過去数年にわたって、AI研究者は、データを並列化し、大量のデータパケットを複数のコンピューターに分割することにより、ニューラルネットワークの学習を加速させることにますます成功しています。 研究者は、 画像分類と言語モデリングに何万ものユニットを使用し、Dota 2をプレイした数百万人の強化学習エージェントにも成功しました。 AI トレーニングの成長を促進する力 ただし、データパケットが大きすぎると、アルゴリズムの戻りが急激に減少し、これらの制限が一部のタスクではより大きく、他のタスクではより小さくなる理由は明らかではありません。

トレーニングアプローチで平均化された勾配ノイズスケーリングは、さまざまな問題に対する重要なデータパケットサイズの変動の大部分(r 2 = 80%)を説明し、6桁異なります。 パッケージサイズは、画像、トークン(言語モデルの場合)、または観測(ゲームの場合)の数で測定されます。

ネットワークグラジエントのS / N比を数値的に決定する単純な統計であるグラジエントノイズスケールを測定することで、最大パケットサイズをほぼ予測できることがわかりました。 ヒューリスティックに、ノイズスケールは、モデルの観点からのデータの変動を測定します(トレーニングの特定の段階で)。 ノイズスケールが小さい場合、大量のデータの並列学習はすぐに冗長になり、ノイズスケールが大きい場合、大きなデータセットで多くのことを学習できます。

この種の統計は、 サンプル の サイズを決定するために広く使用され ており 、 ディープ ラーニングで使用することが提案されましたが、ニューラルネットワークの最新のトレーニングには体系的に使用されませんでした。 パターン予測、言語モデリング、Atari、Dotaゲームなど、上記のグラフに示されている広範な機械学習タスクについて、この予測を確認しました。 特に、さまざまなサイズのデータパケットでこれらの各問題を解決するように設計されたニューラルネットワークをトレーニングし(それぞれの学習速度を個別に調整)、学習の加速をノイズスケールによって予測された加速と比較しました。 大きなデータパケットは、上限を事前に把握してトレーニングを効果的に行うために、慎重かつ費用のかかる調整または学習速度の特別なスケジュールを必要とすることが多いため、新しいモデルをトレーニングする際に大きな利点を得ることができます。

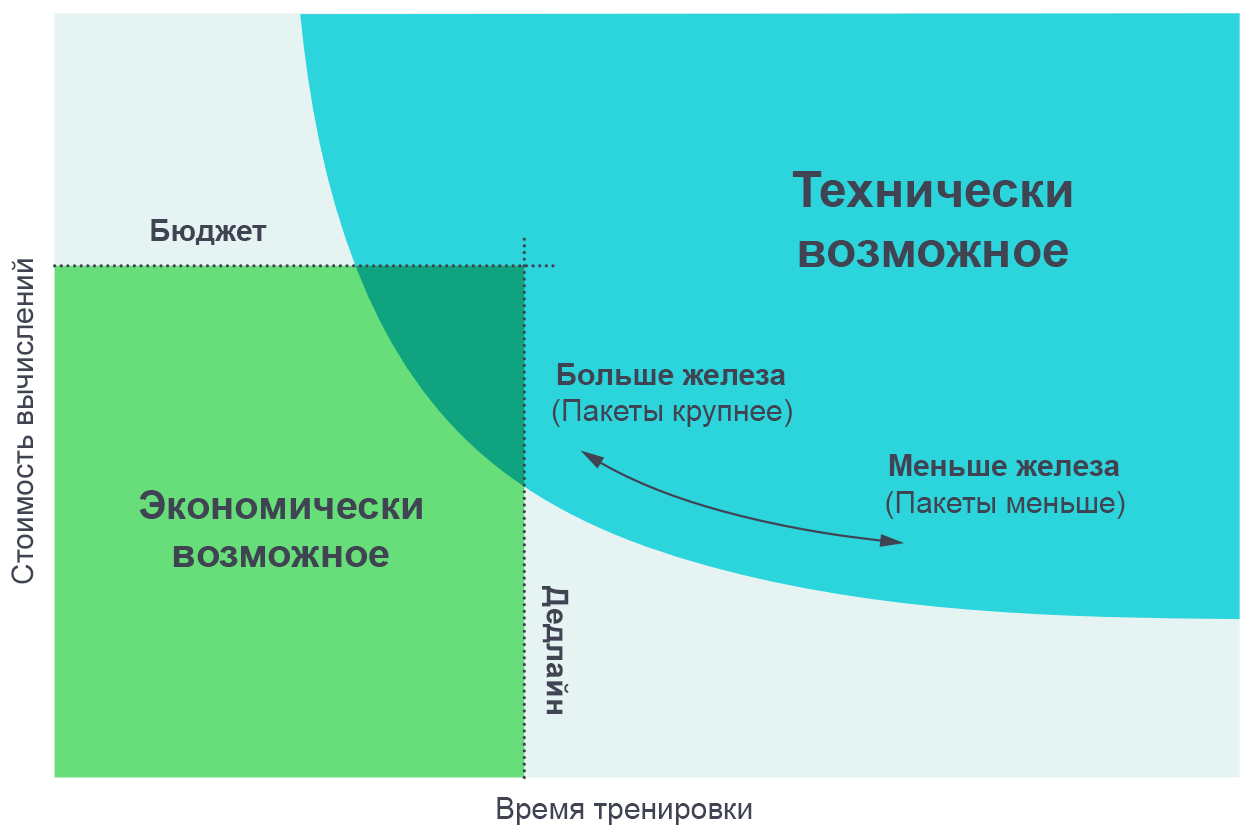

これらの実験の結果を、実際のトレーニング時間とトレーニングに必要な計算の総量(費用対費用に比例)の間の妥協点として視覚化することが有用であることがわかりました。 非常に小さなデータパケットでは、パケットサイズを2倍にすると、追加のコンピューティングパワーを使用せずに2倍の速度でトレーニングを実行できます(2倍の速度で動作する個別のスレッドを2倍実行します)。 非常に大規模なデータモックアップでは、並列化は学習を加速しません。 中央の曲がりの曲線、および勾配ノイズスケールは、正確に曲がる場所を予測します。

並列プロセスの数を増やすと、より複雑なモデルを妥当な時間でトレーニングできます。 パレート境界線図は、アルゴリズムとスケールの比較を視覚化する最も直感的な方法です。

並列プロセスの数を増やすと、より複雑なモデルを妥当な時間でトレーニングできます。 パレート境界線図は、アルゴリズムとスケールの比較を視覚化する最も直感的な方法です。

これらの曲線を取得するには、タスクに目標(たとえば、AtariのBeam Riderゲームの1000ポイント)を割り当て、さまざまなパケットサイズでこの目標を達成するためにニューラルネットワークをトレーニングするのにかかる時間を観察します。 結果は、設定した目標のさまざまな値を考慮して、モデルの予測と非常に正確に一致します。

[ 元の記事のページには 、特定の目標を達成するために必要な経験とトレーニング時間の妥協点を示すインタラクティブなグラフが表示されます ]

勾配ノイズスケールのパターン

勾配ノイズのスケールでいくつかのパターンに遭遇しました。これらのパターンに基づいて、AIトレーニングの将来について推測できます。

まず、学習プロセスでの実験では、通常、ノイズスケールは1桁以上増加します。 どうやら、これは、ネットワークがトレーニングの最初の段階でタスクのより「明白な」特徴を学習し、その後、より小さな詳細を研究することを意味します。 たとえば、画像を分類するタスクでは、ニューラルネットワークはまず、ほとんどの画像に表示されるエッジやテクスチャなどの小規模な特徴を識別することを学習し、後でこれらの小さなことを比較して、猫や犬などのより一般的な概念を作成します。 さまざまな顔やテクスチャの全体像を把握するには、ニューラルネットワークで少数の画像を見る必要があるため、ノイズスケールは小さくなります。 ネットワークがより大きなオブジェクトについて詳しく知るとすぐに、重複データを考慮することなく、より多くの画像を同時に処理できるようになります。

同じデータセットを扱う他のモデルでも同様の効果が機能するという予備的な兆候がいくつかありました。より強力なモデルでは、損失が少ないために勾配ノイズスケールが大きくなります。 したがって、トレーニング中にノイズのスケールを大きくすることは収束のアーティファクトではなく、モデルの改善によるものであるという証拠がいくつかあります。 もしそうなら、将来の改善されたモデルは大規模なノイズを持ち、並列化により適していると期待できます。

第二に、客観的に複雑なタスクは、並列化により適しています。 教師との教育のコンテキストでは、MNISTからSVHNおよびImageNetへの移行に明らかな進歩が見られます。 強化トレーニングのコンテキストでは、 アタリポンからDota 1v1およびDota 5v5への移行で明確な進歩が見られ、最適なデータパケットのサイズは10,000倍異なります。 したがって、AIがますます複雑なタスクに対処するにつれて、モデルはより大きなサイズのデータセットに対処することが期待されます。

結果

データ並列化の程度は、AI機能の開発速度に深刻な影響を及ぼします。 学習を加速することで、より能力のあるモデルを作成し、研究を高速化することができ、各反復の時間を短縮できます。

以前の研究「 AIと計算 」では、最大モデルをトレーニングする計算が3.5か月ごとに2倍になることがわかりました。この傾向は、経済性(計算にお金をかけたいという欲求)と学習を並列化するアルゴリズム機能の組み合わせに基づいていることに注意しました。 後者の要因(アルゴリズムの並列化可能性)は予測が難しく、その限界はまだ十分に研究されていませんが、現在の結果はその体系化と数値表現における一歩前進を表しています。 特に、より複雑なタスク、または既知のタスクを対象とするより強力なモデルにより、データとのより多くの並行作業が可能になるという証拠があります。 これは、学習関連コンピューティングの指数関数的成長をサポートする重要な要素になります。 また、並列モデルの分野における最近の開発についても考慮していません。これにより、既存の並列データ処理に並列化を追加することで、並列化をさらに強化することができます。

トレーニングコンピューティングの分野とその予測可能なアルゴリズムベースの継続的な成長は、今後数年間でAIの機能が爆発的に増加する可能性を示しており、そのようなシステムの安全で責任ある使用の早期調査の必要性を強調しています。 AIポリシーを作成する際の主な困難は、そのような手段を使用して将来のAIシステムの特性を予測する方法を決定し、この知識を使用して、社会がその有用性を最大化し、これらの技術の害を最小限に抑えることを可能にするルールを作成することです。

OpenAIは、AIの将来を予測するための厳密な分析を実施し、この分析によって提起された課題に積極的に対処する予定です。