この記事をきっかけにこの記事を書くことにしました。

簡単な点を思い出してください。Nature誌に、 このテストを使用して実施された研究の結果が掲載されました。

何について書きたいですか?

第一に、なぜこの研究が述べられた問題を解決するために絶対に役に立たないのか、そしてそれが行われた形で。

第二に、そのような研究に優先順位を付ける方法。

そして第三に、テストで指定された条件内でさまざまな事故シナリオをシミュレートしてみてください。

その投稿では、著者は最初からテストへのリンクを挿入しませんでした。 これは、研究の最初のメッセージをキャッチしなかった人々からの無意味なコメントを避けるのに役立ちます。

議論の主題を理解するために、少なくとも数回テストを受けてください。

彼らが研究で私たちに見せることを約束したこと

最初の投稿であるHabrの叙事詩の議論は、大衆は与えられた条件の中で考える方法を知らないが、「テストで死ぬ人もいるだろうか?」 結局のところ、あなたは歩行者とブロックの両方を歩き回って/ハンドブレーキ/ギアをこする/ブレーキをかけることができますか? しかし、私は... "。 これは、道路での自動操縦の動作を規制するアクションアルゴリズムとポリシーを開発するための簡単な例です! 安全規則の開発の観点から、そのような極端なものと単純化は正当化されます。 それは人々が備えなければならない潜在的な結果についてです。 兵士たちが地雷原に行くのは、すべての平方センチメートルがそこで採掘されたからではなく、死ぬ可能性が非常に高いからです。 通常、それほど高くはありませんが、だれもそれを危険にさらすことはありません。 したがって、テストでは、すべての乗客またはすべての歩行者の100%死の選択が適切です-これは、社会の生命を危険にさらすことは容認できないことを念頭に置いて、リスクを示す方法です。

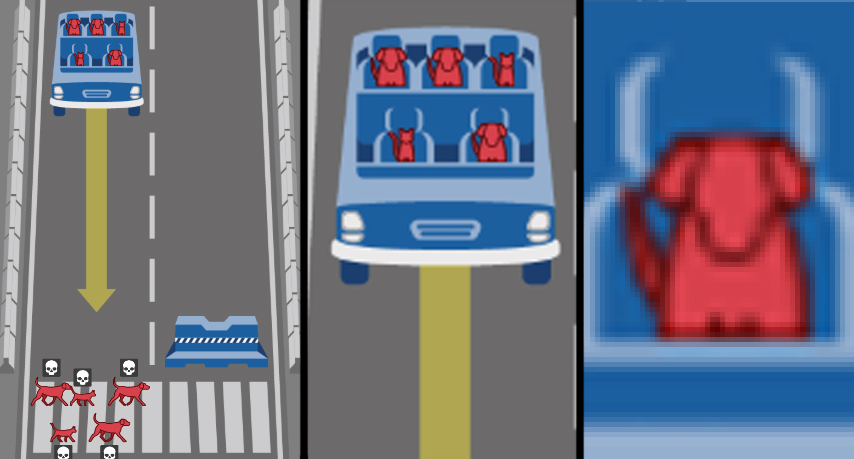

研究のメッセージはこれです。あなたは、現在生きている人々は、オートパイロットの車で満たされた未来の世界に住まなければなりません。 自動車、AI、その他の開発者である私たちにとって、ロボットロボットがどのように振る舞うべきかを知ることは重要です。 さて、あなたはそうです、そうです、それはあなたです-頭と猫がそれに乗った場合、ロボモービルに何をすべきか教えてください、そしてそれはホームレスと犬を粉砕しようとしていますか? ロボモービルは、選択する必要がある場合、どのような倫理を持っているべきですか?

そして、研究の最初の動機を特定した後、そのいくつかの側面について議論したいと思います。

研究が実際に示したこと

はっきりとあなたの目を引く最初のことは、研究のデザインが述べられた目標に向けられていないということです。 ジレンマの形式で設定されたタスクは、ロボット車の動作の「倫理」を作成するのに適していません。 むしろ、すべてではありません。 「事故の結果の深刻さを軽減するためのロボットカーの動作に関するルールを開発する」というタスクを満たすジレンマは次のとおりです。

- 「乗客/歩行者」-保存する人を選択します。

- 「交通ルールの違反」-無意識の歩行者を犠牲にするかどうかを選択します。

- 「潜在的な被害者の数」-被害者の数が優先されるかどうかを選択します。

そして、パラメータは、文明社会の判決にとって非常に重要であることが判明しました。 人々は正直かつ無邪気に尋ねられました:あなたの性差別のレベル、ルキズム、エイジズム? 太ったのか、分類されていないのか? そして、結局のところ、何十万人もの人々が正直に答えました...

ブラボー!

エンターテインメント映画やテレビ番組の最高の伝統の中で、主人公の世界が実際に高いフェンスの後ろの大きな砂場であり、それが実験であるとき! 社会学者、心理学者、文化学者は、ロボット工学とAIの分野で非常に重要な研究のソースの下で、誰も夢にも見なかったトロリー問題に関する非常に強力なサンプルを受け取りました! まあ、皮膚の色は調査に追加されなかったが、研究の人種差別的な倍音は白で縫われるだろうということを除いて...ああ。

真剣に、研究のこのジェンダー表現型の部分は、カテゴリー論によって断ち切られています。 最初の議論は、文明化された人々としてのヒューマニズムであり、私たちは個人の違いよりも人間の生命の価値の優位性を置かなければなりません。 つまり、質問の定式化は差別的であるとんでもないことです。 2番目の議論-多くの事故が発生し、見た目、教育、性別、年齢による被害者の分布は、社会の中で比例する傾向があるため、これを追加で規制することは少なくとも奇妙です。 3番目の議論-ブリオニとベルシュカのプルオーバーを区別する人工知能を作成して、人が身分であるかどうか、押しつぶす価値があるかどうかをさらに比較することはお勧めできません。 さらに、私はAIが判断するのを信用しません-ホームレスの歩行者ですか、それとも科学者ですか? (尊敬される科学者ペレルマンまたはゲルファンドの髪型にこんにちは:))

これらの不要なパラメーターに加えて、残りの2つである種特異性と非干渉を簡単に破棄します。 はい、私たちは考えていたであろう人々を救うために小動物を粉砕します。 また、操縦による「介入/非干渉」パラメータに関しては、トロリーの問題のこの重要な部分は、単に車の障害ではありません。なぜなら、機械は倫理に従って行動するのではなく、そこに定められたアルゴリズムに従って行動するからです そして、「人との衝突事故で車はどのように振る舞うべきか」というタスクを設定しているので、文言ではそれが何らかの形で振る舞わなければならないと想定しています。 今日、鉄道輸送は何の影響も伴わずに直接衝突にうまく対処しており、交通事故の被害者を最小限に抑える方針を開発しています。

これは、我々が世界社会における不寛容のレベルを研究するために、社会心理学的実験から合理的な研究粒子を分離したことを意味します。 上記の最初の3つのジレンマをさらに処理します。 そして、分解するものがあります。 よく調べると、彼らは不完全であることが判明します...

ロボット車の3つのジレンマ

歩行者は交通ルールに違反していますか? ここでは、多数派が社会的ダーウィニズムまたは暗黙に残念な残念な反応を明示的に表明している-むしろ、彼らは罪のない人々を支持して規則に違反した人々を犠牲にしなければならない。 意識のある人は、電車が止まらないことを知ってレールに乗らない-ロボモービルが止まらないことを彼らに知らせる。 シニカルではありますが、すべてが論理的です。 しかし、このcなジレンマには、一方的なもの、不完全なものが隠されています。 交通ルールに違反する歩行者は、状況に対する多くの選択肢の1つにすぎません。 しかし、ロボット車が壊れたら?? この状況は考慮されていませんが、理論的には、突然のブレーキ障害よりもはるかに可能性が高いです(車のカメラが標識や信号機を見逃しました)。 しかし、私は再び空想、特にヒットしました。 テストで状況と同等の相互関係を示すことがより重要です。 つまり、これを想像してみてください。歩行者が交通ルールに違反した場合、彼らは死にます。これは「論理的」かつ「正しい」ものであり、ロボモービルが違反した場合、彼はこの間違いで自殺すべきですか? リーダー、トランプ、中に座っている猫が同時に死ぬことを忘れないでください! これは重要な修正ですが、テストではこの側面はそうではありません。

次。 潜在的な被害者の数。 ここも、それほど単純ではありません。 性別のステレオタイプを捨て、老年を尊重し、脂肪とホームレスを軽contします。 事故では、自然界で発見される頻度に比例して死亡すると想定しています。 そして、私たちは決定します:いくつかの3つは、5つよりも死ぬほうが良いです。 それは論理的に聞こえますか? まあ。 この地獄の不条理をすべて隠そうとしますが、抽象的なシミュレーションがあります。 どちらが良いですか-50人または51人を殺すのですか? 1051または1052? これはそれほど重要ではありませんか? それでは、バスで1人の歩行者または50人を殺すのが良いでしょうか? そして今、それは重要になっていますか? そして、その行はどこに行きますか? すべての余分な人は貴重ですか? しかし、将来何千人もの人々が交通事故で亡くなった場合、それは重要ですか? 外見の場合のように、実際には、潜在的な犠牲者の数のAIを使用した適切な推定は非常に困難です。 意味をなす唯一のことは、犠牲者の数が同じである場合、非介入(非操縦)の条件を作ることです。

3番目の側面は、Habréの最初の記事に対するコメントで多くの論争を引き起こしました。 そして、研究の結果から判断すると、それは社会にとって完全に曖昧であり、ここに解決する必要がある主要な問題があります。 それは誰を危険にさらすか-歩行者または乗客ですか?

歩行者は何の責任も負わないという人もいます。つまり、最初に救われなければならないということです。 一般に、都市部の人々の間では、歩行者の世話をし、通り全体を歩行者にし、50メートルごとに信号機で交差点を作成し、中心部の速度を下げ、歩行者に優先順位を付けることが流行しています。 ここでも、何らかの方法でそれらを確保する必要があり、群衆にブレーキをかけずに飛行するロボット機械は、運動の最も脆弱な参加者を救うために自己破壊しなければなりません。 私の観点から正しいことは、歩行者は他の誰かのロボットカーの行動条件に加入しなかったということです。 彼らは一般的に彼らの紹介に反対かもしれません。 同時に、そのような機械の乗客がその使用条件に同意しないと想像することは不可能です。 したがって、状況は利益相反です。 ある人が別の人に言うように、私はあなたを殺すのがより便利で、私はあなたを殺します。

2番目のものは、ロボット車を購入し、一般的にロボット車に乗る人は全員、事故の際に彼を救うことを保証し、横断道路を救うために医者、子供、または2匹の猫を殺さないことを保証するべきであると言います 一方で、それは論理的で正当化されているように見えますが、他方では、この場合の乗客は自分の人生を意図的に他の人より優先します。 オートパイロットを搭載した車を購入すると、所有者はそれぞれ完璧な武器、銀の弾丸、誘導されていないロケット、その道にいる他の人を完全に合法的に殺す機械を自由に使うことができます。

口に泡がある両側は、サイエンスフィクションから取られた「ロボット工学の第一法則」を引き継ぎます。 それは非常に美しいように聞こえますが、誰もそれを理解したり、問題に関連して挑戦したりすることすらありません。 しかし、概念の代替があるため、この問題の定式化には適用できません。マシンのヒューリスティック/ AIは、人間の生活の価値から選択するのではなく、人々が発明した主観的な優先順位に基づいて作成されたアルゴリズムリズムに従って厳密に動作します。 そしてここでは、「キル/スペア」を選択する際に優先順位としてどのような社会構造が優先されるかは絶対に重要ではありません。以前に拒否した体重、年齢と地位、または車の所有者の社会的ダーウィニストの利己主義です。

2番目のアプローチは、歩行者の生活に対する一方的な攻撃であり、トロリーの問題から囚人の古典的なジレンマに研究を変えます。 当事者が妥協した場合、一般的な開発が可能になり(ロボモービルの導入)、一部の人の最小限の劣化(ロボモービルによる避けられない死亡数の最小化)が可能になります。 しかし、常に彼の興味だけに頼るエゴイストがいます。 「彼は20年になるが、私は釈放される」。 「ブレーキが私の車を拒否したけれども、彼は道路を横断して死ぬでしょう。」 たぶん、このアプローチは、イベントが人生で単一であり、ゲームに2人の参加者がいる場合に正当化されます。 数万または数十万人の参加者がいて、旅行が毎日ある場合、そのような1ゴールのゲームは歩行者に対する差別に変わります。

個人的には、定式化された問題の枠組みの中で、乗客/歩行者のジレンマが行き止まりにつながると信じています。 潜在的に機械に侵入した人を殺す機械は、常識の観点からはばかげており、当然のことながら市場で買い手を見つけることはありません。 意図的に歩行者を殺す車は、前向きな差別と人々の生活への脅威の要素として文明社会では不可能です。

さらに進みます。 この記事は、ロボモービルに関連する事故の悲劇的な結果を最小限に抑えるための政策を実際に議論するものではなく、意味するものでもありません。 合計は「地域」に分割され、優先度が大きく異なり、どちらかと言えば曖昧に形成されています(「宗教的特質と植民地の影響」についての説明がありますが、一般的には、「西」でアフガニスタンとイラクに挨拶し、南部」セクター)。 それで、質問は言語で展開されます。各国ごとに異なる「倫理」を持つロボモービルを作成しますか?

議論の記事の著者は、彼らによって特定された3つの「基本的な基本ブロック」を指定します:人ではなく動物を、より多くの命を救い、より若い人を救います。 しかし、この図から明らかなように、東部地域の人々は、気にしないよりも人口と若者が少し少ないことがわかります。 選択された優先ポリシーは圧倒的多数の意見に反することがわかりますか? では、なぜ人々はまったく疑問視されたのですか?

たぶん数える?

しかし、この投稿の面白い部分に移りましょう。

異なる社会文化的含意を持つ人々からロボット工学に関するアドバイスを求める代わりに、おそらく非中核教育の場合の99%で、私たちは公平なツールに頼ります。 記事の冒頭で選択したジレンマを取り上げましょう。 テストの条件では、最も単純なコンピューターシミュレーションを作成します。 そして、私たちは死んだ道路のユーザーの数を評価します。

そして、覚えておいてください:輸送セキュリティの分野における政治家としての私たちの仕事は、犠牲者の総数を減らすことです。 障害物や人との車の衝突の複雑で現実的な評価ではなく、交通事故の参加者の生命へのリスクに焦点を当てた元のモラルマシンテストのフレームワークと規則に従って作業します。 EuroNCAPはありません。Pythonがあります。

まず、「もっと死ぬ人を救う」というジレンマを満たすコードを書きます。 Moral Machineテストの一環として、1〜5人の乗客と歩行者をランダムに作成し、歩行者>乗客の場合に条件を設定し、すぐにコンクリートブロックで車を殺します。 たとえば、このような事故は10,000件あります。

npedtotal = 0 npasstotal = 0 ndeadped = 0 ndeadpass = 0 # 0 0 n=0 while n < 10000: #10000 nped = random.randint(1, 5) npass = random.randint(1, 5) # 1 5 npedtotal += nped npasstotal += npass # if nped > npass: ndeadpass += npass else: ndeadped += nped # , # . # . n += 1 print (" ", npedtotal) print (" ", npasstotal) print (" ", ndeadped, "(",100*ndeadped/npedtotal, "%",")") print (" ", ndeadpass, "(",100*ndeadpass/npasstotal,"%"")") print (" ", ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

…

29960

29924

13903 ( 46.4052069426 % )

8030 ( 26.8346477744 %) 21933 ( 36.6258098991 % )

, ! , !

. . , . – , « » 4 5, == . , 20 20 , , , 5 – , 5 – . : , , . > >= :

29981, occupants, - , . , . 30000 , 100% — .

29865

7859 ( 26.2132684033 % )

14069 ( 47.1086556169 %)

21928 ( 36.6407111586 % )

, , . – , , 50% , 30000.

– . , , , ! , : , , , , , . , : .

import random

npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

trafficlight = random.randint(0, 1)

# 1 5

#

npedtotal += nped

npasstotal += npass

#

if trafficlight == 0:

ndeadped += nped

else:

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (« », npedtotal)

print (« », npasstotal)

print (« », ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (« », ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (« », ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

```

">", , . ( ).

29978

29899

21869 ( 72.9501634532 % )

4042 ( 13.5188467842 %)

25911 ( 43.2737111078 % )

">="

30152

30138

19297 ( 63.9990713717 % )

6780 ( 22.4965160263 %)

26077 ( 43.2526123735 % )

, . – .

. , , . Moral Machine, , , . - , .

, , , . – , , . . – , , , . , – .

, - , . , , , . – , , .

. . , . .