カットシーンの下には、講義の写しとセルゲイのスライドの一部があります。

近年、私たちは一連の大きな勝利を観察するか、可能な限りそれらに参加しました。 これらの勝利は、機械学習の多くの重要なタスクがニューラルネットワークを使用して、かつてないほど正確に解決されるという事実に表れています。 その結果、科学界をはるかに超えて多くのノイズがあり、非常に多くの人々がディープラーニングの分野に注目を集めました。

このような注意は、一部の新興企業の研究資金の観点から非常に有用です。 しかし、それは期待の成長も刺激し、そのいくつかは率直に言えば不十分であり、ディープラーニングの周りにバブルが膨らみます。

私の論文はこれです。今日、ジャーナリストや、非常に良心的でない、またはあまり知識のない専門家によって私たちに提示される形での深い教育は、現代の神話です。 今日、私はそれを解体し、実際に何が実際に行われ、何が機能し、何が機能しそうにないのか、どのような結論を導き出すことができるのか、または少なくともどのような結論を導き出すのか、そしてディープラーニングに取って代わることができるものについて話したいと思います。

私たちは、他の有名な神話と多くの共通点を持つ神話を提示されます。 たとえば、真の明るい知識が事実上失われ、ほんの数人のイニシエーターによって保持され、世界でカオスが支配する暗い時間についての物語があります。

この神話でさえ、素晴らしい叙事詩的な偉業を行うヒーローがいます。

この神話には大きな偉業があります-それらは歴史に残り、口コミでお互いに語られます。

そして、この神話にはタブー、大きな禁止があります。 それに違反すると、いくつかの強力で制御されない人類の力を解放できます。

最後に、この神話には、客観的な現実よりもカルトよりも崇拝を好む信者がいます。

ディープラーニングが大衆意識にあるものについて話しましょう。 第一に、これまで類似体がなかった完全に新しい技術。

第二に-人間の脳の原理を再現するか、さらにはそれらを超える試み。

そして最後に、これはダウンロードして、努力と利益の間に挿入することができる普遍的な魔法のブラックボックスであり、それ自体がすべてをより良くするように機能します。

ノベルティについて話しましょう。 ディープラーニングの成功の多くは、主にコンピュータービジョンのタスクとその他すべてに関連しており、2人の大学院生と1人の研究監督者が大規模な畳み込みネットワークを訓練し、画像認識競争で大きなマージンを獲得した2012年の歴史的な仕事から始まった例がありますImageNet これが私たちの未来であるという多くの会話は、この仕事から始まりました。 そして、多くの人々が議論中の技術を完全に新しいものとして認識し始めました-畳み込みネットワークに関する最初の記事は90年代半ばにさかのぼります。 もちろん、その場合、それらははるかに小さく、一緒に使用した画像ははるかに単純でしたが、それでもなおそうでした。

別の良い例は、再発ネットワークです。 seq to seq、sequence to sequence learningのよく知られたモデルは、例えば、機械翻訳の実行や対話システムの構築を可能にします。 彼女はまた多くのノイズを作りました。 このシステムで哲学的な対話の例を読んだとき、記事の例がある程度理にかなっているので、背筋が冷たくなりました。 繰り返しになりますが、多くの人が私たちが何らかの人工知能に近づいていると話し始めました。また、まったく新しいことについて話しているという感覚もありました。

それは本当に新しいモデルであり、新しいニューラルネットワークアーキテクチャであり、実際、その結果は独特です。 ただし、入力の質問を認識したり、回答を生成したりするこのネットワークのコンポーネントは、よく知られているリカレントアーキテクチャであり、長期短期記憶またはLSTMとして知られています。 ほぼ20年前の1997年にすでに提案されています。

そして今、強力な人工知能が私たちを待っているかどうかについてのすべての疑念を払拭する、完全に新鮮なブレークスルー。 Google DeepMindのシステムである柔軟なネットワークについて話しています。これは、Atariゲームエミュレータの生のフレームで、個人よりも優れたプレイ方法を学ぶことができました。 もちろん、これも多くのノイズを作りました。

これが歴史的な結果であるのは興味深いことですが、別の事実もあります:知性、意思決定、Q学習の原則に直接関与するこのシステムの部分は、1989年に論文で、クリストファー・ワトキンスによってすでに提案されました。

この20年間で何が変わりましたか? なぜニューラルネットワークがかつて部外者の技術であったのに、誰もがこの分野の研究者に冗談を言ったりsc笑したりしたのに、今ではすべてが逆になっていますか?

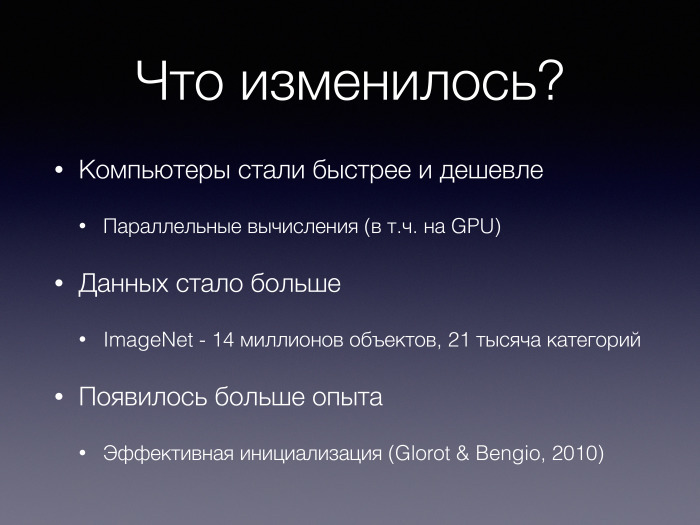

まず第一に、コンピューターはより高速で安価になり、グラフィックアクセラレータでのコンピューティングを含む並列コンピューティングテクノロジーが登場し、主流になりました。 これにより、大きなモデルのトレーニングが可能になりました。

さらにデータがあります。 言及されたImageNetコンテストとそのデータセットは、21,000のカテゴリの1400万のタグ付きオブジェクトで構成されています。 オブジェクトは人によってマークされます。 このデータセットは、画像を分類するために1つのタスクのみで作成されましたが、そのおかげで、Prisma、スタイル転送などのクールなアプリケーションがあり、おそらくすべての可能性が抽出されたわけではありません。 トレーニングデータが利用できるようになるには、定性的な移行が必要でした。

最後に、機械学習の分野でのいくつかの経験は、陳腐なものです。 たとえば、そのようなネットワークを適切にトレーニングおよび初期化する方法に関する作業がありました。 彼らが実際にどのように機能し、機能するかについての理解が深まりました。

ニューラルネットワークがブラックマジックボックスである方法を見てみましょう。 4つの要素から実数のすべての配列をソートする問題を解決する必要があるとします。 普遍的な近似器、そのようなタスクに対応できる普遍的な黒のネットワークを想像してください-あなたのお気に入りのアーキテクチャ。

同じアーキテクチャが、お気に入りのデータ分析ツール(MATLABまたはPythonライブラリ)を使用して取得したヒートマップによって行列のランクを決定する問題を解決するとします。 どう思われるかはわかりませんが、同じニューラルネットワークアーキテクチャが多くの異なるタスクを効果的に解決し、最も多様な種類のデータを等しく効率的に分析し、一般にさまざまなモードで機能することはほとんどありません。

実際、実際にはそのようなブラックボックスがあります-それは多層パーセプトロンと呼ばれます。 これは最も単純なニューラルネットワークアーキテクチャであり、解決すべき問題に関する先験的な仮定をほとんど使用していません。 ニューロンのいくつかの層のように配置されます。 各ニューロンは、前の層のすべてのニューロンからの入力を受け入れ、それらにいくつかの変換を実行し、同様の原理に従ってさらに上に転送します。 最後に、答えを計算します。

そのようなアーキテクチャは、理論的には連続関数の普遍的な近似器であることが知られています。 多層パーセプトロンだけでなく、さまざまな汎用近似器があります。 すべてを近似できるさまざまなクラスの関数があります。 そして、そのような事実があります。

興味深いことに、実際にはこのようなユニバーサルブラックボックスは過度にパラメーター化されています。つまり、各ニューロンと前の層の各ニューロンとのこの接続は非常に冗長です。 これらの接続のいくつかは、それらが害を及ぼさなければ、間違いなく余分です。 個々のニューロンの重みを使用して、他のニューロンの重みを予測できます。

さらに、ボックスが深くなるほど、機能が向上することを期待しています。 理論的にはおそらくそうですが、実際には、深さ、層の数が増えると、その表現能力が低下することがしばしばわかります。

奇妙なことに、このようなブラックボックスが実際のアプリケーションで使用されることはほとんどありません。

畳み込みネットワークは、コンピュータビジョンタスクによく使用されるとしましょう。 そして、そのようなブラックボックスはまったくありません。 彼らは、解決される問題についての先験的な知識、先験的な仮定をより多く使用します-どの例の例を見てみましょう。

まず、画像の比較的小さなオフセットと回転の不変性を確保する必要があります。 これが分類結果に影響を与えないようにします。 たとえば、プーリング操作を使用してこれを実現します。 指定された質問を部分的に削除します。

さらに、パラメーターを再利用する必要があるという強力な先験的な知識があります。 畳み込み演算を実行するとき、同じフィルター、同じ重みを画像の異なる部分に適用します。 もちろん、多層パーセプトロンでそのようなメカニズムを学ぶことはできましたが、明らかに、これまでのところ成功したものはほとんどありません。 そして、ここでは非常に強い制限を課し、多くの構造をモデルに導入します。

最後に、イメージには階層的な性質があり、この階層のレベルはほぼ同じであると想定しています。

同意:これはすべて、ブラックボックスと呼ぶことはできません。ブラックボックスでは、最小数の仮定を構築します。 多くの先験的な知識をもたらします。

ImageNetコンテストで現時点で最良の結果を示している畳み込みネットワークの例を次に示します。 これがInception-ResNetです。 赤でマークされたブロックは実際にはこのように見えます。 次のブロックは次のようになります。

Inception-ResNetの構造は非常に複雑です。 ここでそのような非対称性が必要な理由、ネットワーク要素間のそのような複雑な接続性が完全に明確ではありません。 そして、ここでは、当面の問題だけでなく、このネットワークをセットアップするために使用するトレーニング方法についても、事前知識をさらに活用します。 ここでは、層間の短い結合をレイアウトします。 それらはネットワークのいくつかの層を通過するため、中間層の層をバイパスして勾配がより良く広がります。 ここでは、いわゆる残差学習の原理を使用します。次の各レイヤーは、前のレイヤーの入力を変更するだけでなく、その前に犯した間違いを修正しようとするものと想定しています。 多くの先験的な仮定があります。

言い換えれば、より効率的なニューラルネットワークアーキテクチャは、より正確な先験的仮定を使用し、解決されるタスクに関する情報の処理が優れています。

深層学習では、アプリオリの仮定の抽象化のレベルが増加しています。 以前に手作業で記号をコーディングした場合、今、私たちはおもしろい記号をどのように配置すべきかをおおまかに知っており、それらは自分自身を学習します。 しかし、私たちにはすべてを決定するブラックボックスはまだありません。

一般的な傾向は次のように表されます。トレーニング済みのブラックボックスが必要であり、ブラックボックスについてはほとんど理解していません。 これだけが1つの大きなブラックボックスではなく、多くの小さなブラックボックス-連動して連動します。 良い例は、説明を生成するための画像キャプションのモデルです。 そこでは、かなり複雑な畳み込みネットワークと単語を生成するリカレントネットワークが連動して機能します。 メモリメカニズムもあります。多くのブラックボックスが一緒に機能するように設定されています。

また、ニューラルネットワークは人間よりも優れているという興味深い論文もあります。 一部のタスクでは、これはそうです。 同じImageNetコンテストでは、ニューラルネットワークの精度が一部の人よりも高いいくつかのカテゴリがあります。

しかし、ニューラルネットワークは間違いを犯す可能性があります。 ニューラルネットワークエラーの例を示します。 Googleフォトは自動的に分類され、写真の中の黒人の一部がゴリラとして識別されました。 私はこの例を推測したくありません-これが起こる理由はたくさんありますが、それらは必ずしもディープラーニングやニューラルネットワークとは関係ありません。

しかし、人間の目に見えない特殊なノイズがパンダの画像に追加されると、高度な優れたニューラルネットワークが画像をテナガザルとして定義し、非常に高い信頼度で強制する、指向性攻撃の例がまだあります。

これらの例は、人間の知能と比較して、ニューラルネットワークのある種の無力さを実証するものではありません。 それは単純で、コンピュータービジョンでは-すべてではないにしても、多くのタスクが解決されているように思えますが、かなり基本的なタスクでも作業が必要です。

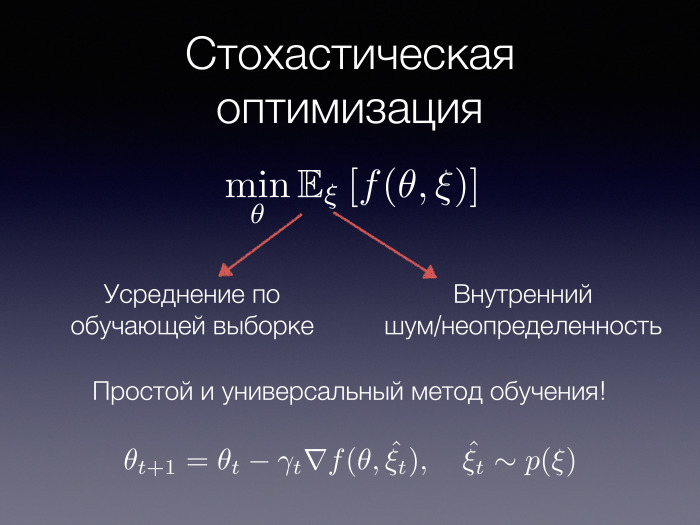

深層学習では、大量のデータで大規模および非常に大規模なモデルをトレーニングできることは本当に素晴らしいことです。 これは、確率的勾配最適化の使用により可能になります。 私たちの問題が、ある関数の期待値を最小化することで表現できる場合(完全な値ξとパラメーターθのノルムがある場合)、θのすべての可能な値に最適なパラメーターを見つけたいと思います。 そして、そのような確率、期待は、さまざまな状況で発生する可能性があります。たとえば、トレーニングサンプル全体で平均化する場合です。 言い換えれば、ランダム変数はサンプルからオブジェクトを選択する役割を果たします。 そして、すべてのオブジェクトを平均すると、すべてのオブジェクトを調べ、損失関数を計算してから平均するのと同じになります。

または、θは何らかの内部ノイズまたは不確実性である可能性があります。 たとえば、今日議論されている生成モデルはこの原則を使用しています。 いくつかのランダムなノイズがあり、それがたとえば人間の顔の写真になります。 このような確率の例もここにあります。

関数fにほとんど何も依存しないのはとてもクールです。 このような関数を最小化する普遍的な方法、いわゆる確率的勾配降下法があります。これは多くの人が聞いたことであり、この大きな期待をすべて計算する必要はありません。 ランダム値の1つのランダムポイントでの関数またはその勾配の値で十分です。

勾配最適化手法を使用すると、機械学習システム全体を類似のコンポーネント(モデル、損失関数、オプティマイザー)に分解できます。これは、トレーニングの成功の非常に重要な要素です。 最適化方法が異なると、一定の反復回数を経て、根本的に異なる収束率と根本的に異なる品質が生成されます。

興味深いことに、これは、プログラミングで見られるモデルビューコントローラモデルに似ています。 ここから何かが続くかもしれません。

損失関数とオプティマイザーを修正すると、モデルのみに集中できます。 空腹の大学院生、学生、またはエンジニアにそれを提供し、95パーセントの品質が欲しいと言います。 そして、彼らの知識、創造力を使用して、単一の勾配最適化フレームワークでモデルを組み合わせ、異なる部分から異なるモデルを構成し、試して、変更することができます。 そして最終的に、彼らは必要な値のしきい値を克服することができます。

人々は現代世界でどのようにニューラルネットワークを構築しますか? ネットワークが特別なアプローチを必要としない場合、この例のように、kerasのような単純な既存のライブラリを使用するだけで十分です。その後、ニューラルネットワークの構造を決定します。その後、このモデルをトレーニングするために計算グラフが自動的に構築されます。 モデル自体があり、データが受信され、損失関数からの勾配が自動的に計算されます。 オプティマイザーがあります-ネットワークの重みを更新します。 これらはすべて、必ずしもコンピューターではなく、さまざまなデバイスで機能します。 複数のコンピューターで並行して実行することもできます。 それは偉大な抽象化についてです。 不思議に思われますが、一般的には、ニューラルネットワークのメタファーが本当に必要なのでしょうか?

確率的勾配降下法または他の勾配法を使用して重みを調整する必要があることがわかっている場合、頭の中のいくつかのニューロンと平行線を引く必要があるのはなぜですか? これについて詳しく説明する準備はできていません。私たちの脳がどのように機能するのかわかりません。 しかし、これらの比phorは非常に有害であり、常に物事の実際の状態に対応するとは限らないように思えます。

同時に、実際のニューラルネットワークを使用した並列の拒否は、予想以上の結果をもたらします。 「ニューラルネットワーク」という用語から「微分可能な関数」という用語に移行すると、新しいモデルを構築できる関数の基盤が大幅に拡張されます。 そして、おそらく彼らの表現力は増大するだけでしょう。

こうした移行を試みているイニシアチブは非常に多くあります。 これは別のレポートに値します。 しかし、私にとって非常に有用であると思われ、プログラミングに関連する関連分野から深い学習研究者が学ばなければならないいくつかのことを伝えたいと思います。

まず、最適化する関数が微分可能または平滑でなければならないことを知っているか、他の制限を課すと仮定します。 また、このプロパティは閉じた操作(構成、追加、その他)に対して保持されると仮定します。 これらの条件下で、高度な型システムを備えたプログラミング言語では、コンパイル段階で微分可能性、滑らかさ、およびその他のプロパティを完全に確率論的にチェックできます。

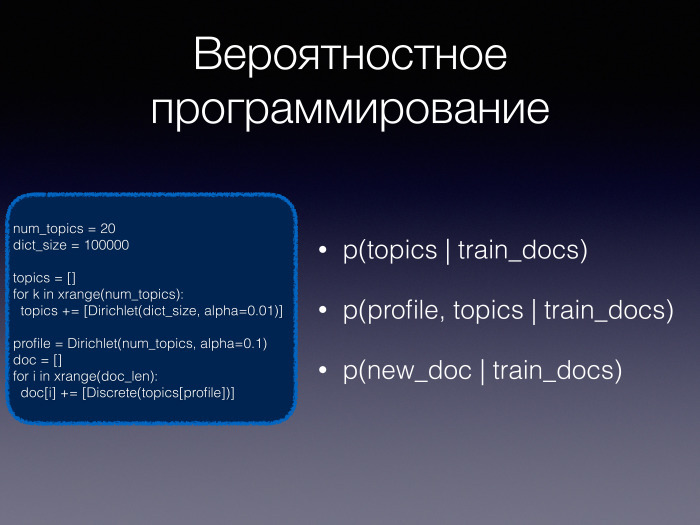

最後に、小さな「ブラックボックス」、微分可能な関数を通常のプログラミング言語に埋め込むというアイデアが本当に好きです。 , , : , , , , . , . , .

— - , . , , .

Topcoder - , , , , — , . - . .

, , . .

, , , — , . ?

, , . , — , .

, , , . — - .

.

, . . , , . , : . , .

. ImageNet. : DQN AlphaGo. , . DQN , , , , . 10 , 10 , - .

AlphaGo ( — . .) 30 , . , .

. , «» , . -, - . , .

, , — . , . , , - .

— , - . . ご清聴ありがとうございました。