最後の記事の最後で、 Maxim maxf75はメモリコネクタの位置の特徴について少し触れました。 今日は、現在取り組んでいるアーキテクチャとレイアウトのバージョンにどのように到達したかについて一般的にお話します。

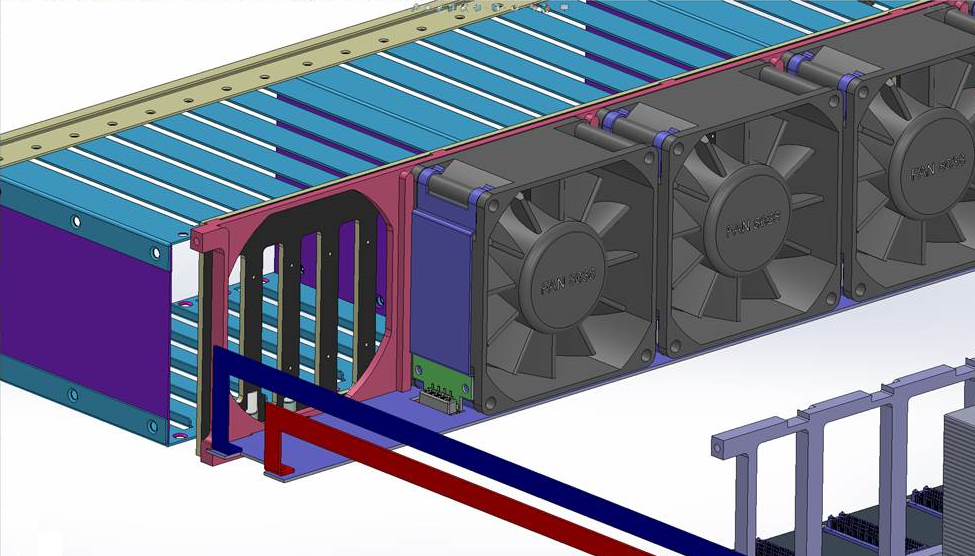

背面グリルを取り外した、設計されたサーバーの背面図。

設計の際には、主要な要件である最大メモリ量を提供することから始めました。 一般に、これはOpenPOWERに基づいて会社がどのように開発を開始し、サーバーの目標を決定し、この要件に到達したかについての別の記事のトピックです。 他の出版物の間で、私たちはこの物語を語ります。 それまでの間、設計の出発点として考えてみましょう。OpenPOWERベースのサーバーで、最大メモリを搭載しています。

現在市場で入手可能で、非常に大量のメモリを提供できるソリューションには、1つの重大な欠点があります。サーバーのコストは、インストールされているメモリのコストの数倍です。 そのため、この伝統を破り、1台のマシンで最大8 TBのメモリを提供しながら、低い合計(実際の8 TB DDR4のコストを考慮しても)のソリューションコストを維持できるサーバーを作成することにしました。

メモリ量を最大化するという目標とともに、高密度を提供したいという要望がすぐに生じました。これは、他のサーバーと比較した場合の競争上の優位性を決定する重要な要因であることが判明しました。 数週間考えて、紙の上で考えた後、これをすべて標準の19インチシャーシ2Uに入れることができると感じました。

記憶

ターゲットのメモリサイズとスラットの総数を考えると、その配置はサーバーレイアウトを構築する決定要因です。 通常のジオメトリ(ボードは巨大になる)とシグナルインテグリティ要件の両方に基づいて、128個のDIMMをマザーボードに配置することは単に不可能であることは明らかです。 明らかに、メモリ量を詰め込むには、システムボードに接続するシャーシにライザーを垂直に配置する必要があります。 ライザーでは、DIMM用のコネクタと、キャッシュを含みメモリへのプロセッサアクセスを提供するCentaurメモリバッファを配置する必要があります(1つのプロセッサは最大4つのメモリバッファをサポートします)。

ライザーレイアウトの最初のアイデアは、図のように、モジュールを片側に配置し、メモリバッファーをそれらの隣に配置することでした。 しかし、最初に、バッファーからDIMMまでのトレースの長さに制限があり、次に、アライメントに問題があることに気付きました。

ライザーメモリの初期レイアウト

それ以外の場合は、メモリバッファチップをDIMMの2つのグループの間に配置する必要がありました。 最初は、そのような決定が高さを通過するかどうかは少し不明確でしたが、ライザーの高さを慎重に計算すると、最小公差でコンポーネントを配置すると、結果のボードが2Uケースの底部とカバーの間の高さで通過することがわかりました。 したがって、マザーボードに接続するためのコネクタは横向きでなければならず、ライザーは次のようになりました。

ボードは18層の複雑なものです。

ローカルストレージおよび冷却ファン

次に、一般的なサーバーレイアウトの構築を開始しました。 従来、シャーシの前面にはローカルストレージ用のディスクがあります。 2Uシャーシの場合、最も標準的なオプションは24×2.5インチまたは12×3.5インチです。 最初の1つを選択しました。SSDに重点を置いているため、このプロジェクトでは3.5インチドライブはあまり重要ではありません。

ファンは古典的にドライブの後ろに配置されます-特別な質問もありませんでした:彼らは一般的なサイズの80×38 mmの5つのファンを配置しました-実際には、幅に収まる最大。 ここでも、いじくりまわさなければならないタスクがありました-5つのファンを配置する場合、コネクター用のスペースは事実上残っていません(外出先でそれらを交換する可能性を確保する必要があります)。 私たちは、非常にコンパクトなコネクタを見つけて、実際にファン自体が占有するボリュームに配置することで抜け出しました。

ファンを接続します。 表示の便宜上、近くのファンと近くのガイドフレームは隠れています。

ファンはその下にあるボードに接続され、電源と速度の制御ラインを分配します。 各ファンには独自の制御チャネルがあります。 写真では、ボードに通じる電源バスを見ることができます。電源を自分で拡張すると、サーバーの左側に沿って走ります。 右側には、システムボードからPWM制御信号を送信するためのループがあります。

ローカルドライブの接続でもそう簡単ではありません。 私たちはNVMe規格を本当に気に入っており、一般的には未来がそこにあると信じています。 予見可能な期間に登場する新しいタイプのメモリ(IntelとMicronの連合による同じ3D-XPoint)に関係なく、PCI Expressはプロセッサに接続する最短の方法であるため、NVMeドライブのバリアントでアプリケーションを見つける可能性があります。 (はい、NV-DIMMについては知っていますが、これは非常に高価な妥協であり、貴重なメモリスロットを使い果たしてしまいます)。 一方、SAS / SATAのサポートを完全に、そして取り消すことなく拒否したくはありません。 これらの考慮事項により、PCI ExpressスイッチでもSAS HBA / RAIDコントローラーでも、PCI Expressバスとケーブルをディスクコントローラーに接続できるようにするコネクターをマザーボードに配置するという決定にかなり論理的に導かれました。

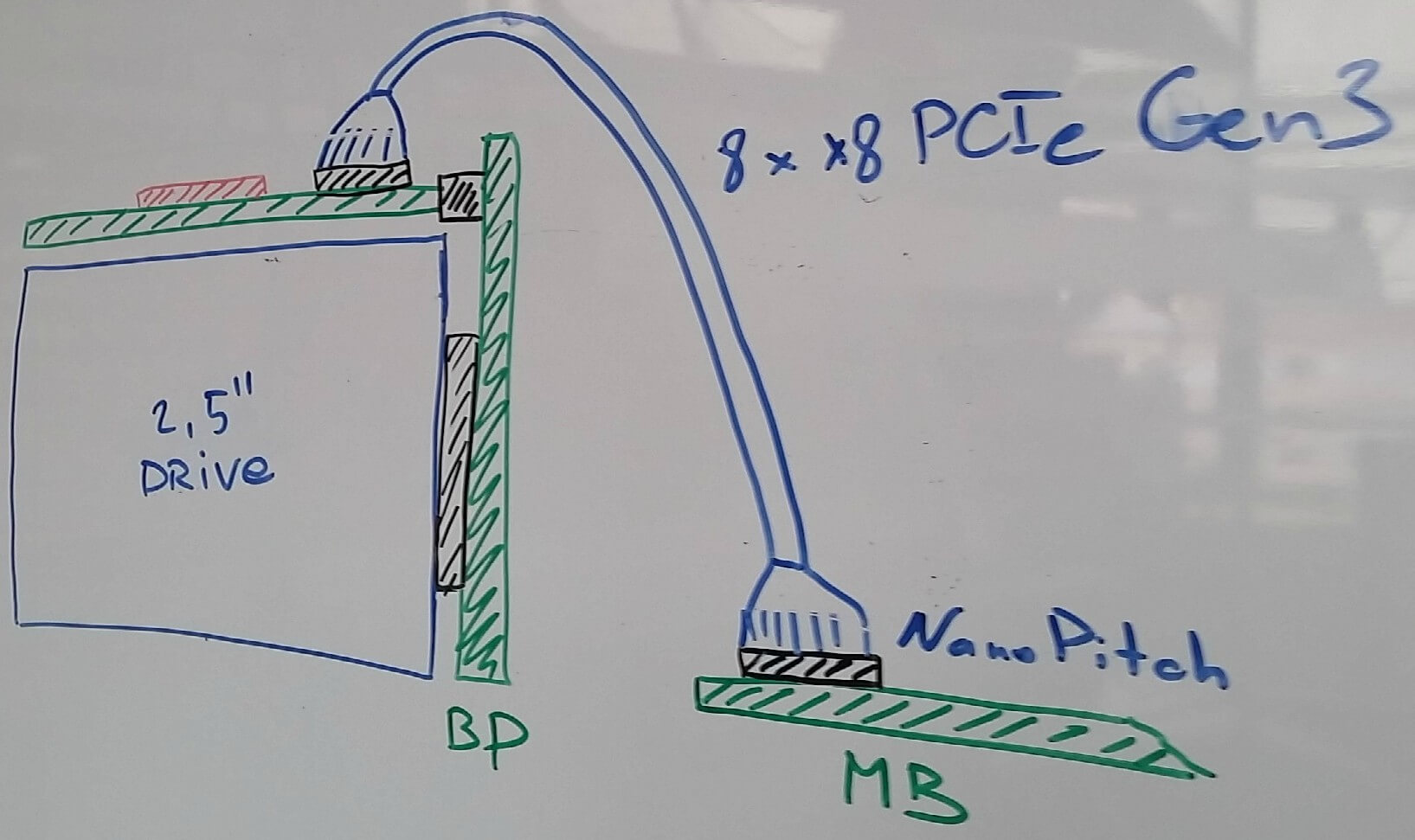

MolexのNanoPitchソリューションは、私たちにとって最適なコネクタとケーブルのペアとして選ばれました(実際、これは積極的に推進されているPCI SIG標準OCuLinkの単なる実装です)。 内部接続用のケーブルは非常にコンパクトで、1本のケーブルで最大8つのPCIe Gen3レーンを配線できます。

次に、ディスクコントローラを実際に配置する場所についての質問が発生しました。 ドライブが接続されているバックプレーンでは、実行することはまったく不可能です(チップはSASコントローラーのチップであり、PCIeスイッチはこれに対して大きすぎます)。 ディスクのサイズ、最大許容シャーシ高さ、およびディスクトレイのさまざまな設計オプションを慎重に検討した結果、一般に、コントローラー付きのボードをディスクの上に配置できることが明らかになりました。 この配置では、まずディスクバックプレーンへの接続が簡単になり(標準のCardEdgeコネクタを使用できます)、次に、光ファイバーの排除とコントローラーボード上のディスプレイ全体の配置により、ディスクトラックの高さを低くすることができます。

その結果、次のような接続スキームが得られました。

変更のために-手でアート。 ディスク接続図。 磁気ボード、マーカー、2016年。

PCIeスイッチまたはSASコントローラーを搭載したボードは、ディスクの上にあり、ケーブルでシステムボードに接続されています。 ボード自体がディスクバックプレーンに接続されており、そこにドライブが固定されています。

電源

電源は通常、ケースの左または右後隅に配置されます。 PDB(配電盤)の設計に基づいて、左側(背面から見た場合)に配置する方が便利でした。 電源はCRPS規格を使用することを決定しました。その主な利点は、電源の高比電力(今日2 kW、最大2.4-ほぼ明日)、高効率、そして最も重要なことです-これは1つのベンダーの独自の標準ではなく、標準です、もともとはIntelによって開始され、多数の企業がサポートしていました。 このケースでは、2キロワットの電源装置が上下に2つ配置されています。

メモリについてもう少し

各ライザーに1つのメモリバッファーと8つのDIMM(Centaurがサポートする最大数)を配置するため、プロセッサーごとに4つのライザー、つまりシャーシに16のみが必要であることがわかります。 標準のDDR4 RDIMMの高さに基づいて、シャーシ内のこのようなライザーの幅は11以下に対応できます(さらに、超低座位のDIMMソケットを使用し、10分の1ミリ単位で収縮する必要があります)。 したがって、別の5つのライザーをシステムボードの背面の別の場所に配置する必要がありました。 実際、これにより最終的に180度で1つのプロセッサが展開されました(前の記事の最後のクトゥルフの写真)。 メモリライザーの底からサーバーカバーまでの高さを考慮して、マザーボードの形状の制限に別の切り欠きが追加されました。

その後、標準のPCI Expressカード用のコネクタを配置するだけで、その数は空き領域によって一意に決定されます。 5つのスロットと、管理ボード用の別のコネクタを配置することが判明しました(システムボードをアンロードするために、別のBMC、USB、およびイーサネットカードに配置することにしました-これらすべてを、同じ6番目のスロットに取り付けられた別の小さなボードに配置します)。

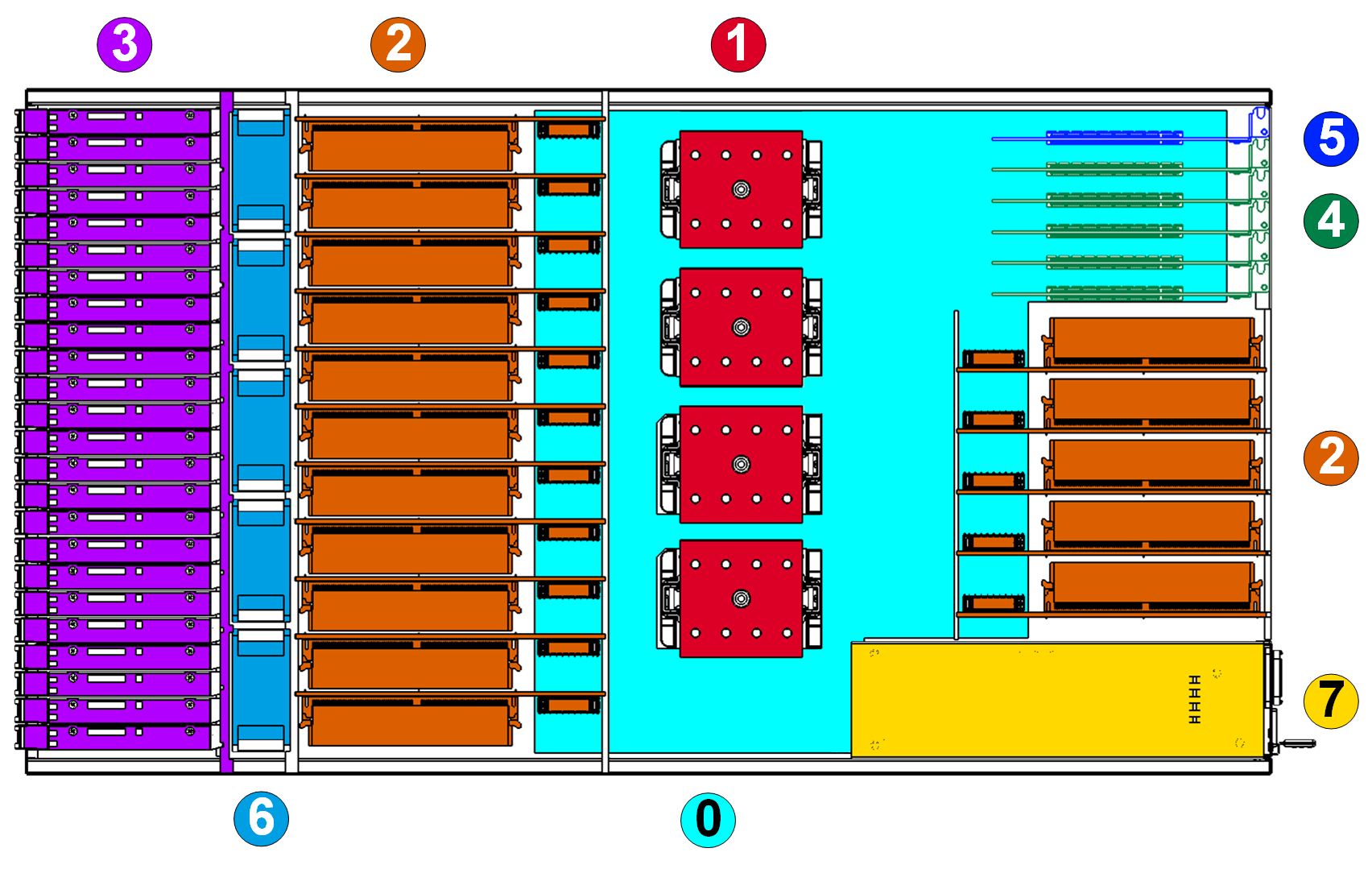

一般的なスキーム

結果は、コンポーネントの位置の写真です(上面図、ドライブの上にコントローラーがあるボードは、ドライブをわかりにくくしないために表示されていません):

凡例:

0.マザーボード。

1.プロセッサーIBM POWER8 SCM Turismo。

2. DIMMを搭載したメモリライザー。

3. 24×2.5”ディスクおよびディスクバックプレーン

4.拡張カード用のスロット(HHHL、つまりロープロファイルカードのみがサポートされています)。

5.管理委員会。

6.冷却システムのファン。

7.電源。

これらは、私が説明し、サーバーの外観を決定した考慮事項です。 合計:高さ2Uの標準19インチシャーシ、POWER8プロセッサ用ソケット4個、メモリスロット付きライザー用スロット16個(サーバー全体で最大128個のDIMM、各ライザーに8個)、拡張カード用標準PCI Expressスロット5個およびカード1個管理。