この記事では、最も人気のある仮想化プラットフォームの1つであるVMware vSphereと連携するAll Flash AccelStorアレイの機能について説明したいと思います。 特に、オールフラッシュなどの強力なツールを使用することで最大限の効果を得るのに役立つパラメーターに焦点を当てます。

すべてのFlash AccelStor NeoSapphire™アレイは、非常に一般的なRAIDアルゴリズムの代わりに独自のFlexiRemap®テクノロジーを使用してデータを保存し、データへのアクセスを整理するという概念を実装するための根本的に異なるアプローチを持つSSDに基づく1つまたは2つのノードデバイスです。 アレイは、ファイバーチャネルまたはiSCSIインターフェイスを介してホストにブロックアクセスを提供します。 公平に言うと、ISCSIインターフェースを備えたモデルにはファイルへのアクセスも素晴らしいボーナスとしてあることに注意してください。 ただし、この記事では、オールフラッシュで最も生産性の高いブロックプロトコルの使用に焦点を当てます。

AccelStorアレイとVMware vSphere仮想化システム間の展開およびコラボレーションのセットアップのプロセス全体は、いくつかの段階に分けることができます。

- 接続トポロジの実装とSANネットワークの構成。

- オールフラッシュアレイのセットアップ。

- ESXiホストを構成します。

- 仮想マシンを構成します。

ファイバーチャネルとiSCSIを備えたAccelStor NeoSapphire™アレイが機器の例として使用されました。 基本ソフトウェアはVMware vSphere 6.7U1です。

この記事で説明するシステムを展開する前に、パフォーマンスの問題( VMware vSphere 6.7のパフォーマンスベストプラクティス )およびiSCSI設定( iSCSIでVMware vSphereを実行するためのベストプラクティス )に関するVMwareのドキュメントをよく理解することを強くお勧めします。

接続トポロジとSAN構成

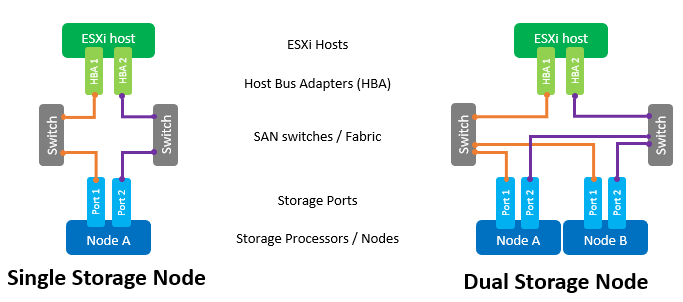

SANネットワークの主要コンポーネントは、ESXiホスト上のHBA、SANスイッチ、およびアレイノードです。 このようなネットワークの典型的なトポロジは次のようになります。

ここでのスイッチという用語は、単一の物理スイッチまたはスイッチのセット(ファブリック)、または異なるサービス間で共有されるデバイス(ファイバチャネルの場合はVSAN、iSCSIの場合はVLAN)を指します。 2つの独立したスイッチ/ファブリックを使用すると、考えられる障害点がなくなります。

アレイへの直接ホスト接続はサポートされていますが、お勧めできません。 オールフラッシュアレイのパフォーマンスは非常に高いです。 また、最高速度を実現するには、アレイのすべてのポートを使用する必要があります。 したがって、ホストとNeoSapphire™の間に少なくとも1つのスイッチが必要です。

HBAホストに2つのポートがあることも、最大のパフォーマンスとフォールトトレランスの前提条件です。

ファイバーチャネルインターフェイスを使用する場合は、ゾーニングを構成して、イニシエーターとターゲットの間で発生する可能性がある競合を排除する必要があります。 ゾーンは、「1つのイニシエーターポート-1つ以上のアレイポート」の原則に基づいて構築されます。

他のサービスと共有されているスイッチを使用している場合にiSCSI接続を使用している場合、iSCSIトラフィックを別のVLAN内に分離する必要があります。 また、ジャンボフレームサポート(MTU = 9000)を有効にして、ネットワーク上のパケットサイズを増やし、送信中のサービス情報の量を減らすことを強くお勧めします。 ただし、正常な動作のためには、イニシエータスイッチターゲットチェーンに沿ったすべてのネットワークコンポーネントのMTUパラメータを変更する必要があることを覚えておく価値があります。

すべてのフラッシュアレイのセットアップ

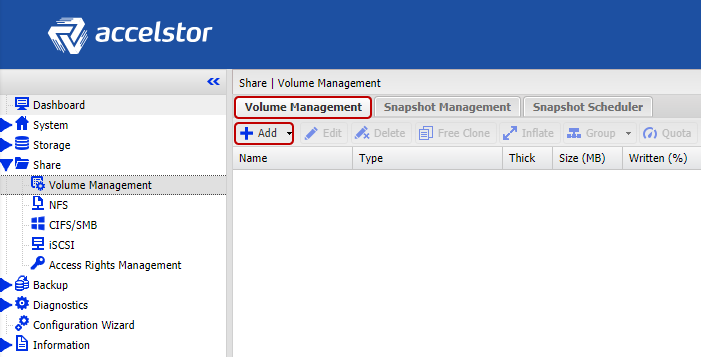

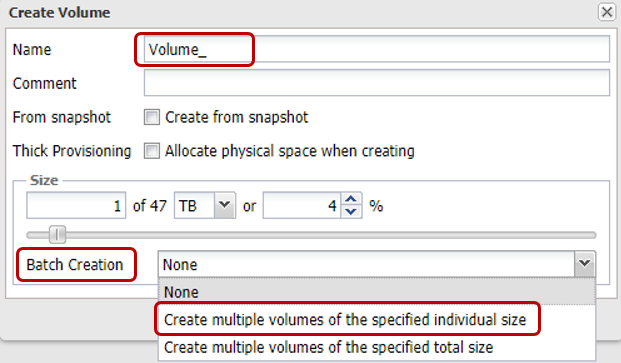

アレイは、すでに形成されたFlexiRemap®グループを使用して顧客に提供されます。 したがって、ドライブを単一の構造に統合するためのアクションは不要です。 必要なサイズのボリュームを必要な量で作成するだけで十分です。

便宜上、特定のボリュームの複数のボリュームを一度にバッチ作成する機能があります。 「シン」ボリュームはデフォルトで作成されます。これにより、使用可能なストレージスペースをより合理的に使用できるようになります(スペース再利用のサポートも含まれます)。 パフォーマンスの観点から、シンボリュームとシックボリュームの差は1%を超えません。 ただし、配列から「すべてのジュースを絞り出す」場合は、いつでも「薄い」ボリュームを「厚い」に変換できます。 ただし、このような操作は元に戻せないことを覚えておく必要があります。

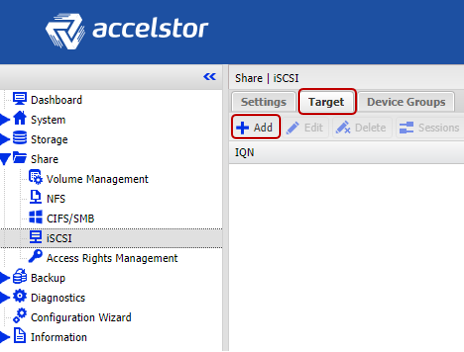

次に、作成されたボリュームを「公開」し、ACL(iSCSIのIPアドレスとFCのWWPN)およびアレイ上のポートの物理的な分離を使用して、ホストからそれらへのアクセス権を設定します。 iSCSIモデルの場合、これはターゲットを作成することにより行われます。

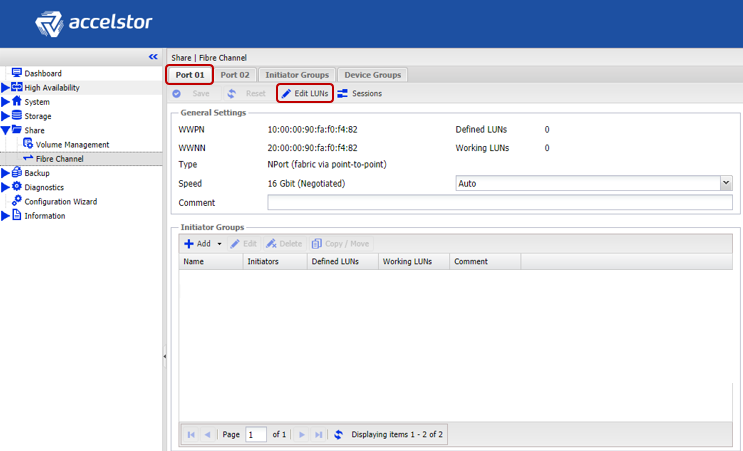

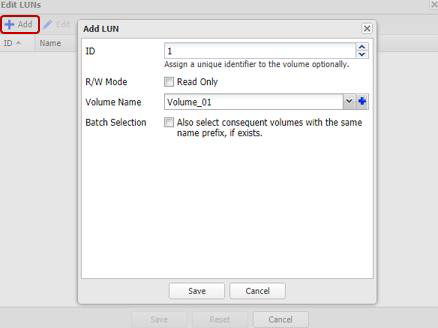

FCモデルの場合、公開はアレイの各ポートのLUNの作成を通じて行われます。

構成プロセスを高速化するために、ホストをグループ化できます。 さらに、ホストがマルチポートFC HBAを使用している場合(実際には最も頻繁に発生します)、システムは、そのようなHBAのポートが1つ異なるWWPNにより同じホストに属していると自動的に判断します。 また、両方のインターフェースでターゲット/ LUNのバッチ作成がサポートされています。

iSCSIインターフェイスを使用する際の重要なポイントは、ボリュームの複数のターゲットを一度に作成してパフォーマンスを向上させることです。ターゲットのキューは変更できず、実際にはボトルネックになるためです。

ESXiホストを構成する

ESXi側では、基本的な構成は予想されるシナリオに従って行われます。 iSCSI接続の手順:

- ソフトウェアiSCSIアダプターを追加します(既に追加されている場合、またはハードウェアiSCSIアダプターを使用する場合は不要です)。

- iSCSIトラフィックが通過するvSwitchを作成し、それに物理アップリンクとVMkernalを追加します。

- 動的検出にアレイアドレスを追加します。

- データストアの作成

重要な注意事項:

- もちろん一般的な場合、既存のvSwitchを使用できますが、別のvSwitchの場合、ホスト設定の管理ははるかに簡単になります。

- パフォーマンスの問題を回避するために、管理トラフィックとiSCSIを個別の物理リンクやVLANに分離する必要があります。

- VMkernalのIPアドレスとオールフラッシュアレイの対応するポートは、パフォーマンスの問題のため、同じサブネット上にある必要があります。

- VMwareのフォールトトレランスを確保するには、vSwitchに少なくとも2つの物理アップリンクが必要です

- ジャンボフレームを使用する場合は、vSwitchとVMkernalの両方のMTUを変更する必要があります

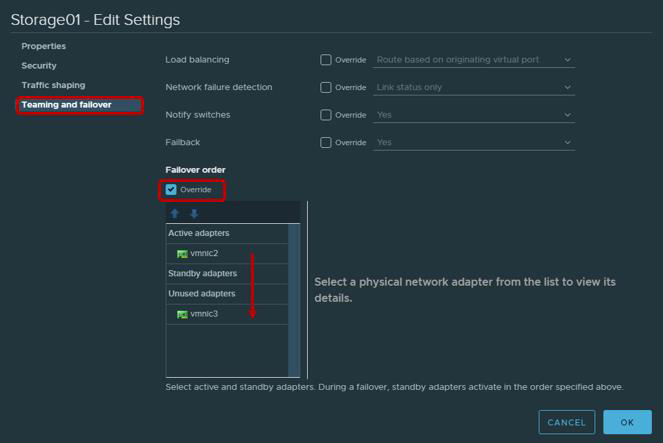

- iSCSIトラフィックを処理するために使用される物理アダプターに関するVMwareの推奨事項によれば、チーミングとフェイルオーバーを構成する必要があることを思い出してください。 特に、各VMkernalは1つのアップリンクのみで機能し、2番目のアップリンクは未使用モードに切り替える必要があります。 フォールトトレランスを実現するには、2つのVMkernalを追加する必要があります。それぞれがアップリンクを介して機能します。

| VMkernelアダプター(vmk#) | 物理ネットワークアダプター(vmnic#) |

|---|---|

| vmk1(Storage01) | アクティブなアダプター

vmnic2 未使用のアダプター vmnic3 |

| vmk2(Storage02) | アクティブなアダプター

vmnic3 未使用のアダプター vmnic2 |

ファイバーチャネル接続は必要ありません。 データストアをすぐに作成できます。

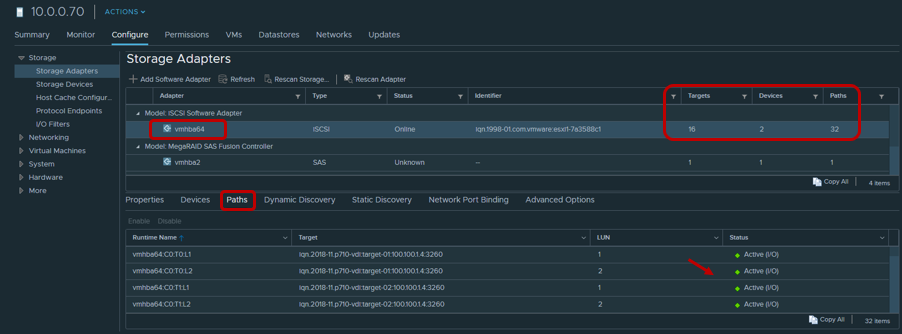

データストアを作成した後、最も生産性の高いターゲット/ LUNへのパスにラウンドロビンポリシーが使用されていることを確認する必要があります。

デフォルトでは、VMwareはスキームに従ってこのポリシーの使用を提供します。最初のパスを介した1000要求、2番目のパスを介した次の1000要求など。 このホストとデュアルコントローラーアレイの相互作用は不均衡です。 したがって、Esxcli / PowerCLIを使用してラウンドロビンポリシー= 1パラメーターを設定することをお勧めします。

Esxcliの場合:

- 利用可能なLUNを印刷する

esxcli storage nmpデバイスリスト

- デバイス名をコピー

- ラウンドロビンポリシーの変更

esxcli storage nmp psp roundrobin deviceconfig set --type = iops --iops = 1 --device = "Device_ID"

最新のアプリケーションのほとんどは、帯域幅の使用率を最大化し、CPU負荷を軽減するために、大きなデータパケットを交換するように設計されています。 そのため、ESXiはデフォルトでストレージデバイスに最大32767KBのバッチでI / O要求を転送します。 ただし、多くのシナリオでは、小さな部分を交換する方が生産性が高くなります。 AccelStorアレイの場合、これらは次のシナリオです。

- 仮想マシンはレガシーBIOSの代わりにUEFIを使用します

- vSphere Replicationによって使用されます

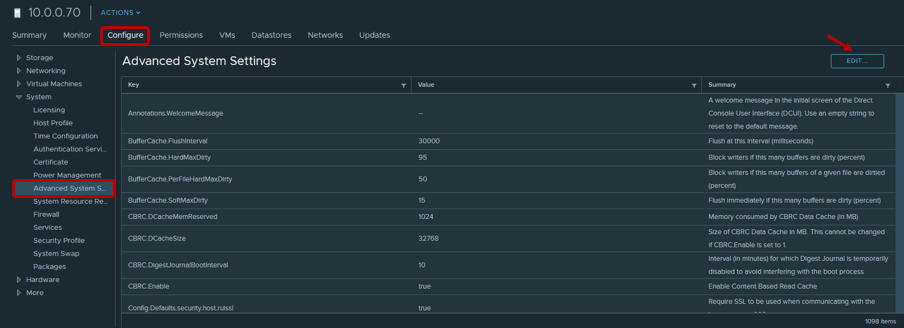

このようなシナリオでは、Disk.DiskMaxIOSizeパラメーター値を4096に変更することをお勧めします。

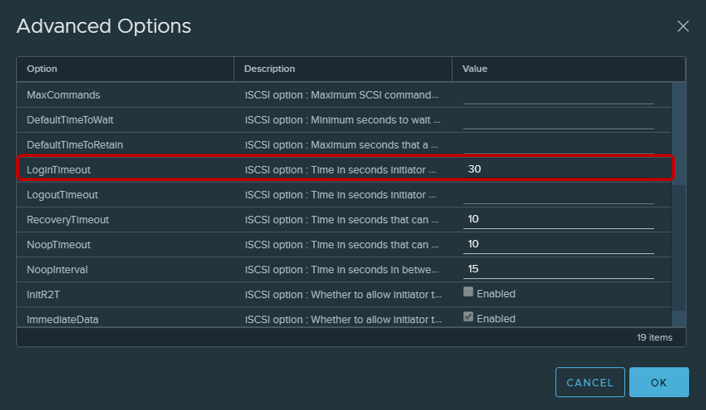

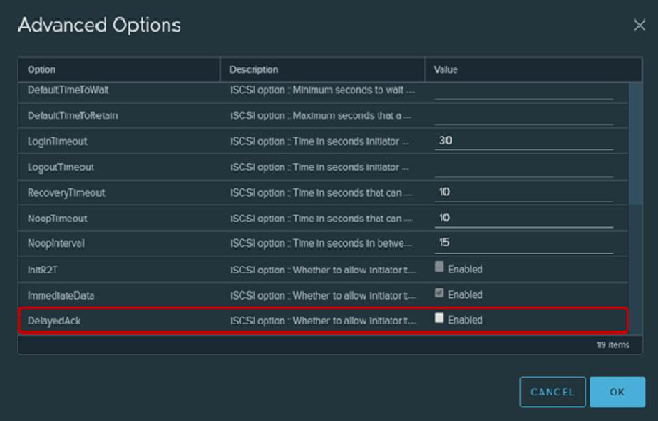

iSCSI接続の場合、ログインタイムアウトパラメーターを30(デフォルトは5)に変更して接続の安定性を高め、転送されたDelayedAckパケットの確認応答の遅延をオフにすることをお勧めします。 両方のオプションがvSphere Clientにあります。ホスト→構成→ストレージ→ストレージアダプター→iSCSIアダプターの詳細オプション

かなり微妙な点は、データストアに使用されるボリュームの数です。 管理を容易にするために、アレイのボリューム全体に対して1つの大きなボリュームを作成することが望ましいことは明らかです。 ただし、複数のボリュームが存在し、それに応じてデータストアが全体的なパフォーマンスに有益な影響を及ぼします(テキストの少し後のキューについて)。 したがって、少なくとも2つのボリュームを作成することをお勧めします。

さらに最近、VMwareは、可能な限り最高のパフォーマンスを得るために、単一のデータストア上の仮想マシンの数を制限することを推奨しました。 ただし、現在、特にVDIの普及により、この問題はそれほど深刻ではなくなりました。 しかし、これは長年のルール-集中的なIOを必要とする仮想マシンを異なるデータストアに分散すること-をキャンセルしません。 ボリュームあたりの仮想マシンの最適な数を決定することは、インフラストラクチャ内でAll Flash AccelStorアレイの負荷テストを行うことほど優れています。

仮想マシンを構成する

仮想マシンをセットアップする場合、特別な要件はありません。むしろ、ごく普通の要件です。

- 可能な限り最高のバージョンのVMを使用する(互換性)

- 仮想マシンがVDIなどに密集して配置されている場合、RAMサイズを設定する方がより正確です(デフォルトでは、起動時にRAMサイズに匹敵するページングファイルが作成されるため、有効な容量を消費し、最終的なパフォーマンスに影響します)

- アダプターの最も効率的なIOバージョンを使用してください:ネットワークタイプVMXNET 3およびSCSIタイプPVSCSI

- 最大限のパフォーマンスを実現するには、Thick Provision Eager Zeroedドライブタイプを、最大限のストレージ使用率を実現するには、シンプロビジョニングを使用します

- 可能であれば、仮想ディスクの制限を使用して、重要ではないI / Oマシンの動作を制限します

- 必ずVMware Toolsをインストールしてください

キューノート

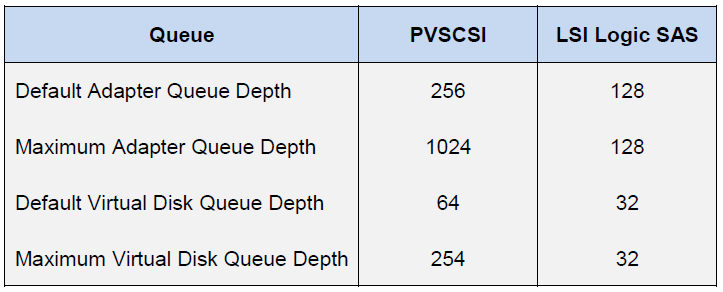

キュー(または未処理のI / O)は、特定のデバイス/アプリケーションからの任意の時点で処理を待機しているI / O要求(SCSIコマンド)の数です。 キューがオーバーフローすると、QFULLエラーが生成され、最終的にレイテンシパラメータが増加します。 ディスク(スピンドル)ストレージシステムを使用する場合、理論的には、キューが高いほどパフォーマンスが高くなります。 ただし、QFULLを実行するのは簡単なので、乱用しないでください。 一方、オールフラッシュシステムの場合、すべてがやや単純になります。アレイの遅延は数桁低くなるため、ほとんどの場合、キューのサイズを個別に調整する必要はありません。 ただし、一方で、一部のユースケース(特定の仮想マシンのIOの要件の強いバイアス、最大パフォーマンスのテストなど)で、キューパラメーターを変更しない場合は、少なくともどのインジケーターを達成できるかを理解し、最も重要なのは、どのような方法で。

AccelStorのオールフラッシュアレイ自体には、ボリュームまたはI / Oポートに関する制限がありません。 必要に応じて、単一のボリュームでもアレイのすべてのリソースを取得できます。 キューの制限は、iSCSIターゲットのみです。 このため、この制限を克服するために、各ボリュームに複数(理想的には最大8個)のターゲットを作成する必要性が上に示されました。 また、AccelStorアレイは生産性の高いソリューションです。 したがって、最高速度を実現するには、システムのすべてのインターフェイスポートを使用する必要があります。

ホストのESXi側では、状況はまったく異なります。 ホスト自体が、すべての参加者に対してリソースへの平等なアクセスの実践を適用します。 そのため、ゲストOSとHBAに個別のIOキューがあります。 ゲストOSへのキューは、キューから仮想SCSIアダプターおよび仮想ディスクへと結合されます。

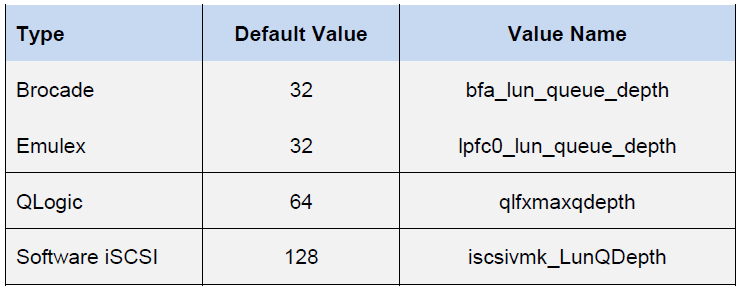

HBAのキューは、特定のタイプ/ベンダーによって異なります。

仮想マシンの最終的なパフォーマンスは、ホストコンポーネントの中で最も低いキュー深度の制限によって決まります。

これらの値のおかげで、特定の構成で取得できるパフォーマンスインジケーターを評価できます。 たとえば、レイテンシ0.5ミリ秒の仮想マシン(ブロックにバインドしない)の理論的なパフォーマンスを知りたいと考えています。 次に、IOPS =(1,000 /遅延)*未処理のI / O(キューの深さ制限)

例1

- FC Emulex HBAアダプター

- データストア上の1つのVM

- VMware準仮想化SCSIアダプター

ここで、キューの深さの制限は、Emulex HBAによって決定されます。 したがって、IOPS =(1000 / 0.5)* 32 = 64K

例2

- VMware iSCSIソフトウェアアダプター

- データストア上の1つのVM

- VMware準仮想化SCSIアダプター

ここで、キューの深さの制限は、準仮想SCSIアダプターによって既に定義されています。 したがって、IOPS =(1000 / 0.5)* 64 = 128K

すべてのFlash AccelStorアレイの最上位モデル(P710など)は、4Kブロックで700K IOPSの記録パフォーマンスを提供できます。 このようなブロックサイズでは、単一の仮想マシンがそのようなアレイをロードできないことは明らかです。 これを行うには、11(たとえば1)または6(たとえば2)の仮想マシンが必要です。

その結果、記載されている仮想データセンターのすべてのコンポーネントの正しい構成により、パフォーマンスの面で非常に印象的な結果を得ることができます。

4Kランダム、70%読み取り/ 30%書き込み

実際、現実の世界を単純な式で記述するのははるかに困難です。 単一のホストには、さまざまな構成とIO要件を持つ多くの仮想マシンが常にあります。 はい。ホストプロセッサは、電力が無限ではないため、I / O処理を行っています。 したがって、同じモデルの可能性を最大限に引き出すには、実際にはP710に3つのホストが必要です。 さらに、仮想マシン内で実行されるアプリケーションが調整を行います。 したがって、正確なサイジングのために、実際の現在のタスクのために顧客のインフラストラクチャ内のすべてのFlash AccelStorアレイのテストモデルの場合にテストを使用することをお勧めします。