私たちとHelvetisのスイスのパートナーにとっての課題は、ドローンの低電力組み込みデバイスからWiFi経由でWindowsタブレットにWebカメラからリアルタイムビデオをブロードキャストすることでした。 理想的には:

- 遅延<0.3s;

- 組み込みシステムのCPU負荷が低い(コアあたり10%未満);

- 少なくとも480pの解像度(720p以上)。

何がうまくいかないように思えますか?

そこで、次の機器リストに決めました。

- Minnowboard 2コア、Atom E3826 @ 1.4 GHz、OS:Ubuntu 16.04

- いくつかの形式(YUV、MJPEG、H264)をサポートするELP USB100W04Hウェブカメラ

- ASUS VivoTab Note 8 Windowsタブレット

標準ソリューションでうまくやっていく試み

Python + OpenCVを使用したシンプルなソリューション

最初に、OpenCVを使用してカメラからフレームを受信し、JPEGを使用して圧縮し、HTTPを介してクライアントアプリケーションに送信する単純なPythonスクリプトを使用しようとしました。

PythonでのHTTP MJPGストリーミング

from flask import Flask, render_template, Response import cv2 class VideoCamera(object): def __init__(self): self.video = cv2.VideoCapture(0) def __del__(self): self.video.release() def get_frame(self): success, image = self.video.read() ret, jpeg = cv2.imencode('.jpg', image) return jpeg.tobytes() app = Flask(__name__) @app.route('/') def index(): return render_template('index.html') def gen(camera): while True: frame = camera.get_frame() yield (b'--frame\r\n' b'Content-Type: image/jpeg\r\n\r\n' + frame + b'\r\n\r\n') @app.route('/video_feed') def video_feed(): return Response(gen(VideoCamera()), mimetype='multipart/x-mixed-replace; boundary=frame') if __name__ == '__main__': app.run(host='0.0.0.0', debug=True)

このアプローチは(ほぼ)動作することが証明されています。 表示用のアプリケーションとして、任意のWebブラウザーを使用できます。 しかし、フレームレートが予想よりも低く、MinnowboardのCPU負荷が常に100%であることがすぐにわかりました。 組み込みデバイスは、リアルタイムフレームエンコーディングに対応できませんでした。 このソリューションの利点のうち、1秒あたり10フレーム以下の周波数で480pビデオを送信する際の非常に小さな遅延に注目する価値があります。

検索中に、非圧縮のYUVフレームに加えて、MJPEG形式のフレームを生成できるWebカメラが見つかりました。 このような便利な機能を使用して、CPUの負荷を軽減し、トランスコーディングなしでビデオを転送する方法を見つけることが決定されました。

ffmpeg / vlc

まず、みんなのお気に入りのオープンソースffmpegコンバインを試してみました。これにより、とりわけ、UVCデバイスからビデオストリームを読み取り、エンコードして送信することができます。 マニュアルに少し浸った後、コマンドラインキーが見つかり、トランスコードせずに圧縮されたMJPEGビデオストリームを送受信できるようになりました。

ffmpeg -f v4l2 -s 640x480 -input_format mjpeg -i /dev/video0 -c:v copy -f mjpeg udp://ip:port

CPU負荷が低かった。 喜んで、ffplayプレーヤーでストリームを熱心にオープンしました...残念なことに、ビデオの遅延レベルはまったく受け入れられませんでした(約2〜3秒)。 ここからすべてを試し、インターネットをブラウジングしても、肯定的な結果を得ることができず、ffmpegを放棄することにしました。

ffmpegで障害が発生した後、VLCメディアプレーヤーが登場しました。それは、cvlcコンソールユーティリティです。 デフォルトでは、VLCは一連のバッファーを使用します。これは、一方では滑らかな画像を実現するのに役立ちますが、他方では数秒の深刻な遅延をもたらします。 かなり苦しめられたので、ストリーミングがかなり許容できると思われるパラメーターを選びました。 遅延はそれほど大きくなく(約0.5秒)、トランスコーディングはなく、クライアントはビデオを非常にスムーズに表示しました(ただし、クライアントに150ミリ秒の小さなバッファーを残す必要がありました)。

これは、cvlcの最終行です。

cvlc -v v4l2:///dev/video0:chroma="MJPG":width=640:height=480:fps=30 --sout="#rtp{sdp=rtsp://:port/live,caching=0}" --rtsp-timeout=-1 --sout-udp-caching=0 --network-caching=0 --live-caching=0

残念ながら、ビデオは非常に安定して動作せず、0.5秒の遅延は受け入れられませんでした。

MJPG-ストリーマー

実際に私たちのタスクに関する記事を見つけたので、mjpg-streamerを試すことにしました。 それを試してみました、それが好き! 変更なしで、480pの解像度でビデオを大幅に遅延させることなく、mjpg-streamerを必要に応じて使用することができました。

以前の失敗を背景に、私たちは長い間幸せでしたが、それからもっと欲しかったのです。 つまり、チャネルの目詰まりが少し少なくなり、ビデオ品質が720pに向上します。

H264ストリーミング

チャンネルの負荷を軽減するために、使用するコーデックをh264に変更することにしました(インベントリで適切なWebカメラを見つける)。 Mjpg-streamerはh264をサポートしていなかったため、変更することが決定されました。 開発時には、LogitechとELPが製造した、統合されたh264コーデックを備えた2台のカメラを使用しました。 結局のところ、これらのカメラのh264ストリームの内容は大きく異なりました。

カメラとストリーム構造

h264ストリームは、いくつかのタイプのNAL(ネットワークアブストラクションレイヤー)パケットで構成されています。 カメラは5種類のパッケージを生成しました。

- ピクチャパラメータセット(PPS)

- シーケンスパラメーターセット(SPS)

- パーティション化されていないコード化スライスレイヤー、IDR画像

- パーティション化されていないコード化されたスライスレイヤー、非IDR画像

- コード化スライスデータパーティション

IDR(インスタントデコーディングリフレッシュ)-エンコードされたイメージを含むパッケージ。 この場合、イメージのデコードに必要なすべてのデータはこのパッケージに含まれています。 このパッケージは、デコーダがイメージの形成を開始するために必要です。 通常、h264圧縮ビデオの最初のフレームはIDR画像です。

非IDR-他のフレームへのリンクを含むエンコードされた画像を含むパッケージ。 デコーダーは、他のパケットが存在しないと、1つの非IDRフレームでイメージを復元できません。

IDRフレームに加えて、デコーダーは画像をデコードするためにPPSおよびSPSパケットを必要とします。 これらのパケットには、画像とフレームストリームに関するメタデータが含まれています。

mjpg-streamerコードに基づいて、V4L2(video4linux2)APIを使用してカメラからデータを読み取りました。 結局のところ、ビデオの1つの「フレーム」にはいくつかのNALパケットが含まれていました。

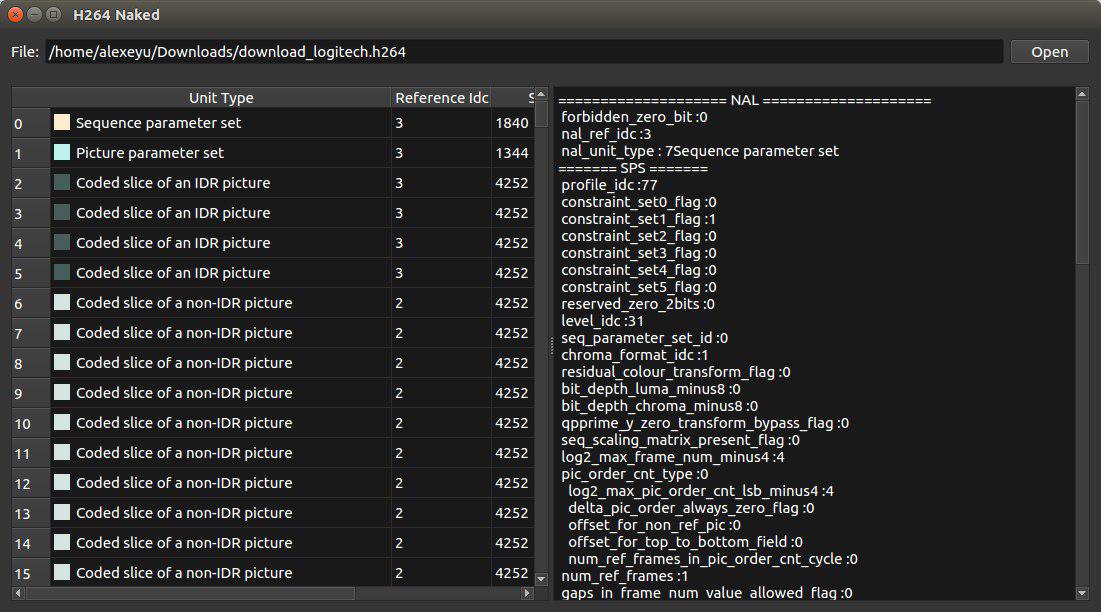

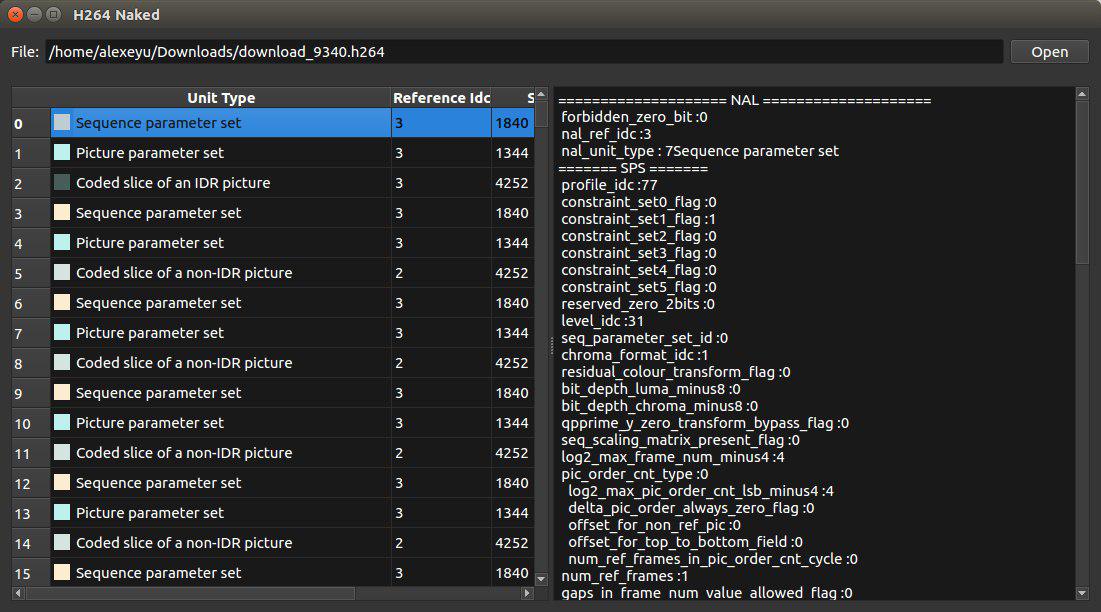

カメラ間で大きな違いが見られたのは、「フレーム」の内容でした。 h264bitstreamライブラリを使用して、ストリームを解析しました。 ストリームのコンテンツを表示するスタンドアロンユーティリティがあります。

Logitechのカメラフレームストリームは、主に非IDRフレームで構成され、いくつかのデータパーティションに分割されていました。 30秒に1回、カメラはIDR画像、SPS、PPSを含むパケットを生成しました。 デコーダーはビデオのデコードを開始するためにIDRパッケージを必要とするため、この状況はすぐには適していませんでした。 残念ながら、カメラがIDRパケットを生成する期間を設定する適切な方法がないことが判明しました。 したがって、このカメラの使用を放棄する必要がありました。

ELPカメラの方がはるかに便利であることがわかりました。 受信した各フレームには、PPSおよびSPSパケットが含まれていました。 さらに、カメラは30フレームごとにIDRパケットを生成しました(期間〜1秒)。 それは私たちにとてもよく合っていて、このカメラを選びました。

mjpg-streamerに基づくブロードキャストサーバーの実装

サーバー部分の基礎として、前述のmjpg-streamerを使用することが決定されました。 そのアーキテクチャにより、新しい入出力プラグインを簡単に追加できました。 まず、デバイスからh264ストリームを読み取るプラグインを追加しました。 出力プラグインとして、既存のhttpプラグインを選択しました。

V4L2では、h264ストリームの受信を開始するためにV4L2_PIX_FMT_H264形式のフレームを受信するように指定するだけで十分でした。ストリームのデコードにはIDRフレームが必要なので、ストリームを解析し、IDRフレームを予期しました。 クライアントアプリケーションには、このフレームからストリームがHTTP経由で送信されました。

クライアント側では、ffmpegプロジェクトのlibavformatとlibavcodecを使用して、h264ストリームの読み取りとデコードを行うことにしました。 最初のテストプロトタイプでは、ネットワーク経由でストリームを受信し、それをフレームに分割し、デコードをffmpegに割り当て、結果のデコードされた画像をNV12形式からRGBに変換し、OpenCVに表示を実装しました。

最初のテストでは、ビデオをブロードキャストするこの方法は実行可能であることが示されましたが、大幅な遅延(約1秒)があります。 私たちの疑いはhttpプロトコルにかかっていたため、UDPを使用してパケットを送信することにしました。

RTPのような既存のプロトコルをサポートする必要がないため、h264ストリームのNALパケットがUDPデータグラム内で送信される最も単純な

タブレットで使用されているAtom Z3740プロセッサはQuick Sync Video(QSV)テクノロジーをサポートしているため、libavcodecのQSV h264デコーダーを使用してみました。 驚いたことに、彼は状況を改善するだけでなく、強力なデスクトップPCでも遅延を1.5秒に増やしました! ただし、このアプローチはCPUの負荷を大幅に削減しました。

ffmpegでデコーダのさまざまな構成オプションを試した後、libavcodecを放棄してIntel Media SDKを直接使用することが決定されました。

私たちにとって最初の驚きは、Media SDKを使用して開発することを決めた人が急いで誘われるという恐怖でした。 開発者に提供される公式の例は、すべてを実行できる強力な組み合わせですが、それを把握するのは困難です。 幸いなことに、 Intelフォーラムで、この例にも不満を抱いている志を同じくする人々を見つけました。 彼らは古いがより消化しやすいチュートリアルを見つけました。 simple_2_decodeの例に基づいて、次のコードを取得しました。

Intel Media SDKによるストリームデコード

mfxStatus sts = MFX_ERR_NONE; // h264 mfxBitstream mfx_bitstream; memset(&mfx_bitstream, 0, sizeof(_mfxBS)); mfx_bitstream.MaxLength = 1 * 1024 * 1024; // 1MB mfx_bitstream.Data = new mfxU8[mfx_bitstream.MaxLength]; // UDP StreamReader *reader = new StreamReader(/*...*/); MFXVideoDECODE *mfx_dec; mfxVideoParam mfx_video_params; MFXVideoSession session; mfxFrameAllocator *mfx_allocator; // MFX mfxIMPL impl = MFX_IMPL_AUTO; mfxVersion ver = { { 0, 1 } }; session.Init(sts, &ver); if (sts < MFX_ERR_NONE) return 0; // :( // , AVC (h.264) mfx_dec = new MFXVideoDECODE(session); memset(&mfx_video_params, 0, sizeof(mfx_video_params)); mfx_video_params.mfx.CodecId = MFX_CODEC_AVC; // mfx_video_params.IOPattern = MFX_IOPATTERN_OUT_SYSTEM_MEMORY; // mfx_video_params.AsyncDepth = 1; // reader->ReadToBitstream(&mfx_bitstream); sts = mfx_dec->DecodeHeader(&mfx_bitstream, &mfx_video_params); if (sts < MFX_ERR_NONE) return 0; // :( // mfxFrameAllocRequest request; memset(&request, 0, sizeof(request)); sts = mfx_dec->QueryIOSurf(&mfx_video_params, &request); if (sts < MFX_ERR_NONE) return 0; // :( mfxU16 numSurfaces = request.NumFrameSuggested; // 32 mfxU16 width = (mfxU16)MSDK_ALIGN32(request.Info.Width); mfxU16 height = (mfxU16)MSDK_ALIGN32(request.Info.Height); // NV12 - YUV 4:2:0, 12 mfxU8 bitsPerPixel = 12; mfxU32 surfaceSize = width * height * bitsPerPixel / 8; // mfxU8* surfaceBuffers = new mfxU8[surfaceSize * numSurfaces]; // mfxFrameSurface1** pmfxSurfaces = new mfxFrameSurface1*[numSurfaces]; for(int i = 0; i < numSurfaces; i++) { pmfxSurfaces[i] = new mfxFrameSurface1; memset(pmfxSurfaces[i], 0, sizeof(mfxFrameSurface1)); memcpy(&(pmfxSurfaces[i]->Info), &(_mfxVideoParams.mfx.FrameInfo), sizeof(mfxFrameInfo)); pmfxSurfaces[i]->Data.Y = &surfaceBuffers[surfaceSize * i]; pmfxSurfaces[i]->Data.U = pmfxSurfaces[i]->Data.Y + width * height; pmfxSurfaces[i]->Data.V = pmfxSurfaces[i]->Data.U + 1; pmfxSurfaces[i]->Data.Pitch = width; } sts = mfx_dec->Init(&mfx_video_params); if (sts < MFX_ERR_NONE) return 0; // :( mfxSyncPoint syncp; mfxFrameSurface1* pmfxOutSurface = NULL; mfxU32 nFrame = 0; // while (reader->IsActive() && (MFX_ERR_NONE <= sts || MFX_ERR_MORE_DATA == sts || MFX_ERR_MORE_SURFACE == sts)) { // if (MFX_WRN_DEVICE_BUSY == sts) Sleep(1); if (MFX_ERR_MORE_DATA == sts) reader->ReadToBitstream(mfx_bitstream); if (MFX_ERR_MORE_SURFACE == sts || MFX_ERR_NONE == sts) { nIndex = GetFreeSurfaceIndex(pmfxSurfaces, numSurfaces); if (nIndex == MFX_ERR_NOT_FOUND) break; } // // NAL- sts = mfx_dec->DecodeFrameAsync(mfx_bitstream, pmfxSurfaces[nIndex], &pmfxOutSurface, &syncp); // if (MFX_ERR_NONE < sts && syncp) sts = MFX_ERR_NONE; // if (MFX_ERR_NONE == sts) sts = session.SyncOperation(syncp, 60000); if (MFX_ERR_NONE == sts) { // ! mfxFrameInfo* pInfo = &pmfxOutSurface->Info; mfxFrameData* pData = &pmfxOutSurface->Data; // NV12 // Y: pData->Y, // UV: pData-UV, 2 Y } } //

Media SDKを使用してビデオデコードを実装した後、同様の状況に直面しました-ビデオ遅延は1.5秒でした。 必死に、フォーラムに目を向けると、ビデオのデコードの遅延を減らすためのヒントが見つかりました。

Media SDK h264デコーダーは、デコードされたイメージを発行する前にフレームを蓄積します。 「ストリームの終了」フラグがデコーダーに送信されるデータの構造(mfxBitstream)に設定されている場合、遅延は約0.5秒に減少することがわかりました。

mfx_bitstream.DataFlag = MFX_BITSTREAM_EOS;

さらに、ストリームの終わりのフラグが設定されている場合でも、デコーダーはキューに5つのフレームを保持することが実験的にわかっています。 その結果、「ストリームの最後」をシミュレートし、デコーダーにこのキューからフレームを出力させるコードを追加する必要がありました。

if( no_frames_in_queue ) sts = mfx_dec->DecodeFrameAsync(mfx_bitstream, pmfxSurfaces[nIndex], &pmfxOutSurface, &syncp); else sts = mfx_dec->DecodeFrameAsync(0, pmfxSurfaces[nIndex], &pmfxOutSurface, &syncp); if (sts == MFX_ERR_MORE_DATA) { no_frames_in_queue = true; }

その後、遅延レベルは許容可能なレベルまで低下しました。 目に見えない視線。

結論

ビデオをリアルタイムでブロードキャストするタスクを開始し、既存のソリューションを使用し、自転車なしで実行することを非常に期待していました。

私たちの主な希望は、FFmpegやVLCなどのビデオジャイアントでした。 彼らは私たちが必要とすること(トランスコーディングなしでビデオを送信する)ができるように見えるという事実にもかかわらず、ビデオ送信に起因する遅延を取り除くことができませんでした。

mjpg-streamerプロジェクトにほとんどつまずいたので、MJPG形式でビデオを放送するそのシンプルさと正確な作業に魅了されました。 この特定の形式を突然転送する必要がある場合は、使用することを強くお勧めします。 ソリューションを実装したのがその根拠にあったことは偶然ではありません。

開発の結果、ビデオを遅延なく送信するためのかなり軽量なソリューションが得られました。送信側または受信側のリソースを必要としません。 Intel Media SDKライブラリは、バッファリングせずにフレームをレンダリングするために少し力を入れなければならなかったにもかかわらず、ビデオデコードタスクで非常に役立ちました。