必要な序文:私は、大衆に光をもたらす現代的な形式を試して、YouTubeでディープラーニングをストリーミングしようとすることにしました。

特に、ある時点で注意を払うように頼まれました。そのために、機械翻訳、シーケンスからシーケンス、写真への適用などについて話す必要があります。 その結果、1時間そのようなストリームを取得しました。

他の投稿から、動画のトランスクリプトを投稿するのが慣習であることがわかりました。 代わりに、ビデオに欠けているもの、つまりシーケンスを操作するための新しいアテンションベースのニューラルネットワークアーキテクチャについて説明します。 機械翻訳、現在のアプローチ、どこから注目が寄せられているかなどについて追加の背景が必要な場合は、ビデオをご覧ください。

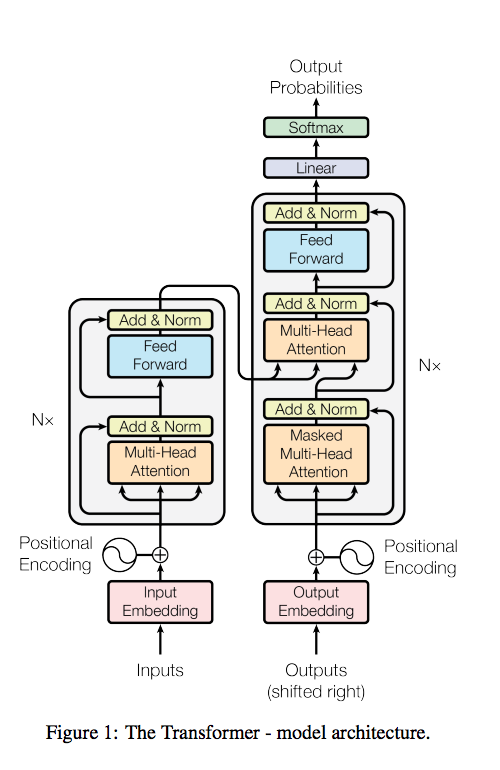

Transformerと呼ばれる新しいアーキテクチャはGoogleで開発され、記事Attention Is All You Need( arxiv )で説明されており、Google Researchブログ (あまり詳細ではありませんが、写真付き)に投稿されています。

行こう

前のエピソードの超要約

ディープラーニングでの機械翻訳のタスクは、(他の多くのタスクと同様に)シーケンスの操作に帰着します。つまり、文を単語のシーケンスとして受け取り、別の言語で単語のシーケンスを生成できるモデルをトレーニングします。 現在のアプローチでは、モデル内に通常エンコーダーとデコーダーがあります-エンコーダーは特定の空間で入力文の単語を1つ以上のベクトルに変換し、デコーダーはこれらのベクトルから別の言語の単語のシーケンスを生成します。

エンコーダーの標準アーキテクチャーはRNNまたはCNNで、デコーダーの場合、ほとんどの場合RNNです。 さらなる開発がこのスキームに注目を集め、それについてのストリームを見ることをお勧めします。

そして現在、この問題を解決するための新しいアーキテクチャが提案されていますが、これはRNNでもCNNでもありません。

これがメイン画像です。 何が入っているの!

エンコーダーおよびマルチヘッドアテンションレイヤー

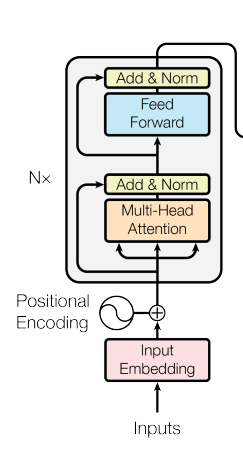

まず、エンコーダー、つまり、単語を受信し、デコーダーによって使用される単語に対応する何らかの種類の埋め込みを発行するネットワークの一部を検討します。

具体的には次のとおりです。

アイデアは、各単語が画像内のレイヤーを並行して通過することです。

それらの一部は標準の完全に接続されたレイヤーであり、一部はResNet(Addピクチャ内)のようなショートカット接続です。

しかし、これらのレイヤーの新しい興味深い点は、マルチヘッドアテンションです。 これは、RNNのように隠れた状態やCNNのように隣接する単語を渡すのではなく、各入力ベクトルがアテンションメカニズムを介して他の単語と対話できるようにする特別な新しいレイヤーです。

クエリベクトルと、いくつかのキーと値のペアが与えられます(実際には、キーと値は常に同じベクトルです)。 それらのそれぞれは訓練された線形変換によって変換され、次にすべてのKとのスカラー積Qが順に計算され、これらのスカラー積の結果がsoftmaxを通過し、得られた重みですべてのベクトルVが単一のベクトルに合計されます。 この注意の表現は、注意が使用される以前の作品に非常に近いものです。

彼らがそれに追加する唯一のことは、いくつかのそのような注意が並列に訓練されていることです(写真の番号はhで示されています)、すなわち いくつかの線形変換と並列スカラー積/加重和。 そして、これらすべての並列アテンションの結果が連結され、もう一度訓練された線形変換を実行し、出口に進みます。

しかし、一般に、そのような各モジュールは、クエリベクトルと、キーと値のベクトルセットをその入力として受け取り、各入力と同じサイズの1つのベクトルを生成します。

これが何をもたらすかは明らかではありません。 標準的なアテンションでは、「直観」は明確です-アテンションネットワークは、ある単語が他の単語に近い場合に、文内のある単語と別の単語の対応を伝えようとします。 そして、これは1つのネットワークです。 ここでも同じことですが、並行してネットワークの束がありますか? そして、彼らは同じことをしますが、出力は一定ですか? しかし、そのときのポイントは何ですか、彼らはまったく同じことを学ばないのでしょうか?

いや 言葉のいくつかの側面に注意を払う必要がある場合、これはネットワークにこれを行う機会を与えます。

このトリックは非常に頻繁に使用されます-異なる方向に異なるレイヤーをプッシュするには、愚かな異なる初期ランダムウェイトで十分であることがわかります。

言葉のいくつかの側面は何ですか?

たとえば、単語にはセマンティックな意味とプログラムに関する特徴があります。

セマンティックコンポーネントと文法の観点から、近傍に対応するベクトルを取得したいと思います。

このようなブロックは入力と同じサイズのベクトルを出力するため、このブロックはネットワークに数回挿入され、ネットワークに深さが追加されます。 実際には、マルチヘッドアテンション、残留層、完全接続層の組み合わせを6回使用します。つまり、非常に深いネットワークです。

最後に言うことは、各単語の特徴の1つが位置エンコードであるということです。 文中の彼の位置。 たとえば、これにより、ワードプロセッシングプロセスで隣接する単語が重要である場合、それらに簡単に「注意を払う」ことができます。

特徴として、ワードベクトルと同じサイズのベクトルを使用し、異なる周期の位置のサインとコサインを含むので、目的の周期の座標を選択することで相対オフセットに注意を払うことができます。

代わりに、ポジションの埋め込みも学習しようとしましたが、サインと同じことがわかりました。

LayerNormalization( arxiv )もあります。 これは、各サンプル内のトレーナー内のすべてのニューロンからの出力を正規化する正規化手順です(バッチ正規化のようにバッチ内の各ニューロンとは異なり、明らかにBNが好きではないため)。

1つのバッチの異なる文の正規化統計はすべてを損なうだけなので、BNはリカレントネットワークでは機能しないと言いますが、文はすべて異なる長さであるため、役に立ちません。 この効果はこのアーキテクチャでも予想され、BNは有害ですか?

なぜ彼らがBNを取らなかったのかは興味深い質問であり、記事では特にコメントされていません。 たとえば、音声認識でRNNを使用する試みは成功しているようです。 Baidu( arxiv )、AFAIRによるDeep Speech 2

エンコーダーの動作をポイントごとにまとめてみましょう。

エンコーダー操作:

- 埋め込みは、文のすべての単語に対して行われます(同じ次元のベクトル)。 たとえば、これ

I am stupid

という文I am stupid

。 埋め込みでは、文中の単語の位置が追加されます。 - 最初の単語のベクトルと2番目の単語のベクトル(

I

、am

)が取得され、1つの出力を持つ単一層ネットワークに供給され、類似度(スカラー値)が得られます。 このスカラー量に2番目の単語のベクトルが乗算され、コピーの類似値によって多少弱められます。 - 2番目の単語の代わりに、3番目の単語が提供され、段落2と同じことが行われます。 同じ重みを持つ同じネットワークで(ベクトル

I

、stupid

)。 - 文の残りのすべての単語に対して同じことを行うことにより、それらの「弱められた」(重み付けされた)コピーが取得され、最初の単語との類似度を表します。 さらに、これらのすべての加重ベクトルが加算され、1つの埋め込みの次元の1つの結果ベクトルが取得されます。

output=am * weight(I, am) + stupid * weight(I, stupid)

これが「通常の」注意のメカニズムです。 - 1つの方法(1つの基準による)での単語の類似性の評価は不十分と見なされるため、同じこと(p。2-4)が他の重みで数回繰り返されます。 1つの注意と同様に、セマンティックロードによって単語の類似性を判断し、文法によって残りの部分を何らかの方法で判断できます。

- 請求項5の出口で いくつかのベクトルが判明します。各ベクトルは、最初の単語(

I

)との類似性に関する文の他のすべての単語の加重合計です。 これを一つにまとめています。 - 次に、パラグラフ6の結果の次元を減らす線形変換の別のレイヤーを配置します。 1つの埋め込みのベクトルの次元に。 文の他のすべての単語の重み付きベクトルで構成される、文の最初の単語の特定の表現が判明します。

文内の他のすべての単語に対して同じプロセスが実行されます。

- 出力の次元は同じであるため、同じことを再び行うことができます(p。2-8)が、元の単語の埋め込みの代わりに、このマルチヘッドアテンションを通過した後に取得したものを取得し、他の重みで減衰ネットワークを取得します(レイヤー間の重みは一般的ではありません)。 そして、あなたはそのようなレイヤーの多くを行うことができます(Google 6)。 ただし、完全に接続されたレイヤーと残りの接続は、ネットワークに表現力を追加するために、1番目と2番目のレイヤーの間に追加されます。

彼らのブログでは、このプロセスは美しいGIFで視覚化されています。今のところ、エンコード部分のみを見てください。

そしてその結果、各単語について、最終的な出力が得られます-埋め込み、デコーダはそれを監視します。

デコーダーに移動します

また、デコーダーは一度に1ワードを開始し、最後のワードを入力として受け取り、次のワードを発行する必要があります(最初の反復で特別な<start>

トークンを受け取ります)。

デコーダーでのマルチヘッドアテンションの使用には、2つの異なるタイプがあります。

- 1つ目は、エンコードプロセスと同じように、過去のデコードされた単語のベクトルにアクセスする機能です(ただし、すべてにアクセスすることはできませんが、既にデコードされている単語にのみアクセスできます)。

- 2番目は、エンコーダー出力にアクセスする機能です。 この場合、Queryはデコーダーの入力ベクトルであり、Key / Valueペアはエンコーダーの最後の埋め込みです。ここでも同じベクトルがキーと値の両方になります(ただし、アテンションモジュール内の線形変換は異なります)。

中央にはまだFCレイヤーがありますが、これも同じ残留接続とレイヤーの正規化です。

そして、これはすべて6回繰り返され、前のブロックの出力が次のブロックの入力に送られます。

最後に、ネットワークの最後に通常のソフトマックスがあり、単語の確率を示します。 それからのサンプリングが結果、つまり文の次の単語です。 デコーダの次の開始を入力に渡し、デコーダが<end of sentence>

トークン<end of sentence>

発行するまでプロセスが繰り返されます。

もちろん、これは通常どおり、すべてエンドツーエンドで微分可能です。

これで、gif全体を見ることができます。

エンコード中、各ベクトルは他のすべてのベクトルと相互作用します。 デコード中、次の各ワードは前のワードおよびエンコーダーベクトルと相互作用します。

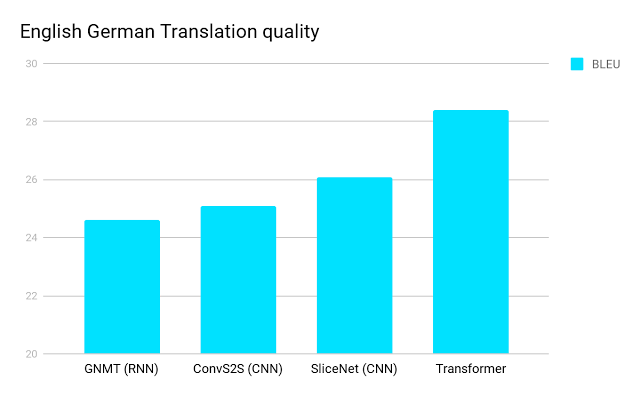

結果

そして、これは機械翻訳の最新技術をきちんと改善します。

BLEUの2ポイント-これは非常に深刻です。特に、これらの値では、BLEUは人が翻訳をどれだけ気に入っているかと相関関係が高まるためです。

一般に、主な革新は、RNNまたはCNNメカニズムの代わりに、文章内の他の単語と対話するための自己注意メカニズムの使用です。

ネットワークは、コンテキストの長さに関係なく、同じ情報に簡単にアクセスできるため、前の単語または10ステップ前の単語に簡単にアクセスできるため、これが役立つと理論的に説明しています。

これから学ぶのは簡単で、各ステップを順番に実行する必要があるRNNとは異なり、計算を並行して実行できます。

彼らはまた、Constituency Parsing、つまり解析のために同じアーキテクチャを試してみましたが、すべてがうまくいきました。

TransformerがGoogle Translateの制作で既に使用されているという確認はまだありませんが(使用することを考える必要があります)、 Yandexでの使用については、YandexのAnton Frolovのインタビューで言及されています(念のため、タイムスタンプ32:40)。

私は何を言うことができます-よくやったとGoogle、そしてYandex! 新しいアーキテクチャが登場することは非常にクールであり、注意はもはやRNNを改善するための標準的な部分ではなく、問題を再検討する機会を与えてくれます。 だから、あなたは標準的なピースとしてメモリを見て、それに到達します。