この機能は壊滅的な忘却と呼ばれます。 ただし、DeepMindとImperial College Londonの科学者は、以前のタスクの「記憶」を維持しながら新しいスキルを習得できるディープニューラルネットワークの学習アルゴリズムを開発しました。

/写真ディーン・ホックマン CC

/写真ディーン・ホックマン CC

ニューラルネットワークはいくつかのリンクで構成され、それぞれの重みが計算されます。 ニューラルネットワークの各重みには、その重要性を決定するパラメーターFが割り当てられます。 特定のニューロンのF値が高いほど、さらなるトレーニング中に置き換えられる可能性は低くなります。 したがって、ニューラルネットワークは、いわば、最も重要な獲得スキルを「記憶」しています。

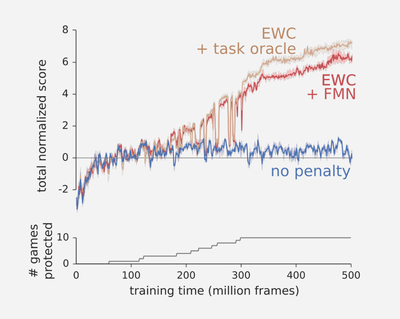

この技術は、弾性重量の統合、または「天びんの弾性固定」と呼ばれます。 アルゴリズムはAtariゲームでテストされました。 科学者は、「重みを固定する」ことなく、プログラムがゲームのプレイを停止するとすぐにゲームを忘れることを示しました(青いグラフ)。 EWCアルゴリズムを使用する場合、ニューラルネットワークは、以前のすべてのタスクを完了するために必要な重みを「記憶」していました。 EWCネットワークはそれぞれ古典的なアルゴリズムを失いましたが、すべての段階の合計で良い結果を示しました(赤と茶色のグラフ)。

この研究の著者は、科学界はすでにいくつかのタスクを一度に実行できるディープニューラルネットワークを作成しようとしていると述べています。 ただし、過去のソリューションでは、ネットワークが多数の連続したサンプル(および複数の連続したサンプルではない)ですぐにトレーニングされたため、十分に強力でないか、大きな計算リソースが必要でした。 このアプローチでは、アルゴリズムを人間の脳の原理に近づけることはできませんでした。

テキスト、音楽、長いデータシリーズを扱うための代替のニューラルネットワークアーキテクチャがあります。 これらは再帰と呼ばれ、長期および短期の記憶を持っています。これにより、グローバルな問題からローカルな問題に切り替えることができます(たとえば、個々の単語の分析から言語全体のスタイルのルールまで)。

再帰的ニューラルネットワークにはメモリがありますが、たとえばグラフィックス処理などで遭遇する複雑な属性セットを分析する能力は、ディープネットワークよりも劣っています。 したがって、DeepMindの将来の新しいソリューションにより、非線形変換を必要とする問題を解決するためのソフトウェアのアプリケーションを見つけるスマートユニバーサルアルゴリズムを作成できます。

PSブログの興味深い資料: