Virtual SANの概念

VMware Virtual SAN(以降vSAN)は、vSphereに基づくハイパーコンバージドインフラストラクチャ(HCI)の組織向けの分散ソフトウェアストレージシステム(SDS)です。 vSANはESXiハイパーバイザーに組み込まれているため、追加のサービスやサービスVMを展開する必要はありません。 vSANを使用すると、ローカルホストメディアを単一のストレージプールに結合して、特定のレベルのフォールトトレランスを提供し、すべてのホストとVMクラスターにそのスペースを提供できます。 したがって、仮想化(vSphereテクノロジー)のすべての機能を明らかにするために必要な集中ストレージを取得し、専用の(従来の)ストレージシステムを実装および維持する必要はありません。

vSANはvSphereクラスターレベルで開始されます。クラスターの管理で対応するサービスを開始し、クラスターホストのローカルメディアを手動モードまたは自動モードで提供するだけで十分です。 VMwareインフラストラクチャの外部で動作できる独立したSDS製品が存在できないため、vSANはvSphereに組み込まれており、vSphereにしっかりと接続されています。

vSANの類似製品と競合製品は、Nutanix DSF(Nutanix Distributed Storage)、Dell EMC ScaleIO、Datacore Hyper-converged Virtual SAN、HPE StoreVirtualです。 これらのすべてのソリューションは、VMware vSphereだけでなく、MS Hyper-V(一部はKVM)とも互換性があり、各HCIホストにサービスVMのインストールと起動が必要です。これは、SDSが機能するために必要であり、ハイパーバイザーに組み込まれていません。

HCIの重要なプロパティ。 VMware vSphere + vSANは、水平方向のスケーラビリティとモジュラーアーキテクチャです。 HCIは、同一のサーバーブロック(ホストまたはノード)に基づいて構築および拡張され、コンピューティングリソース、ストレージリソース(ローカルメディア)、およびネットワークインターフェイスを組み合わせます。 これは、個別に提供されるコモディティ機器(ブランド製品を含むx86サーバー)、または既製のアプリケーション(Nutanix、vxRail、Simplivityなど)になります。 統合ソフトウェア(たとえば、vSphere + vSAN + VMM_orientationツール)を使用すると、仮想化環境、SDN(ソフトウェア定義ネットワーク)、SDS、集中管理および自動化/オーケストレーションツールなど、これらのブロックに基づいてソフトウェア定義データセンター(SDDS)を作成できます。 もちろん、専用の物理ネットワーク機器(スイッチ)の必要性を忘れてはなりません。これがなければ、HCIホスト間の相互作用は不可能です。 同時に、データセンターがネットワークを整理するのに最適なリーフスパインアーキテクチャを使用することをお勧めします。

vSANは、vCenterの下のESXiホストクラスターレベルで上昇し、クラスター内のホストに分散集中ストレージを提供します。 vSANクラスターは、2つのバージョンで実装できます。

•ハイブリッド-フラッシュドライブはキャッシュ(キャッシュレイヤー)として使用され、HDDはメインストレージ容量(容量レイヤー)を提供します。

•オールフラッシュ-フラッシュドライブは、キャッシュと容量の両方のレベルで使用されます。

メディアを既存のホストに追加するか、クラスターに新しいホストをインストールすることにより、vSANクラスターを拡張できます。 クラスターのバランスを維持する必要があることに留意してください。つまり、理想的には、ホスト(およびホスト自体)のメディアの構成は同一である必要があります。 クラスターのvSANキャパシティに参加しているメディアのないホストを含めることはできますが、お勧めできませんが、vSANクラスターの共有ストレージでVMをホストすることもできます。

vSANと従来の外部ストレージシステムを比較すると、次の点に注意する必要があります。

•vSANでは、外部ストレージおよび専用ストレージネットワークの組織は必要ありません。

•vSANでは、LUNとファイルグローブのスライスを必要とせず、それらをホストおよび関連するネットワーク相互作用設定に提示します。 アクティブ化後、vSANはすべてのクラスターホストですぐに使用可能になります。

•vSANデータ送信は、独自の独自プロトコルを使用して実行されます。 vSANの組織と運用のための標準のSAN / NASプロトコル(FC、iSCSI、NFS)は必要ありません。

•vSAN管理は、vSphereコンソールからのみ実行されます。 vSphere用の個別の管理ツールや特別なプラグインは必要ありません。

•専用のストレージマネージャーは必要ありません。 vSANの構成とメンテナンスは、vSphere管理者が実行します。

メディアおよびディスクグループ

各vSANクラスターホストには、少なくとも1つのキャッシュとデータメディア(容量またはデータディスク)が必要です。 各ホスト内のこれらのメディアは、1つ以上のディスクグループに結合されます。 各ディスクグループには、1つのキャッシュメディアと、永続ストレージ用の1つ以上のストレージメディアのみが含まれます。

vSANによって提供され、ディスクグループに追加されたメディアは完全に使用され、他のタスクや複数のディスクグループでは使用できません。 これは、キャッシュドライブと容量ドライブの両方に適用されます。

vSANは、DASを介して接続されたローカルメディアまたはドライブのみをサポートします。 SAN / NAS経由で接続されたvSANストレージをストレージプールに含めることはサポートされていません。

オブジェクトストレージ

vSANはオブジェクトストレージであり、その中のデータはオブジェクトと呼ばれる「柔軟な」コンテナの形式で保存されます。 オブジェクトは、クラスター全体に分散されたデータまたはメタデータを内部に保存します。 以下は、vSANオブジェクトの主な種類です(VMごとに個別に作成されます)。

したがって、各VMのデータは、上記のオブジェクトのセットとしてvSANに保存されます。 次に、各オブジェクトには、選択したストレージポリシーとデータ量に応じて、クラスター全体に分散された多くのコンポーネントが含まれます。

vSANのストレージ管理は、SPBM(ストレージポリシーベースの管理)メカニズムを使用して実装され、バージョン6のすべてのvSphereストレージがどの影響を受けるかによって影響を受けます。ストレージポリシーは、許容する障害の数、フォールトトレランス(レプリケーションまたは消去コーディング)およびオブジェクトのストライプ数(オブジェクトごとのディスクストライプ数)。 ポリシーで指定されたストリップの数によって、オブジェクトが広がるストレージメディアの数が決まります。

ポリシーを特定のVMまたはそのディスクにバインドすると、オブジェクトのコンポーネントの数とクラスター全体でのそれらの分布が決まります。

vSANでは、VMを停止することなく、オブジェクトのストレージポリシーをオンザフライで変更できます。 同時に、オブジェクトの再構成のプロセスがバックグラウンドで起動されます。

オブジェクトをクラスタ全体に分散する場合、vSANは、異なるオブジェクトレプリカおよび監視コンポーネントに関連するコンポーネントが異なるノードまたは障害ドメイン(サーバーラック、バスケット、またはプラットフォーム)に分散されるように制御します。

証人と定員会

監視は、有用なデータ(メタデータのみ)を含まないサービスコンポーネントであり、そのサイズは2〜4MBです。 障害が発生した場合にオブジェクトのライブコンポーネントを決定する際のタイブレーカーとして機能します。

vSANのクォーラム計算メカニズムは次のように機能します。 オブジェクトの各コンポーネントは、一定数の投票(投票)-1以上を受け取ります。 完全なレプリカと投票の半分以上が利用可能な場合、定足数に達し、オブジェクトは「生きている」と見なされます。

このようなクォーラム計算メカニズムにより、場合によっては、ミラーリング監視を作成せずにできるように、オブジェクトのコンポーネントをクラスター全体に分散できます。 たとえば、RAID-5 / 6を使用する場合、またはRAID-1でストリッピングする場合。

Virtual SANデータストア

vSphereクラスターでvSANサービスを有効にすると、同じ名前のデータストアが表示されますが、vSANクラスター全体で唯一のデータストアにすることができます。 上記のSPBMメカニズムにより、単一のvSANストレージ内で、各VMまたはそのディスクは、目的のストレージポリシーにバインドすることで、必要なレベルのサービス(フォールトトレランスとパフォーマンス)を取得できます。

ホストにvSANに含まれるローカルメディアがあるかどうかに関係なく、vSANデータストアはクラスター内のすべてのホストで使用できます。 同時に、クラスターホストは他の種類のデータストア(VVol、VMFS、NFS)にアクセスできます。

vSANデータストアは、VMFS / NFSリポジトリを使用したStorage vMotion(VMディスクのホットマイグレーション)をサポートしています。

単一のvCenterサーバー内に複数のvSANクラスターを作成できます。 vSANクラスタ間のStorage vMotionがサポートされています。 さらに、各ホストは1つのvSANクラスターのメンバーにしかなれません。

他のVMwareテクノロジーとのVSANの互換性

vSANは互換性があり、ほとんどのVMwareテクノロジーをサポートしています。 特に、vMotion、Storage vMotion、HA、DRS、SRM、vSphere Replication、スナップショット、クローン、VADP、Horizon Viewなどの共通ストレージが必要です。

vSANは、DPM、SIOC、SCSI予約、RDM、VMFSをサポートしていません。

VSANハードウェア要件

ストレージ要件

メディア、コントローラー、およびドライバーとファームウェアは、vSAN認定され、適切なVMware互換性シート(VMware互換性ガイドのVirtual SANセクション)に表示される必要があります。

ストレージコントローラーとして、SAS / SATA HBAまたはRAIDコントローラーを使用できます。これらはパススルーモードで機能する必要があります(ディスクはRAIDアレイを作成せずにコントローラーによってそのまま提供されます)またはraid-0。

SAS / SATA / PCIe –SSDおよびNVMeメディアは、キャッシュメディアとして使用できます。

ハイブリッド構成用のSAS / SATA HDDおよびオールフラッシュ構成用の上記のすべてのタイプのフラッシュ(SAS / SATA / PCIe –SSDおよびNVMe)は、ストレージメディアとして使用できます。

RAMとCPUの要件

ホストメモリの量は、ディスクグループの数とサイズによって決まります。

vSANクラスターに参加するホストRAMの最小量は8GBです。

ディスクグループの最大構成(7つのストレージメディアの5つのディスクグループ)をサポートするために必要なホストRAMの最小量は32GBです。

vSANは、プロセッサリソースの約10%を使用します。

ネットワーク要件

ハイブリッド構成用の1Gbps専用アダプター

オールフラッシュ構成用の専用または共有10 Gbpsアダプター

vSANサブネットでマルチキャストトラフィックを許可する必要があります

ブータブルメディア

vSANからホストをロードするには、ローカルのUSBまたはSDメディアとSATADOMを使用できます。 最初の2種類のメディアは、リブート後にログとトレースを保存しません。これらはRAMディスクに書き込まれるためです。後者は保存するため、サバイバビリティとパフォーマンスが高いSATADOM SLCクラスのメディアを使用することをお勧めします。

VSAN 6.5構成の最高値

vSANクラスターあたり最大64ホスト(ハイブリッドとオールフラッシュの両方)

ホストあたり最大5つのディスクグループ

ディスクグループあたり最大7容量のメディア

ホストごとに200以下のVM、クラスターごとに6000以下のVM

ホストあたり9000以下のコンポーネント

最大VMディスクサイズ-62TB

オブジェクトごとのストリップ内のメディアの最大数-12

VMware Virtual SANの技術的機能

vSANクラスターの計画

vSANクラスターホストの最小数は、許容される障害の数(ストレージポリシーの許容障害数パラメーター)によって決定され、式:2 * number_of_failures_to_tolerate + 1によって決定されます。

1つの障害を実行する条件下で、vSANは2および3ノードのクラスターの作成を許可します。 オブジェクトとそのレプリカは2つのホストでホストされ、目撃者は3mでホストされます。 次の制限が表示されます。

•1つのホストが落ちた場合、新しい障害から保護するためのデータ再構築の可能性はありません。

•1つのホストをサービスモードに転送する場合、データ移行の可能性はありません;この時点で残りのホストのデータは安全ではなくなります。

これは、単にデータを再構築または移行する場所がなく、追加の空きホストがないという事実によるものです。 したがって、vSANクラスターを4つのホストから使用する場合に最適です。

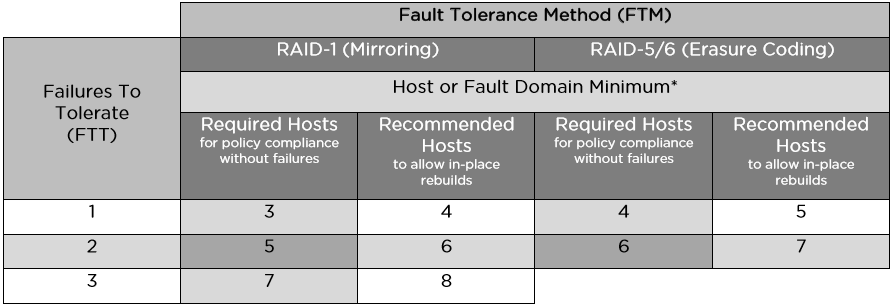

ルール2 * number_of_failures_to_tolerate + 1は、ミラーリングを使用してフォールトトレランスを提供する場合にのみ適用可能です。 Erasure Codingを使用する場合、機能しません。詳細については、「フォールトトレランスの提供」セクションで説明します。

vSANクラスターのバランスをとるには、主にメディアおよびストレージコントローラー用のホストのハードウェア構成が同一である必要があります。

不均衡なクラスター(ホストディスクグループの異なる構成)がサポートされていますが、次のような欠点があります。

•最適でないクラスターパフォーマンス。

•ホスト容量の不均一な使用。

•ホストのエスコート手順の違い。

vSANデータストア上のvCenterサーバーでVMをホストできますが、vSANに問題がある場合、インフラストラクチャ管理に関連するリスクにつながります。

VSANキャッシュの計画

キャパシティレベルを拡張するには、余裕を持ってキャッシュのサイズを計画することをお勧めします。

ハイブリッド構成では、キャッシュの30%が書き込みに割り当てられ、70%が読み取りに割り当てられます。 オールフラッシュvSAN構成では、書き込みキャッシュの全容量が使用され、読み取りキャッシュは提供されません。

推奨されるキャッシュサイズは、レプリケーション前の実際のVM容量の少なくとも10%である必要があります。 使用可能なスペースは考慮されますが、実際には使用されません(レプリケーションは考慮されます)。

ハイブリッド構成では、ディスクグループはインストールされているフラッシュメディアの全容量を使用しますが、最大容量は制限されません。

オールフラッシュ構成では、キャッシュされたデータがメディアのボリューム全体に周期的に記録されるため、ディスクグループはインストールされたフラッシュメディアの600 GBを超える容量を使用できませんが、残りのスペースはアイドル状態になりません。 オールフラッシュvSANでは、キャパシティメディアに比べて高速で寿命の長いキャッシュ付きフラッシュメディアを使用することをお勧めします。 キャッシュに600 GBを超える容量のメディアを使用してもパフォーマンスには影響しませんが、これらのメディアの寿命は延びます。

オールフラッシュvSANでキャッシュを整理するこのアプローチは、フラッシュ容量のメディアが既に高速であるため、読み取りをキャッシュしても意味がありません。 アクセラレーションに加えて、記録用のキャッシュ容量全体の割り当てにより、容量レベルの寿命を延ばし、システムの総コストを削減できます。これは、安価なメディアを永続ストレージに使用できるためです。不要な書き込み操作から。

弾力性

VMのフォールトトレランスと、使用可能なvSANストレージスペースと共有vSANストレージスペースの量の比率は、2つのストレージポリシー設定によって決まります。

•許容する障害の数-許容される障害の数。これにより、VMが障害に耐えられるクラスターホストの数が決まります。

•耐障害性方法-耐障害性を確保する方法。

vSANには2つのフォールトトレランス方式があります。

•RAID-1(ミラーリング)-異なるホスト上のレプリカを持つオブジェクトの完全な複製(ミラーリング)、ネットワークRAID-1の類似物。 クラスターが最大3つの障害(ホスト、ディスク、ディスクグループ、またはネットワークの問題)に耐えることができます。 許容障害数= 1の場合、レプリカが1つ作成され(オブジェクトの2つのインスタンス)、クラスター上のVMまたはそのディスクが実際に占有するスペースは、有効容量の2倍です。 許容される障害の数= 2の場合、2つのレプリカ(3つのコピー)があり、実際に占有されているボリュームは3倍有用です。 許容障害数= 3の場合、レプリカが3つあり、4倍のスペースを占有します。 このフォールトトレランス方式はスペースを非効率的に使用しますが、最大のパフォーマンスを提供します。 ハイブリッドおよびオールフラッシュクラスタ構成に使用できます。 ホストの最小必要数は2〜3(1つの障害を実行するため)で、推奨される最小数は4つのホストです。これにより、障害が発生した場合に再構築できます。

•RAID-5 / 6(Erasure Coding)-オブジェクトを配置すると、ネットワークRAID-5または-6の類似物であるパリティブロックが計算されます。 オールフラッシュクラスタ構成のみがサポートされています。 クラスターが1(raid-5のアナログ)または2つの障害(raid-6のアナログ)を解決できるようにします。 1つの障害を実行するためのホストの最小数は4、2つの障害を実行するためのホスト数は6、再構築の可能性のために推奨される最小値はそれぞれ5と7です。 この方法により、RAID-1と比較してクラスタースペースを大幅に節約できますが、パフォーマンスの低下につながります。これは、オールフラッシュの速度を考えると、多くのタスクで十分に許容される場合があります。 したがって、4つのホストと1つの障害のトレランスの場合、Erasure Codingを使用するときにオブジェクトが占有する使用可能スペースは、その総ボリュームの75%になります(RAID-1の場合は50%の使用可能スペースがあります)。 6つのホストと2つの障害のトレランスの場合、Erasure Codingを使用するオブジェクトが占有する使用可能スペースは、その合計ボリュームの67%になります(RAID-1の場合、33%の使用可能スペースがあります)。 したがって、これらの例のRAID-5 / 6は、クラスター容量をそれぞれ1.5倍および2倍使用する点でRAID-1よりも効率的です。

以下は、RAID-5およびRAID-6を使用したvSANクラスターのコンポーネントレベルでのデータ分散です。 C1-C6(1行目)-オブジェクトのコンポーネント、A1-D4(カラーブロック)-データブロック、P1-P4およびQ1-Q4(グレーブロック)-パリティブロック。

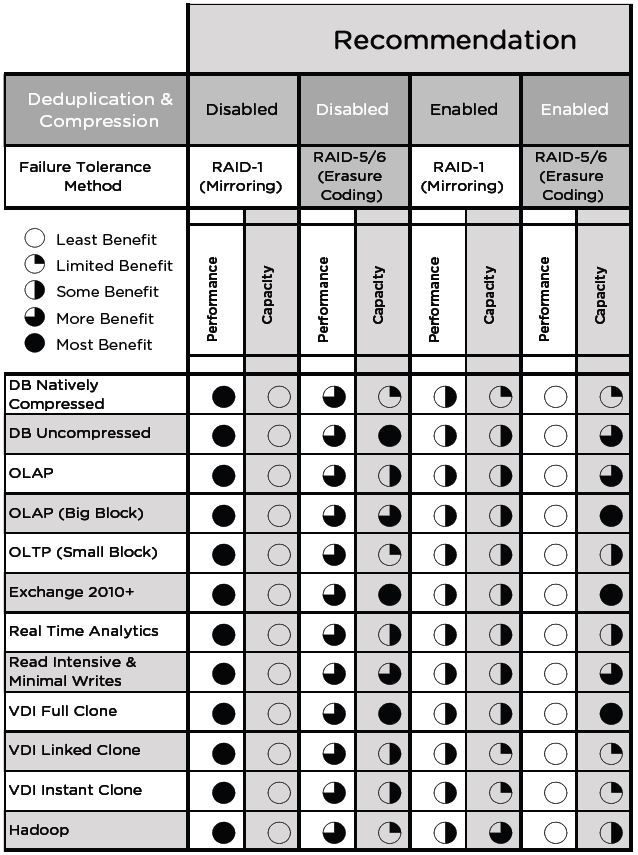

vSANは、さまざまな方法で、さまざまなVMまたはそれらのディスクに耐障害性を提供します。 単一のリポジトリ内で、パフォーマンスが重要なVMのミラーリングにポリシーを関連付けることができ、重要度の低いVMの場合は、スペースを節約するために消去コーディングを構成できます。 したがって、パフォーマンスと容量の効率的な使用とのバランスが維持されます。

次の表は、さまざまなFTM / FTTオプションのホストまたは障害ドメインの最小および推奨数を示しています。

障害ドメイン

vSANはフォールトドメインの概念を導入し、これらのドメインに論理的にグループ化されたサーバーラックまたはバスケットのレベルで障害からクラスターを保護します。 このメカニズムを含めると、オブジェクトのレプリカがノードに配置されるため、個々のノードのレベルではなく、ドメイン全体の障害に耐えるフォールトトレランスを確保するためのデータの配布が行われます。さまざまな障害ドメイン。

障害ドメインの数は次の式で計算されます:障害ドメインの数= 2 *許容される障害の数+1。vSANには少なくとも2つのドメインの障害が必要です。それぞれに1つ以上のホストがありますが、障害の場合に再構築できるため、推奨される数は4です(2〜3個のドメインは再構築を許可しません、どこにもありません)。 したがって、障害のあるドメインの数をカウントする方法は、ホストの数をカウントして、目的の数の障害を解決する方法と似ています。

理想的には、障害の各ドメインには同じ数のホストがあり、ホストは同じ構成になっている必要があります。1つのドメインのスペースを再構築のために空のままにすることをお勧めします(たとえば、1つのフェイルオーバーを持つ4つのドメイン)。

障害ドメインメカニズムは、ミラーリング(RAID-1)だけでなく、Erasure Codingでも機能します。この場合、オブジェクトの各コンポーネントは異なる障害ドメインに配置する必要があり、障害ドメインの数の計算式は変更されます:RAID-5および6ドメインの少なくとも4つのドメインRAID-6の場合(Erasure Codingのホスト数の計算と同様)。

重複排除と圧縮

重複排除と圧縮(DiS)メカニズムはオールフラッシュ構成でのみサポートされ、vSANクラスター全体でのみ有効にできます。ポリシーを使用した個々のVMまたはディスクの選択的包含はサポートされていません。 これらのテクノロジーのいずれか1つのみを使用しても失敗しますが、両方とも一度にしか失敗しません。

DiSをオンにすると、オブジェクトはディスクグループ内のすべてのディスクに自動的にストリップされます。これにより、コンポーネントのリバランスが回避され、ディスクグループ内の各ディスクの異なるコンポーネントからのデータブロックの一致が明らかになります。 同時に、ストレージポリシーのレベルでオブジェクトを手動で設定することも可能です。 ディスクグループを超えて。 DiSをオンにした場合、ポリシーレベル(オブジェクトスペース予約パラメーター、シックディスク)でオブジェクト用のスペースを予約することは実用的ではありません。パフォーマンスが向上せず、スペース節約に悪影響を与えるためです。

DiSは、記録動作を確認した後に実行されます。 重複排除は、各ディスクグループ内の同一の4Kブロックでキャッシュからデータがアンロードされる前に実行され、ディスクグループ間では重複排除は実行されません。 重複排除後、キャッシュからデータをダウンロードする前に、それらは圧縮されます:4Kが実際に2K以下に圧縮されている場合、圧縮が実行され、そうでない場合、ブロックは不当なオーバーヘッドを避けるために圧縮されないままです。

重複排除および圧縮形式では、データはストレージレベル(容量)のみであり、クラスターデータボリュームの約90%です。 同時に、DiSのオーバーヘッドは、クラスターの総容量(メタデータの保存、ハッシュ)の約5%です。 キャッシュでは、データは通常の状態にあります。これは、キャッシュが永続的なストレージよりもはるかに頻繁に書き込まれるため、キャッシュ内のDiSによるオーバーヘッドとパフォーマンスの低下が、比較的小さな容量を最適化することによるボーナスよりもはるかに大きいためです。

少数の大きなディスクグループまたは多数の小さなディスクグループから選択できることに注意してください。 大規模なディスクグループでは、DiSの効果は大きくなります(グループ間ではなくグループ内で行われます)。 多くの小さなディスクグループでは、キャッシュがより効率的に機能し(キャッシュメディアの総数の増加によりスペースが増加します)、より多くの障害ドメインが存在し、1つのディスクグループに障害が発生した場合の再構築を高速化します。

スナップショットチェーンが占めるスペースもDiSによって最適化されます。

オブジェクトとコンポーネントの数の除去

[オブジェクトストレージポリシーごとのディスクストライプの数]パラメーターは、オブジェクトの1つのレプリカ(VMディスク)のコンポーネントを配布するための個別の容量メディアの数を設定します。 このパラメーターの最大値は、vSANがサポートする最大ストライプ長を意味し、12です。この場合、オブジェクトレプリカは12のメディアで配布されます。 指定されたストライプの長さがディスクグループのメディア数を超える場合、オブジェクトのレプリカは複数のディスクグループに拡張されます(ほとんどの場合、1ホスト内)。 指定されたストライプの長さがホストメディアの数を超える場合、オブジェクトのレプリカは複数のホストに拡張されます(たとえば、あるホストのすべてのメディアと別のホストのメディアの一部)。

デフォルトでは、ストライプの長さは1に設定されます。これは、ストリッピングが実行されず、レプリカ(最大255GB)が1つのコンポーネントの形で1つのメディアに配置されることを意味します。

理論的には、オブジェクトがストリップされるメディアが過負荷にならない場合、ストリップはI / Oの並列化によりパフォーマンスを向上させます。 オブジェクトを複数のディスクグループにストリッピングすると、容量のメディアだけでなく、関連するディスクグループのメディアキャッシュリソースを利用して負荷を並列化できます。 VMwareでは、デフォルトで設定されている「オブジェクトあたりのストリップ数」パラメーターを1に設定し、オブジェクトをストリップしないことをお勧めします。ただし、ストリップが受け入れられる場合は必要であり、生産性を高めることができます。 一般に、ストリッピングは具体的なパフォーマンスの向上をもたらすことはできないと考えられています。 ハイブリッド構成では、キャッシュへのアクセスに問題がある場合、特に集中的な読み取りの場合、ストリッピングの効果はプラスになります。 ストリーム記録は、ストリッピングによっても加速できます。 オールフラッシュ構成では、複数のキャッシュメディアを廃棄でき、永続メディアへのデータの押し出しが並列化されるためです。

ストリッピングにより、クラスタコンポーネントの数が大幅に増加することに注意してください。 これは、クラスターごとのコンポーネント制限(9000)を使い果たすことができる場合、多数のVMとオブジェクトを持つクラスターにとって重要です。

オブジェクトの1つのコンポーネントの最大サイズは255GBであることに注意してください。つまり、オブジェクトが大きい場合、そのレプリカは255の倍数であるコンポーネントの数で自動的に分割されます。この場合、ストライピングポリシーに関係なく、レプリカコンポーネントは複数のメディアに分散されます。それらが多数ある場合(たとえば、ホストまたはクラスター内のメディアよりも多く、たとえば62TBのディスクを作成する場合)、1つのオブジェクトの複数のコンポーネントがメディアに到達する可能性があります。

vSANクラスターの容量計画

vSANクラスターストレージのサイズを計画する場合、使用されるフォールトトレランス方式(ミラーまたはEC)と許容される障害の数(1から3倍)を考慮して、実際の占有スペースがクラスターの有効容量を大幅に超える可能性があることを考慮する必要があります。 スペース最適化手法(ECおよびDiS)の影響も考慮する必要があります。

スワップファイル用のスペースの割り当て(各VMのRAMサイズ)とスナップショットのストレージを考慮する必要があります。

vSANの容量を80%満たすと、クラスターの再分散が開始されます。これは、クラスター全体にデータを再分散し、大きな負荷を引き起こすバックグラウンドプロセスです。 vSAN(VSAN-FS)ファイルシステムのクラスターメディアをフォーマットすると、スペースの約1%が消費されます。 スペースのごく一部がDiSメタデータに費やされます(5%)。 そのため、VMwareでは、リバランスが発生しないように、容量マージンが30%のvSANクラスターを設計することをお勧めします。

ストレージコントローラーの選択

vSANは、同じホスト上での複数のストレージコントローラーの使用を推奨し、サポートしています。 これにより、個々のノードのレベルで生産性、容量、およびフォールトトレランスを向上させることができます。 同時に、vSAN対応ノードには複数のストレージコントローラーが含まれていません。

最も長いキュー長(少なくとも256。コントローラーを選択することをお勧めします。ディスクがハイパーバイザーに直接提示される場合、パススルーモードでコントローラーを使用することをお勧めします。VSANはraid-0モードでコントローラーの使用をサポートしますが、メンテナンス中に追加の操作が必要になりますコントローラーの内部キャッシュを無効にすることをお勧めします。それが不可能な場合は、読み取り用に100%に設定してください;コントローラーの独自のアクセラレーションモードも無効にする必要があります。

フェイルオーバー

キャパシティメディアに障害が発生した場合、再構築は同じディスクグループ内または別のグループ(同じホストまたは別のグループ)で実行できます。空き領域の可用性に依存します。

キャッシュに障害が発生すると、ディスクグループ全体が再構築されます。再構築は、同じホスト(ディスクグループと空き領域がまだある場合)または他のホストで実行できます。

ホストに障害が発生した場合、再構築用に少なくとも1つの空きホストを用意することをお勧めします。複数の障害を解決する必要がある場合は、空きホストが複数あるはずです。

コンポーネント(ディスクまたはディスクコントローラー)の性能が低下した場合(リカバリなしのコンポーネント障害)、vSANはすぐに再構築を開始します。

コンポーネント(ネットワークの損失、ネットワークカードの障害、ホストの切断、ディスクの切断)が存在しない場合(回復の可能性がある一時的なシャットダウン)、vSANは延期して(デフォルトでは60分後に)再構築を開始します。

当然、再構築の条件は、クラスター内の空き領域の可用性です。

障害(メディア、ディスクグループ、ホスト、ネットワーク損失)の後、vSANは失われたオブジェクトの可用性を評価する間、5〜7秒間I / Oを停止します。オブジェクトが見つかった場合、I / Oが再開します。

ホストの障害またはネットワーク損失(再構築の開始)の60分後に、失われたホストがサービスに復帰した場合(ネットワークが再構築またはアップグレードされた場合)、vSANは最適な(より高速な)処理を決定します:再構築を完了するか、返されたホストを同期します。

チェックサム

デフォルトでは、vSANはチェックサム計算を実行して、保持ポリシーレベルでオブジェクトの整合性を監視します。チェックサムは、各データブロック(4KB)に対して計算され、読み取り操作のバックグラウンドプロセスとして、また1年中冷たいままのデータ(スクラバー)としてチェックされます。このメカニズムにより、ソフトウェアやハードウェアの理由、たとえばメモリやディスクのレベルでデータの破損を検出できます。

チェックサムの不一致が検出された場合、vSANは破損したデータを上書きして自動的に復元します。

チェックサムは、保持ポリシーレベルで無効にできます。スクラバーの起動(呼び出しがなかったブロックのチェック)の頻度は、追加の設定(VSAN.ObjectScrubsPerYearパラメーター)で変更でき、そのようなチェックを年に1回よりも頻繁に実行できます(少なくとも週に1回ですが、追加のロードが発生します)。

VSANプランニング

vSANは、ポート集約と負荷分散を使用したNICチーミングをサポートしています。

バージョン6.5より前のvSANでは、ネットワーク上のマルチキャストトラフィックのサポートが必要です。複数のvSANクラスターが同じサブネット上にある場合、トラフィックを分離するには、ホストに異なるマルチキャストアドレスを割り当てる必要があります。バージョン6.6以降、vSANはマルチキャストを使用しません。

vSANを設計するときは、リーフスパインアーキテクチャを配置することをお勧めします。

vSANはNIOCをサポートして、トラフィックの帯域幅を保証します。 NIOCは分散vSwitchでのみ実行できます。vSANを使用すると、vSphereのどのエディションでも使用できます(vSANライセンスに含まれています)。

vSANはジャンボフレームの使用をサポートしていますが、VMwareはその使用によるパフォーマンスの向上は重要ではないと考えているため、次の推奨事項を示します:ネットワークが既にそれらをサポートしている場合、それらを使用できますが、そうでない場合は、vSANの完全なオプションであり、フレームなしでも実行できます。

vSANクラスターにオブジェクトを配置する例

vSANクラスターにオブジェクトとコンポーネントを配置する構成、構造、原則、フォールトトレランスを確保する方法、およびストレージポリシーの使用については上記で説明しました。

次に、簡単な例でこれがどのように機能するかを見てみましょう。オールフラッシュ構成の4つのホストのvSANクラスターがあります。次の図は、条件付きで3つのVMディスク(ディスク内)がこのクラスターに配置される方法を示しています。

Disk-1は、耐障害性(FTT)= 1)および消去コーディング(耐障害性方法(FTM)= EC)の保持ポリシーに関連付けられていました。したがって、Disk-1のオブジェクトは、ホストごとに1つの4つのコンポーネントの形でシステムに配布されました。これらのコンポーネント内のドライブのデータは、計算されたパリティ値と一緒に書き込まれます。実際には、ネットワークRAID-5です。

Disk-2とDisk-3は、フェールオーバー1(FTT = 1)とミラーリング(FTM = Mirror)を使用してストレージポリシーに関連付けられていました。 Disk-2では、使用可能なサイズが255GB未満であり、デフォルトのストライプサイズが設定されていることに注意してください(オブジェクトあたりのディスクストライプ数= 1)。そのため、Disk-2のオブジェクトは、異なるノード上の2つのコンポーネント(ミラー化された2つのレプリカとミラーリング監視)の3つのコンポーネントの形でクラスターに配置されました。

この場合、Disk-3の使用可能なサイズは500GBで、デフォルトのストライプサイズが設定されています。 500GBは255GBより大きいため、vSANはDisk-3のオブジェクトのレプリカを2つのコンポーネント(Component1-1およびComponent1-2)に自動的に分割し、Host-1に配置します。それらのレプリカ(コンポーネント2-1およびコンポーネント4-2)は、それぞれホスト2および4でホストされます。この場合、投票を使用してクォーラムを計算するアルゴリズムにより、投票なしで行うことができるため、目撃者はいません。この方法で、vSANがクラスター空間のDisk-3に自動的に配置され、その裁量により、これはユーザーの手では解決しないことに注意してください。同じ成功を収めて、これらのコンポーネントを異なる方法でノードに配置できます。たとえば、ホスト4のレプリカ(Component1-1とComponent1-2)、ホスト1(コンポーネント2-1)とホスト3(Component4- 2)。または、レプリカに2つのホスト(ホスト1に2つのコンポーネント、ホスト3に2つのコンポーネント)を割り当て、3つ目(ホスト4)に監視を配置することができます。これは4ではなく5つのコンポーネントです。

もちろん、オブジェクトの自動配置は任意ではありません。vSANは内部アルゴリズムによってガイドされ、スペースを均等に利用し、可能であればコンポーネントの数を削減しようとします。

Disk-2の配置も異なる可能性があります。一般的な条件は、異なるレプリカおよびミラーリング監視(存在する場合)のコンポーネントが異なるホストに存在する必要があることです。これはフェールオーバー条件です。そのため、Disk-2のサイズが1.9 TBをわずかに下回る場合、各レプリカは8つのコンポーネント(255 GB以下の1つのコンポーネント)で構成されます。このようなオブジェクトは、同じ3つのホストに配置できます(ホスト1に1つのレプリカの8つのコンポーネント、ホスト2に2つのレプリカの8つのコンポーネント、ホスト3にミラーリング)。 4つのホストすべて(同じホスト上の異なるレプリカを交差させることなく)

スペース効率のガイドライン

VMwareの推奨事項からの表:

ストレッチクラスタサポート

vSANは、地理的に分散した2つのサイト(サイト)をカバーするストレッチクラスターモード(ストレッチクラスター)をサポートしますが、共有vSANストレージプールもサイト間で分散されます。両方のサイトがアクティブで、いずれかのサイトに障害が発生した場合、クラスターは残りのサイトのストレージとコンピューティングパワーを使用して、折りたたまれたサービスを再開します。

ストレッチクラスタの機能の詳細な説明は、この出版物の範囲外です。

参照リスト(役に立つリンク)

「vSphereの6.5ドキュメンテーションのVMwareセンターのドキュメントVSAN 6.5

」の設計のためのガイドラインと6.2 VSANサイジング

「デザインガイドVSANネットワーク6.2

」の技術最適化能力VSAN 6.2に

「VSANでストライピング

」VSAN上のVMwareのブログ