序文の代わりに

この記事を可能にしてくれた私のパトロンに感謝します。アレクサンドル・シェペリエフ、セルゲイ・テン、アレクセイ・ポリエタイエフ、ニキータ・ペンジン、アンドレイ・カルナウホフ、マトヴェエフ・エフゲニー、アントン・ポチョムキン。

この記事を自給自足のガイドにしようとしましたが、コマンドをステップごとにコピーアンドペーストするのではなく、各リンクを見て、内部で何が起こっているのかを理解することを強くお勧めします。

前提条件

記事で説明されているすべての手順を実行するために読者が満たす必要がある要件は1つだけです。有料機能を使用するため、課金が有効になっているGoogle Cloudアカウントを持つためです。

2つの主要な質問に対する答えから旅を始めましょう。

- Google Cloud MLとは何ですか?

- Google Cloud Shellとは何ですか?

Google Cloud MLとは何ですか?

公式の定義では次のように書かれています:

Google Cloud Machine Learningは、TensorFlowのパワーと柔軟性をクラウドにもたらします。 そのコンポーネントを使用して、データから機能を選択および抽出し、機械学習モデルをトレーニングし、Google Cloud Platformの管理リソースを使用して予測を取得できます。

あなたについては知りませんが、この定義は私にはほとんど何も言いません。 Google Cloud MLで何が得られるかを説明します。

- TensorFlowモデルをトレーニングするために必要なすべてを備えたマシン上のクラウドにコードをデプロイします。

- クラウド内のマシン上のコードのGoogle Cloud Storageバケットへのアクセスを提供します。

- トレーニングを担当するコードを実行して実行します。

- ストレージ用にクラウドにモデルを配置します。

- 訓練されたモデルを使用して、将来のデータを予測します。

この記事の焦点は、最初の3つのポイントになります。 後で、今後の記事で、Google Cloud MLでトレーニングされたモデルを展開する方法と、クラウドモデルを使用してデータを予測する方法について説明します。

Google Cloud Shellとは何ですか?

そして再び、 公式の定義 :

Google Cloud Shellは、Google Cloud Platformでホストされるリソースを管理するためのシェル環境です。

繰り返しますが、Google Cloud Shellは次のとおりです。

- 提供されたクラウドインスタンス(タイプ?)

- Debian OSを搭載している場合、

- Webからアクセスできるシェル、

- Google Cloudでの作業に必要なものがすべて揃っています。

はい、正しく理解しました。Shellにアクセスできる完全に無料のインスタンスがあり、Webコンソールからアクセスできます。

ただし、無料ではありません。CloudShellの場合、攻撃的な制限がいくつかあります。sshではなく、Webコンソールからのみアクセスできます(個人的には、iTerm以外の端末は使用しません)。 StackOverflowで、 sshを介してCloud Shellを使用することは可能かどうか、また、それは不可能かどうかについて質問しました。 しかし、少なくとも、特別なChromeプラグインをインストールすることで、あなたの生活を楽にする方法があります。これにより、少なくとも、通常のキーバインディングを使用して、ターミナルがブラウザーウィンドウ(この漂遊=)のようではなく、ターミナルのように動作できるようになります)

Cloud Shell機能の詳細については、 こちらをご覧ください 。

実行する必要がある手順:

- 学習のためのCloud Shellの準備

- クラウドストレージの準備

- トレーニングデータの準備

- トレーニングスクリプトの準備

- 学習プロセスをローカルでテストする

- トレーニング

- ボットとの会話

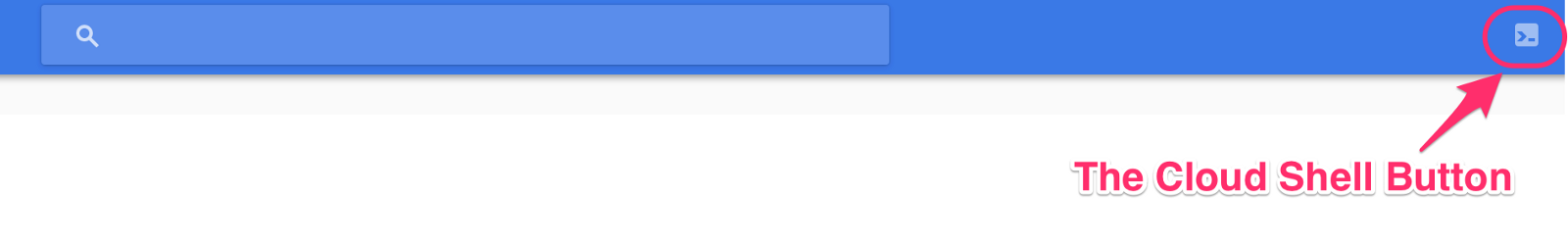

Cloud Shell学習環境の準備

Cloud Shellを開きます。 これをまだ行っていない場合、非常に簡単です。コンソールconsole.cloud.google.comコンソールを開き、右上隅のシェルアイコンをクリックする必要があります。

問題が発生した場合は、コンソールを詳細に起動する方法を説明する短い指示があります。

以降のすべての例は、Cloud Shellで実行されます。

また、Cloud ShellでCloud MLを使用するのがこれが初めての場合は、必要なすべての依存関係を準備する必要があります。 これを行うには、シェルで直接1行のコードのみを実行する必要があります。

curl https://raw.githubusercontent.com/GoogleCloudPlatform/cloudml-samples/master/tools/setup_cloud_shell.sh | bash

彼はすべての必要なパッケージをインストールします。

この段階で枕の取り付けにすべてがつまずいた場合:

Command "/usr/bin/python -u -c "import setuptools, tokenize;__file__='/tmp/pip-build-urImDr/olefile/setup.py';f=getattr(tokenize, 'open', open)(__file__);code=fr ead().replace('\r\n', '\n');f.close();exec(compile(code, __file__, 'exec'))" build_ext --disable-jpeg install --record /tmp/pip-GHGxvS-record/install-record.txt - -single-version-externally-managed --compile --user --prefix=" failed with error code 1 in /tmp/pip-build-urImDr/olefile/

次に、手動インストールを支援します。

pip install --user --upgrade pillow

ヒント@ Sp0tted_0wlをありがとう。 次に、PATH変数を更新する必要があります。

export PATH=${HOME}/.local/bin:${PATH}

現在のプロジェクトでCloud MLを初めて使用する場合は、MLモジュールを初期化する必要があります。 これは1行で実行できます。

➜ gcloud beta ml init-project Cloud ML needs to add its service accounts to your project (ml-lab-123456) as Editors. This will enable Cloud Machine Learning to access resources in your project when running your training and prediction jobs. Do you want to continue (Y/n)? Added serviceAccount:cloud-ml-service@ml-lab-123456-1234a.iam.gserviceaccount.com as an Editor to project 'ml-lab-123456'.

すべてが正常にインストールされたかどうかを確認するには、1つの簡単なコマンドを実行する必要があります。

➜ curl https://raw.githubusercontent.com/GoogleCloudPlatform/cloudml-samples/master/tools/check_environment.py | python ... You are using pip version 8.1.1, however version 9.0.1 is available. You should consider upgrading via the 'pip install --upgrade pip' command. You are using pip version 8.1.1, however version 9.0.1 is available. You should consider upgrading via the 'pip install --upgrade pip' command. Your active configuration is: [cloudshell-12345] Success! Your environment is configured

次に、ネットワークのトレーニングに使用するGoogle Cloudプロジェクトを決定します。 私はMLでのすべての実験のための特別なプロジェクトを持っています。 いずれにせよ、これはあなた次第ですが、プロジェクトを切り替えるために使用するコマンドを紹介します。

➜ gprojects PROJECT_ID NAME PROJECT_NUMBER ml-lab-123456 ml-lab 123456789012 ... ➜ gproject ml-lab-123456 Updated property [core/project].

同じ魔法を使いたい場合は、次を.bashrc / .zshrc / other_rcファイルに追加する必要があります。

function gproject() { gcloud config set project $1 } function gprojects() { gcloud projects list }

既にここにいる場合は、Cloud Shellを準備し、目的のプロジェクトに移動したことを意味します。CloudShellが準備され、自信を持って次のステップに進むことができると自信を持って言えます。

クラウドストレージの準備

まず、クラウドストレージが必要な理由を説明する必要がありますか? クラウドでモデルをトレーニングするため、トレーニングプロセスでは現在のマシンのローカルファイルシステムにアクセスできません。 つまり、必要なすべてのソースデータをクラウドのどこかに保存する必要があります。 訓練されたモデルと同様に、どこかに保存する必要があります。 これはどこかでトレーニングが行われるマシンになることはできません。なぜなら、あなたはそれにアクセスできないからです。 また、学習プロセスはアクセスできないため、マシンはアクセスできません。 このような悪循環は、データへのクラウドストレージという新しいリンクを導入することで破ることができます。

トレーニングに使用する新しいクラウドバケットを作成しましょう。

➜ PROJECT_NAME=chatbot_generic ➜ TRAIN_BUCKET=gs://${PROJECT_NAME} ➜ gsutil mb ${TRAIN_BUCKET} Creating gs://chatbot_generic/...

ここで私はあなたに何かを言わなければなりません、あなたが公式のガイドを見れば、あなたはそこに次のテキストを見つけるでしょう:

警告:マルチリージョンの場所(usなど)ではなく、バケットのリージョン(us-central1など)を指定する必要があります。

無料翻訳:

注:バケットの地域(us-central1)を指定する必要があります。国としての複数地域の場所(例:us)ではありません。

それでも、このアドバイスを使用して地域バケットを作成すると、スクリプトは0_oを書き込むことができません(フッサールについては黙っておいてください、 バグはすでに修正されています )。

すべてが機能する理想的な世界では、地域を確立することが非常に重要であり、トレーニング中に使用される地域に対応している必要があります。 そうしないと、学習速度に悪影響を及ぼす可能性があります。

これで、今後のトレーニングの準備を整えることができます。

トレーニングデータの準備

独自のネットワークを使用している場合、おそらくこの部分を省略するか、このデータをダウンロードする必要がある場所が記述されている部分のみを選択的に読み取ることができます。

今回は( 前の記事と比較して)入力データを準備するスクリプトのわずかに変更されたバージョンを使用します。 READMEファイルでスクリプトの仕組みを読むことをお勧めします。 ただし、次の方法で入力を準備できます(「td src」を「mkdir src; cd src」に置き換えることができます)。

➜ td src ➜ ~/src$ git clone https://github.com/b0noI/dialog_converter.git Cloning into 'dialog_converter'... remote: Counting objects: 63, done. remote: Compressing objects: 100% (4/4), done. remote: Total 63 (delta 0), reused 0 (delta 0), pack-reused 59 Unpacking objects: 100% (63/63), done. Checking connectivity... done. ➜ ~/src$ cd dialog_converter/ ➜ ~/src/dialog_converter$ git checkout converter_that_produces_test_data_as_well_as_train_data Branch converter_that_produces_test_data_as_well_as_train_data set up to track remote branch converter_that_produces_test_data_as_well_as_train_data from origin. Switched to a new branch 'converter_that_produces_test_data_as_well_as_train_data' ➜ ~/src/dialog_converter$ python converter.py ➜ ~/src/dialog_converter$ ls converter.py LICENSE movie_lines.txt README.md test.a test.b train.a train.b

上記のコードを見ると、「td」とは何かを尋ねるかもしれません。..これは「to dir」の短い形式であり、これは私が最も頻繁に使用するコマンドの1つです。 この魔法を使用するには、次を追加してrcファイルを更新する必要があります。

function td() { mkdir $1 cd $1 }

今回は、データを2つのサンプル(トレーニングサンプルとテストサンプル)に分割することにより、モデルの品質を改善します。 前回のように、2つではなく4つのファイルが表示されるのはこのためです。

素晴らしい、ついにいくつかのデータができたので、それをバケットにアップロードしましょう:

➜ ~/src/dialog_converter$ gsutil cp test.* ${TRAIN_BUCKET}/input Copying file://test.a [Content-Type=application/octet-stream]... Copying file://test.b [Content-Type=chemical/x-molconn-Z]... \ [2 files][ 2.8 MiB/ 2.8 MiB] 0.0 B/s Operation completed over 2 objects/2.8 MiB. ➜ ~/src/dialog_converter$ gsutil cp train.* ${TRAIN_BUCKET}/input Copying file://train.a [Content-Type=application/octet-stream]... Copying file://train.b [Content-Type=chemical/x-molconn-Z]... - [2 files][ 11.0 MiB/ 11.0 MiB] Operation completed over 2 objects/11.0 MiB. ➜ ~/src/dialog_converter$ gsutil ls ${TRAIN_BUCKET} gs://chatbot_generic/input/ ➜ ~/src/dialog_converter$ gsutil ls ${TRAIN_BUCKET}/input gs://chatbot_generic/input/test.a gs://chatbot_generic/input/test.b gs://chatbot_generic/input/train.a gs://chatbot_generic/input/train.b

トレーニングスクリプトの準備

これで、トレーニングスクリプトを準備できます。 translate.pyを使用します。 ただし、現在の実装ではCloud MLでの使用が許可されていないため、少しリファクタリングが必要です。 いつものように、 機能リクエストを作成し、必要なすべての変更を含むブランチを準備しました。 だから、お辞儀から始めましょう:

➜ ~/src/dialog_converter$ cd .. ➜ ~/src$ git clone https://github.com/b0noI/models.git Cloning into 'models'... remote: Counting objects: 1813, done. remote: Compressing objects: 100% (39/39), done. remote: Total 1813 (delta 24), reused 0 (delta 0), pack-reused 1774 Receiving objects: 100% (1813/1813), 49.34 MiB | 39.19 MiB/s, done. Resolving deltas: 100% (742/742), done. Checking connectivity... done. ➜ ~/src$ cd models/ ➜ ~/src/models$ git checkout translate_tutorial_supports_google_cloud_ml Branch translate_tutorial_supports_google_cloud_ml set up to track remote branch translate_tutorial_supports_google_cloud_ml from origin. Switched to a new branch 'translate_tutorial_supports_google_cloud_ml' ➜ ~/src/models$ cd tutorials/rnn/translate/

マスターブランチを使用していないことに注意してください!

学習テスト-ローカル

通信教育には費用がかかるため、テストのために、ローカルで学習プロセスをシミュレートできます。 ここでの問題は、Cloud Shellを実行するマシン上でのネットワークのローカルトレーニングが、泥の中に確実に押しつぶし、押しつぶすという事実です。 そして、結果を見ることなくインスタンスをオーバーロードする必要があります。 しかし、この場合でも何も失われないので、心配しないでください。 幸いなことに、スクリプトには使用できるセルフテストモードがあります。 使用方法は次のとおりです。

➜ ~/src/models/tutorials/rnn/translate$ cd .. ➜ ~/src/models/tutorials/rnn$ gcloud beta ml local train \ > --package-path=translate \ > --module-name=translate.translate \ > -- \ > --self_test Self-test for neural translation model.

コマンドを実行するフォルダーに注意してください!

セルフテストは正常に完了したようです。 ここで使用したキーについて話しましょう。

- package-path-トレーニングを完了するためにリモートマシンにデプロイする必要があるpythonパッケージへのパス。

- 「-」-後続のすべてが入力引数としてモジュールに送信されます。

- self_test-実際のトレーニングなしでセルフテストを実行するようモジュールに指示します。

トレーニング

最後に、プロセスの最も興味深い部分に到達しました。実際、このすべてを開始しました。 しかし、まだ細かい部分があります。学習プロセスで使用される必要なバケットをすべて準備し、すべてのローカル変数を設定する必要があります。

➜ ~/src/models/tutorials/rnn$ INPUT_TRAIN_DATA_A=${TRAIN_BUCKET}/input/train.a ➜ ~/src/models/tutorials/rnn$ INPUT_TRAIN_DATA_B=${TRAIN_BUCKET}/input/train.b ➜ ~/src/models/tutorials/rnn$ INPUT_TEST_DATA_A=${TRAIN_BUCKET}/input/test.a ➜ ~/src/models/tutorials/rnn$ INPUT_TEST_DATA_B=${TRAIN_BUCKET}/input/test.b ➜ ~/src/models/tutorials/rnn$ JOB_NAME=${PROJECT_NAME}_$(date +%Y%m%d_%H%M%S) ➜ ~/src/models/tutorials/rnn$ echo ${JOB_NAME} chatbot_generic_20161224_203332 ➜ ~/src/models/tutorials/rnn$ TRAIN_PATH=${TRAIN_BUCKET}/${JOB_NAME} ➜ ~/src/models/tutorials/rnn$ echo ${TRAIN_PATH} gs://chatbot_generic/chatbot_generic_20161224_203332

ここで、リモートワークの名前(JOB_NAME)は、トレーニングを開始するたびに一意でなければならないことに注意してください。 次に、翻訳のために現在のフォルダーを変更しましょう(尋ねないでください=)):

➜ ~/src/models/tutorials/rnn$ cd translate/

これで、トレーニングを開始する準備が整いました。 最初にコマンドを記述して(ただし、実行しません)、その主なキーについて説明します。

gcloud beta ml jobs submit training ${JOB_NAME} \ --package-path=. \ --module-name=translate.translate \ --staging-bucket="${TRAIN_BUCKET}" \ --region=us-central1 \ -- \ --from_train_data=${INPUT_TRAIN_DATA_A} \ --to_train_data=${INPUT_TRAIN_DATA_B} \ --from_dev_data=${INPUT_TEST_DATA_A} \ --to_dev_data=${INPUT_TEST_DATA_B} \ --train_dir="${TRAIN_PATH}" \ --data_dir="${TRAIN_PATH}" \ --steps_per_checkpoint=5 \ --from_vocab_size=45000 \ --to_vocab_size=45000

まず、トレーニングチームのいくつかの新しいフラグについて説明します。

- staging-bucket-展開中に使用されるバケット。 トレーニングと同じバケットを使用することは理にかなっています。

- 地域-学習プロセスを開始する地域。

また、スクリプトに渡される新しいフラグに触れてみましょう。

- from_train_data / to_train_dataは以前のen_train_data / fr_train_dataで、詳細は前の記事に記載されています 。

- from_dev_data / to_dev_data-from_train_data / to_train_dataと同じですが、トレーニング後の損失を推定するために使用されるテスト(またはスクリプトで呼び出される「dev」)データ用。

- train_dir-学習結果が保存されるフォルダー。

- steps_per_checkpoint-一時的な結果を保存する前に実行する必要のあるステップ数。 5-値が小さすぎます。学習プロセスが問題なく進行していることを確認するためにのみ設定します。 後で、大きな値(たとえば200)でプロセスを再起動します。

- from_vocab_size / to_vocab_size-内容を理解するには、 前の記事を読む必要があります。 ここで、デフォルト値(40k)がダイアログ内の一意の単語の数よりも少ないことがわかります。したがって、今回は辞書のサイズを増やしました。

すべてがトレーニングを開始する準備ができているようですので、始めましょう(プロセスには時間がかかるため、少しの忍耐が必要です)...

➜ ~/src/models/tutorials/rnn/translate$ gcloud beta ml jobs submit training ${JOB_NAME} \ > --package-path=. \ > --module-name=translate.translate \ > --staging-bucket="${TRAIN_BUCKET}" \ > --region=us-central1 \ > -- \ > --from_train_data=${INPUT_TRAIN_DATA_A} \ > --to_train_data=${INPUT_TRAIN_DATA_B} \ > --from_dev_data=${INPUT_TEST_DATA_A} \ > --to_dev_data=${INPUT_TEST_DATA_B} \ > --train_dir="${TRAIN_PATH}" \ > --data_dir="${TRAIN_PATH}" \ > --steps_per_checkpoint=5 \ > --from_vocab_size=45000 \ > --to_vocab_size=45000 INFO 2016-12-24 20:49:24 -0800 unknown_task Validating job requirements... INFO 2016-12-24 20:49:25 -0800 unknown_task Job creation request has been successfully validated. INFO 2016-12-24 20:49:26 -0800 unknown_task Job chatbot_generic_20161224_203332 is queued. INFO 2016-12-24 20:49:31 -0800 service Waiting for job to be provisioned. INFO 2016-12-24 20:49:36 -0800 service Waiting for job to be provisioned. ... INFO 2016-12-24 20:53:15 -0800 service Waiting for job to be provisioned. INFO 2016-12-24 20:53:20 -0800 service Waiting for job to be provisioned. INFO 2016-12-24 20:53:20 -0800 service Waiting for TensorFlow to start. ... INFO 2016-12-24 20:54:56 -0800 master-replica-0 Successfully installed translate-0.0.0 INFO 2016-12-24 20:54:56 -0800 master-replica-0 Running command: python -m translate.translate --from_train_data=gs://chatbot_generic/input/train.a --to_train_data=gs://chatbot_generic/input/train.b --from_dev_data=gs://chatbot_generic/input/test.a --to_dev_data=gs://chatbot_generic/input/test.b --train_dir=gs://chatbot_generic/chatbot_generic_20161224_203332 --steps_per_checkpoint=5 --from_vocab_size=45000 --to_vocab_size=45000 INFO 2016-12-24 20:56:21 -0800 master-replica-0 Creating vocabulary /tmp/vocab45000 from data gs://chatbot_generic/input/train.b INFO 2016-12-24 20:56:21 -0800 master-replica-0 processing line 100000 INFO 2016-12-24 20:56:21 -0800 master-replica-0 Tokenizing data in gs://chatbot_generic/input/train.b INFO 2016-12-24 20:56:21 -0800 master-replica-0 tokenizing line 100000 INFO 2016-12-24 20:56:21 -0800 master-replica-0 Tokenizing data in gs://chatbot_generic/input/train.a INFO 2016-12-24 20:56:21 -0800 master-replica-0 tokenizing line 100000 INFO 2016-12-24 20:56:21 -0800 master-replica-0 Tokenizing data in gs://chatbot_generic/input/test.b INFO 2016-12-24 20:56:21 -0800 master-replica-0 Tokenizing data in gs://chatbot_generic/input/test.a INFO 2016-12-24 20:56:21 -0800 master-replica-0 Creating 3 layers of 1024 units. INFO 2016-12-24 20:56:21 -0800 master-replica-0 Created model with fresh parameters. INFO 2016-12-24 20:56:21 -0800 master-replica-0 Reading development and training data (limit: 0). INFO 2016-12-24 20:56:21 -0800 master-replica-0 reading data line 100000

トレーニングの状態を監視できます。 これを行うには、Cloud Shell(またはtmuxウィンドウ)で別のタブを開き、必要な変数を作成してコマンドを実行します。

➜ JOB_NAME=chatbot_generic_20161224_213143 ➜ gcloud beta ml jobs describe ${JOB_NAME} ...

これで、すべてがうまくいけば、ジョブを停止して、さらに多くのステップ(たとえば200)で再開できます。これはデフォルトの数値です。 新しいコマンドは次のようになります。

➜ ~/src/models/tutorials/rnn/translate$ gcloud beta ml jobs submit training ${JOB_NAME} \ > --package-path=. \ > --module-name=translate.translate \ > --staging-bucket="${TRAIN_BUCKET}" \ > --region=us-central1 \ > -- \ > --from_train_data=${INPUT_TRAIN_DATA_A} \ > --to_train_data=${INPUT_TRAIN_DATA_B} \ > --from_dev_data=${INPUT_TEST_DATA_A} \ > --to_dev_data=${INPUT_TEST_DATA_B} \ > --train_dir="${TRAIN_PATH}" \ > --data_dir="${TRAIN_PATH}" \ > --from_vocab_size=45000 \ > --to_vocab_size=45000

ボットとの会話

おそらく、トレーニング中にCloud Storageを使用して中間モデルの状態を保持する最大の利点は、学習プロセスを中断せずに通信を開始できることです。

次に、たとえば、わずか1600回のトレーニングを繰り返した後、ボットとチャットを開始する方法を示します。 ちなみに、これはローカルマシンで実行する唯一の手順です。 理由は明らかだと思う=)

方法は次のとおりです。

mkdir ~/tmp-data gsutil cp gs://chatbot_generic/chatbot_generic_20161224_232158/translate.ckpt-1600.meta ~/tmp-data ... gsutil cp gs://chatbot_generic/chatbot_generic_20161224_232158/translate.ckpt-1600.index ~/tmp-data ... gsutil cp gs://chatbot_generic/chatbot_generic_20161224_232158/translate.ckpt-1600.data-00000-of-00001 ~/tmp-data ... gsutil cp gs://chatbot_generic/chatbot_generic_20161224_232158/checkpoint ~/tmp-data TRAIN_PATH=... python -m translate.translate \ --data_dir="${TRAIN_PATH}" \ --train_dir="${TRAIN_PATH}" \ --from_vocab_size=45000 \ --to_vocab_size=45000 \ --decode Reading model parameters from /Users/b0noi/tmp-data/translate.ckpt-1600 > Hi there you ? . . . . . . . . > What do you want? i . . . . . . . . . > yes, you i ? . . . . . . . . > hi you ? . . . . . . . . > who are you? i . . . . . . . . . > yes you! what ? . . . . . . . . > who are you? i . . . . . . . . . > you ' . . . . . . . .

TRAIN_PATH変数は「tmp_data」フォルダーにつながり、現在のディレクトリは「models / tutorials / rnn」になります。

ご覧のとおり、チャットボットはわずか1,600ステップでまだ完璧にはほど遠い状態です。 5万回の反復後に彼がどのように通信できるかを確認したい場合、目標は理想的なチャットボットをトレーニングすることではなく、Google Cloud MLを使用してクラウド内のネットワークをトレーニングする方法を学ぶことなので、最後の記事を再度参照します。

事後

私の記事がCloud MLとCloud Shellの操作の複雑さを学ぶのに役立ち、それらを使用してネットワークをトレーニングできることを願っています。 また、あなたがそれを書いて気に入ってくれたことを願っています。もしそうなら、あなたは私のpatreonページで私をサポートすることができます。

手順のいずれかで問題に気付いた場合は、すぐに修正できるようにお知らせください。