この記事は、ONTAPを備えたストレージシステムの所有者にとって有用であり、 Disk AlignmentパートはNetAppの所有者だけでなく有用です。

VMWare ESXi 6.X設定は、次の部分に分けることができます。

- ハイパーバイザーの最適化

- ゲストOS最適化( GOS )

- 最適なSAN設定( FC / FCoEおよびiSCSI )

- NAS設定( NFS )

- ハードウェア、ファームウェア、およびソフトウェアの互換性を確認する

ボトルネックを検索するには、通常、順次除外手法が実行されます。 最初にストレージから始めることをお勧めします 。 次に、 ストレージを移動->ネットワーク( イーサネット / FC)->ホスト( Windows / Linux / VMware ESXi )→アプリケーション。

VMware + NetAppをセットアップする際に信頼する必要がある基本的なドキュメントがいくつかあります。

» ONTAP 8.xでVMware vSphere 6.xを構成する方法

» VMware vSphereインストール用Virtual Storage Console 6.0

» TR-4128:NetApp MetroCluster 8.3上のvSphere 6

ハイパーバイザー

すべてのサーバーリソースをゲストOSに提供する価値はありません。第一に、ハイパーバイザーは少なくとも4GBのRAMを残す必要があり、第二に、ゲストOSリソースを追加するときに逆の効果が観察されることがあります。

スワップ

このセクションは別の投稿に提出されました。

ゲストOS

チューニング設定は、次の2つの目的で必要です。

- ゲストOSパフォーマンスの最適化

- 1つのコントローラーの障害(テイクオーバー)およびその操作の再開(ギブバック)の場合のHAペアでの通常の操作

ディスクの位置合わせ

パフォーマンスを最適化するには、 ディスクの不整合を解消する必要があります。 ずれは、次の2つの場合に得られます。

- ストレージシステムで作成するときの月のジオメトリが正しくないため。 このエラーは、 SAN環境でのみ作成できます。

- 仮想マシンの仮想ディスク内。 たぶんSANとNAS環境の両方で

これらのケースを見てみましょう。

VMFSデータストア上の完全に整列したブロック

まず、 VMFSデータストアとストレージの境界で完全に整列したブロックを検討します。

最初のケース-VMFSとの不整合

最初のケースは、ストレージに対するVMFSデータストアの不整合がある場合です。 最初のタイプの問題を修正するには、正しいジオメトリで月を作成し、そこに仮想マシンを移動する必要があります。

2番目のケースは、ゲストOS内のオフセットです

2番目の状況は、 WAFLファイル構造に対してゲストOS内でファイルシステムパーティションがシフトされているため、古いLinuxディストリビューションとWindows 2003以前で取得できます。 問題は「仮想マシンの内部」にあるため、NDMとVMFSの両方のデータストア、およびRDMとvVOLの両方で確認できます。 通常、これは、MBRパーティションテーブルの配置が不適切であるか、物理から仮想に変換されたマシンが原因です。 dmdiag.exe -vユーティリティを使用して、 WindowsゲストOSでこれを確認できます(Rel Secフィールドの値は、 WAFLによる4KBの倍数でなければなりません)。 Windowsマシンのミスアライメント診断の詳細をご覧ください。 このような状況に対処する方法の詳細については、仮想環境でのファイルシステムアラインメントに関するTR-3747ベストプラクティスを参照してください。

2つのレベルのずれ

そしてもちろん、 VMFSデータストアレベルとゲストOSのファイルシステムレベルの両方で、2つのレベルで一度に不整合が発生する可能性があります。 ONTAPリポジトリから不整合を見つける方法の詳細をご覧ください。

新しく作成されたVMFS5(VMFS3でのアップグレードではない)では、ブロックはサイズが1MBで、サブブロックが8KBです。

新しく作成されたVMFS5(VMFS3でのアップグレードではない)では、ブロックはサイズが1MBで、サブブロックが8KBです。

テークオーバー/ギブバック

HAペアでテイクオーバー/ギブバックを使用するには、ゲストOSの正しいタイムアウトを構成する必要があります。 ディスクFASシステムの場合、この時間は60秒であり、オールフラッシュFAS(AFF)の場合は2〜15秒です。 クラスターには異なるモデルのストレージシステム、ディスク、ハイブリッド、AFFシステムを含めることができ、これらのシステム間でデータを移行できるため、最悪のタイムアウト値(ディスクシステムの場合)、つまり60秒を使用することをお勧めします。

| OS | SANのゲストOSチューニングの更新:ESXi 5以降、またはONTAP 8.1以降(SAN)

|

|---|---|

| 窓 | ディスクタイムアウト= 60 |

| Linux | ディスクタイムアウト= 60 |

| Solaris | ディスクタイムアウト= 60; ビジー再試行= 300; 準備ができていない再試行= 300; リセット再試行= 30; 最大 スロットル= 32; 分 スロットル= 8; 修正されたVID / PID仕様 |

NFSを使用する場合のデフォルトのOS値で十分であり、ゲストOSの設定を変更する必要はありません。

これらの値は、手動で、またはVSCの一部として利用可能なスクリプトを使用して設定されます。

窓

レジストリを使用して、ディスクアクセス遅延の値を60秒に設定します(16進数形式で秒単位で設定)。

[HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\services\Disk] "TimeOutValue"=dword:0000003c

Linux

udevルール(16進数形式で秒単位で指定)を作成して、ディスクアクセス遅延値を60秒に設定します。

DRIVERS=="sd", SYSFS{TYPE}=="0|7|14", RUN+="/bin/sh -c 'echo 60 > /sys$$DEVPATH/timeout'"

(Linuxディストリビューションでは、udevルールのインストール場所が異なる場合があります)。 ゲストLinux OS用のVMware Toolsは、180秒の仮想ディスクの遅延値でudevルールを自動的に設定します。 udevルールフォルダーの「VMware」ベンダーIDに対してgrepコマンドを実行して、この値を設定し、必要に応じて変更するスクリプトを見つけることができます。 この値を必ず確認してください。

Solaris

/ etc /システムファイルのディスクに60秒の遅延の値(16進数形式で秒単位で指定)を設定できます。

/kernel/drv/sd.confファイルに追加の設定を行うことができます。

Solaris 10.0 GA-Solaris 10u6:

set sd:sd_io_time=0x3c

/kernel/drv/sd.confファイルに追加の設定を行うことができます。

Solaris 10.0 GA-Solaris 10u6:

sd-config-list="NETAPP LUN","netapp-sd-config", "VMware Virtual","netapp-sd-config"; netapp-sd-config=1,0x9c01,32,0,0,0,0,0,0,0,0,0,300,300,30,0,0,8,0,0;

Solaris 10u7以降およびSolaris 11

注:ベンダーID NETAPPとID LUNの間、および上記の構成の「VMware」と「Virtual」の間に2つのスペースがあります。

sd-config-list= "NETAPP LUN","physical-block-size:4096,retries-busy:300,retries-timeout:16,retries-notready:300,retries-reset:30,throttle-max:32,throttle-min:8", "VMware Virtual","physical-block-size:4096,retries-busy:300,retries-timeout:16,retries-notready:300,retries-reset:30,throttle-max:32,throttle-min:8";

注:ベンダーID NETAPPとID LUNの間、および上記の構成の「VMware」と「Virtual」の間に2つのスペースがあります。

FC / FCoEスイッチのゾーニング設定

NetAppのゾーニングガイドラインの詳細については、写真をご覧ください。

アルア

ONTAP 8.Xおよび9.Xでは、 ALUAはすべてのブロックプロトコル( iSCSI / FC / FCoE )で常に有効になっています。

ホストがALUAを正しく定義した場合、 Storage Array TypeプラグインはVMW_SATP_ALUAを表示します 。 ALUAの場合、 最近使用されたアルゴリズムまたはラウンドロビンアルゴリズムanyを使用できます。

コントローラーへのパスが複数ある場合、 ラウンドロビンの生産性が向上します。 Microsoft Cluster + RDMディスクを使用する場合、 最近使用したバランシングメカニズムを使用することをお勧めします。

以下は、推奨される負荷分散設定の表です。 NetApp ONTAP、ALUAロジック、およびブロックプロトコルの負荷分散の詳細をご覧ください。

| モード | アルア | プロトコル | ESXiポリシー

| ESXiパスバランシング

|

|---|---|---|---|---|

| ONTAP 9.x / 8.x(クラスター化) | 有効化 | FC / FCoE / iSCSI | VMW_SATP_ALUA | 最近使用した |

| ONTAP 9.x / 8.x(クラスター化) | 有効化 | FC / FCoE / iSCSI | VMW_SATP_ALUA | ラウンドロビン |

チェックした月/データストアに適用されたポリシーを確認してください

~ # esxcli storage nmp device list naa.60a980004434766d452445797451376b Device Display Name: NETAPP Fibre Channel Disk (naa.60a980004434766d452445797451376b) Storage Array Type: VMW_SATP_ALUA Storage Array Type Device Config: {implicit_support=on;explicit_support=off; explicit_allow=on;alua_followover=on;{TPG_id=1,TPG_state=ANO}{TPG_id=0,TPG_state=AO}} Path Selection Policy: VMW_PSP_RR Path Selection Policy Device Config: {policy=rr,iops=1000,bytes=10485760,useANO=0; lastPathIndex=0: NumIOsPending=0,numBytesPending=0} Path Selection Policy Device Custom Config: Working Paths: vmhba2:C0:T6:L119, vmhba1:C0:T7:L119 Is Local SAS Device: false Is USB: false Is Boot USB Device: false

ESXiホストの設定

ESXiホストを最適に動作させるには、推奨されるパラメーターを設定する必要があります。

| パラメータ | プロトコル | ESXi 6.xとDataONTAP 8.x | ESXi 6.xとDataONTAP 9.x |

|---|---|---|---|

| Net.TcpipHeapSize | iSCSI / NFS | 32 | |

| Net.TcpipHeapMax | iSCSI / NFS | 1536 | |

| NFS.MaxVolumes | NFS | 256 | |

| NFS41.MaxVolumes | NFS 4.1 | 256 | |

| NFS.HeartbeatMaxFailures | NFS | 10 | |

| NFS.HeartbeatFrequency | NFS | 12 | |

| NFS.HeartbeatTimeout | NFS | 5 | |

| NFS.MaxQueueDepth | NFS | 64(AFFのみの場合、128または256) | |

| Disk.QFullSampleSize | iSCSI / FC / FCoE | 32 | |

| Disk.QFullThreshold | iSCSI / FC / FCoE | 8 | |

これを行うには、いくつかの方法があります。

- ESXi 6.xホストでのコマンドラインインターフェイス(CLI)の使用。

- vSphere Client / vCenter Serverを使用します。

- VMwareのリモートCLIツールを使用します。

- VMware Management Appliance(VMA)を使用します。

- ホストプロファイルを使用して、構成済みのESXi 6.xから他のホストに展開します。

ESX 6.x CLIから詳細オプションを設定する例

これらの例で使用されるesxcfg-advcfgユーティリティは、ESXiホストの/ usr / sbinフォルダーにあります。

# iSCSI/NFS #esxcfg-advcfg -s 32 /Net/TcpipHeapSize #esxcfg-advcfg -s 512 /Net/TcpipHeapMax # NFS #esxcfg-advcfg -s 256 /NFS/MaxVolumes #esxcfg-advcfg -s 10 /NFS/HeartbeatMaxFailures #esxcfg-advcfg -s 12 /NFS/HeartbeatFrequency #esxcfg-advcfg -s 5 /NFS/HeartbeatTimeout #esxcfg-advcfg -s 64 /NFS/MaxQueueDepth # NFS v4.1 #esxcfg-advcfg -s 256 /NFS41/MaxVolumes # iSCSI/FC/FCoE #esxcfg-advcfg -s 32 /Disk/QFullSampleSize #esxcfg-advcfg -s 8 /Disk/QFullThreshold

ESX 6.x CLIから詳細設定を確認する

# iSCSI/NFS #esxcfg-advcfg -g /Net/TcpipHeapSize #esxcfg-advcfg -g /Net/TcpipHeapMax # NFS #esxcfg-advcfg -g /NFS/MaxVolumes #esxcfg-advcfg -g /NFS/HeartbeatMaxFailures #esxcfg-advcfg -g /NFS/HeartbeatFrequency #esxcfg-advcfg -g /NFS/HeartbeatTimeout #esxcfg-advcfg -g /NFS/MaxQueueDepth # NFS v4.1 #esxcfg-advcfg -g /NFS41/MaxVolumes # iSCSI/FC/FCoE #esxcfg-advcfg -g /Disk/QFullSampleSize #esxcfg-advcfg -g /Disk/QFullThreshold

フバ

NetAppでは、通常、アダプターの製造元が設定したESXiホストを使用するONTAPシステム用のHBAに 「デフォルト値」を使用することを推奨しています。 変更されている場合は、出荷時の設定に戻す必要があります。 関連するベストプラクティスをご覧ください。 たとえば、NetApp上のVMwareでのDB2仮想化について話している場合、ESXiでキューの長さを64に増やすことをお勧めします( 21ページを参照 )(これを行う方法はVmware KB 1267で記述されています)。

ESXiでのHBA Qlogicセットアップの例

# Qlogic ESXi 5.5 6.0 # esxcli system module list | grep qln # Qlogic ESXi 5.5 6.0 # esxcli system module parameters set -p qlfxmaxqdepth=64 -m qlnativefc

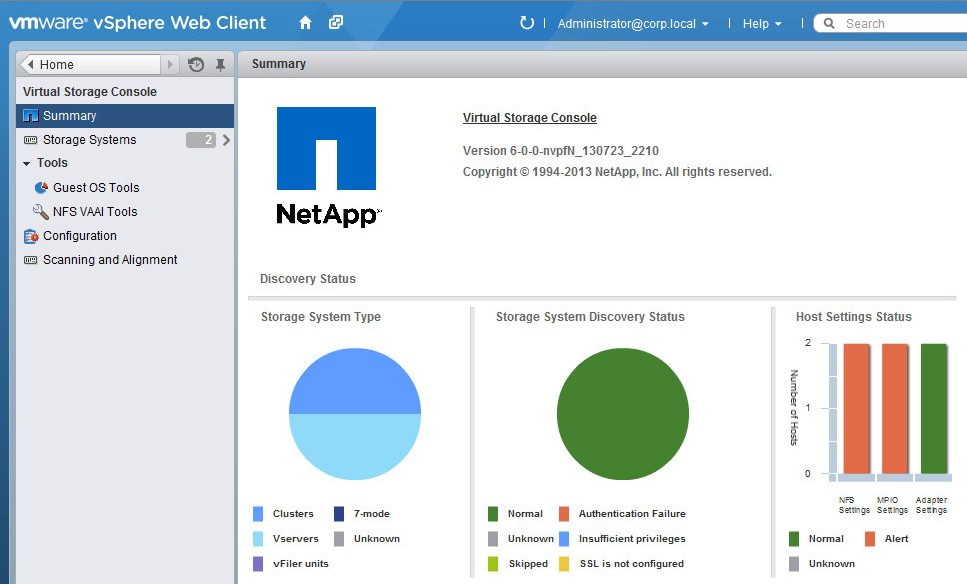

Vsc

NetApp VSCプラグイン(フリーソフトウェア )は、ESXiホストとHBAアダプターの推奨設定(キュー、遅延など)を設定します。 プラグイン自体はvCenterに統合されます。 NetAppでより効率的に動作するようにESXiホストでパラメーターを設定する場合、テスト中の時間を節約し、人的要因を排除します。 仮想化環境の管理者が必要とするvCenterからストレージを管理するための基本操作を実行できます。 VSCストレージのアクセス許可は、 RBACを使用して複数のユーザーに対して柔軟に構成できます。 vSCはvVOLを構成するために必要です。

プラグインバージョンは、Webクライアントでのみ使用できます。 バージョン6以降がサポートされています。

イーサネット

ジャンボフレーム

iSCSIを使用している場合、1Gb以上の速度でイーサネットのジャンボフレームを使用することを強くお勧めします。 詳細については、NetApp ONTAPのイーサネットに関する記事をご覧ください。 LACP、ポートチャネル、スパニングツリー、PortFast、Flowcontrol設定に関するVMwareの推奨事項を忘れないでください。

ESXiおよびMTU9000

適切なネットワークアダプターを作成することを忘れないでください— VMwareはVMXNEE3の使用を推奨しています。 ESXi 5.0以降、VMXNET3はジャンボフレームをサポートしています。 E1000eネットワークアダプターは、1GBネットワークとMTU 9000の速度をサポートします-デフォルトでは、作成されたすべてのVMにインストールされます(Linuxを除く)。 Flexible Flexible Standard Virtual Network Adapterは、MTU 1500をサポートしています。 詳細

また、仮想マシンの仮想ネットワークアダプター用にインストールされたポートグループは、MTU 9000設定がスイッチ全体に設定された仮想スイッチに接続する必要があることを忘れないでください。

NASおよびVAAI

ONTAPシステムは、ホストからストレージにデータストア上のルーチンデータ管理タスクの一部をダウンロードすることにより、VMware VAAIプリミティブをサポートします。 ONTAPシステム8.0以降を備えたESXi 4.1+以降のSAN環境では 、 VAAIが自動的にサポートされ、操作の必要はありません。 NAS環境向けに、NetAppはNFSプロトコルの同様の最適化を可能にするプラグインをリリースしました。 これには、各ESXiホストにNetAppNFSVAAIカーネルモジュールをインストールする必要があります。 VSCは、vCenterからNFS VAAIプラグインを自動的にインストールできます。 動作させるには、VAAIのNFSボールを正しく構成する必要があります。そのためには、いくつかの要件を満たす必要があります。

- ESXiサーバーアクセスを構成します(RO、RW、およびスーパーユーザーはSYSまたはANY状態である必要があり、NFS3 および NFS4プロトコルを介してアクセスをアクティブにする必要があります)。 NFS4を使用しない場合でも、アクセスリストに含まれている必要があります。

- ジャンクションパスのすべての親ボリュームは、ルート読み取りアクセスとNFSv4アクセスを許可する必要があります。 ほとんどの場合、これは、Storage Virtual Server(Vserver)のルートボリュームには、少なくとも、対応するクライアントのSYSに設定されたスーパーユーザー設定が必要であることを意味します。 Vserverルートボリュームへの書き込みアクセスを直接拒否することをお勧めします。

- ボリュームでvStorageサポートを有効にする必要があります。

ONTAPでのVAAIの例

cm3240c-rtp::> export-policy rule show -vserver vmware -policyname vmware_access -ruleindex 2 (vserver export-policy rule show) Vserver: vmware Policy Name: vmware_access Rule Index: 1 Access Protocol: nfs3 <---- needs to be 'nfs' or 'nfs3,nfs4' Client Match Spec: 192.168.1.7 RO Access Rule: sys RW Access Rule: sys User ID To Which Anonymous Users Are Mapped: 65534 Superuser Security Flavors: sys Honor SetUID Bits In SETATTR: true

cm3240c-rtp::> export-policy rule show -vserver vmware -policyname root_policy -ruleindex 1 (vserver export-policy rule show) Vserver: vmware Policy Name: root_policy Rule Index: 1 Access Protocol: nfs <--- like requirement 1, set to nfs or nfs3,nfs4 Client Match Spec: 192.168.1.5 RO Access Rule: sys RW Access Rule: never <--- this can be never for security reasons User ID To Which Anonymous Users Are Mapped: 65534 Superuser Security Flavors: sys <--- this is required for VAAI to be set, even in the parent volumes like vsroot Honor SetUID Bits In SETATTR: true Allow Creation of Devices: true

cm3240c-rtp::> nfs modify -vserver vmware -vstorage enabled

ヴァーサ

VASAは、vCenterがAPIを使用してストレージの機能を学習し、それらをより有効に使用できるようにする無料のソフトウェアです。 VASAは VSCに統合され、 GUIインターフェイスを介して特定のストレージ機能を持つデータストアプロファイルを作成できます(たとえば、Thing Provitioningの有無、ディスクタイプ: SAS / SATA / SSD 、2次キャッシュの存在など)、誰もいない場合の通知を有効にしますレベル(占有スペースや負荷など)。 バージョン6.0以降、 VASAはVSCの必須コンポーネントであり、VMware vVOLパラダイムの重要な(そして必須の)部分です。

スペース予約-UNMAP

ESXi 5.0以降では、リリースされたブロックをシンムーン(データストア)からストレージに戻すことがサポートされています。 VMFSを搭載したバージョンESXi 5.X / 6.0では、スペースを戻すために手動で起動する必要があります。vVOLを搭載したESXi 6.Xでは自動的に動作し、バージョン6.5以降ではVMFS-6データストアで自動的に動作します(遅延あり)。 ONTAP側では、この機能はデフォルトで常にオフになっていますが、 有効にするには、ストレージシステムでいくつかの簡単なコマンドを実行する必要があります 。

vVOL

このトピックは特別な注意に値し、別の記事に記載されています 。

適合性

データセンターインフラストラクチャの潜在的な問題を軽減するために、実際に互換性マトリックスを広く適用してください。 トラブルシューティングについては、 KB NetAppおよびVMwareにお問い合わせください。

ESXiホストの最適化に関するこの記事に追加するものがあると確信していますので、随時こちらをご確認ください。

結論

VMWare仮想化環境に適切な設定を行うと、インフラストラクチャのパフォーマンスが向上するだけでなく、フォールトトレランスが向上します。 インフラストラクチャを最初に起動するときは、必ずVMwareとNetAppの推奨事項に従ってください。 起動中に、負荷テストとフォールトトレランステストの両方で構成されるテスト計画を作成して、構成エラーの可能性を排除し、通常の運用時および障害発生時のインフラストラクチャの機能と動作を把握してください。

英語翻訳:

ONTAPおよびESXi 6.xのチューニング

これには、後で公開されるHabraの記事へのリンクが含まれる場合があります。 テキストのエラーに関するメッセージをLANに送ってください。 それどころかコメントや追加は、コメントでお願いします。