つまり、このテクノロジーにより、仮想マシンはハイパーバイザーを使用してサーバー上の物理pci

デバイスに直接アクセスできます。 ただし、このテクノロジーを使用すると、 vSphere

クラスターで許可されるほぼすべての有用な機能( fault tolerance

、 high availability

、スナップショット、 vMotion

、およびそれを使用したDRS

しなくなりvMotion

。

さらに、仮想マシンがデバイスを直接使用して、ハイパーバイザーをバイパスすると、このデバイスはハイパーバイザー自体にアクセスできなくなります。 たとえば、 DirectPath I/O

を介して仮想マシン内にネットワークカードを投げると、はい、仮想マシンからのトラフィックを処理するためのハイパーバイザーのリソースは使用されなくなります-これは良いことです。 悪いことは、スローされたネットワークカードを使用できる仮想マシンが1つだけであることです。 結局のところ、このテクノロジーは非常に物議を醸すものであり、無駄です。 しかし、すべてがそれほど単純ではありません。

楽しいCisco UCS

率直に言って、私はかなり退屈なタイプで、賞賛することはほとんど不可能です。 それがうまくいったとしても、私はいつもそれを見せたいとは思わない、そして私がそれを望むところに、私はいつもうまくいくとは限らない。 正直に言うと、 Cisco

ブレードシステムに慣れる前は、 Cisco

がサーバーを製造していることすら知りませんでした。 それは判明し、生産し、そして私が賞賛するのに飽きることのないものでさえも。

私は一生サーバーで仕事をしていましたが、ブレードシステムが手に落ちることは少々少なくなりました。 UCS manager

初めて見たとき、突然それを受け取らないことが明らかになりました。 なんで? サーバーにボタンがないためだけです。 service profile

特定の構成パラメータのセットから形成されるまで、鉄片は役に立たない。

プロファイルの構成パラメータでは、ブレードから何でもスカルプトできます:BIOSパラメータ、ブートシーケンス、 ip-kvm

、 hba

、ファームウェアバージョン、ネットワークカードのパラメータおよびmac

アドレス( iscsi

および通常)。 これはすべて非常に柔軟に行われ、便利な階層と、アドレスやポピーなどの大幅に変化するパラメーターのプールを指定する機能を備えています。 したがって、これがすべて研究されるまで、ブレードは機能しません。

ブレードネットワーク

ここでは構成については説明しません。 Cisco

は、この主題に関する非常に明確なドキュメントを提供しています。 そして、Habréを含むインターネット上で、これについて多くの記事が書かれています。 Cisco UCS

ブレードシステムのネットワーク部分についてCisco UCS

ます。 ネットワーク部分も特別です。 実際、ブレードサーバーにはネットワークインターフェイスがありません。 ブレードはネットワークでどのように機能しますか? それでも同じように、各ブレードにはネットワークアダプターがあります。これはVirtual Interface Card

( vic

)です。

バスケット内のIO Module

( iom

) iom

、これら2つの鉄片により、実サーバーに必要な量の仮想ネットワークインターフェイスを作成できます。 もちろん、制限はありますが、制限は非常に大きく、すべての人に十分なはずです 。 では、なぜブレードに100個のネットワークインターフェイスが必要なのでしょうか? 仮想化を使用しない場合、理由はありません。 これが時が来た場所です ヴァレラ 役に立たない DirectPath I/O

思い出してDirectPath I/O

。これは今ではまったく異なる観点から見られます。

vSphere

のドキュメントの 2番目の部分では、 Cisco UCS

DirectPath I/O

突然DirectPath I/O

ブラックジャックと売春婦が付属しています スナップショット、 fault tolerance

、 high availability

、およびvMotion

で動作しvMotion

。これらには、 DRS

が続きvMotion

。 「クール!」私はそれについて読んだときに考えました。 「さっそくやって、みんな幸せになります」と中断しました。 Cisco

ドキュメントにもVMWare

ドキュメントにも、これをすべて実行する方法の説明のようなものは見つかりませんでした。 私が見つけることができたすべてのうち、ステップバイステップの指示を作成する試みに非常にリモートで似ているものがありました。 このサイトはすでに死んでいるので、ウェブアーカイブへのリンクです。

もう少し水

私は最初に詳細なマニュアルを作成することにしました-私自身のために、もう一度タスクに直面したとき、私は何も忘れずに、迅速かつ正常にすべてを繰り返します。 第二に、他のすべての人にとっては、ほとんどの読者、おそらく将来は自分もCisco UCS

出会うことはないだろうということをよく知っています。 インポート置換にも感謝します。

UCS

でDirectPath I/O

を正常に使用するには、 vSphere

virtual distributed switch

( vds

)がどのように機能するかを理解する必要があります。 理解がない場合、または開始できない場合、このマニュアルを完了したと思われる場合は、ここで説明されているすべてを実行できます-これはエラーです。 開始することが判明する場合がありますが、その後、誤解による誤ったアクションのために非常に簡単に壊れます。

同じことがUCS manager

も当てはまります。 この記事では、 vds

、およびUCS manager

ほとんどの構成については説明しません。 VMWare

、 Cisco

、さまざまなハウツー、フォーラムの質問と回答、およびインターネット上の他のものに関する十分な説明があります。

ucsm

とvcsa

ucsm

がvCenter Server Appliance( vcsa

)にvds

を作成してvcsa

をドライブするには、最後にキーを追加してアクセスを許可する必要があります。

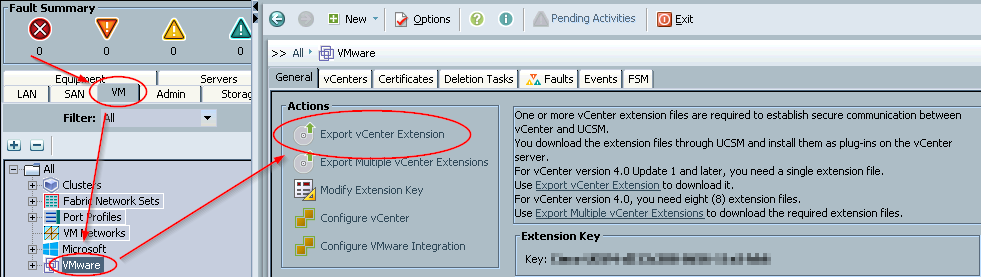

-

ucsm

を開く→vm

タブ→filter: all

→vmware

よる

→export vCenter extension

、cisco_ucs_vmware_vcenter_extn.xml

ファイルが含まれるディレクトリを示します。 実際、スクリーンショットを撮るのはあまり好きではありませんが、そのような鉄片を描くのは素晴らしいことです。

- 次に、この拡張機能を

vcsa

にインポートする必要があります。VMWare

は、バージョン5.1からのvCenter

を使用したすべての操作は、Webクライアントを介して実行できると主張しています。 たぶんそうですが、バージョン5.1、5.5、または6.0のいずれかで、このファイルをWebクライアントからインポートする方法を見つけられませんでした。

そのため、 vmware vsphere client

バージョン6.0を開く→トップメニュー→ plugins

→ plugins

manage plugins

→

プラグインのリストが表示されたウィンドウの空の場所で、

→ new plug-in...

→ browse...

→ cisco_ucs_vmware_vcenter_extn.xml

→ register plug-in

登録に成功すると、新しいCisco-UCSM-xxx

プラグインがリストに表示されます。xxxの代わりに、上のスクリーンショットで難読化したキーがあります。

vcsa

はvcsa

からのコマンドを受け入れる準備ができました。

vm-fex

vds

vm-fex

はucsm

で作成および構成する必要があるvirtual distributed switch

を介してvirtual distributed switch

し、後者は前の部分で説明した統合によりvcsa

この構成を適用します。 この部分のすべての作業は、 vm

タブのucsm

で行われるため、すべての点で参照するわけではありません。

-

vmware

クリックし、configure vCenter

フィールドname

、description

、およびhostname (or ip address)

vcsa

のデータhostname (or ip address)

記述します:gallente tackler

、10.7.16.69

、10.7.16.69

→next

2回→セクションfolders

とdatacenters

スキップ→finish

; -

ares

クリック→create datacenter

→name

とdescription

フィールドにvcsa

すでに作成されているデータセンターのデータを書き込みます:dc

→next

→スキップするfolders

セクション→finish

; -

dc

クリック→create folder

→name

フィールドとdescription

フィールドにvds

が含まれるcreate folder

のデータを書き込みます:ucs

→next

→sectionDVSs

skip→finish

; -

ucs-main

右クリック→create DVS

→name

とdescription

フィールドにvds

のデータを書き込みます:ucs-main

→OK

→admin state: enable

-

vds

準備vds

できました。vds

、port profiles

を作成しport profiles

。 本質的には、これはdistributed port group

と同じですが、cisco

用語では。 そのうち2つしかありません。1つはすべてのvilanが許可されるトランクプロファイル、もう1つは仮想マシンの管理ネットワークを備えたタグなしvilanで、ゲストシステムは何らかの理由でトラフィックにタグ付けできません。

-

port profiles

クリックします。name

とdescription

フィールドで、プロファイルデータvm-mgmt-ucs

を書き込みます。host network io performance

:high performance

→VLANs

のリストで、mganmgmt

反対側の3番目の列のラジオボタンを1つ選択します -

vm-trunk-ucs

トランクポートについても同じことを行います。 ラジオボタンを選択する代わりに、最初の列ですべてのvylansをオフにします。 ucsmに必要なucsm

がすでに作成されていることが理解されています。 - 次に、これら2つのプロファイルを

vds

入れる必要があります。 それらのいずれかをクリックして、profile clients

タブを選択→右側の緑色の[+]

→name

:all

、datacenter

:all

、folder

:all

、distributed virtual switch

:all

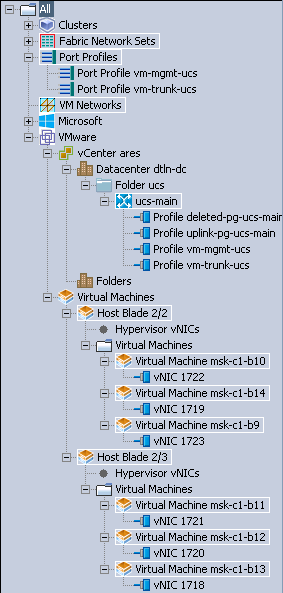

。 2番目のプロファイルでも同じです。 次のようになります。

しばらくして、このucs-main

がvcsa

登場しvcsa

。 これが発生しない場合は、fsm

タブを確認する必要があります-ほとんどの場合、理由がそこに書き込まれます。

-

ハイパーバイザーブレード

冒頭で述べたように、ブレードを起動するには、プロファイルを掛ける必要があります。 これを行うには、最初にプロファイルを作成する必要があります。 サーバーのプロファイルを作成することは、このドキュメントの目的ではないため、プロファイルを作成するために必要なものはすべてそこにあるということです。 vm-fex

関連するもののみを説明します。これがないと、 DirectPath I/O

は機能しません。 各ブレードで、4つの静的ネットワークインターフェイスを実行します。 4つすべてが1つのファクトリに関連付けられ、2番目のファクトリにfailover

されfailover

。 ブレードの半分は工場

で、残りの半分はそれぞれb

ます。

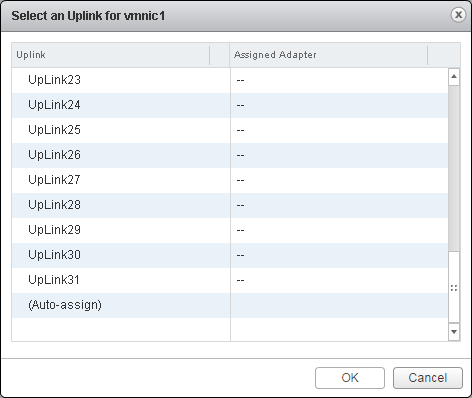

最初のインターフェイスは通常のvSwitchのままです。 2番目のインターフェイスは通常のvds

接続されます。 3番目のインターフェイスはucs-vds

接続されます。 実際には、 ucs-vds

でのuplink

形式のインターフェイスの参加は、 ucs-vds

ように見えます。 彼に依存するものは何もありません。 しかし、これが行われていない場合、仮想インターフェイスの転送は機能しません-私はチェックしました:)仮想マシンのポートをより柔軟に構成できるように、4番目のインターフェイスをソフトウェアcisco nexus 1000v

として追加のvds

に接続することを計画しましたが、私の手はまだ到達しませんでした。

VMWare

レベルでstand by

ことなく、すべてのインターフェイスをスイッチに追加します。 failover

UCS

レベルで実装されます。 接続レベルで冗長ではない2つのインターフェイスを持つ通常のブレードまたはサーバーの場合、このスキームは正しくありません。 UCS

以外で不注意にそれを繰り返さないでください。

adapter policy

作成

adapter policy

は、サーバー内の各ネットワークインターフェイスの設定の集合です。 最初のadapter policy

は、4つの静的ハイパーバイザーインターフェイス用で、2つ目のadapter policy

は動的用です。

- タブ

servers

→policies

→root

→adapter policies

右クリック→create ethernet adapter policy

→name

:nn-vmw

、リソース:

-

transmit queues

:4

、ring size

:4096

; -

receive queues

:4

、ring size

:4096

; -

completion queues

:8

、interupts

:16

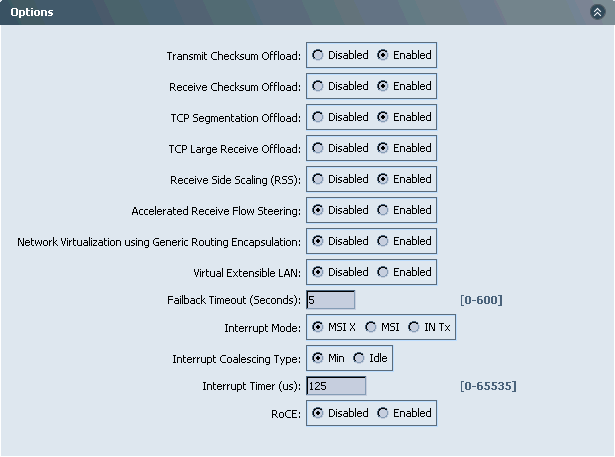

; - 書き換え

options

怠zyなので、スクリーンショットは次のとおりです。

-

- 再び

servers

→policies

→nn-vmw-pt

→adapter policies

nn-vmw-pt

→name

:nn-vmw-pt

、リソース:

-

transmit queues

:8

、ring size

:4096

; -

receive queues

:8

、ring size

:4096

; -

completion queues

:16

、interupts

:32

; - 残りは同じです。 動的インターフェイスを実行するには少なくとも8つのキューが必要であるため、2倍のキューがあります。 今のところ確認のソースを提供することはできません。 もう一度見つけたら追加します。

-

グループ化されたvnic template

を作成する

ブレードにネットワークインターフェイスを持たせるには、テンプレートを作成する必要があります。 テンプレートは各プロファイルで直接使用することも、 lan connectivity policy

介してグループ化することもできます。 2番目のケースでは、サーバープロファイルまたはプロファイルテンプレートごとに、必要なすべてを実行する目的のlan connectivity policy

を指定するだけで十分です。

静的インターフェイス用に2つのテンプレートを作成します。 1つのテンプレートはファクトリーa

で動作し、 b

でfailover

しfailover

が、2番目はその逆です。

-

lan

タブ→policies

→root

→vNIC templates

によるcreate vnic template

→create vnic template

→name

:trunk-a

→fabric id

:a

、enable failover

→target

:adapter

とvm

( 注意 !完成したテンプレートでこの設定を変更すると失敗します)→template type

:updating template

→すべてのvilanをオフにします→MACプールでdynamic vnic

アドレスの事前に作成されたmac pool

選択します→connection policies

:dynamic vnic

2番目のtrunk-b

パターンは、fabric id

を除いて同じです:b

。 - グループ化とは、

lan connectivity policy

を意味します:lan

タブ→policies

→root

→lan connectivity policies

esxi4-trunk-a

PCM→lan connectivity policies

create lan connectivity policy

→name

:[+] add

ボタンを使用してesxi4-trunk-a

、次に4つのネットワークインターフェイスを追加します。

-

user vnic template

横のボックスをuser vnic template

、3つのフィールドのみを入力します。name

:nic0

、vnic template

:前の段落で作成されたtrunk-a

選択し、adapter policy

:nn-vmw

、以前に作成されました。 -

name

についてさらに3回繰り返しますnic3

..nic3

;

-

name

: esxi4-trunk-b

についてセクション全体を繰り返しb

それぞれファクトリーb

バインドします。

bios policy

作成

bios policy

-これらはBIOS設定です。BIOS設定に変更することで変更できます。 コンソールを開いて各ブレードにアクセスすることは意味がありません。これがすべてブレードパックのためにすぐに中央で実行できる場合です。

- タブ

servers

→policies

→root

→bios policies

によるbios policies

→bios policies

create bios policy

:

-

name

:fex

; -

reboot on bios settings change

反対側のチェックボックス。 - また、通常

resume on ac power loss

(サーバー)でresume on ac power loss

ために、reset

ラジオreset

反対側に設定します。

-

-

processor

セクション:

-

virtualization technology (vt)

:enabled

。 -

direct cache access

:enabled

。

-

-

intel direct io

セクションでは、すべてのラジオボタンがenabled

状態です。 - これは

DirectPath I/O

には適用されませんが、boot options

セクションでboot option retry

を有効にすることも好きです。 - これは、

DirectPath I/O

必要な最小値ですDirectPath I/O

残りは必要です。または、すぐに[Finish

押します。

その他の設定は、ポリシーの作成後に変更できます。

service profile

作成する

それから形成され、ブレードに直接掛けられ、それに応じて鉄片が構成されます。 サーバープロファイルを直接作成し、クローンを作成できます。 ただし、すべての依存サーバープロファイルで設定が継承および変更されるテンプレートから作成する方がより正確です。 サーバープロファイルテンプレートには、ここでは考慮されていない多くの設定が含まれています。これは、私の助けなしで既に完了していることを意味します。 ここでは、 DirectPath I/O

が機能するために必要なもののみを検討します。

サーバータブ→ service profile templates

→右クリック→ create service profile template

。 name

: esxi4-a

、 type

: updating template

。 2番目の設定を完成したテンプレートに変更することはできないため、作成時に設定することを忘れることは非常に重要です。

networking

セクションで、 dynamic vnic connection policy

を設定しcreate a specific dynamic vnic connection policy

をcreate a specific dynamic vnic connection policy

しcreate a specific dynamic vnic connection policy

。 number of dynamic vnics

。 マニュアルのネームプレートによると、ここのデフォルト値は54

です:私はucs

6296を持っていucs

、 iom

モデルはすべてのバスケットにiom

を持っているので、最後の行によれば、 iom

9000の場合の最大vif

数は58、mtu 1500の場合は58です116.この情報は部分的にのみ真実です。

明らかに、 マニュアルを書いたヒンズー教徒はこの問題を完全に理解していませんでした。 真実は、アダプタポリシーにキュー数とring size

誇張された値が含まれている場合、ブレードは54の動的インターフェイスをダイジェストできません。 過大評価された値を拒否することはできません。サーバーには膨大なトラフィック負荷がかかり、ポートあたり10ギガビットをはるかに超えます(これについては後述します)。 アダプターポリソールと数値vif

値を入力する数学的方法を使用して、私の場合、ここで数値33が正常に設定され、追加の静的インターフェースにわずかなマージンがあることがわかりました。 突然必要です。

このため、4つの静的インターフェイスを持つ回路を選択しました。 33の動的なインターフェイスはたくさんありますが、本当に誰にとっても十分なはずです 。 しかし、私のクラスターには、強力なネットワークを必要としない、半休眠状態の仮想マシンが多数あります。 33個の動的インターフェイスの1つをそれらに費やすのは無駄です。 したがって、これらのvds

は、より多くを要求し始めるまで、通常のvds

存続します。 それらのほとんどはこのvds

決して到達しないのでvds

彼らは通常のvds

絶えず生きます。

adapter policy

: nn-vmw-pt

、 protection

: protected

。 これは、 ucsm

が各ブレードのDirectPath I/O

用に作成する動的インターフェイスが両方の工場に均等に分散されることを意味します。 どうしてこうすることにしたのか思い出せません。 おそらく直観。 これが間違っている可能性もあり、動的インターフェイスは静的インターフェイスと同じファクトリに固定する必要があります。 時間はわかります。 再実行するのは簡単です。簡単で、変更のために仮想マシンを停止する必要はありません。

how do would you like to configure lan connectivity?

: use connectivity policy

。 ここで、前に作成したネットワークインターフェイステンプレートのグループ化を利用します。 lan connectivity policy

: esxi4-trunk-a

vnic/vhba placement

、スクリーンショットで簡単に表示できます。

operational policies

セクションで、新しく作成されたbios policy

を設定する必要があります。 これで、サーバープロファイルテンプレートを作成できます。

テンプレートから、プロファイル自体を直接作成できるようになりました。 [サーバー]タブ→ service profile templates

→ root

→ esxi4-trunk-a

よるesxi4-trunk-a

→ create service profiles from template

。 naming prefix

: test

、 name suffix starting number

: 1

、 number of instances

: 1

。 これは、 test1

という名前の単一のプロファイルがテンプレートから作成されることを意味しtest1

。

次に、プロファイルをブレードに関連付ける必要があります。 タブservers

service profiles

root

> test1

クリックtest1

change service profile association

。 select existing server

をselect existing server

、表示されたタブレットでブレード自体を選択します。ブレード自体は作成されたプロファイルに関連付ける必要があります。 [ ok

]ボタンをクリックすると、 ucsm

からブレードが再構築されるという警告の質問が表示されます。 私は肯定で答え、 ucsm

仕事のために刃ucsm

準備するのを待ちます。

ucsm

がブレードを準備している間、サーバープロファイルのnetwork

タブに注意する必要があります。 次のようになります。

正常に完了した後、このセクション全体を繰り返して、ファクトリb

ではなくファクトリb

機能する2番目のテンプレートとプロファイルを作成する必要があります。

結婚する

自動車産業での結婚は、パワーユニットがボディに接続される瞬間です。 この名前はこのセクションにも最適です。

esxi

のインストールはスキップします。 それは非常にシンプルで、まったく面白くないです。 ここでesxi

したVmware-ESXi-5.5.0-2068190-custom-Cisco-5.5.2.3.iso

イメージからESXi550-201512001.zip

をESXi550-201512001.zip

、ここからESXi550-201512001.zip

アップグレードしたことESXi550-201512001.zip

をESXi550-201512001.zip

します 。 その結果、 vCenter

によると、結果はバージョン5.5.0-3248547

です。 または、 Vmware-ESXi-5.5.0-3248547-Custom-Cisco-5.5.3.2.iso

( link )をすぐにインストールできます-結果は同じです。 esxi

インストールイメージesxi

Cisco

サーバー用に特別に準備されていますが、何らかの理由でcisco virtual machine fabric extender

( vm-fex

) vm-fex

含まれていません。

個別にダウンロードする必要がcisco-vem-v161-5.5-1.2.7.1.zip

ますucs-bxxx-drivers-vmware.2.2.6c.iso

からucs-bxxx-drivers-vmware.2.2.6c.iso

ファイルが必要ucs-bxxx-drivers-vmware.2.2.6c.iso

。 このドライバーをハイパーバイザーにアップロードしてesxcli software vib install -d /tmp/cisco-vem-v161-5.5-1.2.7.1.zip

必要があります: esxcli software vib install -d /tmp/cisco-vem-v161-5.5-1.2.7.1.zip

ところで、上記のリンクはすべて自由にスイングできます。登録するだけです。 自由にダウンロードできない唯一のものはvCenterです。 私はVMware-VCSA-all-6.0.0-3634788.iso

(別名6.0u2

)を使用しますが、 VMware-VCSA-all-6.0.0-3634788.iso

でも成功したスタンドがあります。 また、 vcsa

インストール、ハイパーバイザーの追加、クラスターの作成もスキップします。

なぜvcsa

バージョン6

とesxi

バージョン5.5

を選んだのかを議論する価値があるでしょう。 以前のすべてのvcsa

のWebクライアントvcsa

ほぼ完全にflash

記述されています。 , vmware, npapi

, chrome

2015. vmware vsphere client

, , -. vcsa

, .

esxi

, 5.1

, iscsi

host profile

. , , , . , vds

5.5 , . , cisco nexus 1000v

. esxi

6.0

: ucs-bxxx-drivers-vmware.2.2.6c.iso/VM-FEX/Cisco/VIC/ESXi_6.0/README.html

: Not supported

.

. vds

, vcsa

. : vds

. . vds

. vcsa

5.5

:

vcsa

6.0

:

, , :

. supportforums.cisco.com

, communities.vmware.com

- vmware employees

, , - . vcsa

5.5

npapi

chrome

, . , vds

, ucsm

, - - .

vds

vmware vsphere client

. , — , . esxi

vds

host profile

. , esxi

vds

— sdk, , , .

, DirectPath I/O

vds

, ucsm

. esxi

vds

. , . esxi

vSwitch

, vcsa

, esxi

, vds

5.5.

DirectPath I/O

. , — , ucs-vds

, — vmxnet3

, reserve all guest memory

. . DirectPath I/O

Active

. ucsm

:

bond. james bond. ?

, 14 /. , irqbalance

:

top - 13:35:03 up 9 days, 17:41, 2 users, load average: 0.00, 0.00, 0.00 Tasks: 336 total, 1 running, 334 sleeping, 0 stopped, 1 zombie Cpu0 : 1.4%us, 8.5%sy, 0.0%ni, 90.2%id, 0.0%wa, 0.0%hi, 0.0%si, 0.0%st Cpu1 : 1.0%us, 7.8%sy, 0.0%ni, 91.2%id, 0.0%wa, 0.0%hi, 0.0%si, 0.0%st Cpu2 : 1.4%us, 4.4%sy, 0.0%ni, 94.2%id, 0.0%wa, 0.0%hi, 0.0%si, 0.0%st Cpu3 : 1.3%us, 8.1%sy, 0.0%ni, 90.6%id, 0.0%wa, 0.0%hi, 0.0%si, 0.0%st Cpu4 : 2.5%us, 9.3%sy, 0.0%ni, 81.4%id, 0.0%wa, 0.0%hi, 6.8%si, 0.0%st Cpu5 : 1.8%us, 9.5%sy, 0.0%ni, 83.6%id, 0.0%wa, 0.0%hi, 5.1%si, 0.0%st Cpu6 : 1.8%us, 6.6%sy, 0.0%ni, 86.3%id, 0.0%wa, 0.0%hi, 5.2%si, 0.0%st Cpu7 : 2.6%us, 8.8%sy, 0.0%ni, 83.9%id, 0.0%wa, 0.0%hi, 4.7%si, 0.0%st Cpu8 : 2.9%us, 8.3%sy, 0.0%ni, 83.3%id, 0.0%wa, 0.0%hi, 5.4%si, 0.0%st Cpu9 : 1.0%us, 8.0%sy, 0.0%ni, 91.0%id, 0.0%wa, 0.0%hi, 0.0%si, 0.0%st Cpu10 : 1.3%us, 8.9%sy, 0.0%ni, 89.4%id, 0.0%wa, 0.0%hi, 0.3%si, 0.0%st Cpu11 : 1.3%us, 9.3%sy, 0.0%ni, 89.4%id, 0.0%wa, 0.0%hi, 0.0%si, 0.0%st Cpu12 : 0.7%us, 3.1%sy, 0.0%ni, 96.2%id, 0.0%wa, 0.0%hi, 0.0%si, 0.0%st Cpu13 : 1.1%us, 5.3%sy, 0.0%ni, 88.0%id, 0.0%wa, 0.0%hi, 5.6%si, 0.0%st Cpu14 : 2.9%us, 8.7%sy, 0.0%ni, 81.9%id, 0.0%wa, 0.0%hi, 6.5%si, 0.0%st Cpu15 : 1.8%us, 9.0%sy, 0.0%ni, 82.4%id, 0.0%wa, 0.0%hi, 6.8%si, 0.0%st Mem: 8059572k total, 3767200k used, 4292372k free, 141128k buffers Swap: 4194300k total, 0k used, 4194300k free, 321080k cached

- , . , . . ucs

( ) . ecmp

? , . Cisco UCS

. port-channel . , — 80 /.