まず、独自のニューラルネットワークライブラリがあることを明確にする必要があります。 もちろん、それほど広大で野心的なものではありませんが、ワープロの特定のタスクを解決するように設計されています。 かつて、既製のソリューションを使用する代わりに、独自のソリューションを作成することにしました。 クロスプラットフォーム、コンパクトさ、残りのコードへの統合の容易さ、さまざまなサードパーティの作者からの一般的に不要なツールへの多数の依存関係を持つ美的不本意など、さまざまな理由で。 その結果、便利なF#で記述されたツールが作成され、約2MBのスペースを取り、必要な処理を実行しました。 一方で、速度の面ではかなり遅く、GPUコンピューティングをサポートせず、機能がトリミングされており、現代の現実への準拠に疑問が残ります。

問題は、ホイールを再発明するか、すぐに使用できるようにするか、一般的には永遠です。 そして、疑いのワームは、自分自身の手段を維持することは不当なものであり、リソースを消費し、可能性を制限していることを常にかじりました。 定期的な悪化により、すべての普通の人がそうであるように、たとえば、TheanoやTorchを使用するようにアイデアが変わりました。 しかし、手は届きませんでした。 そして、TensorFlowのリリースにより、もう1つの追加の動機が生じました。

この文脈で、私はこのシステムに対処し始めました。

インストールプロセスに関する短いメモ

TensorFlowは、おそらく他の多くの最新のニューラルネットワークライブラリよりも簡単にインストールできます。 運がよければ、問題はLinuxターミナルラインに入力された1行に制限される場合があります。 はい、Windowsは伝統的にサポートされていませんが、そのような些細なことは確かに本当の開発者を止めません。

Ubuntu 11では、TensorFlowはインストールを拒否しました。 しかし、04/14へのアップグレードとタンバリンとのダンスの後、何かがまだ機能していました。 少なくとも、入門セクションからコードフラグメントを実行することは可能でした。 したがって、特に新しいディストリビューションがあり、Python 2バージョンが2.7.9以上である場合、TensorFlowのインストールは簡単で難しくないことを安全に記述できます。 Linuxの場合、複雑なソフトウェアパッケージがすぐにインストールされない場合、これは正常です(たぶん、正常ではないかもしれませんが、これは正常な状況であり、よく起こります)。

作業の検証。

ここで私は次のことを言わなければなりません。 次のすべては、かなり狭い領域で個人的な好奇心を満たすために作成された、個人的な経験からの個人的な例と見なされる必要があります。 著者は、調査結果が世界的に重要であるとか、一般的には価値があるとかふりをしません。 結果の欠点についての議論は、TensorFlowシステム自体(基本的には完全に機能し、最も重要なのは迅速に機能する)に起因するものではなく、特定のモデルとトレーニング例に起因するものです。

チャットボット

将来のために設定されたMNISTから数字を認識することについての入門レッスンを終了し、すぐにシーケンスからシーケンスへの学習に関するセクションを開きました。 危険にさらされているものを明確にするために、問題の本質をもう少し詳しく説明します。

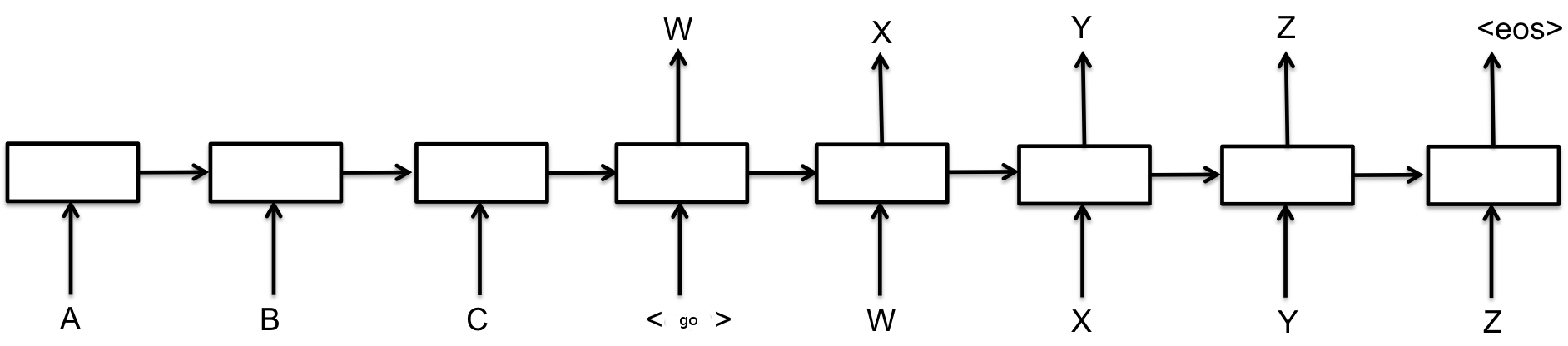

シーケンスからシーケンスへの学習の一般的なタスクは、文字の入力シーケンスに基づいて新しい文字シーケンスを生成することです。 特定のケースでは、シンボルは単語です。 このタスクの最も有名なアプリケーションは、おそらく機械翻訳です。ある言語の文がモデルの入力に送信され、出力で別の言語への翻訳が取得される場合です。 入門レッスンの図に示すように、このようなモデルには2つの主要なクラスがあります。 1つ目はエンコーダーデコーダーオプションを使用します。 元のシーケンスはニューラルネットワークを使用して固定長表現にエンコードされ、2番目のニューラルネットワークはこの表現を新しいシーケンスにデコードします(図1)[1]。 人がテキストを与えられ、記憶するように求められ、次に選択して別の言語への翻訳を書くように求められたようなものです。 2番目のクラスは、デコーダーが操作中に元のシーケンスに「スパイ」できる場合、選択的注意のモデルを使用します(図2)[2]。

図1.ニューラルシーケンスインモデルをトレーニングするための基本モデル。 左側(文字の前)に初期シーケンス、右側に-生成されたシーケンス。 tensorflow.orgからの画像

図2.ニューラルシーケンスインモデルをトレーニングするための基本モデル。 tensorflow.orgからの画像

チャットボットは、シーケンスインシーケンス学習タスクの特別なケースです(入力での質問、出力での回答)。 前に、 このメソッドを使用したチャットボットの実装について書きました。 少し後に、Google社員による記事[3]が同じトピックに登場しましたが、図に示すものと同様のより高度な(考えたとおりの)モデルを使用しました。 1。

GoogleのモデルはLSTMセルを使用していますが、私は通常のリカレントネットワークを使用してチャットボットを構築し、最適な作業のために1つの変更のみをねじ込みました。 記事[3]に示されているダイアログは、私が手に入れることができたものよりも印象的で興味深いように見えます(さらに、ユーザーサポートサービスのダイアログでトレーニングされたチャットボットが有意義なヘルプを提供できるという事実について話します)。 しかし、Googleのチャットボットは、以前のサンプルよりもはるかに多くのデータのコレクションでトレーニングされています。

機械翻訳を目的としたTensorFlowスイートの標準例を修正したので、チャットボットのトレーニングに使用するダイアログのコレクションからデータをダウンロードしました(Googleチャットボットがトレーニングされた数十万の場合とは対照的に、3000の例しかありません)。 Googleのレッスンでは、[2]からのモデルと選択的ソフトマックス[4]が例で実装されている、つまり、この分野の最新の結果がすべて実際に適用されると述べられています。

私のチャットボットは、前述のとおり、畳み込みネットワークをエンコーダーとして使用し(サイズが2ワードと3ワードの16個のフィルターを備えた1つのレイヤー+最大ユニオンレイヤー)、デコーダーは単純なElmanリカレントネットワークを使用します。 他の研究者によると、どちらもどちらもシーケンスからシーケンスへの学習タスクでそれ自体をうまく示していません。 そのため、システムに1つの変更が適用され、1年以上前に別のタスク(レビューの生成)のために発明しました。 1つの畳み込みネットワーク(エンコーダー)の代わりに、2つの畳み込みネットワークが使用されます。1つはソーステキストのエンコード用で、もう1つは生成されたばかりの新しいもののエンコード用です。 ユニオンの最後のレイヤーの出力は、次のレイヤーでペアで接続されます(つまり、1つのニューロンが最初のネットワークのニューロンから1つの入力を受け取り、2番目のニューロンから1つの入力を受け取ります)。 入力信号に対応する何かが生成されると、この信号は2番目のネットワークによって抑制され、システムは残りのテキストを生成し続けるという考え方でした。 私の知る限り、そのような解決策はどこにも記載されておらず、実装時には明らかに記載されていませんでした。 (チャットボットは1つのエンコーダーよりも優れているとはいえ)悪く見えたように機能し、選択的アテンションメカニズムに関する記事を見たときにそれを放棄しました。

結果は次のとおりです。

図3. TensorFlowスイートのseq2seq.embedding_attention_seq2seqモデルを使用したチャットボットとのダイアログ

チャットボットとのダイアログ、おおよその翻訳:

| TensorFlow Kitのモデル | 私のモデル |

| H:こんにちは(こんにちは)

宛先:こんにちは(こんにちは) H:元気ですか? (元気ですか) K:元気です(素晴らしい) H:どこにいるの? (どこにいますか) K:元気です(元気です) D:何か教えて(何か言って) C:はい(はい) H:わかった、すぐに会いましょう(すぐに会いましょう) K:きれいでいいね H:バイ(バイ) K:バイ(バイ) | H:こんにちは(こんにちは)

K:こんにちは(こんにちは) H:元気ですか? (元気ですか) K:違和感を感じる(違和感を感じる) H:どこにいるの? (どこにいますか) K:私は今家にいます(私は家にいます) D:何か教えて(何か言って) 宛先:世界(世界) H:わかった、すぐに会いましょう(すぐに会いましょう) K:分からない...(分からない) H:バイ(バイ) K:わかった(わかった) |

両方のモデルは機能しますが、残念ながら、大きな改善は得られませんでした。 さらに、私の主観的な意見では、右側の対話はより興味深く、より正確に見えます。 ほとんどの場合、問題はデータの量にあります。 図からのモデル 1.かなりの代表力を持っていますが、意味のある結果を生成し始めるには多くのデータが必要です(前の記事で説明した状況)。 私のチャットボットモデルはそれほど良くないかもしれませんが、データ不足に直面しても意味のある結果を生み出すことができます。 これにより、たとえば、限られたダイアログでさまざまな人々の間のコミュニケーションのモデルを作成できます。 たとえば、3000組のフレーズのセットから、対話者の1人だけのフレーズの回答を取得すると、次のようになります。

図4

私は(再び主観的に)より積極的で友好的なコミュニケーションを感じています。 あなたはどうですか? TensorFlowキットのモデルからは、表に示されている最高のダイアログを達成できませんでしたが、5つの異なる構成のみをチェックしましたが、それを使用した経験のある人がより良い結果を得ることができます。

一連の単語からのフレーズの再構築

単語のセットからのフレーズの再構築は合成タスクであり、顧客の1人が設定した実際のタスクの代わりにここで使用します。 顧客は、タスク自体と独自のデータを使用した例の両方の公開に反対していました。そのため、この記事では、フォームが似ている別のタスクを思いつきました。

フレーズとして、私はユーザークエリを検索エンジンに使用しました。なぜなら、それらは短い意味のあるフレーズの良いソースであり、さらに、十分な量が手元にあったからです。 タスクの本質は次のとおりです。 「注文のために卒業証書を作成する」というリクエストがあり、その台無しバージョンが「卒業証書を作成する」というリクエストがあるとします。 元の意味を保持しながら、破損したバージョンから意味のある要求を再度行う必要があります。 つまり、「ウィンドウを順番に並べる」は誤った結果と見なされます。 甘やかされて育ったバージョンは、単語の再配置、性別、番号、大文字小文字の変更、および4文字より短いすべての単語の削除によって自動的に生成されました。 合計で120,000のトレーニングサンプルがこの方法で作成され、そのうち1,000がテスト用に確保されました。 タスクは機械翻訳の問題よりも簡単に思えますが、同時にそれと共通点があります。

元の問題を解決するには、上記のチャットボットのセクションで説明したアイデアに基づいて特別なモデルを開発する必要がありました。 顧客のニーズに対する品質が不十分だったため、セレクティブソフトマックスのアイデアを思い起こさせる、非常に大きな辞書を操作するツールも追加しました。 ところで、TensorFlowチュートリアルから、4日前に初めてセレクティブソフトマックスについて学びました。 その前に、幸運にも結果については判明していましたが、結果については少し後になって、私は彼についての記事を見ました。 このモデルには、ニューラルネットワークの「ファンタジー」の度合いを制御する手段と、形態を考慮するだけでなく、形態を考慮する問題を回避する手段も装備されています。これに関連する問題があります。 ただし、このソリューションには、選択的な注意の通常のメカニズムがなく、元のシーケンスを表すための基本的なメカニズムがあり、LSTMまたはGRUモジュールは使用しません。 そのため、私の実装における彼の作業の速度は非常に適切です。

結果は次のとおりです。

図5

TensorFlowキットのモデルが行ったことは次のとおりです。 生成された検索クエリは、元のキーワードと関係があり、一般に、ロシア語の規則に従って作成されます。 そして、トラブルの意味を持ちます。 「屋根を切るための乳母」はそれだけの価値があります。 一方、これらの構成で私を喜ばせるのは、言語の原則のモデル理解と創造的なアプローチです。 たとえば、ヘマタイトが「鉄鉱石鉱物Fe2O3」であり、ヘマタイトモニタ用の装置がないことを知らない場合、「ヘマタイトモニタ装置」はもっともらしく、医学的にはどうやら聞こえます。 しかし、実際的な目的では、これは適切ではありません。 テストされた100のテストケースのうち、1つが正しくありませんでした。

私のモデルは次のオプションを作成しました:

図6

ここで、オリジナルは破損したバージョン、生成されたものは生成されたもの、人間は初期検索クエリです。 100の検証済みの例のうち、72%が正しいです。 TensorFlowキットのモデルの改善はうまくいきませんでした。

機能のスピードと幅

これらのパラメーターでは、Googleからのパッケージは確かに私のライブラリを一桁上回っています。 また、最新のすべてのメソッド、LSTMおよびGRU、自動微分を使用した画像解析のための畳み込みネットワークも備えており、一般に、ニューラルネットワークだけでなく、あらゆる種類のモデルを簡単に作成できます。 すべてが非常に直感的に行われ、十分に文書化されています。 もちろん、LinuxまたはMacOがある場合は、特に初心者向けに機械学習を行うことをお勧めします(おそらく、cygwinやmingw、またはその他の方法を使用してソースコードをWindowsでコンパイルできますが、これは公式にはサポートされていません)。

速度に関しては、まだ正確な測定を行っていませんが、CPUのTensorFlowモデルでは、実装の2倍から3倍の速度で、ほぼ同じ数のパラメーターが実行されているように感じます(パフォーマンスの大きな違いが予想されます)。 また、大幅に少ないメモリを消費します。 また、GPUバージョンはCPU実装よりも10倍高速です(これも、これまでのところ、正確な測定なしの一般的な印象です)。 Googleにはコード最適化に携わる多くのリソースとプログラマーがいます(40名の開発者のリストのTensorFlowに関するページで)が、私にはそのような機会はありません-それはうまくいきます。

一方、私のライブラリーはスペースをほとんど占有せず、モノを使用している場合はWindowsおよびLinuxで実行されます。 特定の状況では、これはプラスになる場合があります。

もちろん結果については、細心の注意を払って解釈する必要があります。 これらは特定の特殊なケースに関連しており、さらに、これらはライブラリ全体の特定のモデルの結果であり、その機能ははるかに広くなっています。 したがって、モデルをTensorFlowに転送すると、結果は同じになり、すべてがはるかに高速になります。 この意味で、ニューラルネットワークの正しいアーキテクチャの知識は、特定の技術スタックの知識よりも重要です。

真実は、哲学的な疑問の1つです。 最初にTensorFlowにアクセスした場合、または同様の既製のツールを使用した場合、同じモデルを作成して同じ結果を得ることができますか? システムプログラミングをゼロから行うことは、ニューラルネットワークの基本をより深く理解するのに役立ちますか、それとも余分な時間の無駄ですか? パフォーマンスの制限は、新しいモデルを開発するためのインセンティブですか、それとも迷惑な障害ですか?

おわりに

誰もが自分で結論を出すことをお勧めします。 これらの実験から私の質問に対する明確な回答をまだ受け取っていません。自転車を発明する/しないという問題は残っていますが、情報は非常に有益なようです。

参照資料

1. Sutskever、Ilya、Oriol Vinyals、およびQuoc VV Le。 「ニューラルネットワークを使用したシーケンス学習のシーケンス。」 ニューラル情報処理システムの進歩 。 2014年。

2. Bahdanau、Dzmitry、Chounghyun Cho、およびYoshua Bengio。 「調整と翻訳の共同学習によるニューラル機械翻訳」 ArXiv preprint arXiv:1409.0473 (2014)。

3. Vinyals、Oriol、およびQuoc Le。 「神経会話モデル。」 ArXiv preprint arXiv:1506.05869 (2015)。

4.ジャン、セバスチャン、他 「ニューラル機械翻訳に非常に大きなターゲット語彙を使用することについて」 ArXiv preprint arXiv:1412.2007 (2014)。

PS

この記事に記載されているすべての商標は、それぞれの所有者の財産です。