主な段階:

- ビデオの特定のポイントでカメラを追跡します。

- 3Dモデルの作成と照明のシミュレーション。

- レンダリング

- 合成(画像合成と後処理)、色補正。

これはすべて、無料のオープンBlenderを使用して実行できます。

短いビデオにパッケージ化されたプロセスのデモ:

さらに-各ステージの詳細。

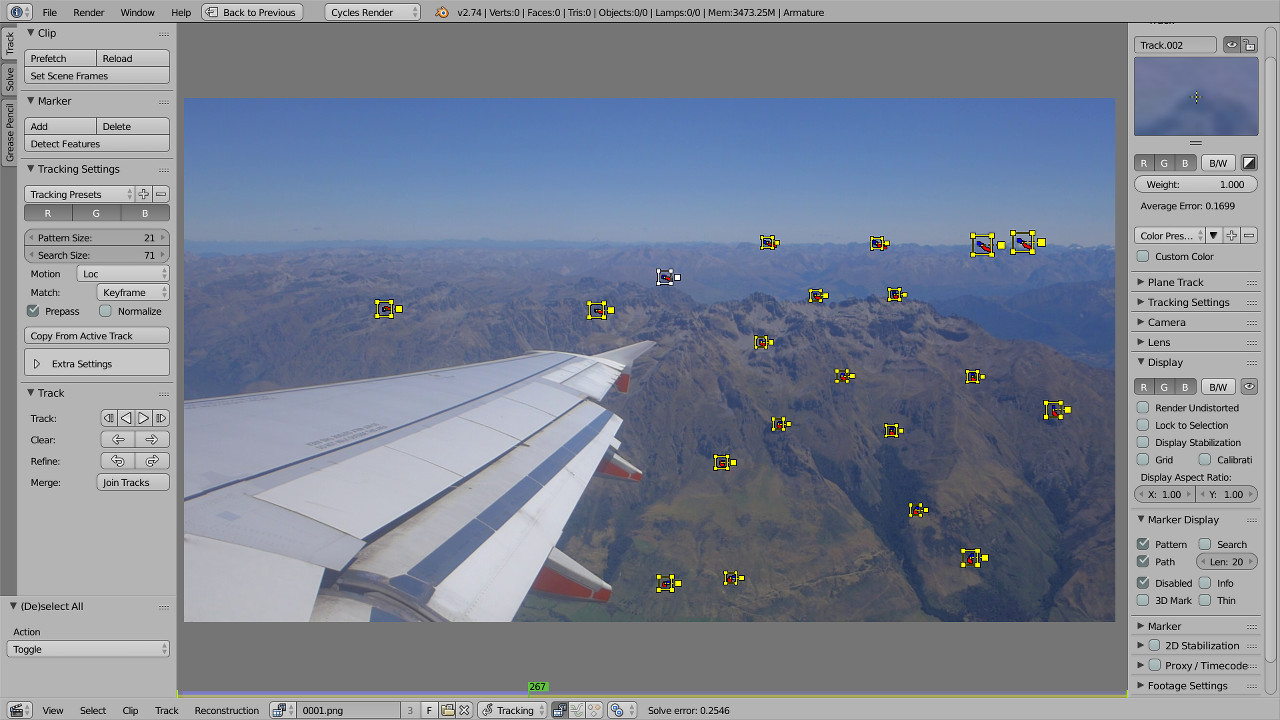

1.カメラ追跡

カメラトラッキングは、3次元空間でのカメラの動きを再現したものです。 これは、マーカーを追跡することによって行われます-手動で選択されたフレームの小さな領域。 理想的には、これらはシャープなコントラストのある領域である必要がありますが、Blenderは非常にぼやけており、あまりコントラストのないマーカーで驚くほどうまく機能します。 多くの場合、自発的に撮影されたビデオでも正常に処理できます。

シーンを正しく再現するには、少なくとも撮影時に使用するおおよその焦点距離を設定する必要もあります。 残念ながら、ビデオファイルにはそのような情報が含まれていないので、写真をほぼ同時に撮影した写真と比較しました。 35mm相当で約37.3mmが出てきました。

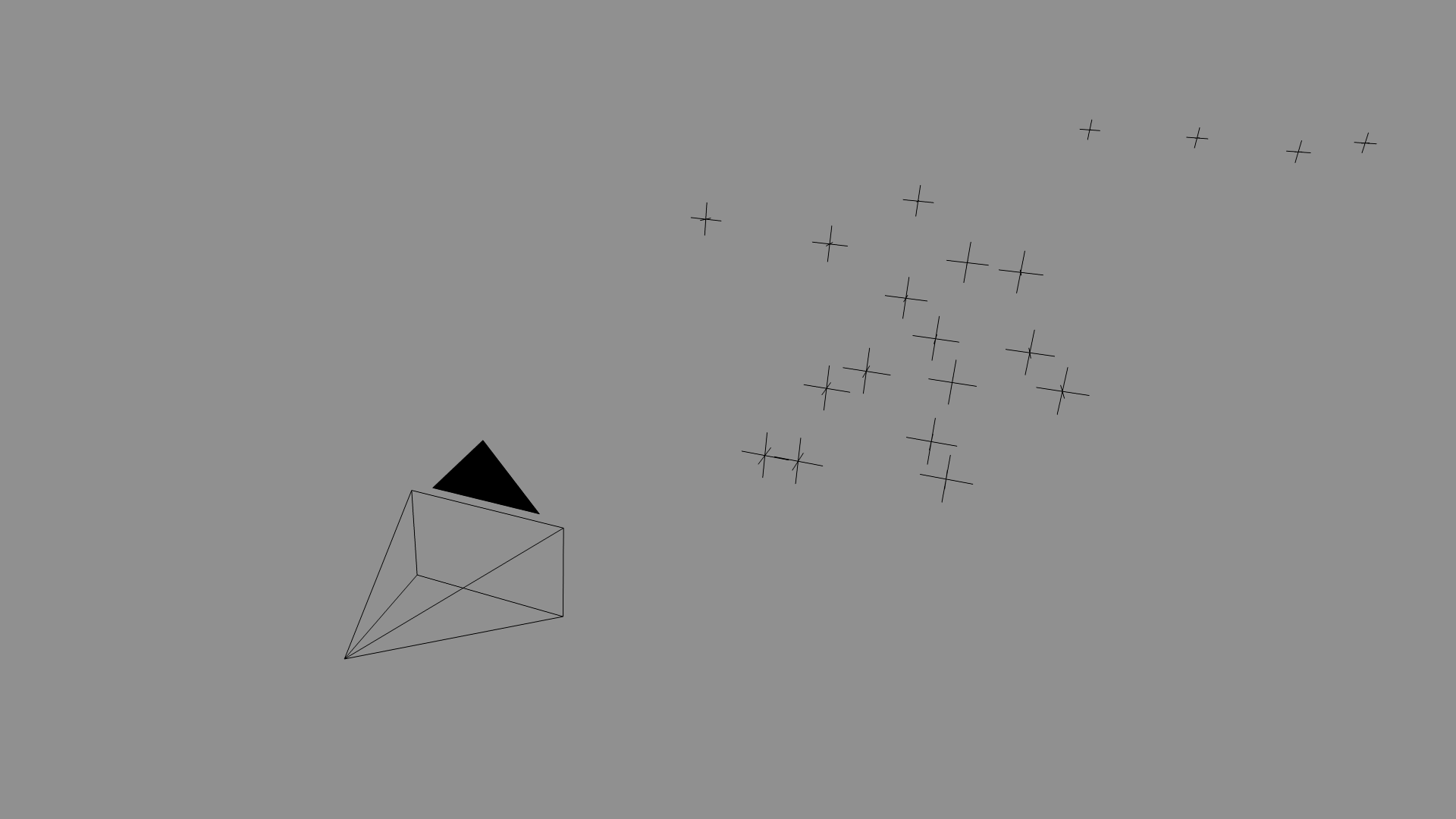

成功:3次元空間でのマークの位置は正しいようで、仮想カメラの動きは、揺れを含めて実際のカメラの動きを繰り返します。

2. 3Dモデルの作成と照明のシミュレーション

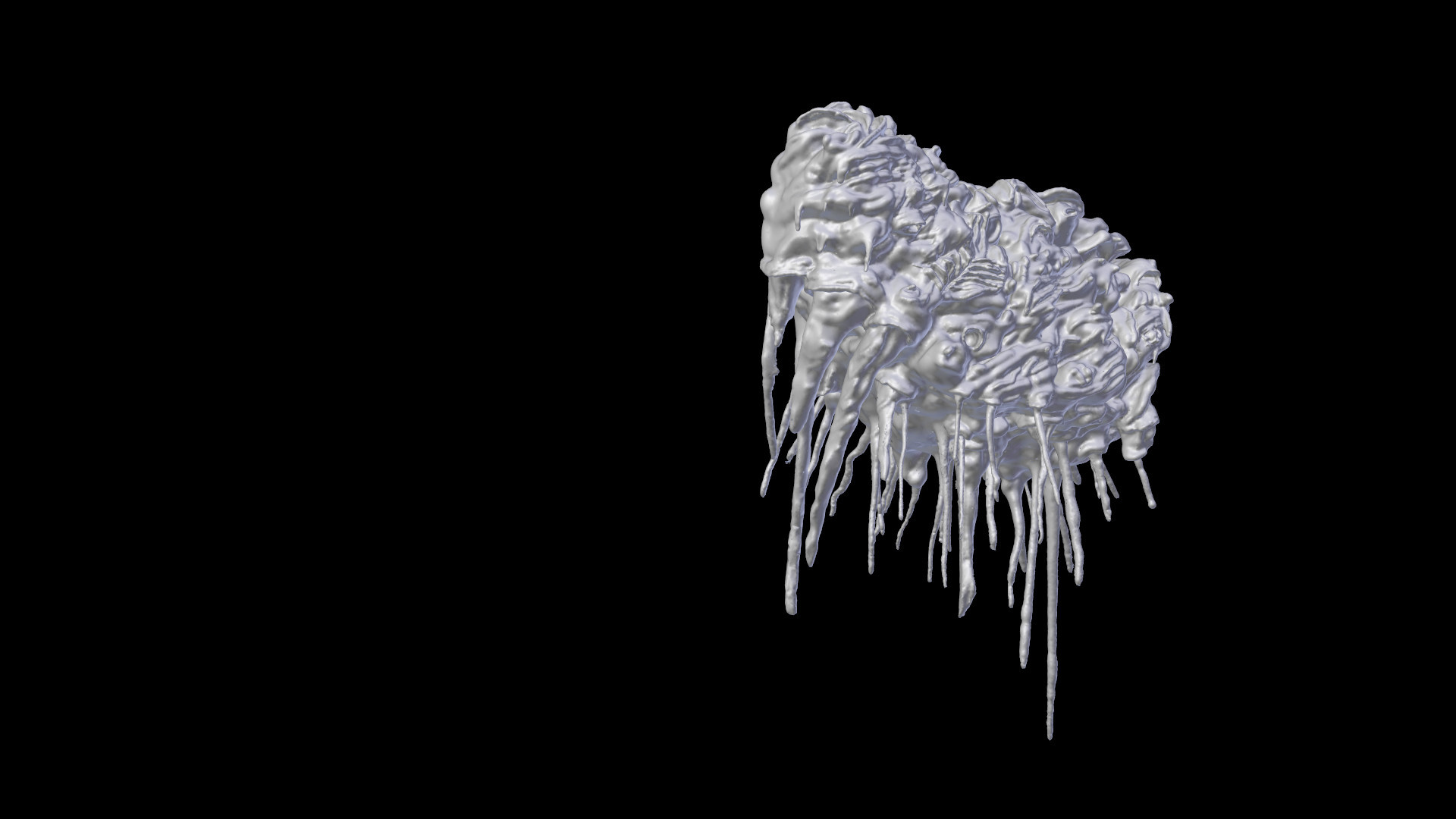

UFOの場合、クローズアップで撮影しない限り、モデルの特別な研究は必要ありません。

モデルは、追跡後に残ったマークにガイドされて、適切な場所に配置する必要があります。

晴れた空の照明では、すべてが簡単です。目的の結果を達成するために、プロシージャルテクスチャ「Sky」とランプ「Sun」のパラメータをひねります。 明るさと色合いを完全に一致させる必要はありません-多くは後処理によって修正できます。

3.レンダリング

GeForce GTX 770ベースのビデオカードを使用して1フレームをレンダリングするのに14〜15秒しかかかりませんでした。 これは非常に高速です。特に、 前回お話しした作品と比較して。 理由は簡単です。フレーム内の最小領域を占めるオープンスペース内の唯一のオブジェクトは、考えられる最も好ましいケースです。

レンダリングされた画像を保存するために、色に関する詳細情報を保存し、その後の処理に最適なOpenEXR形式が使用されました。

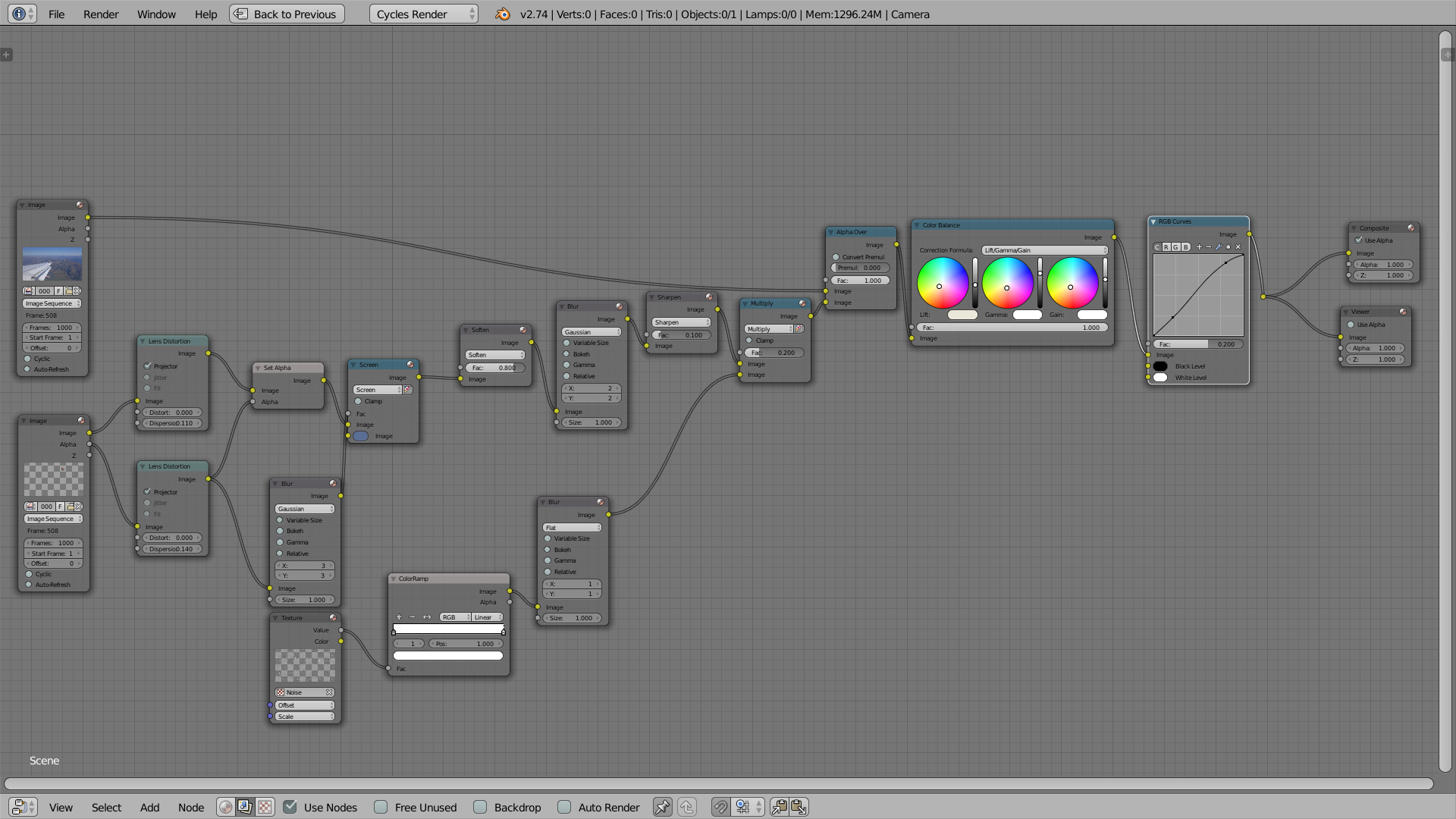

4.合成、色補正

合成とは、構成部分と追加の処理から画像をレイアウトすることです。 レンダリングされた画像をカメラの画像にオーバーレイするだけでは十分ではありません-際立って目立ちます。

まず第一に、細部の鮮明さと識別可能性を一致させる必要があります。同じ解像度であっても、各カメラは独自の方法で撮影します。 レンダリングされた画像は特別にぼかす必要があり、その後、フィルターを使用して人為的にシャープネスを上げる必要があります(カメラがそのぼけたソースで行うように)。 また、 色収差と視覚ノイズの類似性は損なわれません(カメラが優れているほど、これらの効果は弱くなりますが、常に存在します)。 もちろん、空中遠近法を模倣する必要があります(この場合は、目的の色を単純に混ぜる)。

最終的に、カラーバランスをわずかに調整しますが、最終的なビデオはまだカメラの素材のように見えます。

もちろん、この方法でUFOだけでなく、他のさまざまな興味深いものも撮影できます。