そのようなインフラストラクチャのボトルネックを見つけて解消するには、インフラストラクチャのコンポーネントを決定する必要があります。 インフラストラクチャを次のコンポーネントに分割します。

- SANを使用したホスト設定( FC / FCoE )

- IP SAN ( iSCSI )のホストイーサネットネットワーク設定。

- 実際にOSでホストする

- ホスト上のアプリケーション

- ドライバーとソフトウェアのバージョンの互換性を確認する

ボトルネックを検索するには、通常、順次除外手法が実行されます。 最初にストレージから始めることをお勧めします 。 次に、 ストレージを移動します ->ネットワーク( イーサネット / FC)-> ホスト ( Windows / Linux / VMware ESXi 5.XおよびESXi 6.X )->アプリケーション。 それでは、ホストに立ち寄りましょう。

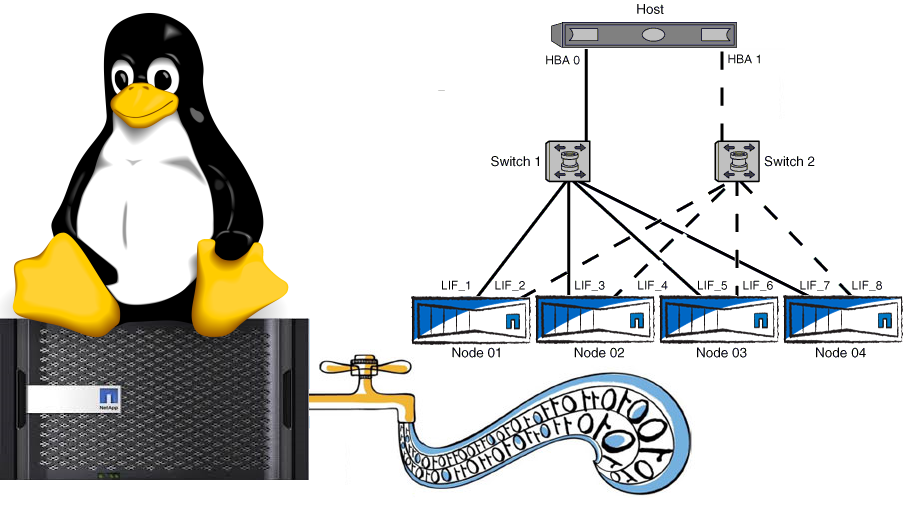

SANマルチパス

仮想化せずにOSに LUNを直接接続する場合は、NetApp Host Utilityをインストールすることをお勧めします。 RDMまたはVMFSで仮想化を使用する場合、ハイパーバイザーでマルチパスを構成する必要があります。

マルチパスでは、デフォルトで優先パスを使用する必要があります。これは、 LUNへのパスであるLUNへのパスです。 FCP Partner Path Misconfigured ストレージコンソールのメッセージは、 不適切に構成された ALUAまたはMPIOを示します 。 これは重要なパラメーターです。激怒したホストマルチパッシングドライバーがパス間でノンストップを切り替え、I / Oシステムに大きなキューを作成する実際のケースが1つあったため、無視しないでください。 SANブートの詳細については、関連記事「 Red Hat Enterprise Linux / Oracle Enterprise Linux 、 Cent OS 、 SUSE Linux Enterprise」を参照してください

NetAppのゾーニングガイドラインの詳細については、写真をご覧ください。

イーサネット

ジャンボフレーム

iSCSIを使用している場合、1Gb以上の速度でイーサネットのジャンボフレームを使用することを強くお勧めします。 詳細については、NetApp FASのイーサネットに関する記事をご覧ください。 Linuxでジャンボフレームを使用する場合、pingの実行が28バイト少なくなる必要があることに注意してください。

ifconfig eth0 mtu 9000 up echo MTU=9000 >> /etc/sysconfig/network-scripts/ifcfg-eth0 #ping for MTU 9000 ping -M do -s 8972 [destinationIP]

フロー制御

サーバーからストレージへのトラフィックを10GBリンクですべてオフにするには、フロー制御が望ましいです。 詳細

ethtool -A eth0 autoneg off ethtool -A eth0 rx off ethtool -A eth0 tx off echo ethtool -A eth0 autoneg off >> /etc/sysconfig/network-scripts/ifcfg-eth0 echo ethtool -A eth0 rx off >> /etc/sysconfig/network-scripts/ifcfg-eth0 echo ethtool -A eth0 tx off >> /etc/sysconfig/network-scripts/ifcfg-eth0

ESXiおよびMTU9000

ESXi環境を使用する場合は、正しいネットワークアダプター(1GBネットワークの場合はE1000、ネットワークが1Gbを超える場合はVMXNET3)を作成することを忘れないでください。 E1000およびVMXNET3はMTU 9000をサポートしますが、標準の「フレキシブル」仮想ネットワークアダプターはサポートしません。

NetApp FASによるVMwareの最適化の詳細をご覧ください。

統合ネットワーク

10 GBEの「普遍性」を考慮して、 FCoE 、 NFS 、 CIFS 、 iSCSIがvPCやLACPなどのテクノロジーの使用、およびイーサネットネットワークのメンテナンスの容易さとともに同じ物理学を通過できる場合、プロトコルとスイッチをFCから区別し、機会を提供します変化するビジネスニーズの場合の「操作」と投資の保存。

FC8 vs 10GBE:iSCSI、CIFS、NFS

NetApp ストレージシステムの内部テスト(他のストレージベンダーでは、この状況は異なる場合があります) FC 8Gおよび10 GBE iSCSI 、 CIFS 、およびNFS は 、 OLTPおよびサーバーおよびデスクトップ仮想化に典型的な、 ほぼ同じパフォーマンスと遅延を示します。 小さなブロックとランダムな読み取りのある負荷の場合。

Ethernet&FCの類似点、相違点、見通しについて説明している記事をよく理解することをお勧めします。

お客様のインフラストラクチャに2つのスイッチが含まれる場合、 SANとイーサネットネットワークの両方をセットアップする同じ複雑さについて話すことができます。 しかし、多くのお客様にとって、 SANネットワークは「全員が全員を見る」2つのSANスイッチにダウンすることはなく、原則として構成はそこで終わりません。この点で、イーサネットメンテナンスははるかに簡単です。 通常、顧客のネットワークのSANは 、冗長リンクとリモートサイトへのリンクを備えた多数のスイッチであり、決して維持するのは簡単ではありません。 また、何か問題が発生した場合、 Wiresharkのトラフィックは「リッスン」されません。

Cisco Nexus 5500などの最新のコンバージドスイッチは、イーサネットとFCの両方のトラフィックを切り替えることができ、ツーインワンソリューションで将来の柔軟性を高めます。

シンプロビジョニング

「ファイル」プロトコルNFSおよびCIFSを使用する場合、ファイル領域内の解放されたスペースを返すことにより、シンプロビジョニングテクノロジーの使用を利用することは非常に簡単です。 ただし、 SANの場合、ThinProvitioningを使用すると、空き領域を常に制御する必要が生じ、さらに空き領域の解放( メカニズムは最新のOSで利用可能 )は同じLUNの 「内部」ではなく、このLUNを含むボリューム内で発生します。 RHEL 6.2 Deployment GuideのNetApp Thin-Provisioned LUNを読むことをお勧めします 。

ESXiホスト

すべてのサーバーリソースをゲストOSに提供する価値はありません。第一に、ハイパーバイザーは少なくとも4GBのRAMを残す必要があり、第二に、ゲストOSにリソースを追加するときに逆の効果が時々観察されます。これは経験的に選択する必要があります。

NetApp FASのESXiホスト設定の詳細。

ゲストOSおよびホストBareMetal Linux

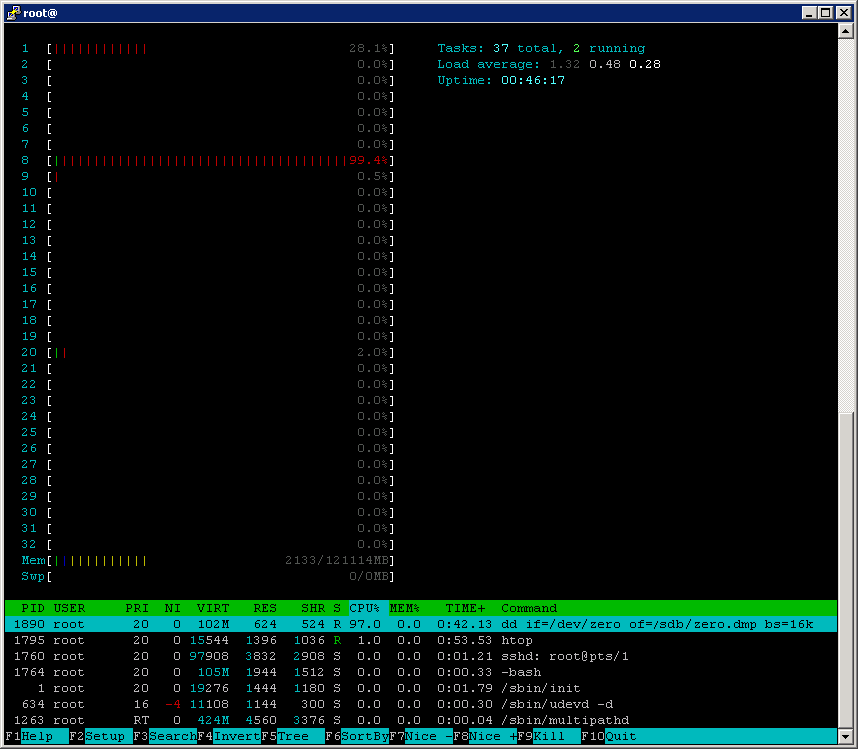

ほとんどのLinuxディストリビューションでは、仮想マシンとBareMetalの両方で 、I / OスケジューリングパラメーターがFASシステムに適さないように設定されているため、 CPU使用率が高くなる可能性があることに注意してください。

topコマンドの出力、 ddプロセスによって引き起こされるCPU使用率が高いことに注意してください。これは一般に、ストレージシステムに負荷をかけるだけです。

ホスト統計収集

Linuxおよびその他のUnixライク :

次に、ホスト側のディスクサブシステムの状態を見てみましょう。

iostat -dx 2 Device: rrqm/s wrqm/sr/sw/s rsec/s wsec/s avgrq-sz avgqu-sz await svctm %util sdb 0.00 0.00 0.00 454.00 0.00 464896.00 1024.00 67.42 150.26 2.20 100.00

await = 150.26 msの高い値に注意してください。 これらの2つの間接的な兆候であるCPU使用率の高さとレイテンシーの高さは、対話のためにOSとストレージをより最適に構成する必要があることを示しています。 たとえば、マルチパスの妥当性、ALUA、優先パス、HBAのキューなどを確認する価値があります。

iostatの解釈

詳細はこちら 。

| イオスタット | Windowsアナログ |

|---|---|

| rrqm / s(1秒あたりにキューに入れられたマージされた読み取り要求の数。)1秒あたりの読み取りI / O | LogicalDisk(*)\ Disk Transfers / sec = rrqm / s + wrqm / s。、Linuxマシンの場合はrrqm / s列を追加し、LogicalDisk(*)\ Disk Transfers / sec skip |

| Wrqm / s(マージされた書き込み要求の数、1秒あたりのキュー)。1秒あたりの書き込みI / O | LogicalDisk(*)\ Disk Transfers / sec = rrqm / s + wrqm / s。、Linuxマシンの場合、列wrqm / sを追加し、LogicalDisk(*)\ Disk Transfers / sec skip |

| R / s(1秒あたりにデバイスに送信された読み取り要求の数。) | ディスク、読み取り/秒 |

| W / s(1秒あたりにデバイスに送信された書き込み要求の数。) | ディスク、書き込み/秒 |

| Rsec / s(1秒あたりの読み取りセクター数。)セクターのサイズ(通常は512バイト)を知る必要があります。 | Rsec / s * 512 =、「\ LogicalDisk(*)\ディスク、読み取りバイト/秒」、 |

| Wsec / s(1秒あたりに書き込まれるセクターの数。)セクターのサイズ、通常は512バイトを知る必要があります。 | wsec / s * 512 =、 "\ LogicalDisk(*)\ Disk Write Bytes / sec"、 |

| Avgrq-sz(セクター単位の要求サイズ。)セクターのサイズ(通常は512バイト)を知る必要があります。 | avgrq-sz-操作されたブロックの平均サイズ-が必要です。 列を追加します; Windowsでは、他のパラメーターから計算されます。 |

| Avgqu-sz(デバイスのキューで待機しているリクエストの数。) | 「\ LogicalDisk(*)\平均、ディスクキューの長さ」。 読み取りと書き込みで別々にノーになりますが、それで十分です。 レコード読み取り率は、「rrqm / s」と「wrqm / s」または「r / s」と「w / s」で計算されます。つまり、Linuxの場合、skip :, LogicalDisk(*)\ Avg。、Disk読み取りキューの長さ、LogicalDisk(_Total)\平均、ディスク書き込みキューの長さ。 |

| 待機(応答に必要なミリ秒数、要求) | 平均、待ち時間、Windowsではこの値は提供されず、他のパラメーターから計算され、列を追加し、パラメーターが必要になります。 |

| Svctm(最初から最後までサービス、リクエストに費やしたミリ秒数) | リクエストの完了にかかった時間。 Linuxマシンに便利な別の列を追加します |

| %Util(リクエストが発行されたCPU時間の割合) | 「\ Processor(_total)\%、Processor Time」、CPUにロード(列を追加)させ、それからディスクサブシステムのオーバーロードが間接的に理解されます。 |

Linuxエレベーター

エレベーター/スケジューラーの値について:

デフォルトでは、 cfqまたはdeadlineに設定されています:

cat /sys/block/sda/queue/scheduler noop anticipatory deadline [cfq]

noopに設定することをお勧めします 。

echo noop > /sys/block/sda/queue/scheduler cd /sys/block/sda/queue grep .* * scheduler:[noop] deadline cfq

設定を永続的にするには、「 エレベーター= noop 」を/etc/grub.confファイルのカーネルブートパラメーターに追加すると、すべてのブロックデバイスに適用されます。 または、適切なスクリプトを/etc/rc.localに追加して、個々のブロックデバイスの設定を柔軟に設定します。

スケジューラをsdbのnoopにインストールするためのサンプルスクリプト

sdbをブロックデバイスの名前に変更することを忘れないでください

cat /etc/rc.local | grep -iv "^exit" > /tmp/temp echo -e "echo noop > /sys/block/sdb/queue/scheduler\nexit 0" >> /tmp/temp cat /tmp/temp > /etc/rc.local; rm /tmp/temp

仮想メモリを使用したSysctl設定

OSの仮想メモリの最も最適な値であるsysctlパラメーターを選択する価値があります: vm.dirty_background_ratio 、 vm.dirty_ratioおよびvm.swappiness 。

sysctl値の確認

sysctl -a | grep dirty vm.dirty_background_bytes = 0 vm.dirty_background_ratio = 10 vm.dirty_bytes = 0 vm.dirty_expire_centisecs = 3000 vm.dirty_ratio = 20 vm.dirty_writeback_centisecs = 500 sysctl -a | grep swappiness vm.swappiness = 60

そのため、ある顧客は、 SSDキャッシュとFC 8G接続を備えたNetApp ストレージを備えたRedHat Enterprice Linux 6の最適な値を持っています: vm.dirty_ratio = 2およびvm.dirty_background_ratio = 1 。 Linux Host ValidatorおよびConfiguratorユーティリティを使用して、最適なLinuxホスト設定を確認します。 Linux(または他のUnix系) OSで SnapDriveユーティリティをテストする場合は、Unix用のSnapDrive構成チェッカーを使用します。 最適なパラメータの選択について詳しく読むvm.dirty *ここをクリックしてください 。 Oracle データベースまたは仮想化を使用している場合、そのようなLinuxマシン内でvm.swappiness = 0を設定することをお勧めします。 この値は、物理メモリが実際になくなったときにのみスワップを使用できるようにします。これは、このようなタスクに最適です 。

sysctl値を設定する

sysctl -w vm.dirty_background_ratio=1 sysctl -w vm.dirty_ratio=2 echo vm.dirty_background_ratio=1 >> /etc/sysctl.conf echo vm.dirty_ratio=2 >> /etc/sysctl.conf #for Guest VMs or Oracle DB sysctl -w vm.swappiness=0 echo vm.swappiness=0 >> /etc/sysctl.conf #Reload data from /etc/sysctl.conf sudo sysctl –p

HBAのI / OキューサイズまたはI / Oキュー長

デフォルト値は通常128であり 、手動で選択する必要があります。 キューの長さを増やすことは、ディスクサブシステムで多くのディスクシーク操作を生成するランダムI / O操作に意味があります。 次のように変更します。

echo 100000 > /sys/block/[DEVICE]/queue/nr_requests

InnoDBの場合(書き込み前にデータを最適化するこのアプリケーションの機能により)、またはSSDディスクで作業しているときにパラメーターがデフォルトよりも大きくなった場合など、 このパラメーターを変更しても結果が得られない場合がありますディスクシーク操作)。

ゲストOS

場合によっては、 VMFSはRDMよりも優れたパフォーマンスを示します。 したがって、 FC 4Gを使用した一部のテストでは、 VMFSを使用すると300 MByte /秒、 RDMを使用すると約200 MByte /秒を取得できます。

ファイルシステム

FSは、パフォーマンスをテストするときに大幅な調整を行うことができます。

FSブロックサイズは4KBの倍数である必要があります。 たとえば、生成されたOLTPに似た合成負荷を実行し、操作されるユニットのサイズが平均8Kである場合、8Kを設定します。 また、 FS自体として、特定のOSおよびバージョンへの実装が全体的なパフォーマンス状況に大きく影響する可能性があるという事実にも注意を喚起したいと思います。 したがって、 データベースからddファイルコマンドを使用して100 MBのブロックで10 MBをLUNにあるUFS FSに書き込むと、 FC 4G経由でFAS 2240 ストレージと21 + 2 SAS 600 10kディスクを1ユニットで転送すると、速度は150 MB / s FS ZFSを使用した同じ構成では、2倍(ネットワークチャネルの理論上の最大値に近づく)が示され、Noatimeパラメーターは状況にまったく影響しませんでした。

ホストのノアタイム

ファイルシステムレベルでは、 noatimeおよびnodiratimeをマウントするときにパラメーターを構成できます。これにより、ファイルへのアクセス時間を更新できなくなり、パフォーマンスに非常に良い影響を与えることがよくあります。 UFS、EXT3などのFSの場合。顧客の1人の場合、ext3ファイルシステムをRed Hat Enterprise Linux 6にマウントするときにnoatimeをインストールすると、ホストCPUの負荷が大幅に削減されました。

ローディングテーブル

Linuxマシンの場合、 LUNを作成するとき、ディスクジオメトリを選択する必要があります 。Dom0を搭載したLinux LVMがこの月にインストールされている場合、「 linux 」(xenなしのマシン)または「 xen 」

ずれ

どのOSでも、 LUNを作成するとき、ストレージ設定で正しいジオメトリを選択する必要があります。 FSブロックサイズが誤って指定されている場合、 LUNジオメトリが誤って指定されている場合、ホストでMBR / GPTパラメーターが正しく選択されていません。ピーク負荷時に、特定の「 LUNミスアライメント」イベントに関するNetApp FASコンソールのメッセージを確認します これらのメッセージは誤って表示される場合がありますが、まれにしか表示されない場合は、単に無視してください。 これを確認するには、ストレージシステムでlun statsコマンドを実行します 。

NetAppホストユーティリティ

この項目を無視しないでください。 一連のユーティリティにより、正しい遅延、 HBAの キューサイズ 、およびホスト上のその他の設定が設定されます。 ドライバをインストールした後 、ホストユーティリティをインストールします。 接続されたLUNとその詳細情報をストレージ側から表示します 。 ユーティリティのセットは無料で、netapテクニカルサポートサイトからダウンロードできます。 インストール後、ユーティリティを実行します

host_config <-setup> <-protocol fcp|iscsi|mixed> <-multipath mpxio|dmp|non> [-noalua]

彼女は

/ opt / netapp / santools /

その後、ほとんどの場合、ホストを再起動する必要があります。

NetApp Linuxフォーラム

https://linux.netapp.com/forumで詳細を検索し、質問することを忘れないでください 。

用途

構成、プロトコル、ワークロード、インフラストラクチャに応じて、アプリケーションにはさまざまなチューニングの推奨事項と微調整があります。 これを行うには、構成に適したアプリケーションのベストプラクティスガイドを申請してください。 最も一般的なものは

- NetApp SnapManager for Oracle&SANネットワーク

- Clustered ONTAP上のOracle DB 、Oracleデータベース 用のNetApp 、 NetAppストレージ上のOracleデータベースのベストプラクティス 、 SnapManager for Oracle

- Oracle VM

- DB2 、 DB2、およびFlexClone 、 IBM DB2マルチパーティションデータベースの展開

- MySQL

- NetAppとMySQLを搭載したWeb 2.0 / LAMPアプリケーションのインフラストラクチャ

- Red Hat Enterprise Linux 6、KVM

- Linux用のLotus Domino 8.5

- Citrix XenServer

- NetApp Clustered Data ONTAPでのRed Hat Enterprise Linux OpenStack Platform 4のデプロイ

- その他

ドライバー

NetApp Host Utilityをインストールする前に、 HBAアダプターのドライバーをインストールする(カーネル用にドライバーをビルドする)ことを忘れないでください。 HBAアダプターの構成に関する推奨事項に従ってください。 多くの場合、NetAppとの最適な対話のためにキューの長さとタイムアウトを変更する必要があります。 VMware ESXiまたは別の仮想化を使用している場合、仮想マシン内で仮想HBAアダプターを転送する必要がある場合は、 NPIVを有効にすることを忘れないでください。 Qlogic HBA 8100シリーズなど、一部のNPIVベースのアダプターはQoSを使用して構成できます。

適合性

データセンターインフラストラクチャの潜在的な問題を軽減するために、実際に互換性マトリックスを広く適用してください。

Linuxホストの最適化に関するこの記事に何か追加するものがあると確信しているので、随時ここに戻って確認してください。

テキストのエラーに関するメッセージをLANに送ってください。

反対にコメントと追加はコメントしてください