Hadoopの基本

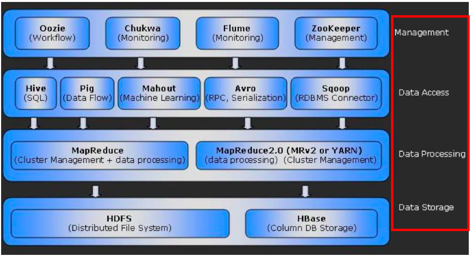

Hadoopの動作を理解するには、2つの主要コンポーネントであるHDFS(Hadoop File System)とMapReduceの機能を理解する必要があります。これらについては、この記事で詳しく説明します。 他の可能なシステムコンポーネントを図1に示します。

図1. Hadoopエコシステム

HDFSは、データストレージを提供するクラスター全体に分散されたグローバルファイルシステムです。 ファイルは、通常64、128、または512 MBの大きなブロックに分割され、その後クラスターの異なるノードに書き込まれます。 したがって、HDFSは任意のサイズのファイルをホストでき、1台のサーバーのストレージ容量を超えます。 記録された各ブロックは、少なくとも2回他のノードに複製されます。 一方では、複製は耐障害性を提供します。 一方、ネットワークインフラストラクチャに負荷をかけずにローカルデータを処理する可能性。 標準の複製率のクラスターディスク領域は、保存する情報の3倍の大きさである必要があります。 また、処理中に発生する中間データを保存するには、HDFSの外部に25〜30%追加する必要があります。 つまり、1 TBの「有用な情報」には4 TBの「生のスペース」が必要です。

MapReduceは、Hadoopクラスターのノード間でデータ処理タスクを分散するためのシステムです。 奇妙なことに、このプロセスはMapとReduceの 2つのステージで構成されています。 マップは多くのノードで同時に実行され、Reduceで処理された中間情報を提供して最終結果を提供します。

何が起きているかをよりよく理解するのに役立つ簡単な例を示します。 新聞の単語の繰り返し回数を計算する必要があると想像してください。 各単語を書き留めて、テキストに再び表示されるときにチェックマークを付けます。 特に迷子になり、最初からやり直さなければならない場合、このプロセスには多くの時間がかかります。 新聞を小さな部分に分割し、カウントを実行するリクエストを送信して友人や知人に配布する方がはるかに簡単です。 したがって、タスクは分散され、それぞれが中間結果を提供します。 データは既に事前にソートされているため、タスクは非常に簡単になります-受信した情報を要約します。 Hadoopの用語では、友達がマップステージを完了し、Reduceを完了します。 ところで、中間データはシャッフルと呼ばれ、新聞の断片はチャンクと呼ばれます。

最適なオプションは、マッププロセスがローカルディスク上の情報を処理する場合です。 ノードの使用率が高いためにこれが不可能な場合、タスクは別のノードに転送され、最初にデータがコピーされるため、ネットワークの負荷が増加します。 情報のコピーが1つだけがHDFSに保存されている場合、リモート処理のケースが頻繁に発生します。 デフォルトでは、HDFSは異なるノード上にデータの3つのコピーを作成します。これは、フォールトトレランスとローカルコンピューティングの良い要因です。

ノードにはSlaveNodesとMasterNodesの 2つのタイプがあります。 SlaveNodeノードは、情報を直接記録および処理し、 DataNodeおよびTaskTrackerデーモンを開始します 。 MasterNodeはマネージャーとして機能し、ファイルシステムメタデータを保存し、HDFS( NameNode )にブロック割り当てを提供し、 Job Trackerデーモンを使用してMapReduceを調整します。 各デーモンは、独自のJava仮想マシン(JVM)で実行されます。

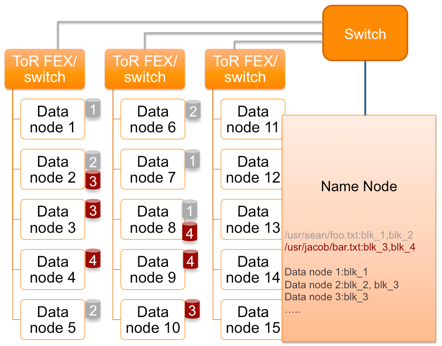

2つのブロックに分割されたHDFSファイルへの書き込みプロセスを検討します(図2)。 クライアントは、これらのブロックを配置するDataNode(DN)のNameNode(NN)を呼び出します。 NameNodeは、DN1にBlock1を配置するよう指示します。 さらに、NameNodeは、Block1をDN2に複製し、DN2をDN6に複製するようにDN1に指示します。 同様に、Block2はノードDN2、DN5、およびDN6に配置されます。 各DNは、利用可能なブロックに関するNNレポートを数秒の頻度で送信します。 レポートが到着しない場合、DNは失われたと見なされます。つまり、レプリカごとの特定のブロックが少なくなります。 NNは他のDNで回復を開始します。 しばらくして欠落したDNが再び表示される場合、NNはデータの余分なコピーが削除されるDNを選択します。

図2. HDFSでの記録プロセス

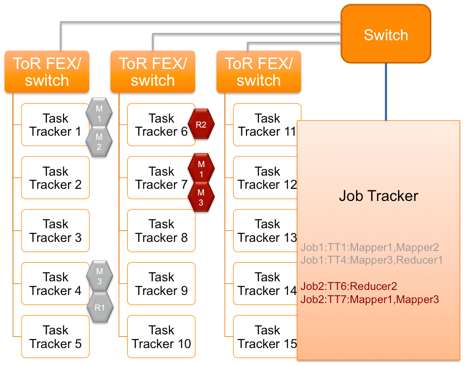

NameNodeは、分散データ処理を管理するJobTrackerデーモンと同じくらい重要です。 クラスター全体でプログラムを実行する場合は、JobTrackerデーモンを使用してMasterNodeに送信されます。 JobTrackerは、どのデータブロックが必要かを判断し、Mapステージをローカルで実行できるノードを選択します。 さらに、Reduceのノードが選択されます。 SlaveNode側では、JobTrackerとの対話プロセスはTaskTrackerデーモンによって実行されます。 JobTrackerにタスクのステータスを伝えます。 エラーまたは実行時間が長すぎるためにタスクが完了しない場合、JobTrackerはそれを別のノードに転送します。 ノードによるタスクの頻繁な失敗は、ブラックリストに登録されるという事実につながります。

図3. MapReduceデータ処理

したがって、ネットワークインフラストラクチャの場合、Hadoopクラスターはいくつかの種類のトラフィックを生成します。

-ハートビート-マスターノードとスレーブノード間のサービス情報。ノードの可用性、タスク実行ステータス、ブロックの複製や削除などのコマンドの送信を決定します。ネットワーク上のハートビートの負荷は最小限であり、これらのパケットは失われないためクラスターの安定性は異なります。

-シャッフル-Reduceの3月のステージを完了した後に転送されるデータ。 トラフィックの性質-多から1まで、ネットワークの平均負荷を生成します。

-HDFSでの記録-大きなブロックでの大量のデータの記録と複製。 ネットワーク負荷が高い。

Hadoopのインフラストラクチャ構築の機能

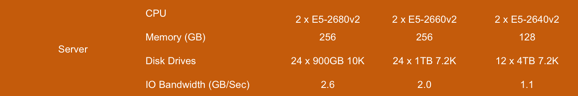

Hadoopで使用されるコンピューティングリソースがどのように進化するかを観察するのは興味深いことです。 2009年の典型的なリソースバランスノードの構成は、4つのハードドライブ、デュアルコアプロセッサ、24ギガバイトのRAMがギガビットイーサネットネットワークに接続されたシングルユニットデュアルソケットサーバーでした。 5年で何が変わったのですか? 4世代のプロセッサが変更されました-より強力になり、より多くのコアとメモリをサポートし、データセンターでは10ギガバイトのネットワークが広く使用されています。 そして、ハードドライブのみが変更されていません。 利用可能なプロセッサとメモリを最適に利用するために、最新のクラスターは、多数のディスクを配置できるデュアルユニットサーバーに基づいて構築されています。 次に、ファイルサブシステムで可能な操作の数によって、ネットワーク帯域幅におけるノードのニーズが決まります。 図4はさまざまな構成のサーバーのデータを示しています。これは、ノードが潜在的に1 Gb / s以上を処理できるため、システムを構築する場合は高速10 GbEに焦点を当てることが望ましいことを意味します。

図4.ハードドライブの数に応じたI / Oサブシステムのパフォーマンス

ローカルストレージ容量の要件は、ローカルドライブをインストールする機能が非常に制限されているブレードサーバーを使用しないという事実も決定します。 SlaveNodeの場合、仮想化を使用せず、ディスクがRAIDで収集されないことにも注意してください。

Cisco共通プラットフォームアーキテクチャ

シスコには、Hadoop用のハードウェアプラットフォームを構築するための完全な製品セットがあります。 これらは、サーバー、ネットワークデバイス、制御および自動化システムです。 Cisco UCSおよびNexusに基づいて、 CPA(Common Platform Architecture)と呼ばれる大量のデータを操作するためのアーキテクチャが作成およびテストされました。 記事のこのセクションでは、ソリューションで使用されるネットワーク設計の機能について説明します。

図5.共通プラットフォームアーキテクチャのコンポーネント

ソリューションは、次の一連の機器に基づいています。

-Fabric Interconnect 6200(FI) -接続されたサーバーインフラストラクチャのすべてのコンポーネント用の統合グラフィカル制御システム( UCSM )を備えた高速ノンブロッキングユニバーサルスイッチ。

-Nexus 2232ファブリックエクステンダー -ファブリックインターコネクトラインカードの独立した実行。 コンパクトなケーブルインフラストラクチャを維持しながら、管理ポイントの数を増やすことなく、サーバーの接続にToRスキームを使用できます。 サーバーを接続するための32 x 10GbEポートと、ファブリックインターコネクトに接続するための8 x 10GbEポートを提供します。

-UCS C240-ラックマウントデュアルユニットサーバー

-Cisco VIC-ハードウェア仮想化をサポートする2つの10GbEポートを提供するネットワークアダプター

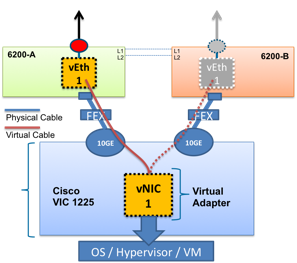

図6に示すように、各サーバーは2つのファブリックインターコネクトモジュールに同時に接続します。1つのパスのみがアクティブで、2つ目はフォールトトレランスに必要です。 問題が発生した場合、サーバーのMACアドレスは変更されないまま、バックアップパスに自動的に切り替わります。 この機能はFabric Failoverと呼ばれ、UCSの一部であり、オペレーティングシステムからの設定を必要としません。

図6.ネットワークアダプターからファブリックインターコネクトへの接続図

UCSを使用すると、FI間のトラフィックの分散を柔軟に制御できます。 説明したアーキテクチャでは、3つの仮想インターフェイスがサーバーのネットワークアダプター上に作成され、それぞれが個別のVLANに配置されます。vNIC0-システム管理者によるノードへのアクセス、vNIC1-クラスター内のノード間で交換される情報、vNIC2-他の種類のトラフィック vNIC1およびvNIC2では、ラージフレームのサポートが有効になっています。 通常モードでは、各インターフェイスは、ネットワークアダプターの構成時にメインインターフェイスとして選択されたFIを使用します。 この例では、すべてのvNIC1トラフィックがFI-Aに切り替えられ、vNIC2トラフィックがFI-Bに切り替えられます(図7)。 FIの1つに障害が発生した場合、すべてのトラフィックは自動的に2番目に切り替わります。

図7.システム内のさまざまなタイプのトラフィックの分布

このソリューションでは、冗長制御およびスイッチングシステム用に2つのファブリックインターコネクトモジュールを使用しています。 各サーバーキャビネットに16台のサーバーと2つのFabric Extenderモジュールをインストールすることをお勧めします。

図8.シスコ機器に基づいたCisco Hadoopクラスタのスケーリング

Nexus 2232サーバーとラインカードを追加することで、Hadoopクラスターのスケーリングが行われますCisco UCS Director Expressソフトウェアを使用して、新しいノードを自動的にインストールおよび構成できますが、これはまったく別の話です。

シスコ製品を購入するか、ウクライナとロシアの シスコパートナーから価格情報を入手できます。

ビジネスに最適なソリューションを選択して実装するのに役立ちます。