ケーブルメラノックスMC2609125-005

この場合、Infinibandはイーサネットの5倍の速度で動作し、同じコストがかかります。 難易度は1つだけでした。これはすべて、データセンターのクラウドサービスを中断することなく実行する必要がありました。 まあ、それは運転中に車のエンジンを再構築する方法についてです。

ロシアでは、そのようなプロジェクトは単に存在しませんでした。 イーサネットからInfinibandへの切り替えを試みた人は、いずれにしても1〜2日間インフラストラクチャを停止しました。 Volochaevskaya-1のデータセンターにあるクラウド「肩」には、約100台の物理サーバーでホストされている約500台の仮想マシンに約60人の大規模な顧客(銀行、小売、保険、重要インフラ施設を含む)がいます。 私たちは、ダウンタイムなしで100時間のネットワークインフラストラクチャを再構築した経験を国内で最初に獲得し、これを少し誇りに思っています。

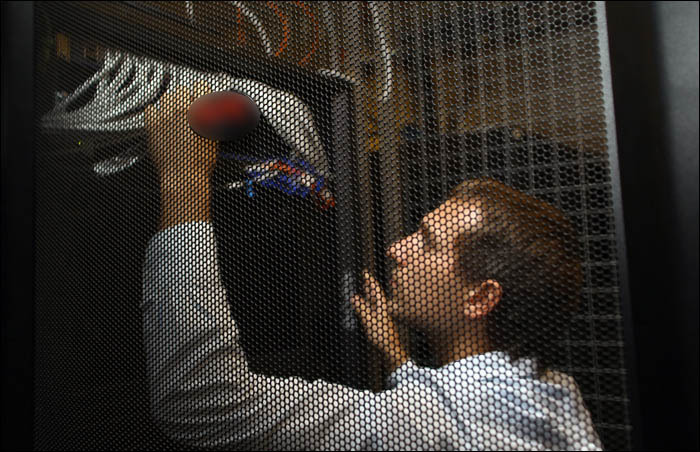

サーバーの入り口にあるInfinibandケーブル

その結果、クラウドサーバー間の通信チャネルのスループットは10 Gb / sから56 Gb / sに増加しました。

何だった

Volochaevskaya-1のデータセンターには、サーバーを統合するイーサネット10 GBがありました。 次のデータセンターであるCompressor(TIER-3レベル)の設計時に、Infinibandを真剣に検討し始めました。 総所有コストをカード、スイッチ、ケーブル、サービスと比較すると、Infinibandのコストはイーサネットとほぼ同じであることがわかりました。 しかし、ネットワークでの遅延ははるかに少なく、少なくとも5倍速くなりました。

さらに、このような施設のInfinibandはセットアップとサポートがはるかに簡単であるという優れた事実に言及する価値があります。 ネットワークはかつて設計された後、新しい鉄片を貼り付けるだけで静かに拡張されました。 複雑なイーサネットアーキテクチャの場合のようなタンバリンとのダンス、状況のスイッチと設定のバイパスはありません。 スイッチのどこかに問題がある場合、彼だけが落ち、セグメント全体ではありません。 インフラストラクチャ内には、実際のプラグアンドプレイがあります。

そのため、InfinibandのCompressorデータセンターにクラウドショルダーを構築し、このテクノロジーの素晴らしさを感じたので、FDR InfiniBandを使用してVolochaevskaya-1のデータセンターのクラウドショルダーを再構築することを考えました。

仕入先

Infinibandには4つの主要なサプライヤがありますが、実際には1つのベンダー、つまりMellanoxの同種の機器でネットワーク全体を構築する価値があります。 さらに、設計時点では、これは最新のInfinband標準であるFDRをサポートした唯一のベンダーでした。 実際、Mellanoxを使用して複数の顧客(大規模な金融会社を含む)のネットワークレイテンシを削減する素晴らしい経験がありました。彼らの技術は完全に証明されています。

Infiniband FDRのレイテンシは約1〜1.5マイクロ秒で、イーサネットでは約30〜100マイクロ秒です。 つまり、差は2桁であり、この特定のケースでは実際にはほぼ同じです。

トポロジとアーキテクチャに関して、私たちは生活を大幅に簡素化することにしました。 2つ目のクラウドショルダーとまったく同じスキームを作成することはそれほど難しくなく、コストもかかりません(私たちのクラウドは2つのデータセンターに基づいています)-データセンターのCompressor-これにより、2つの同一のプラットフォームを取得できるようになりました。 なんで? 交換用の機器を予約するのが簡単で、メンテナンスが容易で、機器の動物園はありません。それぞれに独自のアプローチが必要です。 さらに、一部の機器をサポート対象から外すことはほとんどできませんでした。同時に、古いサーバーを交換しました。 明確にしましょう。この事実は意思決定には影響しませんでしたが、楽しいボーナスであることが判明しました。

最も重要な理由は、ネットワーク遅延の減少でした。 「クラウド」のお客様の多くは同期レプリケーションを使用しているため、ネットワークレイテンシを削減すると、ストレージなどの作業を間接的に加速できます。 さらに、Infinibandを使用すると、仮想マシンをはるかに高速に移行できます。 InfinbandがRDMAをサポートしているため、現時点ではなく未来について話す場合、将来、TCPをRDMAに置き換えることで、仮想マシンを桁違いに速く移行する機能を追加できるようになります。

もちろん、RDMA、TRILL、ECMPテクノロジーは現在、イーサネットの世界に登場しており、Infinibandと同じ機能を提供しますが、Infinbandでは、Leaf-Spineトポロジ、RDMA、自動チューニングを構築する機能が長い間存在し、プロトコルレベルではなく設計されましたEthernet-eのように、AD-HOCソリューションとして追加されました。

乗り換え

Volochayskayaの曇った肩には、10ギガビットネットワーク上にネットワークと100セグメントのセグメントがありました。 Mellanoxで構築されたインフラストラクチャセグメントを接続して、1つのL2セグメントを取得し、最初のオンラインスタンドにあったすべてのものを新しいものに移行しました。 顧客は、サービスの速度を上げる以外に何も感じず、車の電源が切れず、移動中に重大な問題は発生しませんでした。

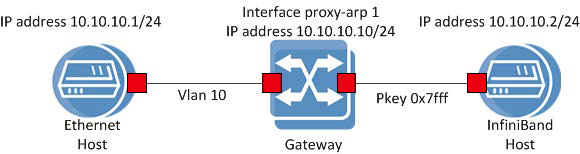

転送スキームの簡易バージョンは次のとおりです。

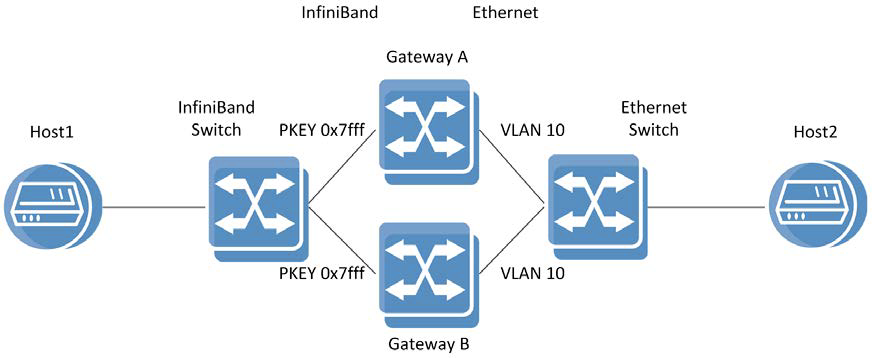

これはもっと複雑なものです:

実際、これらの2つのスタンドの間に1つのデータ転送メディアを作成しましたが、テクノロジーは原則としてあまり互換性がありません。 お客様の仮想インフラストラクチャを移動し、スタンドを切断しました。

2つの環境を組み合わせるために、Mellanox SX6036管理スイッチを使用しました。 クラウド移行用のテストベンチを設計する前に、Mellanoxのエンジニアが相談と技術支援のために来てくれました。 Mellanox機器の計画と機能について彼に同意した後、彼はGWライセンスを送信して、イーサネットネットワークからInfinibandセグメントにトラフィックを転送できるProxy-ARPゲートウェイとしてスイッチを使用できるようにしました。 合計で、移動は約1か月で完了しました(プロジェクトの作業はカウントされません)。 アイデアの実行可能性をテストするために、最初の段階-最初の段階-テストベンチ-「クラウド」のミニモデルをまとめました(通常のネットワークだけでなく、100以上のネットワークも移行する必要がありました)。 テストベンチでの輸送は数回働き、戦闘移住の計画を書き始めました。

テストベンチのレイアウト

さらに-運用サービスは夜のスケジュールに切り替わり、必要なものすべてをゆっくりとマウントし始めました。 夫が夜に行った妻についての話はどこにあるのかは不明であり、働くことはまさにそのような転勤についてであると主張した。

10GネットワークからInfinibandへの移行を実装するための特定のスキーム(IPアドレス、VLAN、pkeyに必要な機器のセットアップ日数)。

インストール中

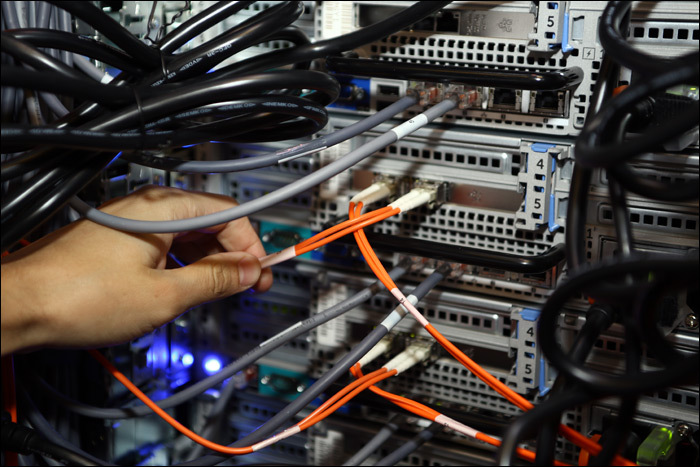

QSFP-4xSFP + Mellanox SX6036に接続されたハイブリッドケーブル

10Gイーサネットスイッチモジュールに接続された同じケーブル

10G-Ethernetパーツの入り口にある光学系

古い機器は現在脇にあり、すでに分解し始めています。 ゆっくりと静かにラックから取り外し、分解します。 ほとんどの場合、テスト環境に任せて、さらに複雑な技術的なケースを解決できるようにします。

すべて、正式にはまだ移動を終了していませんが(古いラックを取り外す必要があります)、結果はすでに非常に暖かくなっています。 コメントの移動やmberezin@croc.ruでの移動に関するご質問にお答えします。