Kinectなどの光線の移動時間の測定に基づいた既存の3Dセンサーは、シーンに光線の経路を屈折および歪ませる半透明および反射面がない場合、画像深度のマップをかなりうまくコンパイルできます。 センサーは信号の最初の反射のみを認識するため、雨、水ジェット、霧、またはガラスや透明なプラスチックでできた物体は、遠くの物体を単純に覆い隠します。

先週香港で開催されたSiggraph Asiaカンファレンスで、MIT Media Labの科学者が同じ原則に基づいた新しい開発を発表しました 。 従来のレーザーダイオードと安価なセンサーを使用します。 機器の費用はわずか約500ドルでした。 プロトタイプとKinectなどの市販のアナログの唯一の大きな違いは、ファームウェアです。

MITプロトタイプは、赤外線レーザーのパルスを単に定期的に変調する代わりに、非常に狭い単一ピークを持つ自己相関機能を持つ特別に選択されたパルスシーケンスを使用します(そのような信号は、エコー遅延および通信で使用され、信号遅延時間を正確に測定します。詳細については、「 基本原理」デジタルワイヤレス通信。Likbez "、セクション内"自己相関関数。バーカーコード ")。 カメラは、透明なオブジェクトの表面からの最初の反射と、より遠くのオブジェクトからの後続の反射を明確に区別します。 彼女は、マットスクリーンで閉じられた碑文の鮮明な画像を取得することさえできます。

MITの開発は、ピコ秒の時間分解能を備えたカメラと、不透明な障害物の背後にあるオブジェクトの画像をキャプチャできるシステムに基づいて作成された以前の研究に基づいています。 このシステムは、フェムト秒レーザーフラッシュからの反射信号の到着時間の測定に基づいています。 同様に、LIDAR、レーダー、エコーサウンダーも機能します。 ただし、コーナーを覗き込むことができるプロトタイプカメラのコストは約50万ドルであり、長いキャリブレーションと信号処理が必要です。

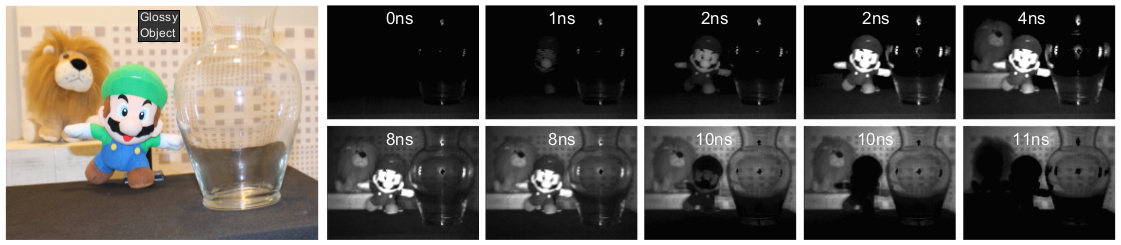

Youtubeのプロジェクト参加者Ashuta Kadambiが投稿したビデオは、カメラがシーンの奥深くにある光パルスの前部の進行をどのように見るかを明確に示しています。 最初に、カメラは透明なオブジェクトの表面からの反射とグレアを認識し、次に-透明なオブジェクトの背後に隠れている他のオブジェクトの画像を認識します。

フレームに鏡があるビデオでは、ライトフロントの進行が特によく見られます。

新しいシステムは、既存の安価で大量販売されているハードウェアで動作できるため、商用利用に非常に適しています。 初期のプロトタイプは、約4秒間、単一のフレームの処理に費やしているため、深刻な最適化を行った後、リアルタイムで動作することを期待できます。 新しい原理に基づいて構築されたセンサーは、理論的には無人車両の非常に高価なライダーに取って代わり、大量採用を近づけることができ、医療で使用することができ、一般にハードウェアを変更せずに3Dカメラのほぼすべての特性を大幅に改善できます。

プロジェクトページでは、テクノロジーの詳細な説明が記載されたビデオとPDFをダウンロードできます。