驚くほど若い年齢の人は、特に教えられていないという事実にもかかわらず、すでにお気に入りのオブジェクトを認識し、拾い上げることができます。 認知能力の発達に関する研究によると、周囲の世界の物体と相互作用する可能性は、物体の検知や操作などの能力の発達において重要な役割を果たします-例えば、標的を絞った捕獲。 外の世界と対話することで、人々は自分の過ちを正すことで学ぶことができます。私たちは何をしたかを知り、その結果から学びます。 ロボット工学では、大量のトレーニングデータや手動調整なしでロボットシステムを学習できるため、エラーの自己修正を伴うこのタイプのトレーニングが積極的に研究されています。

Googleでは、 オブジェクトの永続性の概念に触発されて、 Grasp2Vecシステムを提供しています。これは、オブジェクトの表現を構築するためのシンプルだが効果的なアルゴリズムです。 Grasp2Vecは、オブジェクトを持ち上げようとすると情報が得られるという直感的な理解に基づいています。ロボットがオブジェクトをつかんで拾う場合、オブジェクトはキャプチャする前にこの場所にいる必要があります。 さらに、ロボットは、キャプチャされたオブジェクトがキャプチャ中にある場合、オブジェクトが以前の場所に存在しないことを認識します。 この形式の自己学習を使用して、ロボットは、キャプチャされた後のシーンの視覚的変化により、オブジェクトを認識することを学習できます。

入力データソースとして1台のカメラのみを使用して家庭用オブジェクトをキャプチャするように複数のロボットが同時にトレーニングされたX Roboticsとのコラボレーションに基づいて、ロボットキャプチャを使用してオブジェクトを「意図せずに」キャプチャします。この経験により、オブジェクトの豊富なアイデアを得ることができます。 このアイデアは、ロボットアームが要求に応じてオブジェクトを上げることができる場合に、「意図的なキャプチャ」の能力を獲得するためにすでに使用できます。

知覚報酬機能の作成

強化された学習プラットフォームでは、タスクの成功は報酬機能によって測定されます。 報酬を最大化することにより、ロボットはさまざまなキャプチャスキルをゼロから学びます。 単純なセンサー読み取り値で成功を測定できる場合、報酬関数の作成は簡単です。 簡単な例は、クリックすることでロボットの入力に直接報酬を転送するボタンです。

ただし、成功の基準がタスクの知覚的理解に依存している場合、報酬関数の作成ははるかに複雑です。 キャプチャに保持されている目的のオブジェクトの画像がロボットに与えられる例で、キャプチャの問題を検討します。 ロボットがオブジェクトをキャプチャしようとすると、キャプチャの内容を調べます。 このタスクの報酬関数は、パターン認識の質問に対する答えに依存します。オブジェクトは一致しますか?

左側のグリップはブラシを保持しており、いくつかのオブジェクトが背景に表示されています(黄色のカップ、青いプラスチックブロック)。 右側では、グリップがカップを保持し、ブラシが背景にあります。 左の画像が目的の結果を表している場合、これらの2枚の写真が2つの異なるオブジェクトに対応していることを「理解」するのが良い報酬機能です。

認識の問題を解決するには、非構造化画像(人によって署名されていない)からオブジェクトの意味のある概念を抽出し、教師なしでオブジェクトを視覚化することを学習する知覚システムが必要です。 本質的に、教師なし学習アルゴリズムは、データに関する構造的な仮定を作成することにより機能します。 画像をより少ない次元のスペースに圧縮でき、前のものからビデオフレームを予測できるとしばしば想定されます 。 ただし、データの内容に関する追加の仮定がなければ、これは通常、オブジェクトの無関係な表現を学習するには十分ではありません。

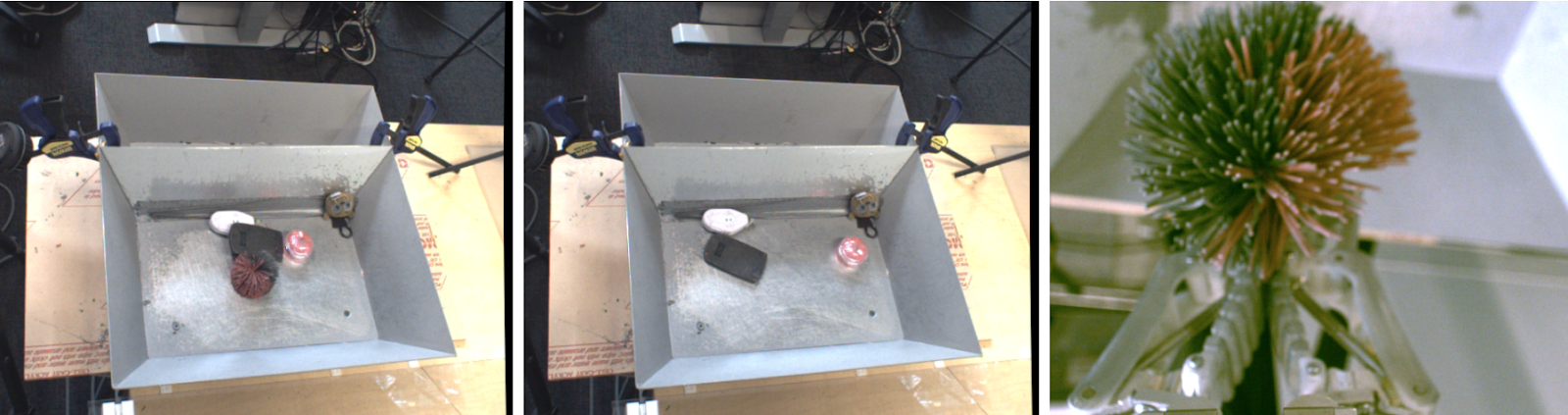

データ収集中にロボットを使用してオブジェクトを物理的に分離した場合はどうなりますか? ロボティクスは、オブジェクトを表現する方法を学ぶ絶好の機会を提供します。これは、ロボットがオブジェクトを操作し、必要な変動要因を与えることができるためです。 この方法は、オブジェクトをキャプチャするとシーンから削除されるという考え方に基づいています。 結果は、1)キャプチャ前のシーン画像、2)キャプチャ後のシーン画像、3)キャプチャされたオブジェクトの個別のビューです。

左-キャプチャするオブジェクト。 中央-キャプチャ後。 右側にはキャプチャされたオブジェクトがあります。

画像から「オブジェクトのセット」を抽出する組み込み関数を検討する場合、次の減算関係を保持する必要があります。

キャプチャ前のオブジェクト-キャプチャ後のオブジェクト=キャプチャされたオブジェクト

畳み込みアーキテクチャと単純なメトリック学習アルゴリズムにより、この平等性を実現します。 トレーニング中、以下に示すアーキテクチャは、キャプチャの前後に画像を空間特性の密なマップに埋め込みます 。 これらのマップは、平均化された結合によってベクトルに変換され、「キャプチャ前」ベクトルと「キャプチャ後」ベクトルの違いはオブジェクトのセットを表します。 このベクトルと、この知覚されたオブジェクトのベクトルの対応する表現は、Nペアの機能によって同一視されます。

トレーニング後、モデルには当然2つの有用なプロパティがあります。

1.オブジェクトの類似性

ベクトル埋め込み間の距離のコサイン係数により、オブジェクトを比較し、同一かどうかを判断できます。 これは、強化学習のための報酬機能を実装するために使用でき、人間がデータをマークアップせずに、ロボットが例でキャプチャする方法を学習できるようにします。

2.ターゲットを見つける

シーンの空間マップとオブジェクトの埋め込みを組み合わせて、画像空間内の「目的のオブジェクト」をローカライズできます。 空間フィーチャマップの要素ごとの乗算と目的のオブジェクトのベクトル対応を実行すると、ターゲットオブジェクトに対応する空間マップ上のすべてのピクセルを見つけることができます。

Grasp2Vecインレイを使用して、シーン内のオブジェクトをローカライズします。 左上はバスケット内のオブジェクトです。 左下-キャプチャする目的のオブジェクト。 ターゲットオブジェクトのベクトルと画像の空間的特徴のスカラー積により、画像の特定のセクションとターゲットの類似性のピクセルごとの「活性化マップ」(右上)が得られます。 このマップを使用して、ターゲットに近づくことができます。

この方法は、複数のオブジェクトがターゲットに対応する場合、またはターゲットが複数のオブジェクト(2つのベクトルの平均)で構成される場合でも機能します。 たとえば、このシナリオでは、ロボットはシーン内のいくつかのオレンジ色のブロックを識別します。

結果の「ヒートマップ」を使用して、ロボットのターゲットオブジェクトへのアプローチを計画できます。 Grasp2Vecのローカリゼーションとパターン認識を「キャプチャー」ポリシーと組み合わせて、データ収集中のケースの80%で成功し、ロボットがこれまでに遭遇したことのない新しいオブジェクトで59%を達成します。

おわりに

私たちの仕事では、ロボットグリッパースキルがオブジェクト表現を教えるために使用されるデータを作成する方法を示しました。 その後、プレゼンテーショントレーニングを使用して、自律キャプチャシステムの教師なしですべての学習プロパティを保持しながら、例によるキャプチャなど、より複雑なスキルをすばやく習得できます。

私たちの仕事に加えて、他のいくつかの最近の研究では、教師なしのインタラクションを使用して、環境内のオブジェクトとのインタラクションをキャプチャ 、 プッシュ、および他の種類のオブジェクトの表現を取得する方法も研究しています。 機械学習がより良い知覚と制御の観点からロボット工学に与えることができるものだけでなく、新しい自己学習パラダイムの観点からロボット工学が機械学習に与えることができるものも喜んで期待しています。