サービスの競争力のある価格は、データセンターを選択する際の顧客にとって常に「議論の王」でした。 そして、これらの価格は何で構成されていますか? 最初に頭に浮かぶのはIT機器と電力のコストですが、価格構造の大きな部分を占めるのは、冷却サーバー、ストレージシステム(SHD)、およびネットワークデバイスのコストです。 たとえば、複数のプロセッサを搭載したサーバーは、最大600 W以上の熱エネルギーを放出します。この熱エネルギーは効果的に除去する必要があり、冷気がサーバーの換気口の入口に供給されます。

この記事では、Selectelデータセンターの気候システムの技術を紹介し、この分野の新製品がデータセンターの運用コストを削減し、間接的に顧客のアカウントの金額を削減する方法を説明します。

3つのサービス市場-3つの冷却要件

大まかに推定されるデータセンターサービス市場には、3つの主要なセグメントがあります。 これは、最初にコロケーション、次にIaaSインフラストラクチャ(専用サーバーとクラウドストレージ)、および3番目のセグメント(パブリック、プライベート、ハイブリッドクラウドを含むクラウドサーバー(VPC、VPS、VMwareクラウド))です。

どんなに驚くかもしれませんが、各セグメントの顧客は気候システムに対して異なる要件を持っています。 最も要求の厳しい顧客は、独自の機器(コロケーション)をデータセンターに配置しています。 その中には、長年の実践とサーバールームの温度について保守的な考えを持つ多くのITマネージャーがいます。 10〜15年前でも、寒い廊下で+ 18°Cを提供するという要件は非常に重要でした。 しかし、最新のサーバーとストレージは、温度が+ 27°Cまで安定して動作します。

ちなみに、データセンターのサーバールームの特定の温度範囲は、ロシアを含む世界中でガイドされているASHRAE(American Society of Heating、Cooling and Air-Conditioning Engineers)の勧告によって非常に厳密に規制されています。 推奨される温度範囲は時間の経過とともに変化し、2000年代初期のどこかで実際には16〜20°C、その後18〜22°Cでした。現在、サーバーの冷却に推奨される気温はすでに20〜27°Cです。

「データセンターのSelectelは、平均で約23°CのASHRAEによると、気温を推奨範囲の下限に維持するよう努めています」と、この記事のSelectelテクニカルディレクターであるKirill Malevanovは述べています。

「データセンターのSelectelは、平均で約23°CのASHRAEによると、気温を推奨範囲の下限に維持するよう努めています」と、この記事のSelectelテクニカルディレクターであるKirill Malevanovは述べています。

これらのうち、データセンター事業について結論付けることができるのはどれですか? エアコンによる高価な冷却は、主にコロケーションサービスに割り当てられたサーバールームに使用する必要があります。 したがって、IaaSサービスのサーバールーム、さらにクラウドサーバーの場合、環境からの冷却を最大限に活用する機器を使用できます。これには、サーバーに外気を吹き付けるだけです。

同時に、Selectelは複数のデータセンターを異なる地域に所有しているため、操作の自由があります。 つまり、設計、データセンターの建設、HVAC機器の選択の段階でも、選択したサービスセグメントの冷却要件を考慮することができます。 そして、これらのサービスを提供する際のTCOの削減を考慮に入れて、運用プロセスの後半で気候システムを近代化します。

PUEとは何ですか?

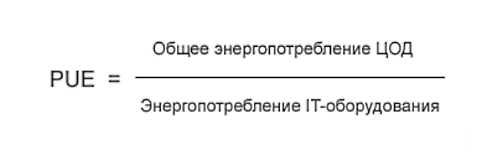

データセンターの効率性の主要な尺度は、2007年以来データセンター業界で使用されている電力使用効率(PUE)比です。 この係数は何ですか:

つまり、PUEが1に近いほど、データセンターはより完璧になります。 ただし、1.0の値を達成することは不可能です。これは、永久運動機械のエネルギー効率レベルに対応するためです。 ところで、PUEという用語の完全な定義は、ドキュメントPUE、A Comprehensive Examination of the Metric(PDF)にあります。

実際には、1.10〜1.15のPUE値は優れていると見なされます。 たとえば、出版物によれば、Googleデータセンターの場合、異なる地域の1年の異なる時期にあるすべてのデータセンターの平均PUE値は1.12です。

次に、選択したSelectelデータセンターの冷却システムについて詳しく見ていきます。

「花1」-フロン

最初の「Flower 1」データセンターは、コロケーションサービスが市場で支配的だった2008年に運用を開始しました。 さらに、これはサンクトペテルブルクの中心です-空きスペースのある状況はやや制約されていました。 したがって、データセンター「Flower 1」には、今日まで稼働しているフロンデータセンター用の古典的な産業用エアコンが設置されていました。

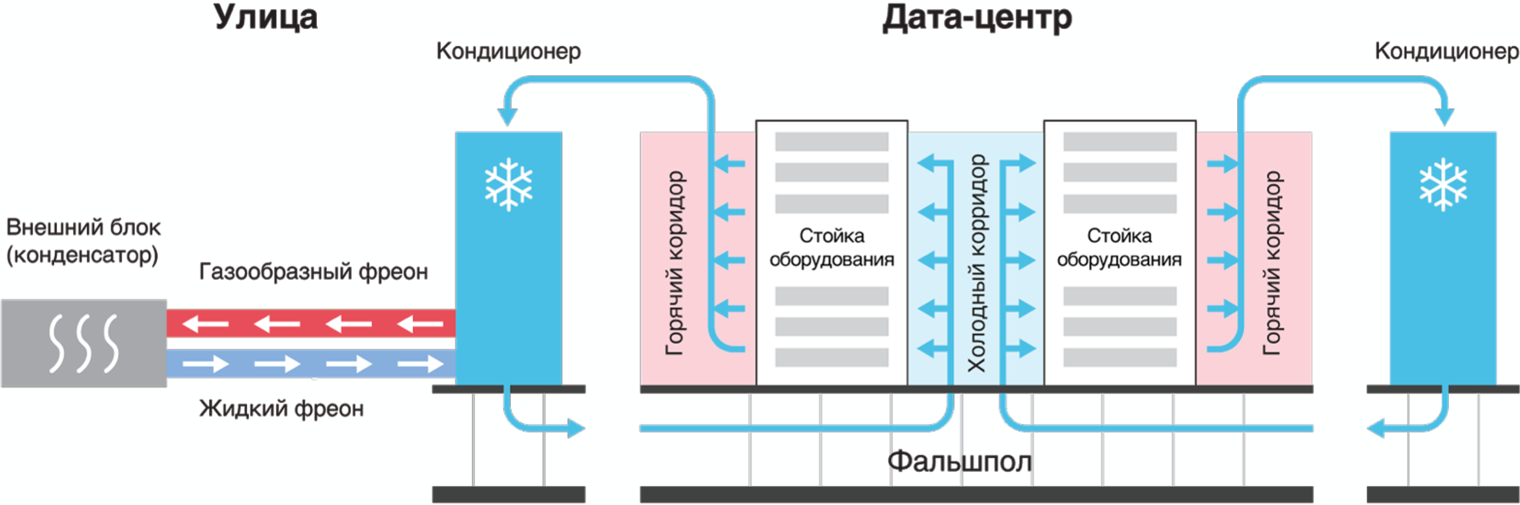

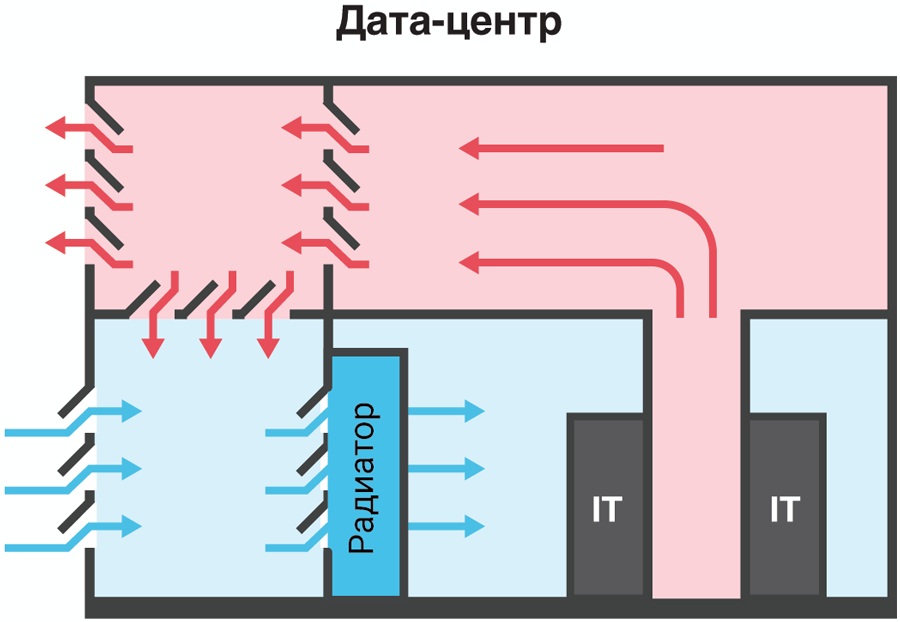

このようなエアコンの動作原理は、フレオンがさまざまな凝集状態に移行することに基づいています。 上げ床の下の冷気は、コンピューティング機器を備えたいわゆる「コールドコリドー」に供給され、加熱された空気はサーバールーム(「ホットコリドー」)に行き、そこから再びエアコン熱交換器に吸い込まれ、冷却されてサーバーおよびストレージシステムに再供給されます。

空調によるデータセンターの冷却

古典的なエアコンの効率には多くの要望があります。そのため、Flower 1データセンターのエネルギー効率係数は、PUE = 1.7という最新の基準で非常に高くなっています。 しかし、コロケーションサービスがここで提供されることを考慮すると、データセンター全体の基本的な近代化の瞬間まで、この状況に耐えることは非常に可能です。

データセンター「Flower 1」のエアコンの検査

「Dubrovka 1」、「Berzarina 1」、「Flower 2」-チラー

Selectelの次の冷却技術は、レニングラード地域のDubrovka村にDubrovka 1データセンターが建設された2010年にテストされました。 その中で、同社の業務で初めて、チラー冷却システムが適用されました。

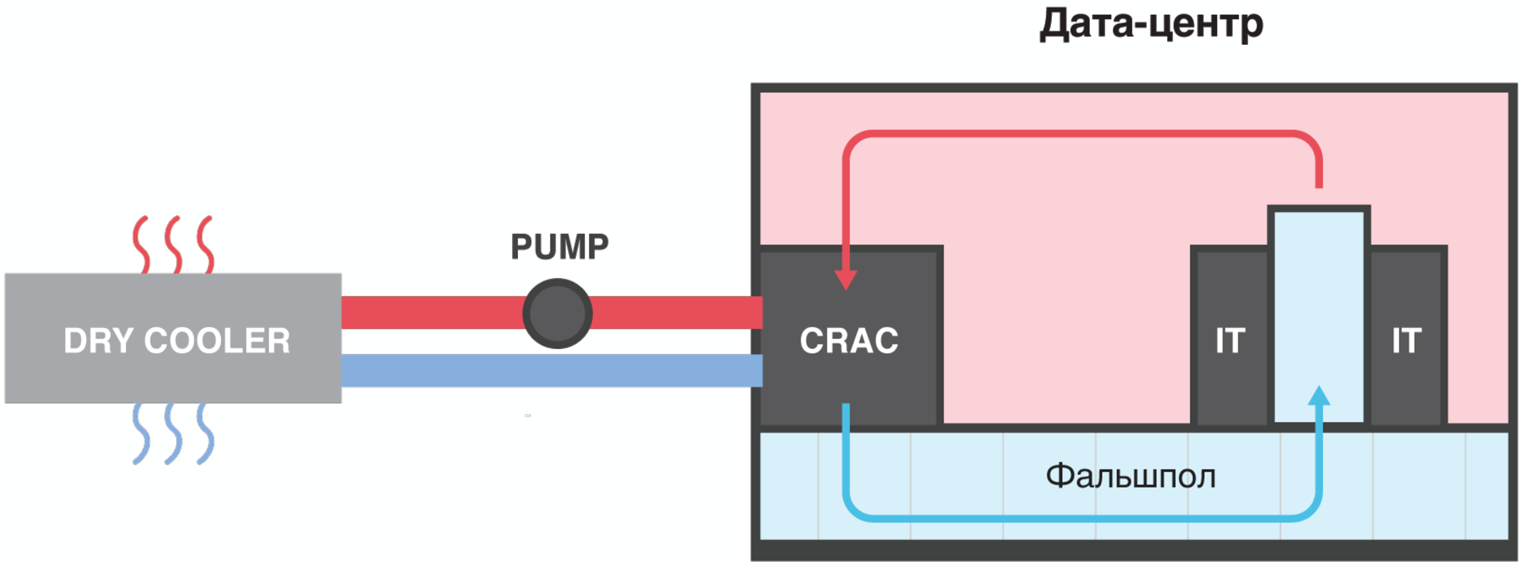

チラーシステムとフレオンエアコンの違いは、非凍結グリコール溶液が屋内ユニットと屋外ユニットの間のパイプ内を循環することです。これは常に液体のままで、気体状態になりません。 このソリューションは、サーバールームのエアコンにポンプで送られ、そこでエアコンの高温のラジエーターで加熱され、そこからチラーと呼ばれる外部の外部熱交換器に送り込まれます。

チラーでは、グリコール溶液は外部空気と追加の凝縮ユニットを使用して冷却されます。 次に、すでに冷却されたグリコール溶液が再びデータセンターのサーバールーム内のエアコンに供給されます。 この場合、コンピューティング機器の冷却は、従来のスキームに従って行われます。冷気が下から上げ床を通って「冷たい廊下」に供給され、温風が共用室に、さらに熱交換器に送られます。

データセンターチラー

コールドコリドーとホットコリドーのスキームでは、最大5%のエネルギーが節約されるため、コールドエアプールとホットエアプール(コリドーとエアストレージ)を分離することが非常に重要です。

チラー回路のエネルギー効率はエアコンと比較して高くなっています。これは、チラーの外部コンプレッサーとコンデンサーユニットが+ 12°Cを超える周囲温度でのみ作動し、屋外ユニットのファンがグリコール冷却液の温度が上昇するにつれて徐々にオンになるという事実によるものです これは、従来の自動車のエンジン冷却システムの仕組みと非常によく似ています。

チラースキームによれば、SelectelはDubrovka 1(2010)、Berzarina 1(2011)、Flower 2(2015)の3つのデータセンターの冷却を構築しました。 Tsvetochnaya 2データセンターの場合、サービスの多くのニュアンスに関するDubrovka 1データセンターの5年間の運用経験が考慮されました。 結局のところ、動作原理は外見的に単純であるにもかかわらず、チラーシステムの動作はかなり気まぐれであり、注意深いメンテナンスと規制の遵守が必要です。 当社のブログ記事で、Berzarina 1データセンターのチラーシステムの操作について詳しく読むことができます。

Flower Center 2データセンターの寒い廊下

「Dubrovka 3」、「Berzarina 2」-フリークーリング

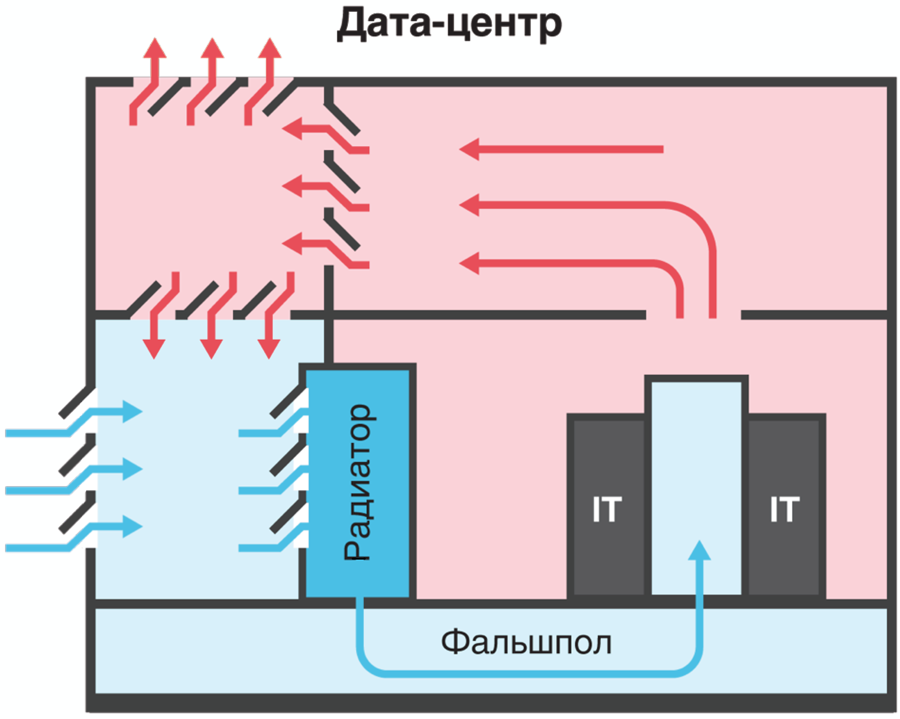

冷却システムのエネルギー効率を改善する次のステップは、直接フリークーリングスキームへの移行時にSelectelで行われました。 古典的な直接フリークーリングの動作原理は、熱交換器の排除であり、コンピューティング機器の冷却は外気の吹き込みにより発生します。

機外の空気はフィルターを通ってほこりが取り除かれ、エンジンルームに入ります。 冬には、必要に応じて、ミキシングチャンバー内のサーバーからの温風で冷気が事前に希釈され、機器の吹出し温度を一定に保ちます。

上げ床なしのアフタークーリングによる直接フリークーリング

前述のように、最新のサーバーとストレージシステムは、+ 27°Cまでの寒冷地の温度で確実に動作します。 レニングラード地域の気候を考えると、7月でも長期平均日気温が+20°Cであるため、このような解決策は非常に有効であるように思われました。 しかし、2010年にレニングラード地域で記録された+ 37.8°Cの温度記録を考えると、自然の慈悲だけに頼ることは不可能でした。 ちなみに、「2018年の暑い夏」では、これらの計算の正確性が確認されました。

したがって、2013年に委託されたDubrovka 3データセンターでは、夏の暑さの場合に追加の冷却ユニット(ABHM、吸収式冷凍機)を使用した直接フリークーリングを使用しています。 機外の空気はフィルターを通過した後、ABXM熱交換器を通過します。 サーバールームの冷たい廊下では、上げ床の下に空気が供給されます。

上げ床を使用したフリークーリング方式による冷却データセンター

運用経験が示しているように、このようなソリューションは、ABCMを+21°Cの周囲温度にオンにすることなく機能します。これは、実際には、ABCMが夏季のみ動作することを意味します。 したがって、これはPUEが1.25未満のかなりエネルギー効率の高いソリューションです。

ABCHMの重要な利点は、フレオンを使用せずに通常の水で機能するため、環境の安全性です。 ABXMの欠点の中には巨大な外部熱交換器がありますが、Dubrovka 3データセンターがほぼクリーンなフィールドに配置されていることを考えると、これはABXM機器の領域のサイズに関して特別な役割を果たしません。

ABHMを備えたデータセンター「Dubrovka 3」の冷却システム

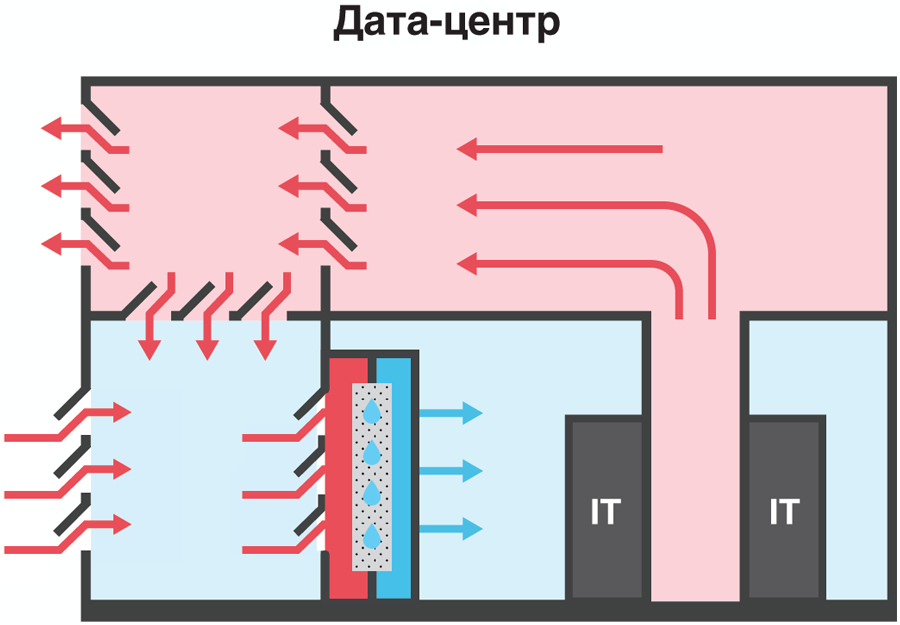

2013年以降、アフタークーリングを備えた直接フリークーリングシステムは高い効率を示しており、モスクワのBerzarina 2データセンターの建設に再実装されます。 ただし、スペースが限られているため、アフタークーリングユニットは断熱システムを使用して実装されます。

予約について一言

従来、Tier IIIデータセンターの冷却システムは、少なくともN + 1のスキームに従って予約されています。 これは、関連するシステムのいずれかの事故または修理(予定されたメンテナンス)が発生した場合に稼働する、少なくとも1つの冷却ユニットが常に在庫にあることを意味します。 そのため、Dubrovka 1データセンターでは、3台が必要な場合、4台の換気マシンがフリークーリングに使用され、Dubrovka 3データセンターでは、3台のABHMマシンが使用され、そのうち1台はオフでスタンバイ状態で、起動準備が整っています。

ちなみに、データセンターのSelectelは、N + 1冗長性の要件を可能な限り厳しくしようとし、1つではなく2つの冗長冷却システムを在庫しています。 たとえば、データセンター「Flower 1」と「Flower 2」には、それぞれ2つのバックアップエアコンとチラーがあります。

Flower Center 1データセンターのサーバールームのエアコン(中央)

「Berzarina 2」-すぐに使用可能

2018年11月、モスクワで新しいBerzarina 2データセンターが稼働し、同社の業務で初めて、断熱システムを使用したアフタークーリングを伴うフリークーリングスキームが適用されます。 外気が暖かすぎる場合-モスクワの夏の温度が23°Cを超える場合-断熱冷却システムがオンになります。

データセンター「Berzarina 2」のポスト冷却断熱システムによるフリークーリング

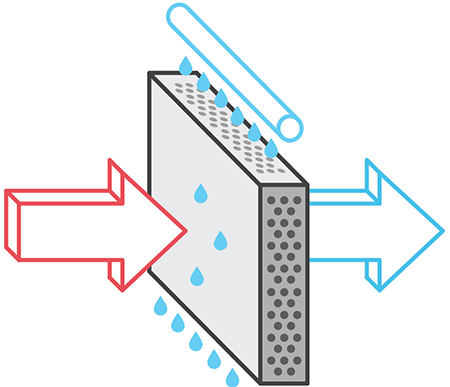

断熱冷却技術は、空気流路内の小さな液滴の形での水の霧化に基づいており、水の蒸発によって空気を冷却できます。 スプレー式空気加湿器を使用する場合、冷却プロセス自体のエネルギーコストは、他の冷却システムと比較して小さくなります。 供給された空気の経路にある濡れ性バリアの複雑なセル構造により、水滴がデータセンターのダクトにさらに入り込むことはできません。 同時に、湿度レベルはIT機器の許容値内にとどまります。

断熱システム

「世界中のエネルギーを節約する冷却システムには、多くの興味深いソリューションがあります。 しかし、すべての新製品を試すことは不可能です-資金を調達し、設計を実行し、機器の購入、準備、および機器の試運転を完了する必要があります。 配送、設置、調整、慣らし運転の段階はすべて非常に長い手順です。 そのため、気候システムは、少なくとも10年間作業を開始した後、すでに構築されたデータセンターの運用プロセスで根本的に近代化されることはめったにありません。 また、興味深い新製品がすでに10〜15年間続く新しいデータセンターに登場しています」と、SelectelのテクニカルディレクターであるKirill Malevanov氏は要約します。