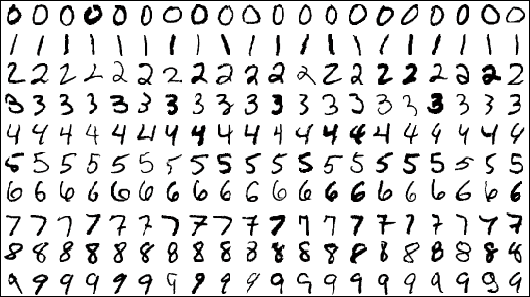

これは、畳み込みネットワークに関する記事の最後の部分です。 読む前に、ネットワーク層とその動作の原理、およびモデル全体のトレーニングに関与する公式について説明する第1部と第2部に精通することをお勧めします。 今日は、Pythonで記述された畳み込みネットワークを手動でテストし、記述されたネットワークをMNISTデータセットに適用し、結果をtensorflowライブラリと比較するときに発生する可能性のある機能と困難を調べます。

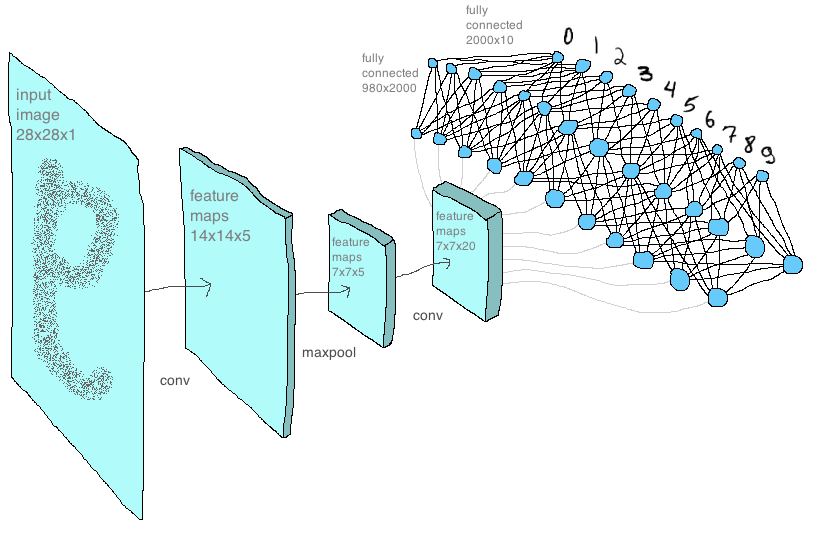

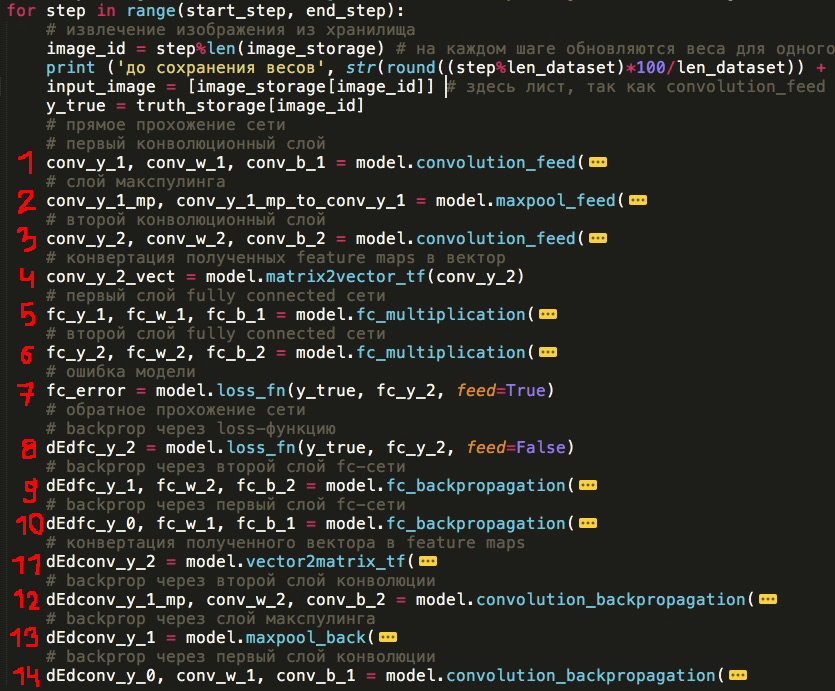

これで、ネットワークの基本概念、レイヤーの構造、およびそれらのシーケンスをすでに見ることができます。 以下に、コードで実装した方法で各レイヤーを示しました-各レイヤーを個別の機能として(実験として、新しいレイヤーを削除または追加したり、交換したり、独自の新しいレイヤーを作成したりできます):

ネットワークを直接通過

1)畳み込みネットワークの最初の層

2)Maxpoolingレイヤー

3)畳み込みネットワークの2番目の層

4)すべての機能マップを1つのベクターに追加(これは完全に「本格的な」レイヤーではありませんが、それでもここで重要な場所を占めます)

5)fcネットワークの最初の層

6)fcネットワークの2番目の層

7)損失関数の値の計算

ネットワークを逆に通過し、パラメーターを更新します(すべてのレイヤーを逆の順序で実行します)

8)損失によるバックプロップ

9)fcネットワークの2番目の層

10)fcネットワークの最初の層

11)ベクターからの機能マップの展開(「フル」レイヤーでもない)

12)畳み込みネットワークの第2層

13)Maxpoolingレイヤー

14)畳み込みネットワークの最初の層

もちろん、このモデルが機械学習用に最適化されたライブラリよりも速く動作することを期待しないでください。 しかし、最終的な目標は、迅速な実装を書くことではなく、ライブラリの仕組みを理解し、最下位レベルでニューラルネットワークを独立して構築する方法を学ぶことです。そして、作業の原則と式を扱った以前の記事の後、コードを書くことだけが残っています。 以下はそのようなコードの例です。

model.py-ネットワークを構成するすべての基本機能がここに保存されます。 過去の記事ですでに多くの機能を取り上げました。

np_mnist_train_test.py-ネットワーク自体とその入力パラメーター。 ネットワークは、model.pyで定義された関数から構築され、記事の冒頭で定義した14ポイントと文字通り同じに見えます。

(私は関数の引数を隠しましたが、拡張された形式ではすべてが不気味に見えます)

しかし、結果の説明に進む前に、私は別のことに触れたいと思います。 記述されたモデルをデータに適用すると、モデルがトレーニングされ、すべてがエラーなく実行されることがわかりました。 ただし、ネットワークが正しく機能していること、すべての内部計算が正しいことを確認したかったのです。 そして、最も明白な解決策は、たとえばMNISTをデータセットとして使用して、このモデルをテンソルフローの同様のアーキテクチャと比較することでした。

テンソルフローでのネットワークの記述ははるかに簡単でした。実際、 このオプションをテンソルフローマニュアルから取り、パラメータを少し調整しました。 そのようなモデルが判明しました:

tf_mnist_train_test.py

両方のモデルの結果が一致することを確認するには、最初にそれらの開始重量が同一であることを確認する必要があります。 ここで最初の難しさがありました-最初にランダムに生成された重み行列が一致するように、numpyとtensorflowのシードを個別に修正できませんでした。 私はこのトリックを思いつきました:tesnrflowでウェイトを作成し、両方のモデルにフィードします。 しかし、私にはこの問題を解決でき、どういうわけか簡単にできるように思えます。 ただし、最終的にはすべてが次のようになります。

code_demo_tf_reshape.py

gitリンク

import numpy as np import tensorflow as tf tf_w = tf.truncated_normal([2, 2, 1, 4], stddev=0.1) with tf.Session() as sess: np_w = sess.run(tf_w) print('\n tensorflow: \n \n', np_w) print('\n \n :') for i in range(len(np_w)): print('\n', np_w[i]) conv_w = [] np_w = np.reshape(np_w, (np_w.size,)) np_w = np.reshape(np_w, (4,2,2), order='F') print('\n \n , tensorflow:') for i in range(4): conv_w.append(np_w[i].T) print('\n', conv_w[-1])

スクリプト出力の例

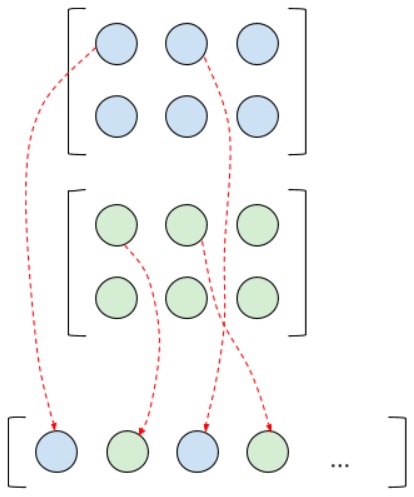

テンソルから重みを見る順序で、つまり、ライブラリ内のさらなる作業で使用されるように、テンソルから重みを抽出するために、上記のコードを使用しました。 ご覧のとおり、すべてが完全に簡単なわけではありません。テンソルフローテンソルは、numpyモデルで使用できるように、いくつかの変換と転置を行う必要がありました。 また、このため、他のいくつかの機能を書き直す必要がありました。 たとえば、すべてのフィーチャマップを1つのベクトルに結合する機能は、畳み込み層の後に多数のフィーチャマップが形成され、fcネットワークにフィードするためにそれらをベクトル化する必要がある場合です。 上記の方法を使用してテンソルをマトリックスに分割した後、テンソルフローの内部と同じように見たい場合、マトリックスをそのようなベクトルに結合することはできなくなりました。 そして、これを達成するために、次のことをしなければなりません:

したがって、エラーの逆伝播中に完全に接続されたレイヤーを通過すると、勾配のベクトルが得られます。これをフィーチャマップに「まっすぐに戻す」必要があります。 これは上の図のように、反対方向にのみ行われます。 もちろん、numpyモデルとtenosorflowモデルの計算結果を比較することが目的でない場合、これらの関数は簡単な方法で作成できます。 そのため、実際には、model.pyで関数matrix2vector(行列をベクトルに変換する)およびvector2matrix(ベクトルを行列に変換する)の機能を説明しました。

以下:フィーチャーマップは、いわば、お互いの独立した画像としてではなく、1つのチャンネルと見なされます。 最初に、出力に4つの機能マップが必要な場合、4つのコアが必要であると想定しましたが、すべてが少し異なって出力されます。 前のレイヤーのすべての機能カードは多くのチャネルを持つ1つの画像と見なされるため、次のレイヤーで1つのカードのみを取得するには、前のレイヤーのチャネルと同じ数のウェイトマトリックスを作成する必要があります(それぞれ、2つのカードの2倍のウェイトマトリックス)。 次に、適切な数の「中間」カードを取得し、それらを1つに追加します。これが、目的の1つの機能マップになります。 たとえば、前のレイヤーで2枚のカードを取得し、次のレイヤーで4枚のカードを取得したい場合、次のようになります。

合計すると、「中間」フィーチャマップが混在して「最終」マップを取得しているように見えますが、よく見ると、元のレイヤーの異なるチャネルからの「中間」フィーチャマップのみが実際に最終マップに合計されていることは明らかです。 たぶん、下の画像のおかげでよりよく理解されるでしょう:

ここでは、1つのRGB画像から2つの機能マップを取得します。 また、エラーの逆伝播の場合、これらの「中間」カードはまったく使用されないことに注意してください。プログラムの理解にはまったく存在しません。 前のレイヤーの各重みマトリックスと機能マップは、次のレイヤーの対応する「最終」カードに関連付けられています。

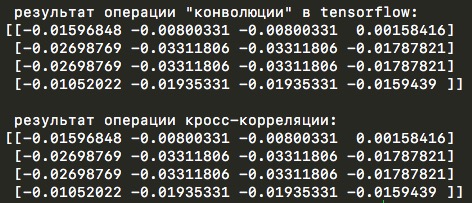

テンソルフロー計算の次の機能は、相互相関が実際にtf.nn.conv2d関数内で発生することであり、これはテンソルフローマニュアルにも記載されています 。

これらのopは「畳み込み」と呼ばれますが、フィルターを反転せずにフィルターが入力ウィンドウと結合されるため、厳密には「相互相関」と呼ばれます。 詳細については、相互相関のプロパティを参照してください。

しかし、numpyでの実装ではTrueからFalseに変更するだけで十分なので、これは大きな問題にはなりませんでした。 相互相関が使用されていることを確認するために使用できるコードの例を次に示します。

code_demo_cross_correlation.py

gitリンク

import tensorflow as tf import numpy as np np.random.seed(0) tf.set_random_seed(0) # from pudb import set_trace; set_trace() # # numpy tf_w1 = tf.truncated_normal([3, 3, 1, 1], stddev=0.1) with tf.Session() as sess: w1 = sess.run(tf_w1) x = tf.constant(0.1, shape=[4, 4]) input_image = tf.reshape(x, [-1, 4, 4, 1]) w_conv1 = tf.Variable(w1) h_conv1 = tf.nn.conv2d(input_image, w_conv1, strides=[1, 1, 1, 1], padding='SAME') with tf.Session() as sess: sess.run(tf.global_variables_initializer()) w_conv = sess.run(h_conv1) w_conv = np.reshape(w_conv, (w_conv.size,)) w_conv = np.reshape(w_conv, (1,4,4), order='F') # ! print('\n "" tensorflow:') for i in range(1): print(w_conv[i].T) w1 = np.reshape(w1, (w1.size,)) w1 = np.reshape(w1, (1,3,3), order='F') for i in range(1): w_l = w1[i].T y_l_minus_1 = np.array([ [0.1,0.1,0.1,0.1], [0.1,0.1,0.1,0.1], [0.1,0.1,0.1,0.1], [0.1,0.1,0.1,0.1]]) other_parameters={ 'convolution':False, 'stride':1, 'center_w_l':(1,1), } def convolution_feed_x_l(y_l_minus_1, w_l, conv_params): indexes_a, indexes_b = create_indexes(size_axis=w_l.shape, center_w_l=conv_params['center_w_l']) stride = conv_params['stride'] # x_l = np.zeros((1,1)) # if conv_params['convolution']: g = 1 # else: g = -1 # # i j y_l_minus_1 , x_l for i in range(y_l_minus_1.shape[0]): for j in range(y_l_minus_1.shape[1]): demo = np.zeros([y_l_minus_1.shape[0], y_l_minus_1.shape[1]]) # result = 0 element_exists = False for a in indexes_a: for b in indexes_b: # , if i*stride - g*a >= 0 and j*stride - g*b >= 0 \ and i*stride - g*a < y_l_minus_1.shape[0] and j*stride - g*b < y_l_minus_1.shape[1]: result += y_l_minus_1[i*stride - g*a][j*stride - g*b] * w_l[indexes_a.index(a)][indexes_b.index(b)] # "" w_l demo[i*stride - g*a][j*stride - g*b] = w_l[indexes_a.index(a)][indexes_b.index(b)] element_exists = True # , i j if element_exists: if i >= x_l.shape[0]: # , x_l = np.vstack((x_l, np.zeros(x_l.shape[1]))) if j >= x_l.shape[1]: # , x_l = np.hstack((x_l, np.zeros((x_l.shape[0],1)))) x_l[i][j] = result # demo # print('i=' + str(i) + '; j=' + str(j) + '\n', demo) return x_l def create_axis_indexes(size_axis, center_w_l): coordinates = [] for i in range(-center_w_l, size_axis-center_w_l): coordinates.append(i) return coordinates def create_indexes(size_axis, center_w_l): # coordinates_a = create_axis_indexes(size_axis=size_axis[0], center_w_l=center_w_l[0]) coordinates_b = create_axis_indexes(size_axis=size_axis[1], center_w_l=center_w_l[1]) return coordinates_a, coordinates_b print('\n -:') print(convolution_feed_x_l(y_l_minus_1, w_l, other_parameters))

スクリプト出力の例

同じデモコードには、テンソルフローの計算に関する別の興味深い詳細が含まれています。 ライブラリ内では、畳み込み操作中に、畳み込みカーネルの中心要素が時々変化します。 通常は位置(0,0)にありますが、3 x 3コアの場合は中央の位置(1,1)に移動します(または、実際には反対が真であり、「通常の」位置はちょうど中央(1,1)にあります)それに関連して、コアは左上隅に移動します...)。 このカーネルでストライドを2に設定すると、テンソルフローの中心要素が再びゼロの位置に移動します。 ロジックは、4 x 4ピクセルの入力マトリックス次元と2ピクセルのピッチで、2 x 2の出力マトリックスを期待しているように思われるということです。そして、これはまさに起こることですが、中心要素が(0,0 )、中央要素が(1,1)にある場合、これらの条件下での出力行列の次元は3 x 3ピクセルになります。 これは、(1,1)の中心要素を持つコアが、入力行列の外側に「隠れる」前にさらに計算を行うためです。 ここで、下の写真を見てください:

したがって、ゼロから作成されたコードが中心要素を選択する可能性を考慮していない場合、結果とテンソルフローの違いの理由を理解することはできません。

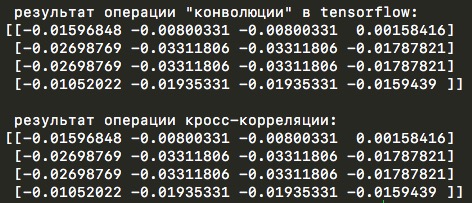

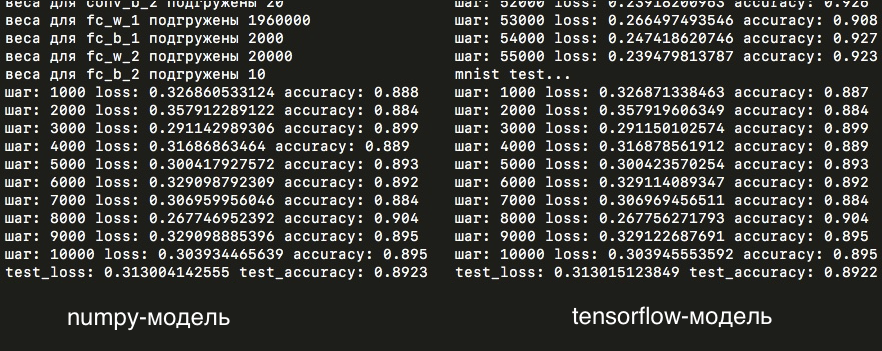

したがって、最終的に、結果の違いにつながるすべてのニュアンスを整理し、スクラッチモデルからこれをすべて考慮し、両方のネットワークの損失を比較できます:最初の実装はnumpyを使用して実装され、2番目のライブラリはtensorflowで実行されます。

次に、ネットワークのアーキテクチャについて少し説明します。 最初の畳み込み層では、2x2ピクセルのコア(およびゼロ位置の中央要素)を2に等しいステップで使用しました。このレイヤーは、14x14ピクセルの次元(つまり、28x28ピクセルの元のmnist画像の2倍)の5つの特徴マップを生成します。 これらのカードは、コアがすでに3 x 3ピクセルで1ステップで(実際にはコアの中心に移動します)、同じ次元の20枚のフィーチャカードの出力で、2番目のレイヤーに供給されます。 次はmax-spoolレイヤーで、カードのサイズを7x7ピクセルに縮小します。 次に、カードがベクターに追加されます。 次は、2,000個のニューロンを含む完全に接続されたネットワークの隠れ層です。 ほぼ200万(7 x 7 x 20 x 2000 = 1,960,000)個の要素が、重みのマトリックスでこのレイヤーに取得されます! そして、すでに2000個のニューロンが、クラスの数に関与する10個の出力ニューロンに接続されています。つまり、ネットワークが予測するために学習しなければならない10桁です。 これらのパラメーターはすべて、np_mnist_train_test.pyファイル内にあるモデル設定と呼ばれる辞書にリストされています。

したがって、両方のモデルを実行して、結果を比較してみましょう:損失と精度、5つの画像ごとの平均:

ご覧のとおり、損失はほぼ完全に一致しています。つまり、手動で組み立てられたモデルとテンソルフローで記述されたモデル内のすべての計算は、少なくとも非常によく似ています。

1日と1つのトレーニングの時代(つまり、ネットワークの順方向および逆方向の通過を55,000回繰り返す)の後、損失と精度のグラフが表示されます。

また、テストサンプルでは、精度は89%です。

ご覧のように、テストサンプルとトレーニングサンプルの結合されたnumpyモデルの損失は、テンソルフローネットワークの結果と非常に似ています。 1回のトレーニング期間後のテストサンプルの精度の違いは、1万個あたり1つの画像のみです! しかし、それでも、重み行列自体は1000分の1で異なります(一方、トレーニングの最初の段階では違いはありませんでした)-numpyとtensorflowの計算の精度が異なる可能性が最も高い可能性があります:float32とfloat64、またはわずかな違いをもたらすその他の不明なニュアンスモデル計算で。

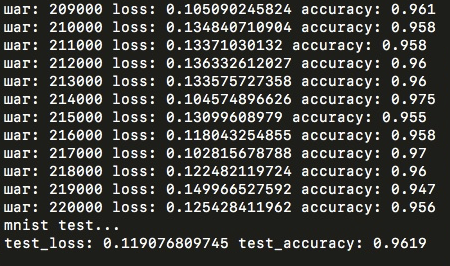

1つの時代を過ぎた後、89%の精度が達成されました。 しかし、同じモデルで4つの時代を経た後、テストサンプルの結果ははるかに高くなります-96%。 しかし、私はテンソルフロー、numpyモデルのみでそれを試しましたが、さらなるトレーニングには時間がかかりすぎましたが、一般的には選択したアーキテクチャはそれほど悪くはないと結論付けることができます!

正確には、numpyモデルの1つの時代は、古いラップトップで約15時間かかりました。 テンソルフローを使用して構築されたモデルでは、この同じ時代はわずか7〜8分で終わります。 つまり、差は120倍です! 手作業で組み立てられたモデルでは常に何がかかり、ボトルネックはどこにありますか? これを理解するには、numpyモデルの各関数がとるタイムラインを見てください(ネットワークを順方向と逆方向に通過する合計):

ご覧のように、ほぼ15時間にわたって、いくつかの畳み込みカーネルがトレーニングされています。 そのため、モデルパラメーターでは、畳み込み層の出力にフィーチャマップがほとんどありません。 numpyマトリックスの最適化された乗算が内部で発生するため、完全に接続されたレイヤー(特にパラメーターの数が少ない2番目のfcレイヤー)にはほとんど時間がかかりません。 テンソルフローの計算ははるかに最適化されており、進化層も行列乗算として表されます。 ここでもっと読むことができます。

「非標準」パラメーターでモデルをトレーニングしました-相互相関の代わりに畳み込み演算を行い、最初の層の位置(1,0)と2番目の畳み込み層の位置(1,2)の中心要素。 結果はさらに悪かったが、さらに訓練すれば、おそらく通常のパラメーターと一致するはずだった。 もちろん、特定の中心要素を他のテンソルフローに変更したり、畳み込みネットワークの任意の層の畳み込みの相互相関を変更することはできないため、計算をテンソルフローモデルと比較することはできません(一般的に、いつか便利になるかもしれません)。 興味深いことに、当初の精度は急激に向上し始めましたが、その後は「通常の」モデルよりもはるかに遅れていました。

もちろん、numpyモデルは実際の計算には適していないため、機械学習用のテンソルフローまたはその他のライブラリを使用する必要があります。 私は、Pythonの実装にエラーがないことを絶対に確信しているとは言えません。絶対に確かにテンソルフローにあるすべての微妙なトレーニングの微妙なニュアンスが考慮されます。 しかし、主なことはトレーニング時間です。 Pythonで2時間かかるのは、テンソルフローでわずか1分です。

MNISTで得られた結果を改善するには、より多くの畳み込み層を使用し、より多くの特徴マップを生成して画像のネットワークから特徴を適切に抽出する必要があります(もちろん、これはすべて、numpyモデルを使用するとトレーニング時間に深刻な影響を与えます)。 また、複数のイメージでバッチを使用し、従来のSGD最適化方法を、たとえばAdam( こちらまたはこちらで読むことができます )に置き換えてください。 もちろん、この記事で得られた結果は印象的ではありません(リーダーボードはここにあります )が、式に従って文字通り書かれたモデルが実際に学習して機能することは明らかです。 テスト結果を再現する場合、またはトレーニングを続行する場合、numpyモデルのcnn_weights_mnist.npyウェイトはgitのリポジトリにあります。

それで、畳み込みネットワークに関する記事の終わりに来ました。 ネットワークの背後にあり、機械学習ライブラリ内に隠れている内部構造と数学のアイデアを既にお持ちであれば、それは良いことです。 私は可能な限り簡単な言語ですべてを伝え、すべての式を解析して質問が残らないようにしました。これらの記事が誰かの時間を節約することを願っています。 それで終わりです。最後まで読んでくれてありがとう!