私は記事を読むのが好きではありません。すぐにGitHubに行きます

このご不便をおかけして申し訳ございません。

この記事で説明することは、何らかの形でコンピューターサイエンスのいくつかの分野に影響を与えますが、個々の領域に飛び込むことはできません。 このご不便をおかけして申し訳ございません。

2017年には、おそらく機械学習と人工知能について話す必要はありません。 ジャーナリスティックな記事と深刻な科学論文の両方が、この主題に関してすでに多数書かれています。 したがって、読者はすでにそれが何であるかを知っていると想定されます。 機械学習といえば、データサイエンティストとソフトウェアエンジニアのコミュニティは、通常、ディープニューラルネットワークを暗示しており、そのパフォーマンスのために非常に人気があります。 現在、世界には人工ニューラルネットワークの問題を解決するためのさまざまなソフトウェアソリューションと複合体が多数あります。Caffe、TensorFlow、Torch、Theano(rip)、cuDNNなどです。

スイフト

Swiftは革新的な、プロトコル指向のオープンソースプログラミング言語で、クリスラトナー(最近SpaceXの後にAppleを離れてGoogleに落ち着いた)によってAppleの壁の中で成長しました。

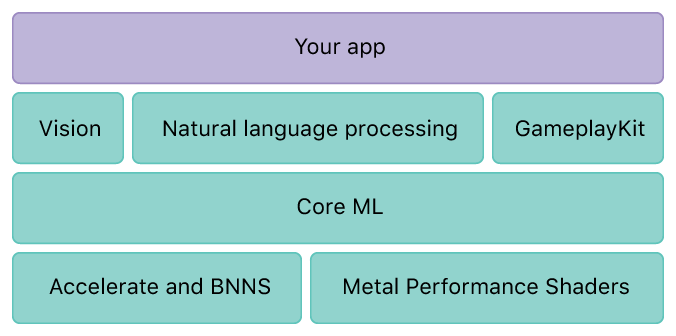

AppleのOSには、マトリックスとベクトル代数を操作するためのさまざまなライブラリが既にありました。BLAS、BNNS、DSPは、1つのAccelerateライブラリの屋根の下で結合されました。

2015年、グラフィックテクノロジーMetalに基づく数学の実装のための小さなソリューションが登場しました。

CoreMLは2016年に登場しました:

CoreMLは、既製のトレーニング済みモデル(CaffeV1、Keras、scikit-learn)をインポートし、開発者にそれをアプリケーションにエクスポートする機会を提供できます。

つまり、次のことを行う必要があります。サードパーティのフレームワークを使用して、PythonまたはC ++の別のプラットフォームでモデルを構築します。 次に、サードパーティのハードウェアソリューションでトレーニングします。

そしてその後のみ、Swift言語でインポートして作業できます。 私の意見では、それは非常に混雑していて困難です。

テンソルフロー

TensorFlowは、人工ニューラルネットワークを実装する他のソフトウェアパッケージと同様に、ニューロン、それらの関係、エラー計算、エラー逆分布を操作するための多くの既製の抽象化とメカニズムを備えています。 しかし、他のパッケージとは異なり、ジェフディーン(Google従業員、分散ファイルシステムの作成者、TensorFlowおよび他の多くの優れたソリューション)は、データ実行モデルとデータ実行プロセスを分離するというアイデアをTensorFlowに組み込むことにしました。 これは、最初にいわゆる計算グラフを記述し、その計算を開始した後にのみ意味するということです。 このアプローチにより、データ実行モデルを分離し、非常に柔軟にデータ実行プロセスと直接連携して、異なるノード(プロセッサ、ビデオカード、コンピューター、クラスター)に実行を分散できます。

TensorFlowKit

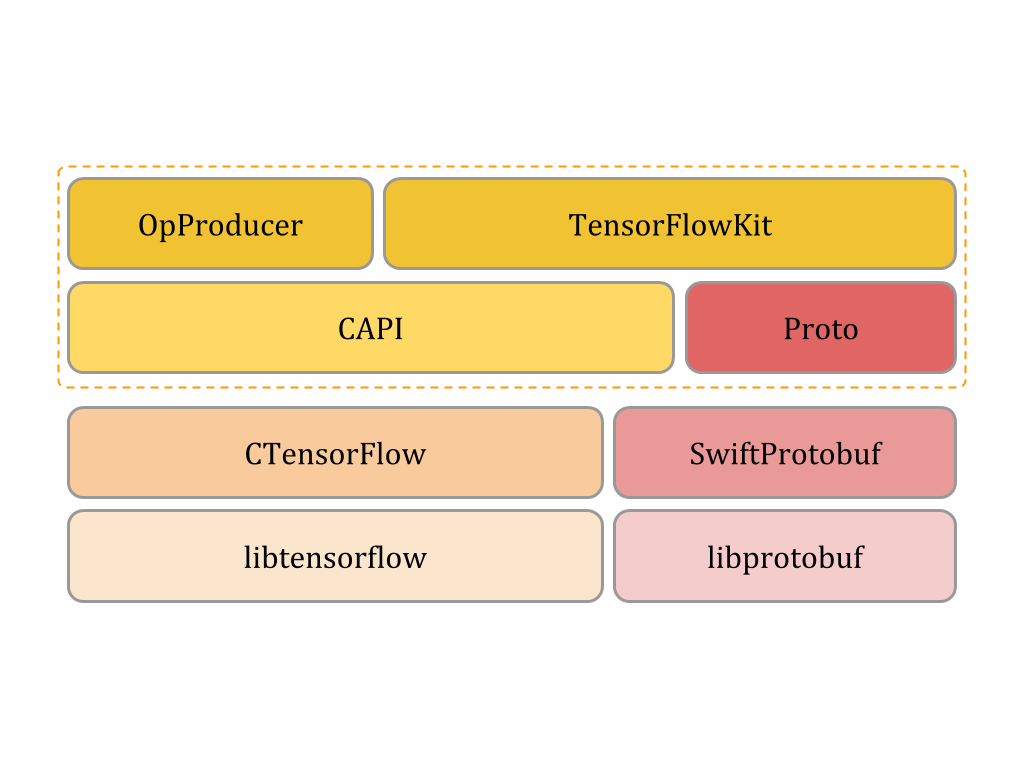

1つの言語のフレームワーク内で、モデル開発から最終アプリケーションでのモデル開発までのタスクのサイクル全体を解決するために、TensorFlowを使用したアクセスおよび作業インターフェイスを作成しました。

ソリューションのアーキテクチャは、中レベルと高レベルの2つのレベルのように見えます。

- 低レベルCでは、このモジュールを使用すると、迅速な言語からlibtensorflowにアクセスできます。

- 中間レベルでは、Cポインターから離れて「美しいミス」で操作することができます。

- 高レベルでは、モデル要素にアクセスするためのさまざまな抽象化と、グラフをエクスポート、インポート、視覚化するためのさまざまなユーティリティを実装します。

したがって、迅速な言語でモデル(計算のグラフ)を作成し、複数のビデオカードを使用してUbuntu OSを実行するサーバーでモデルをトレーニングし、macOSまたはtv OSのプログラムで簡単に開くことができます。 開発は、その長所と短所をすべて備えた通常のXcodeで実行できます。

ドキュメントとAPIはこのリンクにあります。

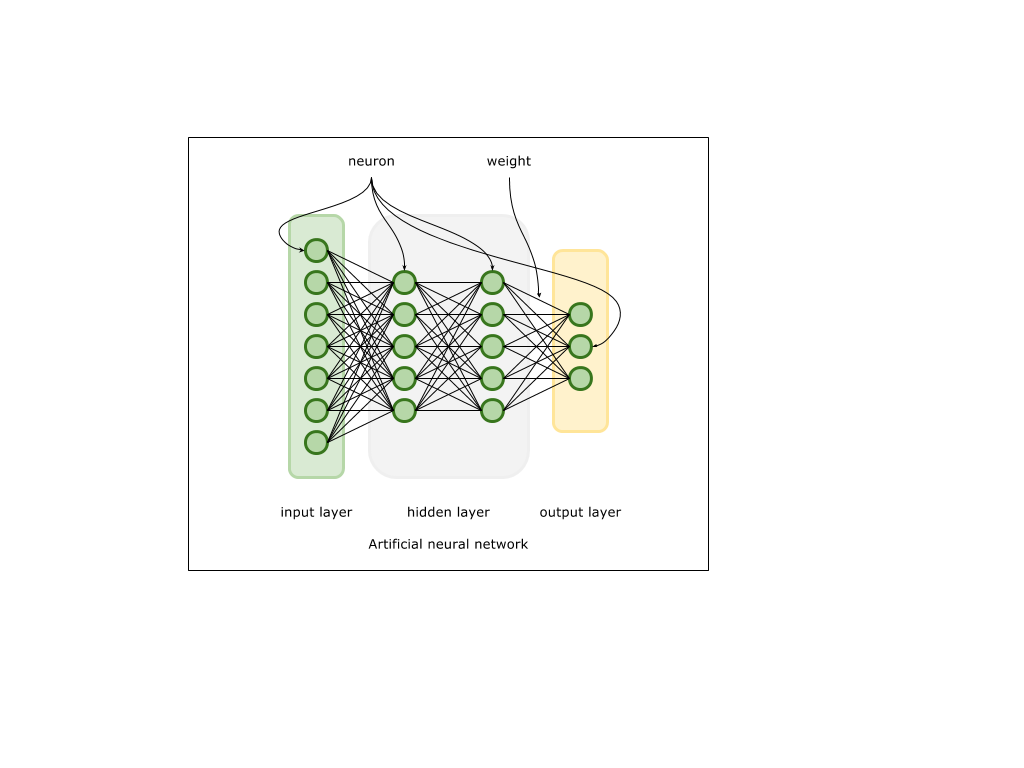

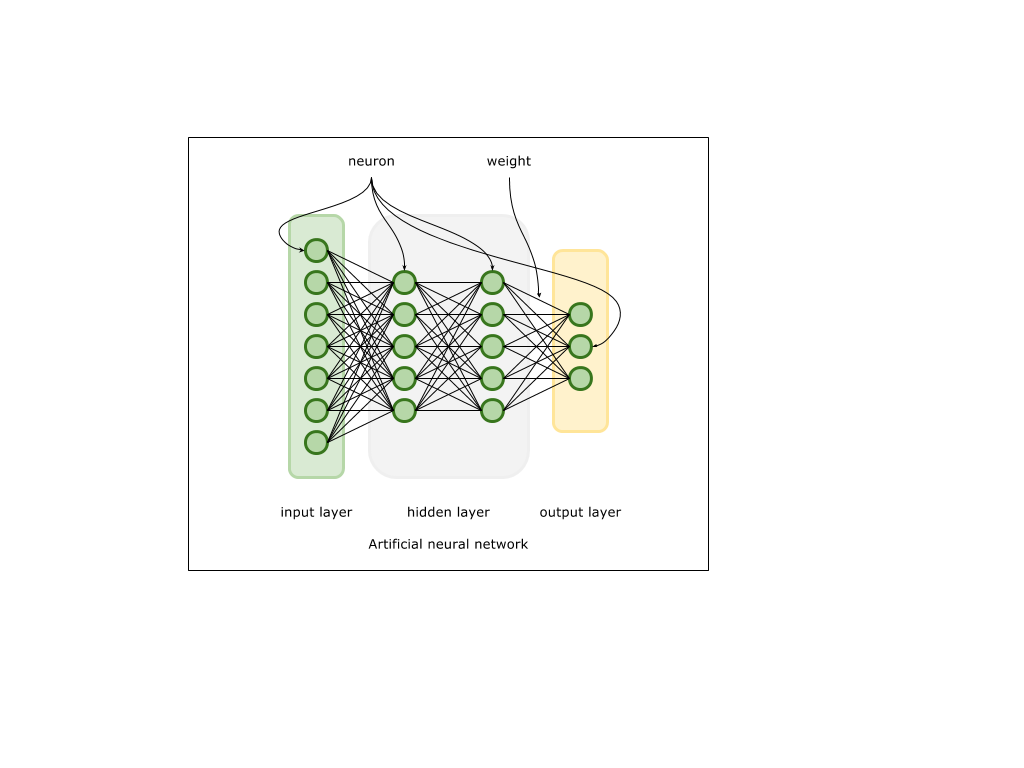

ニューラルネットワークの理論について簡単に説明します。

人工ニューラルネットワークは、神経系の組織におけるニューロン接続の特定の(非常に単純化された)モデルを実装します。 大きな次元のベクトルの形式の入力信号は、ニューロンで構成される入力層に到達します。 次に、各入力ニューロンはこの信号を次の層に送信し、ニューロン間の接続の特性(重み)と後続の層のニューロンの特性に基づいて信号を変換します。 トレーニング中、出力信号が出力層で形成され、予想されるものと比較されます。 出力信号とサンプル信号の差に基づいて、エラー値が生成されます。 さらに、この誤差を使用して、いわゆる勾配(ニューロン間の接続を修正する必要がある方向のベクトル)を計算します。これにより、将来、ニューラルネットワークが予想される信号に類似した信号を生成します。 プロセス自体は、逆エラー分布または逆伝播と呼ばれます。 したがって、ニューロンとニューロン間の接続は、このニューラルネットワークが学習しているデータモデルの特性を一般化するために必要な情報を蓄積します。 技術的な実装は、BLAS、LAPACK、DSPなどのソリューションによってある程度まで既に実装されている行列とベクトルのさまざまな数学演算に基づいています。

ミニスト

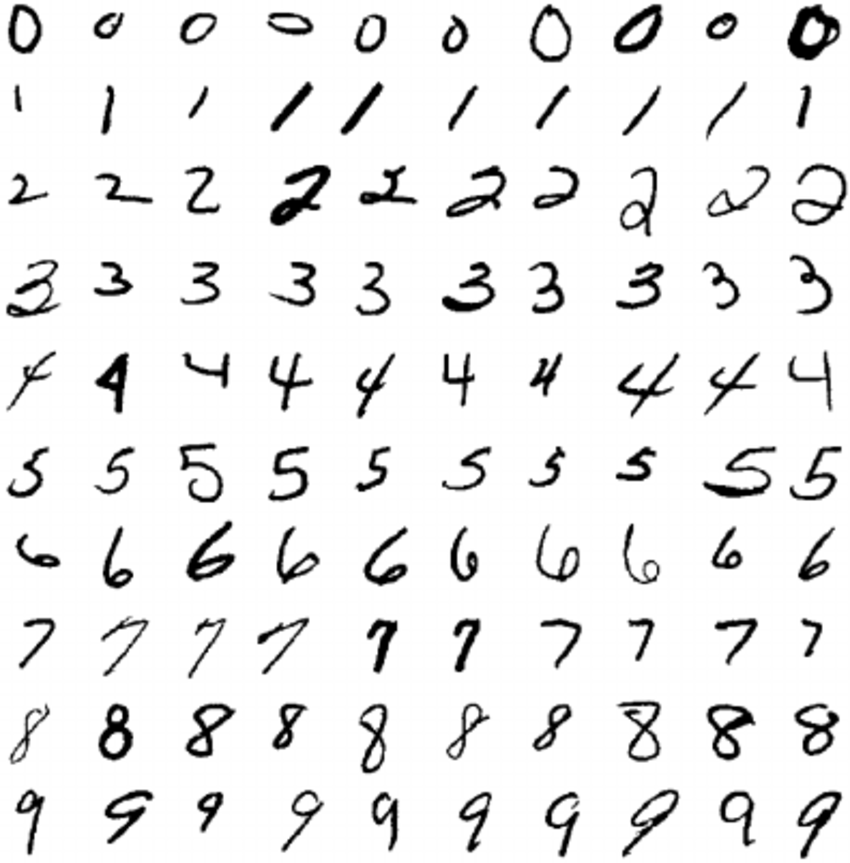

例として、「Hello world!」をニューラルネットワークの世界で取り上げました 。画像MNISTを分類する問題です。 MNISTデータセットは、数千の28 x 28ピクセルの手書き数値画像です。 したがって、トレーニング用の60,000個の画像とテスト用の10,000個の画像にきちんと分散された10個のクラスがあります。 私たちのタスクは、画像を分類し、10のクラスのいずれかに属するかを判断できるニューラルネットワークを作成することです。

TensorFlowKit自体を使用する前に、TensorFlowをインストールする必要があります。 macOSでは、brew package managerを使用できます。

brew install libtensorflow

Linux用のビルドはこちらから入手できます。

迅速なプロジェクトを作成し、依存関係をそれに接続します

dependencies: [ .package(url: "https://github.com/Octadero/TensorFlow.git", from: "0.0.7") ]

MNISTデータセットの準備。

MNISTデータセットを操作するためのパッケージが作成されており、こちらから入手できます。 このパッケージは、データセットを個別に一時ディレクトリにダウンロードし、展開して既成のクラスとして提示します。

dataset = MNISTDataset(callback: { (error: Error?) in print("Ready") })

必要な操作のグラフを収集します。

計算グラフの空間全体と部分空間はスコープと呼ばれ、独自の名前を持つ場合があります。

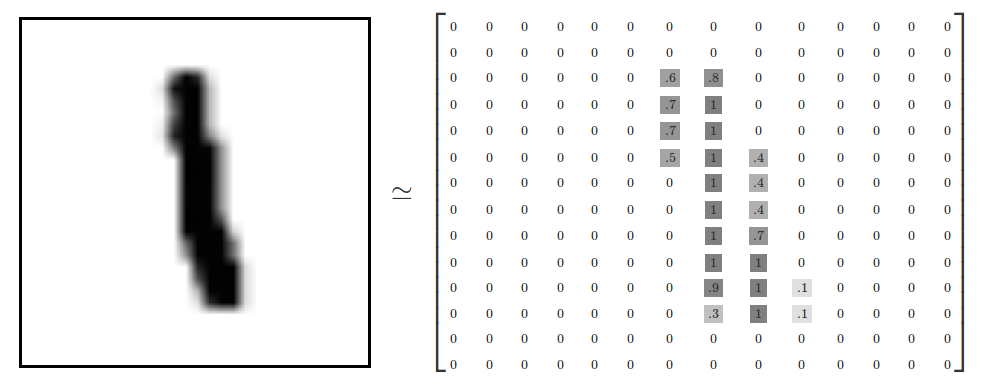

ネットワークの入力で、2つのベクトルをフィードします。 1つ目は、高次元784(28x28 px)のベクトルの形式で表示される写真です。

つまり、ベクトルxの各コンポーネントには、ピクチャ内のピクセルの色に対応する0〜1のFloat値があります。

2番目のベクトルは、対応する1つのコンポーネントがクラス番号に対応する形式(以下を参照)で暗号化された対応するクラスになります。 この例では、クラスは2です

[0, 0, 1, 0, 0, 0, 0, 0, 0, 0 ]

入力パラメーターはトレーニングプロセス中に変更されるため、それらを参照するためのプレースホルダーを作成します。

//Input sub scope let inputScope = scope.subScope(namespace: "input") let x = try inputScope.placeholder(operationName: "x-input", dtype: Float.self, shape: Shape.dimensions(value: [-1, 784])) let yLabels = try inputScope.placeholder(operationName: "y-input", dtype: Float.self, shape: Shape.dimensions(value: [-1, 10]))

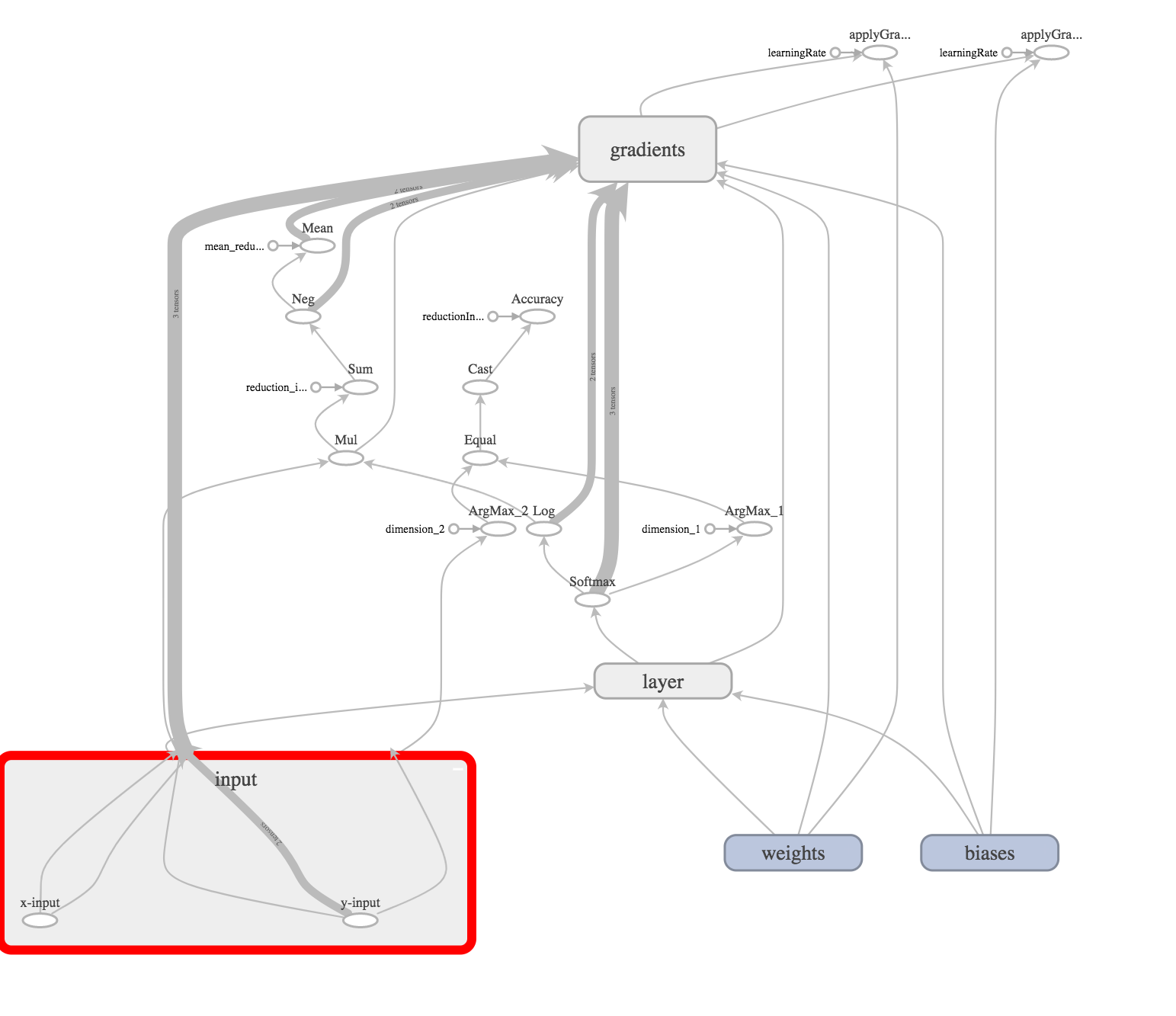

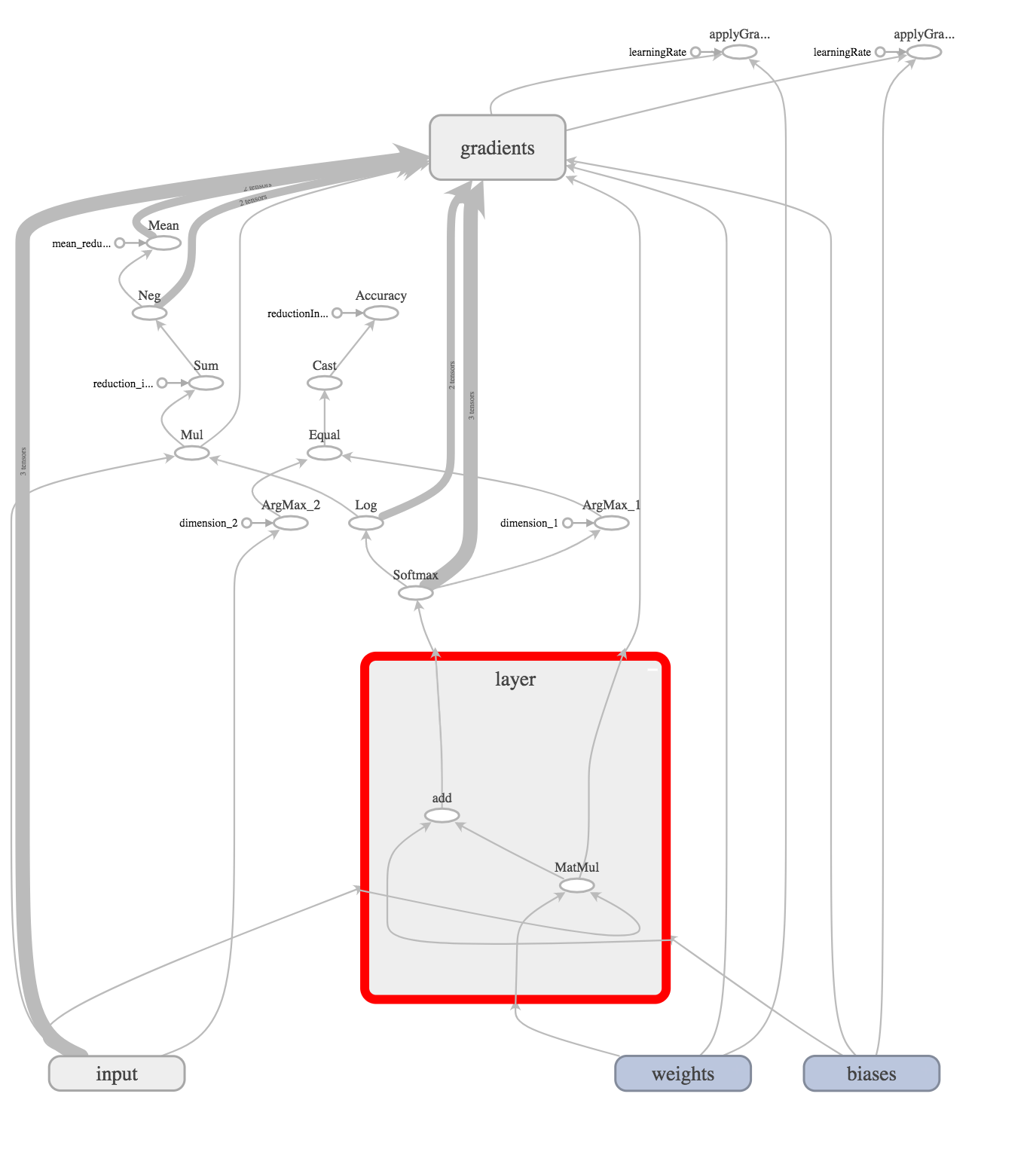

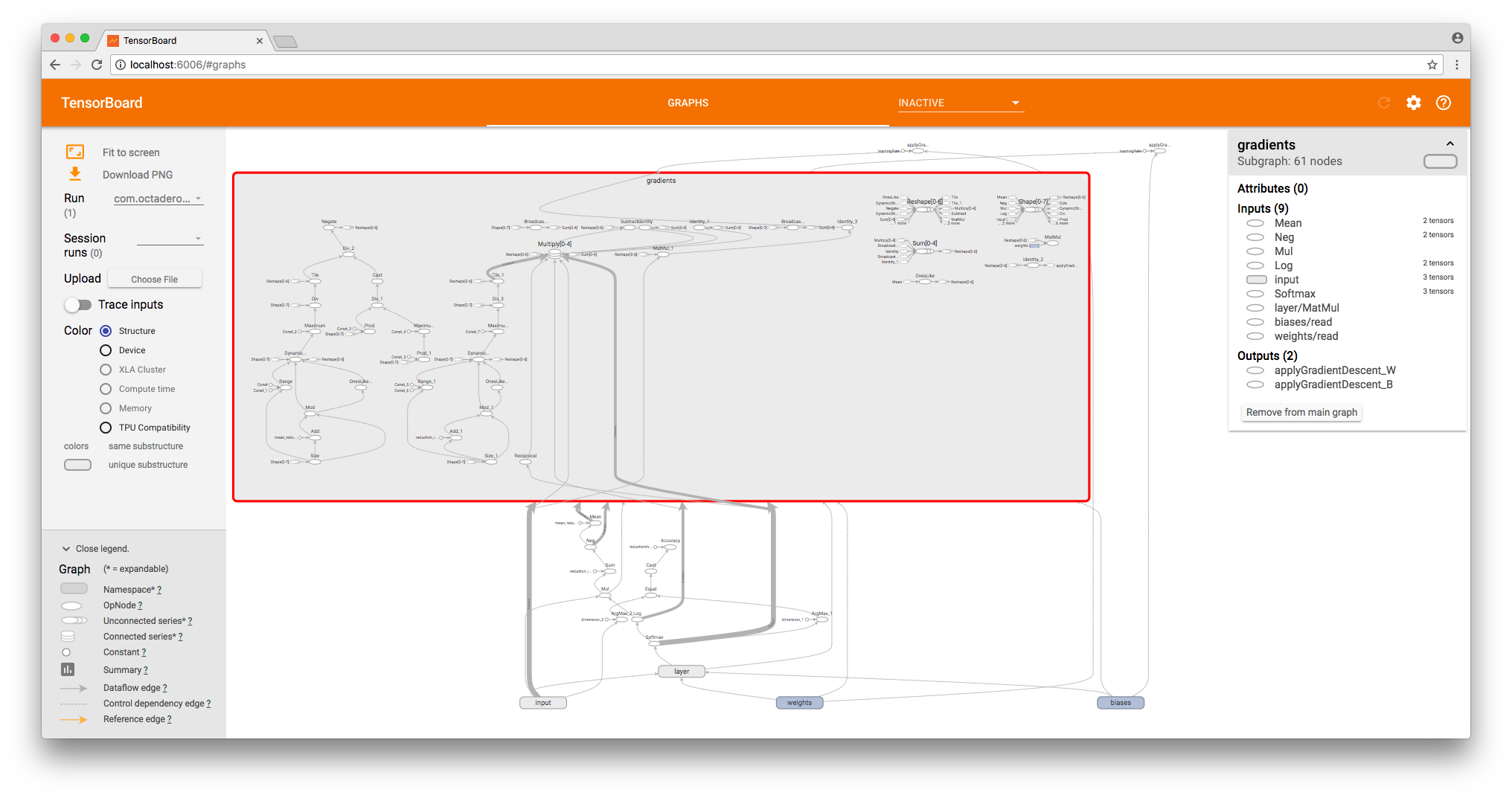

グラフを視覚化するために、 TensorBoardを使用しました 。 TensorFlowKitを使用してグラフを作成し、学習プロセスを視覚化する方法については、別の記事で説明します。

[ 入力 ]列では、次のようになります。

これが入力レイヤーです。

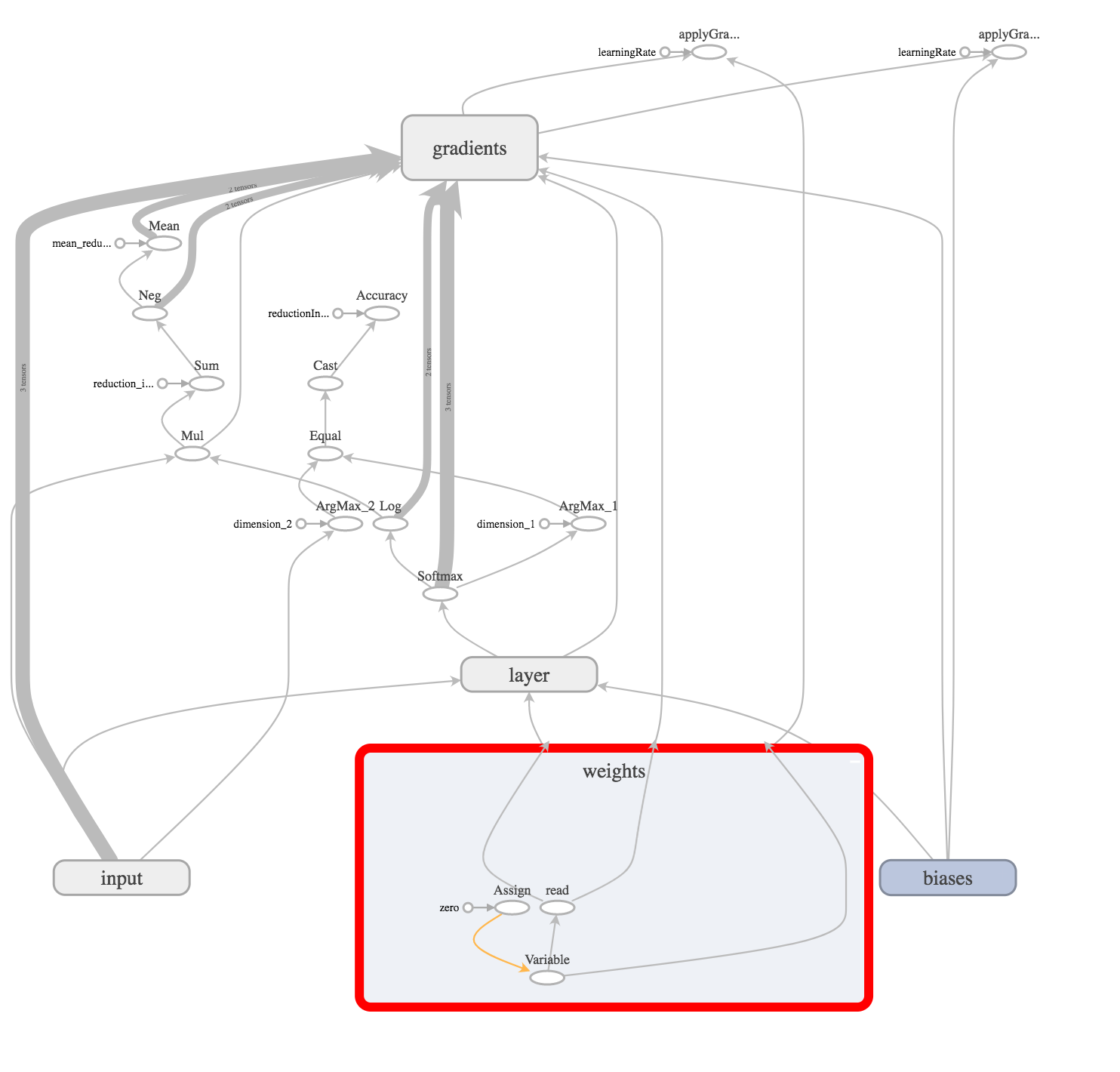

次に、入力レイヤーと非表示レイヤーの間にウェイト(結合)を作成します。

let weights = try weightVariable(at: scope, name: "weights", shape: Shape.dimensions(value: [784, 10])) let bias = try biasVariable(at: scope, name: "biases", shape: Shape.dimensions(value: [10]))

ネットワークのトレーニング中に重みとベースが変更される(調整される)ため、グラフに変数演算を作成します。

そして、ゼロで満たされたテンソルでそれらを初期化します。

次に、最も単純な操作(x * W)+ bを実行する非表示レイヤーを作成します

これは、 ベクトル x(次元1x784) に行列 W(次元784x10)を乗算し、基底を追加する操作です。

この例では、隠れ層はすでに出力(「Hello World!」レベルのタスク)であるため、出力信号を分析して勝者を選択する必要があります。 これを行うには、softmax操作を使用します。

以下で説明する内容をよりよく理解するために、ニューラルネットワークを複雑な機能と見なすことを提案します。 関数の入力で、ベクトルx(画像を表す)を受け取ります。 出力では、関数が入力ベクトルが各クラスに属することをどの程度確信しているのかを示すベクトルを取得します。

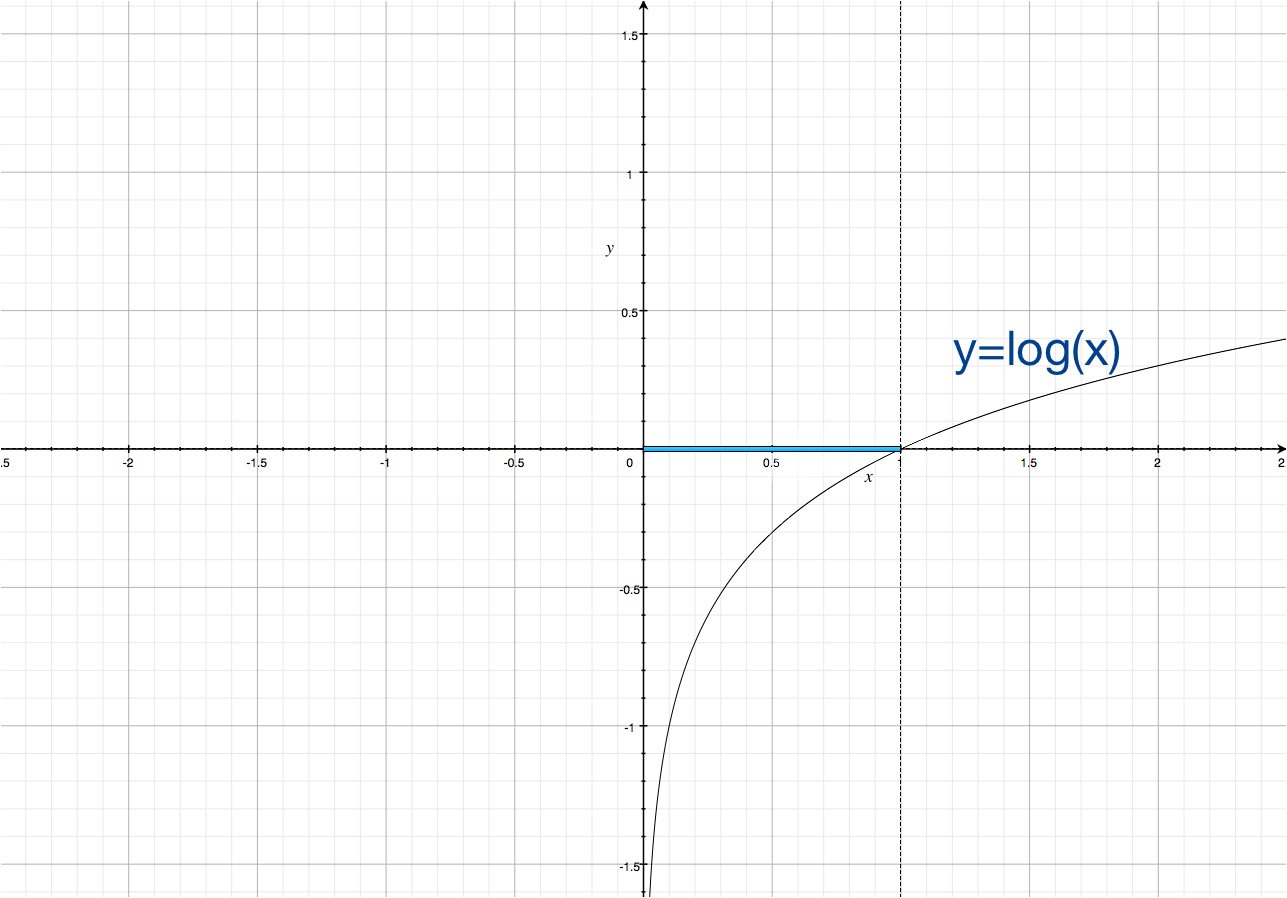

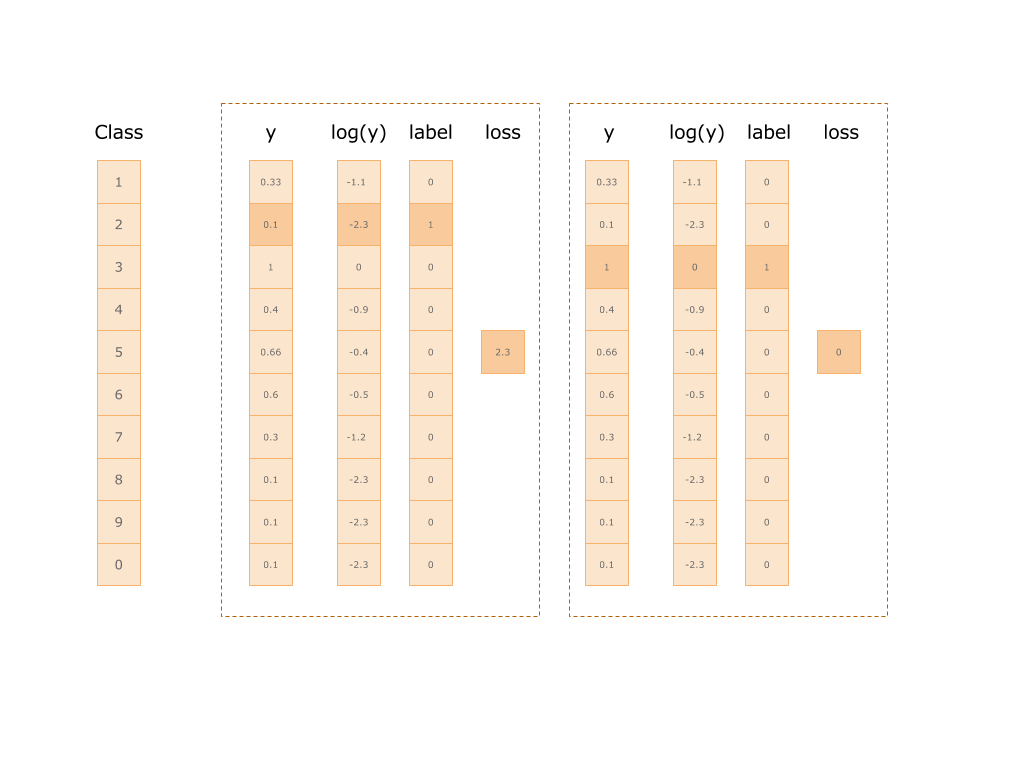

次に、各クラスで取得された予測の大きさの自然対数を取得し、それを正しいクラスのベクトルの値で乗算します。これは、最初にきちんと送信されます(yLabel)。

したがって、エラー値を取得し、それを使用してニューラルネットワークを「非難」できます。 以下に2つの例を示します。 最初のクラス2:エラーは2.3、2番目のクラス1:エラーはゼロです。

let log = try scope.log(operationName: "Log", x: softmax) let mul = try scope.mul(operationName: "Mul", x: yLabels, y: log) let reductionIndices = try scope.addConst(tensor: Tensor(dimensions: [1], values: [Int(1)]), as: "reduction_indices").defaultOutput let sum = try scope.sum(operationName: "Sum", input: mul, reductionIndices: reductionIndices, keepDims: false, tidx: Int32.self) let neg = try scope.neg(operationName: "Neg", x: sum) let meanReductionIndices = try scope.addConst(tensor: Tensor(dimensions: [1], values: [Int(0)]), as: "mean_reduction_indices").defaultOutput let cross_entropy = try scope.mean(operationName: "Mean", input: neg, reductionIndices: meanReductionIndices, keepDims: false, tidx: Int32.self)

次に何をする?

数学的には、目的関数を最小化する必要があります。 1つのアプローチは、勾配降下法です。 必要に応じて、次の記事で彼について話そうとします。

したがって、重み(行列Wの成分)と基底ベクトルbのそれぞれをどの程度修正する必要があるかを計算する必要があります。これにより、ニューラルネットワークはこのような入力データの誤差を小さくします。

数学的には、すべての中間ノードの値によって出力ノードの偏導関数を見つける必要があります。 結果のシンボリックグラディエントにより、変数Wおよびbの各コンポーネントの値を、それらのそれぞれが前の計算の結果にどのように影響したかに従って「シフト」できます。

TensorFlowの魔法。

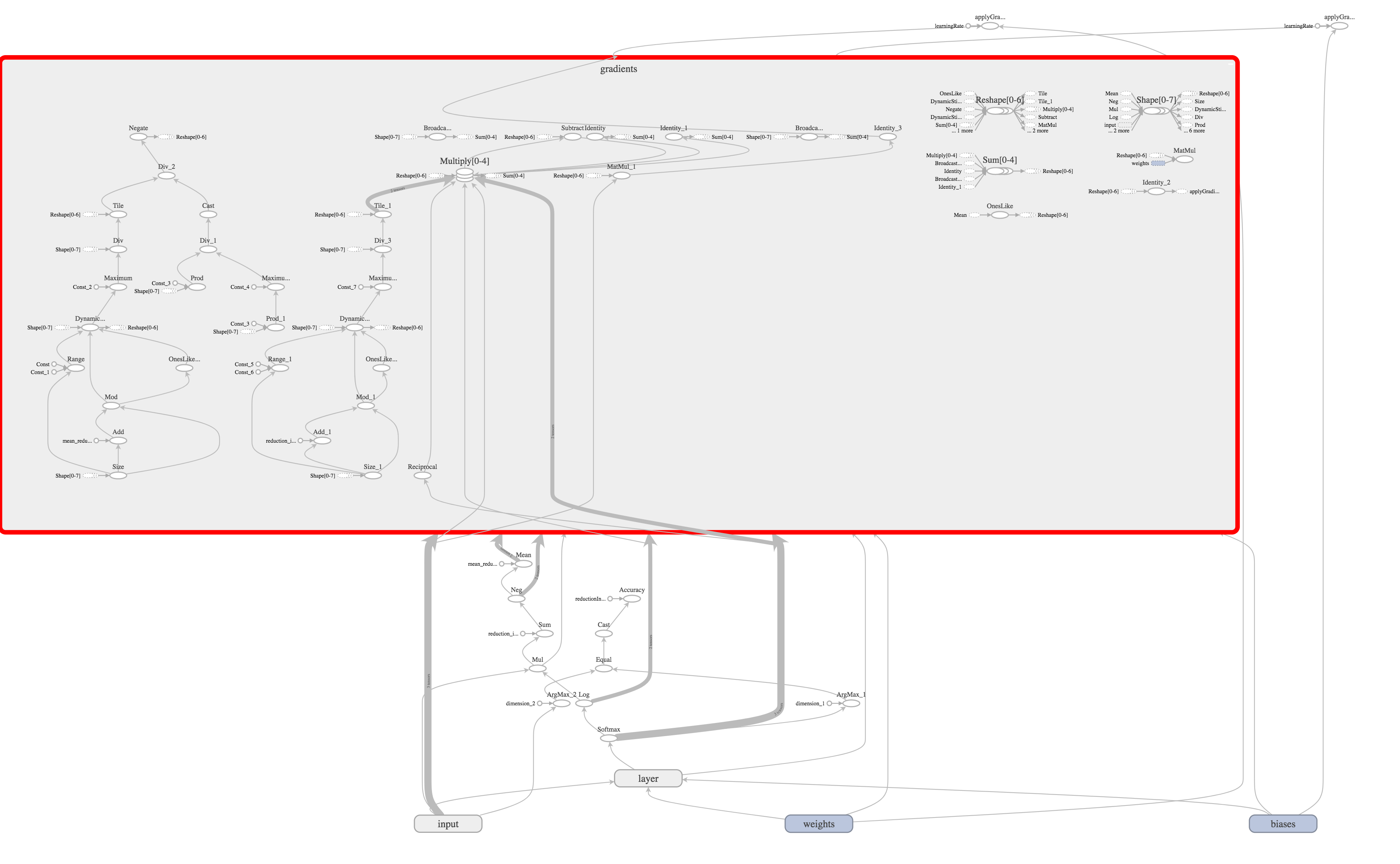

実際、これらの複雑な計算のすべて( 実際には、まだすべてではありません )が、TensorFlowは、作成したグラフを分析することで独立して実行できます。

let gradientsOutputs = try scope.addGradients(yOutputs: [cross_entropy], xOutputs: [weights.variable, bias.variable])

この操作を呼び出した後、TensorFlowはさらに50個の操作を個別に構築します。

これで、先ほど勾配降下法で計算した値に重みの更新操作を追加するだけで十分です。

let _ = try scope.applyGradientDescent(operationName: "applyGradientDescent_W", `var`: weights.variable, alpha: learningRate, delta: gradientsOutputs[0], useLocking: false)

それだけです、カウントの準備ができました!

先ほど言ったように、TensorFlowはモデルと計算を分離します。 したがって、作成したグラフは計算を実行するためのモデルにすぎません。

Sessionを使用して計算を実行できます。

データセットからデータを準備し、それらをテンソルに配置したら、セッションを開始します。

guard let dataset = dataset else { throw MNISTTestsError.datasetNotReady } guard let images = dataset.files(for: .image(stride: .train)).first as? MNISTImagesFile else { throw MNISTTestsError.datasetNotReady } guard let labels = dataset.files(for: .label(stride: .train)).first as? MNISTLabelsFile else { throw MNISTTestsError.datasetNotReady } let xTensorInput = try Tensor(dimensions: [bach, 784], values: xs) let yTensorInput = try Tensor(dimensions: [bach, 10], values: ys)

for index in 0..<1000 { let resultOutput = try session.run(inputs: [x, y], values: [xTensorInput, yTensorInput], outputs: [loss, applyGradW, applyGradB], targetOperations: []) if index % 100 == 0 { let lossTensor = resultOutput[0] let gradWTensor = resultOutput[1] let gradBTensor = resultOutput[2] let wValues: [Float] = try gradWTensor.pullCollection() let bValues: [Float] = try gradBTensor.pullCollection() let lossValues: [Float] = try lossTensor.pullCollection() guard let lossValue = lossValues.first else { continue } print("\(index) loss: ", lossValue) lossValueResult = lossValue print("w max: \(wValues.max()!) min: \(wValues.min()!) b max: \(bValues.max()!) min: \(bValues.min()!)") } }

このコードはGitHubにあります 。

100回の操作ごとに、エラーのサイズを推測します。

新しい記事: TensorFlowKitを使用したニューラルネットワークの学習プロセスの視覚化が公開されました。