さらに、MNISTデータセットのゼロと1の分類では、約80個のサンプルのみを使用して、最も有益な10個の特徴を持つ非常に単純な線形予測子が単純なニューラルネットワークよりも効率的に機能することを示しています。 この記事では、Andrew Beamが反論を書くことを奨励しました。この反論では、適切に訓練されたニューラルネットワークが、非常に少数のサンプルでも、単純な線形モデルを上回りました。

このような論争は、生物医学インフォマティクスの分野でますます多くの研究者がさまざまなタスクに関する詳細なトレーニングを適用しているという事実を背景に行われています。 興奮は正当化されますか、それとも線形モデルで十分ですか? いつものように、単一の答えはありません。 この記事では、ディープニューラルネットワークの使用がまったく意味をなさない機械学習のケースを検討します。 また、私の意見では、特に初心者にとって、ディープラーニングの本当に効果的な使用を妨げる一般的な偏見についても話します。

ディープラーニングの偏見を打ち破る

まず、偏見について話しましょう。 彼らは、ディープラーニングの主題についてあまり知識がなく、実際には半分真実である大多数の専門家にいるように思えます。 2つの非常に一般的なものと、もう1つもう少し技術的な偏見があります。それらについて詳しく説明します。 これは何らかの形で、 Andrew Beamによる記事の The Delusionsの壮大な章の続きです。

ディープラーニングは、小さなサンプルサイズで本当に機能します

綿密なトレーニングは、大量の入力データを効率的に処理することで有名になりました(最初のGoogle Brainプロジェクトでは、多数のYouTubeビデオをネットワークにロードすることを忘れないでください)。それ以来、大量のデータを処理する複雑なアルゴリズムとして常に説明されてきました。 残念ながら、このビッグデータとディープラーニングのペアは、どういうわけか人々を反対の考えに導きました。ディープラーニングは小さなサンプルでは使用できないという神話です。

サンプル数が少ない場合、一見したところサンプルあたりのパラメーターの比率が高いニューラルネットワークを起動することは、再トレーニングへの直接の道のように思えるかもしれません。 ただし、教師の有無にかかわらず、この特定の問題のサンプルサイズとディメンションを単純に考慮することは、コンテキストなしで、真空でデータをモデリングするようなものです。 ただし、このような場合は、関連するデータソースがあるか、この分野の専門家が提供できる説得力のある予備データがあるか、またはデータが非常に具体的な方法(たとえば、グラフや画像の形式)で構成されていることを考慮する必要があります。 これらのすべてのケースで、詳細な学習が有益になる可能性があります。たとえば、より大きな関連データセットの有用な表現をエンコードし、タスクで使用できます。 このような状況の典型的な例は、自然言語処理でよく見られます。ここでは、Wikipediaなどの大規模な語彙の建物に個々の単語を含めることに関する情報を学習し、教師と一緒に教えるときに、より小さくて狭いケースに単語を含めることに関する情報を使用できます。

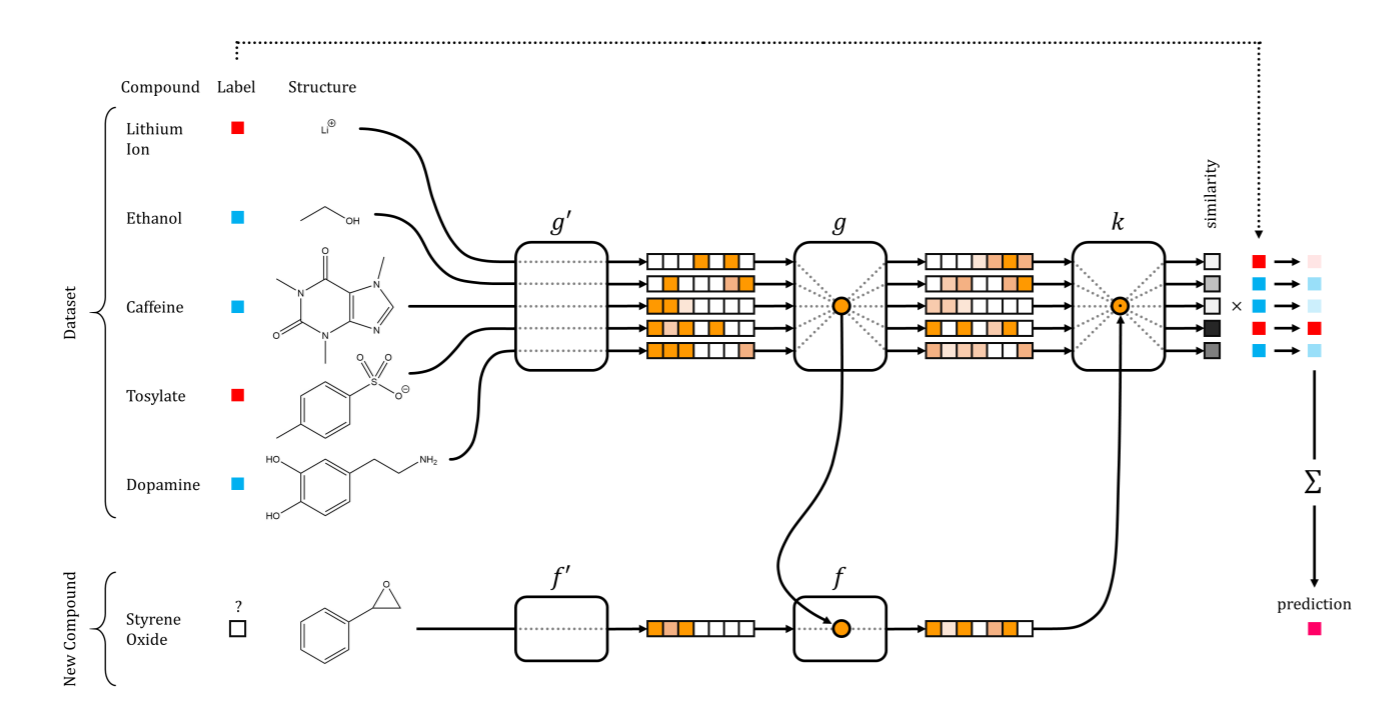

極端な場合、表現を集合的に同化する複数のニューラルネットワークがあり、サンプルの小さなセットでそれを再利用する効果的な方法があります。 これはワンショット学習と呼ばれ、マシンビジョンや新薬の発見など、多次元データを使用してさまざまな分野に適用されています。

新薬の発見における初めてのトレーニングネットワーク。 Altae-Tran et al。の記事のイラスト ACSセント。 科学 2017年

ディープラーニングは、すべての問題に対する普遍的な解決策ではありません。

よく耳にする2番目の誤解は、誇大広告です。 多くの初期開業医は、深いネットワークが生産性の向上を飛躍的に高めることを期待しています。それは単に他の分野で起こるからです。 他の人は、人間に最も近い3種類のデータで、画像、音声、言語学のモデリングと操作におけるディープラーニングの驚くべき成功に感銘を受け、競争力のあるニューラルネットワークの最新のファッショナブルなアーキテクチャを教えようとして、この分野に真っ向から飛び込みます。 このような攪拌は、さまざまな形で現れます。

ディープラーニングは、機械学習における否定できない力であり、あらゆるデータモデル開発者の武器の重要なツールとなっています。 その人気により、TensorFlowやPyTorchなどの重要なフレームワークが作成されました。これらは、詳細なトレーニング以外でも非常に便利です。 弱者からスーパースターへの彼の変革の物語は、進化戦略や強化学習など、以前は理解できないと考えられていた他の方法を改訂する研究者に刺激を与えました。 しかし、これは決して万能薬ではありません。 景品がないことを考えることに加えて、原則として、ディープラーニングモデルには重要なニュアンスがあり、慎重な取り扱いが必要な場合があり、場合によってはハイパーパラメーター、設定、およびテストの非常に高価な検索を行うことができます(詳細については、以下の記事を参照してください)。 さらに、実用的な観点からはディープラーニングが意味をなさないことが多く、単純なモデルの方がはるかに優れている場合が多くあります。

ディープラーニングは.fit()

以上のもの.fit()

ディープラーニングモデルには別の側面があります。これは、私の観察によれば、機械学習の他の領域の観点から誤解されています。 ほとんどのディープラーニングの教科書と入門資料では、これらのモデルはノードの階層的に関連するレイヤーで構成されていると説明しています。最初のレイヤーは入力信号を受け取り、最後のレイヤーは出力信号を生成し、何らかの確率的勾配降下法を使用してそれらをトレーニングできます。 確率的勾配降下がどのように機能し、エラーの逆伝播が何であるかについて簡単に言及されることがあります。 しかし、説明の大部分は、さまざまな種類のニューラルネットワーク(畳み込み、反復など)に当てられています。 最適化手法自体にはほとんど注意が払われていませんが、これはディープラーニングネットワークの作業の重要な(最も重要でないとしても)部分を表しているため、またこれらの特定の手法に関する知識(たとえば、 Ferenc Khuzharと彼の科学者 によるこの記事を読んでください)そこに記載されている記事 )、およびこれらのメソッドのパラメーターを最適化する方法と、それらを効果的に使用するためにデータを分離する方法に関する知識は、妥当な時間で良好な収束を得るために非常に重要です。

確率的勾配が非常に重要である理由はまだ不明ですが、あちこちの専門家がこの主題について異なる仮定をしています。 私のお気に入りの1つは、ベイジアン推論の計算の一部としてこれらの方法を解釈することです。 実際、何らかの数値最適化を実行するたびに、特定の仮定でベイジアン出力を計算します。 最終的に、 確率的数値と呼ばれる領域全体があり、文字通りそのような解釈から生まれました。

確率的勾配降下法(SGD)も違いはなく、 最近の科学的研究では、この手順は実際にはマルコフ連鎖であり、特定の仮定の下では定常分布を示し、事後確率に対する一種の変分近似と見なすことができることが示唆されています。 したがって、SGDを停止して最終パラメーターを受け入れると、実際にはこの近似分布からサンプルを取得します。

この考えは非常に明るいように思えました。 オプティマイザーのパラメーター(この場合は学習速度)の意味が大きくなったため、多くのことが説明されています。 そのような例:確率的勾配降下で学習速度パラメーターをどのように変更すれば、マルコフ連鎖は広い領域でサンプルをカバーする広い局所最小値を見つけるまで不安定になりますか? したがって、プロシージャの分散を増やします。 一方、学習率が低下すると、マルコフ連鎖は非常に狭い領域に収束するまで、より狭い局所的最小値にゆっくりと近づきます。 この方法で、特定の領域への傾きを増やします。

SGDのもう1つのパラメーターであるバッチサイズは、アルゴリズムがどのタイプの領域で収束するかを制御します。小さなパッケージの場合はより広い領域、大きなパッケージの場合はよりシャープな領域です。

SGDは、学習速度またはパケットサイズに応じて、広いまたは狭いローカル最小値を優先します

このような複雑さは、ディープニューラルネットワークオプティマイザーが前面に出ていることを意味します。これは、モデルのコアであり、レイヤーアーキテクチャと同じくらい重要です。 他の多くの機械学習モデルにはありません。 線形モデル(LASSOなどの正則化も)とSVMは、そのような微妙さを持たず、1つの解決策しか持たない凸最適化問題です。 これが、他の分野から来た専門家やscikit-learnなどのツールを使用する専門家が

.fit()

メソッドで非常に単純なAPIを見つけることができない理由を理解できない理由

.fit()

単純なニューラルネットワークをシグネチャに還元しようとするskflowなどのツールがいくつかありますが

.fit()

.fit()

ですが、ディープラーニングの意味はその柔軟性であるため、このアプローチは少し間違っているようです。

ディープラーニングを使用しない場合

ディープラーニングが問題を解決する最良の方法ではないのはいつですか? 私の観点から、ディープラーニングが障害となる可能性が高い主なシナリオを以下に示します。

低予算または軽微な問題

ニューラルネットワークは非常に柔軟なモデルであり、多くのアーキテクチャとノードタイプ、オプティマイザー、および正則化戦略を備えています。 アプリケーションに応じて、モデルには畳み込み層(幅はどのくらいですか?どのプーリングがありますか?)または反復構造(ゲートの有無はありますか)があります。 本当に深い(砂時計、シャム、または他の多くのアーキテクチャのいずれか)か、いくつかの隠されたレイヤー(使用するブロックの数)だけがあります。 線形整流ユニットまたはその他のアクティベーション機能が含まれる場合があります。 ドロップアウトを介してトレーニング中にニューロンの一部をオフにすることができます(どのレイヤーで何個のニューロンをオフにしますか?)そして、おそらく重み(l1、l2またはもっと奇妙なもの)を注文する必要があります。 これは完全なリストではなく、他の多くの種類のノード、リンク、さらには損失関数さえあります-これらはすべてテストできます。

大規模なニューラルネットワークの1つのインスタンスをトレーニングする場合でも、このような多数の可能なハイパーパラメーターとアーキテクチャを体験するには多くの時間がかかります。 Googleは最近、そのAutoMLパイプラインが自動的に最適なアーキテクチャを選択できることを自慢しました。これは非常に印象的ですが、数週間24時間動作するために800以上のGPUも必要であり、これはすべての人が利用できるわけではありません。 結論として、ディープニューラルネットワークの学習は、コンピューティングとデバッグの両方で費用がかかるということです。 このようなコストは、毎日の予測問題を解決するのに意味がないため、このような問題のニューラルネットワークROIは、小さなニューラルネットワークをセットアップする場合でも小さすぎる場合があります。 大きな予算と重要なタスクがある場合でも、最初のレベルとして最初に代替方法を試さない理由はありません。 本当に必要なのは線形SVMだけであることに驚くかもしれません。

モデルパラメータと属性の幅広い対象者の解釈と説明

ディープニューラルネットワークは、予測効率は高いが解釈性が低い「ブラックボックス」としても有名です。 最近ではありますが、顕著なカードやアクティベーションの違いなど、多くのツールが作成されています。 いくつかの分野でうまく機能しますが、すべてのアプリケーションに適用できるわけではありません。 基本的に、これらのツールは、データセットを記憶したり、特定のダミーサインを処理したりして、ニューラルネットワークにだまされていないことを確認する場合に役立ちます。 しかし、ニューラルネットワークの全体的なソリューションに対する各特性の寄与を解釈することは依然として困難です。

そのような条件では、取得した係数が結果に直接関連するため、線形モデルと比較することはできません。 これは、そのような解釈を幅広い聴衆に説明する必要がある場合に特に重要であり、それはそれらに基づいて重要な決定を下します。 たとえば、医師は診断を得るためにあらゆる種類の異なるデータを統合する必要があります。 変数と結果の関係が単純で明確であればあるほど、医師はこの変数をより適切に考慮でき、その値を過小評価または過大評価する可能性を排除できます。 さらに、モデルの精度よりも解釈可能性のほうが重要な場合があります(通常、ディープラーニングの精度は比類のないものです)。 そのため、議員は、たとえば死亡率など、一部の人口統計学的変数がどのような影響を与えるかについて関心を持つ場合があります。 そして、彼らは予測精度よりも直接近似に興味があるかもしれません。 どちらの場合も、ディープラーニングは、よりシンプルで透過的なネットワークに劣ります。

因果関係の決定

モデルの解釈可能性の極端なケースは、機械的モデル、つまりデータの背後にある現象を実際にキャプチャするモデルを定義しようとする場合です。 良い例は、特定の細胞環境で2つの分子(薬物、タンパク質、核酸など)がどのように反応するかを予測する試みです。 または、特定のマーケティング戦略が販売にどのように影響するかを仮定します。 この分野の専門家によると、実際には、古き良きベイジアン手法と競合できるものはありません。 これは、因果関係に関する結論を提示し、引き出すための最良の方法です(理想的ではありませんが)。 Vicariousは最近、 優れた研究論文を発表しました 。 ビデオゲームの問題において、このようなより原則的なアプローチがディープラーニングよりも優れた一般化をもたらす理由を示しています。

「非構造化」標識に関するトレーニング

おそらくこれは議論の余地のある点です。 ディープラーニングが効果的に機能する分野が1つあることがわかりました。 これは、特定のタスクに役立つデータ表現の検索です。 非常に良い例は、前述の単語を含めることです。 自然言語は豊かで複雑な構造を持ち、コンテキストを考慮したニューラルネットワークを使用して近似できます。各単語は、その単語が最も頻繁に使用されるコンテキストをエンコードするベクトルとして表されます。 単語の大きなコーパスに対するトレーニングの結果として得られた単語の包含に関する情報を使用すると、自然言語の処理は、別の単語のコーパスに対する特定のタスクで大幅に高い効率を示すことがあります。 ただし、ケースが完全に構造化されていない場合、このモデルはまったく役に立ちません。

非構造化キーワードリストを調べてオブジェクトを分類しようとしているとします。 キーワードは特定の構造(文など)で使用されないため、ここに単語を含めることが大いに役立つとは考えられません。 この場合、データは「単語の袋」型モデルです。 このような表現は、タスクを完了するのに十分である可能性があります。 ただし、事前にトレーニングされたモデルを使用すると、単語を含めることは比較的簡単に計算でき、キーワードの類似性をより適切に把握できると主張できます。 しかし、私はまだ言葉の袋の形でプレゼンテーションを開始し、彼女が良い予測をすることができるかどうかを確認したいと思います。 結局のところ、ワードバッグの各ディメンションは、対応するワードインクルージョンレイヤーよりも簡単に解釈できます。

未来は深い

ディープラーニングの分野は増加しており、資金も豊富で、驚くほど急速に成長しています。 会議で発表された科学論文を読む頃には、この記事に基づいて改良されたモデルが2〜3回繰り返される可能性があります。 重要な警告は、上で述べたすべての議論に関連しています。実際、近い将来、詳細なトレーニングは、言及されたすべてのシナリオに非常に役立つことが判明する可能性があります。 画像や個々の文章のディープラーニングモデルを解釈するためのツールが改善されています。 エドワードのような最新のソフトウェアは、ベイジアンモデリングとディープニューラルネットワークフレームワークを組み合わせており、ニューラルネットワークパラメーターの不確実性を定量化し、確率的プログラミングと自動変分推論を使用して単純なベイジアン推論を実装できます。 長期的には、モデリングのための語彙の削減が期待できます。これにより、ニューラルネットワークが持つ可能性のある顕著な特性がキャプチャされ、試行されるべきパラメーターのスペースが削減されます。 したがって、arXivフィードを確認することを忘れないでください。この記事は1〜2か月で古くなる可能性があります。

Edwardは確率的プログラミングとTensorFlowを組み合わせて、ディープラーニングとベイジアン手法を同時に使用するモデルの作成を可能にします。 イラスト:Tran et al。 ICLR 2017