リカレントニューラルネットワーク

人々は毎秒ゼロから考え始めるわけではありません。 この投稿を読むと、前の単語の理解に基づいて、すべての単語を理解できます。 私たちはすべてを頭から捨てず、ゼロから考え始めません。 私たちの考えは一定です。

従来のニューラルネットワークにはこの特性がなく、これが主な欠点です。 たとえば、映画で起こっている出来事を分類したいとします。 従来のニューラルネットワークがフィルム内の以前のイベントに関する推論を使用して、後続のイベントに関する情報を取得する方法は不明です。

リカレントニューラルネットワーク(RNN)は、この問題の解決に役立ちます。 これらはフィードバックを含み、情報の保存を可能にするネットワークです。

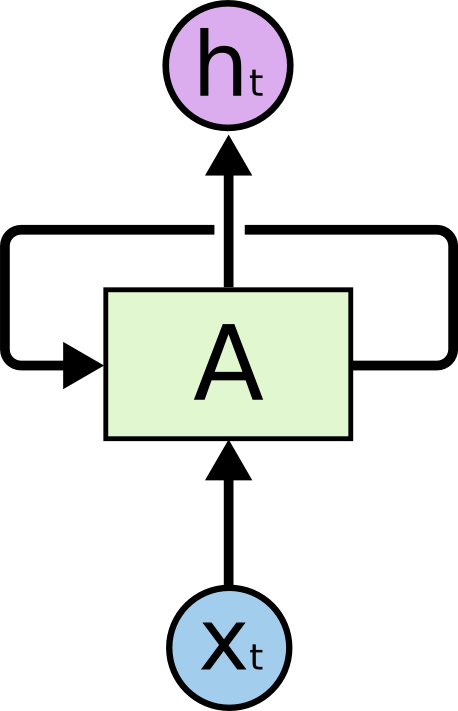

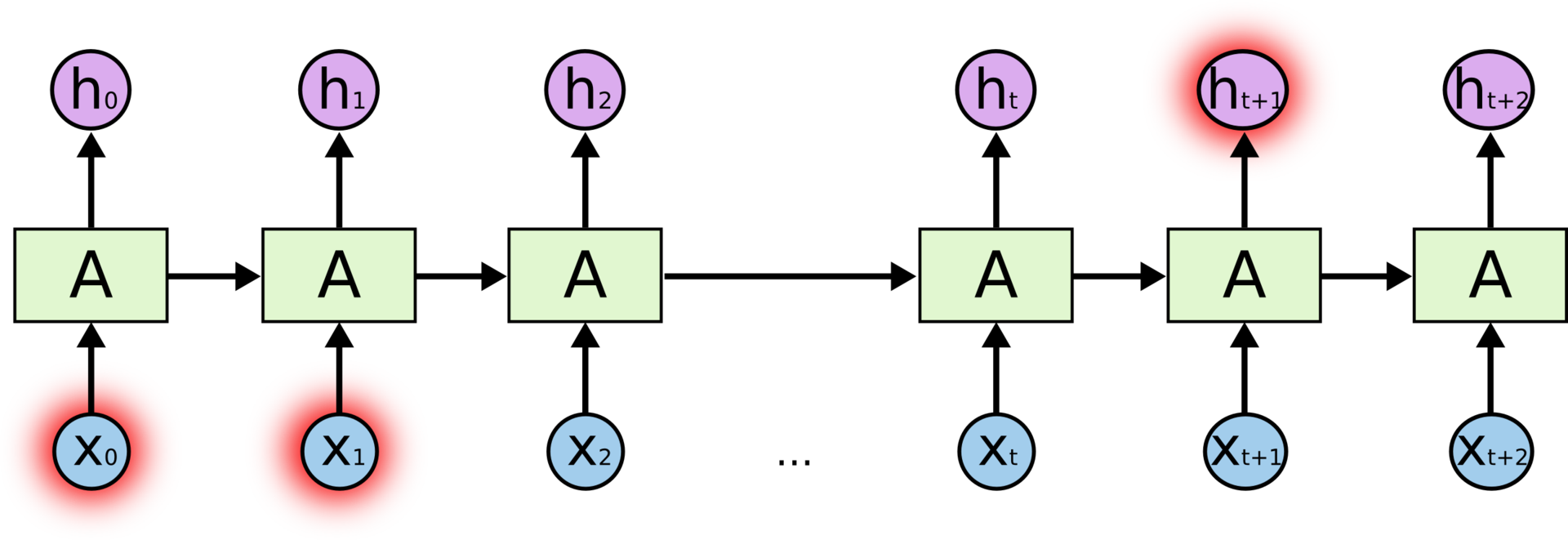

再帰的ニューラルネットワークにはフィードバックが含まれています。

上の図では、ニューラルネットワークの断片 入力値を取る そして値を返します 。 フィードバックがあると、ネットワークのあるステップから別のステップに情報を転送できます。

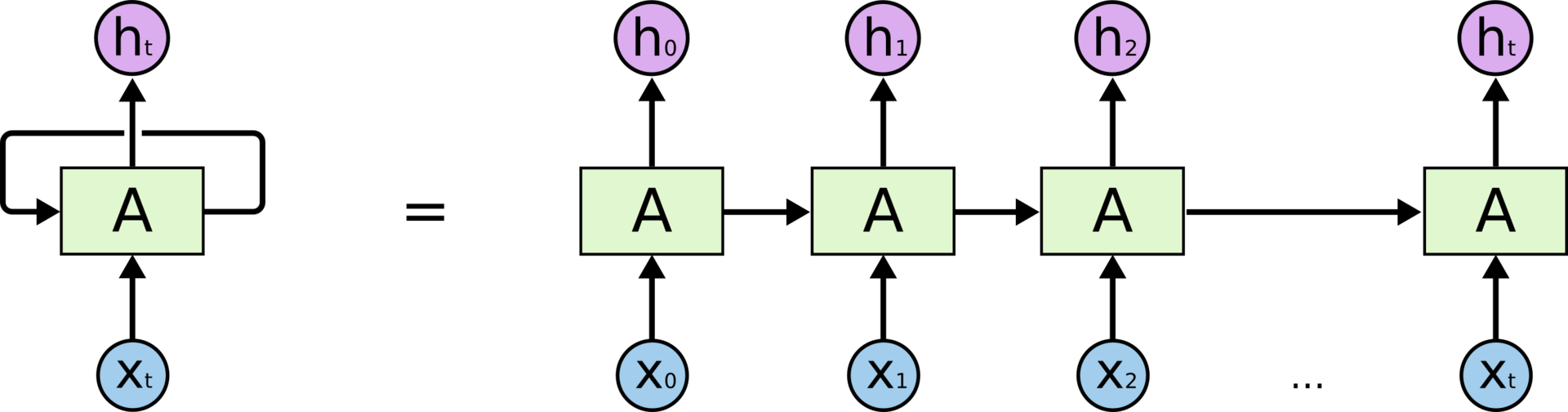

フィードバックは、リカレントニューラルネットワークにいくつかの謎を追加します。 ただし、考えてみると、通常のニューラルネットワークとそれほど違いはありません。 リカレントネットワークは、同じネットワークの複数のコピーと見なすことができ、それぞれが後続のコピーに情報を転送します。 フィードバックを展開すると、次のようになります。

スキャンニューラルネットワーク

RNNがチェーンに似ているという事実は、それらがシーケンスとリストに密接に関連していることを意味します。 RNNは、このタイプのデータを操作するための最も自然なニューラルネットワークアーキテクチャです。

そしてもちろん、それらはそのようなタスクに使用されます。 過去数年にわたり、RNNは、音声認識、言語モデリング、翻訳、画像認識などの多くのタスクで非常に成功を収めてきました。リストは続きます。 RNNで達成できるのは、 The Rereasonable Effectiveness of Recurrent Neural Networksの Andrej Karpathyによる素晴らしいブログ投稿です 。

これらの成功における重要な役割はLSTMに属します。これは、リカレントニューラルネットワークの異常な変更であり、多くのタスクで標準バージョンを大幅に上回っています。 印象的なRNNの結果のほぼすべてがLSTMで達成されました。 それらは私たちの記事の主題です。

長期的な依存関係の問題

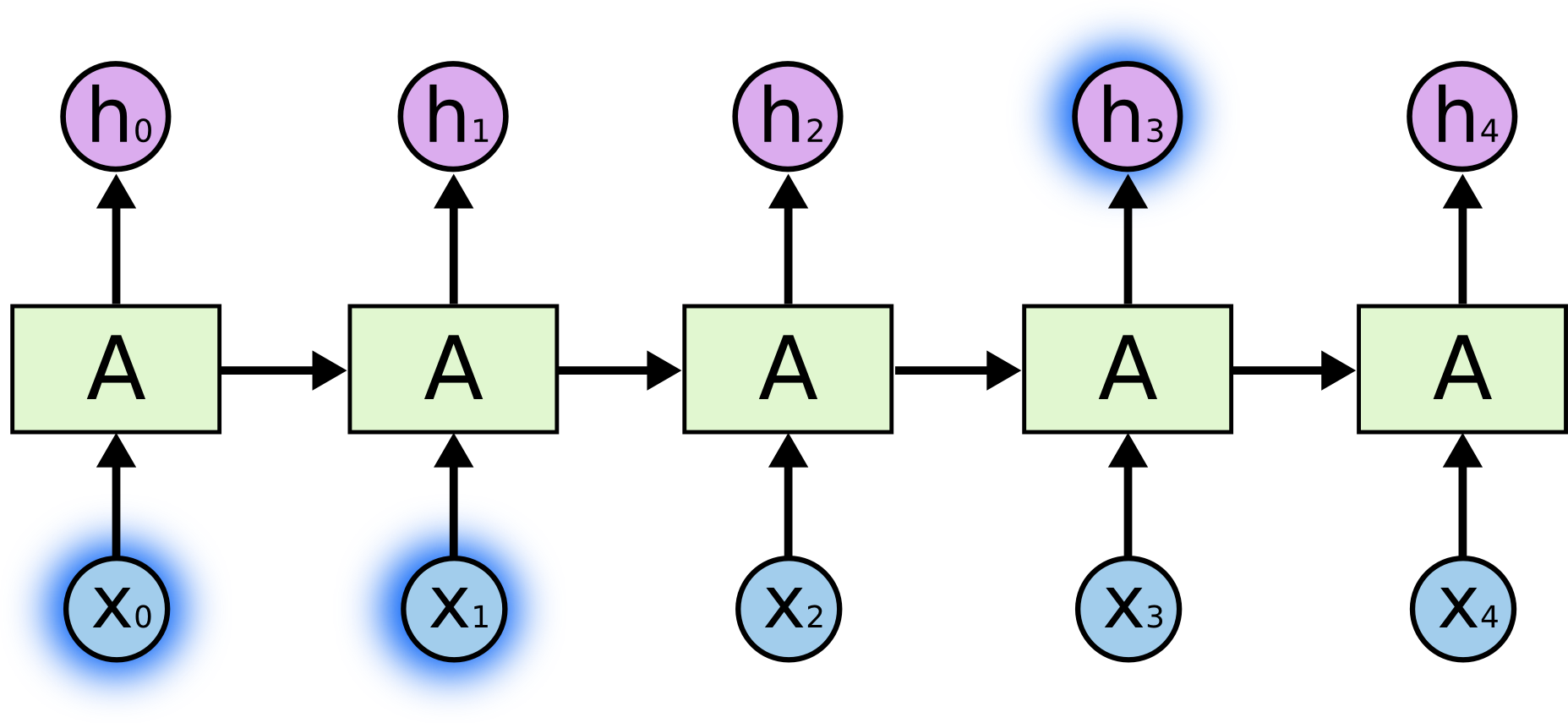

RNNの魅力的なアイデアの1つは、以前の情報を現在のタスクに関連付ける方法を潜在的に知っていることです。たとえば、ビデオの前のフレームの知識は現在のフレームの理解に役立ちます。 RNNにこの機能があれば、非常に便利です。 しかし、RNNは本当にそのような機会を与えてくれるのでしょうか? 状況によって異なります。

現在のタスクを完了するために、最近の情報のみが必要な場合があります。 たとえば、前の単語に基づいて次の単語を予測しようとする言語モデルを考えてみましょう。 「雲が空に浮かんでいる」という文の最後の単語を予測したい場合、より広いコンテキストは必要ありません。 この場合、最後の言葉が「天国」であることは明らかです。 この場合、関連情報とそれが必要な場所との距離が短い場合、RNNは過去の情報の使用を学習できます。

しかし、より多くのコンテキストが必要な場合があります。 「私はフランスで育ちました... フランス語を流 speakに話します」というテキストの最後の単語を予測したいとします。 直近の文脈は、最後の言葉が言語の名前になることを示唆しているが、どの言語を確立するにはより遠い過去のフランスの文脈が必要である。 したがって、関連情報とその適用ポイントとのギャップは非常に大きくなる可能性があります。

残念ながら、この距離が長くなると、RNNは情報をバインドする能力を失います。

理論的には、RNNには長期依存関係の処理に問題はないはずです。 このタイプの人為的な問題を解決するために、ネットワークパラメータを慎重に選択できます。 残念ながら、実際には、これらのパラメーターを使用してRNNを学習することは不可能に思えます。 この問題は、Sepp Hochreiter( Sepp Hochreiter、1991 )およびYoshua Bengio et al。(1994)によって詳細に調査されました。 彼らは、これが難しいのは否めない理由を見つけました。

幸いなことに、LSTMはそのような問題を知りません!

LSTMネットワーク

長期短期記憶(LSTM)は、リカレントニューラルネットワークの特別な種類のアーキテクチャであり、長期的な依存関係を学習できます。 1997年にSepp HochreiterとJürgenSchmidhuberによって紹介され、その後、改良され、他の多くの研究者の研究で一般的に発表されました。 それらは多くのさまざまな問題を完全に解決し、現在広く使用されています。

LSTMは、長期的な依存症の問題を回避するために特別に設計されています。 情報を長期間保存することは通常の動作であり、学習に苦労しているものではありません。

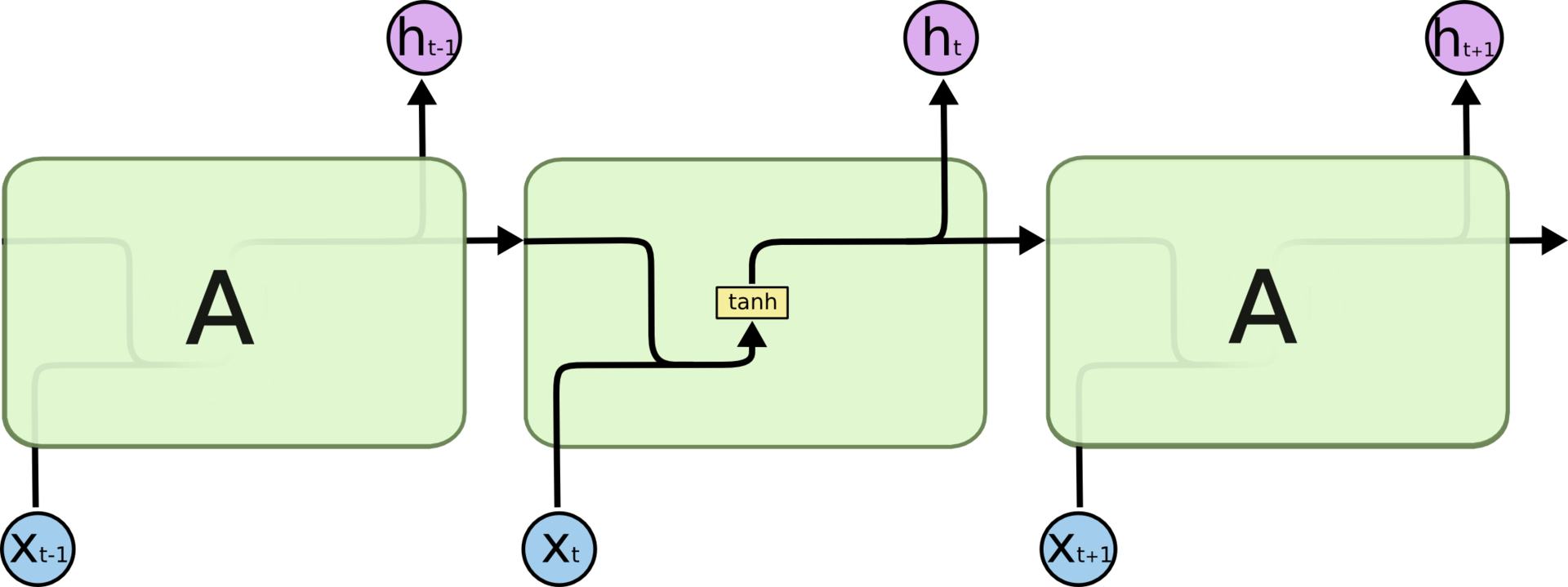

リカレントニューラルネットワークは、ニューラルネットワークの繰り返しモジュールのチェーンの形をしています。 従来のRNNでは、このようなモジュールの構造は非常に単純です。たとえば、tanh活性化機能(双曲線正接)を備えた単一の層にすることができます。

標準RNNの繰り返しモジュールは1つのレイヤーで構成されます。

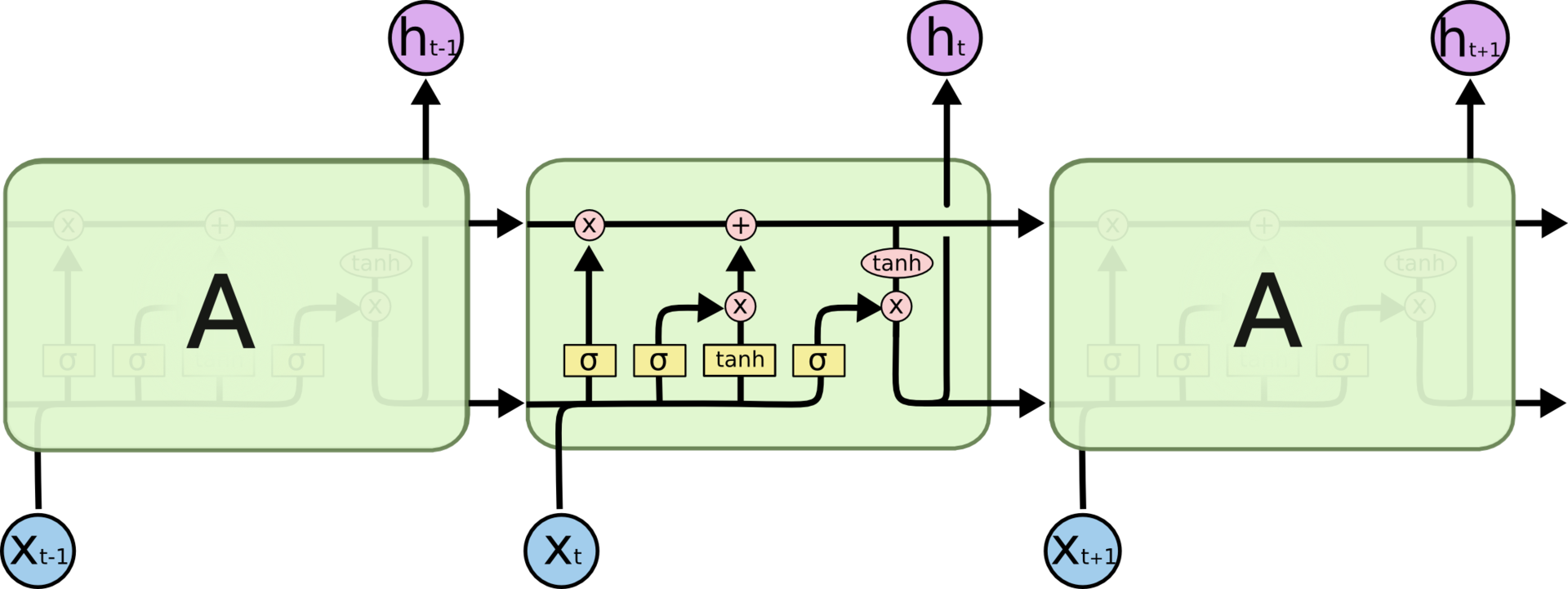

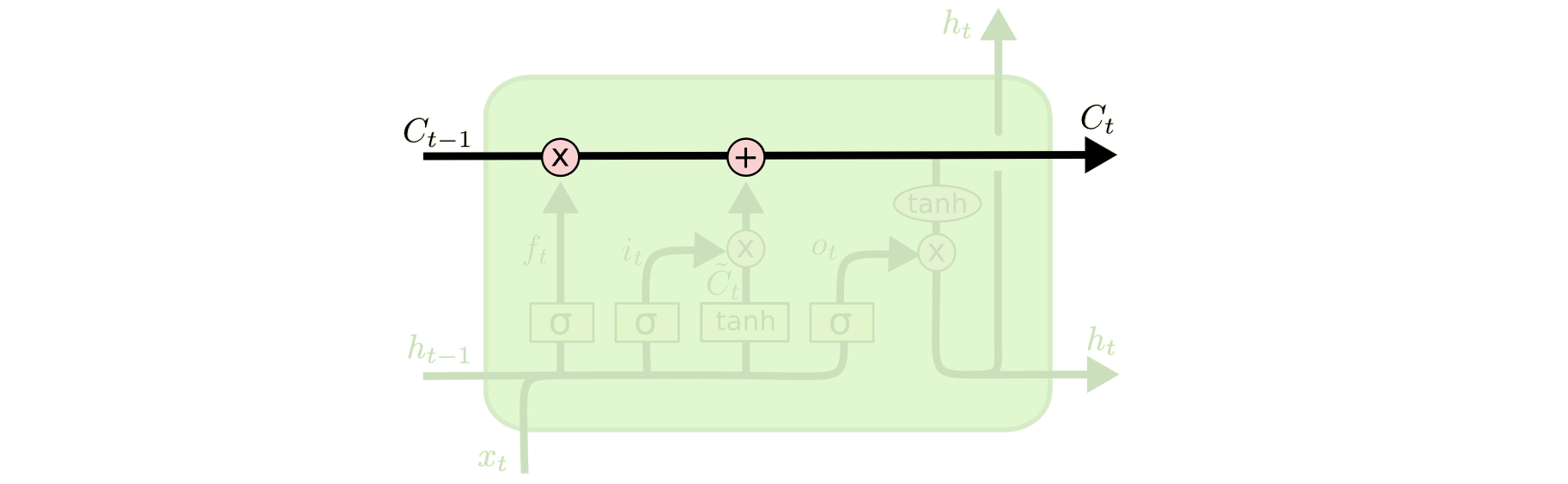

LSTM構造もチェーンに似ていますが、モジュールは異なって見えます。 ニューラルネットワークの1つの層の代わりに、最大4つの層が含まれ、これらの層は特別な方法で相互作用します。

LSTMネットワークの繰り返しモデルは、相互作用する4つのレイヤーで構成されます。

今のところ、詳細に困惑することはありません。 後でLSTMスキームの各ステップを検討してください。 とりあえず、これから使用する特別な表記法について理解しましょう。

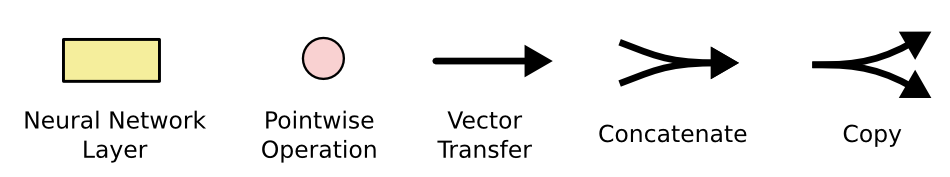

ニューラルネットワーク層。 ポイントツーポイント手術; ベクトル転送; 協会; コピー。

上の図では、各行は1つのノードの出力から別のノードの入力までのベクトル全体を保持しています。 ピンクの円はベクトルの追加などの点ごとの操作を示し、黄色の長方形はニューラルネットワークの訓練された層です。 マージ線はマージを意味し、分岐矢印はデータがコピーされ、コピーが異なるネットワークコンポーネントに移動することを示します。

LSTMの主なアイデア

LSTMの重要なコンポーネントは、セルの状態(回路の上部に沿って走る水平線)です。

セルの状態は、コンベアベルトに似ています。 チェーン全体を直接通過し、わずかな線形変換にのみ参加します。 情報は変更されずに簡単に流れることができます。

ただし、LSTMはセルの状態から情報を削除できます。 このプロセスは、ゲートと呼ばれる構造によって管理されます。

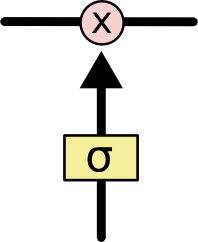

フィルタを使用すると、いくつかの条件に基づいて情報をスキップできます。 これらは、シグモイドニューラルネットワーク層と点ごとの乗算演算で構成されています。

S字型レイヤーは、0から1までの数値を返します。これは、ネットワークでさらにスキップする情報の各ブロックの割合を示します。 この場合のゼロは「何もスキップしない」ことを意味し、ユニットは「すべてをスキップする」ことを意味します。

LSTMには、セルの状態を保護および制御できるこのようなフィルターが3つあります。

LSTMウォークスルー

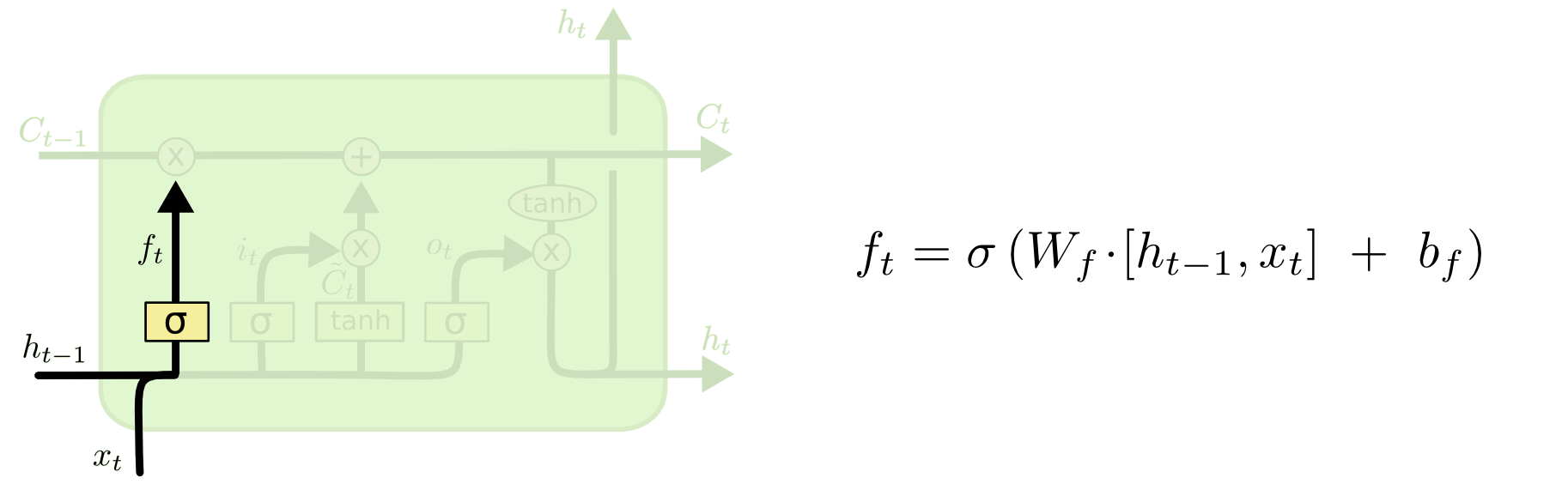

LSTMの最初のステップは、セルの状態から破棄できる情報を決定することです。 この決定は、「ゲート層を忘れる」と呼ばれるシグモイド層によって行われます。 彼は見ている そして セルの状態からの各数値に対して0から1の数値を返します 。 1は「完全に保存」を意味し、0は「完全に破棄」を意味します。

前のすべての単語に基づいて次の単語を予測する言語モデルの例に戻りましょう。 この場合、対応する種類の代名詞を使用するには、セルの状態で名詞を保存する必要があります。 新しい名詞を見ると、古い名詞の性別を忘れることができます。

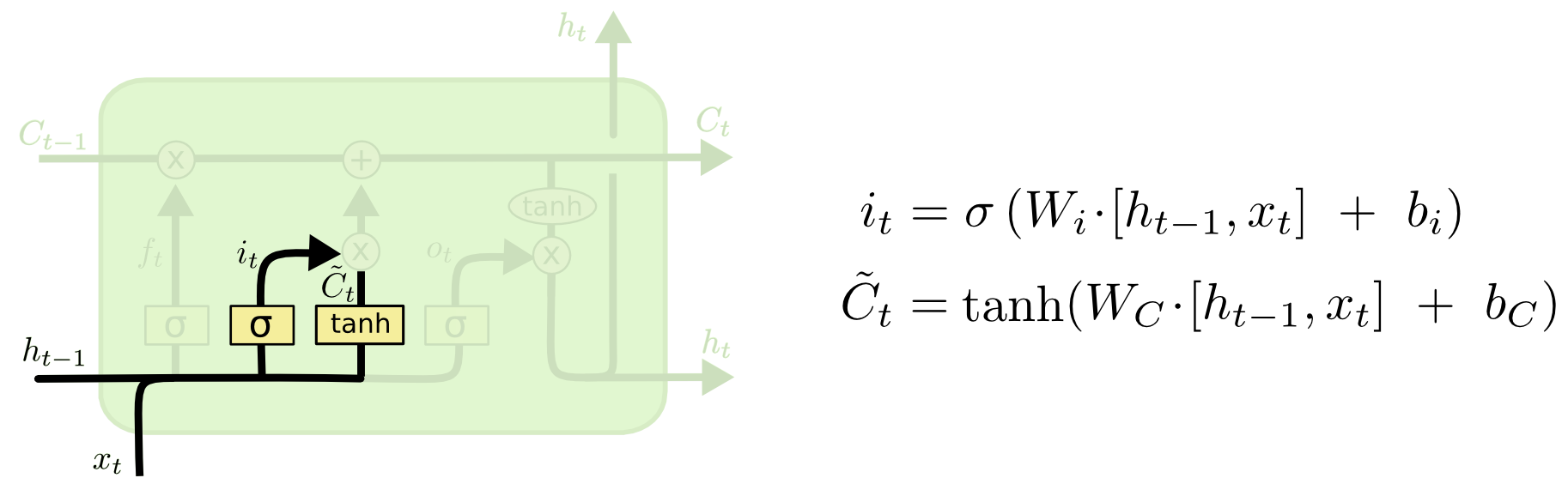

次のステップでは、セル状態に保存する新しい情報を決定します。 このフェーズは2つの部分で構成されています。 まず、「入力レイヤーゲート」と呼ばれるS字型レイヤーが、更新する値を決定します。 次に、tanhレイヤーは新しい候補値のベクトルを構築します セルの状態に追加できます。

言語モデルの例では、このステップで、新しい名詞の性別を追加して、古い名詞を置き換えます。

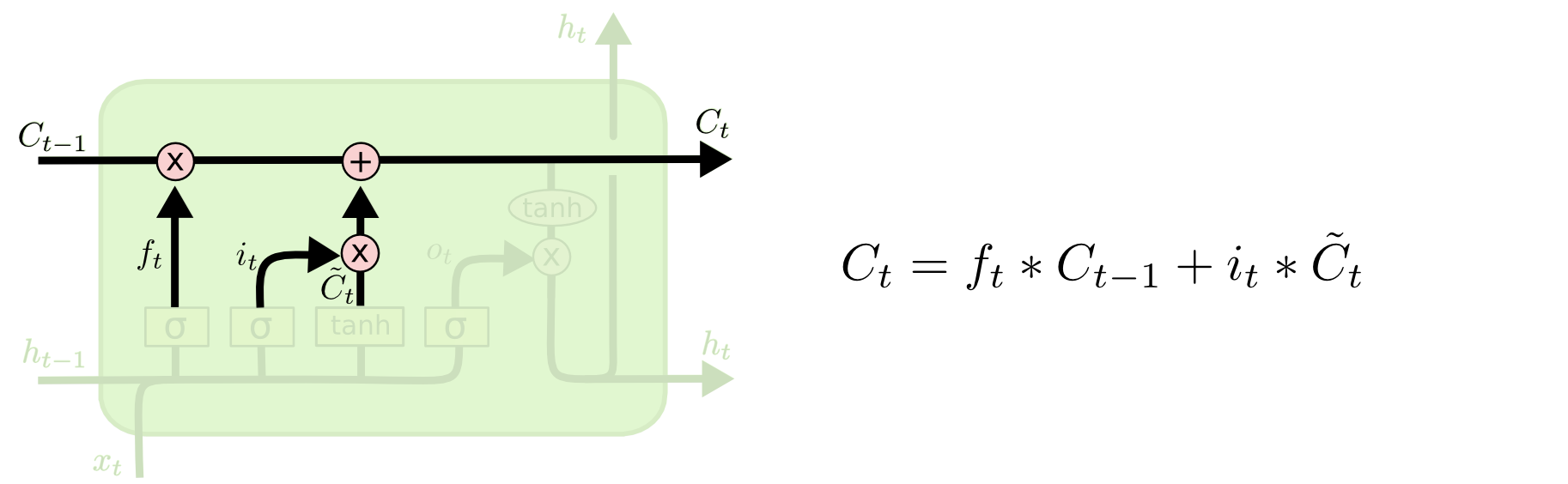

セルの古い状態を置き換える時です 新しい状態へ 。 私たちがする必要があること-私たちはすでに前のステップを決定しました、これを達成することだけが残っています。

古い状態に乗算します 忘れようと決めたものを忘れる。 次に追加します 。 これらは、新しい候補値に乗算されます -各ステータス値をどれだけ更新したいか。

私たちの言語モデルの場合、これは古い名詞の性別に関する情報を捨て、新しい情報を追加する瞬間です。

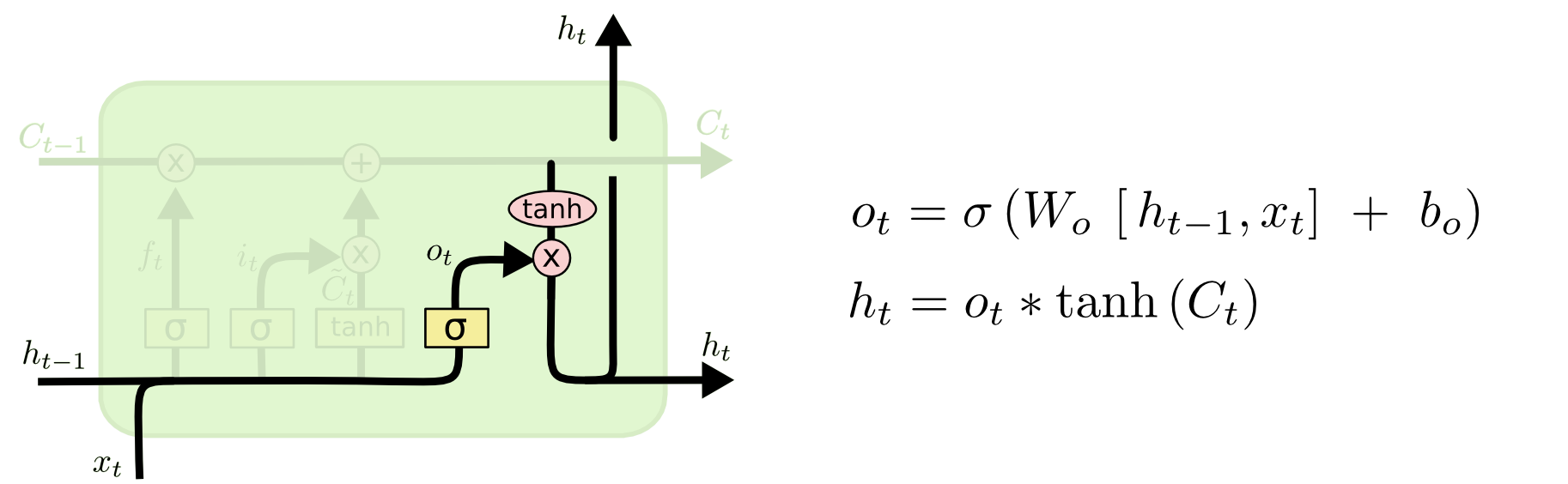

最後に、出力で受け取る情報を決定する必要があります。 出力はセルの状態に基づき、いくつかのフィルターが適用されます。 最初に、シグモイド層を適用します。これは、セルの状態からどの情報を出力するかを決定します。 次に、セルの状態値はtanhレイヤーを通過して-1から1の範囲の出力値を取得し、シグモイドレイヤーの出力値と乗算されます。これにより、必要な情報のみを表示できます。

言語モデルに名詞を発見させ、それに続く動詞にとって重要な情報を表示させたい場合があります。 たとえば、後続の動詞の形式を正しく判別するために、名詞が単数形か複数形かを推測できます。

LSTMのバリエーション

通常のLSTMを確認しました。 ただし、すべてのLSTMが同じというわけではありません。 一般に、LSTMに関するすべての新しい作業では、独自のバージョンのLSTMを使用しているようです。 それらの違いはわずかですが、それらのいくつかは言及する価値があります。

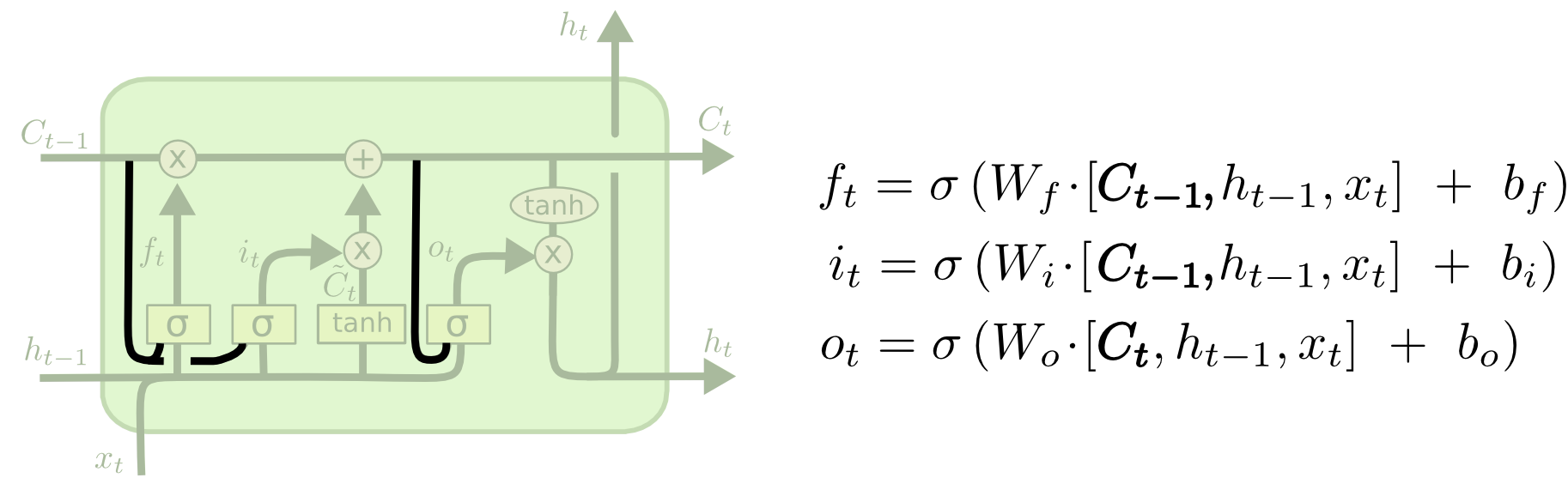

Gers&Schmidhuber(Gers&Schmidhuber、2000)によって提案された人気のあるLSTMバリエーションの1つは、いわゆる「ピープホール接続」の追加によって特徴付けられます。 彼らの助けを借りて、フィルター層はセルの状態を見ることができます。

上の図では、各レイヤーに「目」がありますが、多くの作品では、一部のレイヤーにのみ追加されています。

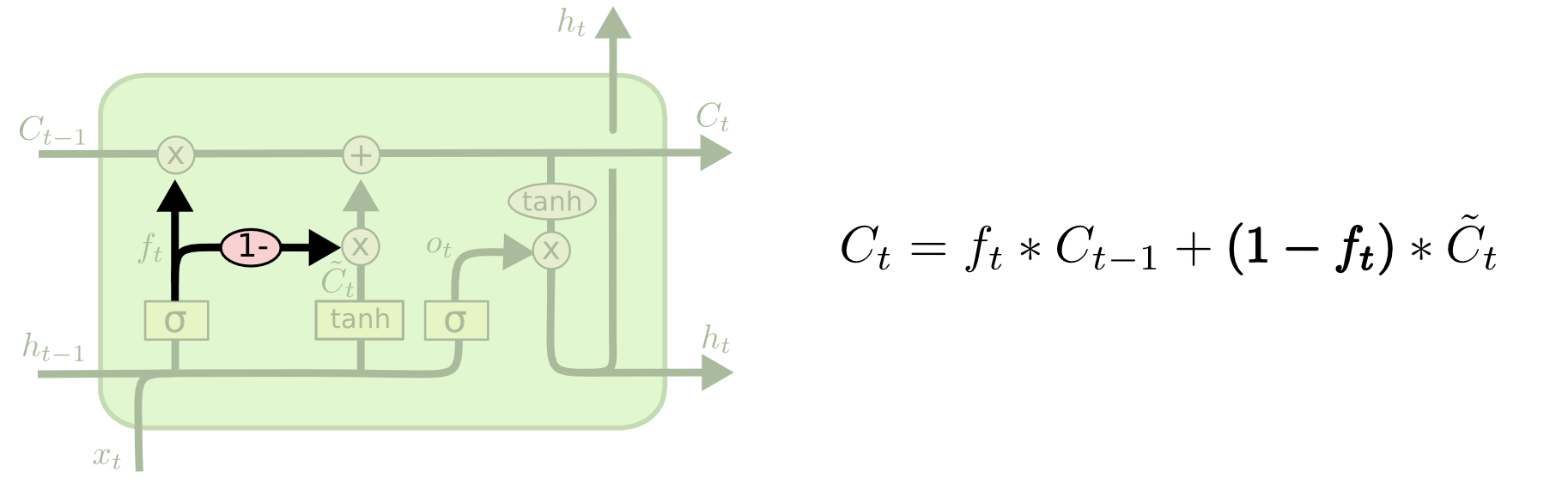

その他の変更には、統合された忘却フィルターと入力フィルターが含まれます。 この場合、どの情報を忘れ、どの情報を記憶するかについての決定は、別々ではなく、共同で行われます。 情報を忘れるのは、その場所に何かを書く必要があるときだけです。 古い情報を忘れた場合にのみ、セルの状態に新しい情報を追加します。

Cho等(2012)で最初に説明されたゲート付き反復ユニット(GRU)は、標準のLSTMよりも若干異なります。 その中で、「忘却」とエントリーのフィルターは、1つのフィルター「更新」(更新ゲート)に結合されます。 さらに、セルの状態は非表示状態と組み合わされ、他の小さな変更があります。 結果として得られるモデルは、標準のLSTMよりも単純であり、その人気は着実に高まっています。

LSTMの最も注目に値するバリエーションのごく一部のみを調査しました。 Yao、et al(2015)によって提示された深層制御リカレントニューラルネットワーク(Depth Gated RNN)など、他の多くの変更があります。 長期的な依存関係の問題を解決する方法は他にもあります。たとえば、 Jan Kutnikの Clockwork RNN (Koutnik、et al。、2014)などです。

最良の選択肢は何ですか? それらの違いはどのような役割を果たしますか? クラウス・グレフと共著者は、LSTMの最も人気のあるバリエーションをよく比較し、彼らの研究では、それらはすべてほぼ同じであるという結論に達しました。 Rafal Jozefowicz氏は2015年の研究で1万件以上のRNNアーキテクチャをテストし、特定のタスクでLSTMよりも優れたソリューションをいくつか見つけました。

おわりに

前に、RNNを使用して達成できる優れた結果に言及しました。 実際、これらの結果はすべてLSTMで得られました。 ほとんどのタスクで、彼らは本当によく働きます。

方程式系として書かれたLSTMは、かなり威圧的に見えます。 この記事のLSTMのウォークスルーにより、よりアクセスしやすくなることを願っています。

LSTMは、RNNの開発における大きなステップです。 これは自然な問題を提起します:次の大きなステップは何でしょうか? 研究者によると、次の大きなステップは注意です。 考え方は次のとおりです。各RNNステップは、より大きな情報リポジトリからデータを取得します。 たとえば、RNNを使用して画像のキャプションを生成する場合、そのようなRNNは部分的に画像を調べ、各部分に基づいて個別の単語を生成できます。 Kelvin Xu(Xu、et al。、2015)の仕事は、まさにそのような仕事に専念しており、「注意」などのメカニズムを研究したい人にとっては良い出発点として役立ちます。 研究者はすでにこの原理を使用して印象的な結果を達成することに成功しており、今後さらに多くの発見があるようです...

RNNの興味深い研究分野は注目だけではありません。 たとえば、 Kalchbrennerなどによって説明されたグリッドLSTM (2015)非常に有望なようです。 生成モデルにおけるRNNの使用に関する研究( Gregor、et al。(2015) 、 Chung、et al。(2015)、またはBayer&Osendorfer(2015))も非常に興味深い。さらに大きな実。

ああ、仕事に来てくれませんか? :)wunderfund.ioは、 高頻度アルゴリズム取引を扱う若い財団です。 高頻度取引は、世界中の最高のプログラマーと数学者による継続的な競争です。 私たちに参加することで、あなたはこの魅力的な戦いの一部になります。

熱心な研究者やプログラマー向けに、興味深く複雑なデータ分析と低遅延の開発タスクを提供しています。 柔軟なスケジュールと官僚主義がないため、意思決定が迅速に行われ、実施されます。

チームに参加: wunderfund.io