私たちは何を持っています:

- HP ProLiant DL120 G6サーバー(10 GB RAM)

- 4x1000Gb SATAハードドライブ-ボード上に物理RAIDコントローラーなし

- PROXMOX 4.3を搭載したフラッシュドライブ(詳細は以下を参照)

何が欲しいですか:

- S-RAID 10 GPTに完全にインストールされたPROXMOX 4.3のインストールを取得します。これにより、ドライブに障害が発生した場合でも、システムは引き続き動作します。

- 故障したディスクドライブの電子メールに関する通知を受け取ります。

私たちが行うことは、一般的な行動計画です。

- PROXMOX 4.3をインストールします

- RAID10を上げてテストする

- メール通知を設定する

猫の下で、クエストの段階的な通過。

そして今、段階的に。

最初の瞬間:

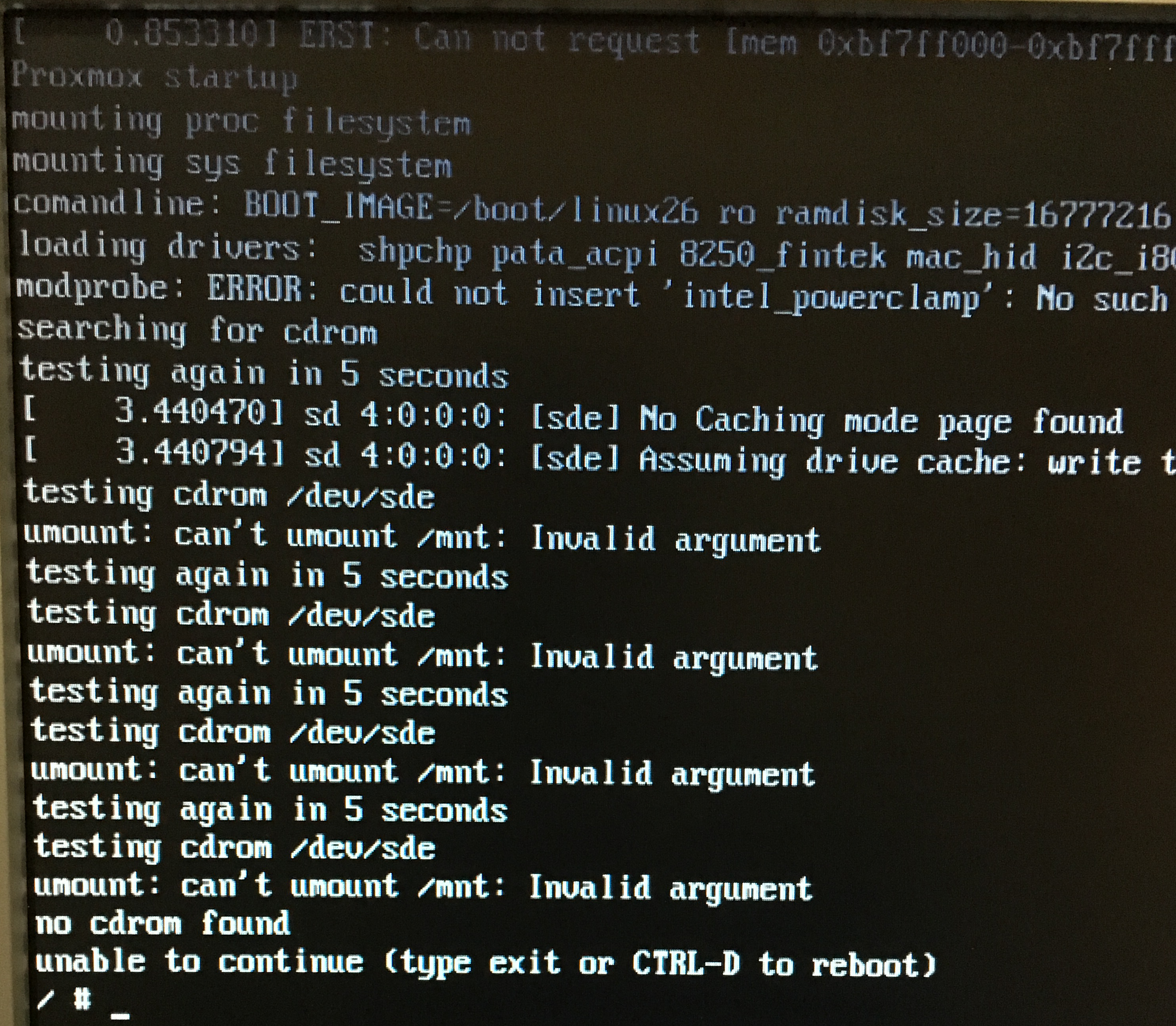

USBフラッシュドライブを接続しました-要するに-インストールディスクが見つかりませんでした。 マウントできません。

私は何をどのように理解していませんでしたが、なぜですか。 イメージをCD-ROMに書き込み、USB CDROMを接続しました(近くにあるため)

第二のポイント:

CDROMとキーボードをサーバーのフロントポートに接続しました(2つあります)-最初に見たのは、proxmoxの最初のウェルカム画面でマウスなしでは何もクリックできないことです。 つまり、コントロールボタンによるタブの切り替えは発生しません。 なぜなら サーバーがラックにあり、後ろに登るのが問題だったので、キーボードとマウスを順番に付け始めました。 マウスで、キーボードで「次へ」をクリックします-データを入力します。

インストールはいくつかのステップで構成されます。

- 要件に同意する

- システムをインストールするハードドライブを選択します。

- 国とタイムゾーンを選択してください

- サーバー名、アドレス指定

- そして、実際にイメージをサーバーにデプロイするのを少し待ちます。

PROXMOXは最初のドライブにインストールされており、/ dev / sdaと呼ばれています。 ラップトップから、インストール中に指定したアドレスに接続します。

root@pve1:~#ssh root@192.168.1.3

システムの更新:

root@pve1:~#apt-get update

出力が表示されます

Ign http://ftp.debian.org jessie InRelease Get:1 http://ftp.debian.org jessie Release.gpg [2,373 B] Get:2 http://security.debian.org jessie/updates InRelease [63.1 kB] Get:3 http://ftp.debian.org jessie Release [148 kB] Get:4 https://enterprise.proxmox.com jessie InRelease [401 B] Ign https://enterprise.proxmox.com jessie InRelease Get:5 https://enterprise.proxmox.com jessie Release.gpg [401 B] Ign https://enterprise.proxmox.com jessie Release.gpg Get:6 http://ftp.debian.org jessie/main amd64 Packages [6,787 kB] Get:7 https://enterprise.proxmox.com jessie Release [401 B] Ign https://enterprise.proxmox.com jessie Release Get:8 http://security.debian.org jessie/updates/main amd64 Packages [313 kB] Get:9 https://enterprise.proxmox.com jessie/pve-enterprise amd64 Packages [401 B] Get:10 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en_US [401 B] Get:11 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en [401 B] Get:12 https://enterprise.proxmox.com jessie/pve-enterprise amd64 Packages [401 B] Get:13 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en_US [401 B] Get:14 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en [401 B] Get:15 https://enterprise.proxmox.com jessie/pve-enterprise amd64 Packages [401 B] Get:16 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en_US [401 B] Get:17 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en [401 B] Get:18 https://enterprise.proxmox.com jessie/pve-enterprise amd64 Packages [401 B] Get:19 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en_US [401 B] Get:20 http://security.debian.org jessie/updates/contrib amd64 Packages [2,506 B] Get:21 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en [401 B] Get:22 https://enterprise.proxmox.com jessie/pve-enterprise amd64 Packages [401 B] Err https://enterprise.proxmox.com jessie/pve-enterprise amd64 Packages HttpError401 Get:23 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en_US [401 B] Get:24 http://security.debian.org jessie/updates/contrib Translation-en [1,211 B] Ign https://enterprise.proxmox.com jessie/pve-enterprise Translation-en_US Get:25 https://enterprise.proxmox.com jessie/pve-enterprise Translation-en [401 B] Ign https://enterprise.proxmox.com jessie/pve-enterprise Translation-en Get:26 http://security.debian.org jessie/updates/main Translation-en [169 kB] Get:27 http://ftp.debian.org jessie/contrib amd64 Packages [50.2 kB] Get:28 http://ftp.debian.org jessie/contrib Translation-en [38.5 kB] Get:29 http://ftp.debian.org jessie/main Translation-en [4,583 kB] Fetched 12.2 MB in 15s (778 kB/s) W: Failed to fetch https://enterprise.proxmox.com/debian/dists/jessie/pve-enterprise/binary-amd64/Packages HttpError401 E: Some index files failed to download. They have been ignored, or old ones used instead.

そうではありません。 サポートライセンスを購入する予定はまだありません。 公式サブスクリプションを「無料」リポジトリに変更しています。

root@pve1:~#nano /etc/apt/sources.list.d/pve-enterprise.list

そこに見えます:

deb https://enterprise.proxmox.com/debian jessie pve-enterprise

変更先:

deb http://download.proxmox.com/debian jessie pve-no-subscription

繰り返しますが、システムの更新を更新して配置します。

root@pve1:~#apt-get update && apt-get upgrade

これで、すべてがためらうことなく更新され、システムは最新の状態になりました。 RAIDを操作するためのパッケージを配置します。

root@pve1:~#apt-get install -y mdadm initramfs-tools parted

ここで、最初のディスクの正確なサイズを決定します。これは将来役に立つでしょう。

root@pve1:~#parted /dev/sda print

Model: ATA MB1000EBNCF (scsi) Disk /dev/sda: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Disk Flags: Number Start End Size File system Name Flags 1 1049kB 10.5MB 9437kB primary bios_grub 2 10.5MB 1000MB 990MB ext4 primary 3 1000MB 1000GB 999GB primary

正確に1000GBが表示されます。覚えておいてください。 残りのセクションを配列の下にマークします。 まず、3つの空のディスクのパーティションテーブルをクリアし、GPTの下にディスクをマークします。

root@pve1:~#dd if=/dev/zero of=/dev/sb[bcd] bs=512 count=1

1+0 records in 1+0 records out 512 bytes (512 B) copied, 7.8537e-05 s, 6.5 MB/s

マークアップ:

第二:

root@pve1:~#parted /dev/sdb mklabel gpt

Warning: The existing disk label on /dev/sdb will be destroyed and all data on this disk will be lost. Do you want to continue? Yes/No? yes Information: You may need to update /etc/fstab.

第三:

root@pve1:~#parted /dev/sdc mklabel gpt

Warning: The existing disk label on /dev/sdc will be destroyed and all data on this disk will be lost. Do you want to continue? Yes/No? yes Information: You may need to update /etc/fstab.

4番目:

root@pve1:~#parted /dev/sdd mklabel gpt

Warning: The existing disk label on /dev/sdd will be destroyed and all data on this disk will be lost. Do you want to continue? Yes/No? yes Information: You may need to update /etc/fstab.

元の最初のディスクと同じ方法でパーティションを再作成します。

1。

root@pve1:~#parted /dev/sdb mkpart primary 1M 10M

Information: You may need to update /etc/fstab.

2。

root@pve1:~#parted /dev/sdb set 1 bios_grub on

Information: You may need to update /etc/fstab.

3。

root@pve1:~#parted /dev/sdb mkpart primary 10 1G

Information: You may need to update /etc/fstab.

これは、元の最初のディスクのサイズに関する知識が役立つ場所です。

4。

root@pve1:~#parted /dev/sdb mkpart primary 1G 1000GB

Information: You may need to update /etc/fstab.

すべてのドライブに対して、sdb、sdc、sddの4つの手順をすべて実行します。 ここに私が得たものがあります:

これがオリジナルです:

root@pve1:~#parted /dev/sda print

Model: ATA MB1000EBNCF (scsi) Disk /dev/sda: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Disk Flags: Number Start End Size File system Name Flags 1 17.4kB 1049kB 1031kB bios_grub 2 1049kB 134MB 133MB fat32 boot, esp 3 134MB 1000GB 1000GB lvm

そして、これは2番目、3番目、4番目です(ドライブ文字が異なります)。

root@pve1:~#parted /dev/sdb print

Model: ATA MB1000EBNCF (scsi) Disk /dev/sdd: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Disk Flags: Number Start End Size File system Name Flags 1 1049kB 10.5MB 9437kB primary bios_grub 2 10.5MB 1000MB 990MB primary 3 1000MB 1000GB 999GB primary

次に、明確にする必要があります-このケースを初めて、そしてその前にサーバーで、そして最も重要なこととしてハードドライブで遊んでいる場合、RAIDの概念さえありませんでした-この点をスキップできます。 何かがうまくいかなかった場合は、おそらくRAIDがすでにインストールされており、削除する必要があるハードドライブにスーパーブロックがあります。

次のように確認します。

root@pve1:~#mdadm --misc --examine /dev/sda

/dev/sda: MBR Magic : aa55 Partition[0] : 1953525167 sectors at 1 (type ee)

4つのドライブすべてを確認する必要があります。

mdadmを構成します

例に基づいて構成を作成します。

root@pve1:~#cp /etc/mdadm/mdadm.conf /etc/mdadm/mdadm.conf.orig

空にする:

root@pve1:~#echo "" > /etc/mdadm/mdadm.conf

開く:

root@pve1:~#nano /etc/mdadm/mdadm.conf

入力して保存:

CREATE owner=root group=disk mode=0660 auto=yes MAILADDR user@mail.domain

メールはそのままにしておきましょう、それから私たちはそれに戻ります。

次に、劣化モードでRAIDを上げます(最初の動作中のハードドライブをスキップします)。

- / dev / md0-私は/ bootを持っています

- In / dev / md1-システムを含むVMLパーティション

root@pve1:~#mdadm --create /dev/md0 --metadata=0.90 --level=10 --chunk=2048 --raid-devices=4 missing /dev/sd[bcd]2

mdadm: array /dev/md0 started.

そして2つ目:

root@pve1:~#mdadm --create /dev/md1 --metadata=0.90 --level=10 --chunk=2048 --raid-devices=4 missing /dev/sd[bcd]3

mdadm: array /dev/md1 started.

ここで、キーを説明する必要があります。

- --level = 10-RAIDが正確に10になることを示します

- --chunk = 2048-パーティション上のクラスターサイズ

- --raid-devices = 4-4つのデバイスがRAIDに参加します

- missing / dev / sd [bcd] 2-最初の作業セクションが欠落しているとマークされている間、残りの3つはraidに追加されます

UDP 多くのコメントの後、私は一つの重要なポイントに来ました。

作成のプロセスでは、このフラグを省略してデフォルトで残すのではなく、意図的にチャンクサイズを2048に設定します。 このフラグはパフォーマンスを大幅に低下させます。 これは、Windows仮想マシンでも特に顕著です。

つまり、正しい作成コマンドは次のようになります。

root@pve1:~#mdadm --create /dev/md0 --metadata=0.90 --level=10 --raid-devices=4 missing /dev/sd[bcd]2

そして

root@pve1:~#mdadm --create /dev/md1 --metadata=0.90 --level=10 --raid-devices=4 missing /dev/sd[bcd]3

設定を保存します。

root@pve1:~#mdadm --detail --scan >> /etc/mdadm/mdadm.conf

内容を確認してください:

root@pve1:~# cat /etc/mdadm/mdadm.conf

CREATE owner=root group=disk mode=0660 auto=yes MAILADDR user@mail.domain ARRAY /dev/md0 metadata=0.90 UUID=4df20dfa:4480524a:f7703943:85f444d5 ARRAY /dev/md1 metadata=0.90 UUID=432e3654:e288eae2:f7703943:85f444d5

次に、現在のLVMアレイを3つの空のディスクに転送する必要があります。 まず、md1-RAIDでLVMパーティションを作成します。

root@pve1:~#pvcreate /dev/md1 -ff

Physical volume "/dev/md1" successfully created

そして、それをpveグループに追加します。

root@pve1:~#vgextend pve /dev/md1

Volume group "pve" successfully extended

次に、元のLVMから新しく作成されたデータにデータを転送します。

root@pve1:~#pvmove /dev/sda3 /dev/md1

/dev/sda3: Moved: 0.0%

プロセスは長いです。 約10時間かかりました。 SSH経由で接続する習慣から始めて、ラップトップで長時間仕事に座っているのは少なくとも便利ではないことに1.3%気づいたのは興味深いことです。 CTRL + Cを介して操作をキャンセルし、物理サーバーに移動してそこで転送コマンドを実行しようとしましたが、プロセスが既に実行中でコマンドが2回実行されないことを認識していないスマートハードウェアが実際の画面に転送パーセンテージを描画し始めました。 少なくともありがとう:)

プロセスは100%を書き込むことで2回終了しました。 LVMから最初のディスクを削除します。

root@pve1:~#vgreduce pve /dev/sda3

Removed "/dev/sda3" from volume group "pve"

boot / bootを新しいraid / md0に転送しますが、最初にraid自体をフォーマットしてマウントします。

root@pve1:~#mkfs.ext4 /dev/md0

mke2fs 1.42.12 (29-Aug-2014) Creating filesystem with 482304 4k blocks and 120720 inodes Filesystem UUID: 6b75c86a-0501-447c-8ef5-386224e48538 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912 Allocating group tables: done Writing inode tables: done Creating journal (8192 blocks): done Writing superblocks and filesystem accounting information: done

ディレクトリを作成し、そこにRAIDをマウントします。

root@pve1:~#mkdir /mnt/md0

root@pve1:~#mount /dev/md0 /mnt/md0

ライブ/ブートの内容をコピーします。

root@pve1:~#cp -ax /boot/* /mnt/md0

RAIDをアンマウントし、一時ディレクトリを削除します。

root@pve1:~#umount /mnt/md0

root@pve1:~#rmdir /mnt/md0

/ bootが保存されているraidセクションのUUIDを定義します-これは/ etc / fstabテーブルに正しく書き込むために必要です:

root@pve1:~#blkid |grep md0

/ dev / md0:UUID = "6b75c86a-0501-447c-8ef5-386224e48538" TYPE = "ext4"

テーブルを開いて、ブートデータを書き込み、最後にブートします。

root@pve1:~#nano /etc/fstab

規定して保存します:

UUID="6b75c86a-0501-447c-8ef5-386224e48538" /boot ext4 defaults 0 1

今マウント/ブート:

root@pve1:~#mount /boot

ステータスがBOOT_DEGRADED(つまり、ディスク障害によりRAIDが劣化している)であっても、OSを起動します。

root@pve1:~#echo "BOOT_DEGRADED=true" > /etc/initramfs-tools/conf.d/mdadm

ramfsのロードを登録します。

root@pve1:~#mkinitramfs -o /boot/initrd.img-`uname -r`

ブートローダーグラフィックモードを無効にします。

root@pve1:~#echo "GRUB_TERMINAL=console" >> /etc/default/grub

3つのディスクすべてにブートローダーをインストールします。

root@pve1:~#grub-install /dev/sdb

Installing for i386-pc platform. Installation finished. No error reported.

root@pve1:~#grub-install /dev/sdc>

Installing for i386-pc platform. Installation finished. No error reported.

root@pve1:~#grub-install /dev/sdd

Installing for i386-pc platform. Installation finished. No error reported.

今非常に重要なポイント。 システム、ブートローダー、およびgrubが置かれている2番目のディスク/ dev / sd bを基礎として、これらすべてを最初のディスク/ dev / sd aに転送して、後でRAIDの一部にします。 これを行うには、最初のディスクをクリーンであると見なし、この記事の冒頭で他のディスクと同様にマークアップします

ゼロおよびGPTとしてマーク:

root@pve1:~#dd if=/dev/zero of=/dev/sda bs=512 count=1

1+0 records in 1+0 records out 512 bytes (512 B) copied, 0.0157829 s, 32.4 kB/s

root@pve1:~#parted /dev/sda mklabel gpt

Information: You may need to update /etc/fstab.

他の3つとまったく同じようにセクションに分割します。

root@pve1:~#parted /dev/sda mkpart primary 1M 10M

Information: You may need to update /etc/fstab.

root@pve1:~#parted /dev/sda set 1 bios_grub on

Information: You may need to update /etc/fstab.

root@pve1:~#parted /dev/sda mkpart primary 10 1G

Information: You may need to update /etc/fstab.

ここでも、ディスクサイズの正確な知識が必要です。 コマンドで取得したことを思い出させてください。この場合、コマンドは/ dev / sdbディスクに適用する必要があります。

root@pve1:~#parted /dev/sdb print

同じドライブを使用しているため、サイズは変更されていません-1000Gb 。 メインセクションをマークアップします。

root@pve1:~#parted /dev/sda mkpart primary 1G 1000Gb

Information: You may need to update /etc/fstab.

次のようになります。

root@pve1:~#parted /dev/sda print

Model: ATA MB1000EBNCF (scsi) Disk /dev/sda: 1000GB Sector size (logical/physical): 512B/512B Partition Table: gpt Disk Flags: Number Start End Size File system Name Flags 1 1049kB 10.5MB 9437kB fat32 primary bios_grub 2 10.5MB 1000MB 990MB primary 3 1000MB 1000GB 999GB primary

このディスクを共有アレイに追加することは残っています。 / md0の2番目のセクション、および/ md1の3番目のセクション。

root@pve1:~#mdadm --add /dev/md0 /dev/sda2

mdadm: added /dev/sda2

root@pve1:~#mdadm --add /dev/md1 /dev/sda3

mdadm: added /dev/sda3

同期を待っています...

root@pve1:~#watch cat /proc/mdstat

このコマンドは、リアルタイムで同期プロセスを表示します。

Every 2.0s: cat /proc/mdstat Fri Nov 11 10:09:18 2016 Personalities : [raid10] md1 : active raid10 sda3[4] sdd3[3] sdc3[2] sdb3[1] 1951567872 blocks 2048K chunks 2 near-copies [4/3] [_UUU] [>....................] recovery = 0.5% (5080064/975783936) finish=284.8min speed=56796K/sec bitmap: 15/15 pages [60KB], 65536KB chunk md0 : active raid10 sda2[0] sdd2[3] sdc2[2] sdb2[1] 1929216 blocks 2048K chunks 2 near-copies [4/4] [UUUU]

/ bootを使用した最初のRAIDがすぐに同期された場合、2番目のRAIDの同期には忍耐が必要でした(約5時間)。

追加したディスクにブートローダーをインストールすることは残ります(ここでは、ディスクが完全に同期された後にのみこれを行う必要があることを理解する必要があります)。

root@pve1:~#dpkg-reconfigure grub-pc

何も変更せずにEnterキーを数回押し、最後のステップで4つのディスクすべてをドウでマークします。

md0 / md1は触れないでください!

システムを再起動し、すべてが正常であることを確認するために残ります:

root@pve1:~#shutdown –r now

システムは正常に起動しました(BIOSでネジをロードする順序を数回変更しました-等しく正しくロードされます)。

配列の確認:

<source lang="vim">root@pve1:~#cat /proc/mdstat

Personalities : [raid10] md1 : active raid10 sda3[0] sdd3[3] sdc3[2] sdb3[1] 1951567872 blocks 2048K chunks 2 near-copies [4/4] [UUUU] bitmap: 2/15 pages [8KB], 65536KB chunk md0 : active raid10 sda2[0] sdd2[3] sdc2[2] sdb2[1] 1929216 blocks 2048K chunks 2 near-copies [4/4] [UUUU]

各襲撃の4つの蹄鉄は、4つのディスクすべてが作動中であることを示しています。 配列に関する情報を調べます(最初の、またはゼロの例)。

root@pve1:~#mdadm --detail /dev/md0

/dev/md0: Version : 0.90 Creation Time : Thu Nov 10 15:12:21 2016 Raid Level : raid10 Array Size : 1929216 (1884.32 MiB 1975.52 MB) Used Dev Size : 964608 (942.16 MiB 987.76 MB) Raid Devices : 4 Total Devices : 4 Preferred Minor : 0 Persistence : Superblock is persistent Update Time : Fri Nov 11 10:07:47 2016 State : active Active Devices : 4 Working Devices : 4 Failed Devices : 0 Spare Devices : 0 Layout : near=2 Chunk Size : 2048K UUID : 4df20dfa:4480524a:f7703943:85f444d5 (local to host pve1) Events : 0.27 Number Major Minor RaidDevice State 0 8 2 0 active sync set-A /dev/sda2 1 8 18 1 active sync set-B /dev/sdb2 2 8 34 2 active sync set-A /dev/sdc2 3 8 50 3 active sync set-B /dev/sdd2

アレイのタイプはRAID10であり、すべてのディスクが所定の位置にあり、アクティブで同期されていることがわかります。

これで、ディスクを切断してBIOSのブートローダーを変更することができますが、その前に、ディスクが故障したときの管理者通知を設定しましょう。これはRAID自体を意味します。 予告なしに、襲撃はゆっくりと痛みを伴って死に、誰もそれを知らないでしょう。

Proxmoxでは、デフォルトでpostfixが既にインストールされていますが、削除しませんでしたが、他のMTAを設定する方が簡単だと意識的に理解しています。

SASLライブラリを配置します(外部メールサーバーで動作するために必要です)。

root@pve1:/etc#apt-get install libsasl2-modules

リモートメールサーバーで許可されるデータを含むファイルを作成します。

root@pve1:~#touch /etc/postfix/sasl_passwd

そこに行を書きます:

[mail.domain.ru] pve1@domain.ru:password

トランスポートファイルを作成します。

root@pve1:~#touch /etc/postfix/transport

そこに書きます:

domain.ru smtp:[mail.domain.ru]

generic_mapを作成します。

root@pve1:~#touch /etc/postfix/generic

ここに書きます(メールの送信元を示します):

root pve1@domain.ru

sender_relay(本質的には、外部サーバーへのルート)を作成します。

root@pve1:~#touch /etc/postfix/sender_relay

そして、そこに書きます:

pve1@domain.ru smtp.domain.ru

ハッシュファイル:

root@pve1:~#postmap transport

root@pve1:~#postmap sasl_passwd

root@pve1:~#postmap geniric

root@pve1:~#postmap sender_relay

/etc/postfix/main.cfファイルで、次の作業構成を取得しました。

main.cf

#コメント付きのより完全なバージョンについては、/ usr / share / postfix / main.cf.distを参照

myhostname = domain.ru

smtpd_banner = $ myhostname ESMTP $ mail_name(Debian / GNU)

biff = no

#.domainの追加はMUAの仕事です。

append_dot_mydomain = no

#次の行のコメントを解除して、「遅延メール」警告を生成します

#delay_warning_time = 4h

alias_maps = hash:/ etc / aliases

alias_database = hash:/ etc / aliases

mydestination = $ myhostname、localhost。$ mydomain、localhost

mynetworks = 127.0.0.0/8,192.168.1.0/24

inet_interfaces =ループバックのみ

recipient_delimiter = +

smtp_tls_loglevel = 1

smtp_tls_session_cache_database = btree:/ var / lib / postfix / smtp_tls_session_cache

smtp_use_tls = no

tls_random_source = dev:/ dev / urandom

## SASL設定

smtpd_sasl_auth_enable = no

smtp_sasl_auth_enable = yes

smtpd_use_pw_server = yes

enable_server_options = yes

smtpd_pw_server_security_options =プレーン、ログイン

smtp_sasl_password_maps =ハッシュ:/ etc / postfix / sasl_passwd

smtp_sender_dependent_authentification = yes

sender_dependent_relayhost_maps =ハッシュ:/ etc / postfix / sender_relay

smtpd_sasl_local_domain = $ myhostname

smtp_sasl_security_options = noanonymous

smtp_sasl_tls_security_options = noanonymous

smtpd_sasl_application_name = smtpd

smtp_always_send_ehlo =はい

relayhost =

transport_maps =ハッシュ:/ etc / postfix / transport

smtp_generic_maps =ハッシュ:/ etc / postfix / generic

disable_dns_lookups = yes

myhostname = domain.ru

smtpd_banner = $ myhostname ESMTP $ mail_name(Debian / GNU)

biff = no

#.domainの追加はMUAの仕事です。

append_dot_mydomain = no

#次の行のコメントを解除して、「遅延メール」警告を生成します

#delay_warning_time = 4h

alias_maps = hash:/ etc / aliases

alias_database = hash:/ etc / aliases

mydestination = $ myhostname、localhost。$ mydomain、localhost

mynetworks = 127.0.0.0/8,192.168.1.0/24

inet_interfaces =ループバックのみ

recipient_delimiter = +

smtp_tls_loglevel = 1

smtp_tls_session_cache_database = btree:/ var / lib / postfix / smtp_tls_session_cache

smtp_use_tls = no

tls_random_source = dev:/ dev / urandom

## SASL設定

smtpd_sasl_auth_enable = no

smtp_sasl_auth_enable = yes

smtpd_use_pw_server = yes

enable_server_options = yes

smtpd_pw_server_security_options =プレーン、ログイン

smtp_sasl_password_maps =ハッシュ:/ etc / postfix / sasl_passwd

smtp_sender_dependent_authentification = yes

sender_dependent_relayhost_maps =ハッシュ:/ etc / postfix / sender_relay

smtpd_sasl_local_domain = $ myhostname

smtp_sasl_security_options = noanonymous

smtp_sasl_tls_security_options = noanonymous

smtpd_sasl_application_name = smtpd

smtp_always_send_ehlo =はい

relayhost =

transport_maps =ハッシュ:/ etc / postfix / transport

smtp_generic_maps =ハッシュ:/ etc / postfix / generic

disable_dns_lookups = yes

postfixを再起動します:

root@pve1:~#/etc/init.d/postfix restart

ここで、RAID設定ファイルに戻って少し修正する必要があります。 私たちは誰に幸福の手紙を受け取り、誰から来るのかを示します。

root@pve1:~#nano /etc/dmadm/mdadm.conf

私はこれが好きです:

CREATE owner=root group=disk mode=0660 auto=yes MAILADDR info@domain.ru MAILFROM pve1@dpmain.ru ARRAY /dev/md0 metadata=0.90 UUID=4df20dfa:4480524a:f7703943:85f444d5 ARRAY /dev/md1 metadata=0.90 UUID=432e3654:e288eae2:f7703943:85f444d5

mdadmを再起動して、設定を再読み取りします。

root@pve1:~#/etc/init.d/mdadm restart

レイドをテストしてレターを送信するコンソールを確認します。

root@pve1:~#mdadm --monitor --scan -1 --test --oneshot

私が作成した両方の襲撃に関する情報が記載された2通の手紙を受け取りました。 テストタスクをクラウンに追加し、-testスイッチを削除することは残ります。 そのため、何かが起こったときにのみ手紙が届きます。

root@pve1:~#crontab -e

タスクを追加します(行の後にEnterキーを押し、カーソルを下に移動して空の行が表示されることを忘れないでください)。

0 5 * * * mdadm --monitor --scan -1 –oneshot

毎朝午前5時にテストが実行され、問題が発生した場合はメールが送信されます。

それだけです たぶん、私はpostfix configが賢すぎた-外部サーバーを介して通常の送信を達成しようとしていた間に、私は多くのものを追加した。 修正(簡略化)していただければ幸いです。

次の記事では、Esxi-6ハイパーバイザーからこの新しいProxmoxに仮想マシンを移動した経験を共有したいと思います。 面白いと思います。

UPD。

/ dev / dataセクションの物理的な場所で瞬間を個別にキャンセルする必要があります-これはLVM-Thinとして作成されたメインセクションです

Proxmoxをインストールすると、システム、ISO、ダンプ、コンテナが保存されている/ルートパーティションに、パーティションの容量の10%、つまり100Gbが割り当てられているという事実を考慮して、/ dev / sdaが自動的にマークされました。 残りのスペースで、彼はLVM-Thinパーティションを作成しました。これは基本的にどこにもマウントされていません(これは、ディスクをGPTに転送した後のバージョン4.2の別の微妙な点です)。 ご存じのとおり、このセクションのサイズは900Gbになりました。 1Tbの4台のドライブからRAID10を引き上げたとき-予備のRAID1 + 0を考慮して容量を取得しました-2Tb

しかし、LVMをRAIDにコピーすると、サイズが900Gbのコンテナーとしてコピーされました。

初めてProxmox管理パネルにアクセスすると、注意深い視聴者はlocal-lvm(pve1)セクションを突っ込んでいることに気付くかもしれません-800Gbのコペックでこれらを観察します

したがって、LVM-Thinを1.9TBのサイズ全体に拡張するには、1つのコマンドをすべて実行する必要があります。

lvextend /dev/pve/data -l +100%FREE

その後、システムを再起動する必要さえありません。

resize2fsを実行する必要はありません。システムは次のように誓い始めるため、これはおそらく不可能です。

root@pve1:~# resize2fs /dev/mapper/pve-data resize2fs 1.42.12 (29-Aug-2014) resize2fs: MMP: invalid magic number while trying to open /dev/mapper/pve-data Couldn't find valid filesystem superblock.

そして、正しく起動します-このセクションはfstabでマウントされていません

一般に、ディスクを拡張してProxmoxフォーラムを読む方法を理解しようとしていた間、システムはすでにテーブルとスケールの両方で新しいサイズを完全に表示していました。