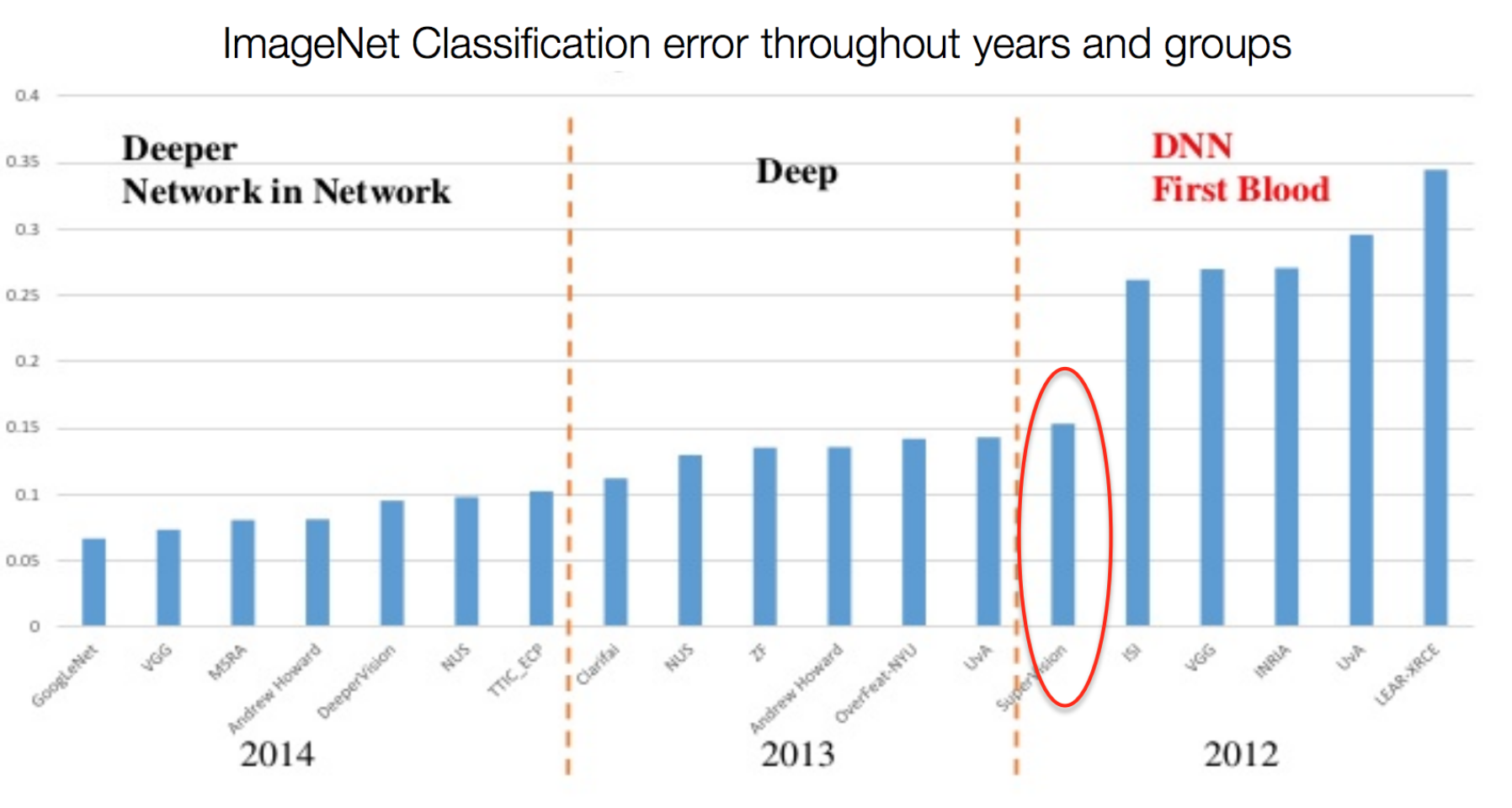

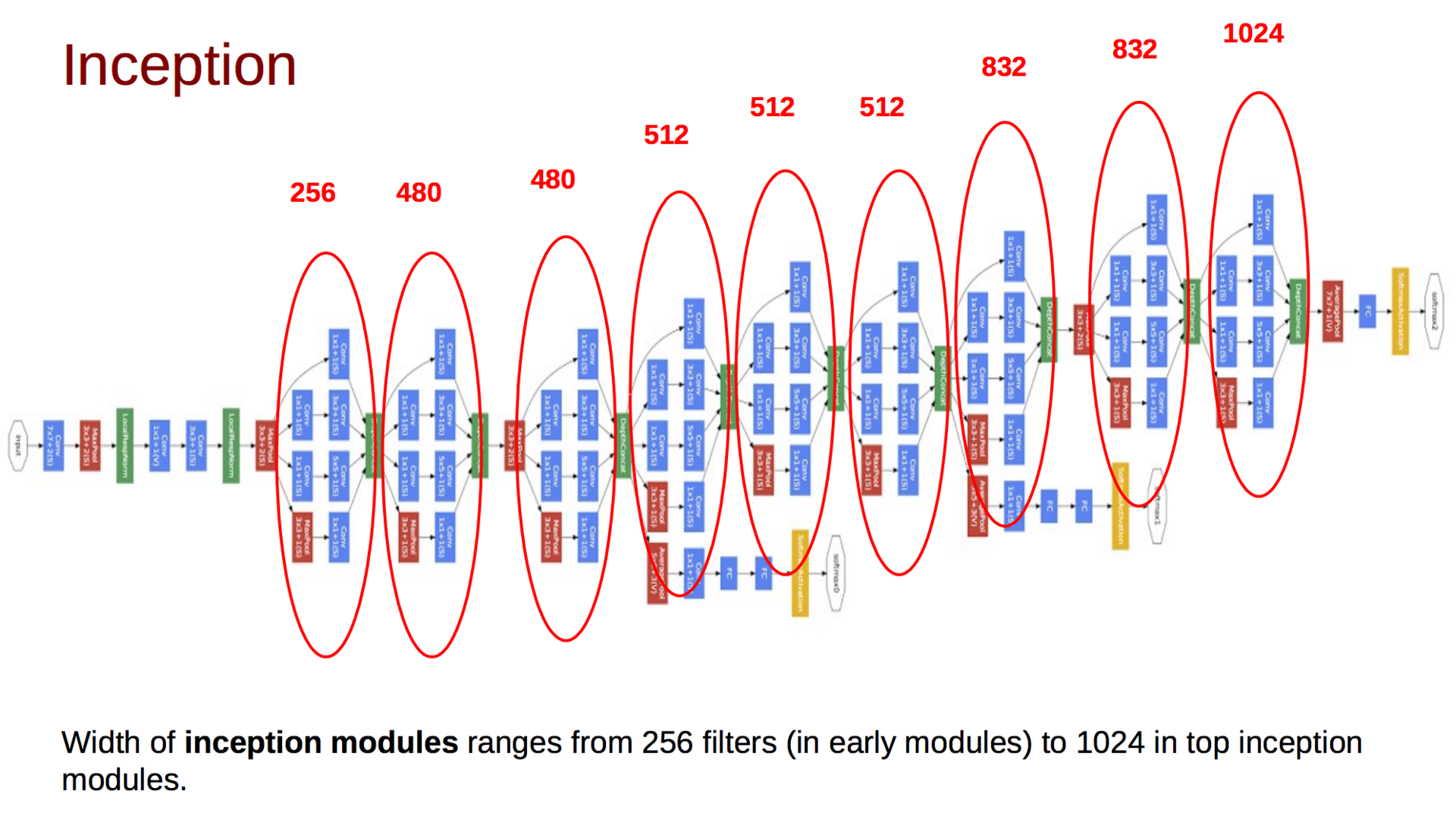

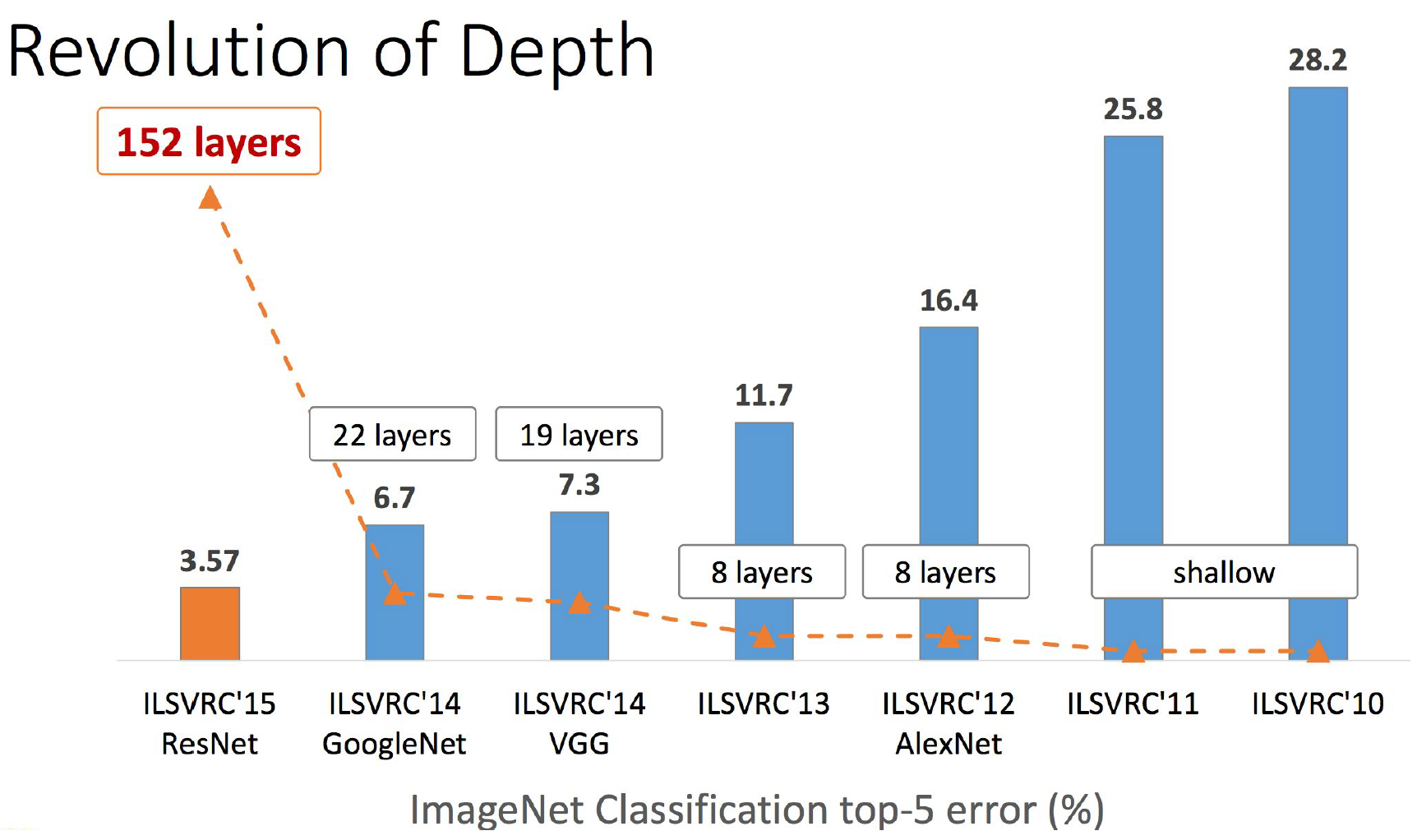

長い投稿になります。 私は長い間このレビューを書きたいと思っていましたが、 sim0nsaysが私よりも先を行き、たとえばImageNetの結果がどのように表示されるかなど、少し待つことにしました。 今、その時が来ましたが、想像力は何の驚きももたらしませんでした。ただし、分類の最初の場所は中国のefesbeshnikiです。 ceglの最高の伝統にある彼らのモデルは、いくつかのモデル(Inception、ResNet、Inception ResNet)のアンサンブルであり、過去の勝者を半パーセント追い越します(ところで、まだ出版物はなく、本当に新しい何かがあるというわずかなチャンスがあります)。 ちなみに、画像の結果からわかるように、最終モデルのアーキテクチャの幅が広くなっていることから明らかなように、レイヤーの追加で何かがおかしくなりました。 おそらく、ニューラルネットワークから絞り出せるすべてのものでしょうか? または、NVidiaはGPU 価格で過度にいじめられているため、AIの開発を遅らせていますか? 冬は近いですか? 一般的に、これらの質問にはここでは答えません。 しかし、カットの下には、タンバリンと一緒に多くの写真、レイヤー、ダンスがあります。 エラーの逆伝播アルゴリズムに既に精通しており、畳み込みニューラルネットワークの基本的な構成要素である畳み込みとプーリングの仕組みを理解していることが理解されます。

長い投稿になります。 私は長い間このレビューを書きたいと思っていましたが、 sim0nsaysが私よりも先を行き、たとえばImageNetの結果がどのように表示されるかなど、少し待つことにしました。 今、その時が来ましたが、想像力は何の驚きももたらしませんでした。ただし、分類の最初の場所は中国のefesbeshnikiです。 ceglの最高の伝統にある彼らのモデルは、いくつかのモデル(Inception、ResNet、Inception ResNet)のアンサンブルであり、過去の勝者を半パーセント追い越します(ところで、まだ出版物はなく、本当に新しい何かがあるというわずかなチャンスがあります)。 ちなみに、画像の結果からわかるように、最終モデルのアーキテクチャの幅が広くなっていることから明らかなように、レイヤーの追加で何かがおかしくなりました。 おそらく、ニューラルネットワークから絞り出せるすべてのものでしょうか? または、NVidiaはGPU 価格で過度にいじめられているため、AIの開発を遅らせていますか? 冬は近いですか? 一般的に、これらの質問にはここでは答えません。 しかし、カットの下には、タンバリンと一緒に多くの写真、レイヤー、ダンスがあります。 エラーの逆伝播アルゴリズムに既に精通しており、畳み込みニューラルネットワークの基本的な構成要素である畳み込みとプーリングの仕組みを理解していることが理解されます。

神経生理学からコンピュータービジョンへの移行

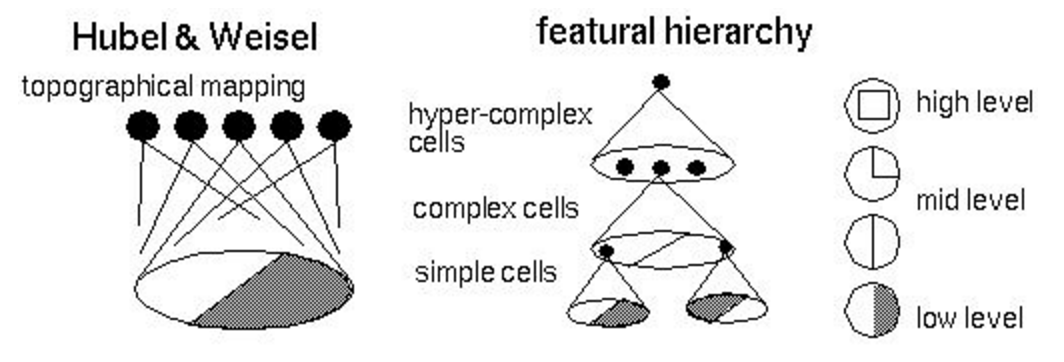

ストーリーは、ニューラルネットワーク(人工的なものだけでなく)の分野の先駆者とその貢献から始めてください。 マッカロックピットニューロンの正式なモデル、 ヘブの学習理論 、 ローゼンブラットのパーセプトロン 、 ポールバッハリタの実験など。独立した仕事のため。 だから、1981年のノーベル賞受賞者であるデイビッド・フーベルとトーステン・ヴィーゼルにすぐに行くことを提案します。 彼らは1959年に行われた仕事に対して賞を受賞しました(同時に、Rosenblattは実験を行いました)。 正式には、この賞は「神経構造における情報処理の原理と脳活動のメカニズムに関する研究」に対して授与されました。 敏感な読者はすぐに注意する必要があります。 猫の実験については以下で説明します。 実験モデルを次の図に示します。さまざまな角度で、暗い画面で明るい細長い長方形が猫に表示されます。 オシロスコープの電極は、哺乳類の視覚情報処理センターがある脳の後頭部に接続されています。 実験中、科学者は次の効果を観察しました(最新の畳み込みネットワークとリカレントネットワークとの類似点を簡単に見つけることができます)。

ストーリーは、ニューラルネットワーク(人工的なものだけでなく)の分野の先駆者とその貢献から始めてください。 マッカロックピットニューロンの正式なモデル、 ヘブの学習理論 、 ローゼンブラットのパーセプトロン 、 ポールバッハリタの実験など。独立した仕事のため。 だから、1981年のノーベル賞受賞者であるデイビッド・フーベルとトーステン・ヴィーゼルにすぐに行くことを提案します。 彼らは1959年に行われた仕事に対して賞を受賞しました(同時に、Rosenblattは実験を行いました)。 正式には、この賞は「神経構造における情報処理の原理と脳活動のメカニズムに関する研究」に対して授与されました。 敏感な読者はすぐに注意する必要があります。 猫の実験については以下で説明します。 実験モデルを次の図に示します。さまざまな角度で、暗い画面で明るい細長い長方形が猫に表示されます。 オシロスコープの電極は、哺乳類の視覚情報処理センターがある脳の後頭部に接続されています。 実験中、科学者は次の効果を観察しました(最新の畳み込みネットワークとリカレントネットワークとの類似点を簡単に見つけることができます)。

- 視覚皮質の特定の領域は、線が網膜の特定の部分に投影される場合にのみアクティブになります。

- 長方形の角度が変わると、領域のニューロンの活動レベルが変わります。

- 一部の領域は、オブジェクトが特定の方向に移動したときにのみアクティブになります。

この調査の結果の1つは、次の特性を持つ視覚システムまたは地形図のモデルでした。

- 隣接ニューロンは、網膜の隣接領域からの信号を処理します。

- ニューロンは階層構造(下の画像)を形成し、次のレベルごとにますます高レベルの兆候が強調表示されます(今日、 これらの兆候を効果的に操作する方法は既にわかっています )。

- ニューロンはいわゆる列に編成されます-情報をレベルからレベルに変換および送信する計算ユニット。

フーベルとヴィーゼルのアイデアをプログラムコードに変換しようとする最初の試みは、1975年から1980年の間にコグニトロンとネオコグニトロンの 2つのモデルを提案した福島邦彦でした。 これらのモデルは生物学的モデルをほぼ繰り返しており、今日では単純なセルの畳み込み 、および複雑なセルのプールと呼ばれています。これらは依然として現代の畳み込みニューラルネットワークの主要な構成要素です。 モデルは、エラーの逆伝播アルゴリズムによってではなく、教師なしのモードでの元のヒューリスティックアルゴリズムによってトレーニングされました。 この作業がニューラルネットワークのコンピュータービジョンの始まりだったと推測できます。

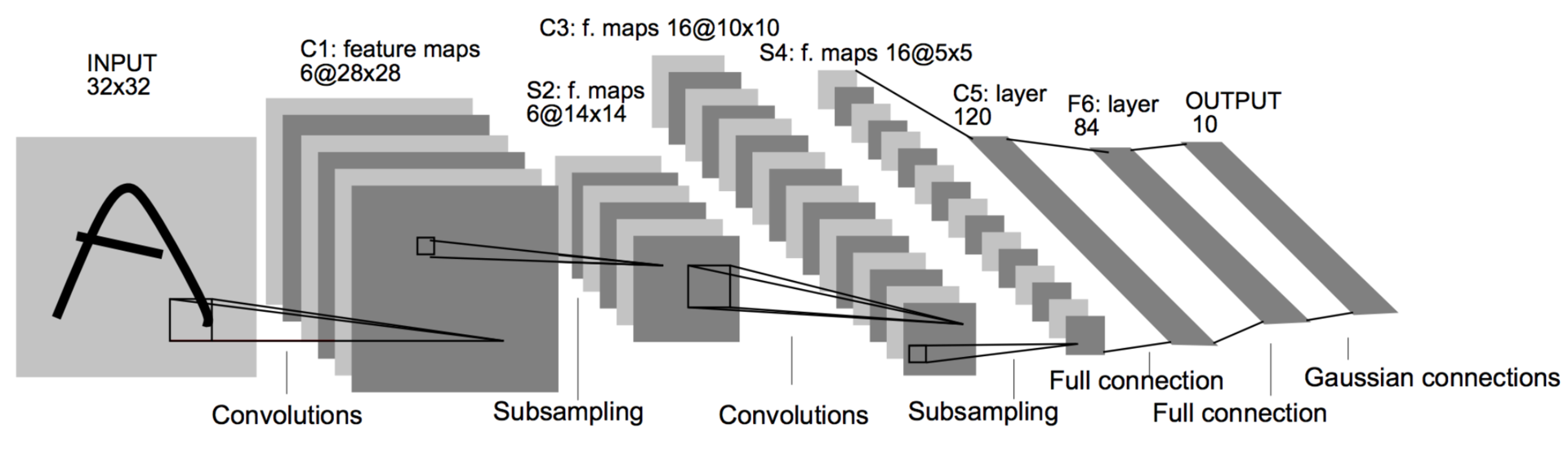

文書認識に適用される勾配ベースの学習 (1998)

数年後、1998年が来ました。 冬が過ぎました。 エラー逆伝播アルゴリズムに関する記事の著者の1人のポスドクであるJan LeCunnは 、(ニューラルネットワークの他の著名人と協力して)作品を公開します。これは、畳み込みとプーリングのアイデアをbackpropと組み合わせ、最終的に最初の動作する畳み込みニューラルネットワークを取得します。 インデックス認識のために米国のメールに埋め込まれました。 このアーキテクチャは、最近まで畳み込みネットワークを構築するための標準テンプレートでした。畳み込みは、数回プールされ、その後、完全に接続された複数の層で交互に行われます。 このようなネットワークは6万個のパラメーターで構成されています。 主な構成要素は、シフト1の5×5コンボリューションとシフト2の2×2プールです。すでにご存知のように、コンボリューションは特徴検出器の役割を果たし、プーリング(またはサブサンプリング)を使用して次元を減らし、 画像にプロパティがあるという事実を活用しますピクセルの局所相関 -原則として、隣接するピクセルは互いに大きく異なりません。 したがって、いくつかの隣接するものから集計が取得された場合、情報の損失はわずかです。

ディープコンボリューショナルニューラルネットワークを使用したImageNet分類 (2012)

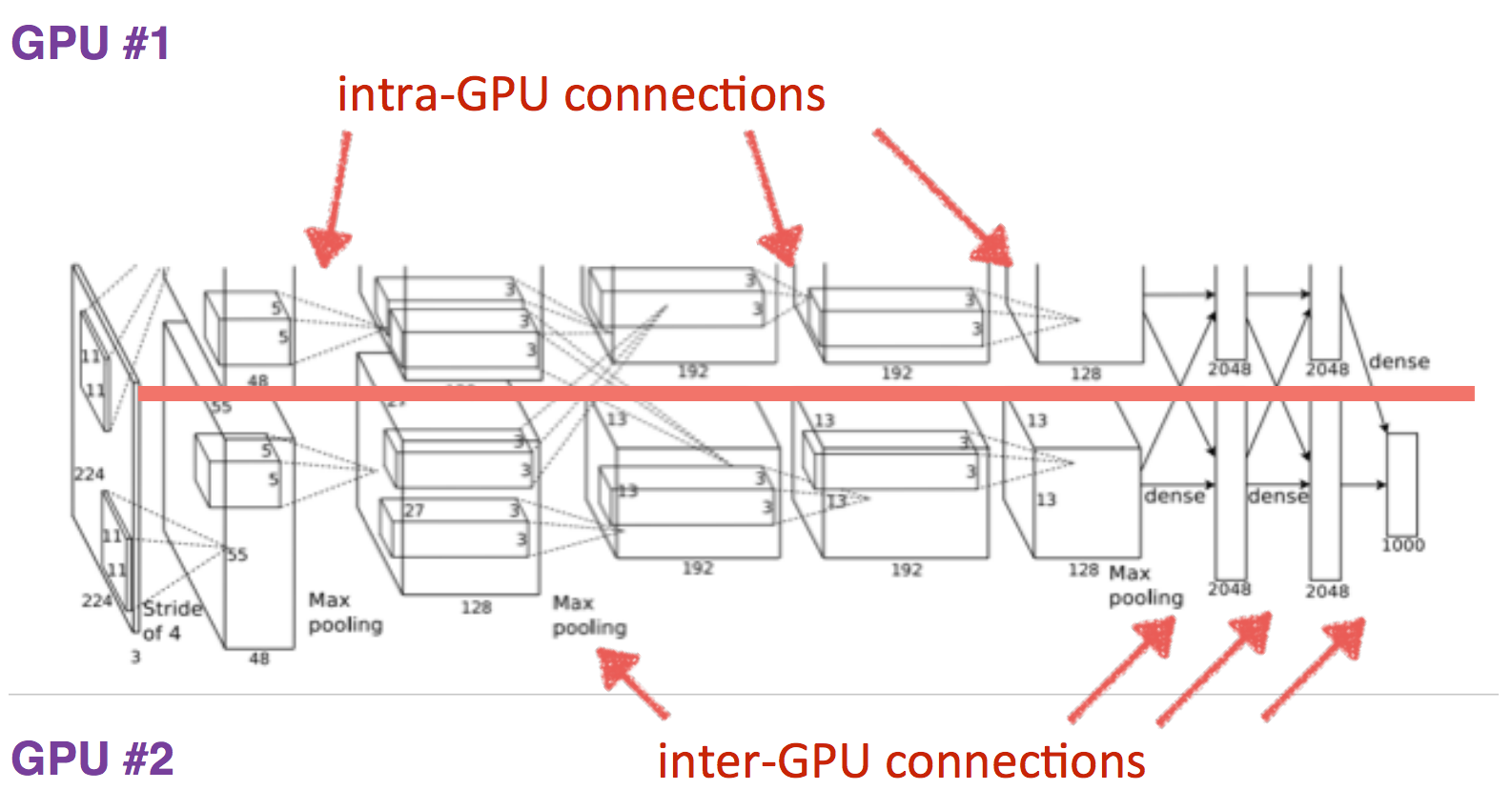

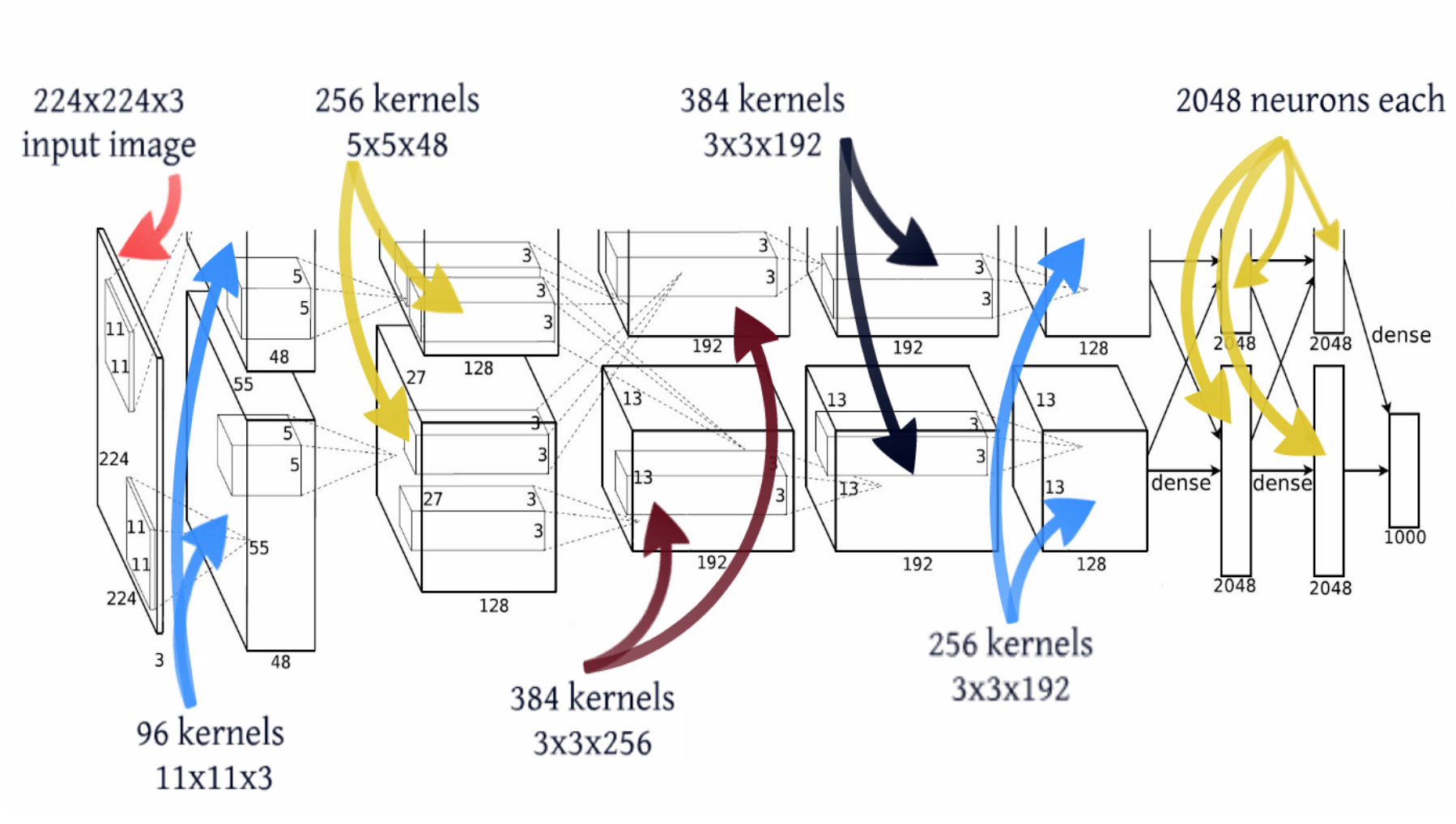

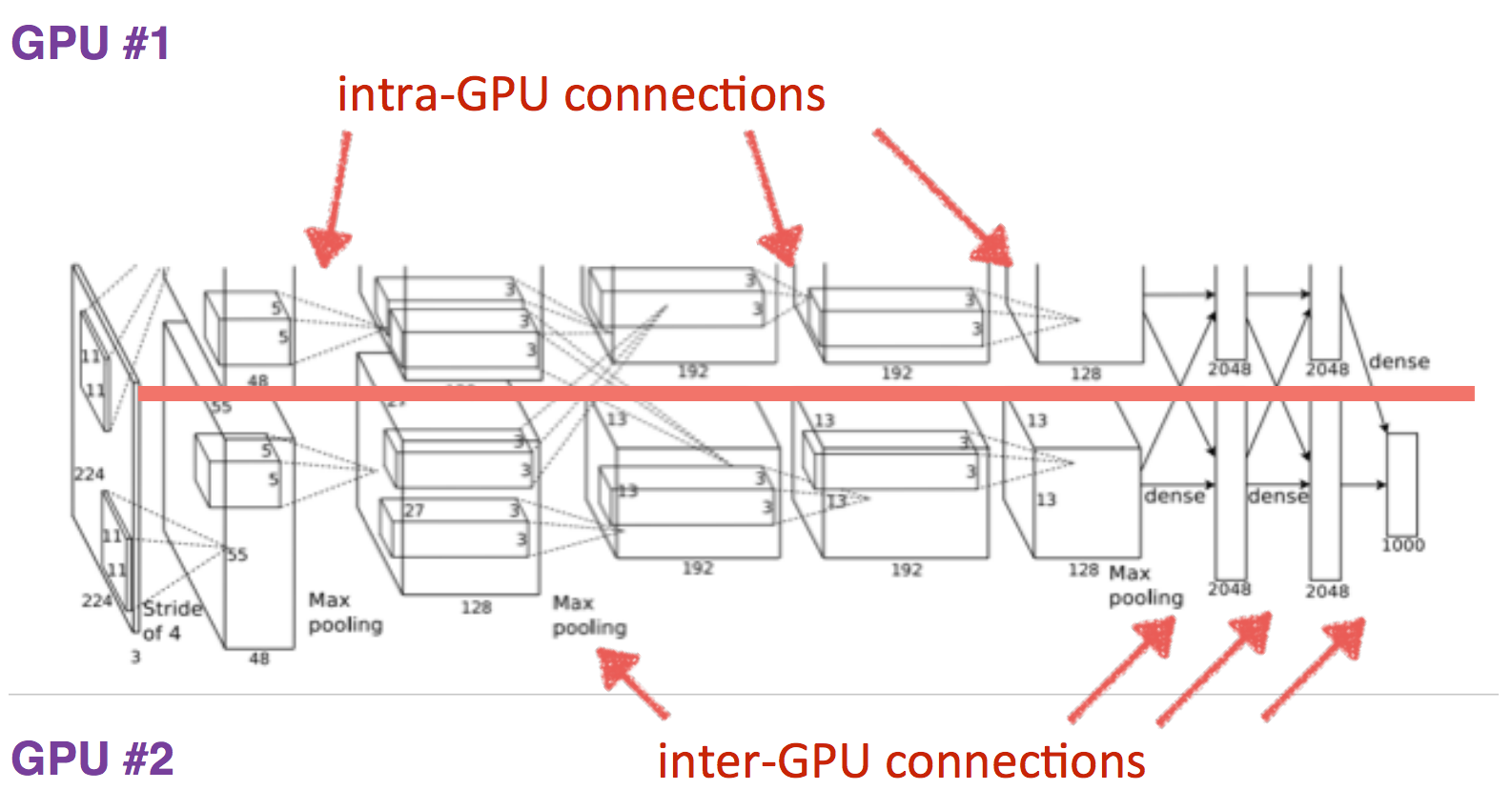

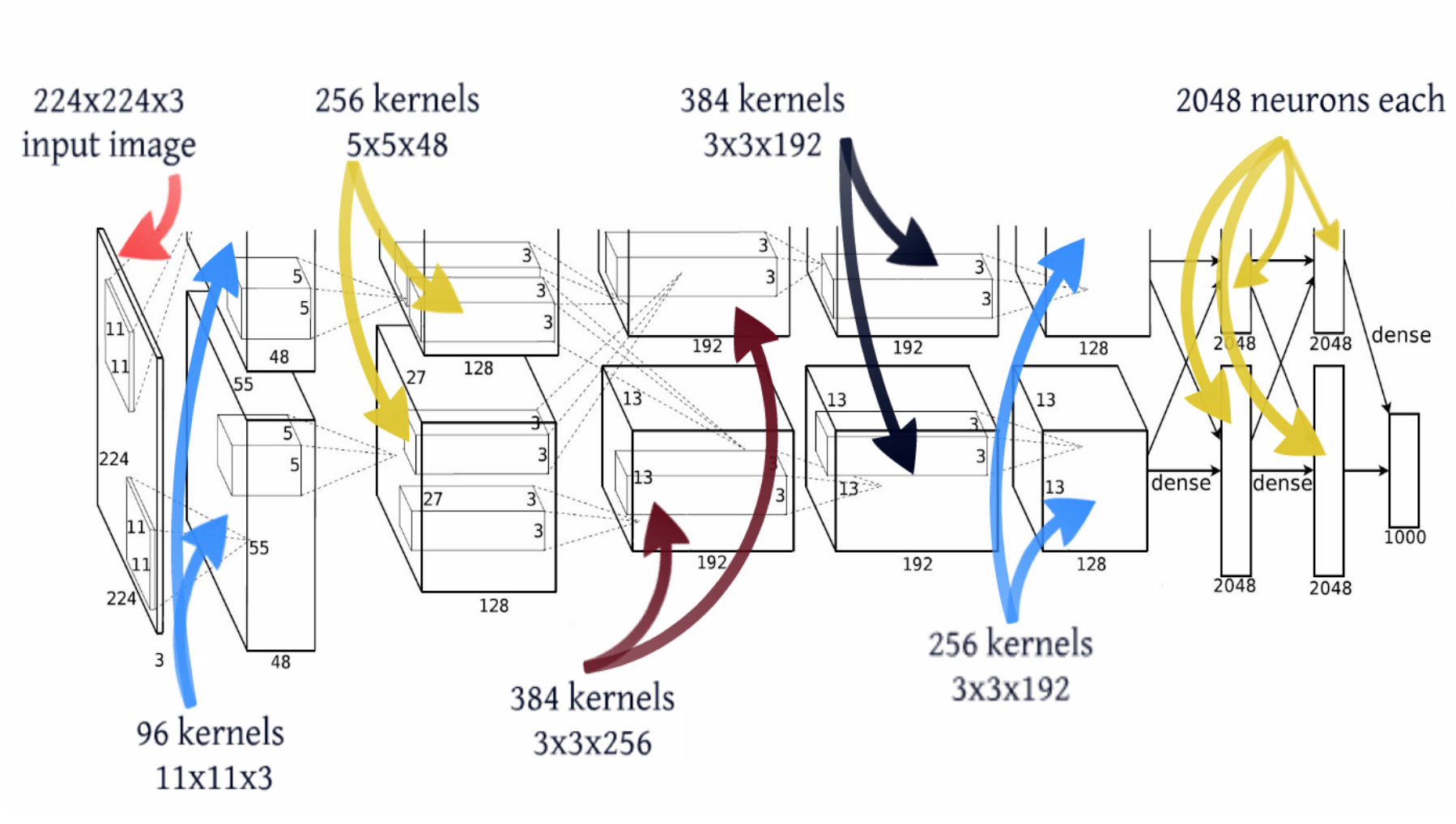

もう14年が経ちました。 LeCunがポストドックであった同じ研究所のAlex Krizhevskyは、最後の成分を処方に追加しました。 ディープラーニング=モデル+学習理論+ビッグデータ+ ハードウェア 。 GPUは、トレーニングされたパラメーターの数を大幅に増やしました。 このモデルには、3桁以上の6,000万個のパラメーターが含まれており、2つのグラフィックアクセラレーターを使用してこのようなモデルをトレーニングしました。

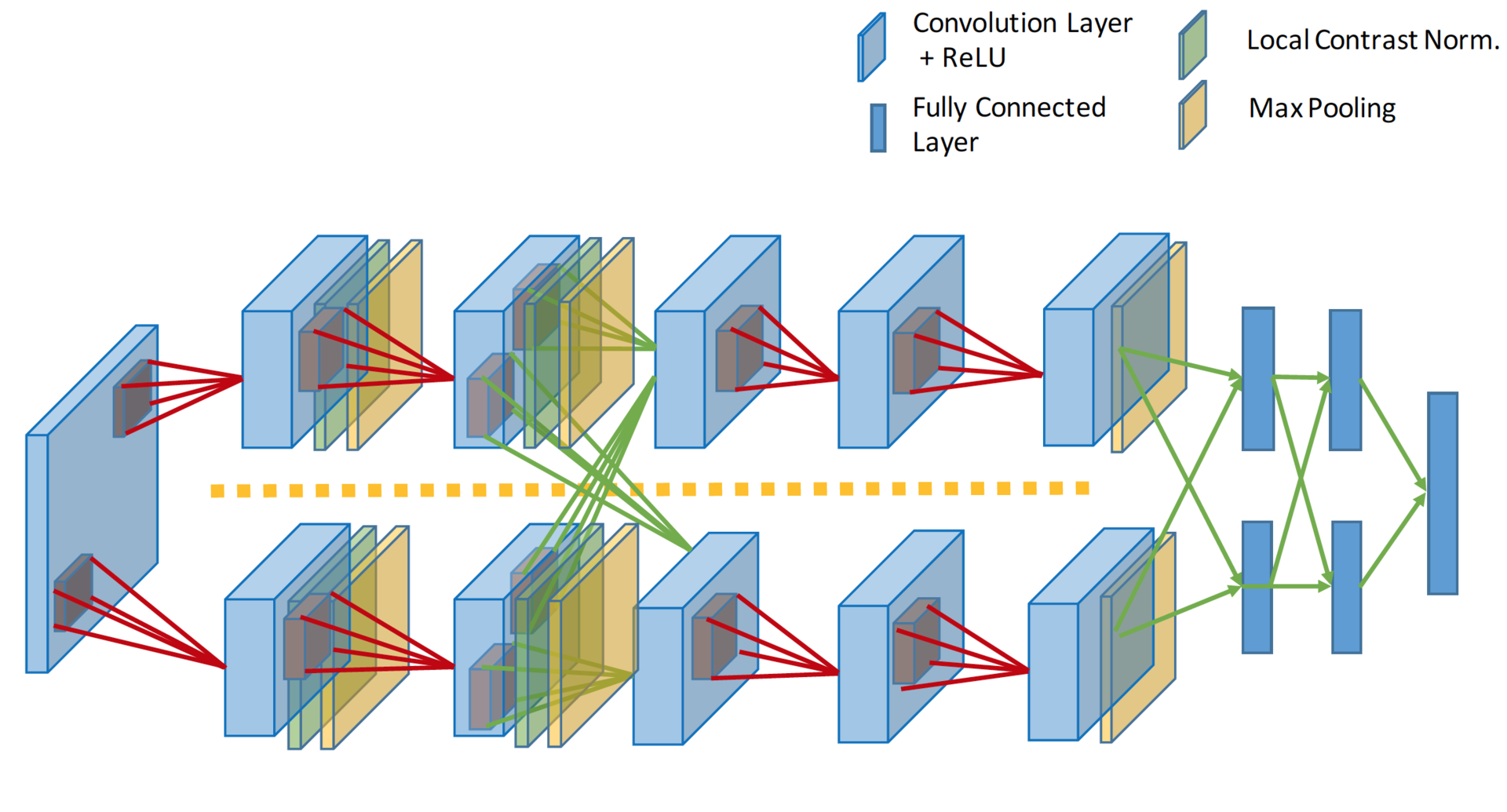

その他の画像AlexNet

GPUデータ交換

レイヤーサイズ

レイヤーサイズ

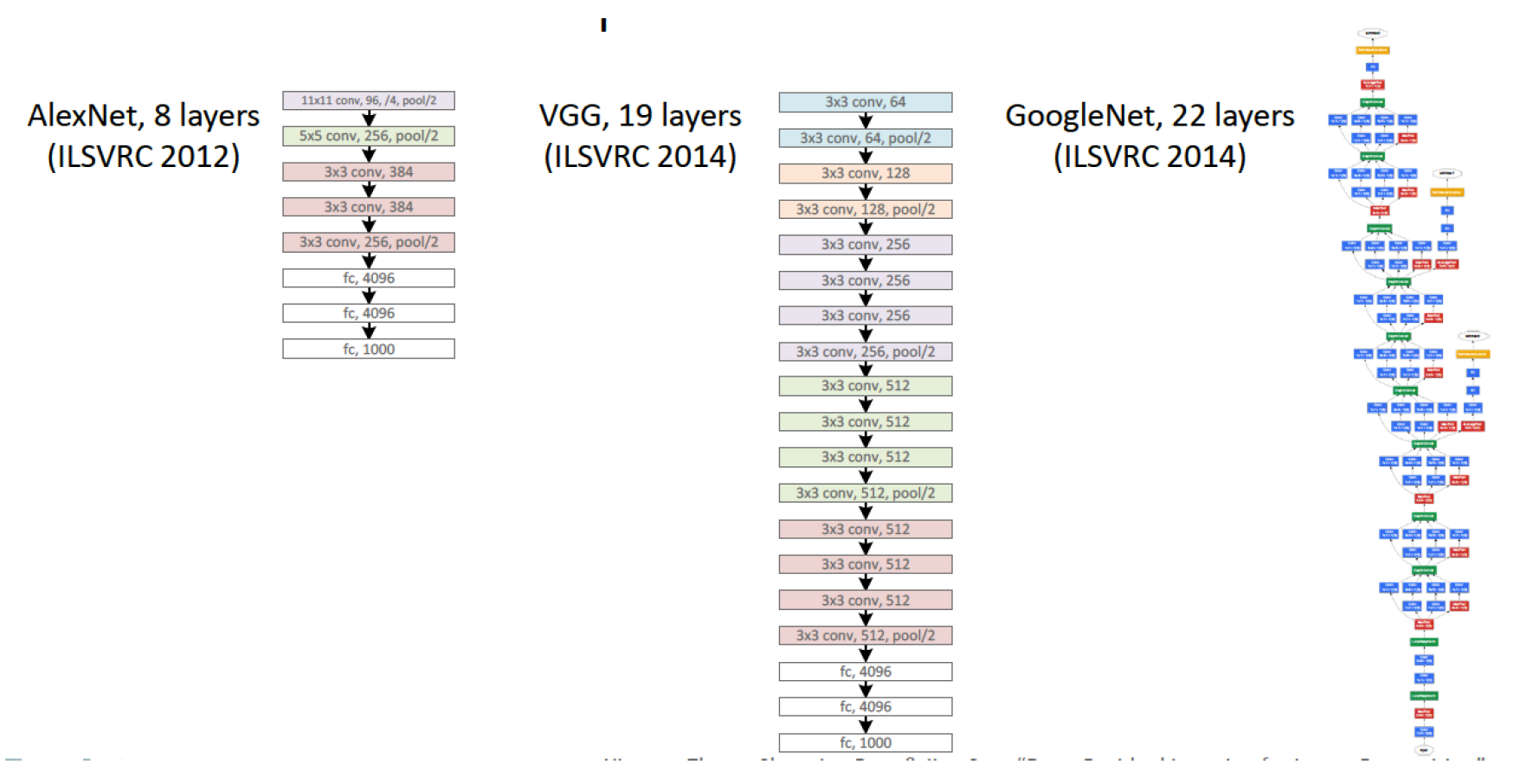

ネットワークトポロジの観点から見ると、これはほぼ同じLeNetであり、1000倍の大きさです。 さらにいくつかの畳み込み層が追加され、畳み込みカーネルのサイズはネットワークの入力から出力に向かって減少します。 これは、最初はピクセルが高度に相関しており、受容体領域を安全に大きく取ることができるという事実によるものであり、まだ少しの情報が失われています。 次に、プーリングを使用して、無相関領域の密度を増やします 。 次のレベルでは、わずかに小さい受容体領域を取ることが論理的です。 その結果、著者はそのような畳み込みのピラミッドを取得しました11×11-> 5×5-> 3×3 ...

再トレーニングを回避するために他のトリックも使用されましたが、それらの一部は現在、ディープネットワークの標準であるDropOut (RIP)、Data Augmentation、 ReLuです。 これらのトリックに焦点を当てるのではなく、モデルのトポロジーに焦点を当てます。 2012年以降、非ニューラルネットワークモデルが画像を獲得できなくなったことだけを追加します。

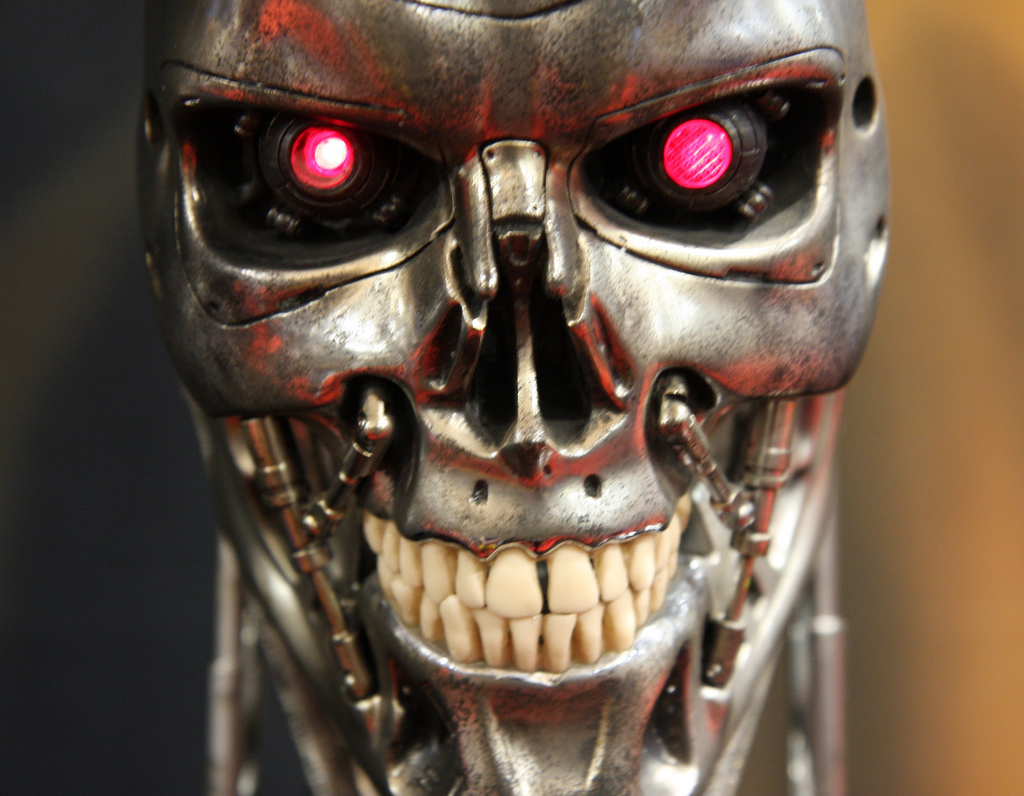

大規模画像認識用の非常に深い畳み込みネットワーク (2014年4月12日)

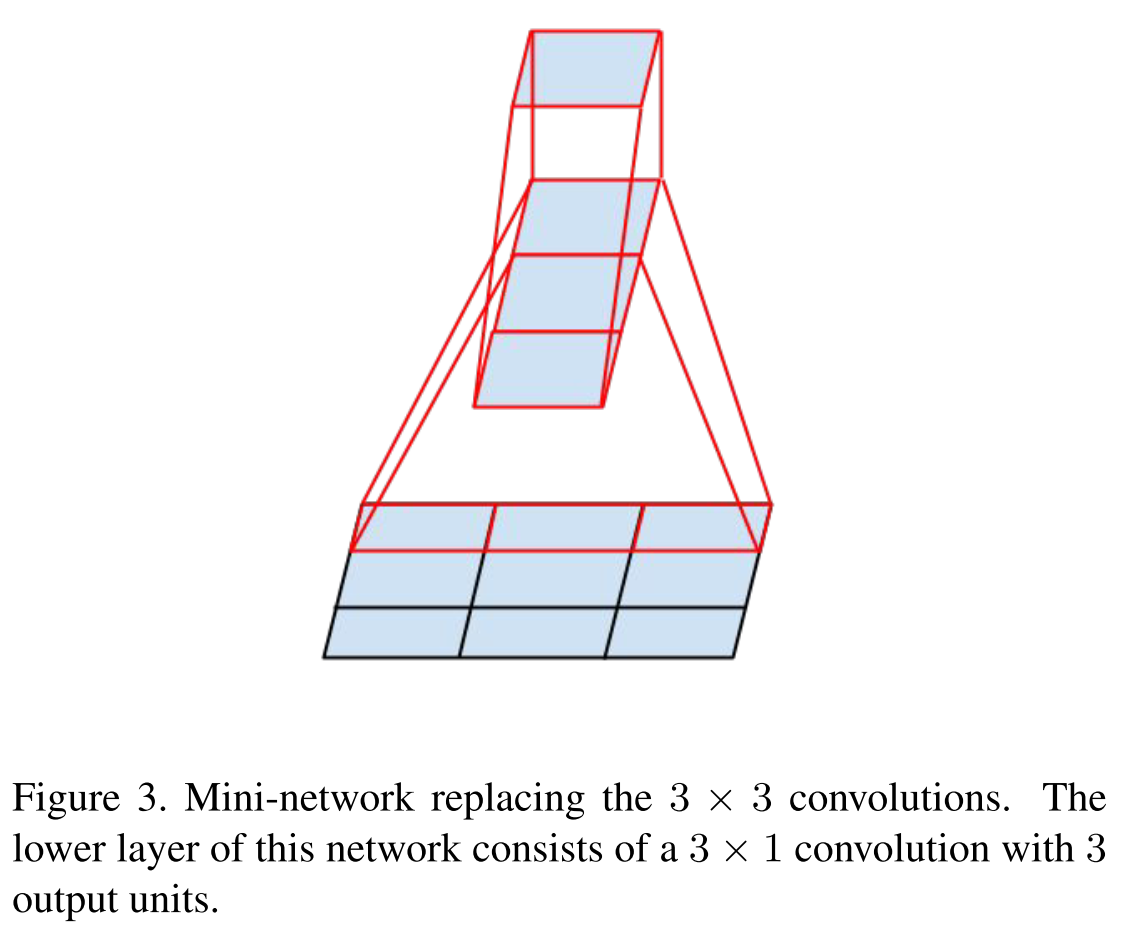

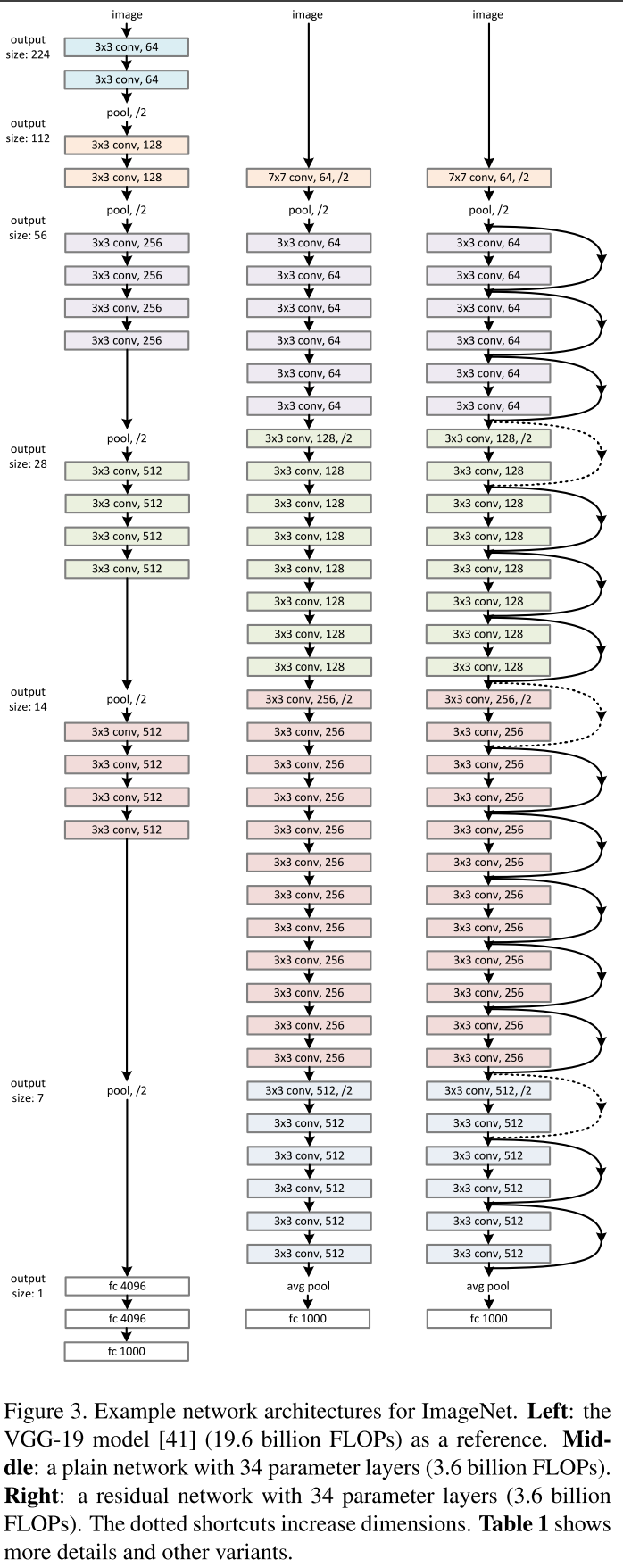

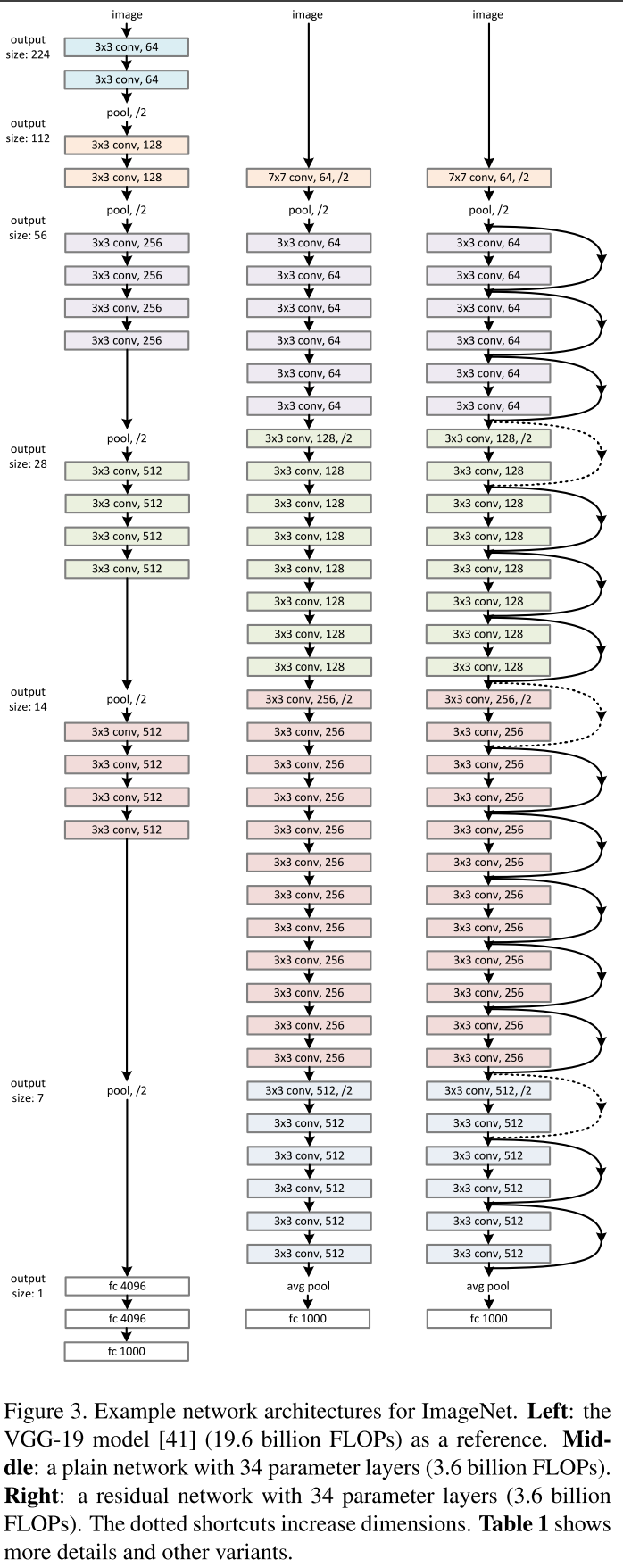

今年2つの興味深い記事が発表されました。この記事とGoogle Inceptionです。これについては以下で説明します。 オックスフォード研究所の研究は、LeCunが定めたトポロジーのパターンに準拠した最後の研究です。 VGG-19モデルは1億4400万のパラメーターで構成され、8400万のパラメーターに加えて、アーキテクチャに別の簡単なアイデアを追加します。 たとえば、5×5の畳み込み、このマッピング

、25個のパラメーターが含まれています。 畳み込みが3×3の2つのレイヤーのスタックに置き換えると、同じ表示になりますが、パラメーターの数は3×3 + 3×3 = 18となり、これは22%少なくなります。 11×11を4つの3×3畳み込みに置き換えると、これはすでにパラメーターよりも70%少なくなります。

、25個のパラメーターが含まれています。 畳み込みが3×3の2つのレイヤーのスタックに置き換えると、同じ表示になりますが、パラメーターの数は3×3 + 3×3 = 18となり、これは22%少なくなります。 11×11を4つの3×3畳み込みに置き換えると、これはすでにパラメーターよりも70%少なくなります。

VGG- *モデル

ネットワーク内ネットワーク (2014年3月4日)

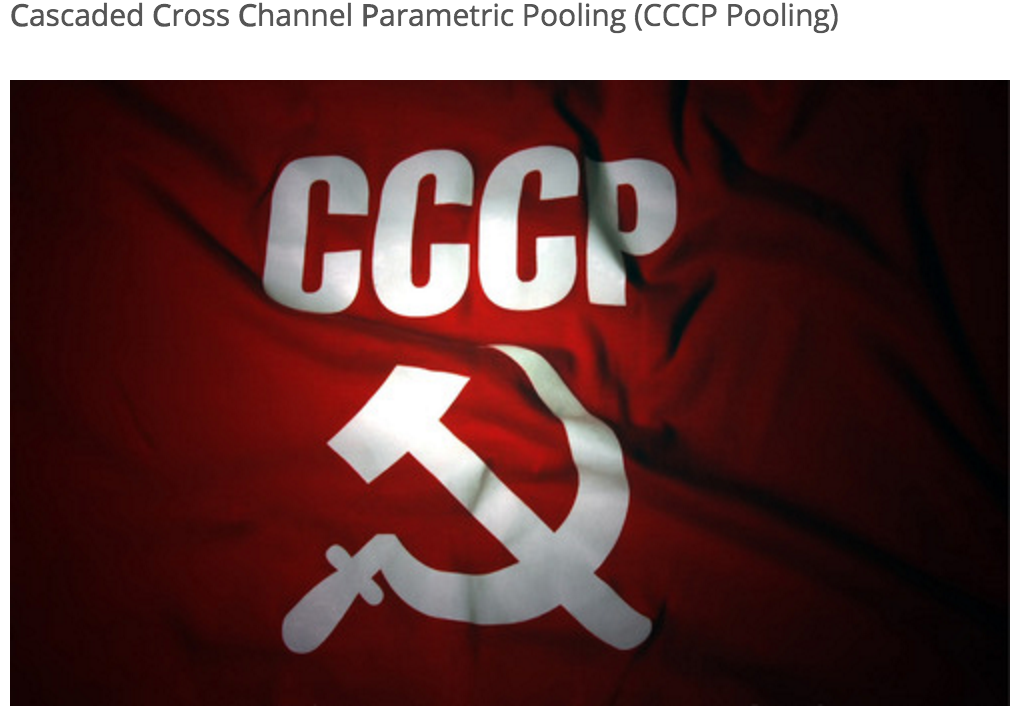

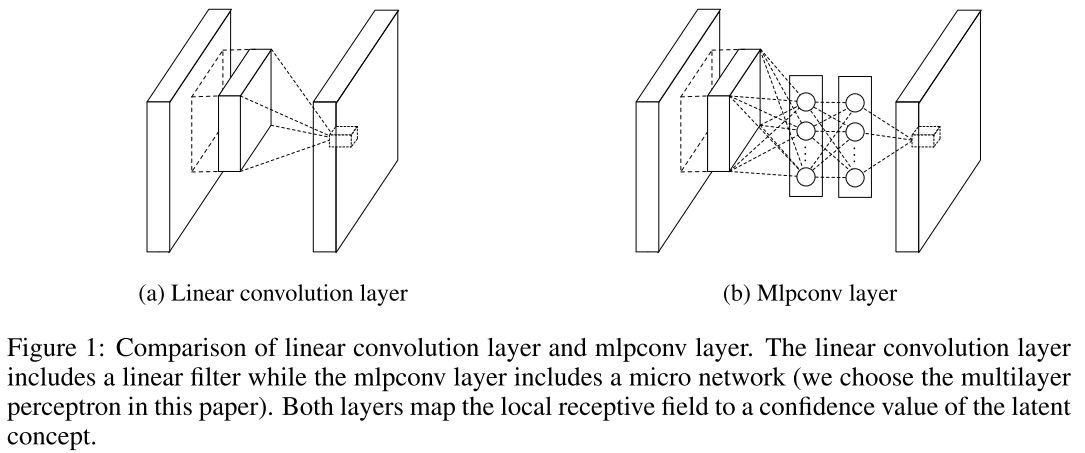

そして、ここからタンバリンと踊り始めます。 このような写真で、この出版物の著者は彼のブログ投稿を例証し、そこでは彼がascadedrosshannelParameteric poolingについて話しました。 この記事の主なアイデアを検討してください。 明らかに、畳み込み演算は画像パッチの線形変換であり、畳み込み層は一般化線形モデル(GLM)です。 画像は線形に分離可能であると想定されています。 しかし、なぜCNNが機能するのでしょうか? すべてが単純です。過剰な表現(多数のフィルター)を使用して、属性空間内の1つの画像のすべてのバリエーションを考慮します。 1つのレイヤーでフィルターが多いほど、次のレイヤーで考慮する必要があるバリエーションが増えます。 どうする GLMをより効率的なものに置き換えましょう。 最も効果的なのは単層パーセプトロンです。 これにより、標識のスペースをより効果的に分割し、標識の数を減らすことができます。

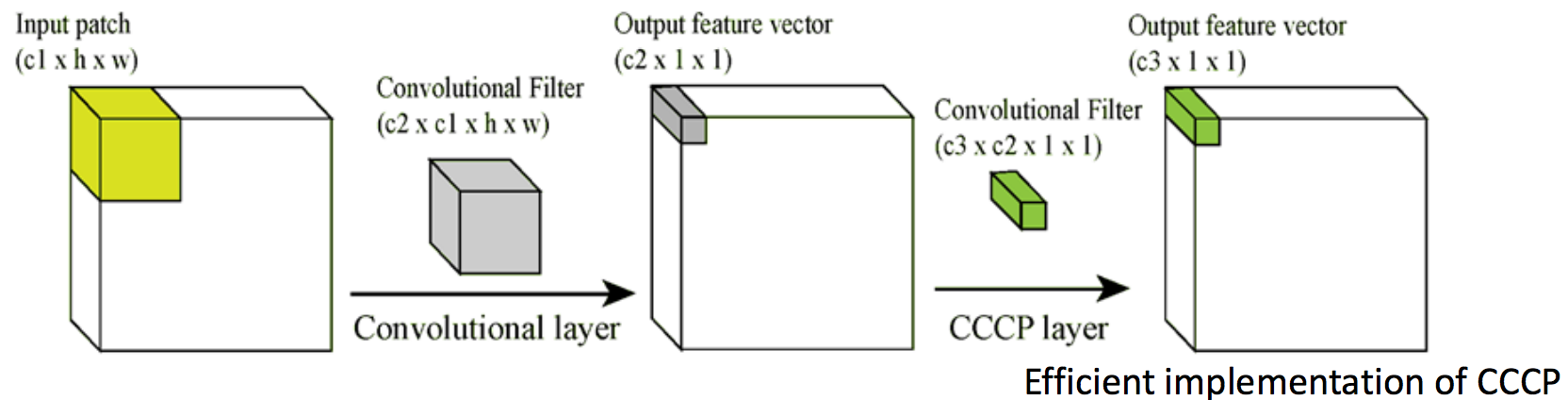

あなたはすでにそのような決定の妥当性を疑い始めていると確信しています。私たちはサインの数を本当に減らしますが、パラメーターの数を大幅に増やします。 著者は、ソ連がこの問題を解決すると述べています。 それは次のように機能します:畳み込み層の出口で、サイズW×H×Dの立方体を取得します。各位置(w、h)について、D、クロスチャンネルのすべての値を取得し、線形結合、パラメトリックプーリングを計算します。回、それによって新しいボリュームを作成し、数回-カスケード。 これらは、1×1のたたみ込みとそれに続く非線形性であることがわかります。 このトリックは、理想的には3×3コンボリューションに関するVGGの記事と同じですが、最初は通常のコンボリューションをMLPに置き換えることを提案しますが、MLPは非常に高価なので、その完全に接続された各レイヤーを畳み込みレイヤーに置き換えます-シンガポールのトリック。 NINは深い畳み込みニューラルネットワークであり、畳み込みの代わりに、1×1コアの小さな畳み込みニューラルネットワークがあることがわかりました。

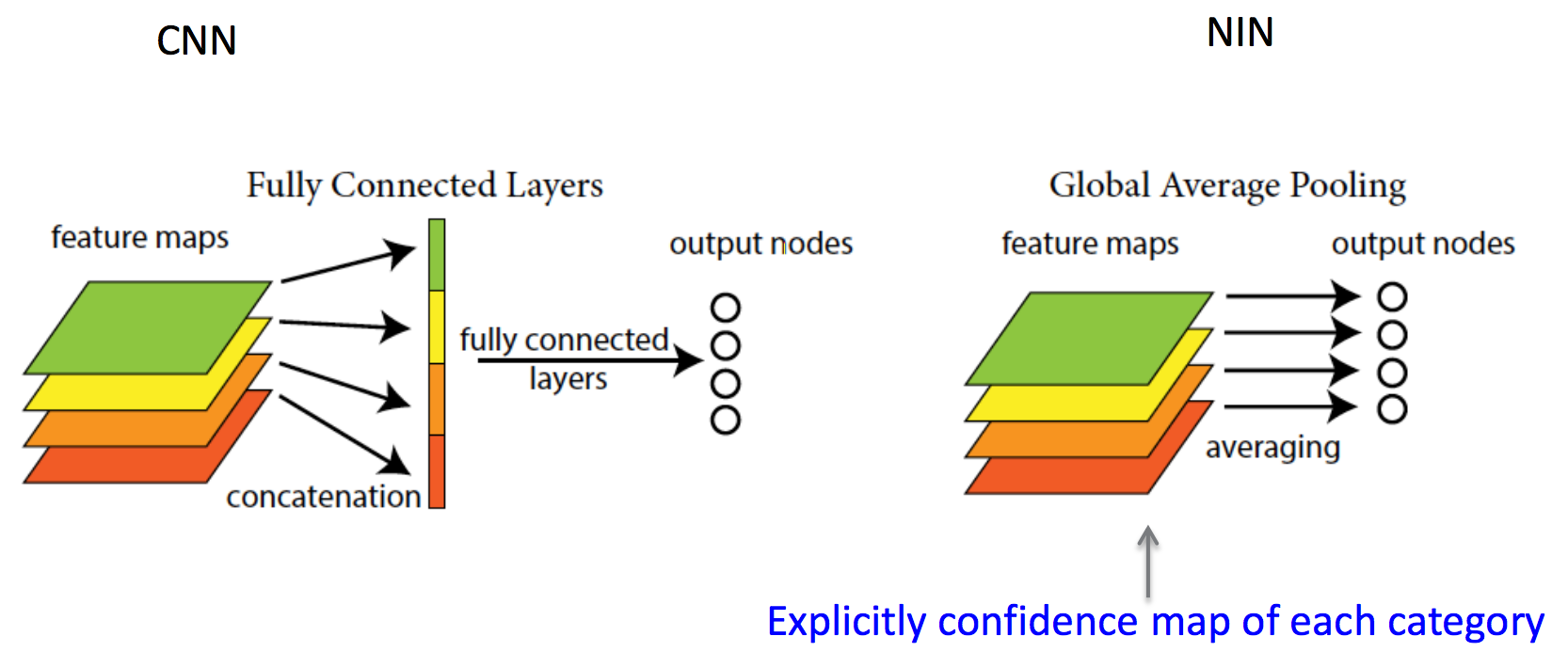

さらに興味深い次のアイデアは、完全に接続されたレイヤーを完全に放棄することです-グローバル平均プーリング。 このようなネットワークは、特定の画像サイズを入力する必要がなく、畳み込み/プーリングのみで構成されるため、完全な畳み込みネットワークと呼ばれます。 N個のクラスへの分類問題があり、キューブW×H×DからキューブW×H×Nを作成するために、完全に接続されたレイヤーの代わりに1×1の畳み込みが使用されると仮定します。つまり、1×1の畳み込みはキューブの深さを任意に変更できますサイン。 N個のダイスがW×Hの場合、ダイスの平均値を計算し、softmaxを計算できます。 少し深い考えは、以前の畳み込み層は単に記号を抽出するメカニズムとして機能し、弁別器は完全に接続された層であったという著者の主張にあります(そこからLeCunnが指定したパターン)。 ネットワークは畳み込みのみで構成され、分類問題を解決するため、著者は畳み込みも弁別子であると主張しています。 LeNet形式の畳み込みネットワークでは、計算の80%が畳み込み層にあり、メモリ消費の80%が完全に接続された層にあることに注意してください。

LeCunは後にフェイスブックに次のように書いています 。

畳み込みネットでは、「完全に接続されたレイヤー」などはありません。 1×1の畳み込みカーネルと完全な接続テーブルを持つ畳み込み層のみがあります。

非常に多くの新しいアイデアを思いついた著者が画像に参加しなかったことは残念です。 しかし、Googleはこれらのアイデアをすぐに大騒ぎし、次の出版物で使用しました。 その結果、Googleは2014年の受賞地をオックスフォードのチームと共有しました。

畳み込みでさらに深く (2014年9月17日)

Googleはゲームに参入し、彼らはネットワークInceptionと名付けました。名前は偶然に選ばれたものではなく、「ネットワーク内部のネットワーク」と有名なミームに関する前作のアイデアを引き継いでいるようです。 著者が書いたものは次のとおりです。

この論文では、有名な「我々はより深く行く必要がある」とともに、リンら[12]によるネットワーク論文のNetworkからその名前を得た、Inceptionと呼ばれるコンピュータービジョンのための効率的なディープニューラルネットワークアーキテクチャに焦点を当てますインターネットミーム[1]。 私たちの場合、「深い」という言葉は2つの異なる意味で使用されます。まず、「インセプションモジュール」という形で新しいレベルの組織を導入するという意味と、ネットワークの増加というより直接的な意味深さ。 一般に、インセプションモデルは[12]の論理的集大成であると見なすことができますが、アロラらの理論的研究からインスピレーションとガイダンスを得ています[2]。

幅(レイヤー内のニューロンの数)と深さ(レイヤーの数)の任意の増加には、多くの欠点があります。 第一に、パラメータの数を増やすと再トレーニングが容易になり、層の数を増やすと勾配減衰の問題が増えます。 ところで、最後のステートメントはResNetによって解決されますが、これについては後で説明します。 第二に、レイヤー内の畳み込み数が増加すると、このレイヤーでの計算が2次的に増加します。 新しいモデルのパラメーターが非効率的に使用されている場合、たとえば、それらの多くがゼロに近くなる場合、単純に計算能力を浪費しています。 これらの問題にも関わらず、この記事の最初の著者は、深いネットワークで実験することを望んでいましたが、パラメーターを大幅に減らしました。 これを行うために、彼は記事「 いくつかの深い表現を学習するための証明可能な境界 」に目を向けました。そこでは、データの確率的分布がまばらで深くて広いニューラルネットワークとして表現できる場合、ニューロンの相関を分析することでこのデータセットに最適なニューラルネットワークを構築できることを証明しています前の層と相関するニューロンを次の層のニューロンになるグループに結合します。 したがって、後層ニューロンは、元の画像の強く交差する領域を「見ます」。 ニューロンの受容体領域が異なるレベルでどのように見えるか、そしてそれらが抽出する兆候を思い出させてください。

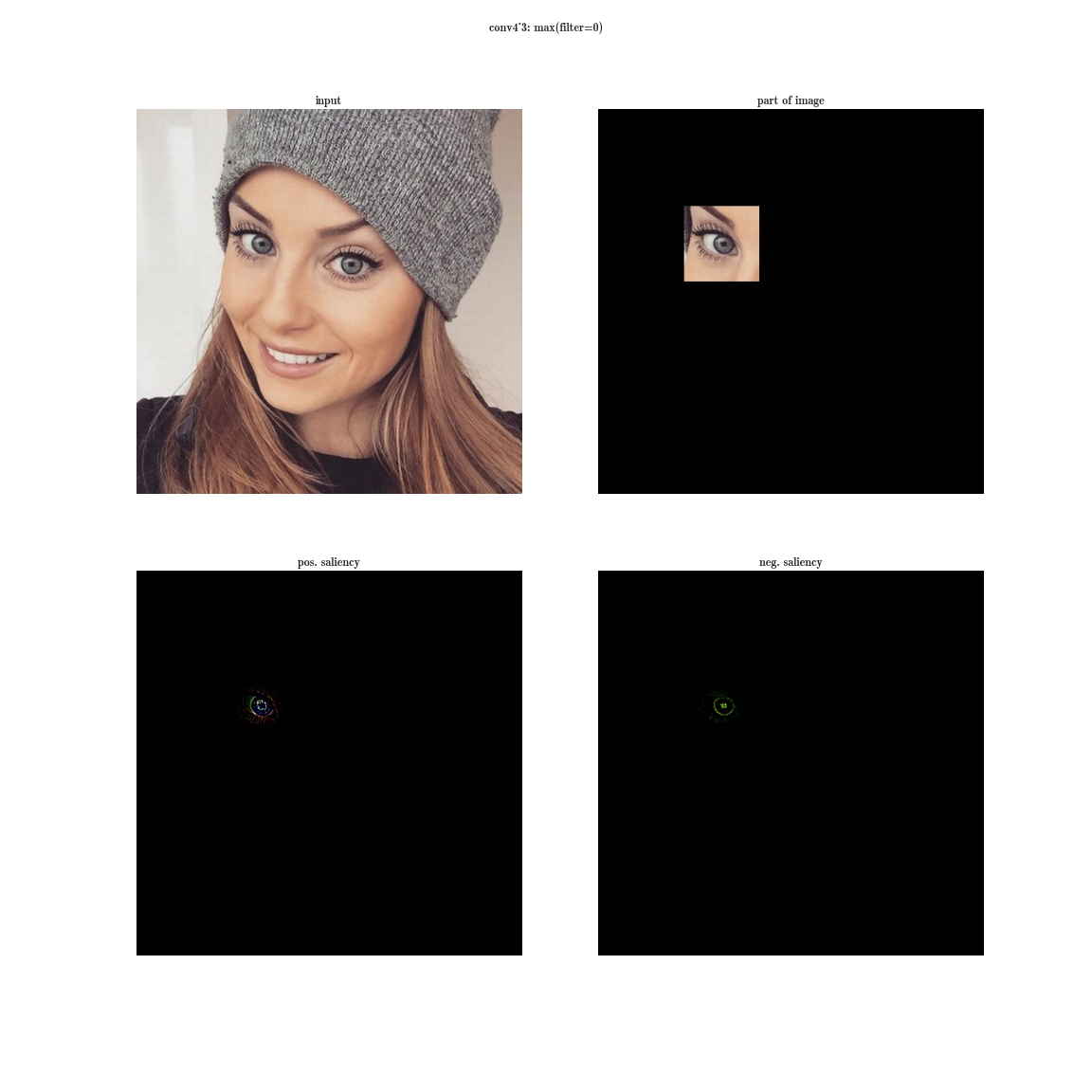

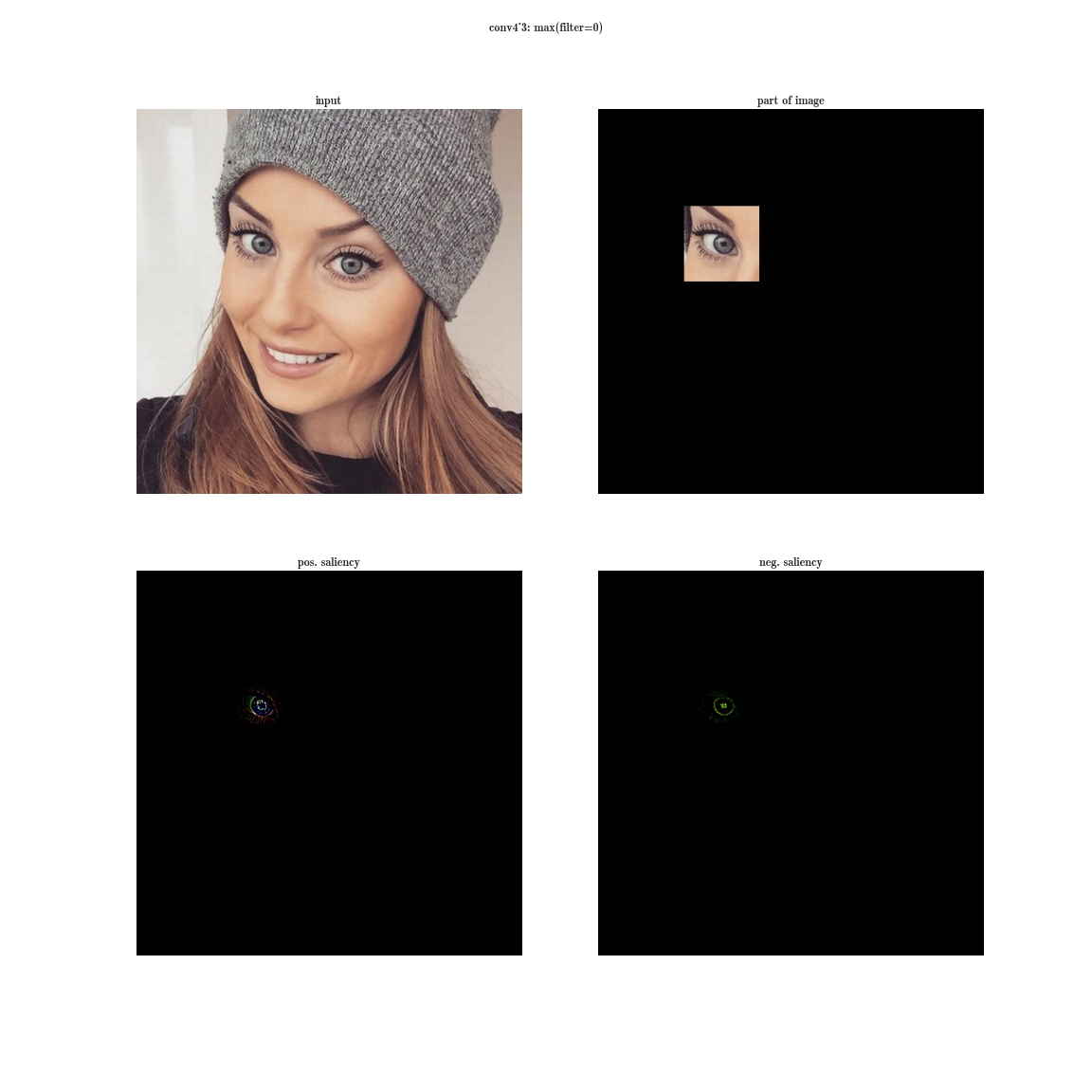

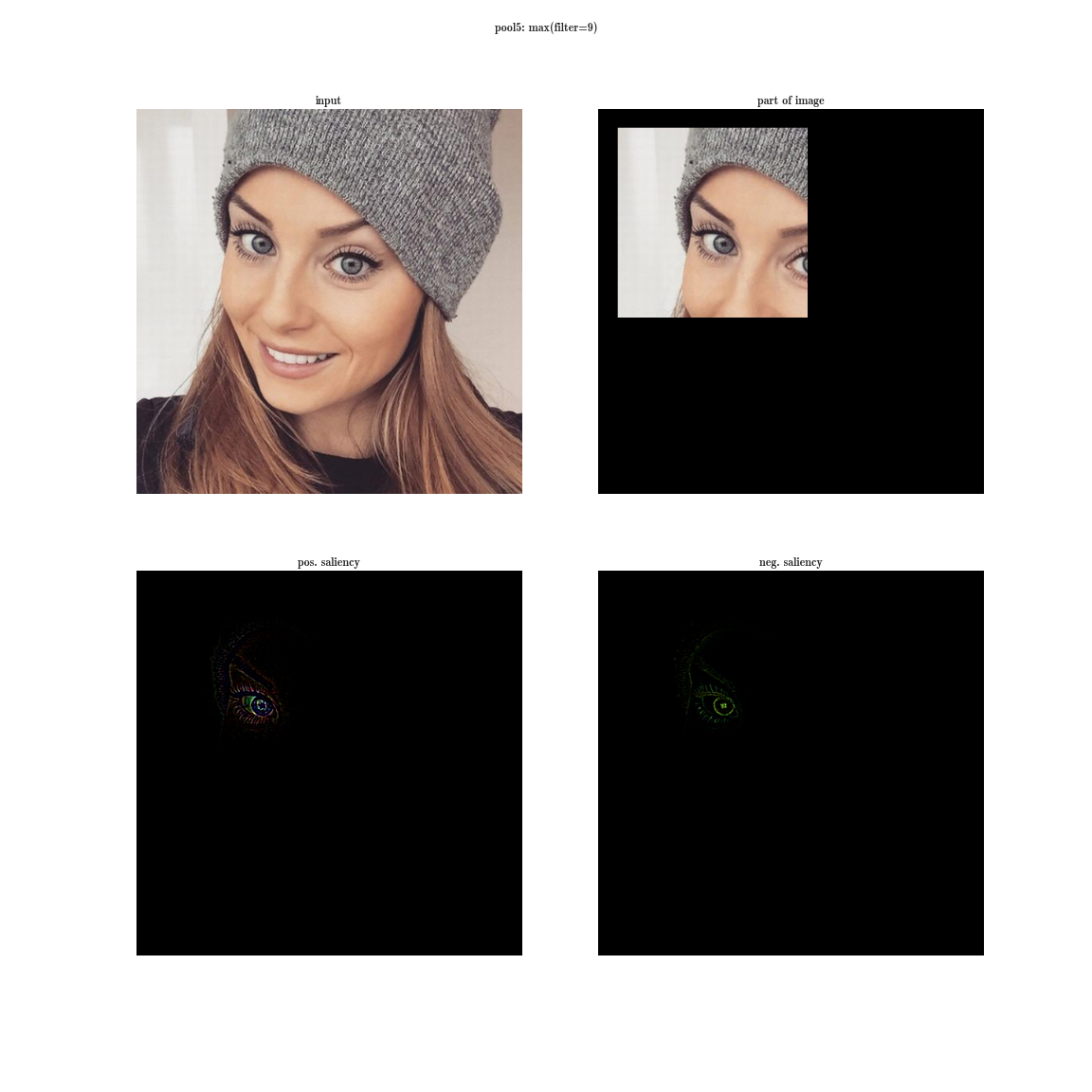

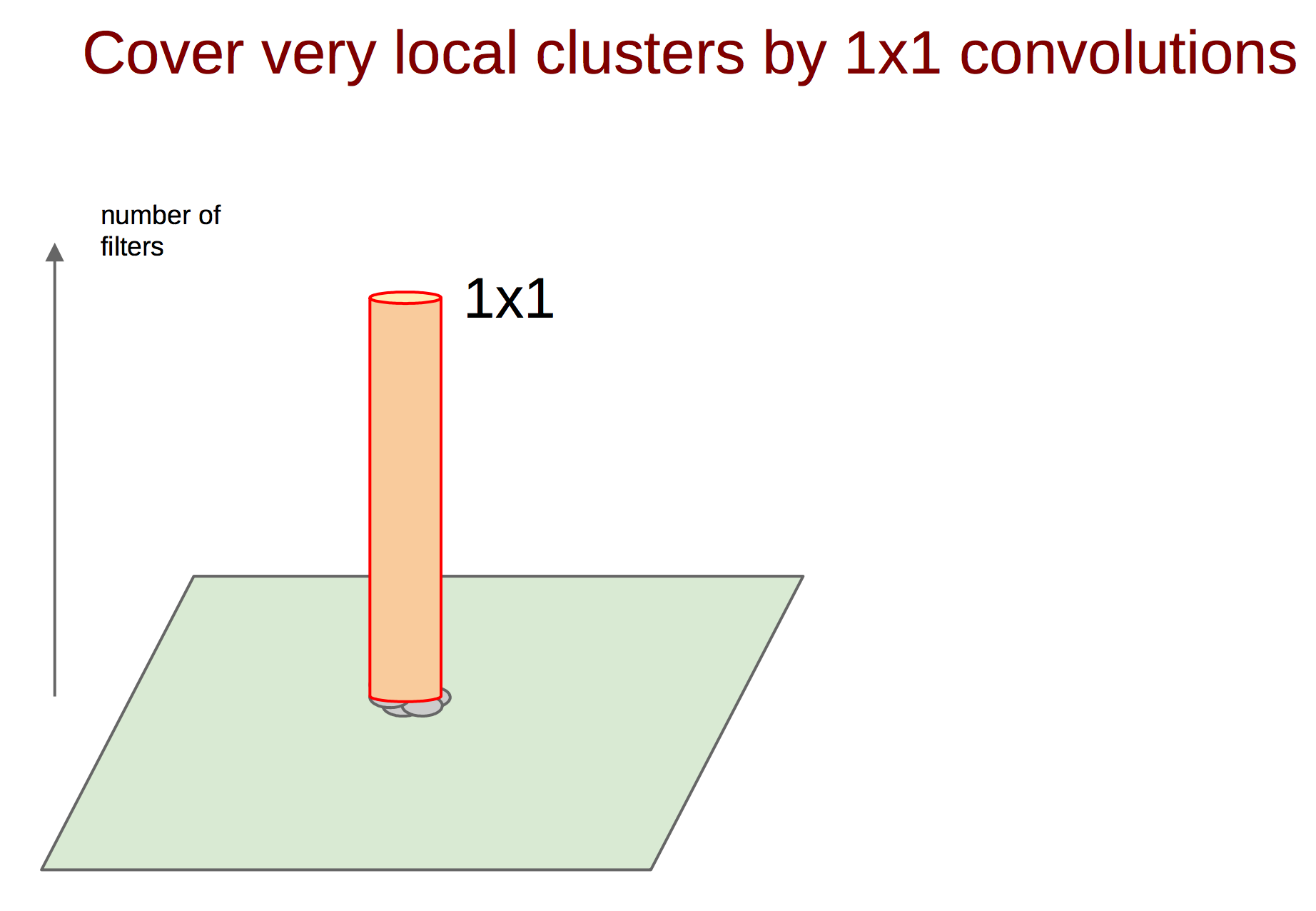

VGG-19ネットワークのconv1_2層の受容体領域

はい、受容領域は非常に小さいため、ほとんど何も表示されません。これはそれぞれ2番目の3×3畳み込みであり、一般的な面積は5×5です。

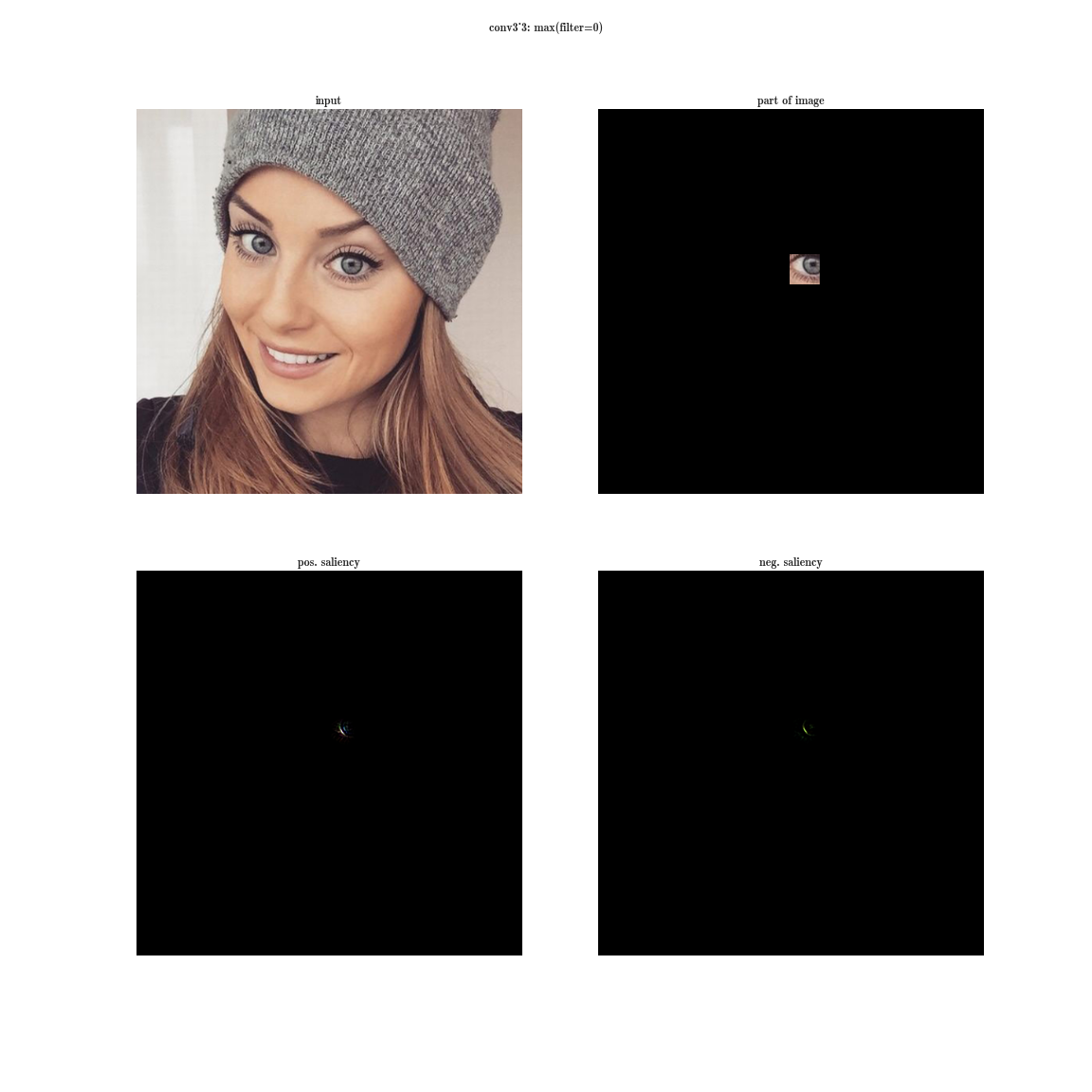

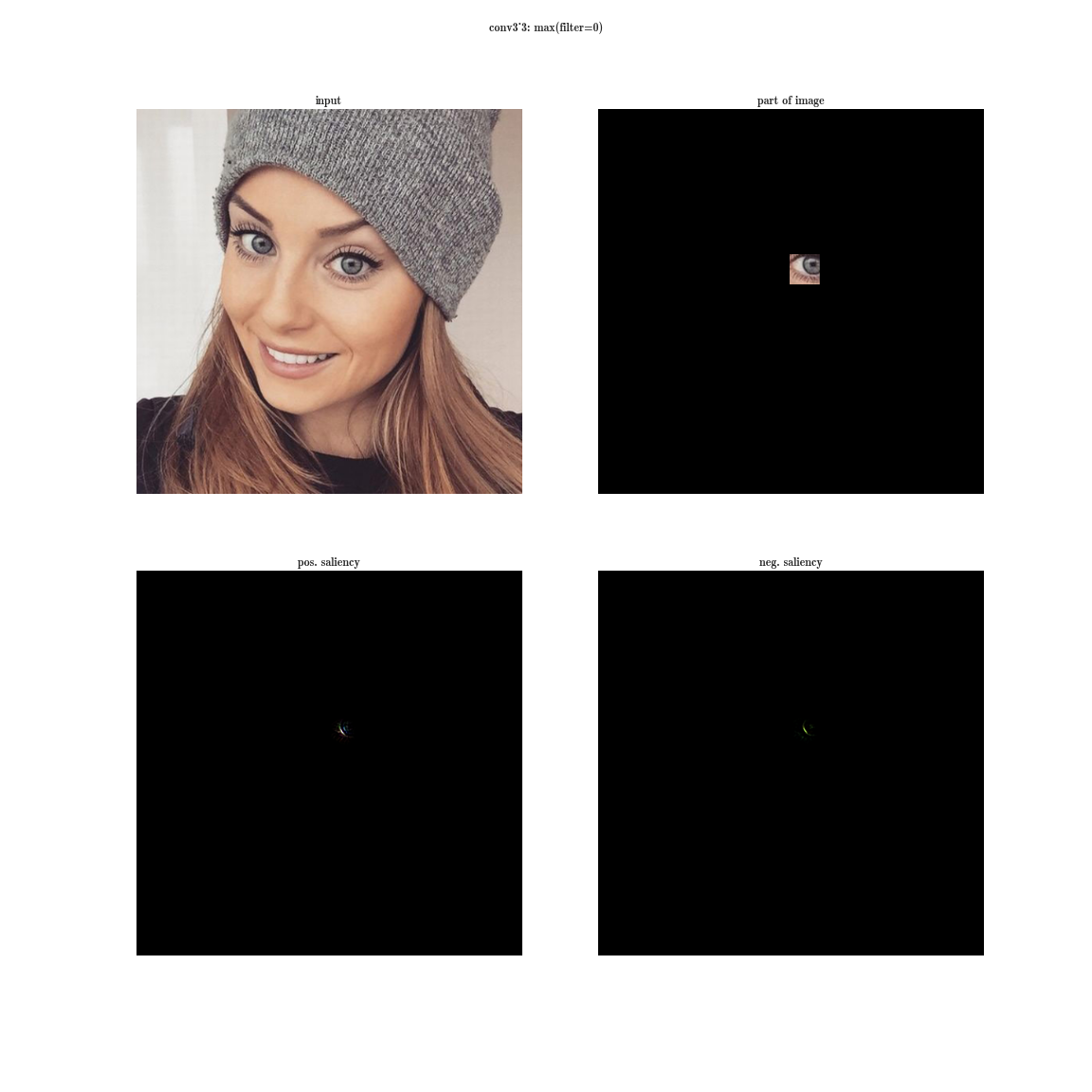

VGG-19ネットワーク受容体層conv3_3

VGG-19ネットワークのconv4_3層の受容体領域

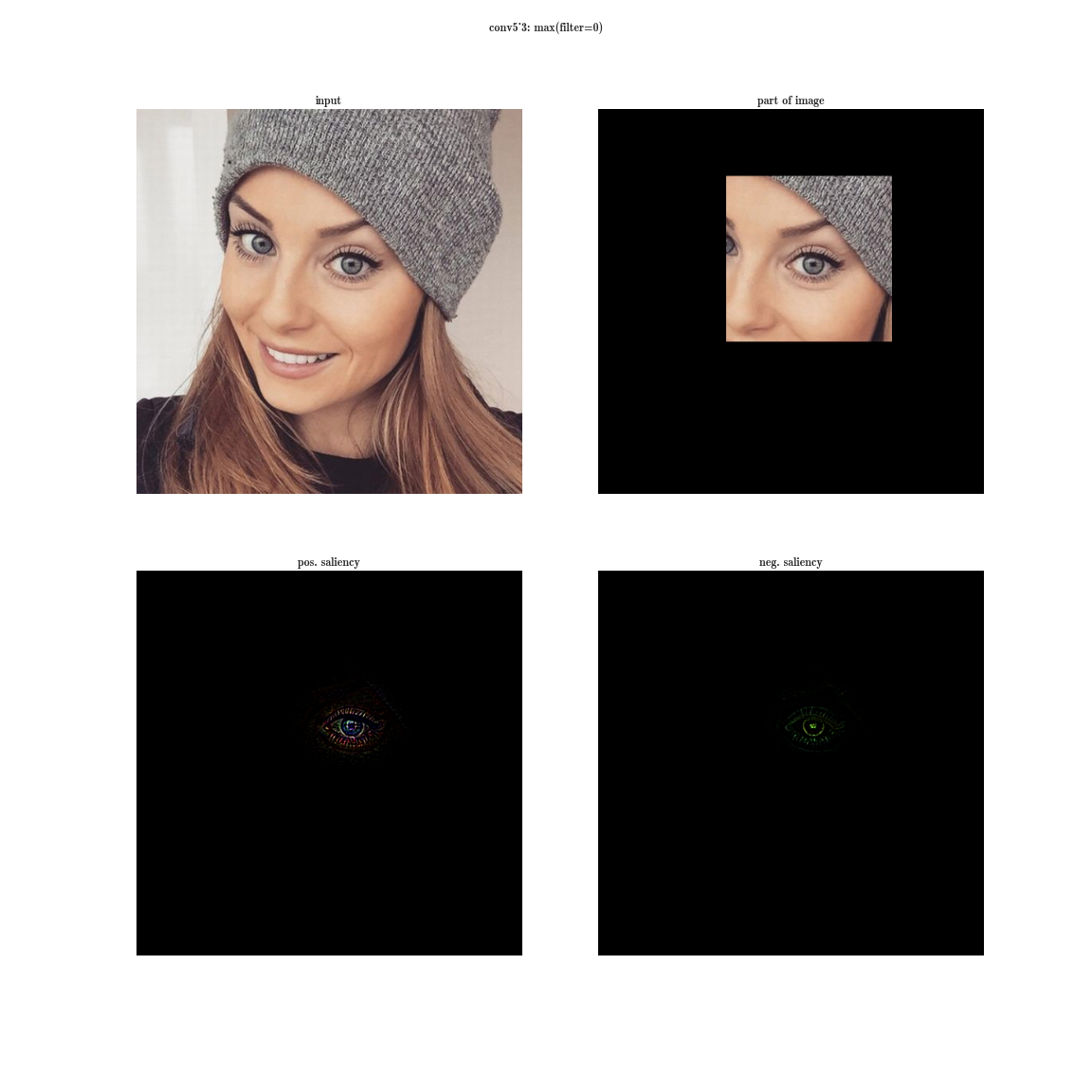

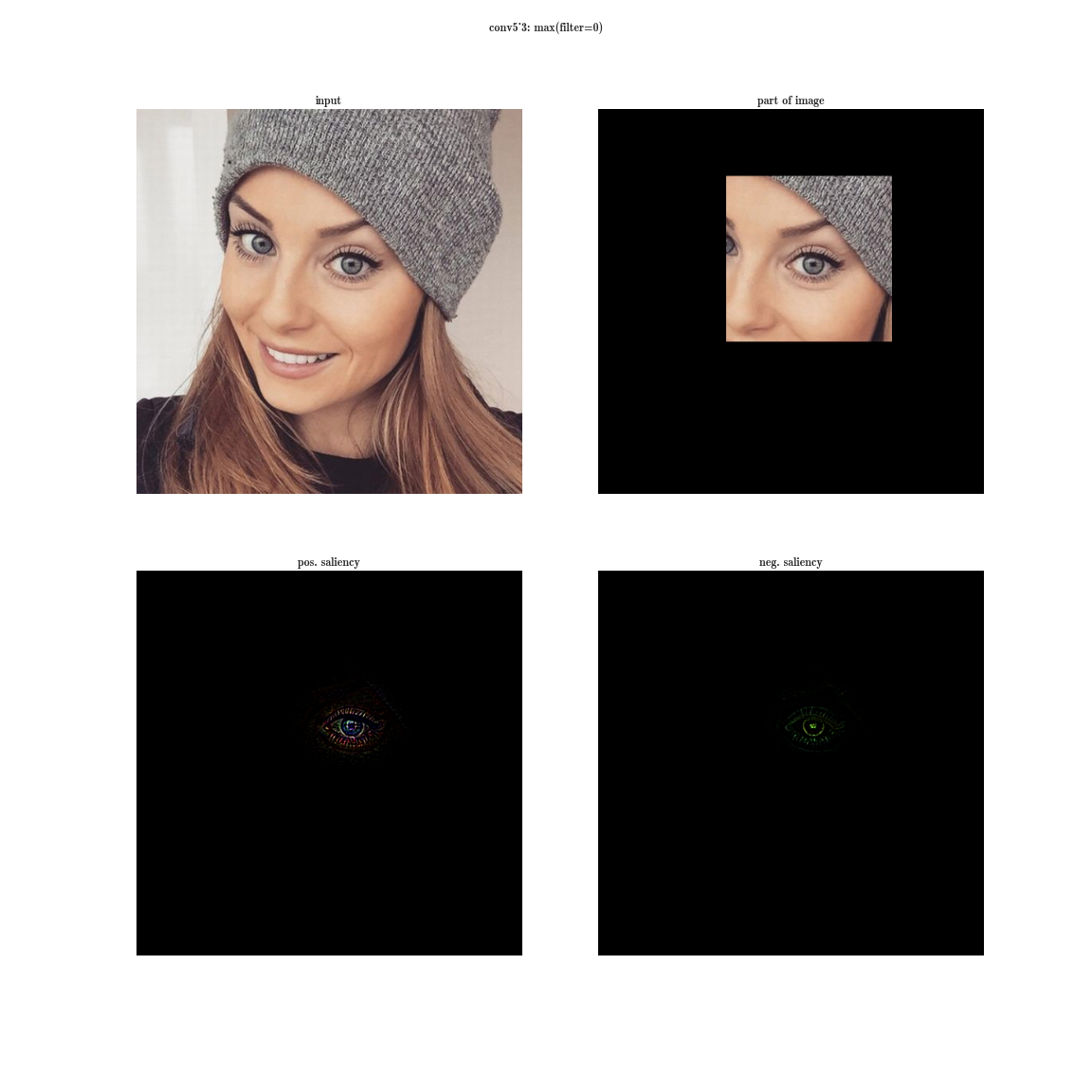

VGG-19ネットワーク受容体層conv5_3

VGG-19ネットワークpool5受容体領域

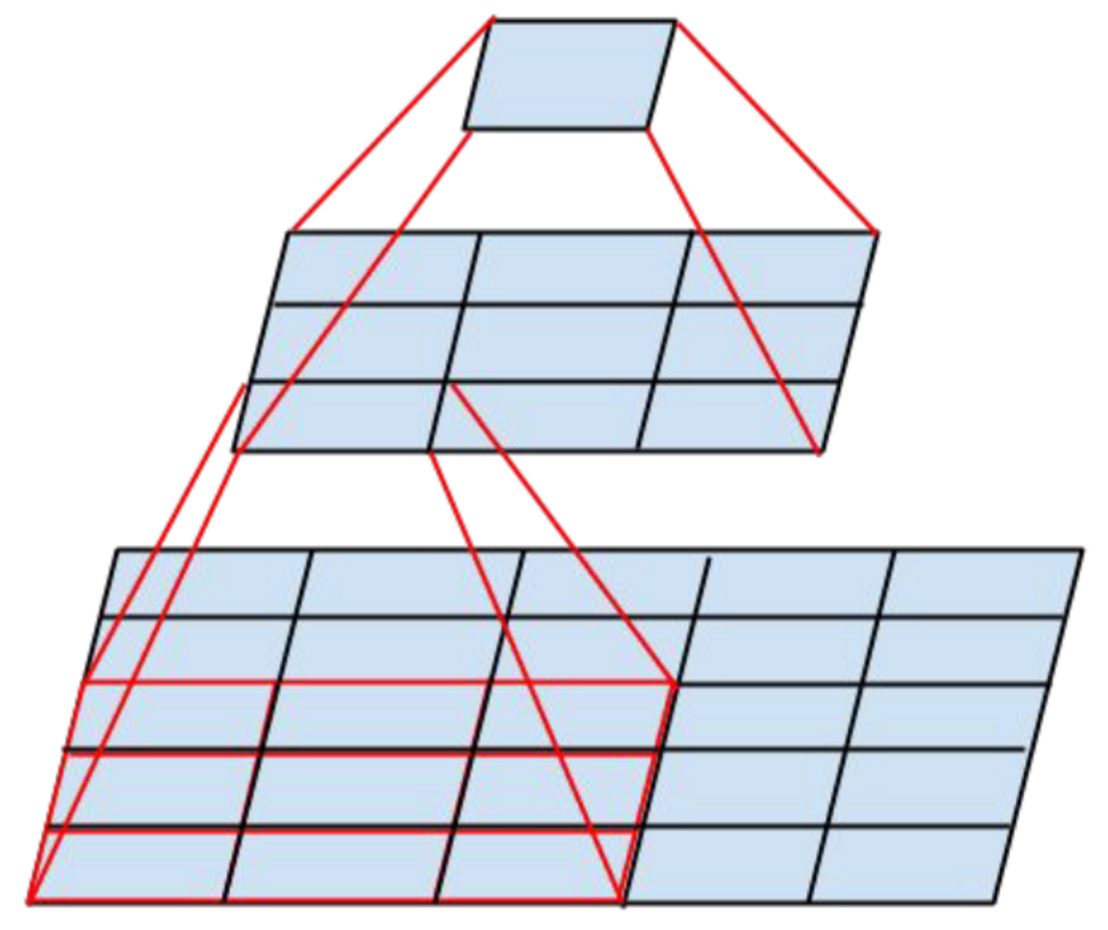

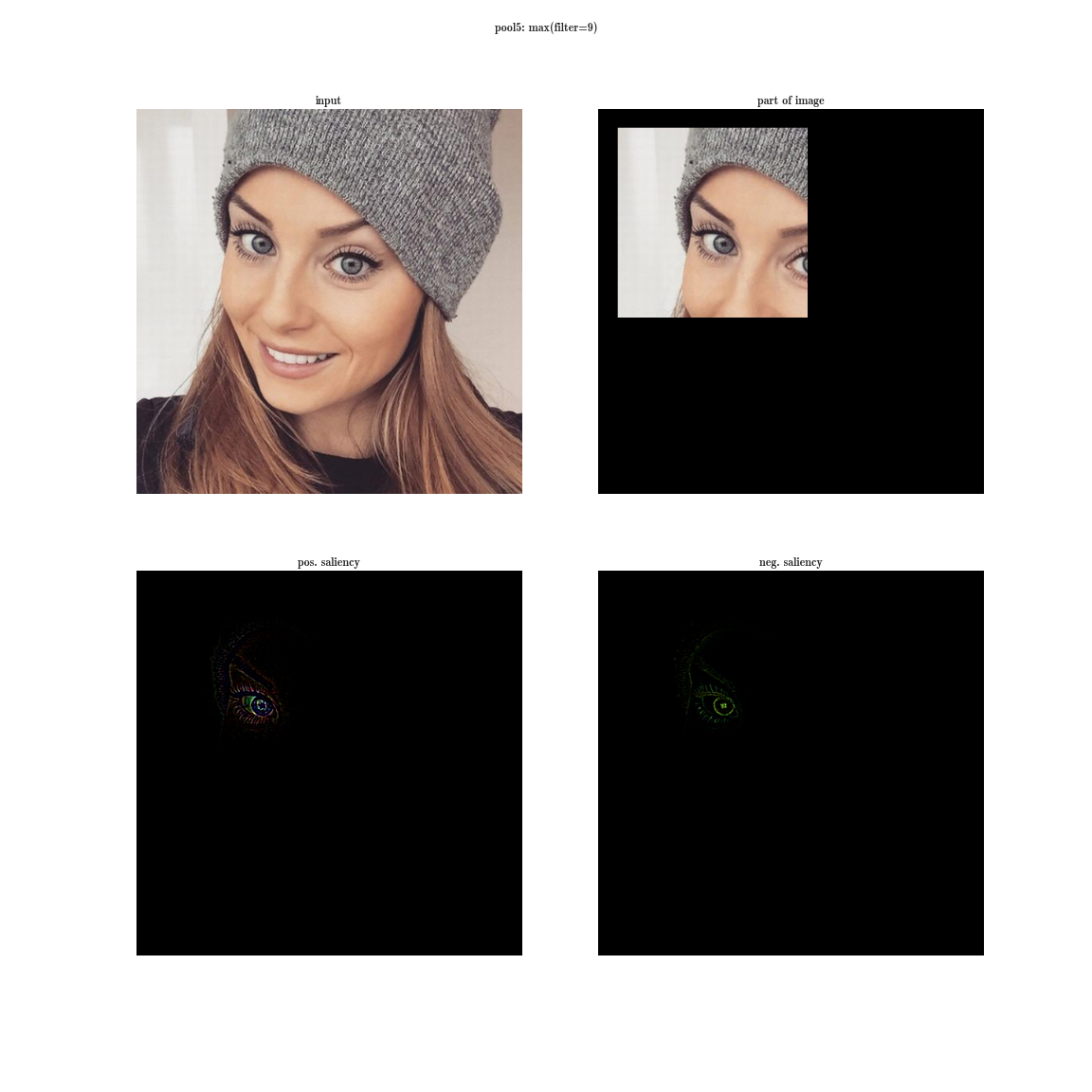

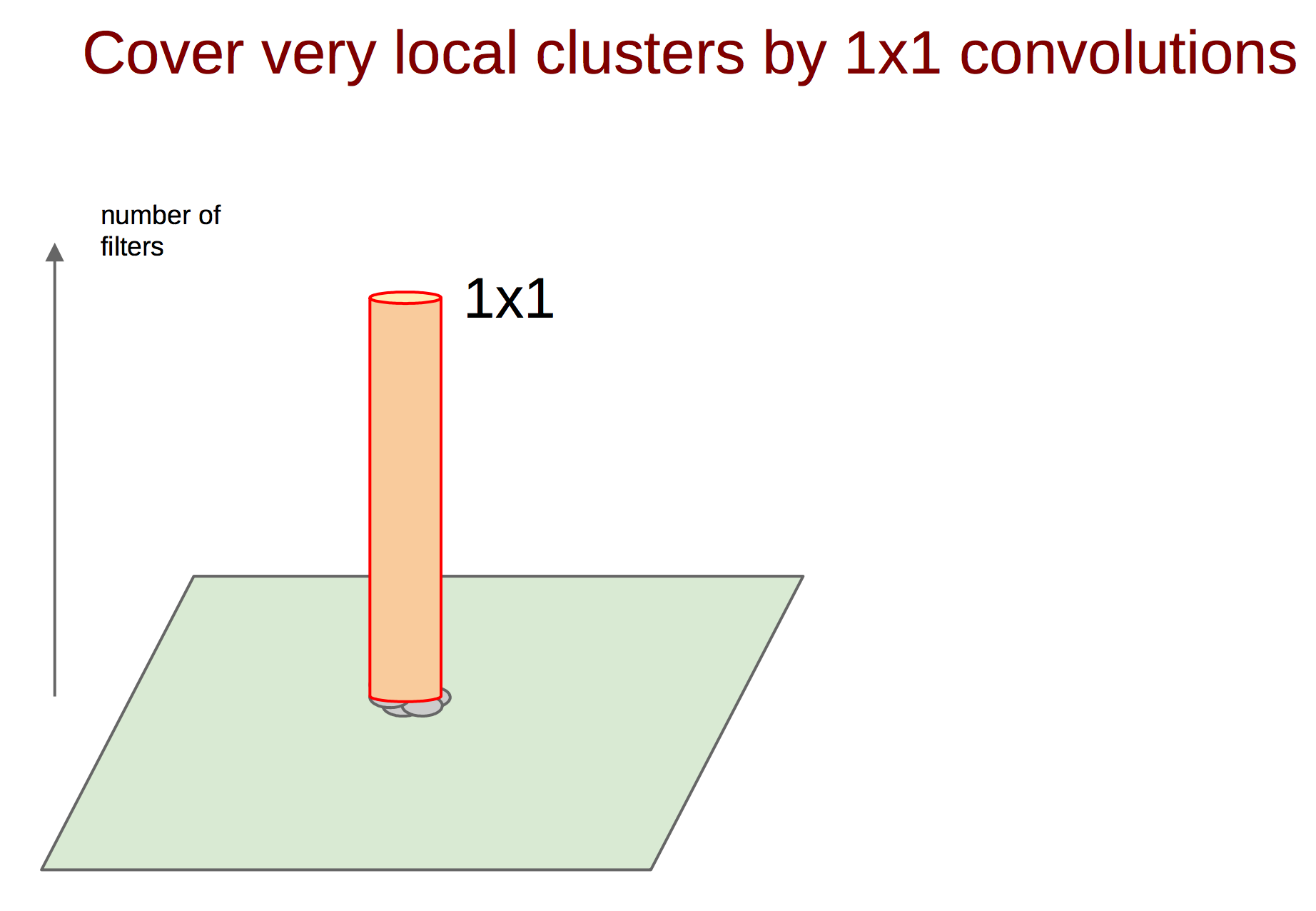

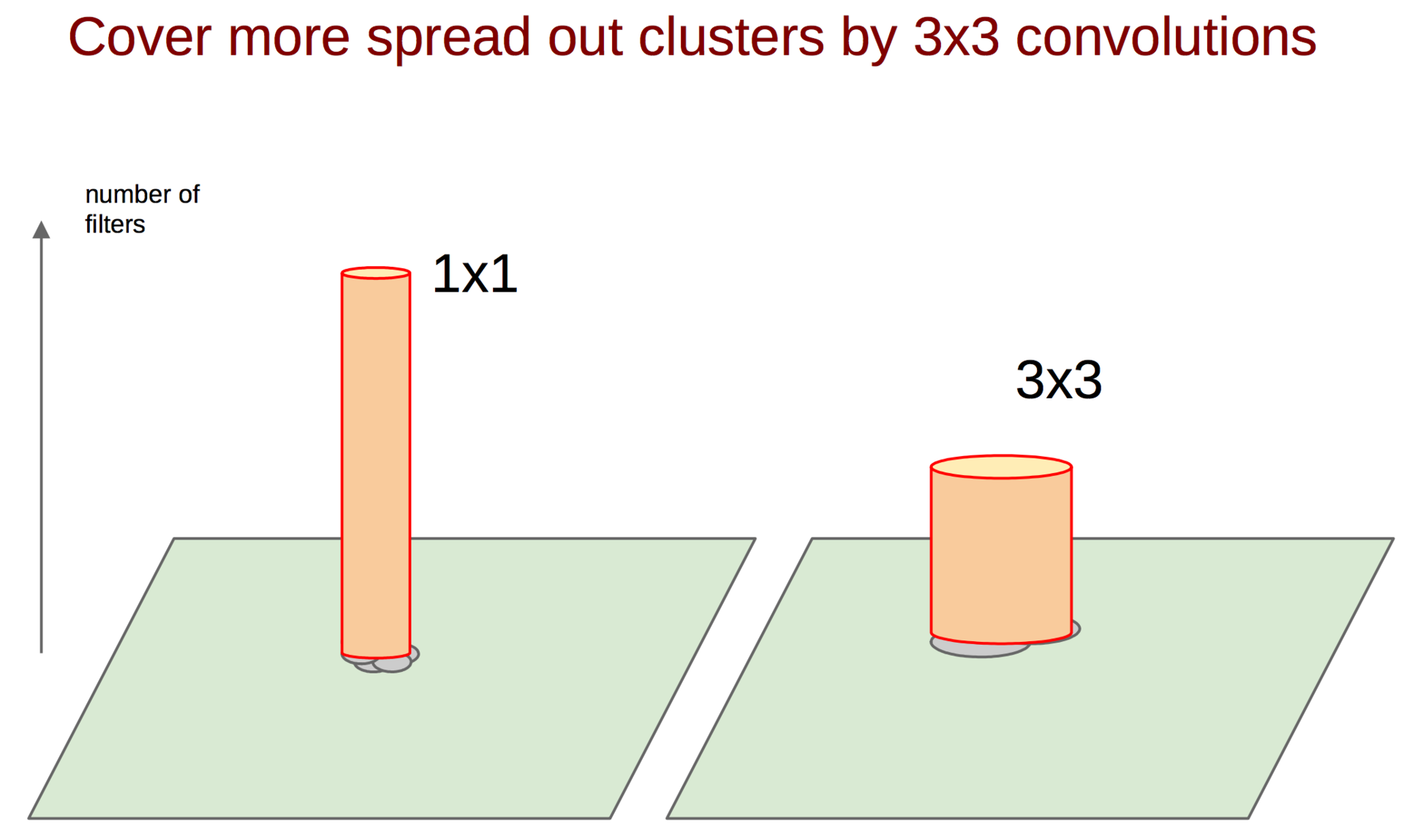

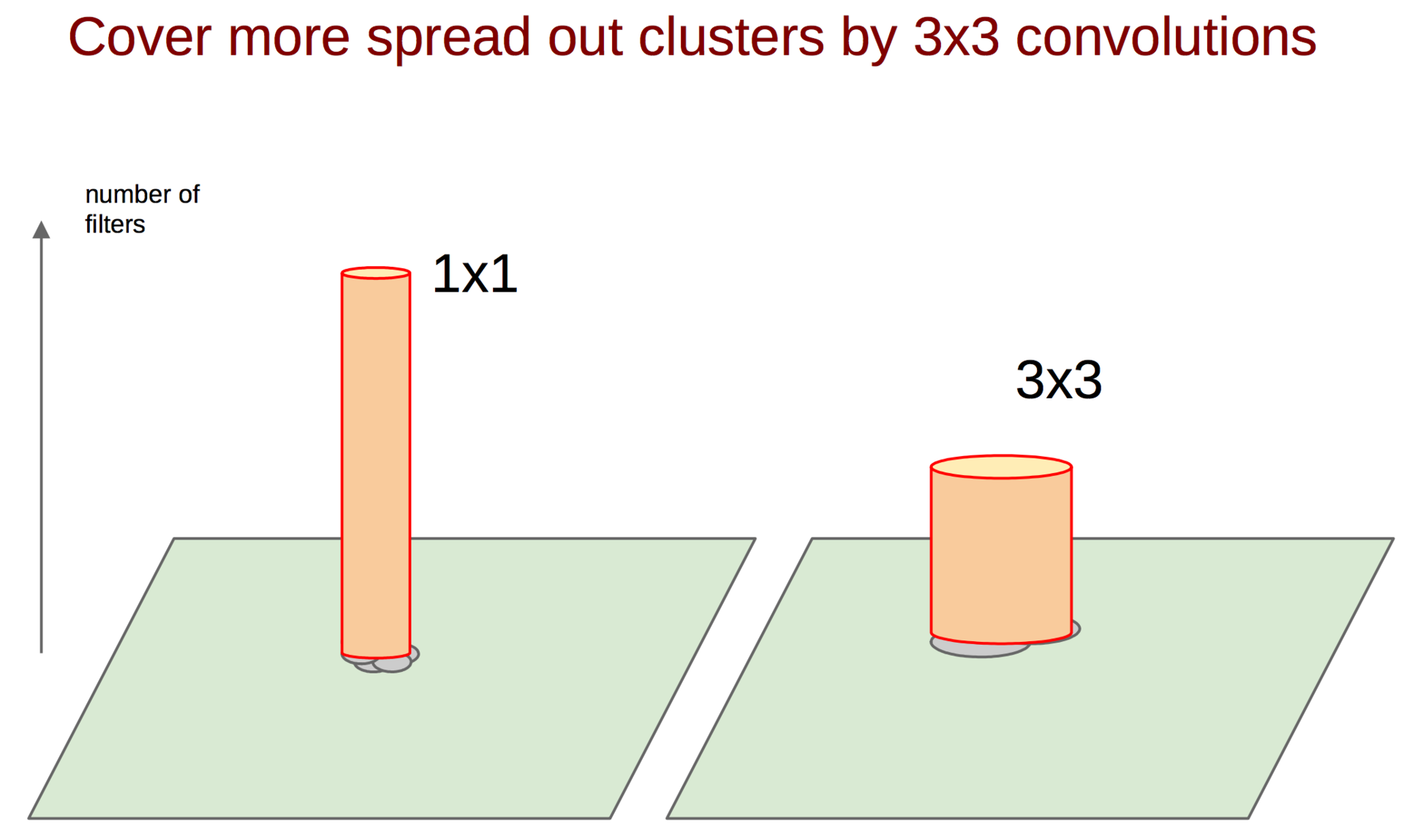

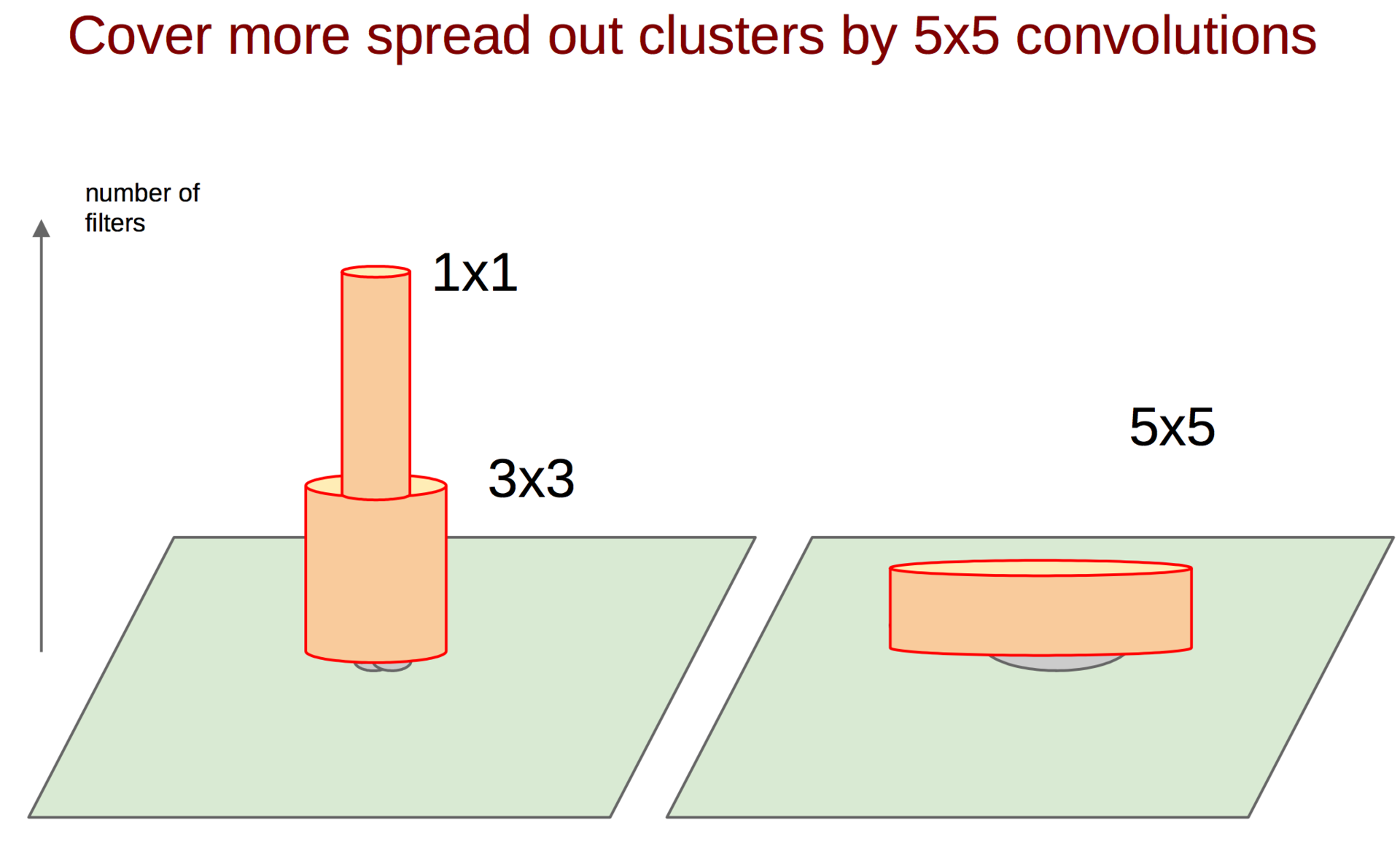

初期層(入り口に近い)では、相関ニューロンは局所領域に集中します。 つまり、プレート上の同じ座標(w、h)にある複数のニューロンが同じことを学習できる場合、最初の層の後のテンソルでは、それらの活性化は特定の点(w、h)の領域の小さな領域に配置されますが、分布しますフィルターバンクの次元に沿って配置されます-D.このようなもの:

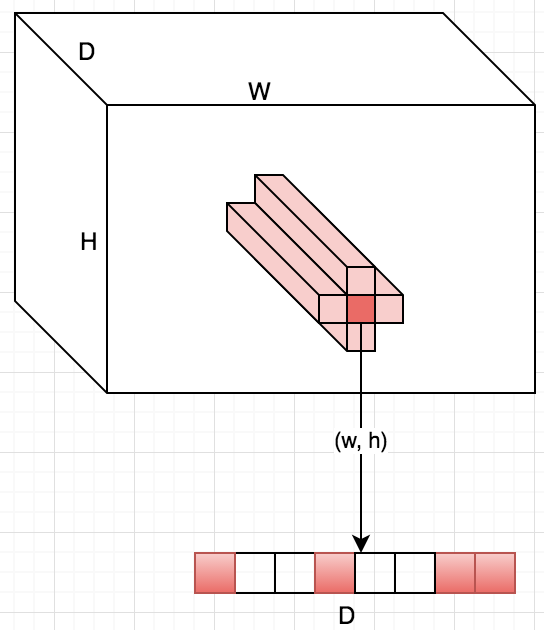

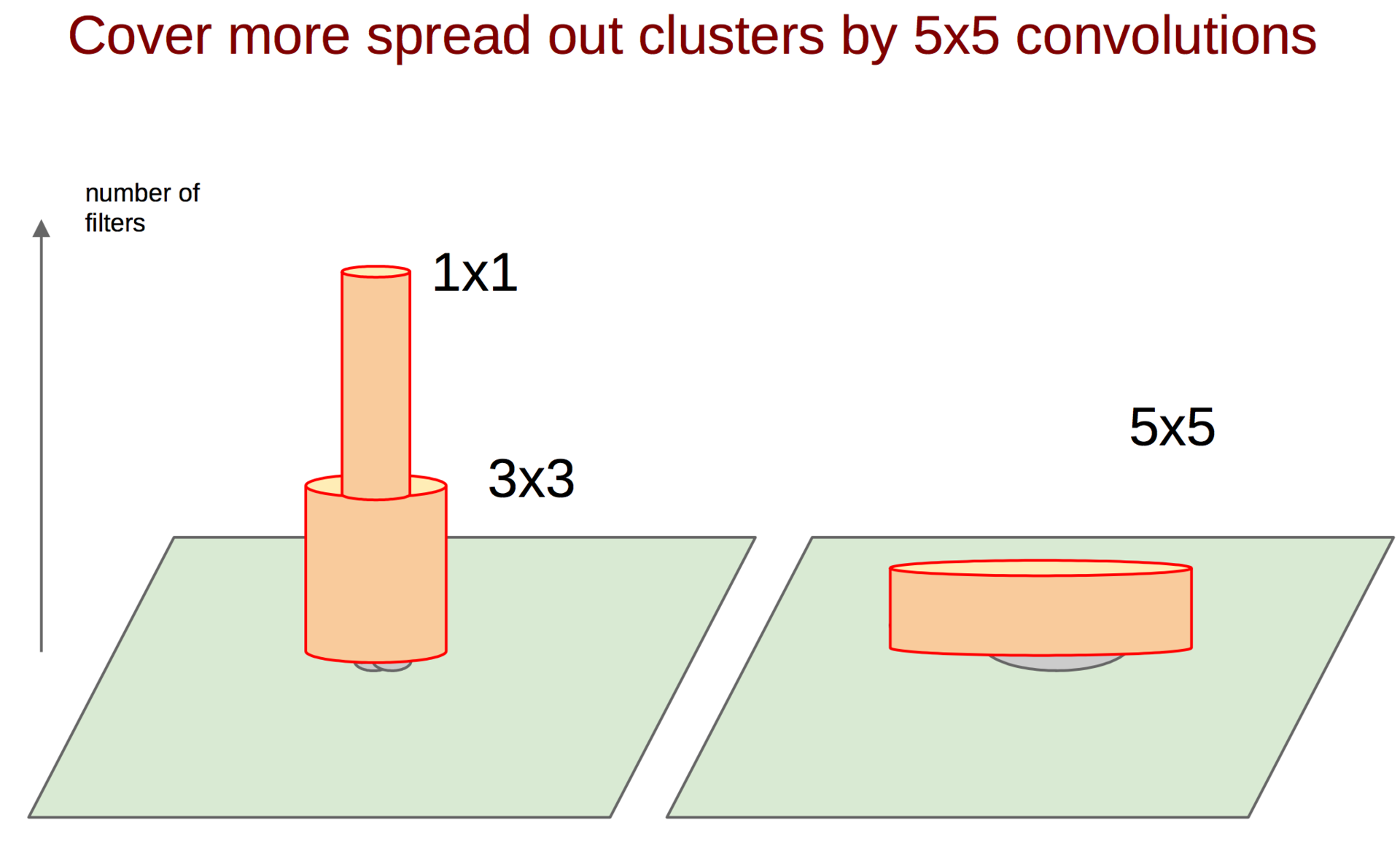

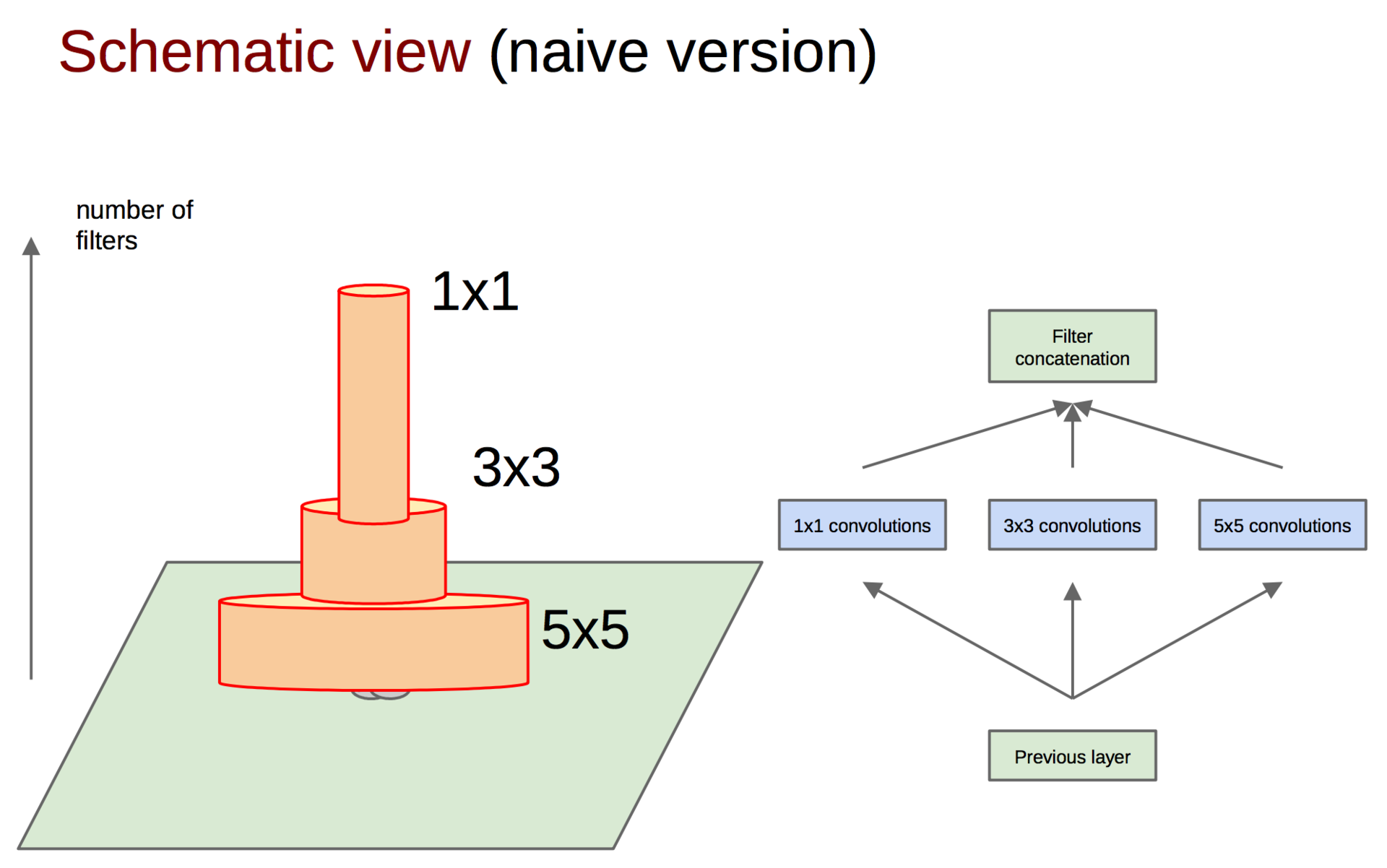

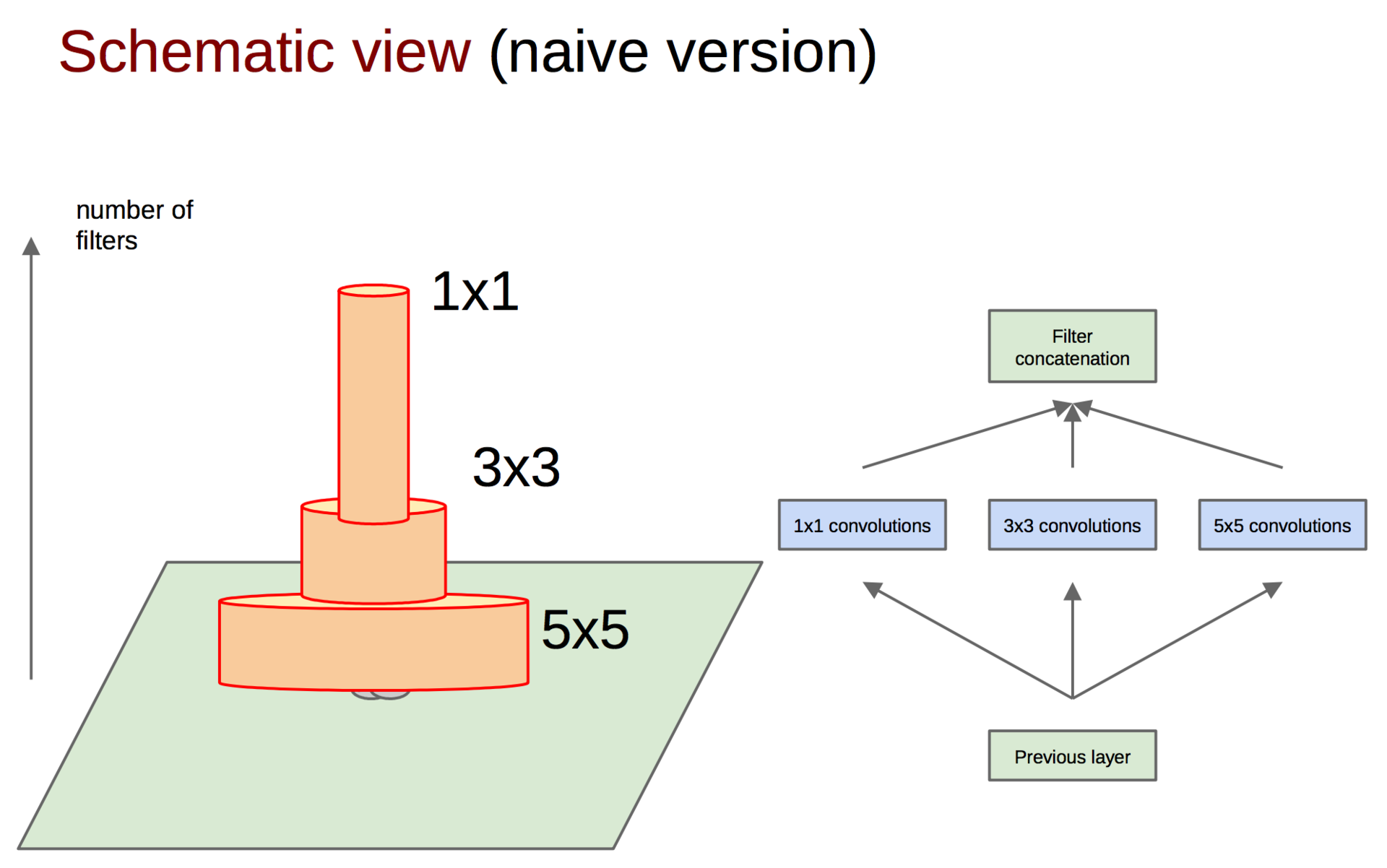

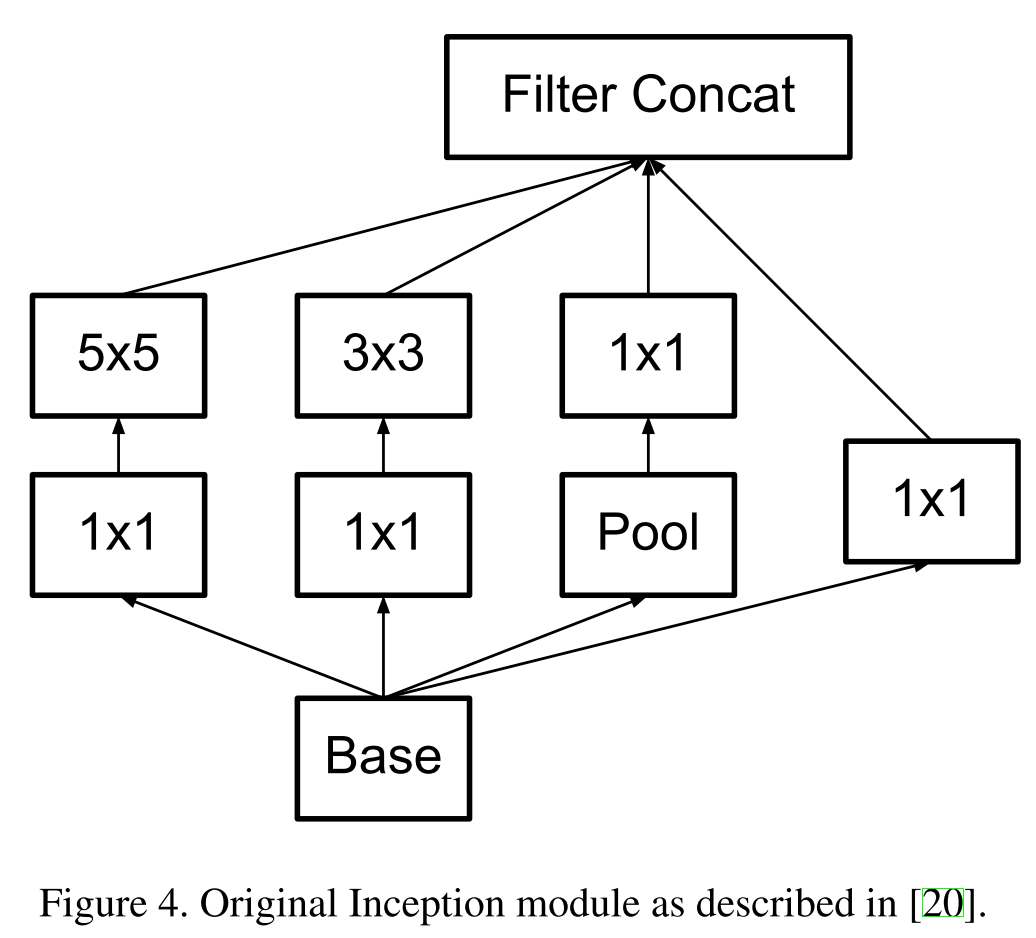

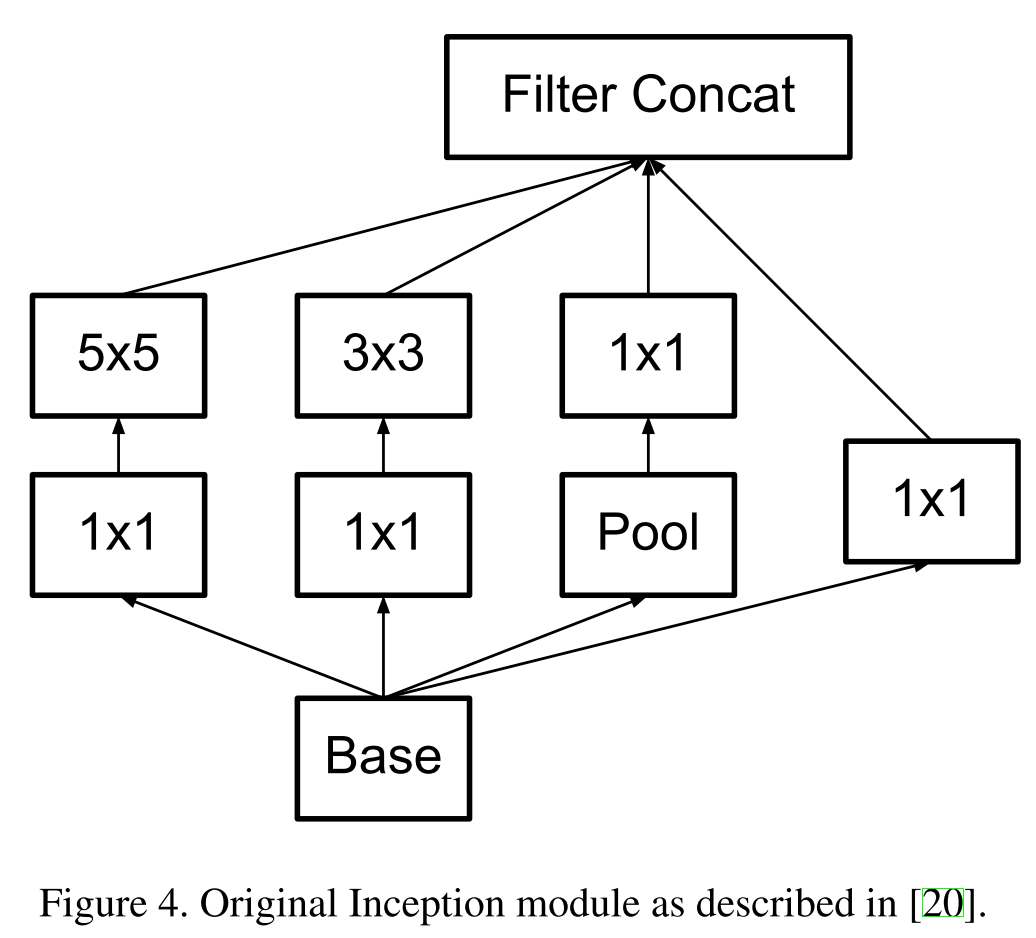

このような相関をキャッチして、それらを1つの兆候に変える方法は? 前作からの1×1畳み込みのアイデアが助けになります。 この考えを続けると、相関クラスターの数がわずかに少なく、たとえば3×3になると想定できます。これは5×5などにも当てはまりますが、Googleは5×5で停止することにしました。

たたみ込み1×1

たたみ込み3×3

たたみ込み5×5

各畳み込みの特徴マップを計算した後、それらを何らかの方法で集約する必要があります(たとえば、連結フィルター)。

標識の連結

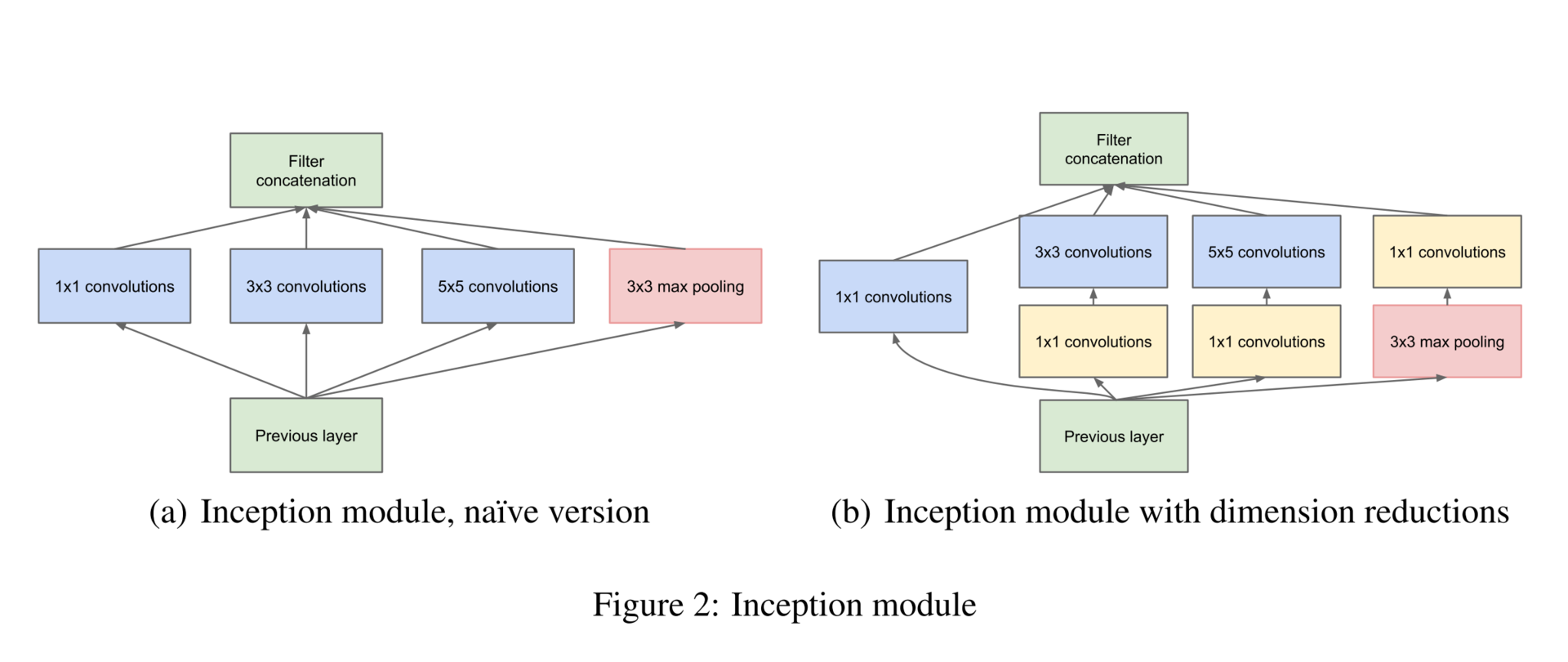

ちなみに、前のレイヤーの元の画像を失わないために、畳み込みに加えて、プーリングの兆候も追加されています(プーリング操作は情報の大きな損失を伴わないことを覚えています)。 とにかく、誰もがプーリングを使用します-それを拒否する理由はありません。 複数の操作のグループ全体をInceptionブロックと呼びます。

さらに、現在の最先端の畳み込みネットワークの成功にはプーリング操作が不可欠であるため、このような各段階で代替の並列プーリングパスを追加することも有益な効果があることを示唆しています。

出力テンソルのサイズを均一にするために、1×1の畳み込みを使用することも提案されています。これは、プル操作の直後の図で見ることができます。 さらに、1×1の畳み込みは、エネルギー集約的な畳み込み操作の前に次元を削減するためにも使用されます。 ご覧のとおり、Googleはこのような目標を達成するために1×1の畳み込みを使用しています(次世代ネットワークもこれらの手法を活用します)。

- 寸法の増加(手術後);

- 次元削減(手術前);

- 相関値のグループ化(ブロック内の最初の操作)。

最終的なモデルは次のとおりです。

上記に加えて、異なるレベルのいくつかの追加分類子にも気付くことができます。 元のアイデアは、そのような分類器が初期の層に勾配を「押し出す」ことを可能にし、それによって勾配減衰の影響を減らすというものでした。 Googleはそれらを後で拒否します。 ネットワーク自体がテンソルの深さを徐々に増やし、空間次元を減らします。 記事の終わりに、著者はそのようなモデルの有効性の問題を未解決のままにしており、また、上記の原則を使用してネットワークトポロジを自動的に生成する可能性を探ることを示唆しています。

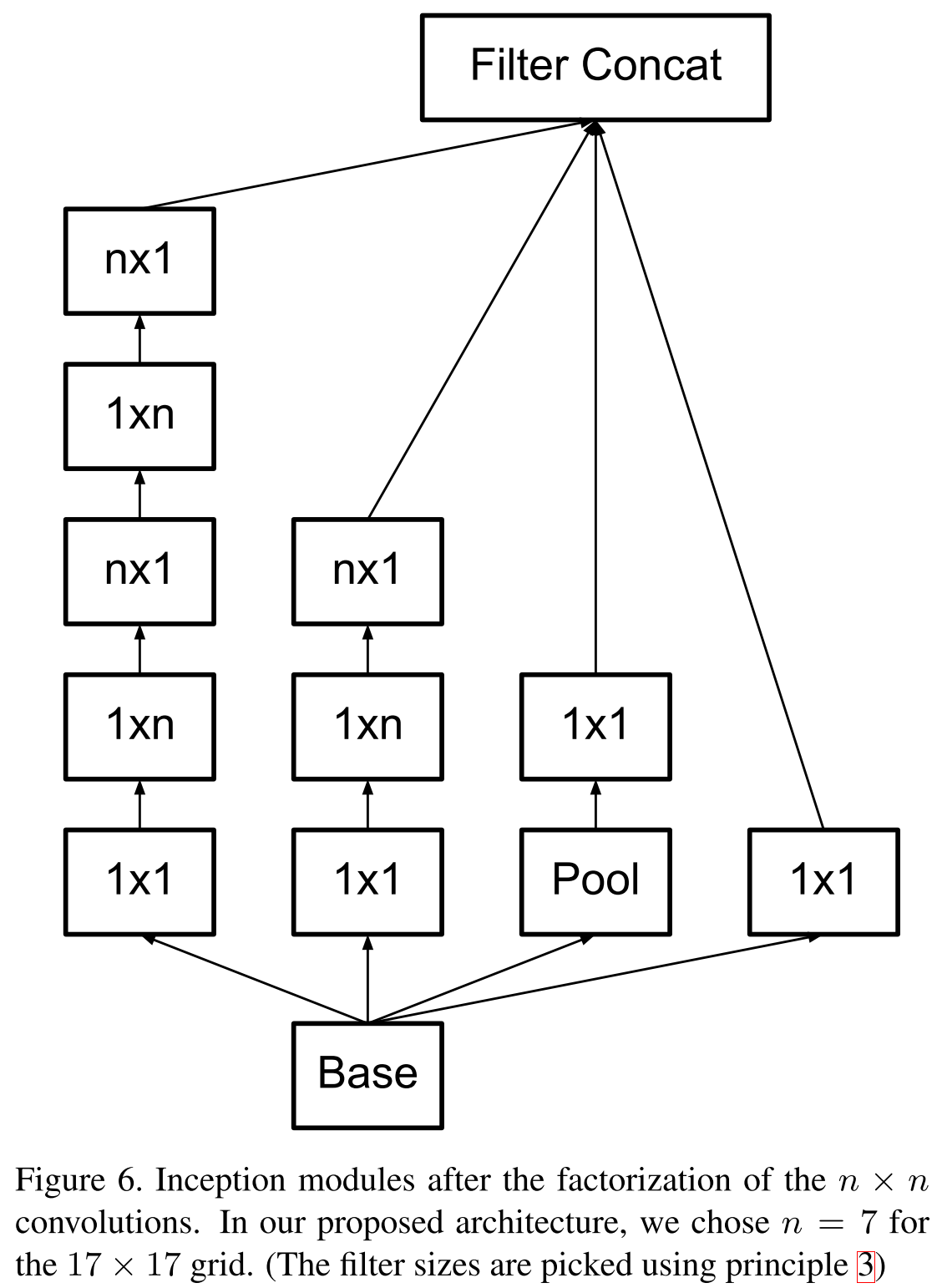

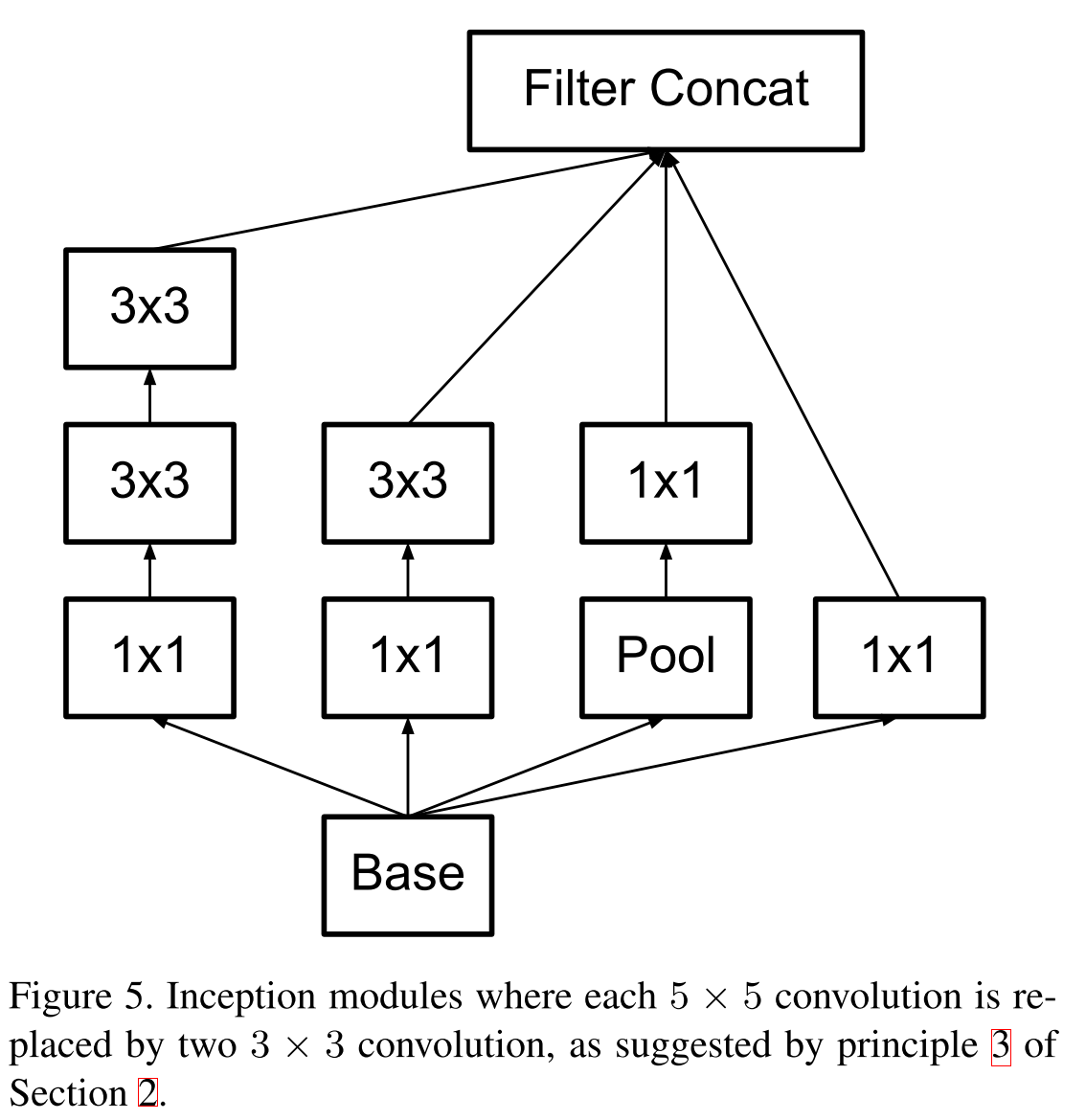

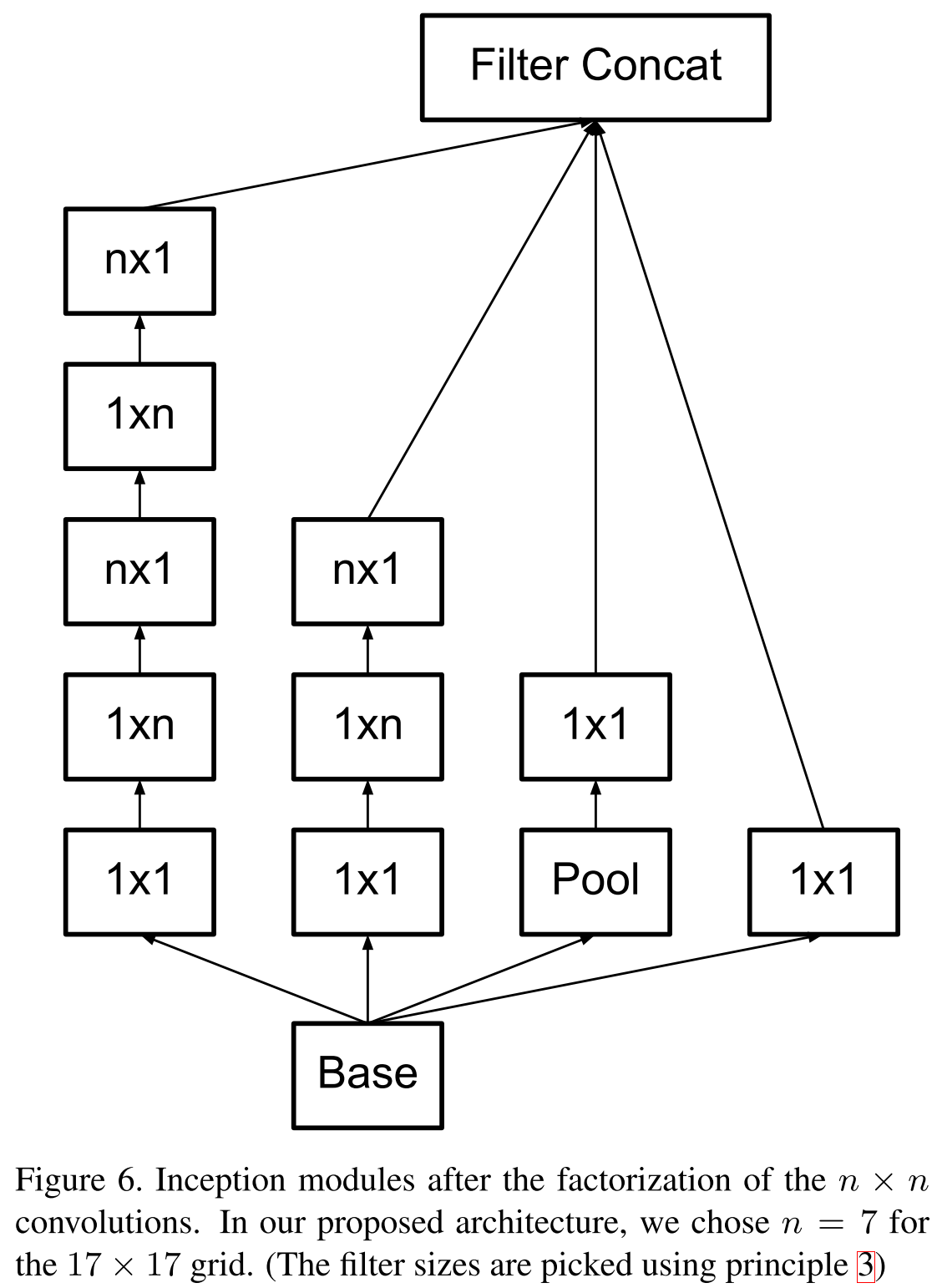

コンピュータービジョンのインセプションアーキテクチャの再考 (2015年12月11日)

1年後、グーグルはこの画像に対して十分に準備を整え、昆虫の構造を再考したが、完全に新しいモデルを失いました。これについては次のパートで説明します。 新しい記事では、著者は実際にさまざまなアーキテクチャを検討し、コンピュータービジョン用の深い畳み込みニューラルネットワークを構築するための4つの原則を開発しました。

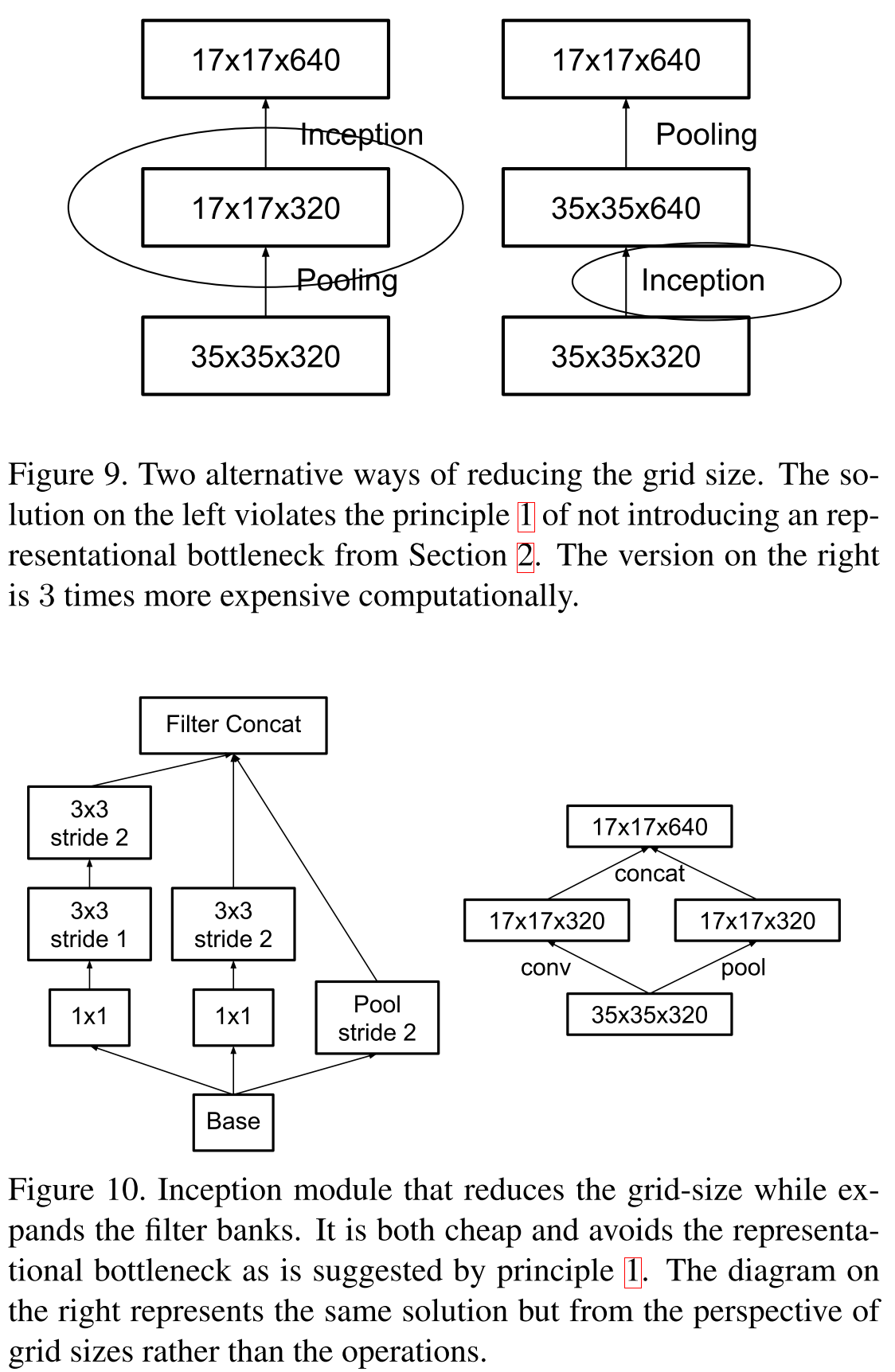

- 表現のボトルネックを回避します。データ表示の次元を大幅に減らすべきではありません。これは、ネットワークの最初から出力分類子までスムーズに行う必要があります。

- 高次元の表現はローカルで処理し、次元を増やします。次元をスムーズに減らすだけでは十分ではありません。前の記事で説明した原則を使用して相関セクションを分析およびグループ化する価値があります。

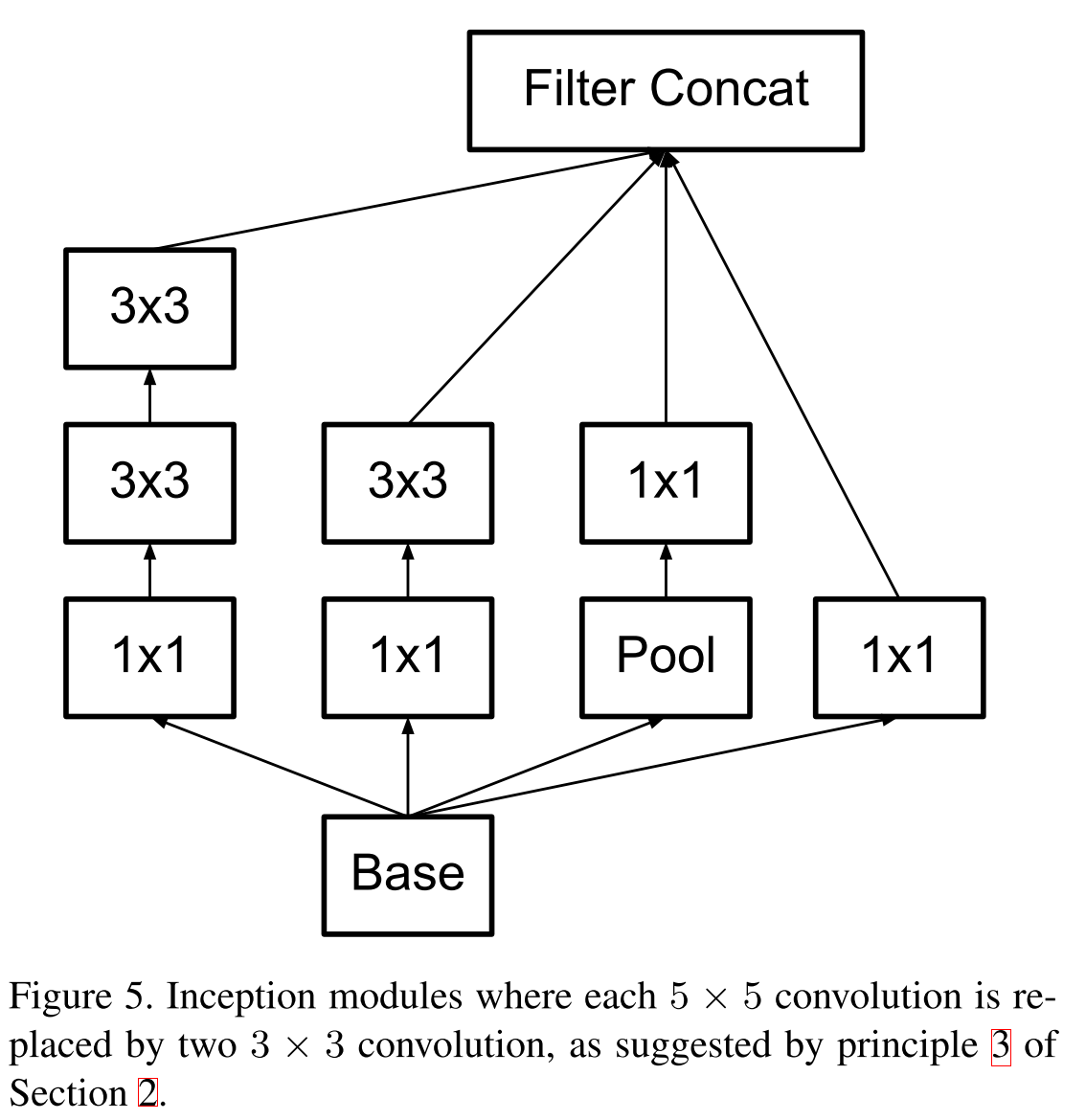

- 空間調整は、さらに小さなものに分解することができますし、そうする必要があります。これにより、リソースを節約し、ネットワークのサイズを増やすことができます。

- ネットワークの深さと幅のバランスを維持する必要があります。ネットワークの深さを幅とは別に急激に増加させたり、その逆を行ったりしないでください。 両方の寸法を均一に増減する必要があります。

大きな畳み込みを3×3畳み込みスタックに分解できるという2014 VGGのアイデアを覚えていますか? したがって、グーグルはさらに進んで、すべての畳み込みをN×1および1×Nで因数分解しました。

インセプションブロックモデル

最初はオリジナルです。

VGGの原理によって最初に因数分解されました。

新しいブロックモデル。

VGGの原理によって最初に因数分解されました。

新しいブロックモデル。

ボトルネックに関しては、次のスキームが提案されています。 入力次元が

、取得したい

、取得したい  、その後、最初に畳み込みを適用します

、その後、最初に畳み込みを適用します  1のステップでフィルタリングしてから、ケースプーリング。 そのような操作の全体的な複雑さ

1のステップでフィルタリングしてから、ケースプーリング。 そのような操作の全体的な複雑さ  。 最初に引っ張り、次に畳み込みを行うと、複雑さが低下します

。 最初に引っ張り、次に畳み込みを行うと、複雑さが低下します  しかし、その後、最初の原則に違反します。 並列分岐の数を増やし、2のステップで畳み込みを行うことが提案されていますが、同時にチャネル数を2倍にすると、代表表現力は「スムーザー」を減少させます。 そして、テンソルの深さを操作するために、1×1の畳み込みが使用されます。

しかし、その後、最初の原則に違反します。 並列分岐の数を増やし、2のステップで畳み込みを行うことが提案されていますが、同時にチャネル数を2倍にすると、代表表現力は「スムーザー」を減少させます。 そして、テンソルの深さを操作するために、1×1の畳み込みが使用されます。

新しいモデルはInception V2と呼ばれ、 バッチ正規化を追加すると、Inception V3があります。 ちなみに、追加の分類子は削除されました。これらは特に品質を向上させるわけではないが、正規化子として機能できることが判明したためです。 しかし、この時点までに、正規化するためのより興味深い方法がすでにありました。

画像認識のための深層学習 (2015年12月10日)

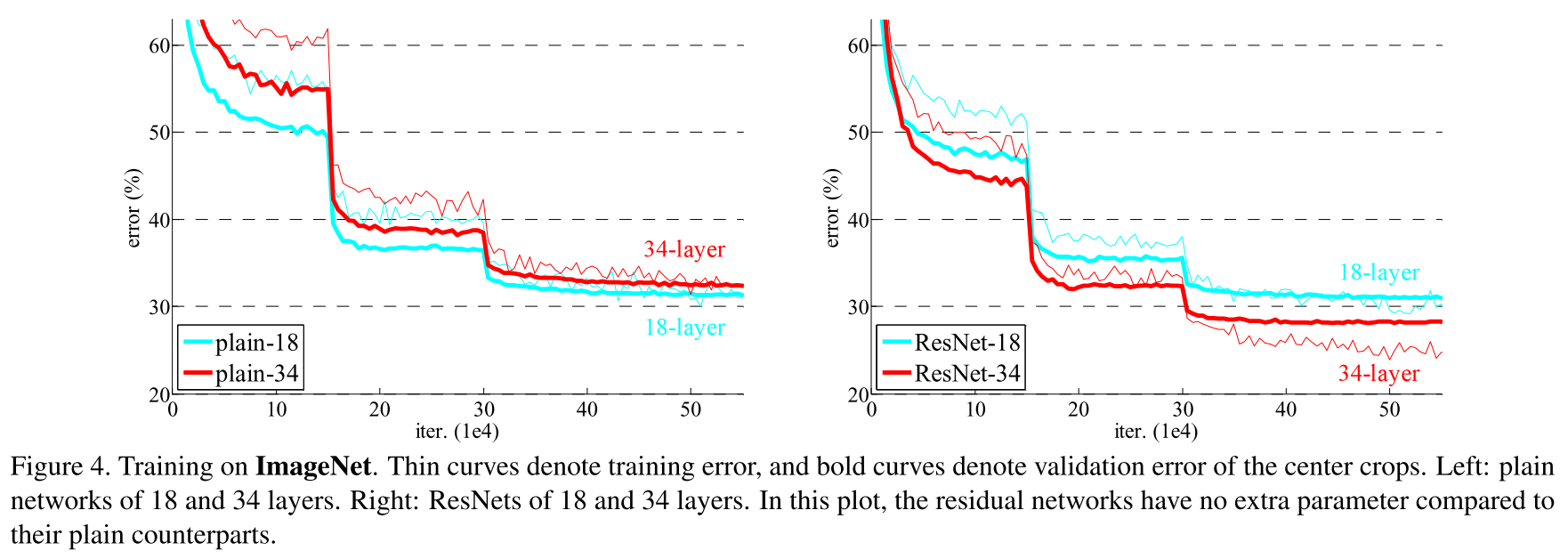

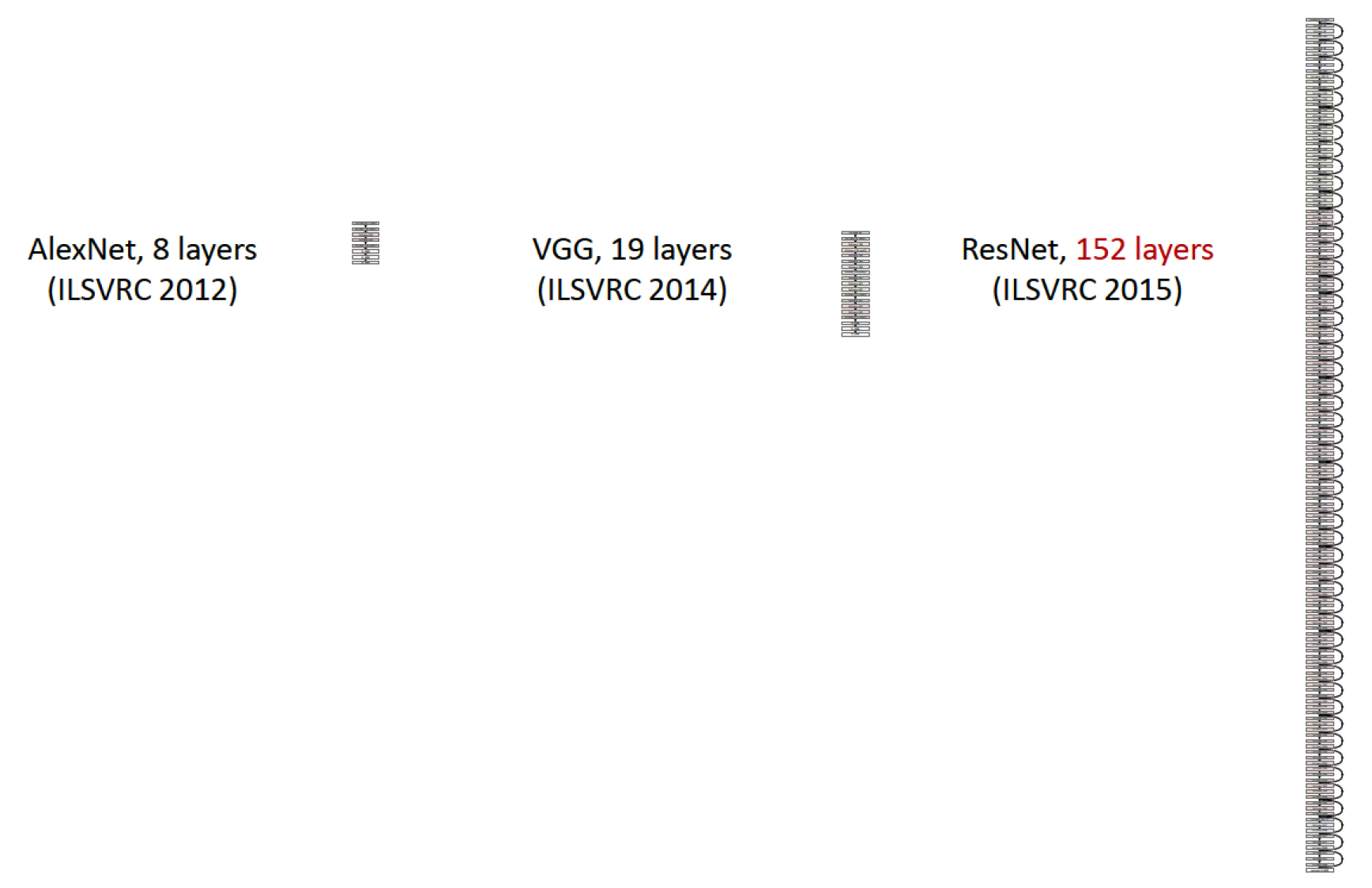

2015年にGoogleが失ったMicrosoft Researchの中国部門の仕事を研究する時が来ました。 単にもっと多くのレイヤーをドレーンすると、そのようなモデルの品質は一定の限界まで上昇し(VGG-19を参照)、その後低下し始めることが長い間気づいていました。 この問題は劣化問題と呼ばれ、より多くの層をドレーンすることによって得られるネットワークはプレーンな、またはフラットなネットワークです。 著者は、新しいレイヤーを追加することでモデルの品質が向上するトポロジを見つけることができました。

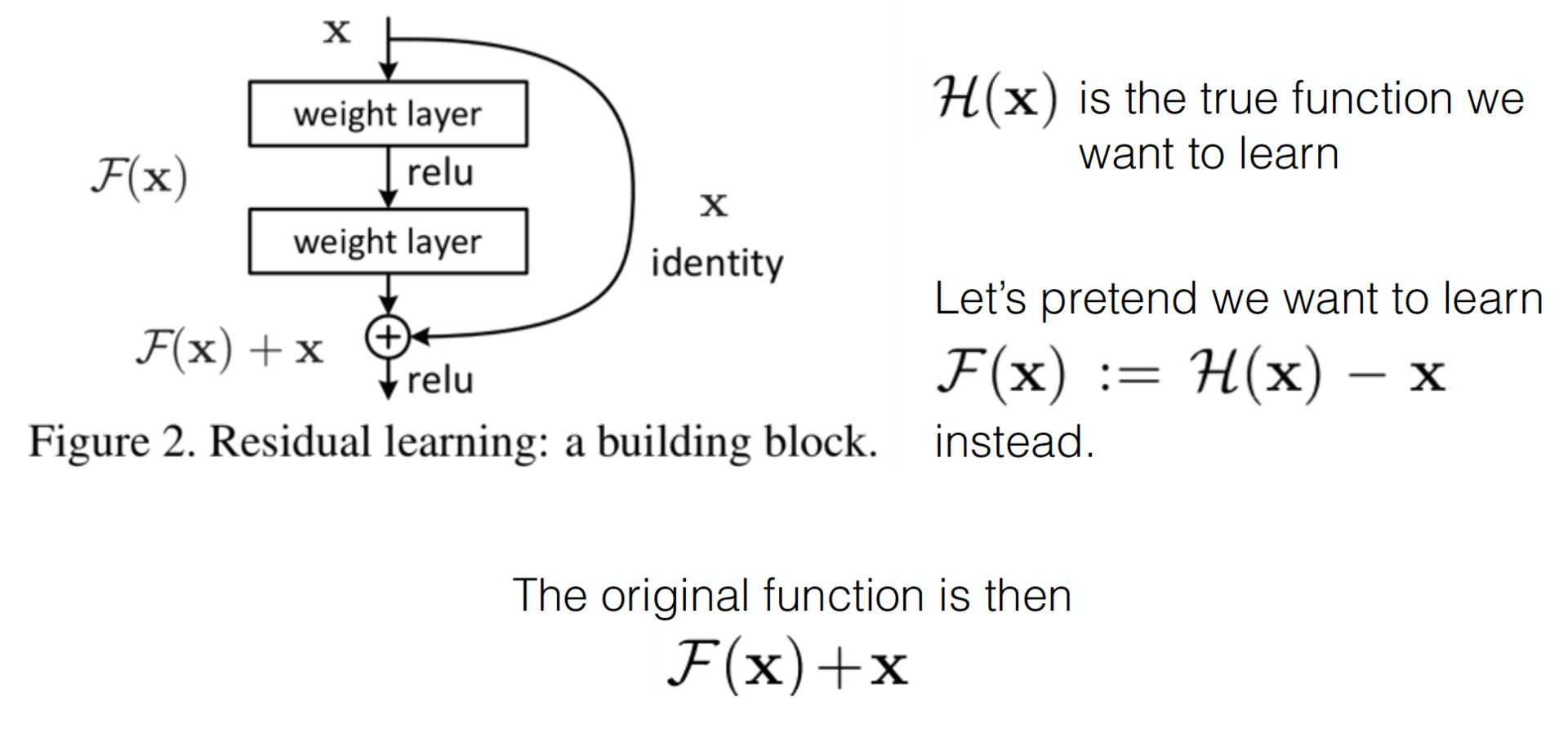

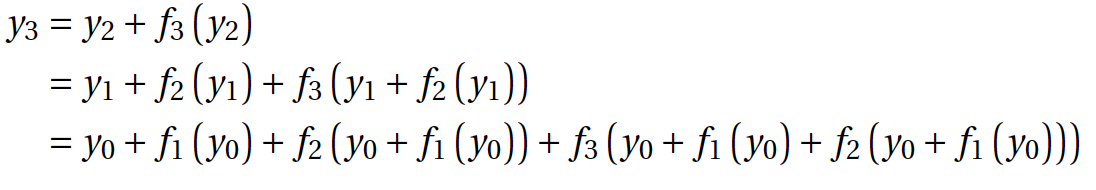

これは、一見、単純なトリックによって達成されますが、予期しない数学的結果につながります。 アーノルドとコルモゴロフのおかげで、私たちと彼らは、ニューラルネットワークがほぼすべての関数、たとえば、いくつかの複雑な関数を近似できることを認識しています。

。 そして、そのようなネットワークが残差関数を簡単に学習できることは事実です(ロシア語では残差関数と呼びます)。

。 そして、そのようなネットワークが残差関数を簡単に学習できることは事実です(ロシア語では残差関数と呼びます)。  。 明らかに、最初の目的関数は

。 明らかに、最初の目的関数は  。 ネットワーク、たとえばVGG-19を使用し、さらに20層を追加する場合、深層ネットワークが少なくともその浅層ネットワークよりも悪くならないようにします。 劣化の問題は、複雑な非線形関数

。 ネットワーク、たとえばVGG-19を使用し、さらに20層を追加する場合、深層ネットワークが少なくともその浅層ネットワークよりも悪くならないようにします。 劣化の問題は、複雑な非線形関数  いくつかのレイヤーをドレーンすることで得られたものは、以前のレイヤーで品質の限界に達した場合に恒等変換を学習するはずです。 しかし、これは何らかの理由で発生しません。おそらく、オプティマイザは単純に重みの調整に対応できないため、複雑な非線形階層モデルが同一の変換を行います。 しかし、ショートカット接続を追加するのを手伝えば、オプティマイザーがすべての重みをゼロに近づけることは、同一の変換を作成するよりも簡単かもしれません。 確かに、これはアイデアを後押しすることを思い出させます。

いくつかのレイヤーをドレーンすることで得られたものは、以前のレイヤーで品質の限界に達した場合に恒等変換を学習するはずです。 しかし、これは何らかの理由で発生しません。おそらく、オプティマイザは単純に重みの調整に対応できないため、複雑な非線形階層モデルが同一の変換を行います。 しかし、ショートカット接続を追加するのを手伝えば、オプティマイザーがすべての重みをゼロに近づけることは、同一の変換を作成するよりも簡単かもしれません。 確かに、これはアイデアを後押しすることを思い出させます。

フラットネットワークを残余ネットワークに変換する例

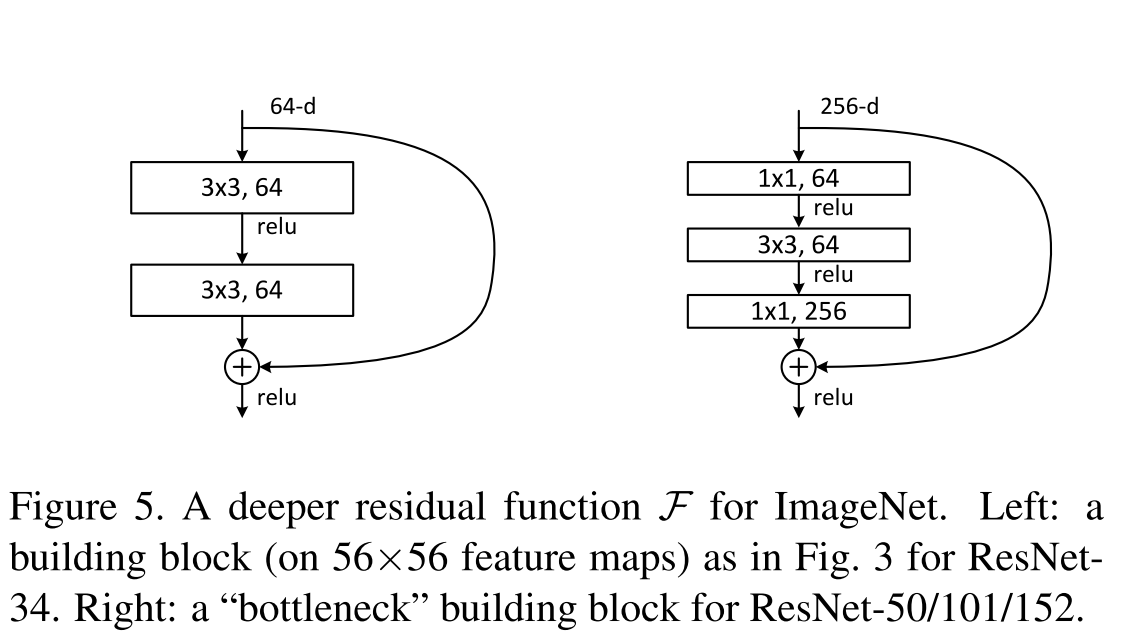

テアノ/ラザニアでのResNet-52の構築の詳細をここで説明します 。ここでは、Googleが遺言しているように、1×1の畳み込みが次元の増減に使用されることのみに言及します。 ネットワークは完全に畳み込みです。

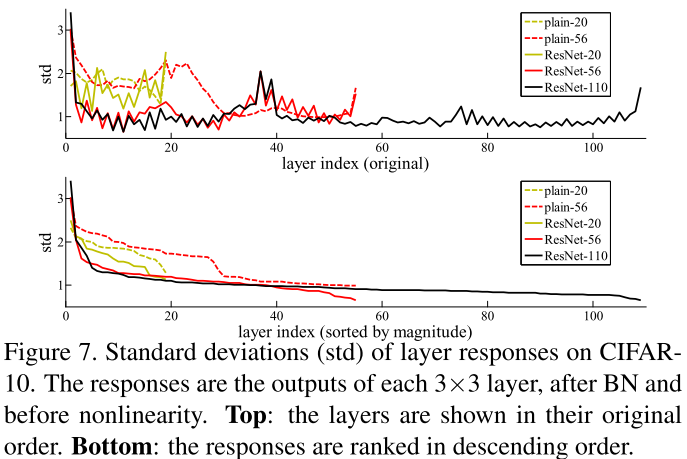

残差関数がゼロに近いという仮説の正当化の1つとして、著者は、層に応じて残差関数の活性化のグラフを示し、フラットネットワークの層の活性化を比較します。

そして、これらすべてからの結論はおよそ次のとおりです。

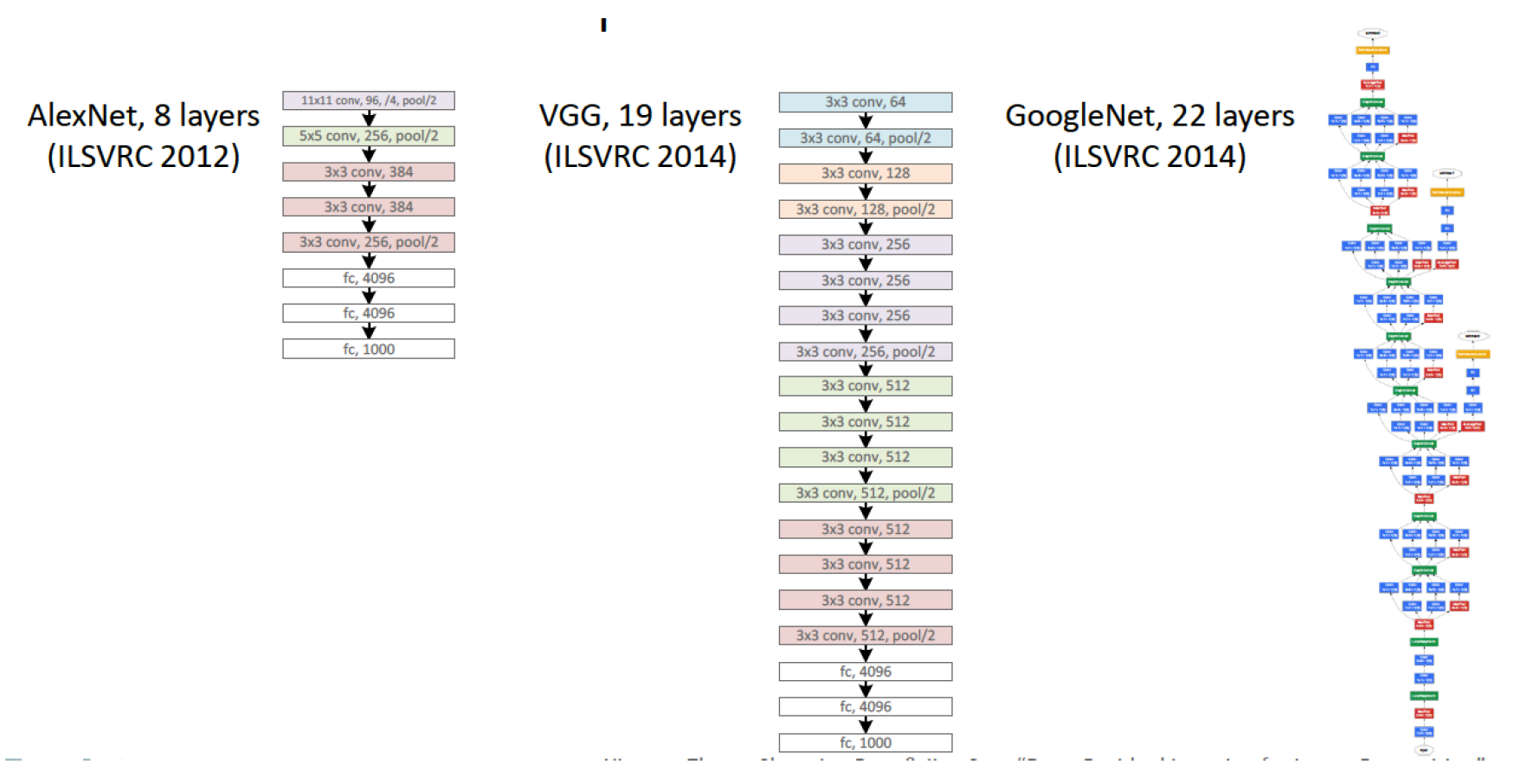

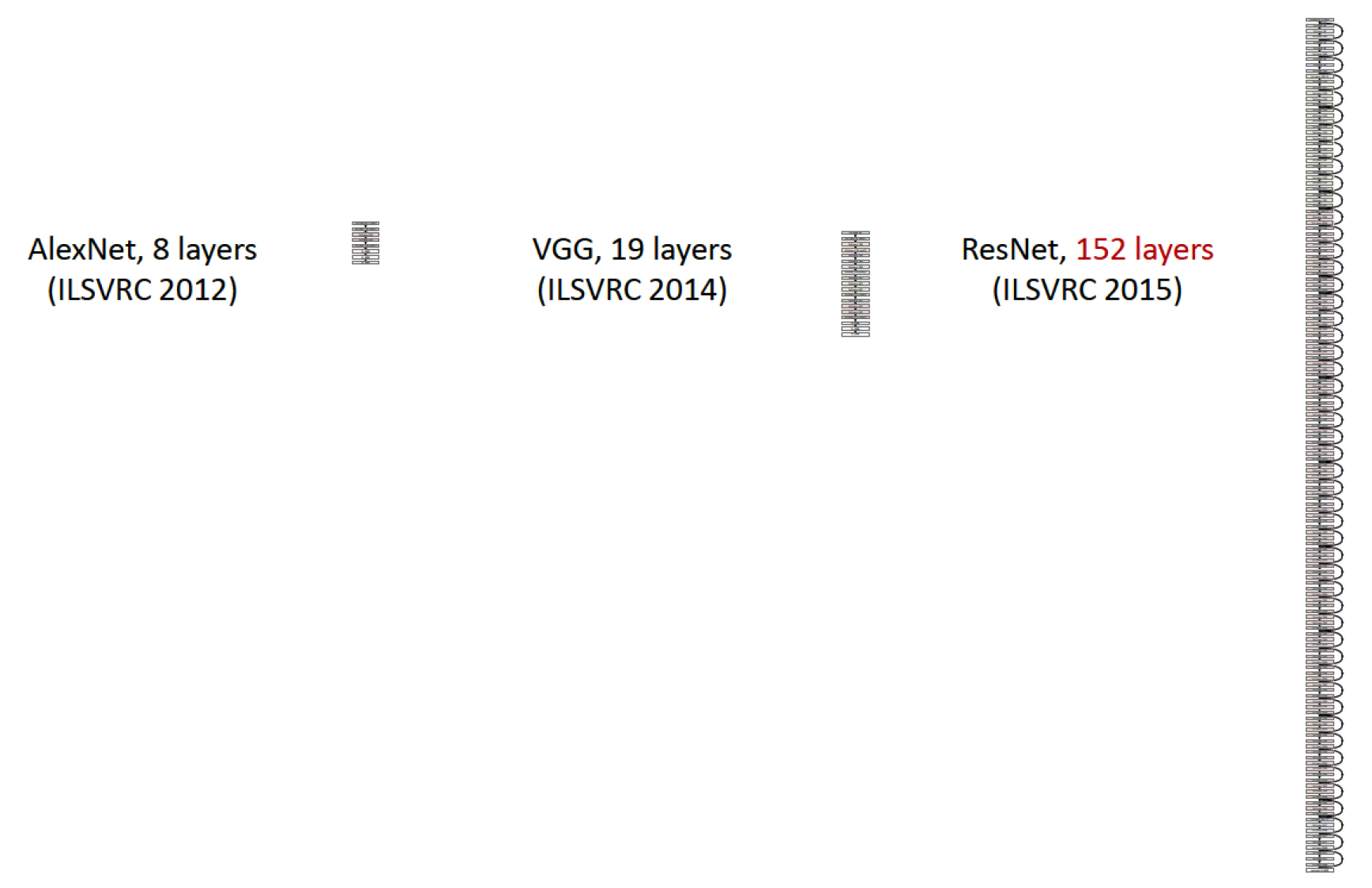

ResNet'ovと以前のすべてのネットワークの深さを比較する

著者の別の興味深いスライドは、彼らがネットワークの深さ/品質に突破口を開いたことを示しています。 , , , 19- VGG, 152 .

, . , 2016 , . .

ResNet:

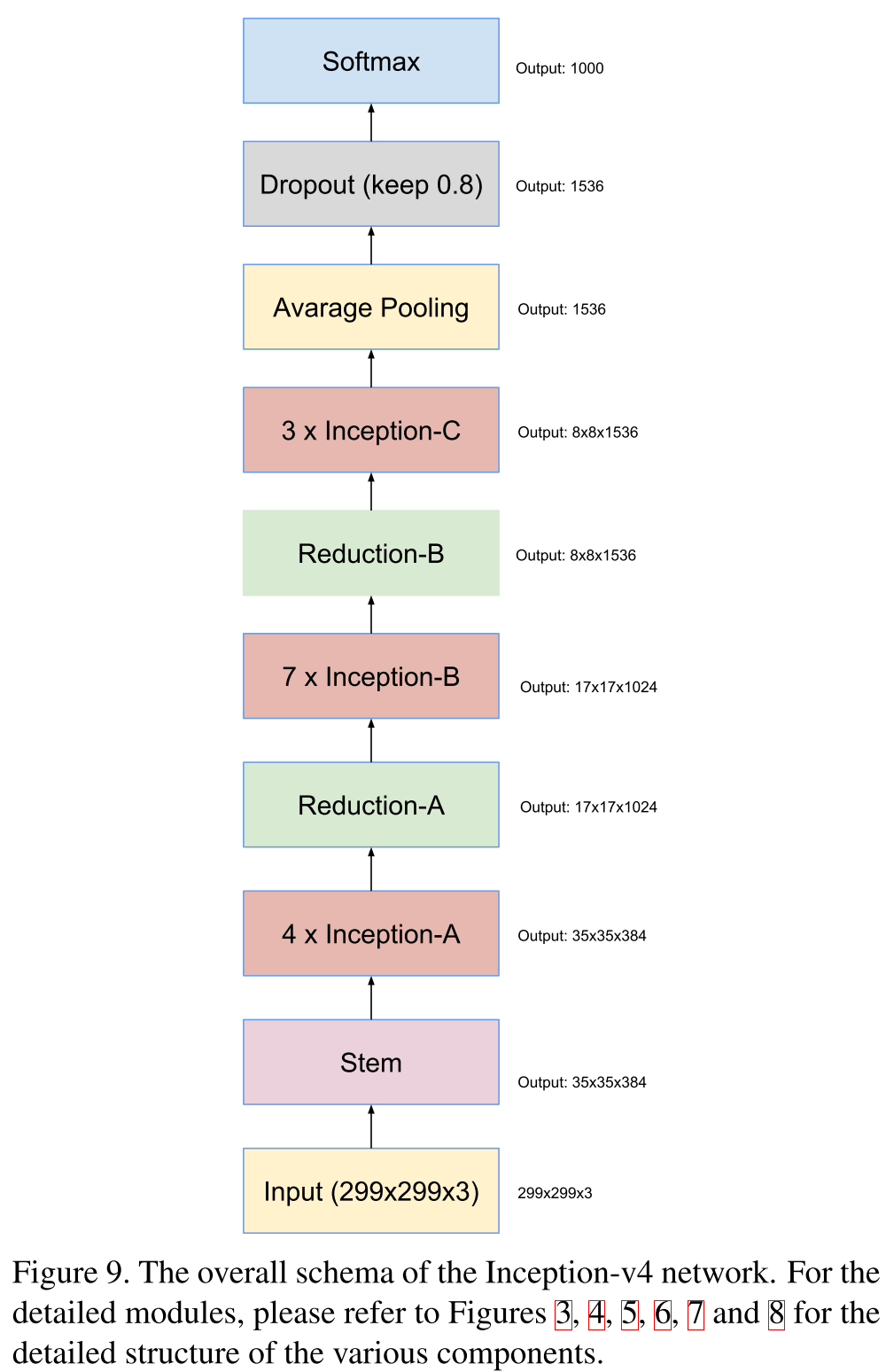

Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning (23 Feb 2016)

, , Inception, ResNet'. , , , . , , . Inception V4 Inception ResNet.

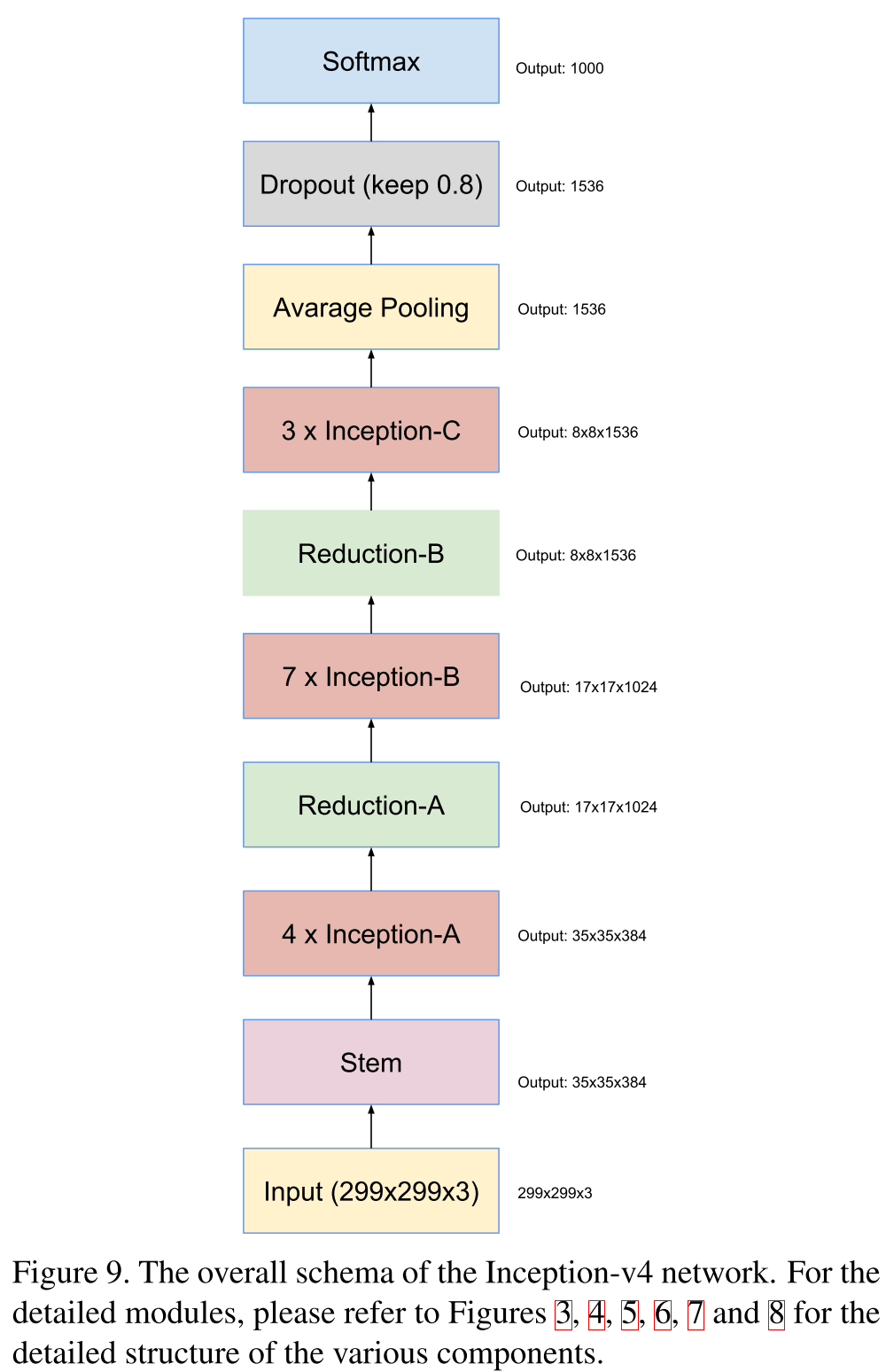

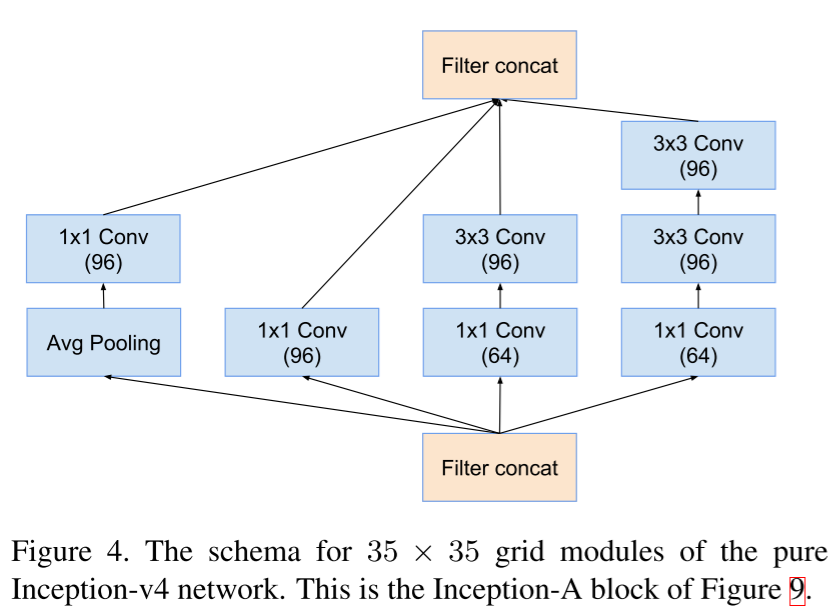

Inception V4 , Inception-. , , 4 , , — , .

Inception V4

一般的なネットワーク図。

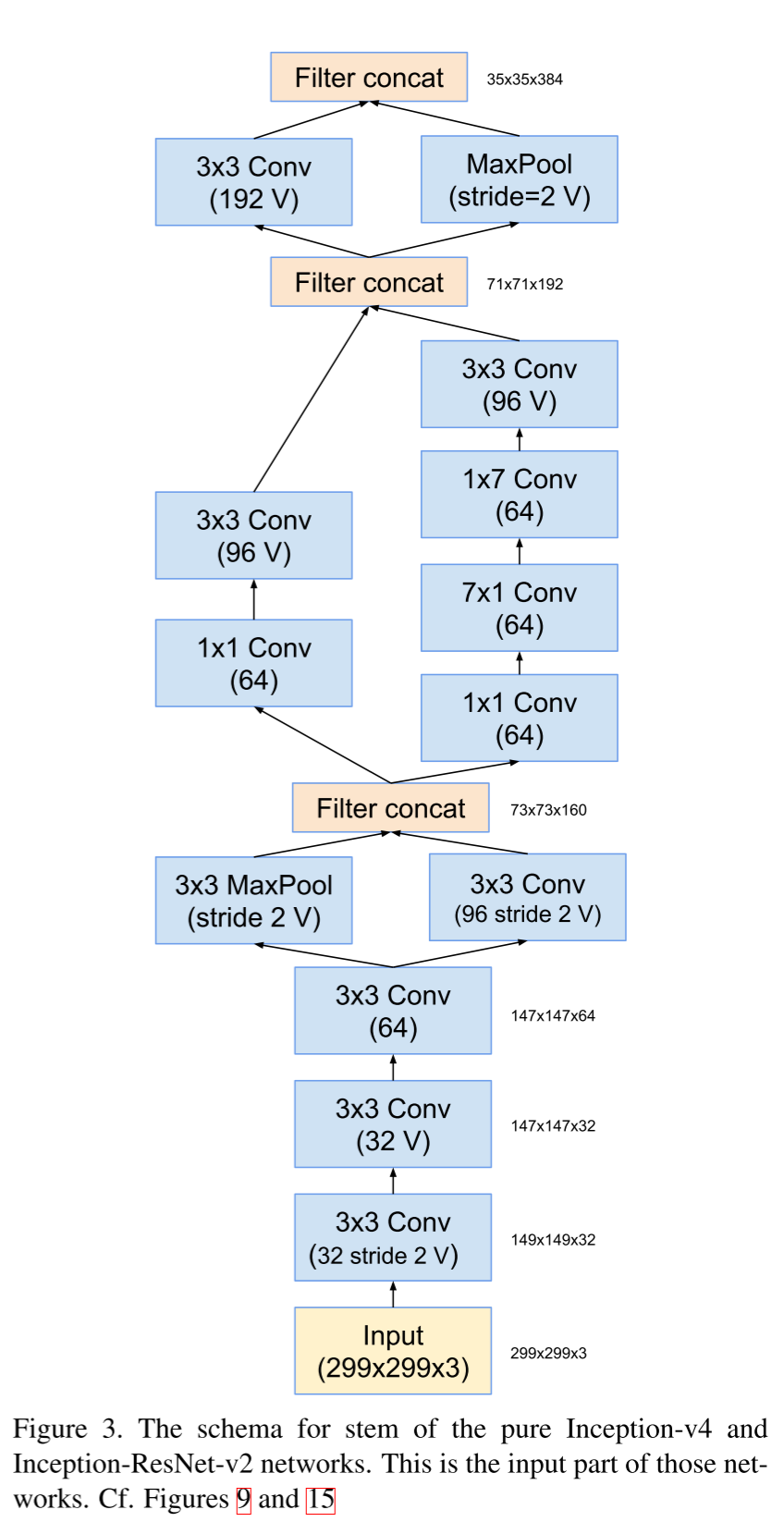

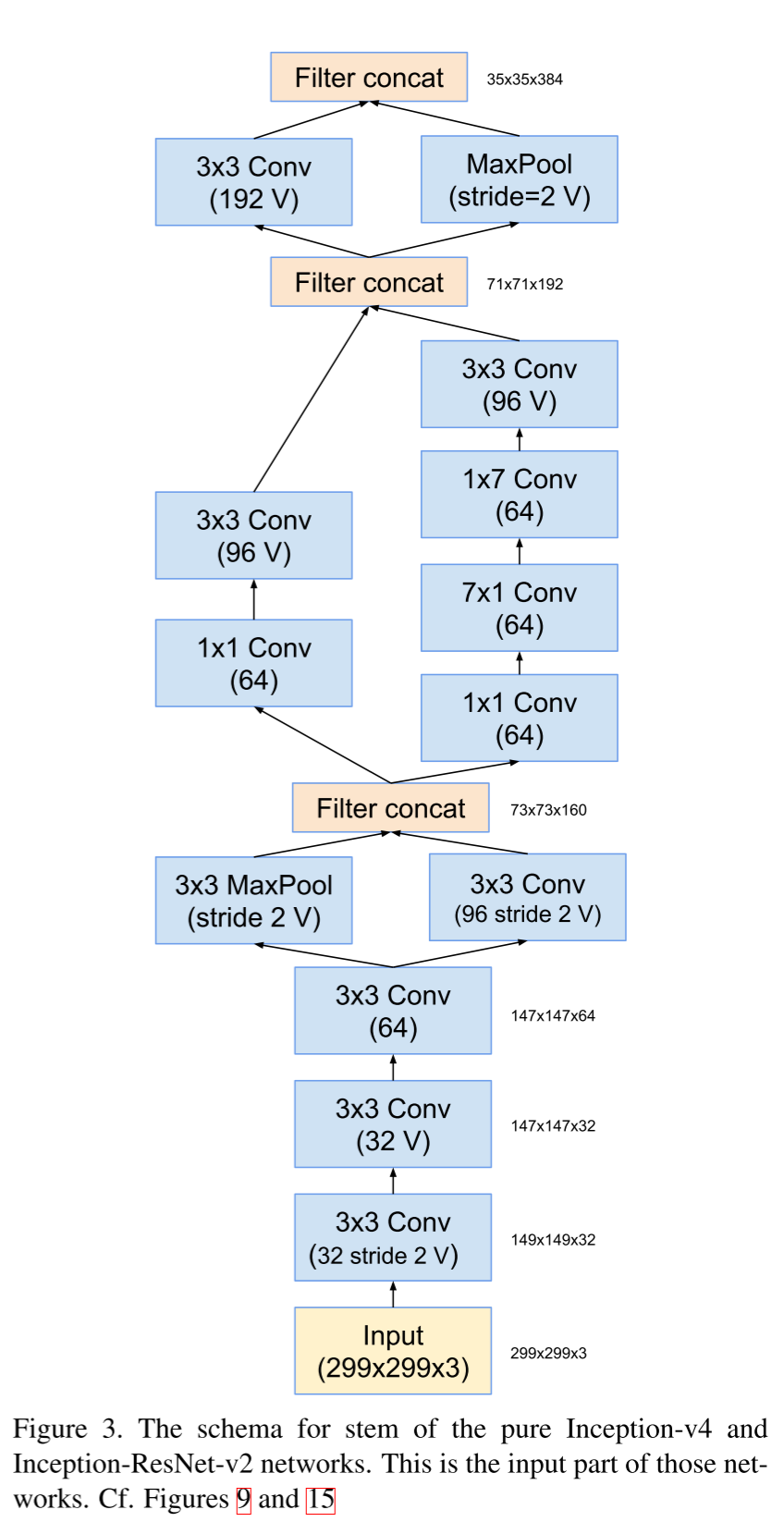

ステムブロック。

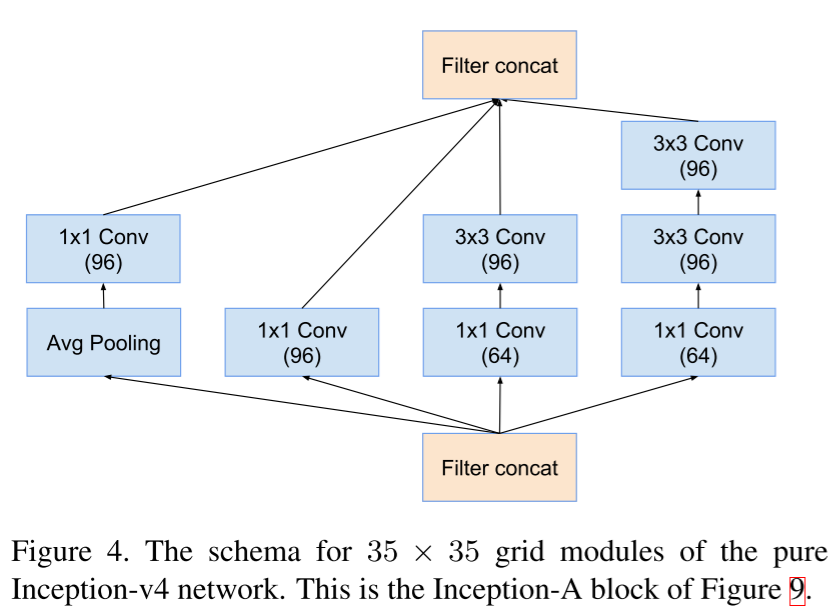

インセプションブロックA

ステムブロック。

インセプションブロックA

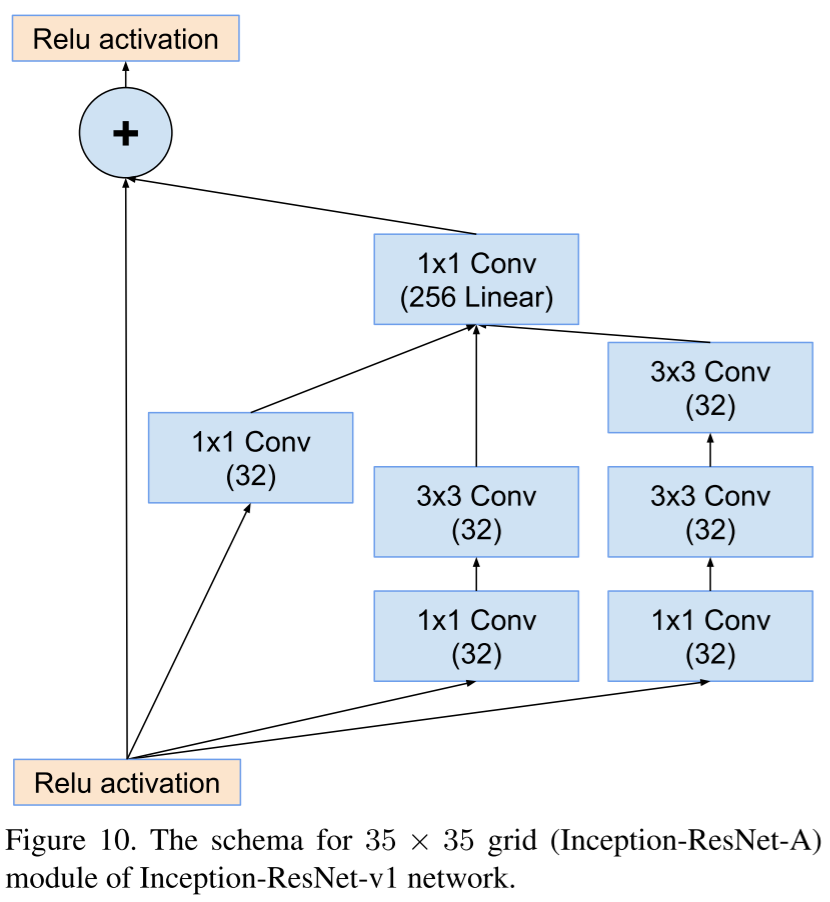

Inception V4 Inception- , shortcut-, Inception ResNet.

, , , .

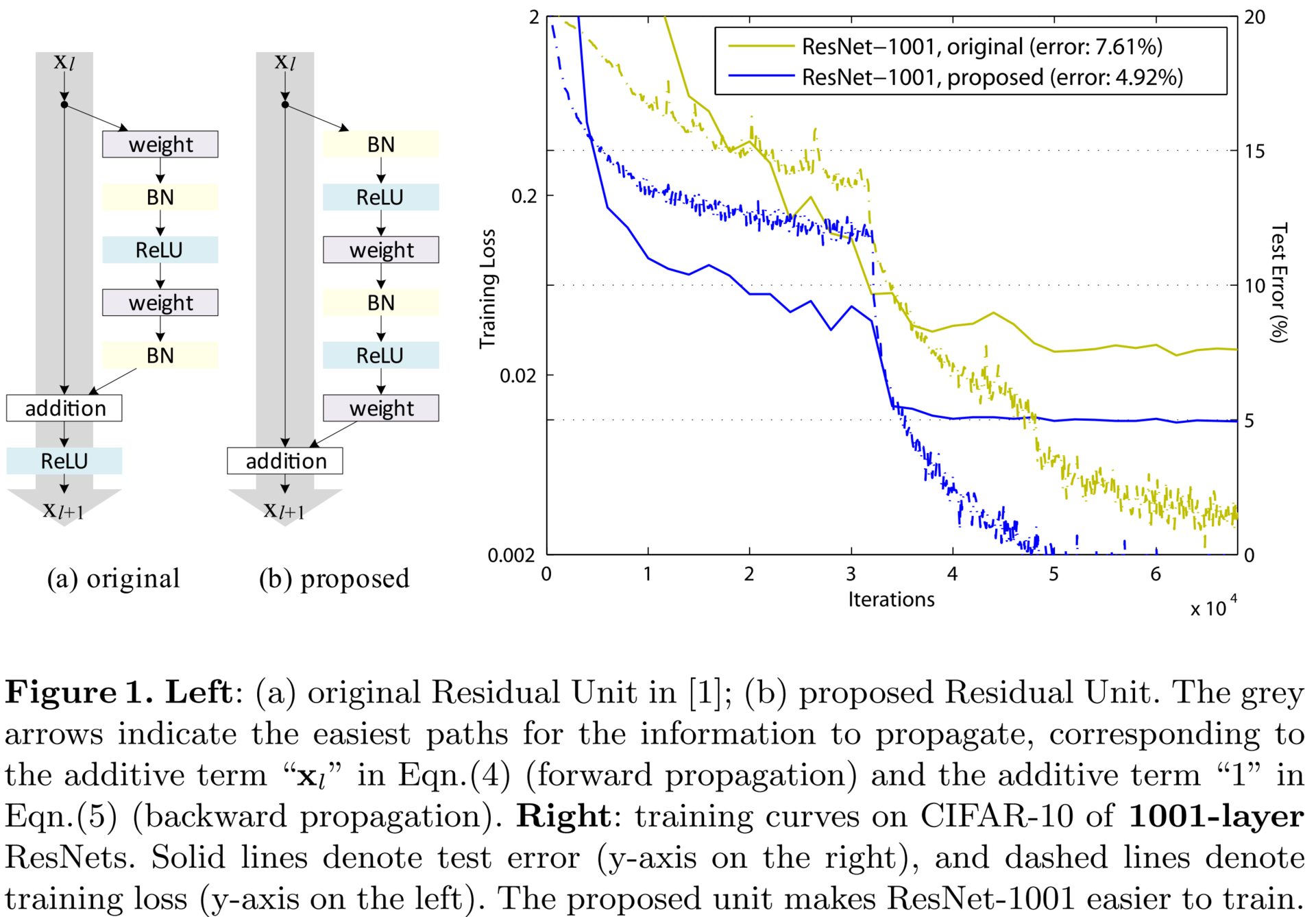

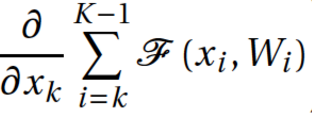

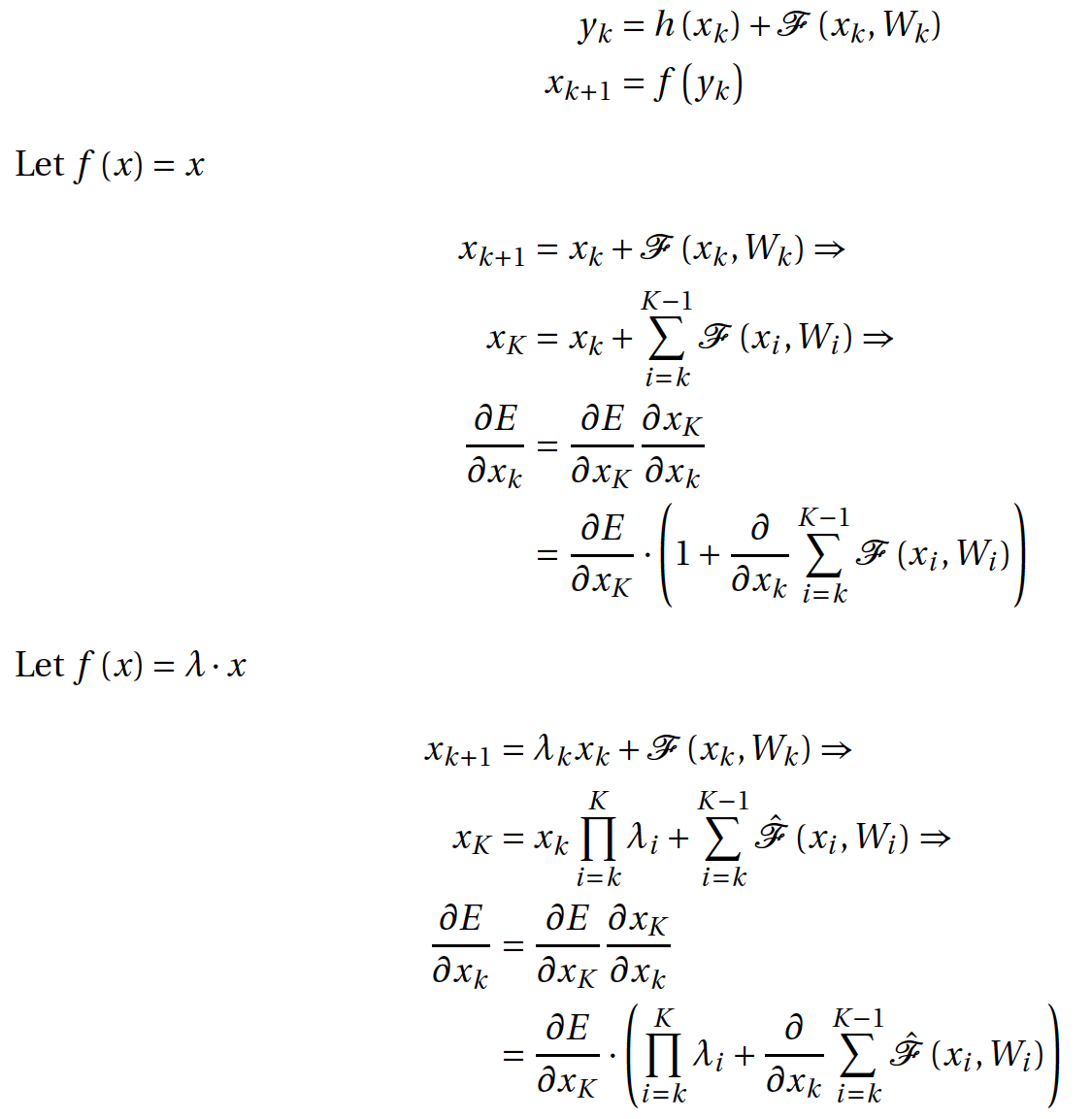

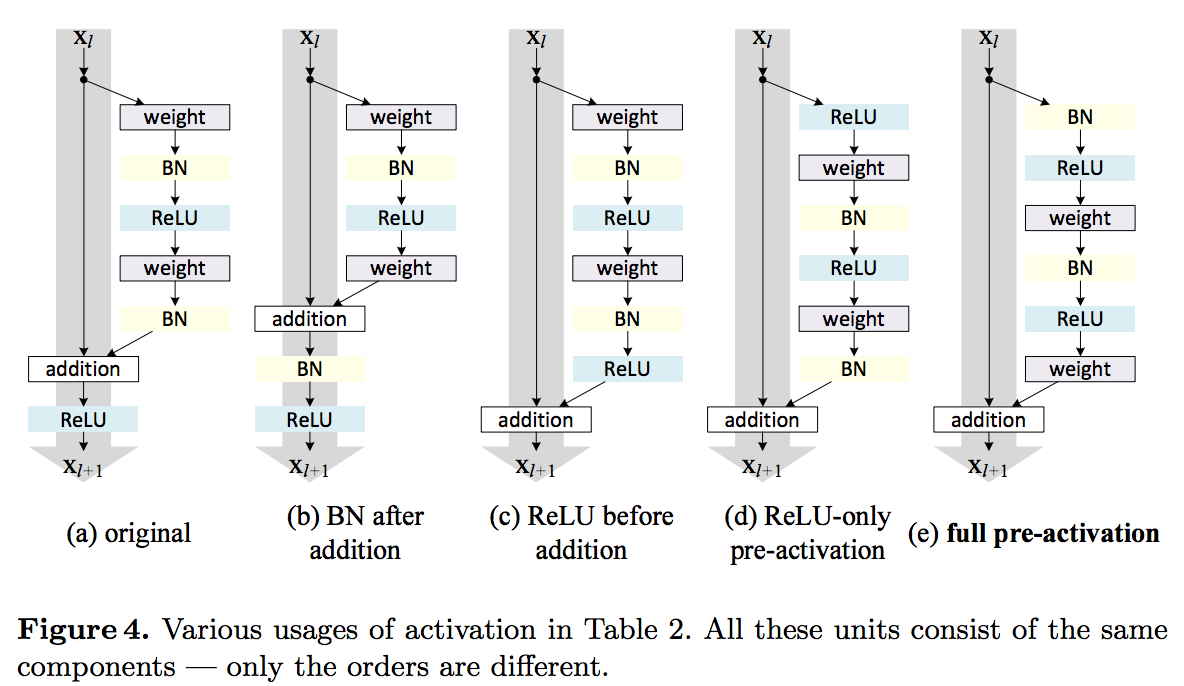

Identity Mappings in Deep Residual Networks (12 Apr 2016)

ResNet, , : . , . . , ; , . , 1001 . , 2014 19- «very deep convolutional neural networks».

. させる

— ;

— ;  — shortcut connection,

— shortcut connection,  ;

;  — residual network;

— residual network;  — ;

— ;  — .

— .

,

— , . K , . , . - k , , : . , - . , , vanishing gradients, ,

— , . K , . , . - k , , : . , - . , , vanishing gradients, ,  –1. , . , .

–1. , . , .

, - ? ,

。 . , . , . .

。 . , . , . .

residual- , , , .

— ( Jürgen Schmidhuber ). LSTM- , 1997 , , ResNet — , LSTM, 1. , — Highway Network . , , , (gate), , .

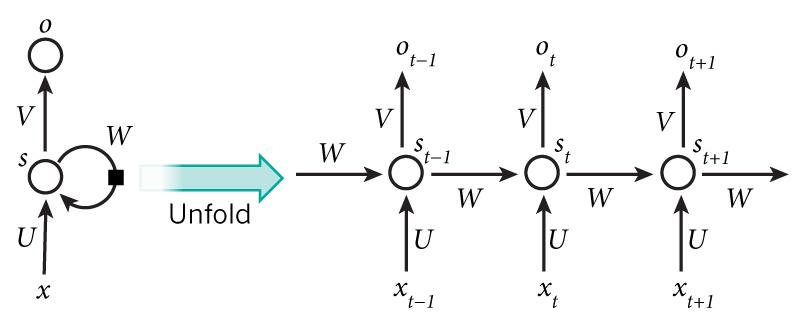

Bridging the Gaps Between Residual Learning, Recurrent Neural Networks and Visual Cortex (13 Apr 2016)

, ResNet RNN. . , , , , , , .

The dark secret of Deep Networks: trying to imitate Recurrent Shallow Networks?

A radical conjecture would be: the effectiveness of most of the deep feedforward neural networks, including but not limited to ResNet, can be attributed to their ability to approximate recurrent computations that are prevalent in most tasks with larger t than shallow feedforward networks. This may offer a new perspective on the theoretical pursuit of the long-standing question “why is deep better than shallow”.

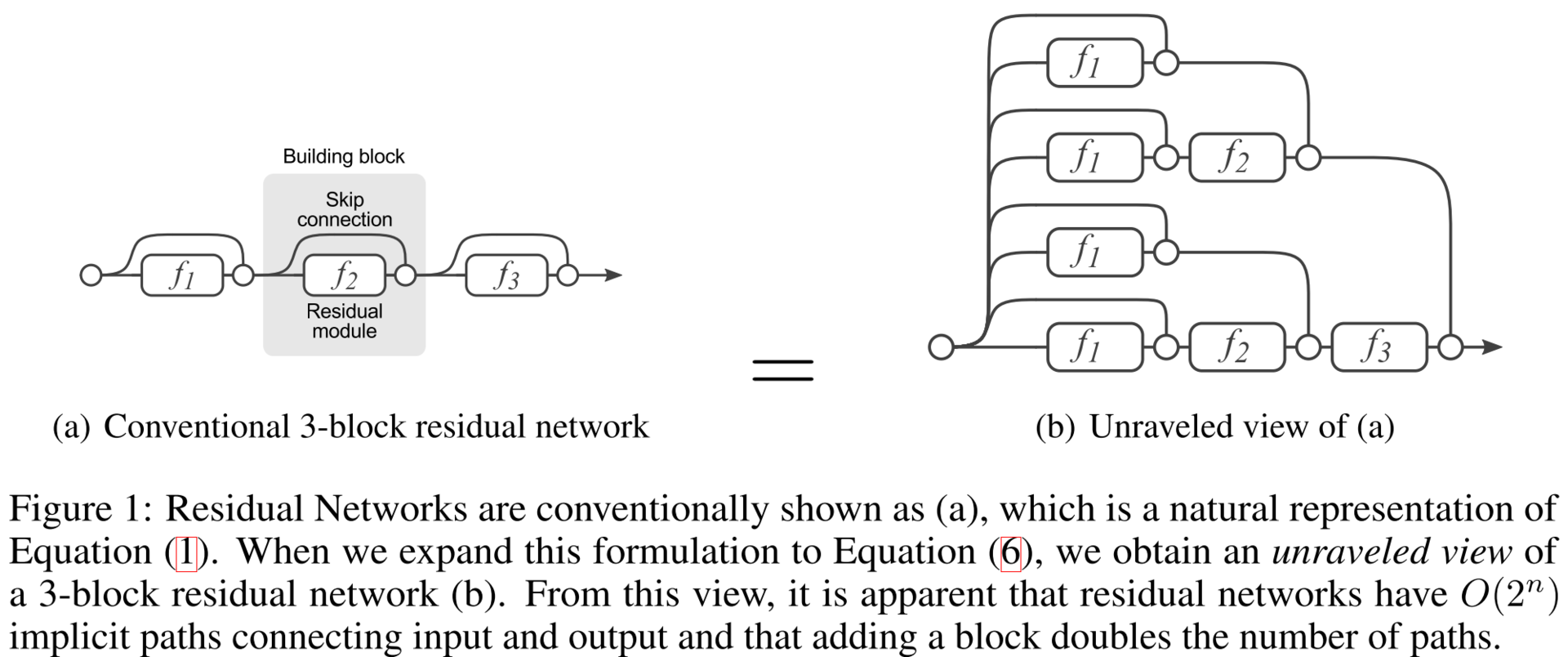

Residual Networks are Exponential Ensembles of Relatively Shallow Networks (20 May 2016)

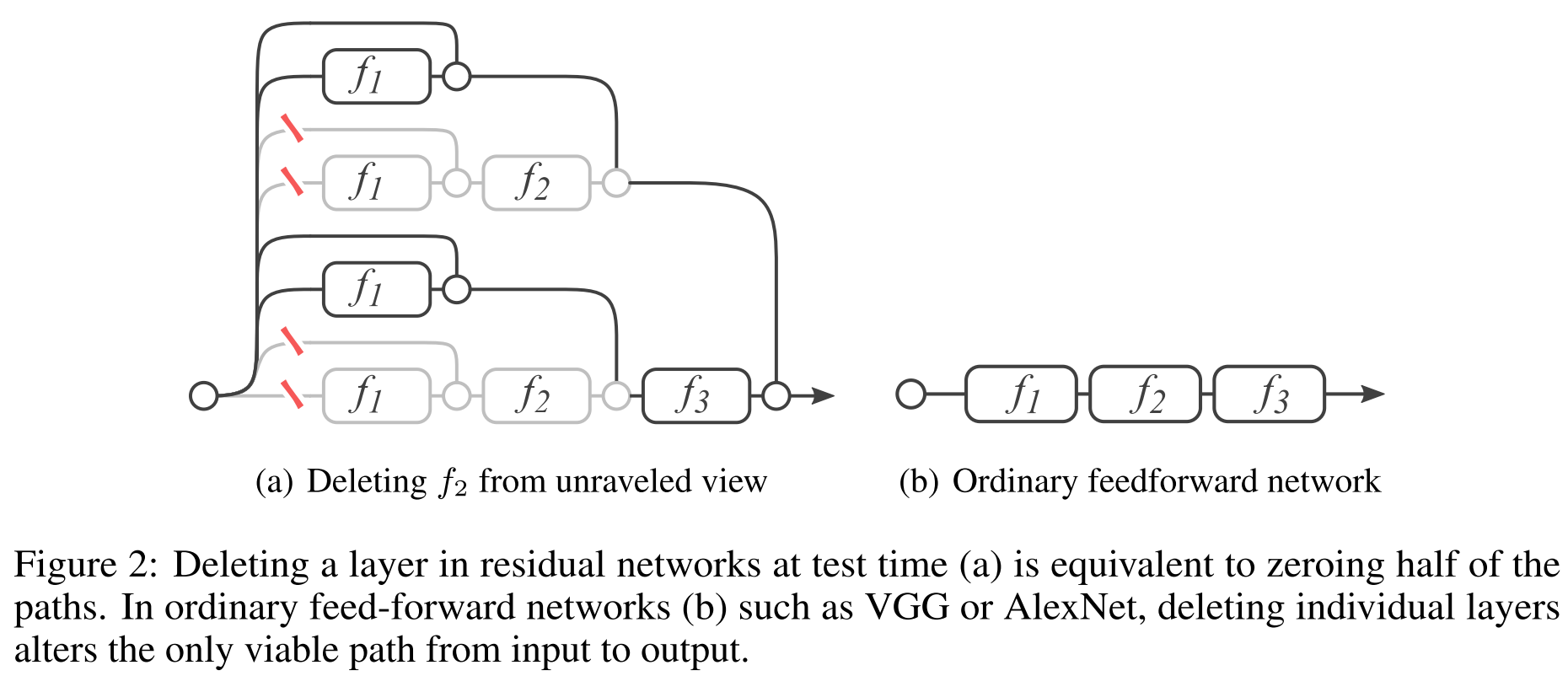

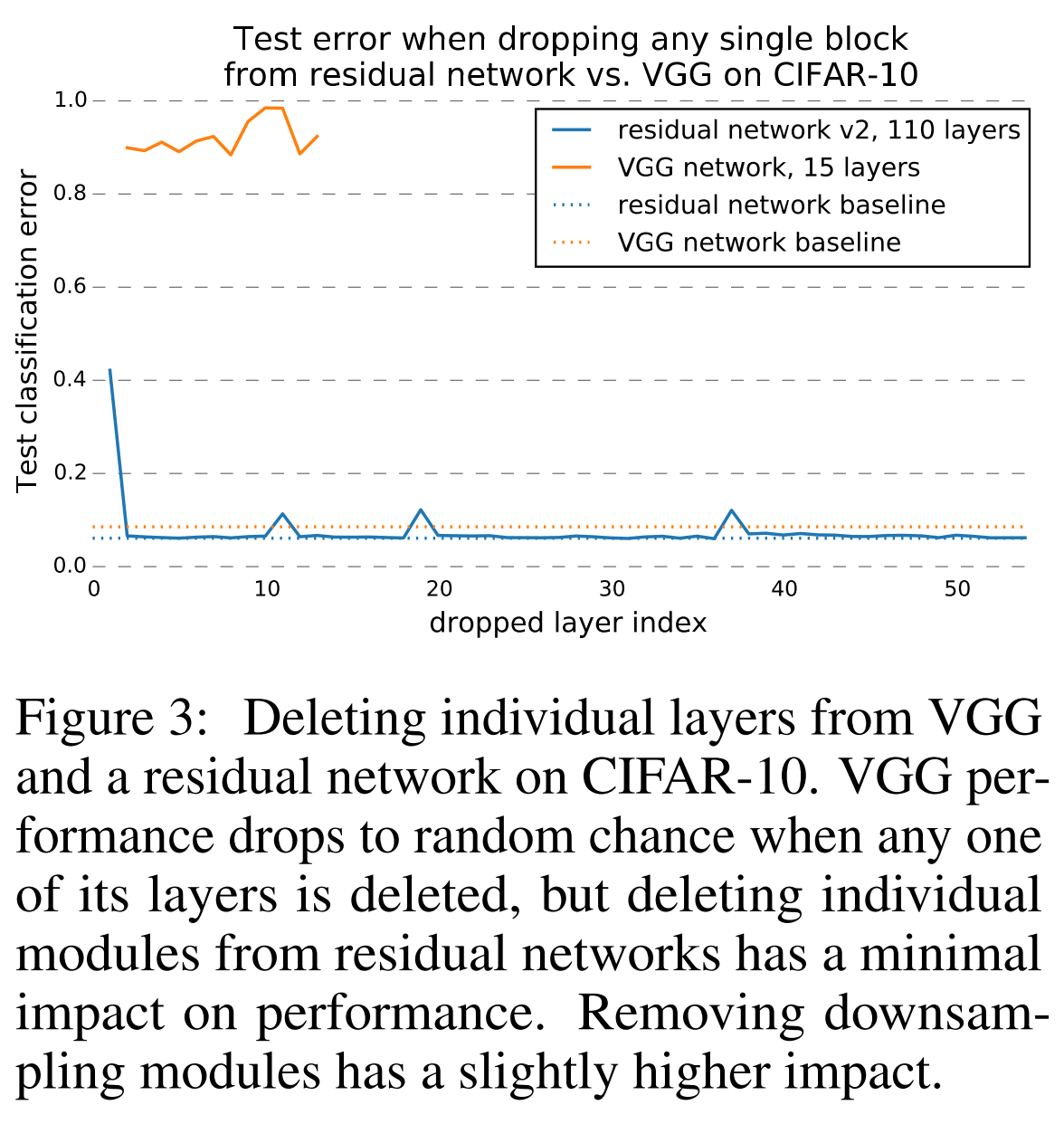

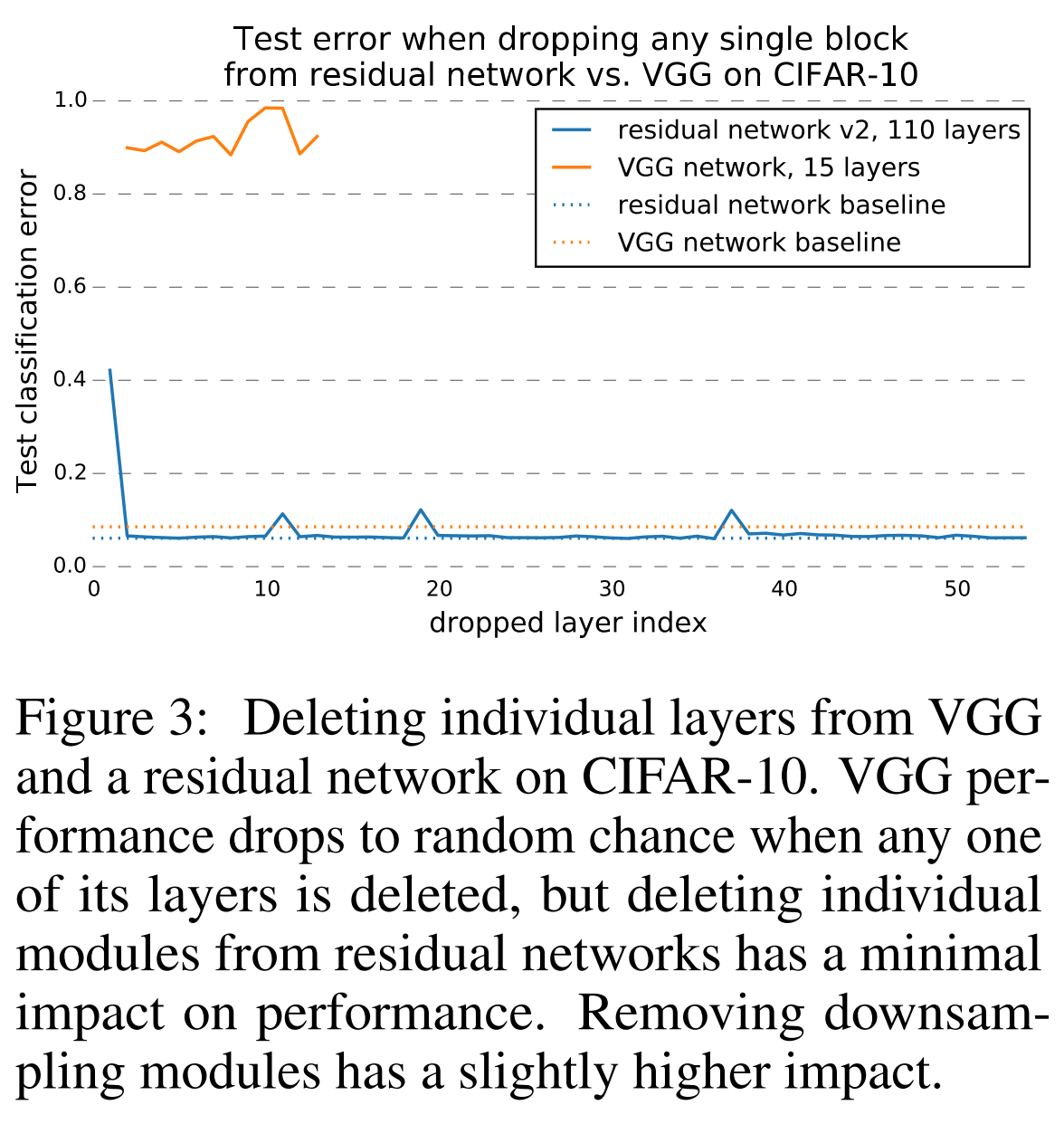

, DropOut, , . , . . , ResNet — . . ResNet, , shortcut- flowing graph'.

:

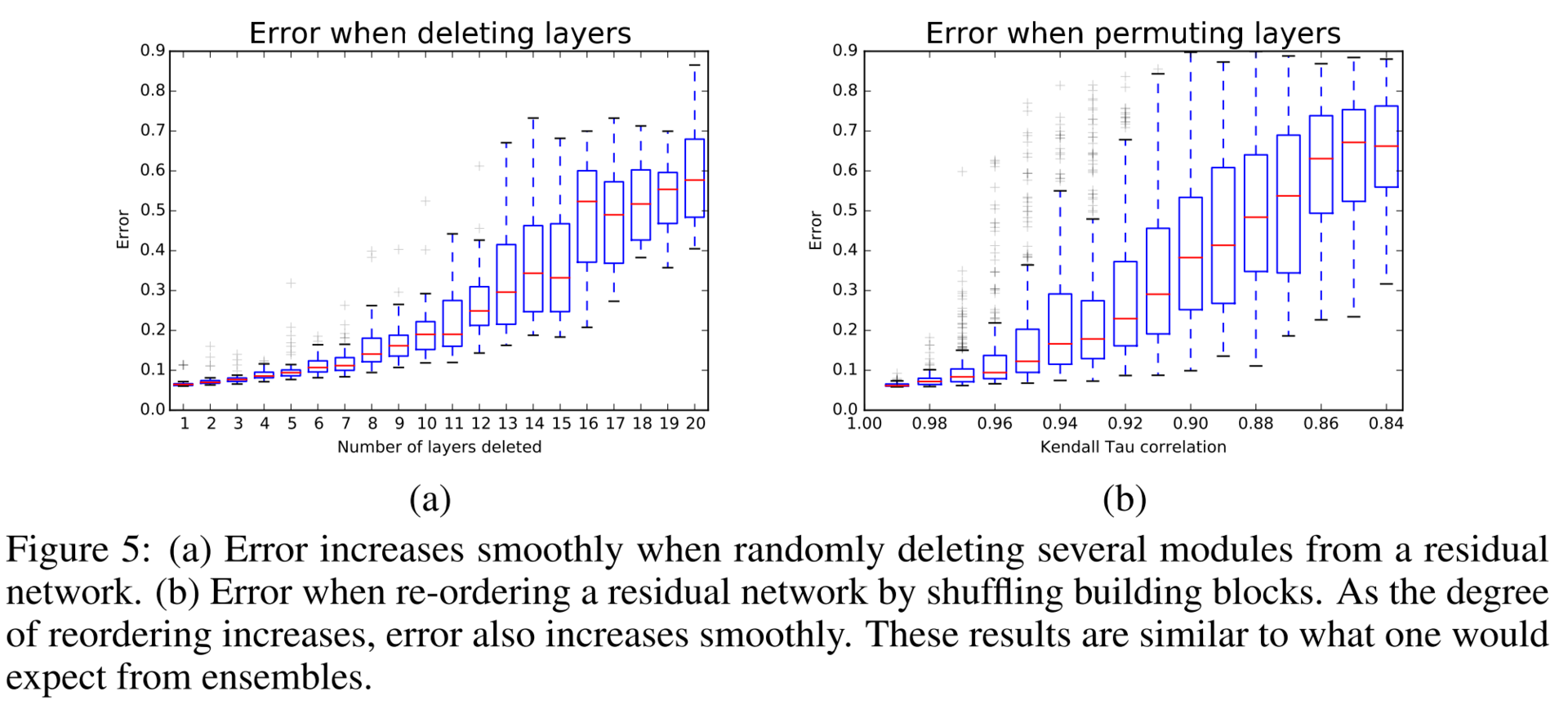

, , . , , multiplicity, -, , — . , , (). , , , (). , , .

, . , , . , ResNet .

, ResNet . , , .

, VGG ResNet .

結果は素晴らしいです。

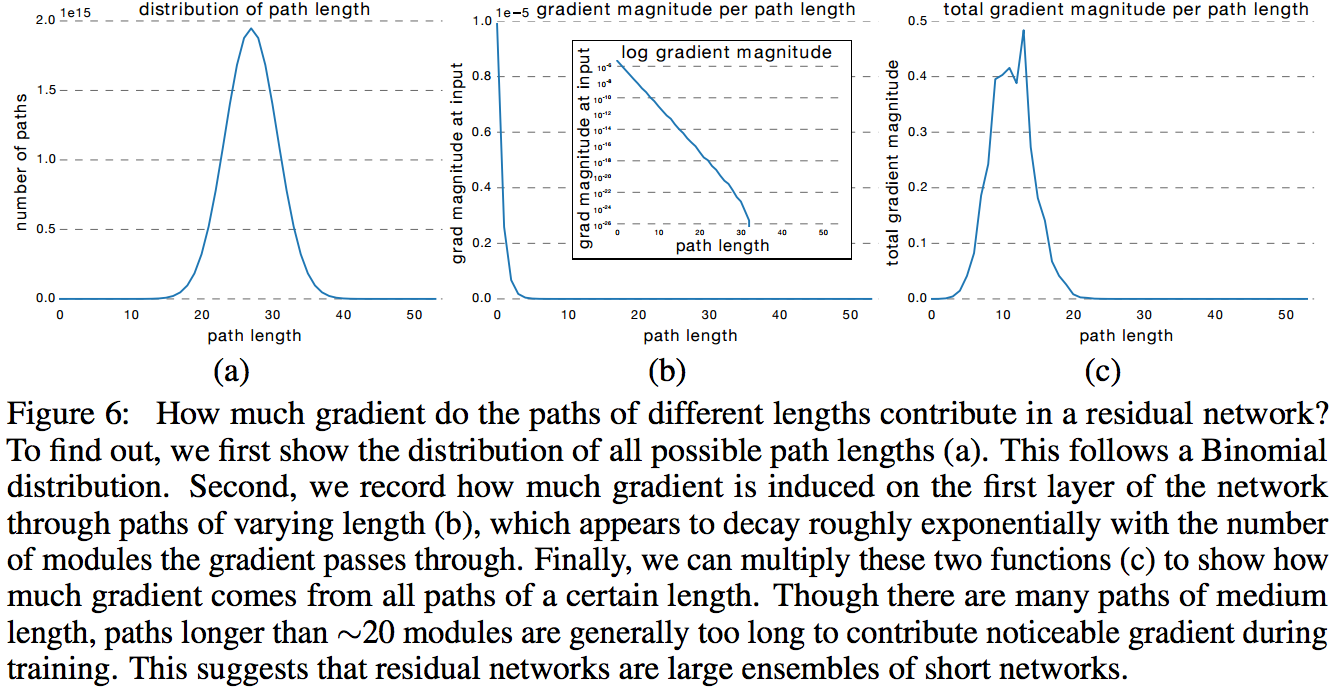

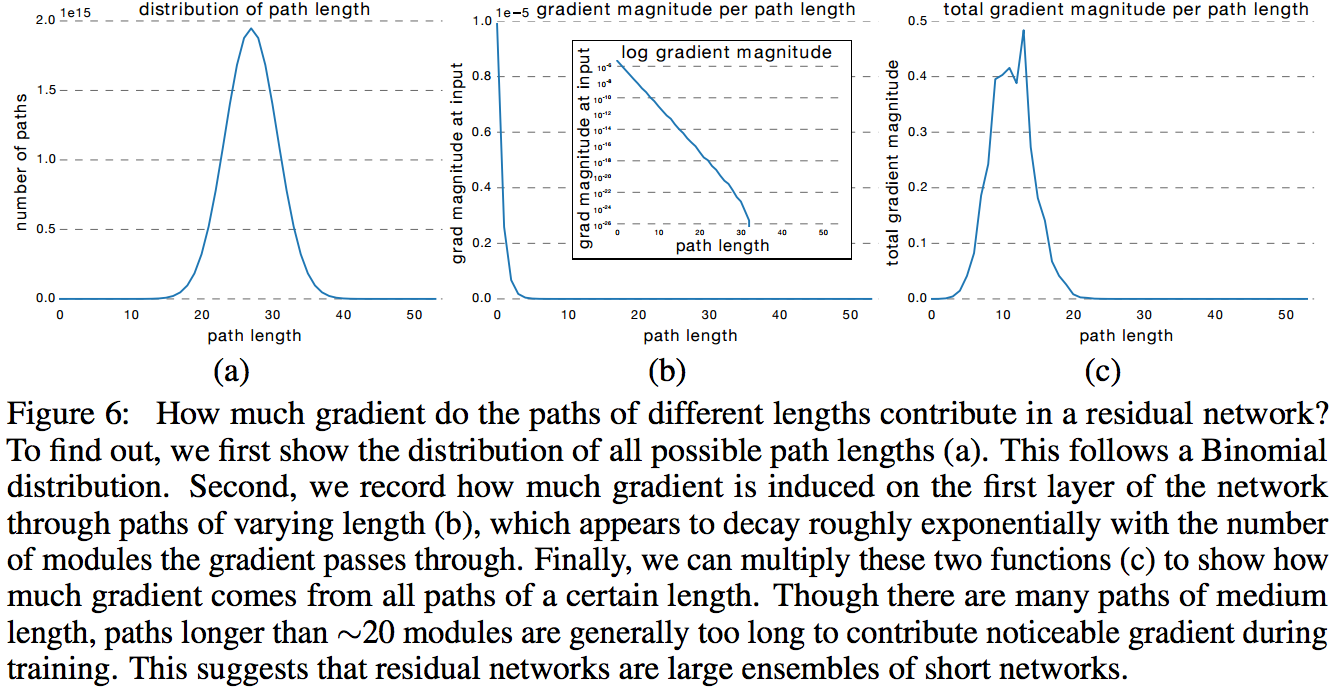

次の実験では、著者は異なる長さのサブネットから取得した勾配の絶対値の分布を構築します。 ResNet-50の有効なサブネット長は5〜17層であり、すべてのパス長の45%しか占有していませんが、モデル全体のトレーニングへのほぼすべての寄与を占めています。

勾配分布分析。

おわりに

ResNetは進化を続けており、さまざまなグループが新しいことに挑戦し、過去の実績のあるパターンを適用しています。 たとえば、ResNetでResNetを作成します。

- 畳み込み残留メモリネットワーク (2016年7月14日)

- 広い残余ネットワーク (2016年5月23日)

- 深度ドロップアウト:残留畳み込みニューラルネットワークの効率的なトレーニング

- ResnetのResnet:残留アーキテクチャの一般化 (2016年3月25日)

- 残留ネットワークの残留ネットワーク:マルチレベルの残留ネットワーク (2016年8月9日)

- 複数の残留ネットワーク (2016年9月24日)

- 分離可能な畳み込みによるディープラーニング (2016年10月7日)

- 深いピラミッド型残差ネットワーク (2016年10月10日)

このレビューで言及されていないものを読んだ場合は、コメントで教えてください。 このような新しい記事のストリームですべてを追跡することは、単に現実的ではありません。 この投稿はブログで管理されていましたが、リストにさらに2つの新しい出版物を追加することができました。 1つはグーグルが昆虫の新しいバージョンであるXceptionについて、もう1つはピラミッド型ResNetについてです。

ニューラルネットワークについて少し知っている人に、ネットワークの種類を尋ねると、彼は正常(完全に接続された畳み込み)で再発していると言います。 すべてのタイプのニューラルネットワークが同じクラスに属する理論的基盤がまもなく登場すると思われます。 普遍的な近似定理があります。これは、任意の(ほぼ)関数をニューラルネットワークで近似できると言います。 RNNの同様の定理は、動的システムはリカレントネットワークによって近似できると述べています。 そして今、RNNは通常のネットワークで近似できることがわかりました(ただし、これを証明するために残っています)。 一般的に、私たちは面白い時間に住んでいます。

表示されます。