2014年に、ゲームの開発中に蓄積された3Dテクノロジーでの5年間の経験を活用できるソフトウェアスタートアップを立ち上げることにしました。 3D再構築のトピックは長い間私たちの関心を集めており、2013年を通じて他社のソリューションを使用して多くの実験を行いました。 おそらく既に理解しているように、私たちの夢はうまく実現しました。 この実施形態の記録は猫の下にある。 Intel RealSenseとの関係の歴史もあります。

3Dモデルを作成するための最良の方法を探していたため、私たちは自分のニーズに合わせてステレオ再構築に以前から従事していました。 ハンドスキャナーを使用した3Dスキャンは、最も手頃なオプションのように思えました。 広告ではすべてがシンプルに見えましたが、プロセスには多くの時間がかかることが判明しました。追跡はしばしば失われ、最初から始めなければなりません。 しかし、何よりも、ぼやけたテクスチャーは私を怒らせました。 つまり、そのようなゲームのコンテンツは私たちには向いていませんでした。

写真測量について尋ねると、余分な$ 100,000ドルはないことがわかりました。 さらに、特別なカメラチューニングスキルが必要でした。その後、ハイポリデータの長い後処理が必要でした。 確かに何も保存しなかったことが判明しましたが、逆に、コンテンツ制作の量を考えると、すべてがはるかに高価になりました。 この瞬間に、アイデアが独自の何かをしようとするようになりました。

最初に、コンテンツの制作に便利なシステムの要件を考えました。

- 固定システム-一度較正され、取り外し可能。

- インスタント撮影-クリックして完了。

- 写実的なテクスチャ品質のために一眼レフカメラを接続する機能。

- センサーのタイプからのシステムの独立性-技術は止まっておらず、新しいセンサーが登場します。

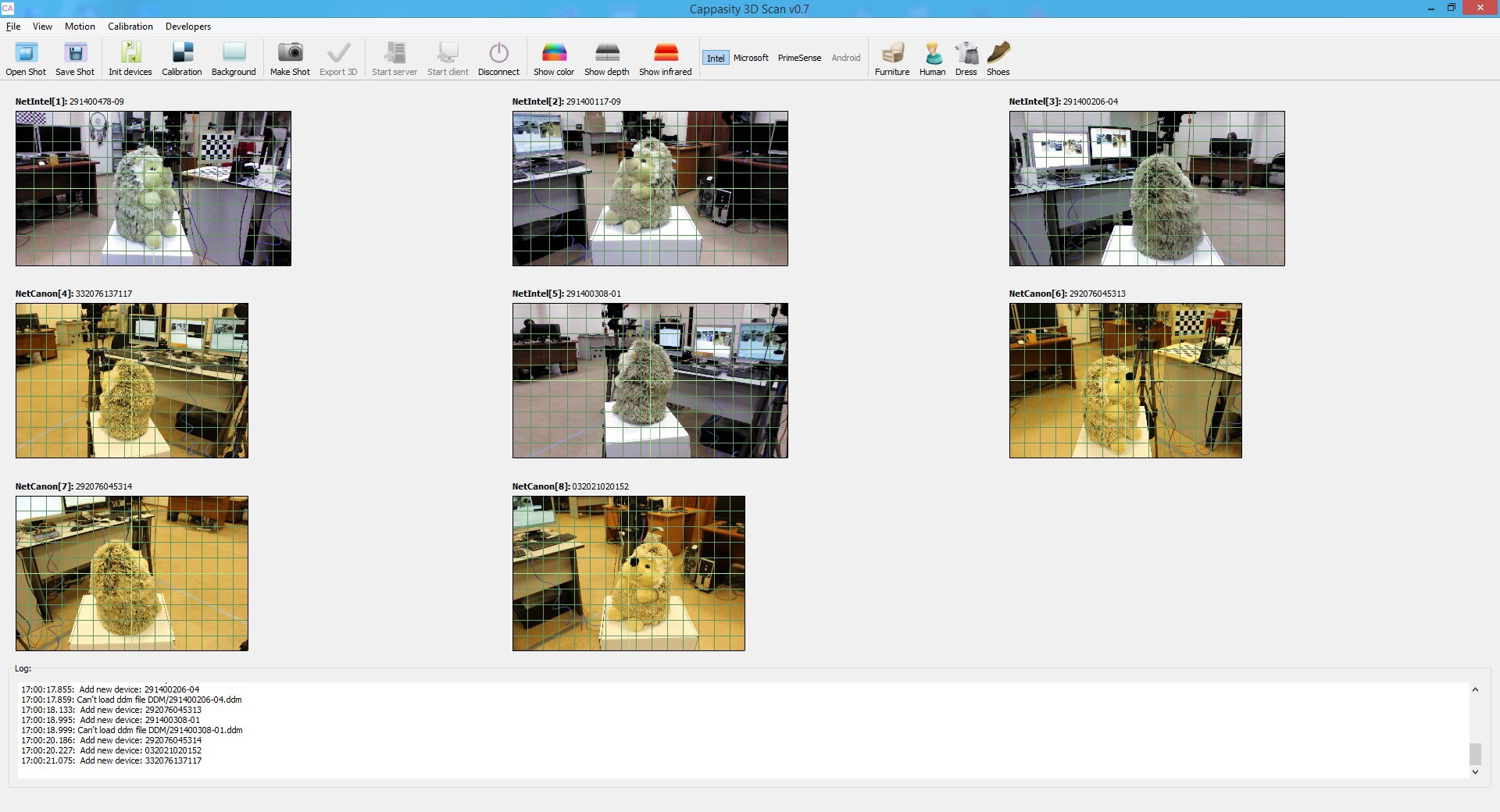

- クライアント/サーバーテクノロジーの完全な実装。 各クライアントはセンサーを備えたコンピューターです。

- デバイスの数に制限はありません。さまざまなサイズのオブジェクトを即座にキャプチャする必要があるため、制限には問題が伴います。

- 3D印刷でモデルを表示する機能。

- ブラウザに表示するためのプラグインとモバイルアプリケーションに統合するためのSDKの存在。

ここにそのような夢のシステムがあります。 アナログが見つからなかったので、自分で書いた。 ほぼ1年が経過し、2014年の秋に、最終的に潜在的な投資家に当社の業績を伝える機会が現れました。 また、2015年の初めに、CES 2015でIntel RealSenseセンサーを使用して組み立てられたシステムのデモを行いました。

しかし、その前に何が起こったのでしょうか?

独自のデータ転送プロトコルでネットワークコードを作成すると、すぐに成果が上がりました。 PrimeSenseセンサーを使用しましたが、1台のPCに3つ以上のセンサーがある場合、非常に不安定に機能しました。 現時点では、Intel、Google、その他の市場リーダーがすでに新しいセンサーに取り組んでいるとは考えていませんでしたが、拡張性のあるアーキテクチャを習慣的に設計しました。 したがって、当社のシステムはこの機器を簡単にサポートしていました。

ほとんどの時間は、キャリブレーションの作成に費やされました。 PrimeSenseセンサーの構造を誰も理解しておらず、必要なすべてのパラメーターがキャリブレーションされていなかったため、キャリブレーション用の有名なツールキットは理想的ではありませんでした。 PrimeSenseの工場キャリブレーションを放棄し、IRデータに基づいて独自のキャリブレーションを作成しました。 その過程で、メッシュの構築とテクスチャリングのためのセンサーとアルゴリズムの機能について多くの研究が行われました。 多くの対応とやり直し。 その結果、システム内のすべてのセンサーに同じ方法で撮影するように強制しました。 そして、強制的に、彼らはすぐに特許を申請し、現在、米国特許出願中です。

AppleがPrimeSenseを購入した後、他のメーカーに注意を向けるべきであることが明らかになりました。 その時点で既に存在する開発のおかげで、Intel RealSenseセンサーを搭載したソフトウェアは、Intelからセンサーを受け取ってからわずか2週間で機能しました。 現在、Intel RealSenseを使用し、長距離での撮影にMicrosoft Kinect 2を使用しています。最近、ロボットのセンサーに関するIntelのCESキーノートを視聴しました。 開発者が利用できるようになったら、おそらくKinect 2に置き換えられます。

新しい力でRealSenseに切り替えると、キャリブレーションの問題が発表されました。 対応する色でクラウドポイントを色付けしたり、クラウドから取得したメッシュにテクスチャを適用したりするには、RGBカメラと深度カメラの相対的な位置を知る必要があります。 最初は、RealSenseでPrimeSenseと同じ独自の手動スキームを使用する予定でしたが、センサーの制限に直面しました-データはフィルタリング後に取得され、RAWでの作業には異なるアプローチが必要です。 幸いなことに、Intel RealSense SDKには、座標をある空間から別の空間に変換する機能があります。たとえば、深度空間から色空間、色から深度空間、カメラから色などに変換できます。 したがって、代替のキャリブレーション方法の開発に時間を無駄にしないために、この機能を使用することが決定されました。 色付きの点群をPrimesenseおよびc RealSenseと比較すると、RealSenseの雲はよりよく色付けされます。

何を得たの? センサーとカメラは、被写体の周りに円を描いて立っています。 それらを較正し、センサー、カメラの位置、および互いに対する傾斜角を見つけます。 必要に応じて、Canon Rebelカメラを使用して、価格/品質が最適になるようにテクスチャリングします。 ただし、歪みを含むすべての光学パラメータを調整するため、ここには制限はありません。

テクスチャが投影され、3Dモデルに直接ブレンドされます。 したがって、結果は非常に明確です。

3Dモデルは、N個のセンサーから形成されたポイントのクラウドから構築されます。 データキャプチャの速度は5〜10秒です(センサーの種類と数に依存)。 そして、オブジェクトの完全なモデルを取得します!

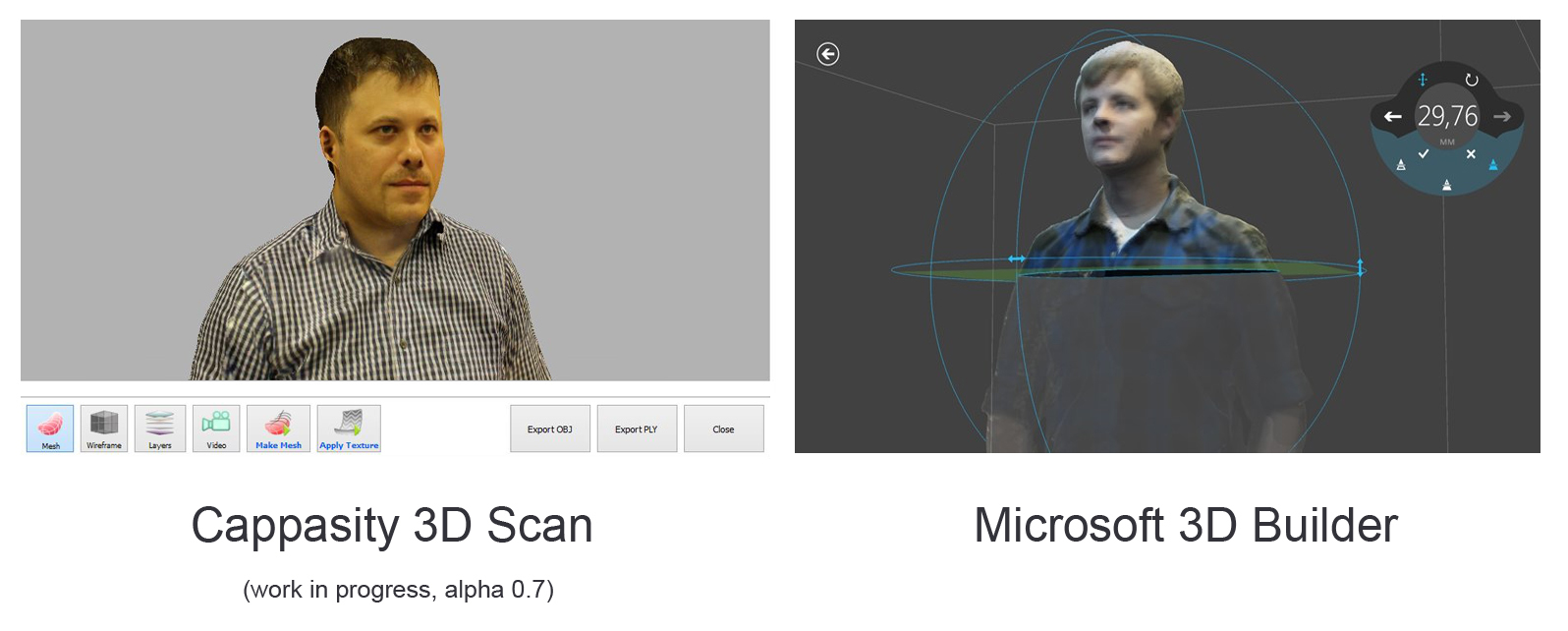

3Dモデルを表示

3Dモデルのプレビュー:

今年は、人をスキャンするappasityHuman 3D Scan、部屋をスキャンするappasityRoom 3D Scan、家具をスキャンするappasityFurniture 3D Scan、1つのセンサーを使用してスキャンするCappasity Portable 3D Scanの4つの製品を一度にリリースする予定です。

Cappasity Portable 3D Scanは、Intel RealSenseを搭載したラップトップ向けに、わずか数か月でリリースされます。 3月4日にサンフランシスコで開催されるGDC 2015で発表します。 ターンテーブルを使用するか、モデルを手動で回転させることにより、高品質の3Dモデルを作成できます。 さらに、カメラをお持ちの場合は、高解像度のテクスチャを作成する機会を提供します。

なぜインテルRealSenseを選択したのですか? 私たちはいくつかの理由でIntelテクノロジーに焦点を合わせることにしました。

- すでに約15のラップトップモデルがRealSenseをサポートしています。

- RealSenseを搭載したタブレットの計画的なリリース。

- B2C販売への道を開きます-製品の収益化の新しい方向性。

- 高品質のSDKがあります。

- センサーの特徴は高速です。

また、会社自体からの優れた技術、マーケティング、およびビジネスサポートによって、少なくとも役割が果たされているわけではありません。 私たちは2007年から密接に協力してきましたが、インテルの同僚からの質問に答えることができない状況はありませんでした。

最大1メートルの距離での3Dスキャンの観点からRealSenseテクノロジーを考慮すると、Intelをこの分野のリーダーと安全に呼ぶことができます。

間違いなく、現代の技術は私たちの周りの世界の深部で働くための素晴らしい機会を開きます!

FacebookおよびTwitterページに進捗状況に関する新しい資料を定期的に投稿しています。