ビッグデータ処理は、すべての人類をさらに効率化し、私たちがまだ完全に想像することさえできない未来に私たちを導く技術革新の新ラウンドの一部であると信じています。 その中で、大量のデータを扱うことは、今日の発電や鉄道の発電と同じくらい重要であり、普及しているでしょう。

Yandex Data Factoryが公開される前に、パートナー企業といくつかのパイロットプロジェクトを実施しました。 Yandex Data Factoryは、送電線にサービスを提供する会社のために、無人機で撮影された画像を分析し、脅威に自動的に特定するシステムを作成しました。 また、道路代理店の場合、渋滞、カバレッジの品質、交通の平均速度、事故率に関するデータを分析しました。 これにより、次の1時間の交通渋滞をリアルタイムで予測し、事故の可能性が高いエリアを特定できました。

人類が約10%のどこかに救うことを学ぶたびに、産業革命が起こるようです。 200年前、彼らは蒸気機関を使い始めました。 100年前、化学の発展により、新しい人工材料が登場しました。 20世紀のエレクトロニクスは、生産だけでなく生活も変えました。 中国と東南アジアで材料を処理する方が安価であることに人々が気付いたとき、世界の工業生産全体がそこに移動しました。 実際、10%の節約は世界的な変化です。 データ分析は、グローバルな製造と経済の効率化に役立ちます。

ビッグデータがあるのはインターネットだけではありません。 歴史的には、前世紀の60年代と70年代に、地質学者がそれらを生成しました。 彼らは地表での爆発から反射された波を見ました-それは地下を見る彼らの方法でした。 探索には、分析するものがあります。 そして2年前、私たちは地質学的および地球物理学的データを処理するための並列コンピューティング技術と機器を提供しました。 アルゴリズムは、地下を見る新しい方法になりました。

私たちの多くは、フライト中にデバイスを使用できるように、飛行機にはWi-Fiが必要だと考えています。 しかし、最初はインターネットが登場しました。現代の航空機は、飛行中に膨大な数のインジケーターを測定し、常にデータを生成する数千のセンサーだからです。 それらのいくつかは着陸前に地面に移され、その後テラバイトのディスクが飛行機から取り外されて保管され、そこに記録されているすべてをどうするか分からない。

ただし、飛行中に送信されるデータを見ても、たとえば飛行機で交換する必要がある部品を事前に予測することができます。 これにより、乗客の時間と航空機業界のリソースの両方が節約され、スペアパーツによりダウンタイムで10%が失われます。 Yandex自体は、120 MWの電力を消費する文字通りサーバーの街です。 また、数十万台のサーバーがある場合でも、同時に数百台のディスクが常に機能しません。 マシンは、次に故障するドライブを予測し、変更する必要があることを通知できます。

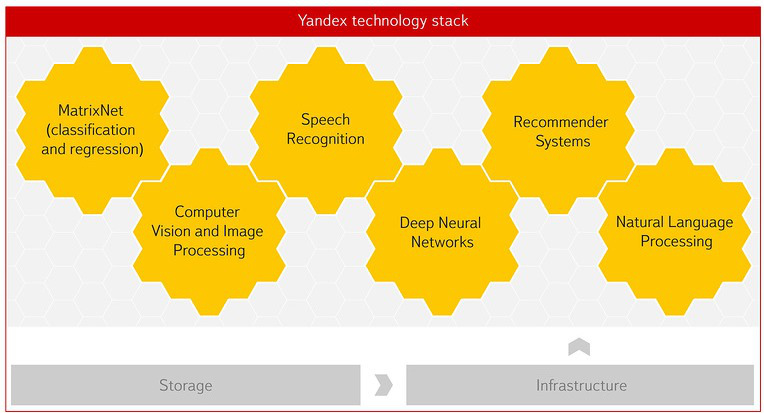

Yandexは、必要な技術と専門知識を備えた世界でも数少ない企業の1つです。 インターネット検索は、機械学習とデータ分析機能なしでは不可能です。 現在、トラフィック予測、統計変換、音声、画像認識など、Yandexのほぼすべての背後にいます。 ソビエト科学学校はこれの形成に大きな影響を及ぼしました。 その後、データを扱うことができる専門家を訓練するために、データ分析の学校を作成しました。 高等経済学部の参加により、コンピューターサイエンス学部が登場しました。これには、とりわけデータ分析と人工知能の部門が含まれます。

Matrixnet-機械学習テクノロジーは、もともと検索ランキングの問題を解決するために作成されました。 現在、CERNの科学者によって使用されています。 プロジェクトの1つは、コライダーでの粒子衝突に関するデータをリアルタイムで選択するためのシステムの構築に関連しています。 これは、Matrixnetに基づいた正確で柔軟なフィルターです。これにより、科学者はLHCでの粒子衝突に関する興味深く重要なデータのみをすばやく入手できるため、科学研究で使用できます。 時々、これは非常にまれなデータであり、たとえば、1,000億件あたり10万件で見つかります。 すべてのLHCb科学論文の半分以上は、Matrixnetアルゴリズムによってフィルター処理されたデータに基づいています。

CERNとの2番目のプロジェクトは、データウェアハウスの最適化です。 2年間の運用で、LHCはペタバイトのデータをハードドライブに保存し、科学者がそれらにすばやくアクセスできるようにしました。 しかし、HDDのスペースはすでに不足しているため、一部のデータをテープドライブに転送する必要があります。 これは安価な保存方法ですが、柔軟性も低くなります。テープ上のデータを検索するのはそれほど簡単ではありません。 ファイルのどの部分を転送し、どの部分をハードドライブに残すかを理解する必要があります。 CERNを招待して、実験に関する何千もの蓄積されたファイルのランク付けを支援し、HDDに残さなければならないデータを強調しました。 したがって、数ペタバイトのHDDをリリースするのに役立ちます。これは数十パーセントです。

データ量は非常に急速に増加しています。 私たちはそれぞれ、ポケットに電話の膨大なデータを持っています。 センサーは安価になり、より多くのデータがサーバーに送信されています。問題はセンサーをどうするかです。 それらを使用し、何らかの方法でそれらを使用することを学べば、つまり、世界経済の10%のリソースを節約できる可能性があるように思えます。 そして、これが起こると、新しい産業革命が私たちを待っています。