前の記事で始まった最新の超大規模データセンターとの関係を継続し、今日は最も重要な問題の1つであるデータストレージについて説明します。 さらに、このようなメガデータセンターの近い将来についても少しお話しします。

もちろん、データストレージシステムは、メガデータセンターの非常に多くのアプリケーションのボトルネックにならざるを得ませんでした。 この分野での大きなブレークスルーにもかかわらず、常に既存のソリューションが課題に対する手間のかからないソリューションに十分であるとは限りません。 Amazon、Google、Facebook、その他の企業のデータセンターで毎秒処理されるデータ量を想像するのは困難です。 データの量と受信速度が問題の本質であるだけでなく、実際には、データの安全性と保護から始まり、いわゆる「データ保持」の法的要件で終わる、多くの追加の問題を考慮する価値があります。

ほぼ例外なく、大規模なデータセンターストレージシステムは、ダイレクトストレージ接続(DAS)の原則に基づいて構築されています:購入が簡単です(記事の最初の部分でコストを最適化することの重要性についての議論を覚えていますか?)。より多くのパフォーマンスは言うまでもなく、NASとSANに基づいています。 大規模なDPCのストレージシステムは、従来のコンシューマディスクとSATA接続のSSDを使用する場合があります。 シリアル接続SCSIが普及し、多くは従来のSATAディスクと互換性のあるSASに移行します。管理のシンプルさ。 12 Gb / sスループットをサポートするSASインターフェイスへの移行プロセスもあります。

少し前まで、ストレージシステムを評価するための主な指標は、1秒あたりの操作数(IOPS)と1秒あたりのメガバイト数で測定された最大インターフェイス帯域幅でした。 メガDPCの動作の現実は、SSD上で動作する最新のSSDが最大のI / Oパフォーマンス(多くの場合最大200,000 IOPS)を達成し、データ転送速度が重要な役割を果たしなくなることを示しています。 I / O操作の遅延などの指標が最前線にあり、インフラストラクチャの効率、サーバーの負荷、そしてもちろんアプリケーションの速度などのサイズのデータセンターの最も重要な指標に重要な影響を与えます。

主な最適化方法は、SSD、特別なキャッシュボード、およびこれら2つのオプションの組み合わせの導入です。

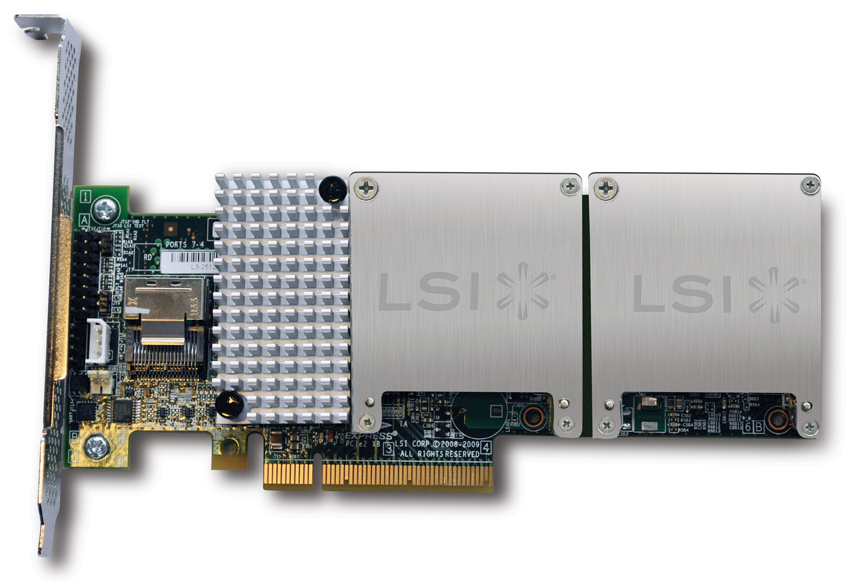

実際には、一般的なハードドライブのI / Oレイテンシは約10ミリ秒(0.01秒)です。 SSDでは、読み取り遅延は約200マイクロ秒で、書き込み遅延は100マイクロ秒(それぞれ0.0002秒と0.0001秒)です。 専用のPCIeカード(最近、 同様のLSI Nytroソリューションについて説明しましたが、実際にはその有効性を示しています)は、数十マイクロ秒というさらに低いレイテンシを実現できます。

さまざまなストレージソリューションを組み合わせてSSDテクノロジーを適切に使用すると、平均4〜10倍の増加を達成できます。メガデータセンターの状況では、所有者にとって莫大な利益が得られます。

エンタープライズSANストレージは、さまざまなキャッシングソリューションの実装からさらに恩恵を受けます。これは、キャッシュがそのようなストレージの最も遅い部分であるネットワークインフラストラクチャの影響を排除するためです。 最新のI / O最適化カードは、キャッシュに最大数テラバイトの「ホット」データを保存できるため、多くの場合、データベース全体がその中に収まります。これは、アプリケーションの動作に不可欠です。

大規模なデータセンターとは対照的に、企業構造では、I / O遅延がストレージを評価するための主要な基準の1つとして常に使用されるわけではなく、IOPSと1ギガバイトのデータを保存するコストに依存し、従来のSSDハードドライブとは異なります。 また、最新の超大規模データセンターを構築した経験から、より高価なSSDを使用しても、サポートのコストを削減し、効率を最適化することで、より効率的なインフラストラクチャを取得できることがわかります。 HDDと比較して、最新のSSDは障害が発生しにくく、保守が容易で、電力消費量が少ないため、主な利点であるI / O操作の速度と低遅延により、より少ないサーバーでより多くのデータを処理し、節約できます。サービス契約およびソフトウェアライセンスについても同様です。

将来、メガデータセンターは何を待ち望んでいますか?

イノベーションを適用する最初の場所はソフトウェアです。 場合によっては、後に大規模なデータセンターがソリューションの先駆者となり、後にITの「日常生活」の一部となりました(もちろん、この表現がここに当てはまる場合を除きます。例としては、Apache Cassandra、Google Dremel、そしてもちろんHadoopがあります。そのような性質アプリケーションはとてつもない速度で進化しており、多くの場合、数年ではなく数ヶ月です。

これで、2つの非常に若いテクノロジーが企業データセンターの世界をどのように変えているか、Linuxがかつてサーバー市場全体をどのように変えたかがわかります。 OpenComputeは、コンピューティングデータセンターのオープンで最小限の効率的なアーキテクチャを作成することを目的としたイニシアチブです。 2011年にFacebookから提供され、現在大きなブームを経験しており、多くの変化をもたらす可能性があります(たとえば、「オープンソフトウェア」原則に基づく「オープンサービス」モデル)。 2番目のイニシアチブであるOpenStackは、自動的に制御できるネットワークインフラストラクチャとリソース処理リソースのプールを作成することにより、ソフトウェア定義のデータセンターの大部分の基盤になりました。

また、近い将来、ラックレベルでサーバーを分解するためのソリューションを待っています。すべてのサーバーコンポーネント(プロセッサ、メモリ、電源など)を互いに分離し、個別に管理できるようになります。 これにより、超大型DCで「鉄」を使用する効率をさらに高めることができます。

要約すると、メガデータセンターはイノベーションの最前線にあり、これはまさに多くの分野で「先駆者」とみなせるITの分野であり、業界全体がすぐに続く道を開くと言えます。

...誰も行ったことのない場所に大胆に行く!