SIGGRAPHの Microsoft Researchは、非常に興味深い開発-KinectFusionを実証しました。 ソフトウェアは、_リアルタイムでKinectからのデータに基づいて3Dシーンを復元し、オブジェクトのセグメンテーションと追跡を実行できます。

テクノロジーは印象的でした。ゲームと現実が現実のものになり、オブジェクトと環境を現実から移すことが可能になったと思います。 ちなみに、3Dプリンティングテクノロジーの開発がブームになった今、その逆も可能です。まもなく利用可能になる可能性があります。 このような手頃な価格のスキャンと印刷により、実際のオブジェクトを電子的に転送することができます。 ただし、これはもちろん1つの使用例にすぎません。

猫の下で少しビデオ分析:

- 3Dモデル(三角形メッシュ)の構築

- テクスチャモデル

- 拡張現実-ボールをシーンに放り込む

- 拡張現実-シーンにボールを投げる、シーンは変更可能です

- セグメンテーション-削除されたアイテムは保持されます

- 追跡-選択したオブジェクトを追跡

- セグメンテーションと追跡-指でオブジェクトを描画

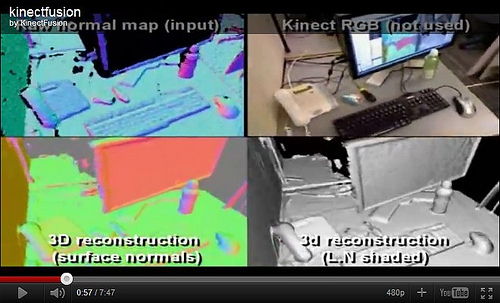

3Dモデル(三角形メッシュ)の構築

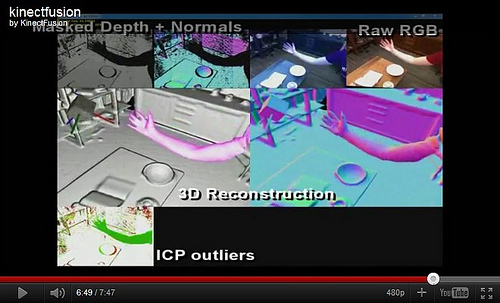

彼らは、Kinectを空間でかなり気軽に動かすことができ、ジッターや突然の動きが怖くなく、リアルタイムで現在の3Dポイントクラウドが既存のシーンと組み合わされ、シーンが修正/完成されることに注目しています。 この段階では、深度データのみが必要です。 三角測量はややぼやけています 光線のグリッドは640x480であるため、詳細を明確にするために近づく必要があります。 将来的には解像度を上げることができ、デバイスはさらに深刻になると思います。 もう1つのオプションは、光学部品を取り付けて、オブジェクトを詳細にスキャンできるようにすることです。最小スキャン距離は1.2 mです。

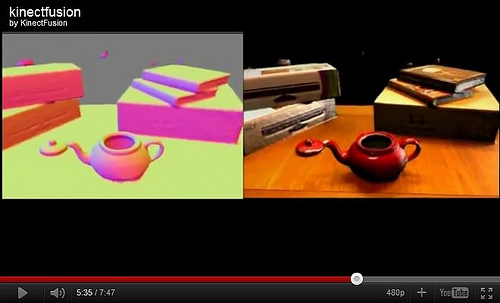

テクスチャモデル

Kinectには通常のカメラがあり、そこから色が取得され、テクスチャが構築されます。 右側の写真には、光源が飛び回るテクスチャモデルがあります。

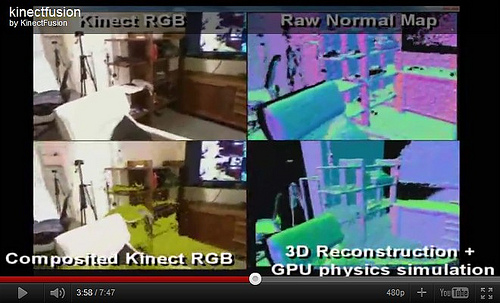

拡張現実-ボールをシーンに放り込む

三角形の3Dシーンに沿ってリアルタイムで散らばるGPUで、ボールを大量にシーンに投入し、Kinectからの通常のビデオでは、見えない部分のクリッピングを考慮して同じボールを描画します。

拡張現実-シーンにボールを投げる、シーンは変更可能です

繰り返しますが、ボールをステージに投げると、フレーム内の人がタオルを振り落とし、ボールが変化する3Dシーンと相互作用します。

セグメンテーション-削除したアイテムは保持されます。

テーブルの上にケトルがあり、シーンは静的です。 ティーポットを取り、シーンから取り出します。これは別のオブジェクトとして認識されます。

追跡-選択したオブジェクトを追跡

次に、ケトルを元の場所に戻します。プログラムはそれが戻ったことを理解し、それを移動し、ソフトウェアがその動きを追跡し、プロトタイプと組み合わせます。

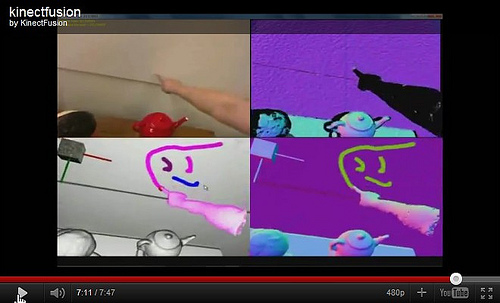

セグメンテーションと追跡-指でオブジェクトを描画

手は静的なシーンの背景に対して際立っており、オブジェクトの表面でのマルチタッチタッチによって追跡および決定されます。