1.課題

そこで、画像認識の問題を解決します。 これは、顔、オブジェクト、キャラクターなどの認識です。 まず、手書きの数字を認識する問題を検討することを提案します。 このタスクは、いくつかの理由で有効です。

- 手書き記号を認識するために、形式化された(知的ではない)アルゴリズムをコンパイルすることは非常に困難であり、これは明らかになります。異なる人々によって書かれた同じ数字を見るだけです。

- タスクは非常に関連性が高く、OCR(光学式文字認識)に関連しています

- ダウンロードと実験に利用できる手書き文字の自由に利用可能なベースがあります。

- このテーマに関する記事は非常に多く、さまざまなアプローチを比較するのは非常に簡単で便利です。

入力としてMNISTデータベースを使用することが提案されています。 このデータベースには、60,000のトレーニングペア(画像-ラベル)と10,000のテストペア(ラベルのない画像)が含まれています。 画像はサイズが標準化され、中央に配置されます。 各図のサイズは20x20以下ですが、サイズは28x28の正方形に刻まれています。 MNISTデータベースのトレーニングセットの最初の12桁の例を図に示します。

したがって、タスクは次のように定式化されます。 手書き文字を認識するニューラルネットワークを作成およびトレーニングし、入力で画像を受け入れ、10個の出力の1つをアクティブにします 。 アクティベーションとは、出力で値1を意味します。 この場合の残りの出力の値は(理想的に)-1に等しくなければなりません。 このスケールが使用されない理由[0,1]後で説明します。

2.「通常の」ニューラルネットワーク。

ほとんどの人は、「通常の」または「古典的な」ニューラルネットワークを、エラーの後方伝播を伴う直接結合完全接続ニューラルネットワークと呼びます。

そのようなネットワークで名前が示すように、各ニューロンはそれぞれに接続され、信号は入力層から出力への方向にのみ進み、再帰はありません。 このようなネットワークをPNSと略します。

最初に、入力にデータを送信する方法を決定する必要があります。 PNSの最も単純でほぼ代替的な解決策は、1次元ベクトルの形式で2次元の画像行列を表現することです。 つまり サイズが28x28の手書きの図の画像の場合、入力が784になりますが、これは十分ではありません。 次に起こるのは、多くの保守的な科学者がニューラルネットワークとその手法を好まない理由です。これはアーキテクチャの選択です。 建築の選択は純粋なシャーマニズムだからです。 問題の記述に基づいてニューラルネットワークの構造と構成を一意に決定する方法はまだありません。 防衛面では、ほとんど公式化されていないタスクの場合、このようなメソッドが作成されることはほとんどありません。 さらに、さまざまなヒューリスティックと経験則に加えて、さまざまなネットワーク削減手法(OBD [1]など)があります。 これらのルールの1つでは、隠れ層のニューロンの数は、入力の数より少なくとも1桁大きくする必要があるとされています。 画像からクラスのインジケーターへの変換がかなり複雑で本質的に非線形であることを考慮すると、ここで1つのレイヤーを実行するだけでは不十分です。 上記に基づいて、隠れ層のニューロンの数は約15,000 (第2層で10,000、第3層で5,000)になると概算します。 同時に、2つの隠れ層がある構成の場合、 構成可能かつトレーニング済みのリンクの数は、入力と最初の隠れ層で1,000万+ 1番目と2番目で5,000万+ 2番目と出力で500,000になります(それぞれ10個の出力があると仮定した場合)これは、0から9までの数を示します 。合計約6,000万の接続 。 私はそれらがカスタマイズ可能であることを無駄に言及していません-これは、それぞれのトレーニング中に誤差勾配を計算する必要があることを意味します。

まあ、大丈夫、あなたは何ができますか、人工知能の

3.畳み込みニューラルネットワーク

この問題の解決策は、フランス生まれのアメリカ人科学者イアン・ルクンによって発見されました。これは、医学分野のノーベル賞受賞者の仕事に触発されたトルステン・ニルス・ヴィーゼルとデビッド・H・フーベルです。 これらの科学者は猫の脳の視覚皮質を検査し、さまざまな角度の直線に特に強く反応するいわゆる単純な細胞と、一方向に動く線に反応する複雑な細胞があることを発見しました。 Ian LeKunは、いわゆる畳み込みニューラルネットワークの使用を提案しました[2]。

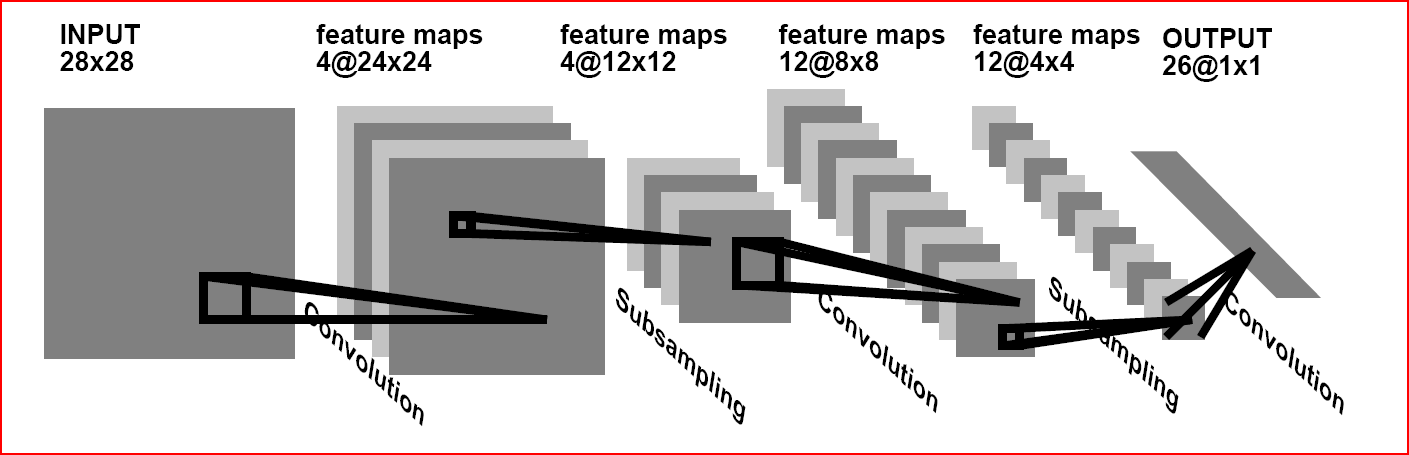

畳み込みニューラルネットワークの概念は、出力に畳み込み層(C層)、サブサンプリング層(S層)、および完全に接続された(F層)層を交互に配置することです。

このアーキテクチャには、3つの主要なパラダイムが含まれています。

- 局所的な知覚。

- 共有ウェイト。

- ダウンサンプリング。

局所知覚は、1つのニューロンの入力には画像全体(または前のレイヤーの出力)ではなく、その領域の一部のみが供給されることを意味します。 このアプローチにより、レイヤーごとに画像のトポロジを保持することができました。

共有ウェイトの概念は、非常に小さなウェイトセットが多数の同点に使用されることを示唆しています。 つまり サイズが32x32ピクセルの入力画像がある場合、次のレイヤーの各ニューロンは、この画像の小さなセクション(5x5など)のみを受け入れ、各フラグメントは同じセットで処理されます。 多くのスケールセットが存在する可能性があることを理解することが重要ですが、スケールセットはそれぞれ画像全体に適用されます。 このようなセットは、多くの場合カーネルと呼ばれます。 サイズ32x32の入力イメージに対してサイズ5x5の10個のコアであっても、リンクの数は約256,000(1000万と比較)になり、調整可能なパラメーターの数は250にすぎないことを計算するのは簡単です!

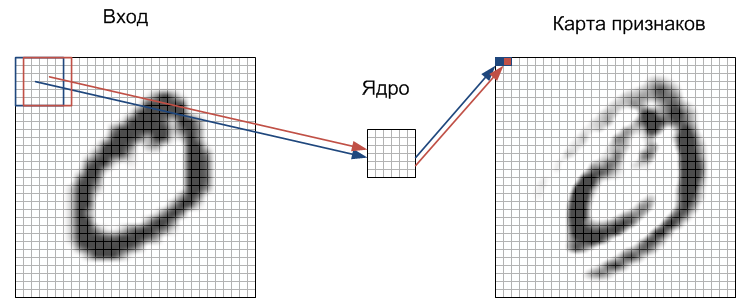

しかし、これは認識の質に何を影響しますか? 奇妙なことに、良い方向に。 事実、このような人為的な重みの制限は、ネットワークの一般化特性(一般化)を改善し、最終的にネットワークが他のノイズに注意を払わずに画像内の不変量を見つけて主にそれらに反応する能力にプラスの影響を与えます。 このアプローチは、少し異なる視点から見ることができます。 画像認識の古典を研究し、実際に(たとえば、軍事装備で)動作する方法を知っている人は、これらのシステムのほとんどが2次元フィルターに基づいていることを知っています。 フィルタは、通常は手動で指定される係数の行列です。 この行列は、 畳み込みと呼ばれる数学演算を使用して画像に適用されます。 この操作の本質は、各画像フラグメントに要素ごとに畳み込み行列(コア)要素を乗算し、結果を合計して出力画像の同じ位置に書き込むことです。 このようなフィルターの主な特性は、出力の値が、画像フラグメントがフィルター自体に似ているほど大きくなることです。 したがって、特定のコアで畳み込まれた画像は別の画像を提供し、その各ピクセルは画像フラグメントとフィルタの類似度を示します。 つまり、機能マップになります。

C層での信号伝搬のプロセスを、図に示してみました。

各画像フラグメントには、要素ごとに重みの小さな行列(コア)が乗算され、結果が合計されます。 この量は、機能マップと呼ばれる出力画像のピクセルです。 ここでは、入力の他のニューラルネットワークのように、入力の重み付き合計がまだアクティベーション関数を通過するという事実を省略しました。 実際、これはS層で発生する可能性があり、根本的な違いはありません。 理想的には、異なる断片がコアを順次通過するのではなく、並行して画像全体が同一の核を通過することを言っておく必要があります。 さらに、コアの数(重みのセット)は開発者によって決定され、選択する機能の数に依存します。 畳み込み層のもう1つの特徴は、エッジ効果により画像がわずかに減少することです。

サブサンプリングとSレイヤーの本質は、画像の空間的次元を減らすことです。 つまり 入力画像は、指定された回数だけ大体(平均)縮小されます。 ほとんどの場合、2回です。ただし、垂直方向に2回、水平方向に3回など、不均一な変化がある場合があります。 スケール不変性を確保するには、サブサンプリングが必要です。

レイヤーを交互に使用すると、フィーチャマップからフィーチャマップを作成できます。これは、実際には、複雑なフィーチャ階層を認識する機能を意味します。

通常、いくつかのレイヤーを通過した後、特徴マップはベクトルまたはスカラーに縮退しますが、そのような特徴マップは数百あります。 この形式では、完全に接続されたネットワークの1つまたは2つの層に供給されます。 このようなネットワークの出力層には、さまざまなアクティベーション機能があります。 最も単純な場合、接線関数である可能性があり、放射基底関数も正常に使用されます。

4.トレーニング

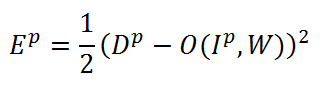

ネットワークのトレーニングを開始するには、認識の品質を測定する方法を決定する必要があります。 私たちのケースでは、このために、ニューラルネットワークの理論で平均二乗誤差(MSE)の最も一般的な関数を使用します[3]。

この式で、Epはp番目のトレーニングペアの認識エラー、Dpは目的のネットワーク出力、O(Ip、W)はp番目の入力と畳み込みカーネル、バイアス、重みを含む重み係数Wに依存するネットワーク出力ですSおよびF層の係数。 トレーニングのタスクは、任意のトレーニングペア(Ip、Dp)で最小エラーEpが得られるように重みWを調整することです。 トレーニングサンプル全体のエラーを計算するには、すべてのトレーニングペアのエラーの算術平均を取るだけです。 この平均誤差をEと表します。

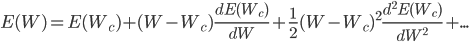

Epエラー関数を最小化するために、最も効果的なのは勾配法です。 例として最も単純な1次元の場合(つまり、重みが1つしかない場合)を使用した勾配法の本質を考えてみましょう。 Taylorシリーズのエラー関数Epを展開すると、次の式が得られます。

ここで、Eは同じ誤差関数であり、Wcは何らかの初期重量値です。 学校の数学から、関数の極値を見つけるには、その導関数をゼロに等しくする必要があることを覚えています。 それでは、エラー関数の重量による導関数を取得し、2次より上の項を破棄します。

この式から、エラー関数の値が最小になる重みは、次の式から計算できます。

つまり 最適な重みは、電流から誤差関数の微分を重みで除算し、誤差関数の二次微分で除算して計算されます。 多次元の場合(つまり、重み行列の場合)はすべてまったく同じであり、1次導関数のみが勾配(偏導関数のベクトル)に変わり、2次導関数はヘッセ行列(2次偏導関数の行列)になります。 そして、ここで2つのオプションが可能です。 2次導関数を省略すると、最速の勾配降下のアルゴリズムが得られます。 それでも2次導関数を考慮したい場合、完全なヘッセ行列を計算し、それを逆にするのに必要な計算リソースの量に驚かされます。 したがって、通常、ヘシアンはより単純なものに置き換えられます。 たとえば、最も有名で成功した方法の1つであるLevenberg-Marquardt(LM)法は、ヘッセ行列を置き換え、その近似は2次ヤコビアンを使用します。 詳細はここではわかりません。

しかし、これら2つの方法について知っておくべき重要なことは、LMアルゴリズムではトレーニングサンプル全体を処理する必要がありますが、勾配降下アルゴリズムでは個々のトレーニングサンプルを処理できることです。 後者の場合、アルゴリズムは確率的勾配と呼ばれます。 データベースに60,000のトレーニングサンプルが含まれていることを考えると、確率的勾配がより適しています。 確率的勾配のもう1つの利点は、LMと比較してローカルミニマムに陥りにくいことです。

LMアルゴリズムの確率的な変更もありますが、これについては後で説明します。

提示された式により、出力層の重みに関する誤差の導関数を簡単に計算できます。 AI で広く知られているエラー伝播方法では、隠れ層でエラーを計算できます。

5.実装

個人的には、Matlabを使用して、リアルタイムで動作する必要のないさまざまなアルゴリズムを実装しています。 これは非常に便利なパッケージです。M言語を使用すると、メモリの割り当て、I / O操作などを気にせずにアルゴリズム自体に集中できます。 さらに、さまざまなツールボックスを使用して、真に学際的なアプリケーションを最短時間で作成できます。 たとえば、Image Acquisition Toolboxを使用してWebカメラを接続し、Image Processing Toolboxを使用して画像を処理し、Neural Network Toolboxを使用してロボットのモーションパスを作成し、Virtual Reality ToolboxおよびControl Systems Toolboxを使用してロボットの動きをシミュレートできます。 Neural Network Toolboxといえば、これはかなり柔軟なツールセットであり、さまざまなタイプとアーキテクチャのニューラルネットワークを作成できますが、残念ながら畳み込みNSではありません。 それはすべて共有スケールです。 NNツールボックスには、共有ウェイトを設定する機能がありません。

この欠点を解消するために、任意のアーキテクチャのSNAを実装してさまざまなタスクに適用できるクラスを作成しました。 こちらからクラスをダウンロードしてください 。 クラス自体は、それを使用する人に最大のネットワーク構造が見えるように書かれています。 変数の名前が保存されなかったため、すべてが非常に豊富にコメントされています。 ネットワークシミュレーションの速度は悪くなく、ほんの一瞬です。 トレーニングの速度はまだ高速ではありませんが(> 10時間)、更新に合わせて調整してください。注文による加速は近い将来に予定されています。

C ++でのSNAの実装に興味がある人は、 こことここでそれを見つけることができます。

6.結果

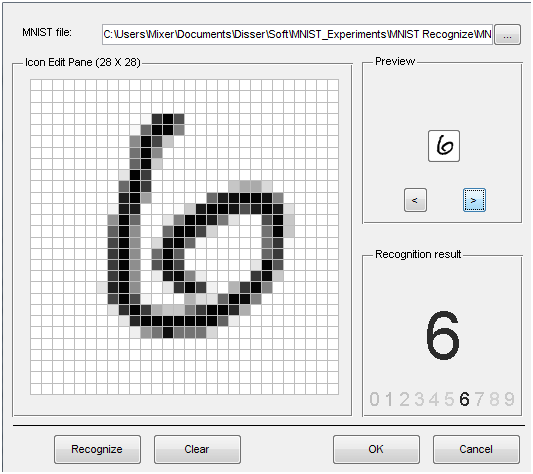

matlabcentralのプログラムには、既に訓練されたニューラルネットワークのファイルと、作業結果を示すGUIが付属しています。 認識の例を次に示します。

リンクには、MNISTに基づく認識方法を比較する表があります。 最初の場所は、0.39%の認識エラーの結果を伴う畳み込みニューラルネットワークです[4]。 これらの誤って認識された画像のほとんどは、すべての人によって正しく認識されません。 さらに、入力画像の弾性歪み、および教師なしの予備トレーニングが[4]で使用されました。 しかし、他の記事でこれらの方法について。

参照資料

- Yann LeCun、JS Denker、S。Solla、RE Howard、LD Jackel:Optimal Brain Damage、in Touretzky、David(Eds)、Advances in Neural Information Processing Systems 2(NIPS * 89)、Morgan Kaufman、Denver、CO、1990

- Y. LeCunとY. Bengio:画像、音声、時系列のたたみ込みネットワーク、マサチューセッツ州アービブ(Eds)、The Brainbook of Brain Theory and Neural Networks、MIT Press、1995

- Y. LeCun、L. Bottou、G. Orr and K. Muller:Efficient BackProp、in Orr、G. and Muller K.(Eds)、Neural Networks:Tricks of the trade、Springer、1998

- Ranzato Marc'Aurelio、Christopher Poultney、Sumit Chopra、およびYann LeCun:J. Platt et al。のエネルギーベースモデルによるスパース表現の効率的な学習 (編)、ニューラル情報処理システムの進歩(NIPS 2006)、MIT Press、2006

PSコメントとフィードバックをありがとうございました。 これはハブに関する私の最初の記事ですので、提案、コメント、追加を見てうれしいです。