datacenterknowledge.com

昨年、現時点で最大のRAIDIXベースのストレージインストールが実装されました。 11のフェールオーバークラスターのシステムが、理化学研究所計算科学研究所(日本)に展開されました。 システムの主な目的は、HPCインフラストラクチャ(HPCI)のストレージであり、学術情報Academic Cloud(SINETネットワークに基づく)の大規模な学術交換の一部として実装されます。

このプロジェクトの重要な特徴は、総容量が65 PBであり、システムの使用可能容量は51.4 PBです。 この値をよりよく理解するために、これらはそれぞれ10 TBの6512個のディスクであることを追加します(インストール時の最新のもの)。 これはたくさんあります。

プロジェクトの作業は1年を通して続けられ、その後、システムの安定性の監視はさらに1年間続けられました。 得られた指標は規定の要件を満たしていたため、この記録の成功と私たちにとって重要なプロジェクトについて話すことができます。

理研研究所コンピューティングセンターのスーパーコンピューター

ICT産業の場合、理研研究所は、主に伝説的な「K-コンピューター」(10兆兆を意味する日本の「kei」から)で知られています。

K-コンピューターについて読む

スーパーコンピューターは、複雑な大規模研究の実施において計算科学センターを支援します。気候、気象条件、分子挙動のモデリング、核物理学における反応の計算と分析、地震予知などを可能にします。 スーパーコンピューターの能力は、油田を検索し、株式市場の動向を予測するために、より多くの「毎日」の応用研究にも使用されています。

このような計算と実験は膨大な量のデータを生成しますが、その価値と重要性は過大評価することはできません。 これを最大限に活用するために、日本の科学者は、さまざまな研究センターのHPC専門家が受け取ったHPCリソースにアクセスできる単一の情報スペースの概念を開発しました。

高性能コンピューティングインフラストラクチャ(HPCI)

HPCIは、日本の大学と研究センターの間で科学データを交換するためのバックボーンネットワークであるSINET(科学情報ネットワーク)に基づいて動作します。 現在、SINETは約850の研究所と大学を結集し、核物理学、天文学、測地学、地震学、およびコンピューターサイエンスに影響を与える研究における情報交換の大きな機会を生み出しています。

HPCIは、日本の大学と研究センター間の高性能コンピューティングの分野で統一された情報交換システムを形成するユニークなインフラストラクチャプロジェクトです。

「K」スーパーコンピューターと他の研究センターの機能をアクセス可能な形式で組み合わせることにより、科学界はスーパーコンピューターコンピューティングによって作成された貴重なデータを操作することで明らかな利点を受け取ります。

HPCI環境への効果的な共同ユーザーアクセスを確保するために、アクセス速度に対する高い要件がストレージに課されました。 また、Kコンピューターの「高生産性」のおかげで、理研計算科学研究所のストレージクラスターは、少なくとも50 PBの作業量で作成されるように計算されました。

HPCIプロジェクトのインフラストラクチャは、Gfarmファイルシステムに基づいて構築されました。これにより、高レベルのパフォーマンスを提供し、異なるストレージクラスターを単一の共有スペースに結合することが可能になりました。

Gfarmファイルシステム

Gfarmは、日本人エンジニアによって開発されたオープンソースの分散ファイルシステムです。 Gfarmは先進産業科学技術研究所(AIST)の開発の成果であり、システムの名前はグリッドデータファームで使用されるアーキテクチャを指します。

このファイルシステムは、一見互換性のないプロパティをいくつか組み合わせています。

- ボリュームとパフォーマンスの高いスケーラビリティ

- 複数の多様な研究センターの単一の名前空間をサポートする長距離ネットワーク配信

- POSIX APIサポート

- 並列計算に必要な高性能

- データストレージセキュリティ

Gfarmは、複数のサーバーのストレージリソースを使用して仮想ファイルシステムを作成します。 データはメタデータサーバーによって配信され、配信スキーム自体はユーザーから隠されます。 Gfarmは、ストレージクラスターだけでなく、同じサーバーのリソースを使用する計算グリッドでも構成されていると言わなければなりません。 システムの動作原理はHadoopを連想させます。送信された作業は、データが存在するノードに「下げられ」ます。

ファイルシステムのアーキテクチャは非対称です。 役割は明確に割り当てられています:ストレージサーバー、メタデータサーバー、クライアント。 しかし同時に、3つの役割すべてを同じマシンで実行できます。 ストレージサーバーはファイルの多くのコピーを保存し、メタデータサーバーはマスタースレーブモードで動作します。

プロジェクト作業

日本におけるRAIDIXの戦略的パートナーおよび独占的サプライヤであるCore Micro Systemsは、理化学研究所計算科学センターで実装を実施しました。 プロジェクトを実施するには、12か月の骨の折れる作業が必要でした。この作業には、Core Micro Systemsの従業員だけでなく、Reydixチームの技術専門家も積極的に参加しました。

同時に、別のストレージシステムへの移行は考えられませんでした。既存のシステムには多くの技術的な拘束力があり、新しいブランドへの移行が複雑になりました。

長時間のテスト中、チェックと改善RAIDIXは、このような膨大な量のデータを扱う際に一貫して高いパフォーマンスと効率を示しました。

改善点については、もう少し説明する価値があります。 ストレージシステムとGfarmファイルシステムの統合を作成するだけでなく、ソフトウェアのいくつかの機能特性を拡張する必要がありました。 たとえば、確立された技術仕様の要件を満たすために、できるだけ早く自動書き込み機能の技術を開発して実装する必要がありました。

システム自体の展開は体系的でした。 Core Micro Systemsのエンジニアは、テストの各段階を慎重かつ正確に実施し、システムの規模を徐々に拡大しました。

2017年8月、システムボリュームが18 PBに達したときに、最初の展開フェーズが完了しました。 同じ年の10月に第2フェーズが実施され、そのボリュームは記録的な51 PBに達しました。

ソリューションのアーキテクチャ

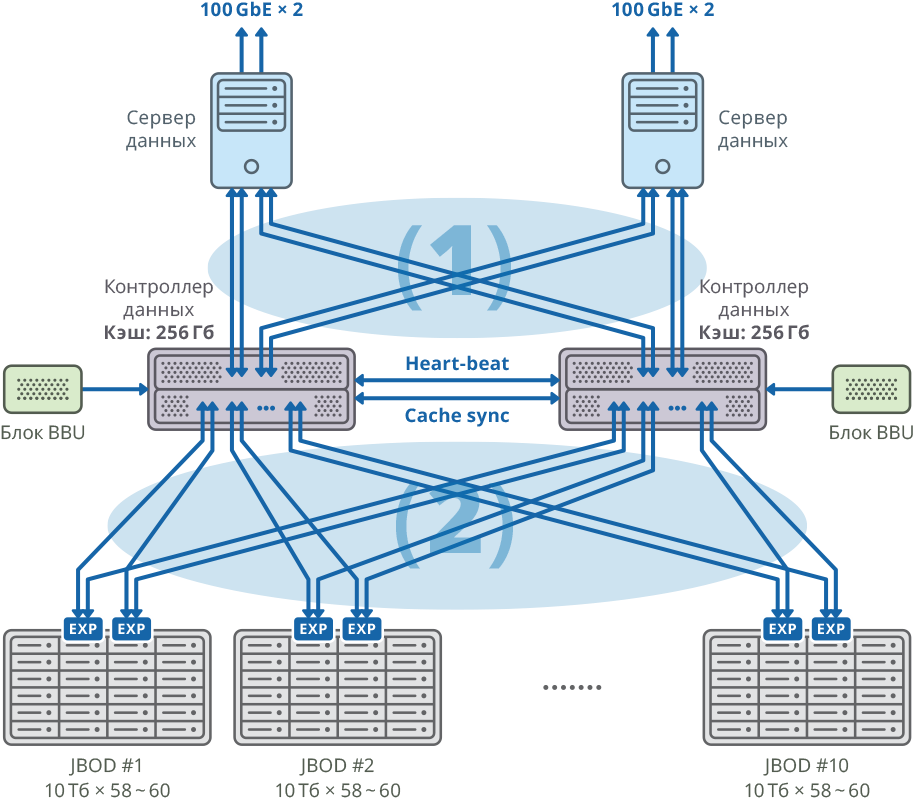

このソリューションは、RAIDIXストレージシステムとGfarm分散ファイルシステムの統合により作成されました。 Gfarmと組み合わせて、11のデュアルコントローラーRAIDIXシステムを使用してスケーラブルなストレージを作成する機能。

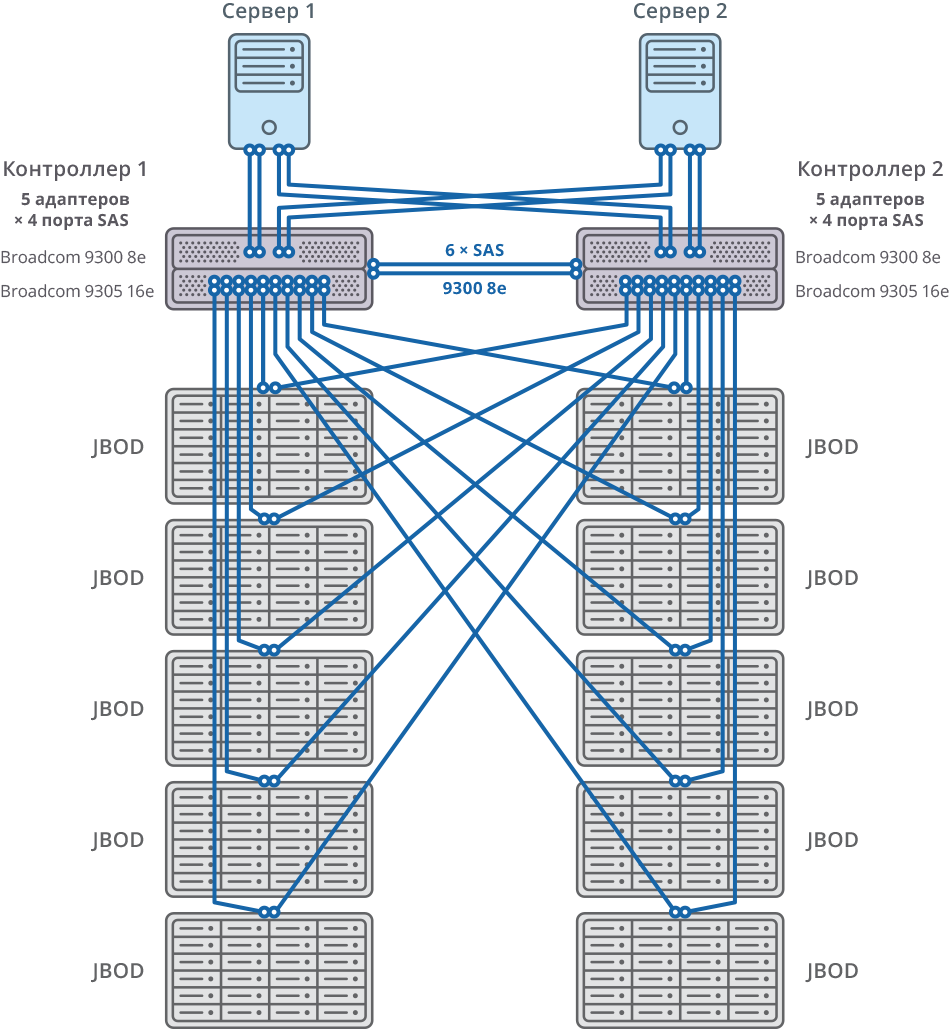

Gfarmサーバーへの接続は、8 x SAS 12Gを介して行われます。

図 1.各ノードに個別のデータサーバーがあるクラスターのイメージ

(1)48Gbps×8 SAN Mesh接続。 帯域幅:384Gbps

(2)48Gbps×40メッシュFABRIC接続。 帯域幅:1920Gbps

デュアルコントローラープラットフォーム構成

| CPU | Intel Xeon E5-2637-4個 |

| マザーボード | PCI Express 3.0 x8 / x16をサポートするプロセッサモデルとの互換性 |

| 内部キャッシュ | 各ノードに256 GB |

| シャシー | 2U |

| ディスクシェルフ、サーバー、および書き込みキャッシュの同期を接続するためのSASコントローラー | Broadcom 9305 16e、9300 8e |

| HDD | HGSTヘリウム10TB SAS HDD |

| ハートビート同期 | イーサネット1 GbE |

| CacheSync Sync | 6 x SAS 12G |

フェールオーバークラスターの両方のノードは、各ノードの20個のSAS 12Gポートを介して10個のJBOD(それぞれ10 TBの60個のディスク)に接続されます。 これらのディスクシェルフには、58個の10TB RAID6アレイが作成され(8個のデータディスク(D)+ 2個のパリティディスク(P))、12個のディスクが「ホットスワップ」用に割り当てられました。

10 JBOD => 58×RAID6(8データディスク(D)+ 2パリティディスク(P))、580 HDDからのLUN +「ホットスワップ」用の12 HDD(総ボリュームの2.06%)

クラスタあたり592 HDD(10TB SAS / 7.2k HDD)* HDD:HGST(MTBF:2 500 000時間)

図 2. 10 JBOD接続図を使用したフェールオーバークラスター

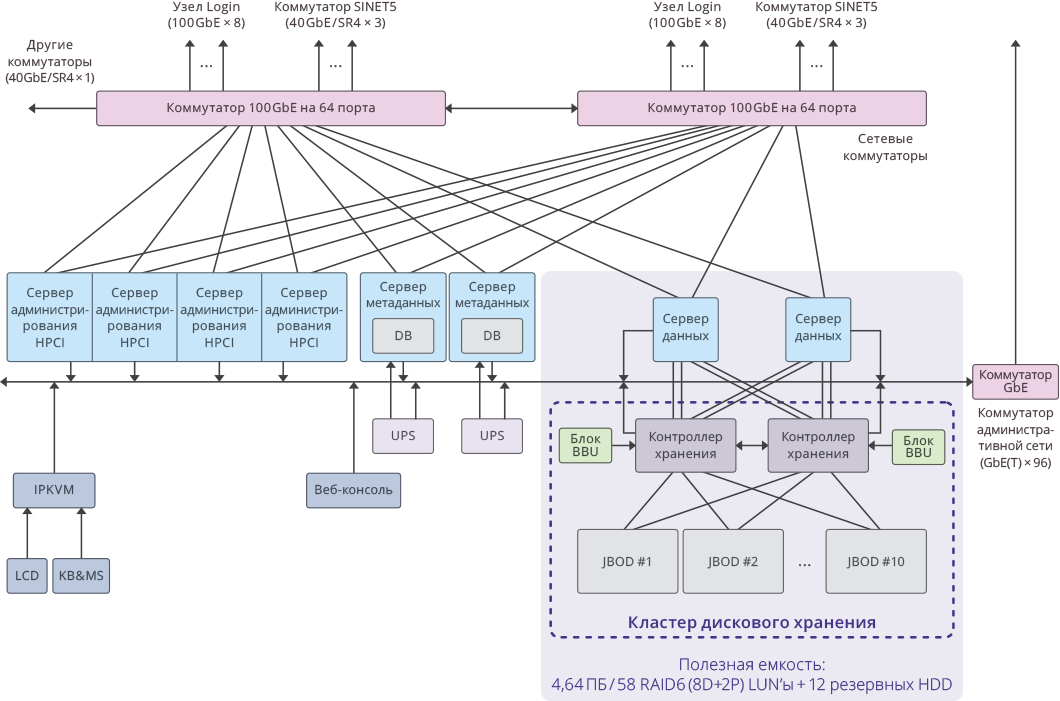

システムと接続の一般的なスキーム

図 3. HPCIシステム内の単一クラスターのイメージ

主要プロジェクト指標

クラスターあたりの使用可能容量: 4.64 PB ((RAID6 / 8D + 2P)LUN×58)

システム全体の合計使用可能容量: 51.04 PB (4.64 PB×11クラスター)。

総システム容量: 65 PB 。

システムのパフォーマンスは次のとおりでした:書き込み用に17 GB /秒 、読み取り用に22 GB /秒 。

11 RAIDIXストレージシステム上のクラスターのディスクサブシステムの合計パフォーマンス: 250 GB /秒 。