少し前、Pure Storageは新しいActiveCluster機能を発表しました。これは、データウェアハウス間のアクティブ/アクティブメトロクラスターです。 これは、論理ボリュームが2つのリポジトリ間でストレッチされ、両方で読み取り/書き込みが行われる同期レプリケーションテクノロジーです。 この機能は、新しいPurity // FA 5ファームウェアバージョンで使用でき、完全に無料です。 また、Pure Storageは、拡張クラスターのセットアップがこれほど簡単で簡単ではないことを約束しました。

この記事では、ActiveClusterについて説明します:ActiveClusterの構成、動作、構成方法。 記事の一部は、公式文書の翻訳です。 さらに、VMware環境でフォールトトレランスをテストした経験を共有します。

競争力のあるソリューション

提示された機能は革新的ではなく、ほとんどの主要なストレージメーカーが同様のソリューションを備えています:Hitachi GAD(グローバルアクティブデバイス)、IBM HyperSwap、HPE 3PAR Peer Persistance、Fujitsu Storage Cluster、Dell Compellent Live Volume、 Huawei HyperMetro

ただし、競合ソリューションと比較したActiveClusterの利点のいくつかを強調することにしました。

- 追加のライセンスは必要ありません。 機能はそのまま使用できます。

- シンプルなレプリケーション管理(試しました-本当に便利でシンプルです)。

- クラウドピック(定足数デバイス)。 3番目のサイトを必要とせず、その上にサーバークォーラムを展開します。

ActiveClusterの概要

ActiveClusterを構成するコンポーネントを検討してください。

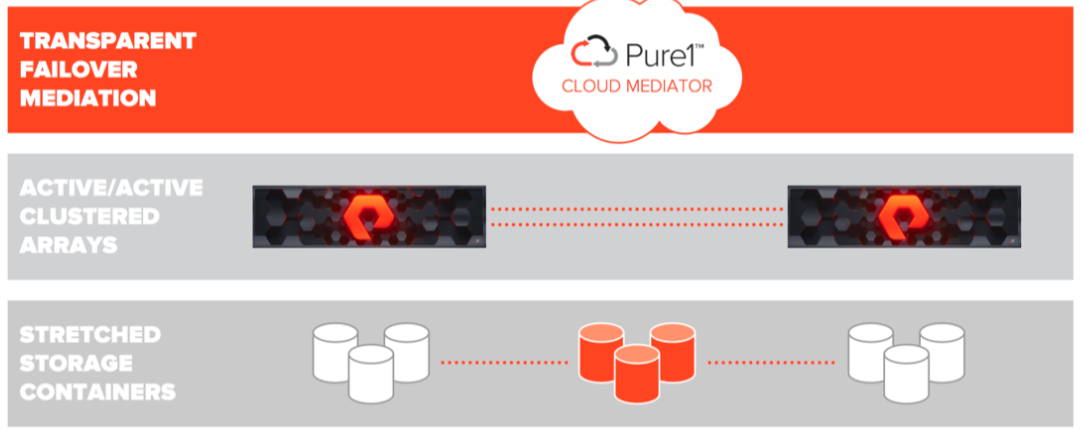

- トランスペアレントフェールオーバーメディエーション 。 Cloud Mediatorはサーバー/デバイスクォーラムであり、どのアレイが引き続き動作し、データへのアクセスを提供し、さまざまな障害が発生した場合に動作を停止するアレイを決定します。

- アクティブ/アクティブクラスターアレイ -同期レプリケーションが構成されたPureStorageアレイ。 あるアレイと別のアレイのデータの一貫したコピーへのアクセスを提供します。

- ストレッチストレージコンテナ-2つのアレイ間で複製する必要があるオブジェクトを含むコンテナ 。

ActiveCluster-ポッドにアクティブなオブジェクトが登場しました。 ポッドは、他のオブジェクトを含むコンテナです。 2つのアレイ間に複製チャネルがある場合、複数のアレイをポッドに追加でき、このポッド内のすべてのオブジェクトがアレイ間で複製されます。 ストレッチポッドは、どのアレイからでも制御できます。

ポッドには、ボリューム、スナップショット、保護グループ、およびその他の構成情報が含まれる場合があります。 ポッドは一貫性グループとして機能します。つまり、1つのポッドでのボリュームの一貫した記録順序を保証します。

ActiveCluster:アレイのホストアクセススキーム

データへのホストアクセスは、均一と非均一の2つのアクセスモデルで構成できます。 均一なモデルでは、両方のサイトの各ホストが両方のアレイへの読み取り/書き込みアクセス権を持ちます。 非均一モデルでは、各ホストはローカルに配置された読み取り/書き込みアレイにのみアクセスできます。

均一なアクセスモデル

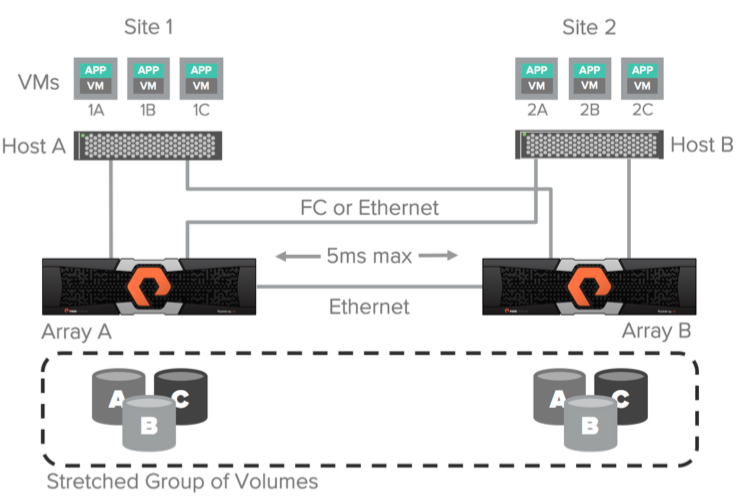

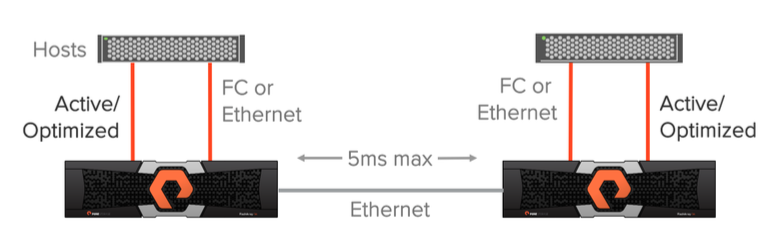

Uniformデータアクセスモデルは、ファイバーチャネルまたはイーサネット(iSCSI)を使用してホストをアレイに接続し、レプリケーションのためにアレイ間でイーサネット接続(10g)を使用する環境で使用できます。 この構成では、ホストはローカルとリモートの両方のアレイを介してデータにアクセスできます。 このソリューションは、5 msの複製チャネルを介したアレイ間の最大遅延でのみサポートされます。

上の図は、ホストからアレイへの論理パス、および均一アクセス方式のアレイ間の複製チャネルを示しています。 データは、ホストの場所に関係なく両方のホストで利用できると想定されています。 ローカルアレイへのパスは、リモートアレイへのパスよりも遅延が少ないことを理解することが重要です。

Uniformモデルを使用する場合のパフォーマンスの最適化

アクティブ/アクティブ同期レプリケーションを使用する際のI / Oパフォーマンスを向上させるために、ホストはリモートアレイへのパスを使用しないでください。 たとえば、次の図を検討してください。 VM 2AがアレイAアレイを使用してボリュームAで書き込み操作を実行する場合、この書き込み操作により、ホストからリモートアレイへの遅延だけでなく、レプリケーションチャネルを介したデータ転送の二重の遅延が発生します。

より詳細に分解することを提案します。 アレイ間のレプリケーションチャネルの遅延が3ミリ秒であるとします。 接続「ホストB」<->「アレイB」の場合、遅延は1ミリ秒です。 そして、「ホストB」<->「アレイA」の場合-3ms。 書き込みコマンドは、3msの遅延でVM 2Aホストからリモートサイト、アレイAアレイに送信されます。 次に、書き込みコマンドがレプリケーションチャネル経由で6ミリ秒(3ミリ秒+ 3ミリ秒)の遅延でアレイBアレイに送信されます。 その後、正常な記録に関する応答が、レプリケーションチャネルを介してアレイBアレイからアレイAアレイに返送されます(6ミリ秒+ 3ミリ秒= 9ミリ秒)。 次に、記録の成功に関する応答がホスト「VM 2A」に返送されます(9ms + 3ms = 12ms)。 リモートアレイを使用する場合、書き込み操作で合計12msの遅延が発生します。 ローカル配列を使用してまったく同じ原理を計算すると、8ミリ秒になります。

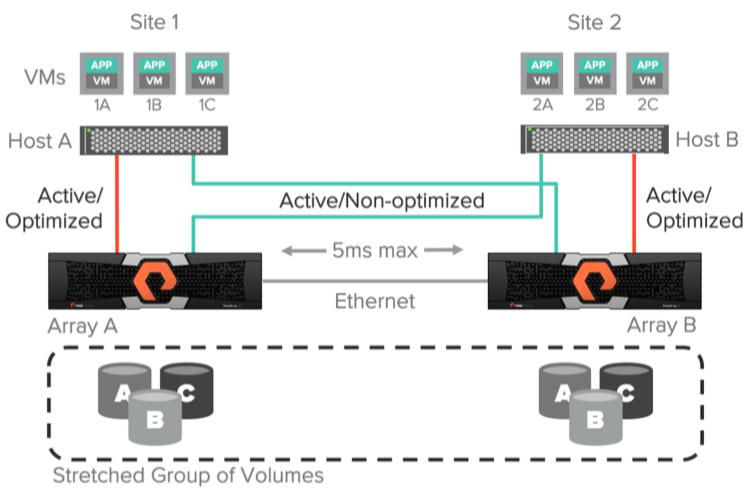

ActiveClusterでは、ALUA(非対称論理ユニットアクセス)を使用して、ローカルホストへのパスをアクティブ/最適化として提供し、リモートホストへのパスをアクティブ/非最適化として提供できます。 優先アレイオプションを設定することにより、ホスト<->ボリュームバンドルごとに最適なパスが決定されます。 したがって、アプリケーションまたは仮想マシンがどのホストで実行されているかは関係ありません。ホストは常に、どのアレイがローカル(最適なパスを持つ)で、どのアレイがリモート(最適なパスではない)かを認識します。

ActiveClusterを使用すると、仮想マシンまたはアプリケーションが実行されているサイトを心配することなく、真にアクティブ/アクティブなデータセンターを構成できます。 すべての読み取り/書き込み操作は、常にホストローカル配列を経由します。

不均一なアクセスモデル

非均一アクセスモデルは、ファイバーチャネルまたはイーサネット(iSCSI)を使用してホストをアレイに接続する環境でも使用されます。 このモデルでは、ホストはローカルアレイにのみアクセスでき、リモートアレイにはアクセスできません。 このソリューションには、5ms以内の遅延でアレイ間のレプリケーション接続を使用することも含まれます。

これらのアクセスモデルの長所と短所

Uniformアクセスモデルは、1つのアレイの障害がこのアレイを使用する仮想マシンまたはアプリケーションの再起動を必要としないため、より高いレベルのフォールトトレランスを提供します。データへのアクセスは別のアレイを通じて継続されます。 もちろん、このモデルは、ホスト側で動作および設定されたマルチパスを想定しています。これにより、アクティブ/最適化されたパスと前者が利用できない場合のアクティブ/非最適化に沿ってI / O要求が分散されます。

非均一モデルを使用する場合、ホストはローカルアレイにのみアクセスできるため、アクティブ/最適化されたパスのみを使用できます。 ローカルアレイに障害が発生した場合、すべての仮想マシンまたはアプリケーションはこのサイトのデータへのアクセスを失い、別のアレイを介したデータへのアクセスを使用して別のサイトで(たとえば、VMware HAを使用して)再起動されます。

アクティブなクラスターを構成する

Pure Storageのスタッフは、ActiveClusterの非常にシンプルで直感的なセットアップを発表しています。 さて、見てみましょう。 セットアップは4つの手順で行われます。

ステップ1 :2つのFlashアレイを接続します。

2つの10Gb / sイーサネットチャネルでアレイを接続し、GUIを介して接続タイプを同期レプリケーションとして構成します。

ステップ2 :ポッドを作成してストレッチします。

ポッドを作成するには、CLIを使用します(GUIからも可能です)。 purepodコマンドは、ポッドの作成と「ストレッチ」に使用されます。 前述したように、ポッドはアクティブ/アクティブ環境での管理を簡素化するように設計されたコンテナです。 ポッドは、配列間で同期的に複製されるオブジェクトを決定します。 任意の配列からストレッチポッドとその中のオブジェクトを制御できます。 ポッドには、ボリューム、スナップショット、クローン、グループ進行、およびその他の構成情報を含めることができます。

配列A配列にポッドを作成します。

arrayA> purepod create pod1

配列Bでポッドをストレッチします。

arrayA> purepod add --array arrayB pod1

これで、このポッドに配置されたボリューム、スナップショット、またはクローンは、アレイAアレイとアレイBアレイ間で自動的に複製されます。

ステップ3 :ボリュームを作成する

いずれかのアレイで、サイズが1TBのボリュームvol1を作成し、pod1に配置します。

> purevol create --size 1T pod1::vol1

ボリュームを作成する代わりに、既存のボリュームをpod1に移動すると、複製が開始されます。

ステップ4 :ホストにボリュームを提示します。

繰り返しになりますが、ActiveClusterは実際のアクティブ/アクティブソリューションであり、両方のアレイを使用して同じ論理ボリュームを読み書きできます。

ホストを作成し、このホストにvol1を提示します。

> purehost create --preferred-array arrayA --wwnlist <WWNs f ESX-1 >

> purehost connect --vol pod1::vol1 ESX-1

–preferred-arrayオプションを指定することに注意してください。これは、ArrayAアレイからのパスがこのホストに最適(アクティブ/最適化)になることを意味します。

以上です! ESX-1は、ArrayAとArrayBの両方を介してボリュームvol1にアクセスできるようになりました。 早くて簡単ですね。

さらに、メディエーターの状態を確認します。 クラウドメディエーターPureを使用します。それにアクセスするには、アレイがインターネットにアクセスできる必要があります。 セキュリティポリシーでこれが許可されていない場合、ローカルメディエータをダウンロードして展開することができます。

purepod list --mediator

Name Source Mediator Mediator Version Array Status Frozen At Mediator Status

pod1 - purestorage 1.0 Array-A online – online

Array-B online - online

VMwareのActiveCluster機能テスト

仮想マシンのフォールトトレラントな動作を提供するという観点から、ActiveClusterとVMware(2 ESXホスト)の構成で2つのFlashアレイ// m20の組み合わせを機能テストするタスクに直面しました。 2つのサイトの存在をエミュレートしました。各サイトにはESXホストとフラッシュアレイがありました。 VMware 6.5 U1バージョンとPure // FA 5.0.1バージョンを使用しました。

次の成功基準がありました。

- エミュレートされたディスクアレイの障害により、仮想マシンが誤動作することはありません。

- エミュレートされたESXサーバーの障害により、別のESXサーバーで仮想マシンを(VMware HAを使用して)自動的に開始できます。

- 模擬サイト障害(アレイ+ esxサーバー)を使用すると、別のサイトで仮想マシンを自動的に起動できます(VMware HAを使用)。

- VMware + ActiveClusterを使用して構成でvMotionをテストします。

ブースのレイアウトは次のとおりです。

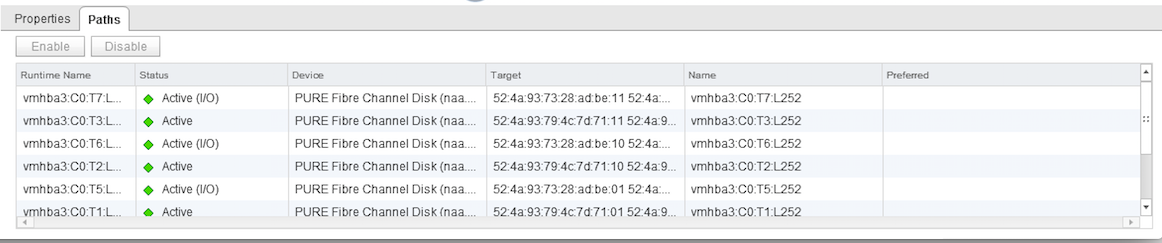

m20#1とm20#2アレイの間で、ActiveClusterは10 Gb / sレプリケーションチャネルを使用して構築されました。 ポッドは1つのアレイ上に作成され、2番目のアレイを追加することで引き伸ばされました。 両方のアレイで、200GBのボリュームが作成され、ストレッチされたポッドに追加されたため、アレイ間でこれらのボリュームの複製が開始されました。 レプリケートされたボリュームは、ホストグループの優先アレイ構成を使用して、均一アクセススキームを使用して両方のESXホストに提示されました。 ESX1ホストの優先アレイはm20#1で、ESX2の優先アレイはそれぞれm20#2でした。 したがって、ESXホスト側からは、データストアへのパスはローカルアレイに対してアクティブ(I / O最適化)であり、リモートに対してアクティブ(非最適化)でした。

ディスクアレイ障害のエミュレーション

テストのために、Windows 2012 r2を搭載した仮想マシンがインストールされました。 VMファイルは、Pure Storageを備えた拡張ボリューム上の共有データストアにありました。 また、同じデータストアからの別の100GBディスクがこのVMに提示され、IOmeterを使用して合成負荷を起動しました。 パフォーマンスを測定するという目標がなかったので、I / Oアクティビティを生成する必要があったため、テスト中にアレイへのパスを切り替えたときにSCSI読み取り/書き込みコマンドがハングする瞬間をキャッチできました。

これで、すべての準備が整いました。テストVMはESX1で動作し、ESX1ホストは入出力操作にm20#1アレイへの最適なパスを使用します。 サーバールームに移動し、m20#1アレイを電源で切り落とし、VMのIOmeterを観察します。 入力/出力の中断は発生しません。 データストアへのパスの状態を確認します。m20#1へのパスはデッド状態にあり、m20#2へのパスはアクティブ(I / O)状態にあります。 テストは入力データがわずかに異なる複数回実行されましたが、結果は常に成功しました。 テストは成功したとみなされます。

PS m20#1アレイをオンにした後、パスはスイッチに戻りました。つまり、このESXホストのローカルサイトに戻りました。

ESXホスト障害のエミュレート

このテストは、Pure StorageではなくVMware HAの動作を実際にテストするため、あまり興味深いものではありません。 いずれにせよ、VMのダウンタイムと、その後の別のESXホスト上のクラスターによる復活が予想されました。

一般的に、サーバールームに行き、ESX1ホストに電源を入れました。 VMware HAは正常に機能し、ESX2ホストでVMが正常に起動しました。 テストは成功したとみなされます。

サイト全体の障害のエミュレーション

実際、これは同時に行われる最初と2番目のテストです。 いずれにしても、ESXホストを切断するため、これは仮想マシンのダウンタイムです。 初期データは最初のテストと同じです。VMはESX1で実行され、ESX1ホストはm20#1を使用してアレイの入出力を行い、IOmeterはVMで起動されてアレイの合成負荷をかけます。

サーバールームに行き、ESX1とm20#1の電源を切ります。 観察しています。 1〜2分以内に、VMware HAは仮想マシンをESX2に上げます。ESX2へのパスは、m20#1では無効で、m20#2アレイではアクティブ(I / O)です。 テストは成功したとみなされます。

ActiveCluster構成でvMotionの健全性を確認する

非常に正式なテスト。 それが機能し、落とし穴がないことを確認する必要がありました。 スイッチをオンにした仮想マシンとスイッチをオフにした仮想マシンの両方でvMotionを実行しました。データストアを変更する場合と変更しない場合で、問題は明らかになりませんでした。 テストに成功しました。

おわりに

同期レプリケーションテクノロジーはもはや新しいものではなく、ほとんどすべての主要なストレージベンダーが持っていますが、Pure Storageは使用のために追加のライセンスを必要としないため、その中でも際立っています。 また、Pureのスタッフはレプリケーション管理の利便性を新たなレベルに引き上げました。構成するために何十ページものドキュメントを勉強する必要がなくなり、プロセス全体が直感的になりました。 コンピテンシーを向上させ、概念実証組織の枠組み内で、自宅と顧客の両方でさまざまなテストを実施しています。 OCSのディストリビューターと一緒に(2番目のアレイを取得しました)、ロシアで最初のPure Storage ActiveClusterを展開し、テストしました。

Sergey Surnin、Jet Infosystemsサービスセンターのエキスパート