畳み込みニューラルネットワーク

まず、少しの理論。 畳み込みとは何ですか? これについては多くの資料がすでに書かれているので、これについて詳しくは説明しませんが、まだ簡単に実行する価値があります。 スタンフォード大学からの美しい視覚化により、本質を把握できます。

出所

後でお互いを理解できるように、基本的な概念を紹介する必要があります。 大きなマトリックスを移動するウィンドウはフィルターと呼ばれます(英語版のカーネル、フィルター、または機能検出器では、これらの用語の翻訳とトレースを見つけることができますが、怖がらないでください、すべて同じです)。 フィルターは大きなマトリックスのセクションに重ねられ、各値に対応するフィルター値が乗算されます(メインマトリックスの黒い数字の下と右の赤い数字)。 次に、判明したすべてが加算され、出力(「フィルター処理済み」)値が取得されます。

ウィンドウは、英語ではストライドと呼ばれる大きなステップに沿って移動します。 このステップは水平および垂直にすることができます(後者は私たちにとって有用ではありませんが)。

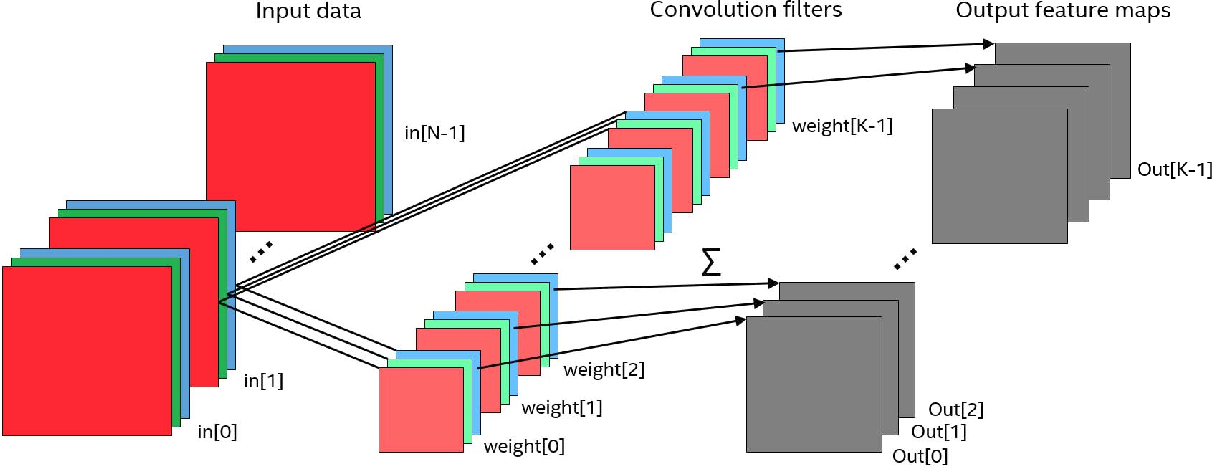

重要なチャンネルのコンセプトを紹介することは残っています。 画像内のチャンネルは、多くの人に知られている基本色と呼ばれます。たとえば、単純で一般的なRGBカラーコーディングスキーム(赤-赤、緑-緑、青-青)について話している場合、これらの3つの基本色のうち、それらを混合することにより、任意の色を取得できます。 ここでのキーワードは「混合」です。3つの基本色はすべて同時に存在し、たとえば、希望の色のフィルターを使用して太陽の白色光から取得できます(用語が意味を成し始めていると感じますか?)。

そして、画像があり、その中にチャンネルがあり、フィルターが正しいステップでそれを通過することがわかります。 理解する必要があります-これらのチャネルで実際に何をすべきか? これらのチャネルを使用して、次のことを行います。各フィルター(つまり、小さなマトリックス)は、3つのチャネルすべてで同時に元のマトリックスに重ねられます。 結果は単純に要約されます(見れば論理的には、最終的にチャネルは光の連続した物理的スペクトルを扱う方法です)。

もう1つ詳細に言及する必要がありますが、それなしではさらに理解することは難しくなります。 どういう意味ですか? これは、同じジョブを実行するn個のフィルターがあることを意味します。 彼らは窓でマトリックスを歩き回り、何かを考えます。 なぜ、1つの仕事を2回行うのでしょうか? 1つではなく1つ-フィルタリングマトリックスの初期化が異なるため、学習プロセスでは、異なる詳細に注意を払い始めます。 たとえば、1つのフィルターは行を調べ、もう1つのフィルターは特定の色を調べます。

ソース:cs231n

これは、1つのネットワークの1つのレイヤーのさまざまなフィルターの視覚化です。 彼らがまったく異なる画像機能をどのように見ているかを見てください。

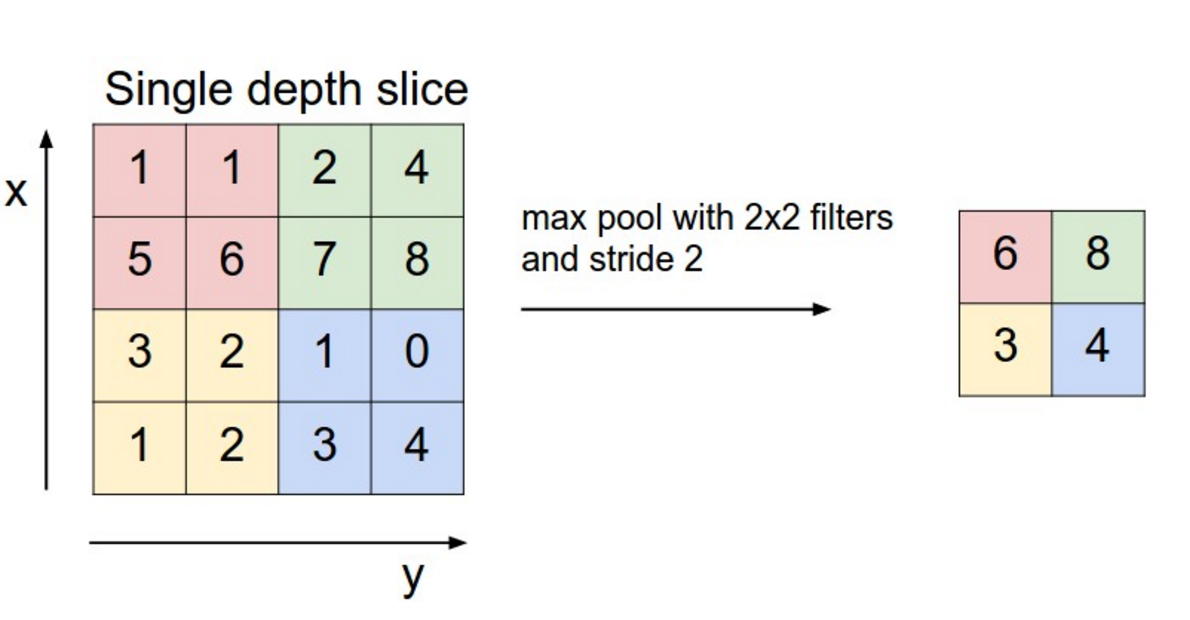

すべて、私たちは先に進むために用語で武装しています。 用語と並行して、畳み込み層がどのように機能するかを見つけました。 畳み込みニューラルネットワークの基礎です。 CNNには別のベースレイヤーがあります-これはいわゆるプーリングレイヤーです。

それを説明する最も簡単な方法は、最大プーリングです。 したがって、既に知られている畳み込み層では、フィルター行列は固定されており、単一である(つまり、乗算しても入力データに影響しない)と想像してください。 そして、すべての乗算結果(条件に応じた入力データ)を合計する代わりに、単純に最大要素を選択します。 つまり、ウィンドウ全体から最も強度の高いピクセルを選択します。 これは最大プーリングです。 もちろん、関数の代わりに、最大値は別の算術(またはさらに複雑な)関数です。

ソース:cs231n

このテーマの詳細については、Chris Olahの投稿をお勧めします。

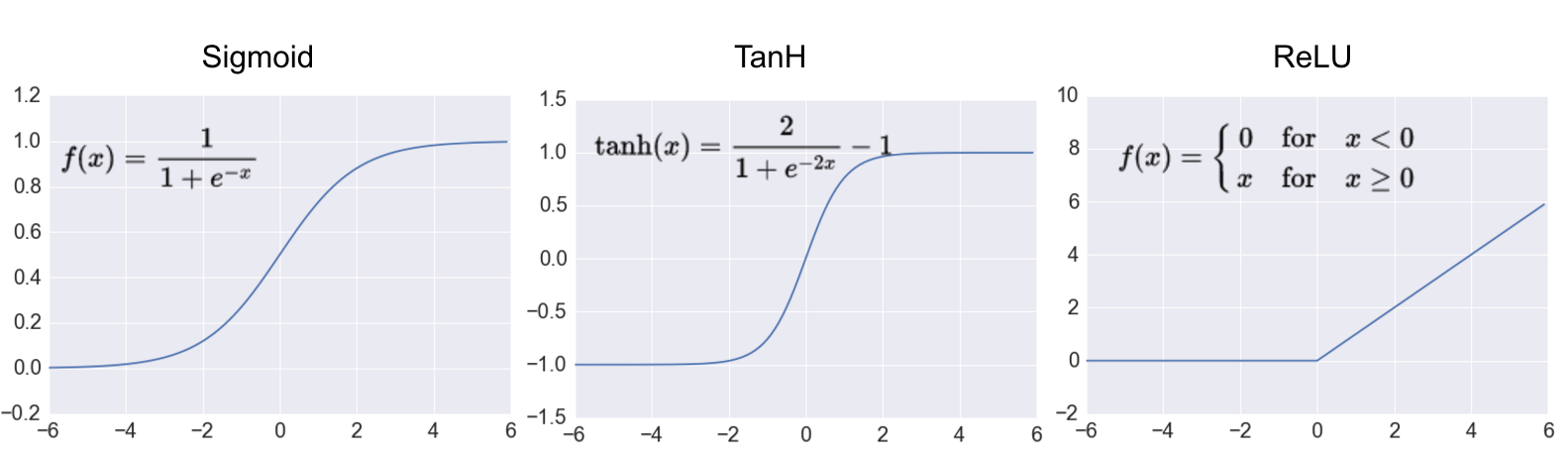

上記はすべて良好ですが、非線形性がなければ、ニューラルネットワークは私たちにとって必要な普遍的な近似器の特性を持ちません。 したがって、私はそれらについていくつかの言葉を言わなければなりません。 リカレントで完全に接続されたネットワークでは、シグモイドや双曲線正接などの非線形性がボールを支配します。

出所

これらは優れた非線形の滑らかな関数ですが、CNNでボールを支配したものと比較して、かなりの計算が必要です:ReLU-Rectified Linear Unit。 ロシア語では、ReLUは通常、線形フィルターと呼ばれます(単語フィルターを使用するのにまだ疲れていませんか?)。 これは、滑らかではないことに加えて、最も単純な非線形関数です。 しかし、その後、それは1つの基本操作で計算され、計算フレームワークの開発者はそれを非常に好みます。

さて、あなたと私はすでに畳み込みニューラルネットワーク、ビジョンの仕組みなどについて説明しました。 しかし、歌詞はどこですか、それとも恥知らずにあなたを欺いたのですか? いいえ、私はあなたをだましませんでした。

テキストへの畳み込みの適用

この図は、CNNを使用してテキストを操作する方法をほぼ完全に説明しています。 はっきりしない 正しくしましょう。 まず最初に、質問は次のとおりです。どこからマトリックスを取得するのか。 CNNは行列で動作しますか? ここで少し戻って、埋め込みとは何かを覚えておく必要があります(これについては別の記事があります)。

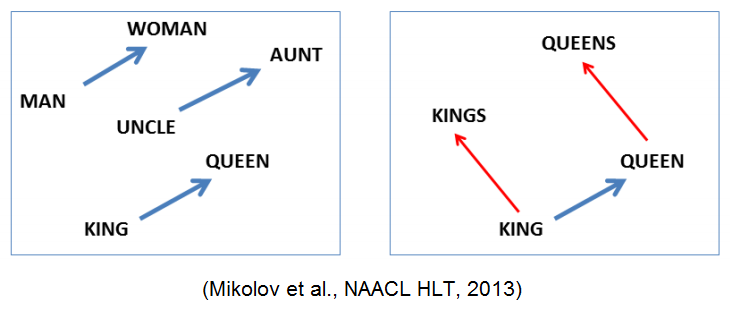

要するに、埋め込みとは、ある多次元空間の点をオブジェクト、この場合は単語にマッピングすることです。 そのような埋め込みでおそらく最もよく知られている例は、Word2Vecです。 ところで、

word2vec(“king”) - word2vec(“man”) + word2vec(“woman”) ~= word2vec(“queen”)

ようなセマンティックプロパティがあります。 したがって、テキスト内の各単語に埋め込みを行い、すべてのベクトルを行に配置して、目的のマトリックスを取得します。

次のステップでは、マトリックスは良好で、絵のように見えることもあります-同じ2次元です。 かどうか? 待って、写真にもっとチャンネルがあります。 画像マトリックスには、幅、高さ、チャンネルの3つの次元があります。 そしてここに? そして、ここには幅のみがあります(セクションのタイトル画像では、表示の便宜上マトリックスが転置されます)-これは文中のトークンのシーケンスです。 そして-いいえ、高さではなく、チャンネル。 チャンネルが選ばれる理由 単語の埋め込みは完全に意味があるため、個々のディメンションは何も教えません。

さて、マトリックスを計算し、畳み込みについてさらに詳しく説明しました。 畳み込みは1つの軸(幅)にのみ沿って進むことができます。 したがって、標準の畳み込みと区別するために、1次元(1D畳み込み)と呼ばれます。

そして今、神秘的なMax Over Time Poolingを除いて、ほとんどすべてが明確になっています。 これはどんな獣ですか? これは上記で既に説明した最大プーリングであり、一度にシーケンス全体に適用されます(つまり、ウィンドウの幅はマトリックスの幅全体に等しくなります)。

テキスト用の畳み込みニューラルネットワークの使用例

畳み込みニューラルネットワークは、ピースまたはシーケンス全体を確認し、これから何らかの結論を出す必要がある場合に適しています。 つまり、これらは、たとえば、スパムの検出、調性の分析、名前付きエンティティの抽出などのタスクです。 記事の構文解析は難しい場合があります。ニューラルネットワークに精通している場合は、このセクションをスキップできます。

[2]で、Yoon Kimは、CNNが異なるデータセットのオファーを分類するのに適していることを示しています。 上記のセクションを説明するために使用される写真は、彼の作品からのものです。 Word2Vecで動作しますが、文字を直接使用することもできます。

[3]では、著者は文字に直接基づいてテキストを分類し、学習プロセスでの埋め込みを学習します。 大規模なデータセットでは、単語を処理するネットワークよりも優れた結果を示しました。

畳み込みニューラルネットワークには、RNNと比較して大きな欠点があります-固定サイズの入力でのみ機能します(ネットワーク内の行列のサイズは操作中に変更できないため)。 しかし、上記の研究の著者[1]はこの問題を解決することができました。 そのため、この制限は削除されました。

[4]では、著者は文字に直接基づいてテキストを分類します。 70文字のセットを使用して、各文字をワンホットベクトルとして表し、1014文字の固定テキスト長を設定しました。 したがって、テキストはサイズ70x1014のバイナリマトリックスで表されます。 ネットワークは単語についての考えを持たず、それらを文字の組み合わせと見なし、事前に訓練されたWord2Vecベクトルの場合のように、単語の意味的近接性に関する情報はネットワークに提供されません。 ネットワークは、1d conv、max-poolingレイヤー、2つの完全に接続されたドロップアウトレイヤーで構成されています。 大規模なデータセットでは、単語を処理するネットワークよりも優れた結果を示しました。 さらに、このアプローチにより、前処理ステップが大幅に簡素化され、モバイルデバイスでの使用に貢献する可能性があります。

別の研究[5]では、著者はコンピュータービジョンのベストプラクティスを使用して、NLPでのCNNの適用を改善しようとしています。 近年のコンピュータービジョンの主な傾向は、ネットワークの深さと、互いに隣接していない層を接続するいわゆるスキップリンク(ResNetなど)の追加です。 著者は、同じ原則がNLPにも適用されることを示し、16次元埋め込みの文字に基づいてCNNを構築し、ネットワークで調査しました。 異なる深さ(9、17、29、49の変換層)のネットワークをトレーニングし、スキップリンクを実験して、それらが結果にどのように影響するかを調べました。 彼らは、ネットワークの深さを増やすと選択したデータセットの結果が改善されるが、深すぎるネットワーク(49層)のパフォーマンスは中程度の深さ(29層)よりも低いと結論付けました。 スキップリンクを使用すると、49層のネットワーク結果が改善されましたが、29層のネットワークインデックスを超えることはありませんでした。

コンピュータービジョンにおけるCNNのもう1つの重要な機能は、1つの大きなデータセット(典型的な例はImageNet)でトレーニングされたネットワークウェイトを他のコンピュータービジョンタスクで使用できることです。 [6]では、著者は、ワード埋め込みを使用したCNNを使用してテキストを分類するタスクにおけるこれらの原則の適用可能性を調べています。 ネットワークの特定の部分(埋め込み、コンバーレイヤー、完全に接続されたレイヤー)の転送が、選択したデータセットの分類結果にどのように影響するかを研究します。 彼らは、NLPタスクでは、ネットワークが事前にトレーニングされたソースのセマンティックな近接が重要な役割を果たしている、つまり、映画レビューでトレーニングされたネットワークが別の映画レビューデータセットでうまく機能すると結論付けています。 さらに、彼らは単語に同じ埋め込みを使用すると転送の成功が増加し、レイヤーをフリーズせずに、ターゲットデータセットでレイヤーをトレーニングすることを推奨していることに注意します。

実用例

CNNで感情分析を行う方法を実際に見てみましょう。 Kerasについての記事で同様の例を見てきたので、私はあなたに送るすべての詳細について、ここでは理解すべき重要な機能のみを検討します。

まず、Kequ Sequenceコンセプトが必要になります。 実際、これはKerasにとって便利な形式のシーケンスです。

x_train = tokenizer.texts_to_sequences(df_train["text"]) x_test = tokenizer.texts_to_sequences(df_test["text"]) x_val = tokenizer.texts_to_sequences(df_val["text"])

ここで、

text_to_sequences

は、a)トークン化、つまり文字列をトークンに分割し、b)各トークンをディクショナリ内の番号で置き換えることにより、テキストを整数のシーケンスに変換する関数です。 (この例の辞書はプリコンパイルされています。完全なラップトップでコンパイルするためのコード。)

次に、結果のシーケンスを整列する必要があります-思い出すように、CNNは可変テキスト長の操作方法をまだ知らず、これはまだ産業利用に至っていません。

x_train = pad_sequences(x_train, maxlen=max_len) x_test = pad_sequences(x_test, maxlen=max_len) x_val = pad_sequences(x_val, maxlen=max_len)

その後、すべてのシーケンスは切り捨てられるか、長さが

max_len

までゼロが埋め込まれます。

そして今、実際に最も重要なのはモデルのコードです:

model = Sequential() model.add(Embedding(input_dim=max_words, output_dim=128, input_length=max_len)) model.add(Conv1D(128, 3)) model.add(Activation("relu")) model.add(GlobalMaxPool1D()) model.add(Dense(num_classes)) model.add(Activation('softmax'))

最初のレイヤーは

Embedding

、整数(実際には、単位の場所が辞書内の単語の数に対応するワンホットベクトル)を密なベクトルに変換します。 この例では、埋め込みコードのサイズ(ベクトルの長さ)は128、辞書の単語の数は

max_len

、シーケンスの単語の数は

max_len

です。これは、上記のコードから既にわかっています。

埋め込み後は1次元の畳み込み層

Conv1D

です。 その中のフィルターの数は128であり、フィルターのウィンドウの幅は3です。アクティベーションは明確でなければなりません-これはReLUのお気に入りです。

ReLUの後、

GlobalMaxPool1D

レイヤーが登場します。 この場合の「グローバル」とは、着信シーケンスの全長に沿って取得されることを意味します。つまり、前述の最大時間プーリングとは異なります。 ところで、なぜOver Timeと呼ばれるのですか? 単語の順序は自然な順序であるため、一部の単語は音声/テキストの流れの早い段階で、つまり時間の早い段階で到着します。

最終的に得たモデルは次のとおりです。

画像に興味深い特徴があります。畳み込み層の後、シーケンスの長さは40ではなく38になりました。なぜですか? 私たちは話をせず、パディングを使用しなかったため、Svetaがそれを超えることができるように、元のマトリックスにデータを事実上「追加」できる技術です。 そして、これがないと、長さが3で、1に等しいステップのたたみ込みは、幅40のマトリックスに沿って38ステップしか作成できません。

さて、結果として何が得られましたか? 私のテストでは、この分類子の品質は0.57でしたが、もちろんそれほどではありません。 しかし、少し努力すれば、私の結果を簡単に改善できます。 どうぞ

PS:この記事をEvgeny Vasiliev somesnmとBulat Suleymanov khansuleymanに書いてくれてありがとう。

文学

[1] Bai、S.、Kolter、JZ、およびKoltun、V。(2018)。 シーケンスモデリングのための一般的な畳み込みおよびリカレントネットワークの経験的評価。 arxiv.org/abs/1803.01271

[2] Kim、Y.(2014)。 文分類のための畳み込みニューラルネットワーク。 自然言語処理の経験的方法に関する2014年会議(EMNLP 2014)、1746–1751の議事録。

[3] Heigold、G.、Neumann、G.、およびvan Genabith、J.(2016)。 形態学的に豊富な言語の文字からの神経形態学的タグ付け。 arxiv.org/abs/1606.06640

[4]テキスト分類のための文字レベルの畳み込みネットワーク。 チャン・ジャン、ジャンボ・チャオ、ヤン・ルクンarxiv.org/abs/1509.01626

[5]テキスト分類のための非常に深い畳み込みネットワーク。 コネウ、Hシュウェンク、Lバロー、Yレクンarxiv.org/abs/1606.01781

[6]畳み込みニューラルネットワークを使用したテキスト分類のための転移学習の実務者向けガイド。 T Semwal、G Mathur、P Yenigalla、SB Nair arxiv.org/abs/1801.06480