物語

生成モデリングには、未計算の事後分布の近似が含まれます。 このため、差別モデルをトレーニングするために開発された最も効果的な方法は、生成モデルでは機能しません。 この問題を解決するための既存の方法は計算が難しく、主に拡張性に乏しいマルコフ連鎖モンテカルロ法の使用に基づいています。 したがって、生成モデルをトレーニングするには、 確率的勾配降下(SGD)や逆伝播などのスケーラブルな手法に基づく方法が必要でした。 そのような方法の1つは、Generative Adversarial Networks(GAN)です。 GANは2014年にこの記事で初めて提案されました 。 高レベルのこのモデルは、互いに競合する2つのサブモデルとして説明できます。これらのモデルの1つ(ジェネレーター)は、2番目のサブモデル(差別者)を欺く意味で学習しようとしています。 これを行うために、ジェネレーターはランダムなオブジェクトを生成し、弁別器はこれらの生成されたオブジェクトをトレーニングセットの実際のオブジェクトと区別しようとします。 学習プロセスでは、ジェネレーターがサンプルにますます類似したオブジェクトを生成し、弁別者がそれらを実際のオブジェクトと区別することがますます困難になります。 したがって、ジェネレータは、たとえば人間の顔の写真の分布など、何らかの複雑な分布からオブジェクトを生成する生成モデルに変わります。

モデル

まず、必要な用語を紹介します。 を通して

オブジェクトのスペースを示します。 たとえば、写真

オブジェクトのスペースを示します。 たとえば、写真  ピクセル。 ある確率空間で

ピクセル。 ある確率空間で  ベクトル確率変数

ベクトル確率変数  密度を持つ確率分布

密度を持つ確率分布  そのようなスペースのサブセット

そのようなスペースのサブセット  その上

その上  ゼロ以外の値を取ります-これらは、たとえば、人間の顔の写真です。 マグニチュードの顔写真のランダムなiidサンプルが与えられます

ゼロ以外の値を取ります-これらは、たとえば、人間の顔の写真です。 マグニチュードの顔写真のランダムなiidサンプルが与えられます  。 さらに、補助スペースを定義します

。 さらに、補助スペースを定義します  およびランダム変数

およびランダム変数  密度を持つ確率分布

密度を持つ確率分布  。

。  -弁別器機能。 この関数は、入力としてオブジェクトを取ります。

-弁別器機能。 この関数は、入力としてオブジェクトを取ります。  (この例では、適切なサイズの画像)および入力画像が人間の顔の写真である確率を返します。

(この例では、適切なサイズの画像)および入力画像が人間の顔の写真である確率を返します。  -ジェネレーター機能。 彼女は意味を取ります

-ジェネレーター機能。 彼女は意味を取ります  空間オブジェクトを生成します

空間オブジェクトを生成します  、つまり、私たちの場合、写真です。

、つまり、私たちの場合、写真です。

すでに完璧な識別器を持っているとします

。 どんな例でも

。 どんな例でも  この例が特定のサブセットに属する真の確率を提供します

この例が特定のサブセットに属する真の確率を提供します  サンプルの取得元

サンプルの取得元  。 確率的言語で弁別器を欺く問題を再定式化すると、生成された例を使用して理想的な弁別器が与える確率を最大化する必要があることがわかります。 したがって、最適な発電機は

。 確率的言語で弁別器を欺く問題を再定式化すると、生成された例を使用して理想的な弁別器が与える確率を最大化する必要があることがわかります。 したがって、最適な発電機は  。 以来

。 以来  単調に増加する関数であり、引数の極値の位置を変更しません。この式を次のように書き換えます。

単調に増加する関数であり、引数の極値の位置を変更しません。この式を次のように書き換えます。  これは将来便利になります。

これは将来便利になります。

現実には、通常、理想的な識別器はなく、見つけなければなりません。 弁別器のタスクは、理想的な弁別器の代わりにジェネレーターをトレーニングする信号を提供することであるため、現在のジェネレーターによって生成された例から実際の例を理想的に分離する弁別器を取るだけで十分です。 サブセットでのみ完璧

そこから現在のジェネレーターによってサンプルが生成されます。 この問題は、そのような関数の検索として再定式化できます

そこから現在のジェネレーターによってサンプルが生成されます。 この問題は、そのような関数の検索として再定式化できます  、例を実物または生成物として正しく分類する可能性を最大化します。 これは、バイナリ分類問題と呼ばれ、この場合、無限のトレーニングセットがあります:有限数の実例と潜在的に無限数の生成された例です。 各例にはラベルがあります。それが本物か生成物かです。 最初の記事では、最尤法を使用した分類問題の解決策について説明しました。 私たちのケースのために書きましょう。

、例を実物または生成物として正しく分類する可能性を最大化します。 これは、バイナリ分類問題と呼ばれ、この場合、無限のトレーニングセットがあります:有限数の実例と潜在的に無限数の生成された例です。 各例にはラベルがあります。それが本物か生成物かです。 最初の記事では、最尤法を使用した分類問題の解決策について説明しました。 私たちのケースのために書きましょう。

サンプル

。 分布密度を決定します

。 分布密度を決定します  それから

それから  差別者の再定式化です

差別者の再定式化です  クラス確率

クラス確率  (実際の例)クラスの分布として

(実際の例)クラスの分布として  。 以来

。 以来  、この定義は正しい確率密度を設定します。 次に、最適な識別器は次のように見つけることができます。

、この定義は正しい確率密度を設定します。 次に、最適な識別器は次のように見つけることができます。

要因をグループ化する

そして

そして  :

:

そして、サンプルサイズが無限大になると、次のようになります。

合計で、次の反復プロセスが得られます。

- 任意のイニシャルを設定

。

。 - 始まる

番目の反復

番目の反復  。

。 - 現在の発電機に最適な弁別器を探しています。

。

。 - 最適な識別器を使用してジェネレーターを改善します。

。 電流発生器の近くにいることが重要です。 現在のジェネレーターから離れると、弁別器は最適でなくなり、アルゴリズムは真でなくなります。

。 電流発生器の近くにいることが重要です。 現在のジェネレーターから離れると、弁別器は最適でなくなり、アルゴリズムは真でなくなります。 - ジェネレーターをトレーニングするタスクは、次の場合に解決されたと見なされます。

のために

のために  。 プロセスが収束しない場合は、段落(2)の次の反復に進みます。

。 プロセスが収束しない場合は、段落(2)の次の反復に進みます。

元の記事では、このアルゴリズムは、ある意味、弁別器と発生器の間のミニマックスゲームを定義する1つの式にまとめられています。

両方の機能

ニューラルネットワークとして表すことができます。

ニューラルネットワークとして表すことができます。  、その後、最適な関数を検索するタスクは、パラメーターによる最適化の問題に還元され、従来の方法を使用して解決できます:バックプロパゲーションとSGD。 さらに、ニューラルネットワークは機能の普遍的な近似であるため、

、その後、最適な関数を検索するタスクは、パラメーターによる最適化の問題に還元され、従来の方法を使用して解決できます:バックプロパゲーションとSGD。 さらに、ニューラルネットワークは機能の普遍的な近似であるため、  任意の確率分布を近似することができ、分布の選択の問題を取り除きます

任意の確率分布を近似することができ、分布の選択の問題を取り除きます  。 何らかの合理的なフレームワーク内で継続的に配布できます。 例えば

。 何らかの合理的なフレームワーク内で継続的に配布できます。 例えば  または

または  。 このアルゴリズムと収束の正確さ

。 このアルゴリズムと収束の正確さ  に

に  かなり一般的な仮定の下で、元の記事で証明されています。

かなり一般的な仮定の下で、元の記事で証明されています。

正規分布パラメーターを見つける

数学がわかったので、今度はその仕組みを見てみましょう。 言いましょう

、つまり 一次元の問題を解決します。

、つまり 一次元の問題を解決します。  。 線形ジェネレーターを使用しましょう

。 線形ジェネレーターを使用しましょう  どこで

どこで  。 識別器は、最後にバイナリ分類器を備えた完全に接続された3層ニューラルネットワークになります。 この問題の解決策は

。 識別器は、最後にバイナリ分類器を備えた完全に接続された3層ニューラルネットワークになります。 この問題の解決策は  つまり、

つまり、  。 Tensorflowを使用して、この問題の数値解をプログラムしてみましょう。 完全なコードはここにありますが、重要なポイントのみがこの記事で説明されています。

。 Tensorflowを使用して、この問題の数値解をプログラムしてみましょう。 完全なコードはここにありますが、重要なポイントのみがこの記事で説明されています。

最初に設定するのは入力サンプルです。

。 トレーニングはミニバッチで行われるため、一度に数値のベクトルを生成します。 さらに、サンプルは平均と標準偏差によってパラメーター化されます。

。 トレーニングはミニバッチで行われるため、一度に数値のベクトルを生成します。 さらに、サンプルは平均と標準偏差によってパラメーター化されます。

def data_batch(hparams): """ Input data are just samples from N(mean, stddev). """ return tf.random_normal( [hparams.batch_size, 1], hparams.input_mean, hparams.input_stddev)

ジェネレーターのランダム入力を設定しましょう

:

:

def generator_input(hparams): """ Generator input data are just samples from N(0, 1). """ return tf.random_normal([hparams.batch_size, 1], 0., 1.)

ジェネレーターを定義します。 2番目のパラメーターの絶対値を取得して、標準偏差の意味を指定します。

def generator(input, hparams): mean = tf.Variable(tf.constant(0.)) stddev = tf.sqrt(tf.Variable(tf.constant(1.)) ** 2) return input * stddev + mean

実際の例のベクトルを作成しましょう:

generator_input = generator_input(hparams) generated = generator(generator_input)

そして生成された例のベクトル:

generator_input = generator_input(hparams) generated = generator(generator_input)

次に、すべての例を識別器を通して実行してみましょう。 Tensorflowは両方の入力に同じパラメーターを使用するように要求される必要があるため、2つの異なる弁別子ではなく1つが必要であることを覚えておくことが重要です。

with tf.variable_scope("discriminator"): real_ratings = discriminator(real_input, hparams) with tf.variable_scope("discriminator", reuse=True): generated_ratings = discriminator(generated, hparams)

実際の例の損失関数は、ユニット(実際の例の識別器の予想される応答)と識別器の推定値の間のクロスエントロピーです。

loss_real = tf.reduce_mean( tf.nn.sigmoid_cross_entropy_with_logits( labels=tf.ones_like(real_ratings), logits=real_ratings))

偽の例での損失関数は、ゼロ(偽の例で予想される判別子の応答)と判別子の推定値の間のクロスエントロピーです。

loss_generated = tf.reduce_mean( tf.nn.sigmoid_cross_entropy_with_logits( labels=tf.zeros_like(generated_ratings), logits=generated_ratings))

判別損失関数は、実際の例と偽の例の損失の合計です。

discriminator_loss = loss_generated + loss_real

ジェネレーター損失関数は、ユニット(偽の例での望ましい識別器のエラー応答)と弁別器によるこれらの偽の例の推定値の間のクロスエントロピーです。

generator_loss = tf.reduce_mean( tf.nn.sigmoid_cross_entropy_with_logits( labels=tf.ones_like(generated_ratings), logits=generated_ratings))

オプションのL2正則化が弁別子損失関数に追加されます。

モデルトレーニングは、収束までのサイクルでの弁別器と生成器の順次トレーニングに縮小されます。

for step in range(args.max_steps): session.run(model.discriminator_train) session.run(model.generator_train)

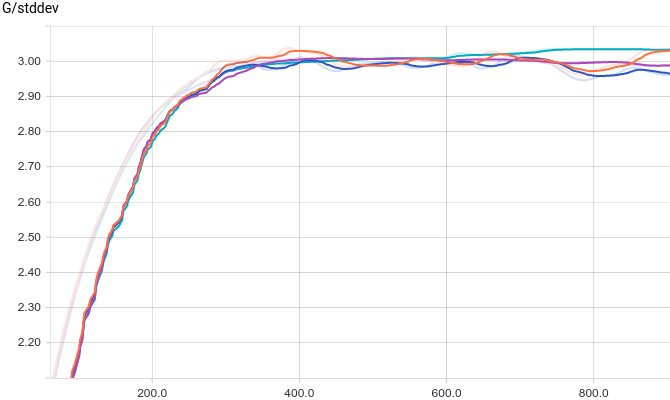

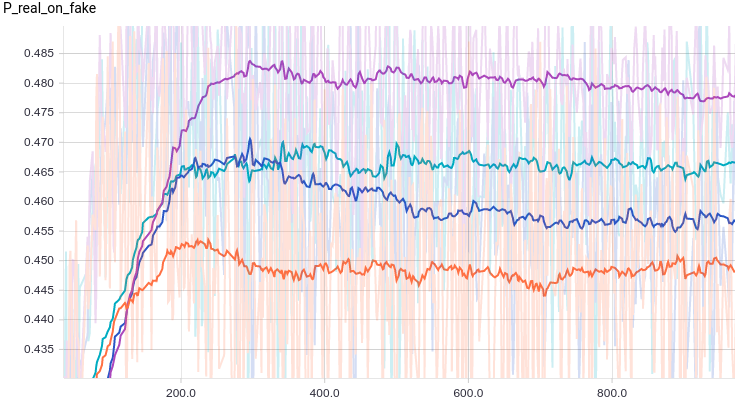

以下は、4つのディスクリミネーターモデルのグラフです。

- 3層ニューラルネットワーク。

- L2正規化による3層ニューラルネットワーク..

- ドロップアウト正則化を備えた3層ニューラルネットワーク。

- L2およびドロップアウト正則化を備えた3層ニューラルネットワーク。

図 1.識別器が実例を実として分類する確率。

図 2.生成された例の識別器による実数としての分類の確率。

4つのモデルはすべて、弁別器が生成するものにすばやく収束します

すべての入り口で。 ジェネレーターが解決する問題は単純であるため、モデル間にほとんど違いはありません。 グラフは、平均と標準偏差がデータ分布の値にすばやく収束することを示しています。

すべての入り口で。 ジェネレーターが解決する問題は単純であるため、モデル間にほとんど違いはありません。 グラフは、平均と標準偏差がデータ分布の値にすばやく収束することを示しています。

図 3.生成された分布の平均。

図 4.生成された分布の標準偏差。

以下は、学習プロセスにおける実際の例と生成された例の分布です。 トレーニングの終わりまでに生成された例は、実際の例とは実際上区別できません(Tensorboardが異なるスケールを選択したため、グラフ上で区別されますが、値を見ると同じです)。

図 5.実データの配布。 時間とともに変化しません。 トレーニングステップは垂直軸で遅れます。

図 6.実データの配布。 時間とともに変化しません。 トレーニングステップは垂直軸で遅れます。

モデルのトレーニングプロセスを見てみましょう。

図 7.モデルの学習プロセスの視覚化。 固定ガウス-実データの分布密度、移動ガウス-生成された例の分布密度、青い曲線は弁別器の結果、つまり 実例の可能性。

トレーニングの開始時の弁別器はデータを非常によく分離していることがわかりますが、生成された例の分布は実際の例の分布に文字通り「クリープ」します。 最後に、ジェネレータはデータを近似し、弁別器が定数になるようにします

タスクが収束します。

タスクが収束します。

正規分布の混合の近似I

交換してみましょう

に

に  これにより、ソースデータのマルチモーダル分布をシミュレートします。 このモデルでは、実際の例を生成するためのコードのみを変更する必要があります。 正規分布したランダム変数を返す代わりに、いくつかの混合物を返します。

これにより、ソースデータのマルチモーダル分布をシミュレートします。 このモデルでは、実際の例を生成するためのコードのみを変更する必要があります。 正規分布したランダム変数を返す代わりに、いくつかの混合物を返します。

def data_batch(hparams): count = len(hparams.input_mean) componens = [] for i in range(count): componens.append( tf.contrib.distributions.Normal( loc=hparams.input_mean[i], scale=hparams.input_stddev[i])) return tf.contrib.distributions.Mixture( cat=tf.contrib.distributions.Categorical( probs=[1./count] * count), components=componens) .sample(sample_shape=[hparams.batch_size, 1])

以下は、前の実験と同じモデルのグラフですが、2つのモードのデータのグラフです。

図 8.識別器が実例を実として分類する確率。

図 9.生成された例の識別器による実数としての分類の確率。

正規化されたモデルは、不規則化されたモデルよりもはるかに優れていることがわかります。 ただし、モデルに関係なく、ジェネレーターが弁別器をそれほどうまく欺かないことは明らかです。 それがなぜ起こったのかを理解しましょう。

図 10.生成された分布の平均。

図 11.生成された分布の標準偏差。

最初の実験のように、ジェネレーターはデータを正規分布で近似します。 品質が低下する理由は、データが2つの正規分布の混合物からサンプリングされるため、データを正規分布で正確に近似できないためです。 混合物のモードはゼロに関して対称であり、4つのモデルすべてが、ゼロに近い中心と十分に大きな分散を持つ正規分布によってデータを近似していることがわかります。 実際の例と偽の例の分布を見て、何が起こるかを理解しましょう。

図12.実際のデータの分布。 時間とともに変化しません。 トレーニングステップは垂直軸で遅れます。

図13. 4つのモデルから生成されたデータの分布。 トレーニングステップは垂直軸で遅れます。

これがモデル学習プロセスの流れです:

図 14.モデルの学習プロセスの視覚化。 固定ガウス混合は実データの分布密度、移動ガウスは生成された例の分布密度、青い曲線は識別器の結果、つまり 実例の可能性。

このアニメーションは、上記で検討した事例を詳細に示しています。 ジェネレーターは、十分な表現力を持たず、ガウス分布のみでデータを近似する機能を備えているため、両方のデータ分布モードをカバーしようとして、広いガウス分布に広がります。 その結果、ジェネレーターは、ジェネレーターカーブとソースデータの下の領域が近い場所、つまりこれらのカーブの交点でのみ、確実に弁別器を欺きます。

ただし、これが唯一の可能なケースではありません。 ジェネレータの初期近似がキャプチャしないように、右モードを少し右に移動しましょう。

図 15.モデルの学習プロセスの視覚化。 固定ガウス混合は実データの分布密度、移動ガウスは生成された例の分布密度、青い曲線は識別器の結果、つまり 実例の可能性。

この場合、発電機が左の分配モードを近似しようとすることが最も有益であることがわかります。 これが発生すると、ジェネレーターは左モードをキャプチャしようとします。 アニメーションの後半では、ジェネレーターの標準偏差の振動のように見えます。 しかし、弁別器はジェネレータを「ロック」し、左モードをキャプチャするために、学習速度が不十分であるためにできない高損失機能の障壁を克服する必要があるため、これらの試みはすべて失敗します。 この効果は、モード崩壊と呼ばれます。

上記の2つの例では、データの初期分布を表現するのにジェネレーターが十分に強力でない場合に発生する2つのタイプの問題を見ました。モード平均化、ジェネレーターが分布全体を近似するが、どこでも十分に悪い場合。 ジェネレータがモードのサブセットを学習し、学習していないモードがモードに影響を与えない場合、モードの崩壊。

これらの問題の両方が差別につながるという事実に加えて

、それらはまた、生成モデルの品質の低下につながります。 最初の問題は、ジェネレーターがすべきではない「間」モードの例を提供するという事実につながり、2番目の問題は、ジェネレーターが一部のモードのみから例を提供するという事実につながり、それによって初期データ分布の豊富さを減らします。

、それらはまた、生成モデルの品質の低下につながります。 最初の問題は、ジェネレーターがすべきではない「間」モードの例を提供するという事実につながり、2番目の問題は、ジェネレーターが一部のモードのみから例を提供するという事実につながり、それによって初期データ分布の豊富さを減らします。

正規分布の混合の近似II

前のセクションで弁別器を完全に欺くことができなかった理由は、ジェネレーターの自明性であり、単純に線形変換を行いました。 次に、完全に接続された3層ニューラルネットワークをジェネレーターとして使用してみましょう。

def generator(self, input, hparams): # 256 . input_size = 1 features = 256 weights = tf.get_variable( "weights_1", initializer=tf.truncated_normal( [input_size, features], stddev=0.1)) biases = tf.get_variable( "biases_1", initializer=tf.constant(0.1, shape=[features])) hidden_layer = tf.nn.relu(tf.matmul(input, weights) + biases) # 256 . features = 256 weights = tf.get_variable( "weights_2", initializer=tf.truncated_normal( [input_size, features], stddev=0.1)) biases = tf.get_variable( "biases_2", initializer=tf.constant(0.1, shape=[features])) hidden_layer = tf.nn.relu(tf.matmul(input, weights) + biases) # , . output_size = 1 weights = tf.get_variable( "weights_out", initializer=tf.truncated_normal( [features, output_size], stddev=0.1)) biases = tf.get_variable( "biases_out", initializer=tf.constant(0.1, shape=[output_size])) return tf.matmul(hidden_layer, weights) + biases

トレーニングスケジュールを見てみましょう。

図 16.実例の実例としての識別器による分類の確率。

図 17.生成されたサンプルの識別器による実数としての分類の確率。

多数のパラメーターが原因で、トレーニングのノイズが大きくなっていることがわかります。 すべてのモデルの弁別器は、約の結果に収束します

しかし、この時点で不安定になります。 ジェネレーターの形状を見てみましょう。

しかし、この時点で不安定になります。 ジェネレーターの形状を見てみましょう。

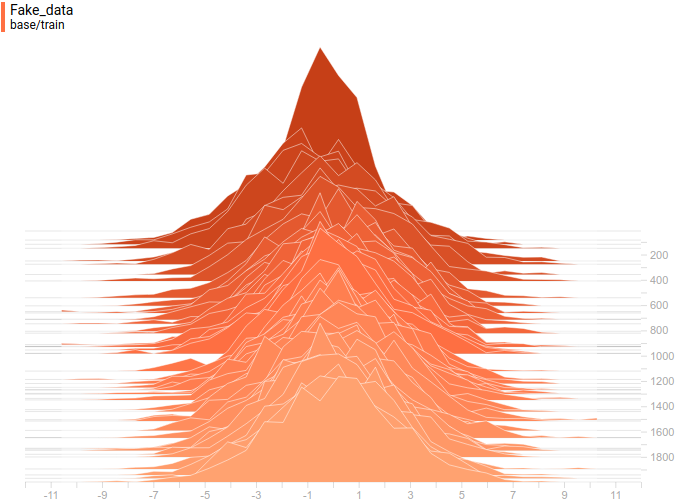

図18.実際のデータの分布。 時間とともに変化しません。 トレーニングステップは垂直軸で遅れます。

図19. 4つのモデルから生成されたデータの分布。 トレーニングステップは垂直軸で遅れます。

ジェネレーターの分布は、データの分布とは一致しませんが、非常に似ていることがわかります。 最も正規化されたモデルが再び最適であることが証明されました。 彼女はデータ配布モードとほぼ一致する2つのモードを学習したことがわかります。 ピークサイズもあまり正確ではありませんが、データの分布に近似しています。 したがって、ニューラルネットワークジェネレーターは、マルチモーダルデータ分布を学習できます。

これがモデル学習プロセスの流れです:

図 20.近接モードを使用したモデルの学習プロセスの視覚化。 固定ガウス混合は実データの分布密度、移動ガウスは生成された例の分布密度、青い曲線は識別器の結果、つまり 実例の可能性。

図 21.遠隔モードを使用したモデルの学習プロセスの視覚化。 固定ガウス混合は実データの分布密度、移動ガウスは生成された例の分布密度、青い曲線は識別器の結果、つまり 実例の可能性。

これら2つのアニメーションは、前のセクションのデータ分布に関するトレーニングを示しています。 これらのアニメーションから、多くのパラメーターを備えた十分に大きなジェネレーターを使用すると、大まかにでもマルチモーダル分布を近似できるため、前のセクションの問題が不十分に複雑なジェネレーターに起因することを間接的に確認できることがわかります。 これらのアニメーションの識別器は、正規分布のパラメーターを見つけるセクションよりもはるかにノイズが多いですが、それにもかかわらず、トレーニングの終わりまでに、ノイズの多い水平線に似始めます

。

。

まとめ

GANは、この分布からサンプリングすることによってのみ、任意の分布を近似するためのモデルです。 この記事では、正規分布のパラメーターを検索する簡単な例と、ニューラルネットワークによる双峰分布を近似するより複雑な例で、モデルがどのように機能するかを詳しく調べました。 両方の問題は高い精度で解決されたため、ジェネレーターのかなり複雑なモデルを使用する必要がありました。 次の記事では、これらのモデル例から、画像分布の例を使用して複雑な分布からサンプルを生成する実際の例に移ります。

謝辞

テキストをレビューしてくれたOlga TalanovaとRuslan Loginに感謝します。 画像とアニメーションの準備に協力してくれたRuslan Loginに感謝します。 この記事のレイアウトを手伝ってくれたAndrei Tarashkevichに感謝します。