12月18日、モスクワ物理技術研究所のニューラルシステムとディープトレーニングの研究所からのDeepHack.Babelハッカソンへの参加のための選択ツアーが始まりました。 研究コミュニティで人気を博しており、すでに商用製品で使用されているニューラルネットワーク機械翻訳に重点が置かれます。 さらに、一般に受け入れられている慣行に反して、非並列データで機械翻訳システムをトレーニングする必要があります。つまり、機械学習の観点から、教師は関与しません。 まだ登録を検討している場合、なぜこれが必要なのかを説明します。

以前は何でしたか

最近まで(ニューラルネットワークが普及する前)、機械翻訳システムは本質的に翻訳オプションのテーブルでした。ソース言語の各単語またはフレーズについて、ターゲット言語への多数の可能な翻訳が示されていました。 これらの翻訳は、単語と表現の同時発生の頻度を分析することにより、多数の並行テキスト(互いに正確に翻訳された2つの言語のテキスト)と区別されました。 行を翻訳するには、個々の単語やフレーズの翻訳を組み合わせて文章にし、もっともらしいオプションを選択する必要がありました。

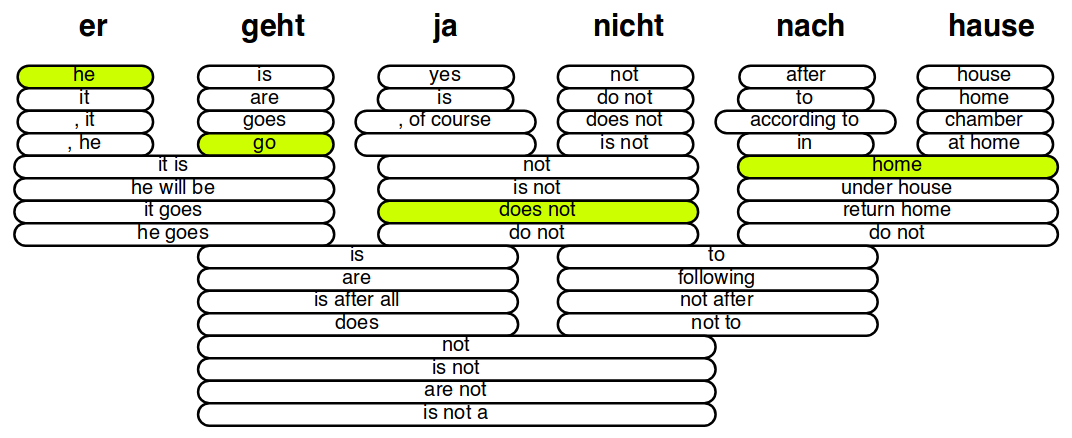

「er geht ja nicht nach hause」(「彼は家に帰らない」)という文の個々の単語やフレーズを英語に翻訳するオプション。 オプションの品質は、たとえば、確率p( e | f )およびp( f | e )などの属性の値の加重合計によって決まります。ここで、 eおよびfはソースおよびターゲットのフレーズです。 適切な翻訳に加えて、フレーズの順序も選択する必要があります。 フィリップケーンプレゼンテーションからのイラスト。

ここで、機械翻訳システムの2番目のコンポーネント、つまり言語の確率モデルが登場しました。 古典的なバージョン-n - gramの言語モデル -変換テーブルのように、単語の共同出現に基づいていますが、今回は特定の接頭辞( n個の前の単語)の後の単語に出会う確率についてです。 生成された文の各単語の尤度が高いほど(つまり、単語の選択により言語モデルを「驚かせる」ほど)、自然に聞こえ、これが正しい翻訳である可能性が高くなります。 このような手法は、一見制限はあるものの、非常に高品質の翻訳を実現することを可能にしました。特に、言語の確率的モデルは単一言語(並列ではない)コーパスでのみ学習されるため、非常に大量のデータでトレーニングできます。そして、彼女はあなたがどのように話すことができるかについてよく知らされますが、どのようにされないでしょう。

ニューラルネットワークの出現で何が変わったのか

ニューラルネットワークは機械翻訳へのアプローチを変えました。 現在、翻訳は、文全体をベクトル表現(この文の一般的な意味を言語に依存しない形式で含む)に「エンコード」してから、この表現をターゲット言語の単語に「デコード」することによって行われます。 これらの変換は、多くの場合、オブジェクトのシーケンス(この場合は単語のシーケンス)を処理するために特別に設計されたリカレントニューラルネットワークを使用して実行されます。

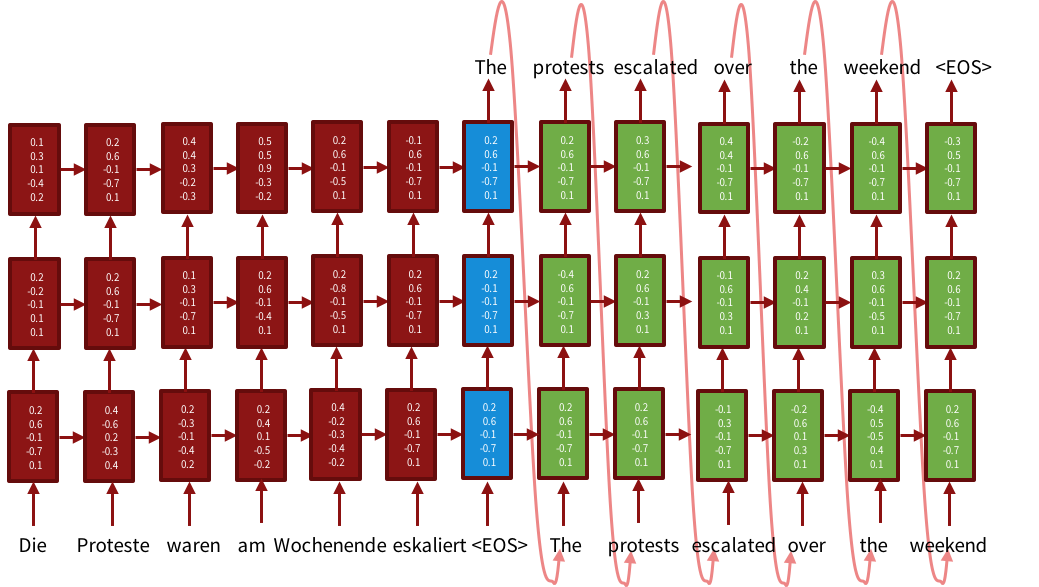

3層モデルのエンコーダー/デコーダーのスキーム。 エンコーダー(赤色の部分)は文の表現を生成します。各ステップで、新しい入力単語と先に読んだ単語の表現を組み合わせます。 青色の部分は、提案全体のプレゼンテーションです。 デコーダー(緑色の部分)は、元の文と以前に生成された単語の表現に基づいて、出力言語で単語を発行します。 ACL-2016のニューラルネットワーク機械翻訳チュートリアルから抜粋した図。

各ステップで、このようなニューラルネットワークは、新しい入力単語(より正確には、そのベクトル表現)と以前の単語に関する情報を組み合わせます。 ニューラルネットワークのパラメーターは、各ステップで「忘れる」量と「記憶する」量を決定するため、文全体の表示には、そこから最も重要な情報が含まれます。 エンコーダー-デコーダーアーキテクチャーは既に古典的なものになっています。たとえば、[1]で説明を読むことができます。

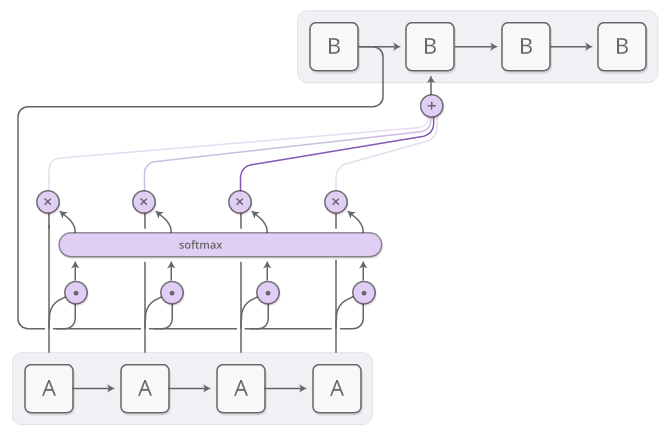

実際、このシステムの標準バージョンは期待どおりに機能しないため、優れた翻訳品質を得るには追加のトリックが必要です。 たとえば、通常のセルを含むリカレントネットワークは、勾配の爆発または減衰の影響を受けます(つまり、勾配はゼロまたは非常に大きな値に収束し、変化しなくなり、ネットワークの学習が不可能になります)-異なる構造のニューロン-LSTM [2]およびGRU [このために提案されました3]、各ステップで、どの情報を「忘れる」か、どの情報を渡すかを決定します。 長い文を読むとき、システムはそれらがどこから始まったかを忘れます-この場合、[4]で行われたように、文を最初と最後から読む双方向ネットワークを使用するのに役立ちます。 さらに、統計システムとの類推により、元の文の個々の単語とその翻訳との対応を明確に描くことが有用であることが判明しました-このために、他の問題ですでに使用されていた注意メカニズムが適用されました(機械翻訳への注意の適用は、たとえば、 [5]、注意の簡潔で簡単な説明がこの投稿にあります )。 これは、デコード(翻訳の生成)時に、システムがこのステップで元の文のどの単語を翻訳すべきかについての情報を受け取るという事実にあります。

エンコーダーデコーダーアーキテクチャーのアテンションメカニズム。 デコーダーの現在の状態(B)は、エンコーダーの各状態(A)と乗算されます-このようにして、入力ワードのどれが現時点でデコーダーに最も関連するかを判別します(乗算の代わりに、別の操作を使用して類似性を判別できます)。 次に、この乗算の結果は、softmax関数によって確率分布に変換されます。これは、デコーダの各入力語の重みを返します。 重み付きエンコーダー状態の組み合わせがデコーダーに供給されます。 クリス・オラーの投稿から取られたイラスト。

これらすべての追加手法を使用して、ニューラルネットワークでの機械翻訳は統計システムを確実に無効にします。たとえば、 機械翻訳システムの最後の競争で、ニューラルネットワークモデルはほとんどすべての言語ペアで最初になりました。 ただし、過去の統計モデルには、ニューラルネットワークにまだ転送できない機能があります-これは、大量の非並列データ(つまり、他の言語への翻訳がないデータ)を使用する機能です。

非並列データを使用する理由

ニューラルネットワークシステムがそれらがなくても非常に優れている場合、なぜ非並列データを使用するのでしょうか? 実際には、高品質には非常に大量のデータが必要であり、常に利用できるとは限りません。 ニューラルネットワークはトレーニングデータの量を要求していることが知られています。 非常に小さなデータセットでは、従来の方法(サポートベクターマシンなど)がニューラルネットワークをバイパスすることを簡単に確認できます。 機械翻訳には、最も人気のある言語ペア(英語Europeanヨーロッパの主要言語、英語中国語、英語ロシア語)の十分なデータがあり、そのような言語ペアのニューラルネットワークアーキテクチャは非常に良い結果を示しています。 しかし、並列データの提供が数百万未満の場合、ニューラルネットワークは役に立ちません。 並列データが豊富なそのような言語のペアはほとんどありませんが、非常に多くの言語、およびニュース、ブログ、ソーシャルネットワーク、政府機関の作品など、多数の言語で単一言語のテキストを利用できます-新しいコンテンツは絶えず生成されています。 これらのテキストはすべて、統計システムの改善に役立ったのと同様に、ニューラルネットワーク機械翻訳の品質を改善するために使用できますが、残念ながら、そのような技術はまだ開発されていません。

より正確には、単一言語テキストでニューラルネットワーク翻訳システムをトレーニングするいくつかの例があります。[6]では、エンコーダーデコーダーアーキテクチャと確率的言語モデルの組み合わせが説明され、[7]では、単一言語コーパスの欠落した翻訳がモデル自体によって生成されます。 これらの方法はすべて翻訳の品質を向上させますが、ニューラルネットワーク機械翻訳システムでの単一言語コーパスの使用はまだ一般的な慣行になっていません:トレーニングで非並列テキストを使用する方法はまだ明確ではありません。さまざまな言語のペア、さまざまなアーキテクチャなどに対応します。これらは、ハッカソンDeepHack.Babelで解決しようとする問題です。

非並列データとDeepHack.Babel

制御された実験の実施を試みます。参加者には非常に小さな並列データセットが与えられ、ニューラルネットワーク機械翻訳機を訓練し、単言語データを使用して品質を改善することが提案されます。 すべての参加者は同じ立場にあります:同じデータ、モデルのサイズとトレーニング時間に関する同じ制限-この方法により、参加者によって実装された方法のどれがより効果的であるかがわかり、非共通言語ペアの翻訳の品質を改善する方法を理解することに近づきます。 さまざまな複雑さのさまざまな程度の言語のいくつかのペアで実験を行い、さまざまなソリューションがどのように多用されるかをテストします。

さらに、統計的な翻訳では不可能と思われた、さらに野心的なタスク、つまり並列データなしの翻訳に近づきます。 多くの関連する問題はまだ解決されていませんが、平行テキストで翻訳を教えるための技術はすでに知られており、うまく機能しています。 同等のコーパス(共通のテーマと同様のコンテンツを持つテキストのペア)も機械翻訳で積極的に使用されます[8]-これにより、ウィキペディアなどのリソースを使用できます(異なる言語の対応する記事は単語ごとに一致しませんが、同じオブジェクトについて説明します) 。 しかし、テキストが互いに対応しているかどうかについてまったく情報がない場合はどうでしょうか? たとえば、特定の年の2つのニュース本文を異なる言語で分析する場合、同じイベントが議論されたことを確認できます(つまり、別の本文の1つの本文のほとんどの単語に対して翻訳があります)が、文間または少なくともテキスト間の対応を確立します追加情報がなければ、できません。

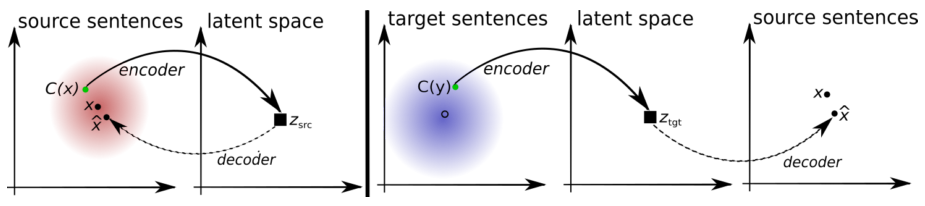

そのようなデータを使用することは可能ですか? これは空想科学小説のように思えますが、可能な科学文献にはすでにいくつかの例があります。たとえば、最近の出版物[9]では、オートエンコーダーのノイズ除去に基づいたシステムが説明されています。 Hackathonの参加者は、これらの方法を再現し、並行テキストでトレーニングされたシステムをバイパスすることができます。

並列データのない機械翻訳システムの動作原理。 自動エンコーダー(左):モデルは、歪んだバージョンから文を復元する方法を学習しています。 xは文、C(x)は歪んだバージョン、x̂は再構成です。 翻訳者(右):モデルは文を別の言語に翻訳することを学習します。 その入力では、前の反復からのモデルのバージョンによって生成された、歪んだ変換が生成されます。 モデルの最初のバージョンは、辞書(辞書)であり、これも並列データを使用せずにトレーニングされます。 2つのモデルの組み合わせにより、並列データでトレーニングされたシステムに匹敵する翻訳品質が実現します。 この図は記事[9]から引用したものです。

参加方法

ハッカソン予選の申し込みは、1月8日まで受け付けられます。 予選ラウンドのタスクは、英語からドイツ語への機械翻訳システムを教えることです。 データと方法にまだ制限はありません。参加者は、任意のケースと事前トレーニングされたモデルを使用し、好みに応じてシステムアーキテクチャを選択できます。 ただし、ITトピックに関する一連の提案でシステムがテストされることに注意してください。これには、関連するソースからのデータの使用が含まれます。 また、アーキテクチャに制限はありませんが、ハッカソンの主なタスクによりうまく対処するために、参加者は適格なタスクを完了すると、ニューラルネットワーク変換モデルに精通するものと想定されます。

システムが最高の翻訳品質(BLEUメトリック[10]で測定される)を示す50人がハッカソンに参加できます。 選択に合格しなかった人は怒ってはいけません-彼らはリスナーとしてハッカソンに参加できます:毎日、機械翻訳、機械学習、ワードプロセッシングの専門家による講義が開かれます。

書誌

- ニューラルネットワークを用いたシーケンス学習 。 I. Sutskever、O。Vinyals、QVLe。

- LSTM:サーチスペースオデッセイ K.グレフ、RKSrivastava、J.Koutník、BR Steunebrink、J.Schmidhuber。

- 統計的機械翻訳のためのRNNエンコーダー-デコーダーを使用したフレーズ表現の学習 。 K.Cho、Bv Merrienboer、C.Gulcehre、D.Bahdanau、F.Bougares、H.Schwenk、Y.Bengio。

- 位置合わせと翻訳の共同学習による神経機械翻訳 。 D.バーダナウ、K。チョ、Y。ベンジオ。

- 注意に基づくニューラル機械翻訳への効果的なアプローチ 。 M.-T.ルオン、H。ファム、CDマニング。

- 神経機械翻訳における単一言語コーパスの使用について 。 C.グルケレ、O。フィラット、K。シュー、K。チョー、L。バロー、H.-C。リン、F。ブーガーレス、H。シュウェンク、Y。ベンジオ。

- 単言語データによる神経機械翻訳モデルの改善 。 R.ゼンリッチ、B。ハドウ、A。バーチ。

- Earth Moverの距離正則化を使用した非並列データからのバイリンガルレキシカの誘導 M.Zhang、Y。Liu、H。Luan、Y。Liu、M。Sun.

- モノリンガルコーパスのみを使用した教師なし機械翻訳 。 G.ランプル、L。デノイヤー、M。ランザート。

- BLEU:機械翻訳の自動評価のための方法 。 K.パピネーニ、S。ルーコス、T。ワード、W.-J。朱。