この記事は、Virtuozzo Storageに基づいてクラスターを運用する実際の経験に焦点を当てています。

ホスティングサーバーでのプラットフォームのアクティブな実装と使用の1年間、およびクライアント用のクラスターを作成する際に、多くのヒント、コメント、推奨事項を収集しました。 このプラットフォームの導入を検討している場合は、クラスターを設計する際の経験を考慮することができます。

その他の出版物

- nginx + php-fpmおよびmariadbに乗ったZabbix 2.2

- CentOS上のPerconaまたはGaleraのHAPRoxy。 Zabbixでの設定と監視

- 「パーフェクト」www-cluster。 パート1.フロントエンド:CentOSでのNGINX + Keepalived(vrrp)

- 「理想的な」クラスター。 パート2.1:hetznerの仮想クラスター

- 「理想的な」クラスター。 パート2.2:アクセスしやすくスケーラブルなWebサーバー、ビジネスを守るための最高のテクノロジー

- 「理想的な」クラスター。 パート3.1 MySQLマルチマスタークラスターのデプロイ

- PHPサイトを高速化し、最適化します。 PHP用のサーバーをセットアップするときに選択するテクノロジー

- PHP 5.3-5.6と7.0のDrupalコード実行速度の比較。 Battle of Code Optimizers apc vs xcache vs opcache

- ProxmoxおよびVirtuozzo 7およびVirtuozzoストレージでのパフォーマンスBitrixの発売

あるかどうか Virtuozzoの長所と短所

要するに。 Virtuozzoを使用したときに見つかった長所と短所のリストを次に示します。pros :

- クラスターは便利です。 あるサーバーで仮想マシンをオフにして、すぐに別のサーバーでオンにすることができます。データのコピーや転送時間はありません。 サーバーがクラッシュした場合、すべての仮想マシンをクラッシュしたサーバーから無料の仮想マシンのいずれかにすぐに持ち上げることができます。

- 特定のサーバーに空き領域の概念はなくなりました。 すべてのサーバーは、クラスター内のディスク数とライセンスによってのみ制限される共有スペースを使用できます。

- テクニカルサポートが存在し、電話とメールで非常に迅速に対応します。

- ロシア連邦には直接かつ唯一のディーラーがあるため、法人のライセンスをルーブルで購入できます。

- vzに基づいた仮想マシンは、Proxmoxなどよりも非常に効率的かつはるかに効率的に動作します

- クラスターの操作に関するすべての必要な情報を明確かつ有益に取得できる便利な監視ツールがあります。 Zabbix、Monin、Nagiosのデータを自由に解析できます。

- readykernelのおかげで、カーネルのほとんどの0日脆弱性は、ハイパーバイザーの再起動なしで毎日修正されます。

- Pfcacheテクノロジーは、ハイパーバイザーのRAMを節約します(詳細は以下を参照)。

- いずれにしても、Virtuozzo Storageはネットワークファイルシステムであり、その動作はネットワークパフォーマンスに大きく依存しています。 ただし、Virtuozzoでは、高速読み取りにはローカルssdデータキャッシュを使用し、書き込みにはローカルssdログを使用できます。 さらに、Virtuozzo Storageは、特定の仮想マシンに関連付けられたデータを、この仮想マシンが実行されているハイパーバイザーに転送しようとしています。

- クラスターには複数のタイプのディスク(ssd、hdd + ssdキャッシュ、hdd)を配置できますが、それらの間で仮想マシンを自由に移動できます。 高速ディスクがなくなると、高速ディスクの場所が表示されるまで、マシンは他のタイプのディスクの使用を自動的に開始します。

- ディスクをローカルRAIDに保持することは厳密に禁忌です。 私たちにとっての主な利点は、データのコピーが1つのサーバーではなく複数のサーバーに保存されることです。これは、Raidよりもはるかに信頼性があります。

残念ながら、欠点もあります(:

- 特に大規模なプロジェクトやデータボリュームでは、(cef + kvmと比較して)非常に高価です。

- 月に1、2回、明らかな理由もなくハイパーバイザーの1つがフリーズする可能性があります。

- クラスター内のスペースを仮想マシン内のリモートデータから物理的に解放するには、非常に難しいpcompactプロシージャを実行する必要があります(これについては以下で詳しく説明しています)。

- サポートは一生懸命努力していますが、本当に複雑な問題を解決することはできません。 通常、このような問題は次のアップデートで解決されます。 それまでの間、アップグレードと再起動を求めるメッセージが表示されます(IT Crowdの最高の伝統)。

- ライブマイグレーションはありますが、コンテナでハーフオープンソケットが使用されている場合、エラーで落ちます(つまり、存在しません)。

- ドロップされたハイパーバイザーからの仮想マシンの自動移行と開始がありますが、クラスター内のサーバーの最小数は5である必要があり、レプリケーションレベルは3:2(つまり、クラスター内の同じデータブロックの3つのコピー)です。 仮想マシンの実行ステータスがある場合、オートメーションは保存されませんが、フリーズします。

- Virtuozzo Storageのコンポーネントは、少量の完全に空いているRAMの状態では正常に動作できません。 通常のLinuxディスクキャッシュは、特定のCS(Virtuozzo Storageデーモン)の崩壊につながり、仮想マシンやハイパーバイザー全体の崩壊にさえつながります。

- Virtuozzo Automatorコントロールパネルは、実際の使用には適さず、むしろリソースと負荷の統計を表示するのに適しておらず、他の代替コントロールパネルは見つかりませんでした。

- 典型的な操作の自動化のためのAPIが見つかりませんでした。 私は自分で書く必要がありましたが、彼と一緒にすべてが順調に進んでいるわけでもありません。 実際、通常の操作はbashコンソールを介して実行しますが、結果として、明確な理由なしに一部の操作が実行されない場合があります。 たとえば、古いハイパーバイザーでコンテナーをシャットダウンし、移行し、最終的なハイパーバイザーで実際に起動するという一連の簡単な手順を経て、ハイパーバイザーからハイパーバイザーに仮想マシンを移行するプロセスを自動化しました。 起動手順が遅すぎることがあるため、起動手順が機能しない場合があります。また、自分で作成したapiが落ちるだけです。 さらに、同じハイパーバイザーで複数のタスクが同時に起動された場合の対処方法が明確ではありません。

だから、賛否両論が多かれ少なかれ理解された今、本当の推奨事項 :

設置

インストールパラメータを制御する機能が必要な場合、または6か月前に作成した古いクラスターに新しいノードを追加する必要がある場合(たとえば、ディスクから起動する場合)、2番目の項目を選択します-CLIをインストールします。

ただし、この場合、美しいクラスターコントロールパネルを取得する機会が失われます。

インストール段階でディスクをクラスターに追加する場合(ただし、それ以上はしないでください)、それらが完全にフォーマットされていることを確認してください。そうしないと、インストーラーはインストールの途中で美しいエラーを表示します。

スワップおよびpfcacheシステムには、高速のssdディスクが必要です。 この瞬間をお見逃しなく。そうしないとリメイクが困難になります。 スワップですべてが多かれ少なかれ明確である場合、pfcacheが何であり、それが何であるかはすぐには明確ではありません。 実際、すべての仮想マシンのフォルダーは特定のパスに沿ってスキャンされ、すべてのライブラリと実行可能ファイルはキャッシュされ、ハッシュログは特別なローカル仮想ディスクに配置され、システムパーティションに格納されます。 次に、仮想マシン内でバイナリファイルを起動すると、(ディスク上にある)ハッシュログが分析され、そのようなバイナリが既に実行されている場合、新しいバイナリは起動せず、単にメモリ内に既存のバイナリへのリンクを作成します。 ここで、ログディスクがssdでない場合に何が起こるか想像してください。 そして、スワップがまだそこに保存される場合はどうなりますか? )

ログを移行する方法は次のとおりです。

service pfcached stop ploop umount /vz/pfcache.hdd/DiskDescriptor.xml mv /vz/pfcache.hdd /mnt/ssd2/ sed '/^PFCACHE_IMAGE=/ s~.*~PFCACHE_IMAGE="/mnt/ssd2/pfcache.hdd"~' -i /etc/vz/pfcache.conf ploop mount -m /vz/pfcache /mnt/ssd2/pfcache.hdd/DiskDescriptor.xml service pfcached restart

インターネットには、高速ディスクにファイルスワップをマウントし、古い低速スワップを無効にする方法に関する情報がたくさんあります。複製はしません。 ただし、ドライブとネットワークに関するすべての推奨事項を必ず検討してください。以下で分析します。 また、少なくとも3つのクラスターサーバーが必要であることを計画します。

インストール段階で自動時刻同期を有効にしてください。そうしなかった場合、修正するのは難しくありません。

yum install ntp -y systemctl stop ntpd ntpdate 165.193.126.229 0.ru.pool.ntp.org 1.ru.pool.ntp.org 2.ru.pool.ntp.org 3.ru.pool.ntp.org systemctl start ntpd systemctl enable ntpd

インストール後、 すぐに標準のsysctlカーネル設定に多くの変更を加えますが 、明確な理由がない限りこれを行うことはお勧めしません。 サポートに相談することをお勧めします。

echo "fs.file-max=99999999" >> /etc/sysctl.d/99-files.conf echo "kernel.sysrq=1" >> /etc/sysctl.d/99-reboot.conf echo "kernel.panic=1" >> /etc/sysctl.d/99-reboot.conf sysctl -w fs.file-max=99999999 sysctl -w kernel.panic=1 sysctl -w kernel.sysrq=1

ファイル制限設定、bashプロンプト、画面のオプション

cat > /etc/security/limits.d/nofile.conf << EOL root soft nofile 1048576 root hard nofile 1048576 * soft nofile 1048576 * hard nofile 1048576 * hard core 0 EOL cat > /etc/profile.d/bash.sh << EOL PS1='\[\033[01;31m\]\u\[\033[01;33m\]@\[\033[01;36m\]\h \[\033[01;33m\]\w \[\033[01;35m\]\$ \[\033[00m\] ' EOL sed -i 's/Defaults\ requiretty/#Defaults\ requiretty/g' /etc/sudoers

仮想マシン用にローカルデータキャッシュを用意することを強くお勧めします。これはssdドライブ上にある必要があります。 これにより、仮想マシンがネットワーク経由でデータを受信するのではなく、キャッシュからローカルに取得できるようになり、クラスターと仮想マシンの動作が何倍も高速化されます。

これを行うには、/ etc / fstabを編集します。livelinuxはクラスター名、/ vz / client_cache、cachesize = 50000 0 0はMB単位のサイズのssdログへのパスです。

vstorage://livelinux /vstorage/livelinux fuse.vstorage _netdev,cache=/vz/client_cache,cachesize=50000 0 0

ネットワーク

高速ネットワークが必要です。 1 Gbネットワークでクラスターを上げることはできません。これは、自分の足で一気に行われるからです。 多数のマシンとデータがある場合、深刻な問題が発生し始めます。 ファイルシステムはネットワークであり、ディスクはネットワークを介して機能し、レプリケーションのバランスと復元も行います。 ネットワークを100%接続すると、雪崩が落ち、ブレーキがかかります。 もちろん、テストクラスタでない限り、1 GBネットワークでクラスタを実行する必要はありません。

良くはありませんが、10 GBの光学系の代替として考えられるのは、2ギガビットのネットワークカードを結合することです。 これにより、最大1.5 GBのピークが得られ、非常に良好で晴天の天気でも2 GBになります。

このタイプの結合では、802.3adが好ましい。 次に、ネットワーク機器の側で構成する必要があります。 また、xmit_hash_policy = layer3 + 4を選択するようにしてください(これは最も効率的なオプションです(Virtuozzoによる))。

/ etc / sysconfig / network-scripts / ifcfg-bond0からの例

BONDING_OPTS="miimon=1 updelay=0 downdelay=0 mode=802.3ad xmit_hash_policy=layer3+4"

ボンディングは、サーバーが他の2つのサーバーと同時に動作している場合にのみ機能することに注意してください。 すなわち 2 GBのサーバー間での直接交換は1 GBの速度で行われますが、すでに3つのサーバーがある場合、約1.5 GBの速度でデータを交換できます。

クラスタの最初のノードをインストールすると、ネットワークはすでに機能しているはずであり、Virtuozzoはブロードキャスト要求を送信できるはずです。 言い換えると、ネットワークインターフェイスにアップリンクがない場合、Virtuozzoは最終インストール段階で理由もなく黙って停止し、ハングします。 実際、彼女はブロードキャストを介してネットワークにリクエストを送信しようとしますが、成功しない場合はインストールを停止します。

もちろん、仮想マシン用とクラスターの操作用に別々のネットワークインターフェイスとネットワークを用意することは非常に望ましいことです。

Virtuozzoをインストールしたら、ネットワークブリッジを作成し、そこに実際のネットワークインターフェイスを追加する必要があります。 これは、仮想マシンが共有ネットワークで動作するために必要です。

prlsrvctl net add network1 prlsrvctl net set network1 -t bridged --ifname enp1s0d1 #enp1s0d1

ディスク

ハイパーバイザーのインストール中にディスクをストレージに追加しないでください 。 むしろ、まだ必要ですが、インストール後に削除して再度追加する必要があります。 問題は、デフォルトでVirtuozzoがすべてのディスクをtier0グループに含めたことです。 これはディスクのデフォルトのクラスターグループであり、最も低速です。 クラスター内のディスクの種類をssdではなくssdに分割するには、既に追加されているすべてのディスクをアンロードして、目的の層に再度追加する必要があります。 すでにクラスター内にある層ディスクを変更することはできません。 あなたが今日そのような分離を持つことを計画していなくても、ちょうど今それをしてください。 悪くなることはありませんが、将来は多くの不必要な困難を取り除いてください。

もう1つの問題は、指示に従ってディスクを削除すると、存在しないディスクのCSを開始しようとするサービスの形でテールが存在することです。 また、同じディスクを2回削除して追加した場合はどうなりますか? その後、サービスを再起動すると、CSディスクは2回起動を試みます。 問題なくCSを適切にアンロードおよび削除する方法に関する簡単なレシピを次に示します。

cs=1071 # - cluster=livelinux # vstorage -c $cluster rm-cs --wait $cs systemctl stop vstorage-csd.$cluster.$cs.service systemctl disable vstorage-csd.$cluster.$cs.service systemctl reset-failed vstorage-csd.$cluster.*.service systemctl | grep vstorage-csd

ディスクを正しいダッシュに追加するには、次のコマンドで完全に空のディスクを準備する必要があります。

/usr/libexec/vstorage/prepare_vstorage_drive /dev/sdc --noboot

blkid # UUID mkdir /vstorage/livelinux-cs4 # # /etc/fstab UUID="3de71ff9-724f-483a-8984-3b78fdb3b327" /vstorage/livelinux-cs4 ext4 defaults,lazytime 1 2 # mount -all # livelinux ( ) 2 ( ) vstorage -c livelinux make-cs -r /vstorage/livelinux-cs4/data -t 2 # hdd- ssd-, # -t 1 hdd+ssd , /vz/livelinux-cs6-sata-journal - ssd, #-s 30240 . vstorage -c livelinux make-cs -r /vstorage/livelinux-cs7-sata/data -t 1 -j /vz/livelinux-cs6-sata-journal -s 30240 # CS, systemctl restart vstorage-csd.target

さらに、Linuxはログを/ホームフォルダーに書き込むためのディスクスペースを確保しています

私たちの場合、それは無意味です、 オフにします (クラスターの最新バージョンでは、これはディスクを準備するときに行われますが、自分で確認する方が良いです)

tune2fs -m 0 /dev/sdc1

記憶

状況を想像してください。サーバーは仮想マシンのハイパーバイザーであり、Virtuozzo Storageのディスクチャンク(CS)を含んでいます。 その結果、Linuxは物理ディスク上のすべてのデータをRAMのディスクキャッシュに細心の注意を払って配置し、可能な限りあらゆる方法でデータを完全に占有して、システムのディスク操作を高速化します。 CS(ディスク)およびMDS(分散ファイルシステム)サービスは、メモリの空きページをすぐに取得できず、毎回キャッシュからキャッシュを解放しようとしますが、これは長い時間です。 さらに、Virtuozzo Clusterの古いエディションは、断片化されている場合、つまりメモリで動作できませんでした。 RAMの空きメモリブロック全体が必要でした。 結果は単純です-CSチャンクサービスが低下し、クラスター内でデータの複製されていないコピーが形成され、クラスターがそれらの複製を開始し、ディスク使用量が増加し、CSがより頻繁に削除され、複製のためのブロックがさらにあります...その結果、完全に埋もれたクラスターとほとんど生きていない仮想マシンがあります。

理解し始めると、特にVirtuozzoにはデフォルトでメモリ管理モードが含まれており、オーバーコミットは一切含まれていません。 言い換えると、仮想マシンは、作業のためにメモリが解放され、ディスクキャッシュが干渉しないことを期待しています。 しかし、それだけではありません。 デフォルトでは、コンテナは独自のディスクキャッシュを超えて、ハイパーバイザーの一般的なシステムディスクキャッシュに移動できます。 この場合、原則として、システムキャッシュは既にCSデータキャッシュで満たされています。

最初の仮想マシンがクラスターで起動される前であっても、すぐに実装する必要があるいくつかの推奨事項を示します。

# echo "PAGECACHE_ISOLATION=\"yes\"" >> /etc/vz/vz.conf #c CS , hdd-, , CS 32 cat > /etc/vz/vstorage-limits.conf << EOL { "VStorage": { "Path": "vstorage.slice/vstorage-services.slice", "Limit": { "Max": 34359738368 "Min": 0, "Share": 0.7 }, "Guarantee": { "Max": 4294967296, "Min": 0, "Share": 0.25 }, "Swap": { "Max": 0, "Min": 0, "Share": 0 } } } EOL service vcmmd restart # , prlsrvctl set --vcmmd-policy density prlsrvctl info | grep "policy"

さらに、メモリの操作に関してLinux設定にいくつかの変更を加えることができます。

touch /etc/sysctl.d/00-system.conf echo "vm.min_free_kbytes=1048576" >> /etc/sysctl.d/00-system.conf echo "vm.overcommit_memory=1" >> /etc/sysctl.d/00-system.conf echo "vm.swappiness=10" >> /etc/sysctl.d/00-system.conf echo "vm.vfs_cache_pressure=1000" >> /etc/sysctl.d/00-system.conf

sysctl -w vm.swappiness=10 sysctl -w vm.overcommit_memory=1 sysctl -w vm.min_free_kbytes=1048576 sysctl -w vm.vfs_cache_pressure=1000

そして、定期的にディスクキャッシュをフラッシュします。

sync && echo 3 > /proc/sys/vm/drop_caches

キャッシュをフラッシュすると、上記の問題を一時的に解決できますが、慎重に行う必要があります。 残念ながら、これはディスクサブシステムのパフォーマンスに悪影響を及ぼします。キャッシュではなく、データがディスクから再び読み取られるためです。

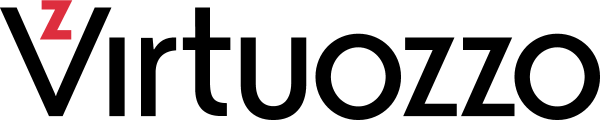

これは、Virtuozzo Storageの通常のメモリモードのようです

ご覧のとおり、ディスクキャッシュは安定しており、サーバーには十分な空きメモリがあります。 もちろん、実際のメモリオーバーキットについて話すことはできません。 これを考慮しなければなりません。

ディスク領域を解放し、ゴミをクリーンアップします

クラスタ内のコンテナと仮想マシンは、大きなフラットファイルとして保存されます。 コンテナまたは仮想マシン内で何かが削除されると、実際には場所が解放されず、クラスター内のデータブロックのみがリセットされます。 この問題を解決するために、Virtuozzo開発者はpcompactツールを作成しました。 このユーティリティは、午前3時にすべてのサーバーでCronによって同時に起動され、仮想マシンのイメージのデフラグ、およびクラスター内の未割り当てメモリページの削除とクリア(つまり、空き領域の返却)を試みます。 操作自体は、ネットワーク上、ディスク上で非常に高い負荷を作成し、その作業には追加のRAMも必要です(非常に多くの場合)。 これにより、ネットワークとディスクの使用率が高くなるため、この操作中にクラスターのパフォーマンスが低下する可能性があります。 また、メモリ消費量が多い(つまり、空きメモリ、ディスクキャッシュがアンロードされない)場合、メモリに関する段落で説明した効果が得られる可能性があります。

すなわち ネットワークとディスクの使用率は最高です。 さらに、十分な空きメモリがない場合、CSチャンクが落ち始め、欠落しているデータブロックの複製が開始されます。 その結果、すべてのノード、すべての仮想マシンなどで雪崩の問題が発生します。

さらに、デフォルトでは、この操作は2時間しか続かず、その後は自動的に停止します。 つまり、非常に大きな仮想マシンが12台ある場合、2時間のタイムアウトに収まらないため、ガベージクリーニングがすべての仮想マシンに到達しない可能性があります。

このプロセスの悪影響を減らすために、このタスクをCronからanacronに移動しました。 その後、夜間のいつでも手順が開始され、完了するまで中断しません。 その結果、原則として、プロセスは一度にクラスターの1つのノードでのみ機能します。これにより、一般に夜間のクラスターの負荷と負荷低下のリスクが軽減されます。

モニタリング

クラスターには、次のような優れた独自の監視ツールがあります。

vstorage stat --cluster livelinux #

vstorage top --cluster livelinux #

zabbiksaのデータを取得し、その中に必要なグラフをすべて作成することもできます。

たとえば、 社内のクラウド :

さまざまな範囲の空き領域と共通のライセンスクラスタの場所

クラスターの状態、再バランスされた割合、緊急に複製されたチャンクの数。 おそらく最も重要なスケジュールの1つです。

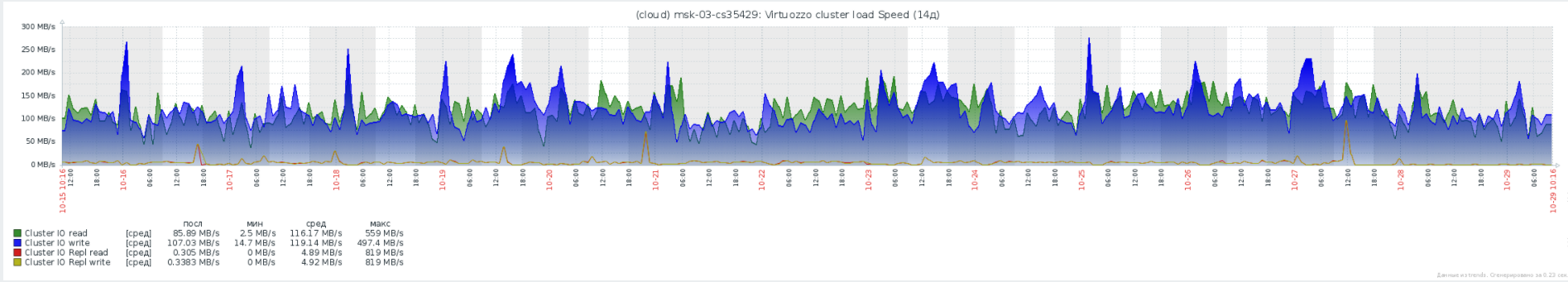

クラスター内のすべての仮想マシンのディスクのネットワーク負荷の合計と、レプリケーションとリバランスの速度。

クラスター内の平均および最大ディスクキュー。

IOPSクラスターの一般的な統計。

さらに、デフォルトでは、Virtuozzoのファイアウォールが明らかに許可されていないすべての操作を禁止していることを忘れないでください。 zabbix-agentの場合、ファイアウォールイネーブルルールのペアが必要です。

firewall-cmd --permanent --add-port=10050/tcp firewall-cmd --permanent --add-port=10051/tcp firewall-cmd --permanent --add-port=5001/tcp systemctl restart firewalld

最後に、クラスターを操作するためのいくつかの便利なコマンド

ディスクダッシュにある仮想マシンを確認します。

(for i in `ls /vstorage/livelinux/private`; do grep HOSTNAME /vstorage/livelinux/private/$i/ve.conf; vstorage -c livelinux get-attr /vstorage/livelinux/private/$i|grep tier; done) | (grep "HOSTNAME\|tier" | tr '\n ' ' ' | tr 'H' '\n' | sed 's#tier=2#SSD#g' | sed 's#tier=1#HDD#g' | sed 's#tier=2#SSD#g' | sed 's#OSTNAME=##g' | sed 's#"##g') | awk '{print $2" "$1}' | sort

pcompactプロセスの手動開始

/usr/sbin/pcompact -v

デフォルトでは、万が一に備えてVirtuozzo Storageはディスク容量を確保しています。 強く押した場合、 一時的に予約の割合を下げることができます。

vstorage -c livelinux set-config mds.alloc.fill_margin=1

クラスタファイルシステムをアンマウントする必要があるが、サーバーに過負荷をかけたくない場合は、すべての仮想マシンをオフにして実行する必要があります。

fusermount -uz /vstorage/livelinux #

ローカルデータキャッシュの統計を調べる

watch cat /vstorage/livelinux/.vstorage.info/read_cache_info

ライセンスの状態を調べる

pstorage -c livelinux view-license # vzlicupdate vzlicview

あなたのhwidを見つける

pstorage -c livelinux stat --license-hwid

pfcacheログのサイズが、割り当てられた仮想ディスクに収まらない場合があります。 次の解決策があります

prl_disk_tool resize resize --size 15G --hdd /vz/pfcache.hdd/DiskDescriptor.xml

サーバーからMDSサービスを削除する

vstorage -c livelinux rm-mds 11 #11-id mds

ローカルサーバーでMDSを起動します

vstorage -c livelinux make-mds -a 172.17.0.254:2510 # -r /vz/mds/data # mds, ssd -b 172.17.0.255 -b 172.17.0.249 -b 172.17.0.248 -b 172.17.0.4 # mds systemctl restart vstorage-mdsd.target systemctl enable vstorage-mdsd.target

クラスターサーバー上の仮想マシンデータのデフォルトのコピー数を変更する

vstorage set-attr -R /vstorage/livelinux replicas=2

特定の仮想マシンのデータのコピー数を変更する

vstorage set-attr -R /vstorage/livelinux/private/a0327669-855d-4523-96b7-cf4d41ccff7e replicas=1

すべての仮想マシンの階層を変更し、デフォルトで階層を設定します

vstorage set-attr -R /vstorage/livelinux/private tier=2 vstorage set-attr -R /vstorage/livelinux/vmprivate tier=2

特定の仮想マシンの層を変更する

vstorage set-attr -R /vstorage/livelinux/private/8a4c1475-4335-40e7-8c95-0a3a782719b1 tier=2

ハイパーバイザー上のすべての仮想マシンを停止して移行します

hp=msk-07 for vm in `prlctl list | grep -v UUID | awk '{print $5}'`; do prlctl stop $vm; prlctl migrate $vm $hp; ssh $hp -C prlctl start $vm; done

既にどこかで実行されていても、完全にハングしたか、正しく移行されなかった場合でも、仮想マシンを別のサーバーで強制的に起動します 。

prlctl register /vz/private/20f36a7f-f64d-46fa-b0ef-85182bc41433 --preserve-uuid --force

コンテナーを作成および構成するコマンドのリスト

prlctl create test.local --ostemplate centos-7-x86_64 --vmtype ct prlctl set test.local --hostname test.local --cpus 4 --memsize 10G --swappages 512M --onboot yes prlctl set test.local --device-set hdd0 --size 130G prlctl set test.local --netif_add netif1 prlctl set test.local --ifname netif1 --network network1 prlctl set test.local --ifname netif1 --ipadd 172.17.0.244/24 prlctl set test.local --ifname netif1 --nameserver 172.17.0.1 prlctl set test.local --ifname netif1 --gw 172.17.0.1 prlctl start test.local prlctl enter test.local

ご清聴ありがとうございました。