これは、カリフォルニア大学ロサンゼルス校の学生であるAdit Deshpandeによる一連の「深層学習研究レビュー」の3番目の記事です。 Aditは2週間ごとに、ディープラーニングの特定の領域の研究のレビューと解釈を公開しています。 今回は、自然言語テキストを処理するためのディープラーニングの使用に焦点を当てました。

自然言語処理の概要

はじめに

自然言語処理(NLP)とは、特定のタスクを実行するために言語を処理または「理解」するシステムの作成を指します。 これらのタスクには以下が含まれます。

- 質問に対する回答の作成(質問への回答)(Siri、Alexa、Cortanaが行うこと)

- センチメント分析(ステートメントに肯定的または否定的な意味合いがあるかどうかを判断する)

- 画像に一致するテキストの検索(画像からテキストへのマッピング)(入力画像のキャプションを生成)

- 機械翻訳(ある言語から別の言語へのテキストの段落の翻訳)

- 音声認識

- 形態学的マークアップ(品詞タグ付け)(文の品詞とその注釈の定義)

- エンティティの認識

NLPへの従来のアプローチは、主題分野の深い知識、つまり言語学を前提としていました。 音韻や形態素などの用語を理解することは必須であり、彼らの研究に専念する言語学の専門分野はすべてあります。 従来のNLPが次の単語をどのように認識するかを見てみましょう。

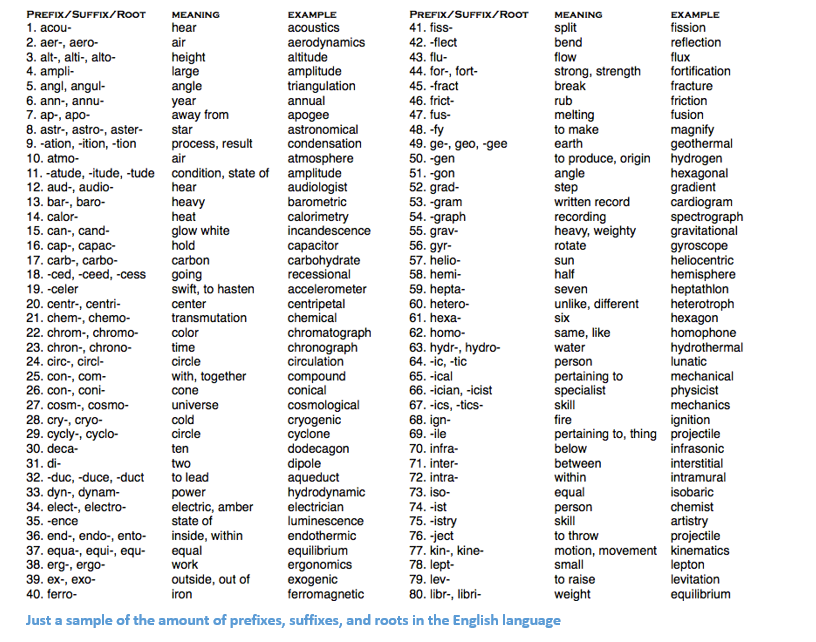

私たちの目標は、この単語に関する情報を収集することです(その感情的な色付けを決定し、その意味を見つけるなど)。 言語の知識を使用して、この単語を3つの部分に分けることができます。

接頭辞は否定を意味することを理解しており、-edは特定の単語が参照する時間(この場合は過去形)を意味することがわかっています。 同族の単語の興味の意味を認識したら、単語全体の意味と感情的な色付けを簡単に結論付けることができます。 簡単そうです。 それでも、英語のさまざまな接頭辞と接尾辞を考慮すると、考えられるすべての組み合わせとその意味を理解するには、非常に熟練した言語学者が必要になります。

サフィックスとルートのプレフィックスの数を英語で示す例

ディープラーニングの使用方法

ディープラーニングの中心は、アイデアについて学ぶことです。 たとえば、畳み込みニューラルネットワーク(CNN)には、オブジェクトをカテゴリに分類するために設計されたさまざまなフィルターの組み合わせが含まれます。 ここでは、同様のアプローチを適用して、大きなデータセット内の単語の表現を作成しようとします。

記事の構造

この記事は、NLPの深いネットワークを構築するための基本的な要素について説明し、その後、最近の科学研究に関係するいくつかのアプリケーションについて説明できるように構成されています。 たとえば、RNNを使用する理由やLSTMが何に役立つのか正確にわからない場合でも構いませんが、これらの作品を研究した後、NLPでディープラーニングが非常に重要である理由を理解できます。

単語ベクトル

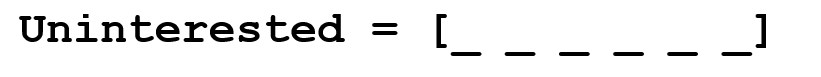

ディープラーニングは数学なしでは生きられないため、各単語をd次元のベクトルとして表します。 d = 6を取ります。

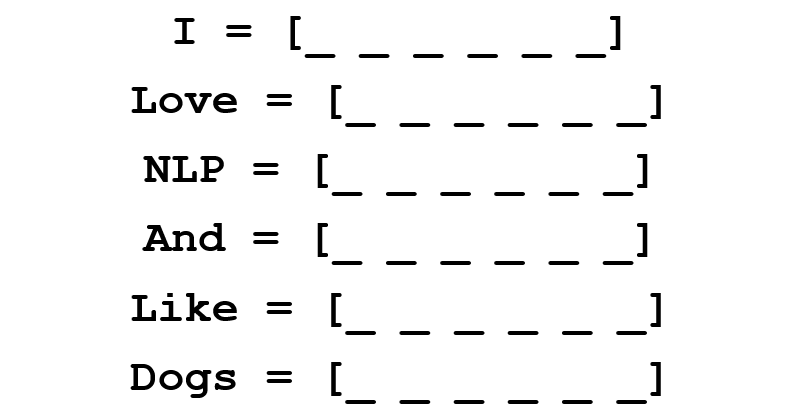

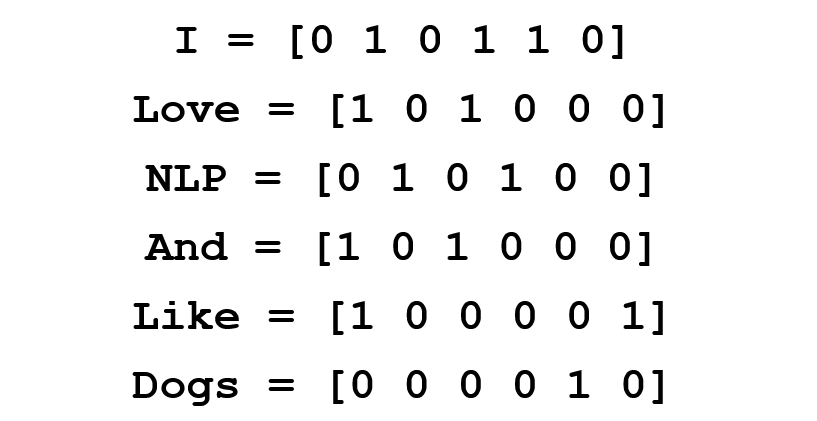

次に、値の入力方法を検討します。 ベクトルは、単語とそのコンテキスト、意味、またはセマンティクスを何らかの形で表すような方法で埋められるようにします。 1つの方法は、共起行列を作成することです。 次の文を考慮してください。

各単語のベクトル表現が必要です。

共起マトリックスには、コーパス(トレーニングセット)で各コーパスの他の各ワードの後に各ワードが発生する回数が含まれます。

この行列の行は、単語のベクトル表現として機能します。

この単純なマトリックスからでも、非常に重要な情報を描画できることに注意してください。 たとえば、「love」および「like」という単語のベクトルには、セルが名詞への近接に関与する単位(「NLP」および「dogs」)を含むことに注意してください。 また、「I」に隣接する「1」は、この単語が動詞である可能性が高いことを示しています。 データセットが複数の文である場合、類似の類似性を識別することがどれほど簡単か想像できます。この場合、「愛」、「ライク」、および他の同義語などの動詞のベクトルは類似します。コンテキスト。

最初は良いですが、ここではコーパスのサイズに応じて各単語のベクトルの次元が線形に増加することに注意します。 100万語(標準のNLPタスクには不十分)の場合、100万あたり100万の次元の行列が得られ、さらに非常にまばらです(多数のゼロがあります)。 これは間違いなく、ストレージ効率の点で最良のオプションではありません。 単語の最適なベクトル表現を見つけることに関して、いくつかの重大な進歩がなされました。 最も有名なのはWord2Vecです。

Word2vec

単語のベクトルを初期化するすべての方法の主な目標は、妥当な次元(理想的には25〜1000)を維持しながら、このベクトルにできるだけ多くの情報を格納することです。 Word2Vecの中核となるのは、各単語の周囲の単語を予測する方法を学習するという考え方です。 前の例の文を考えてみましょう:「私はNLPが好きで、犬が好きです」。 今、私たちは最初の3つの単語だけに興味があります。 ウィンドウのサイズを3にします。

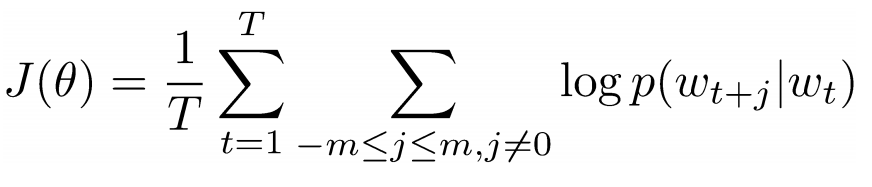

ここで、「愛」という中心的な言葉を取り上げ、その前後に来る言葉を予測します。 これをどうやってやるの? もちろん、関数を最大化して最適化することにより! 正式には、この関数は、現在の中心単語の各単語コンテキストの対数確率を最大化しようとします。

上記の式をさらに詳しく調べます。 それから、「I」と「love」、および「NLP」と「love」の両方の同時発生の対数確率を合計することになります(両方のケースで「love」が中心語です)。 変数Tは、トレーニング提案の数を意味します。 より近い対数確率を考慮してください。

-中心語のベクトル表現。 各単語には2つのベクトル表現があります。 そして 、1つは単語が中心位置を占める場合、もう1つはこの単語が「外部」である場合です。 ベクトルは確率的勾配降下法によって訓練されます。 これは間違いなく理解するのが最も難しい方程式の1つです。したがって、まだ何が起こっているのか想像できない場合は、 こちらとこちらで詳細をご覧 ください 。

1つの文にまとめると、 Word2Vecは、さまざまな単語のベクトル表現を検索し、特定の中心単語のコンテキスト単語の出現確率を最大化し、確率的勾配降下法によってベクトルを変換します。

(オプション:さらに、 作業の著者は、ネガティブサンプリングを使用してサブサンプリングを行うことで、より正確な単語ベクトルを取得する方法について詳しく説明します)。

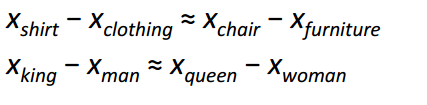

おそらく、NLPの開発に対するWord2Vecの最も興味深い貢献は、異なる単語ベクトル間の線形関係の出現でした。 トレーニング後、ベクトルはさまざまな文法およびセマンティックの概念を反映します。

このような単純な目的関数と単純な最適化手法により、これらの線形関係を特定できたのは驚くべきことです。

ボーナス :単語ベクトルを初期化するもう1つのクールな方法は、 GloVe (単語表現のグローバルベクトル)(共起行列のアイデアとWord2Vecを組み合わせたもの)です。

リカレントニューラルネットワーク(RNN)

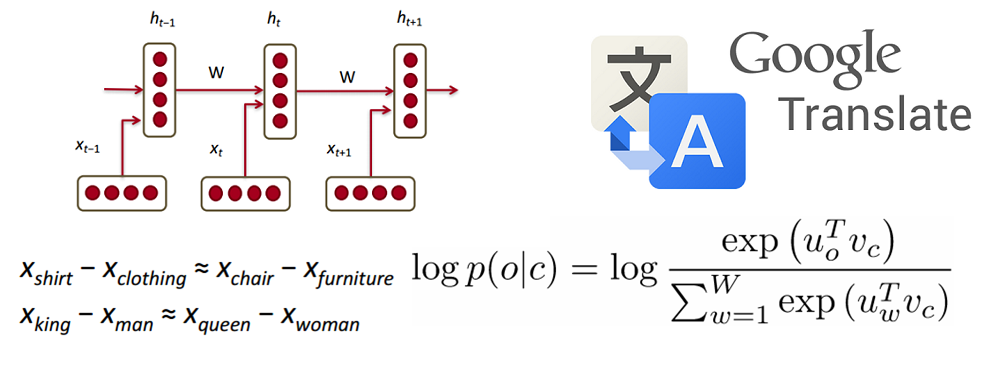

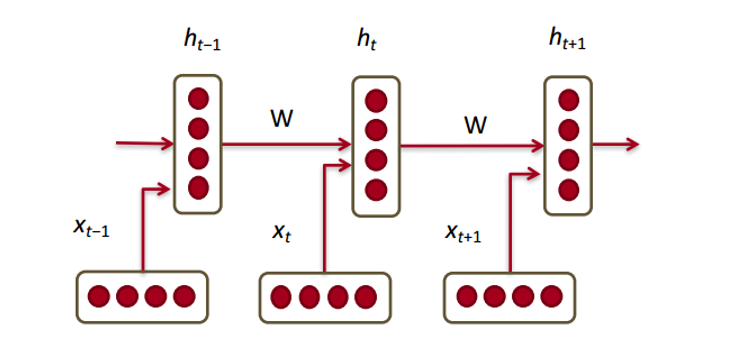

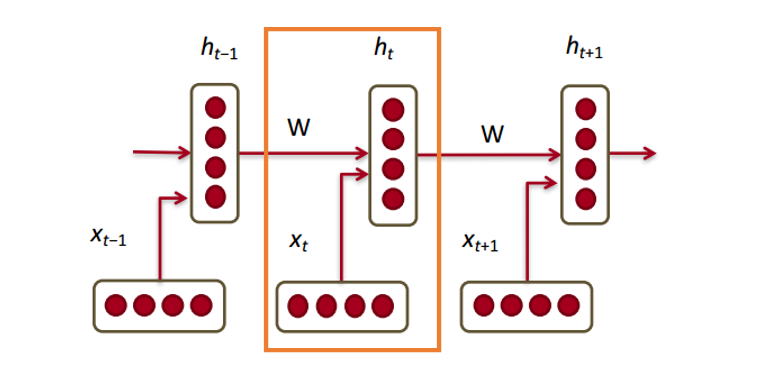

次に、リカレントニューラルネットワークがベクターでどのように機能するかを見てみましょう。 RNNは、ほとんどの最新の自然言語処理タスクの命の恩人です。 RNNの主な利点は、前の手順のデータを効率的に使用できることです。 RNNの小さな部分は次のようになります。

以下は単語ベクトル( ) すべてのステップの各ベクトルには、非表示の状態ベクトル(非表示の状態ベクトル)( ) このペアをモジュールと呼びます。

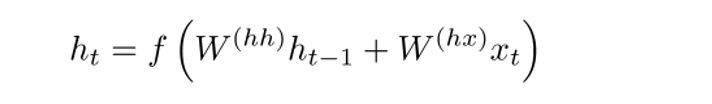

各RNNモジュールの潜在状態は、ワードベクトルと最後のステップの潜在状態ベクトルの関数です。

上付き文字をよく見ると、重み行列があることがわかります 、入力値で乗算する、重みの繰り返し行列です 、前のステップの非表示状態のベクトルが乗算されます。 これらの繰り返し重み行列は、すべてのステップで同じであることに注意してください。 これがRNNの重要なポイントです 。 慎重に考えると、このアプローチは、たとえば従来の2層ニューラルネットワークとは大きく異なります。 この場合、通常、レイヤーごとに個別の行列Wを選択します。 そして 。 ここで、重みの繰り返し行列はネットワーク全体で同じです。

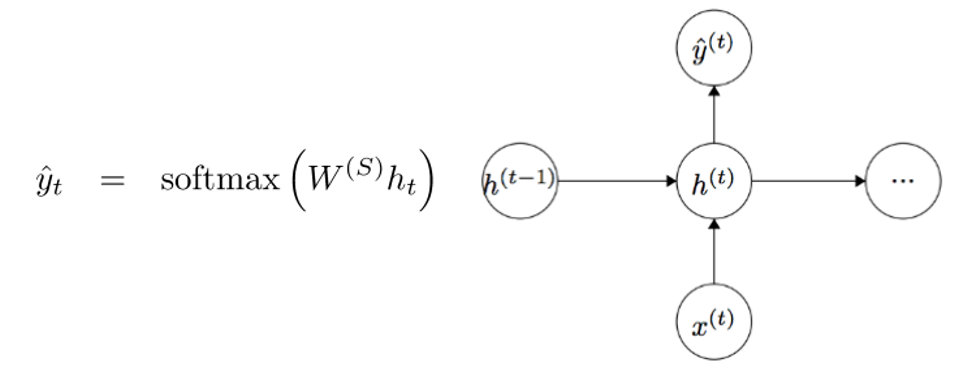

各モジュールの出力値(Yhat)を取得するには、別の重み行列があります- 回h。

それでは、外部から見て、RNNの利点を理解しましょう。 RNNと従来のニューラルネットワークの最も明らかな違いは、RNNが入力として一連の入力データ(この場合は単語)を受け取ることです。 この点で、たとえば、典型的なCNNとは異なり、その入力には画像全体が提供されます。 ただし、RNNの場合、短い文と5つの段落のエッセイの両方を入力として使用できます。 さらに、データが表示される順序は、トレーニング中に潜在状態の重み行列とベクトルがどのように変化するかに影響を与える可能性があります。 トレーニングの終了までに、過去のステップからの情報は潜在状態のベクトルに蓄積されるはずです。

制御された再発ニューロン(ゲート付き再発ユニット、GRU)

次に、制御された回帰ニューロンの概念を理解し、その助けを借りて、RNNの隠れ状態のベクトルの計算を実行します。 このアプローチにより、より遠くの依存関係に関する情報を保存できます。 通常のRNNの長距離依存性が問題になる理由について説明しましょう。 バックプロパゲーションメソッドの操作中、エラーはRNNに沿って最後のステップから最も早い段階に移動します。 3番目または4番目のモジュールへの初期勾配が十分に小さい(たとえば、0.25未満)場合、勾配はほとんど消滅し(勾配は複素関数の導関数の規則で乗算されるため)、最初のステップの隠された状態は更新されません。

通常のRNNでは、隠れ状態ベクトルは次の式を使用して計算されます。

GRU方式では、h(t)を異なる方法で計算できます。 計算は、更新ゲートフィルター、リセットゲートフィルター、および新しいメモリコンテナーの3つのブロックに分割されます。 両方のフィルターは、単語の入力ベクトル表現と前のステップの非表示状態の関数です。

主な違いは、各フィルターが独自の重みを使用することです。 これは、異なる上付き文字で示されます。 更新フィルターの使用 そして 、状態リセットフィルターは そして 。

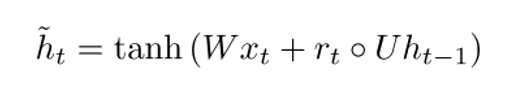

次に、メモリコンテナを計算しましょう。

(ここの空の円は、 アダマールの積を示しています )。

ここで、式をよく見ると、状態リセットフィルターの係数がゼロに近い場合、製品全体もゼロに近づくため、前のステップの情報がわかります。 カウントされません。 この場合、ニューロンは新しい単語ベクトルの単なる関数です 。

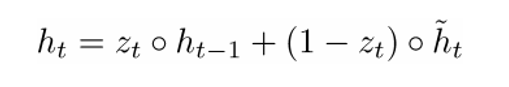

最終的な式h(t)は次のように記述できます。

-3つのコンポーネントすべての機能:更新フィルター、ステータスリセットフィルター、およびメモリコンテナー。 次の場合に数式に何が起こるかを視覚化することで、これをよりよく理解できます。 1に近づいたとき 0に近い。最初のケースでは、隠れ状態ベクトル 以前の非表示状態に大きく依存し、現在のメモリコンテナは考慮されません。なぜなら(1- )0になる傾向があります。しかし、 1に近づき、新しい隠れ状態ベクトル それどころか、それは主にメモリコンテナに依存し、以前の非表示状態は考慮されません。 したがって、3つのコンポーネントは次のように直感的に説明できます。

- フィルターを更新

- もし 〜1その後 現在の単語ベクトルを考慮せず、以前の非表示状態を単にコピーします。

- もし 〜0その後 以前の非表示状態を考慮せず、メモリコンテナのみに依存します。

- このフィルターにより、モデルは、以前の非表示状態からの情報が現在の非表示状態にどの程度影響するかを制御できます。

- ステータスリセットフィルター

- もし 〜1、メモリコンテナは以前の非表示状態からの情報を保存します。

- もし 〜0の場合、メモリコンテナは以前の非表示状態を考慮しません。

- このフィルタを使用すると、将来興味を持たない場合に情報の一部を破棄できます。

- メモリコンテナ:ステータスリセットフィルターに依存します。

GRUの動作を示す例を示します。 以下のいくつかの提案があるとしましょう:

質問:「2つの数字の合計は何ですか?」中央の文は答えに影響しないため、リセットおよび更新フィルターにより、モデルはこの文を「忘れ」、特定の情報のみが非表示状態(この場合は数字)を変更できることを理解できます。

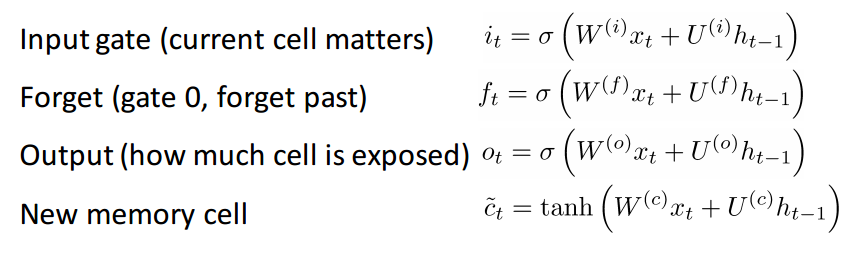

長期短期記憶(LSTM)を持つニューロン

GRUを理解できれば、LSTMは難しくありません。 LSTMも一連のフィルターで構成されています。

LSTMは間違いなく、より多くの入力を受け入れます。 GRU拡張機能と見なすことができるため、詳細には分析しません。各フィルターと計算の各ステップの詳細な説明を取得するには、Chris Olah による美しく書かれたブログ投稿を参照できます。 これは現在、LSTMで最も人気のあるチュートリアルであり、この方法がどのように機能するかについての明確で直感的な説明を探している人に間違いなく役立ちます。

LSTMとGRUの比較

まず、一般的な機能を検討します。 これらのメソッドは両方とも、単語のシーケンスの遠い依存関係を保持するように設計されています。 遠い依存関係とは、2つの単語またはフレーズが異なるタイムステップで発生する可能性があるが、最終的な目標を達成するためにそれらの関係が重要な状況を意味します。 LSTMとGRUは、処理中のシーケンスの情報を保存または破棄できるフィルターを使用して、この関係を追跡します。

2つの方法の違いは、フィルターの数(GRU-2、LSTM-3)です。 これは、入力から生じる非線形性の量に影響し、最終的に計算プロセスに影響します。 さらに、GRUにはメモリの場所はありません。 LSTMのように。

記事を掘り下げる前に

小さな発言をしたいと思います。 他のディープラーニングモデルがNLPで役立つ場合。 実際には、再帰的および畳み込みニューラルネットワークが使用されることがありますが、ほとんどのNLP深層学習システムの基礎となるRNNほど一般的ではありません。

NLPに関してリカレントニューラルネットワークに精通し始めたので、この分野での作業のいくつかを見てみましょう。 NLPには(機械翻訳から質問への回答の生成まで)タスクのいくつかの異なる領域が含まれているため、かなりの数の作品を検討することができましたが、特に有益な3つの作品を選択しました。 2016年には、NLPの分野で多くの大きな進歩がありましたが、2015年に1つの作業から始めましょう。

メモリを備えたニューラルネットワーク(メモリネットワーク)

はじめに

私たちが議論する最初の仕事は、質問に対する答えを形成する分野の発展に大きな影響を与えました。 Jason Weston、Sumit Chopra、Antoine Bordesによるこの出版物では、「メモリネットワーク」と呼ばれるクラスのモデルが最初に説明されました。

直感的なアイデアは次のとおりです。テキストフラグメントに関連する質問に正確に回答するには、提供された初期情報を何らかの方法で保存する必要があります。 「RNNの略語はどういう意味ですか?」と尋ねると、記事の最初の部分を読んで学んだ情報が記憶のどこかに保存されていたので、答えてください。 この情報を見つけて発言するのに数秒しかかかりません。 脳内でこれがどのように機能するかはわかりませんが、この情報を保存するにはスペースが必要であるという考えは変わりません。

このホワイトペーパーで説明するメモリネットワークは、書き込みと読み取りが可能な連想メモリを備えているため、ユニークです。 CNNもQ-Network(強化学習用)も従来のニューラルネットワークもそのようなメモリを使用しないことに注意してください。これは、質問への回答を生成するタスクがシミュレートする能力に大きく依存しているという事実に一部起因します遠い依存関係を追跡する、たとえば、歴史の英雄を追う、またはイベントのシーケンスを記憶する。CNNまたはQ-Networksでは、メモリはシステムの重みに統合され、さまざまなフィルターや状態とアクションの対応のマップを学習します。 一見、RNNまたはLSTMを使用できますが、通常は過去の入力データを思い出せません(これは質問に対する回答を生成するタスクにとって重要です)。

ネットワークアーキテクチャ

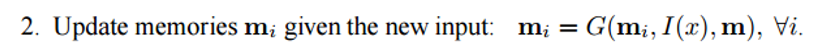

次に、このようなネットワークがソーステキストを処理する方法を見てみましょう。 ほとんどの機械学習アルゴリズムと同様に、最初のステップは、入力を属性空間の表現に変換することです。 これは、プログラマーの裁量で、単語のベクトル表現、形態学的マークアップ、解析などを使用することを意味する場合があります。

次のステップは、属性空間I(x)の表現を取得し、入力データxの新しい部分をメモリに読み込むことです。

メモリmは、個別のメモリブロックで構成される一種の配列と見なすことができます。 。 そのような各ブロック は、メモリm全体の機能、符号I(x)および/またはそれ自体の空間表現です。 関数Gは、単純にI(x)の表現全体をメモリブロックmiに格納できます。 関数Gは、新しい入力データに基づいて過去のメモリを更新するように変更できます。 3番目と4番目の手順には、oの記号の表現を見つけるために質問に照らしてメモリから読み取り、それをデコードして最終的な回答rを取得することが含まれます。

RNNはRの関数として使用できます。Rの機能は、機能の表示を人間が読み取れる、質問に対する正確な回答に変換します。

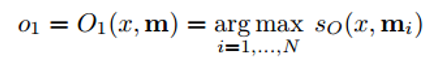

次に、ステップ3を見てみましょう。O関数が、与えられた質問xに対する可能な答えに最も適した属性空間の表現を返すようにします。 , .

(argmax) , , ( , ). ( ) ( ). , , . RNN, LSTM , .

, , , . , :

, , , :

- End to End Memory Networks

- Dynamic Memory Networks

- Dynamic Coattention Networks ( 2016 Stanford's Question Answering)

Tree-LSTM

はじめに

– , (). “ ”. LSTM. (Kai Sheng Tai), (Richard Socher) (Christopher Manning) LSTM- .

, . , , , . , LSTM- , .

ネットワークアーキテクチャ

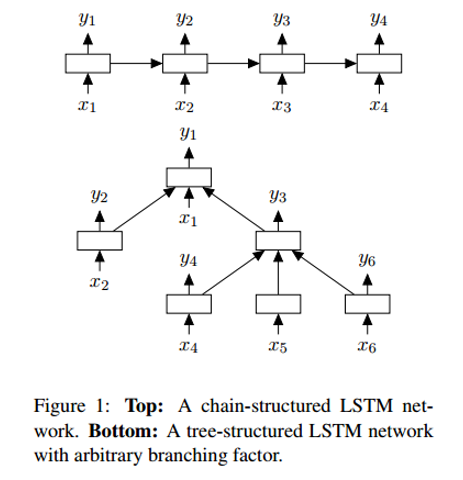

Tree-LSTM LSTM , – . Tree-LSTM – .

– – , , . . , LSTM.

Tree-LSTM . , -. , (, “” “”) . .

(Neural Machine Translation, NMT)

はじめに

, , . – Google (Jeff Dean), (Greg Corrado), (Orial Vinyals) – , Google Translate. 60% , Google.

. . , . , ( NMT) , .

ネットワークアーキテクチャ

LSTM, . : RNN, RNN “” (attention module). , , , ( ).

, . , , .

おわりに

これで、ディープラーニングが自然言語処理の問題の解決にどのように寄与するかについての投稿を締めくくりました。この分野の開発におけるさらなる目標は、カスタマーサービス、完璧な機械翻訳、そして場合によっては非構造化テキストや長いテキスト(Wikipediaページなど)の質問に深く答えるためのトレーニングシステムのチャットボットを改善することだと思います。

ああ、仕事に来てくれませんか? :)wunderfund.ioは、 高頻度アルゴリズム取引を扱う若い財団です。 高頻度取引は、世界中の最高のプログラマーと数学者による継続的な競争です。 私たちに参加することで、あなたはこの魅力的な戦いの一部になります。

熱心な研究者やプログラマー向けに、興味深く複雑なデータ分析と低遅延の開発タスクを提供しています。 柔軟なスケジュールと官僚主義がないため、意思決定が迅速に行われ、実施されます。

チームに参加: wunderfund.io