たとえば、検索で初めてニューラルネットワークを使用して、リクエストで使用される単語やドキュメント自体ではなく、リクエストの意味とタイトルでドキュメントを検索します。

何十年もの間、研究者はセマンティック検索の問題に苦労してきました。セマンティック検索では、クエリに対するセマンティックの関連性に基づいてドキュメントがランク付けされます。 そして今、それは現実になりつつあります。

この投稿では、その方法と、それが単なる機械学習アルゴリズムではなく、将来への重要なステップである理由について少しお話しようと思います。

人工知能または機械学習?

ほとんどの人は、最新の検索エンジンが機械学習によって機能することを知っています。 そのタスクのためにニューラルネットワークの使用について話す必要があるのはなぜですか? そして、なぜこのトピックに関する誇大広告が数年間沈静化していないのに、今だけですか? 私は問題の歴史について話そうとします。

インターネットの検索は、かなり前に登場した複雑なシステムです。 最初はページを検索するだけでしたが、その後問題解決に変わり、今では本格的なアシスタントになりつつあります。 インターネットが増え、その中にいる人が多いほど、要件が高くなるほど、検索が難しくなります。

ナイーブサーチの時代

最初は単語検索、つまり逆索引がありました。 その後、ページが多すぎたため、ランク付けする必要がありました。 さまざまな合併症、つまり単語の頻度tf-idfが考慮され始めました。

リンク年齢

次に、トピックに関するページが多すぎて、重要なブレークスルーが発生しました-リンクを考慮に入れ始め、 PageRankが表示されました。

機械学習の時代

インターネットは商業的に重要になり、当時存在していた単純なアルゴリズムをだまそうとする多くの詐欺師がいます。 2番目の重要なブレークスルーがありました-検索エンジンは、ユーザーの行動に関する知識を使用して、どのページが良いページでどれがそうでないかを理解し始めました。

人間の心のこの段階のどこかで、ドキュメントをランク付けする方法を理解するのはもはや十分ではありませんでした。 次の移行が発生しました-検索エンジンが機械学習を積極的に使用し始めました。

最高の機械学習アルゴリズムの1つがYandexで発明されました-Matrixnet。 ユーザーの集合的な精神と「 群衆の知恵 」がランキングに役立つと言えます。 サイトと人々の行動に関する情報は多くの要因に変換され、それぞれがMatrixNetによってランキング式を作成するために使用されます。 実際、ランキング式はマシンによって書き込まれます(約300メガバイトが判明)。

しかし、「古典的な」機械学習には限界があります。大量のデータがある場合にのみ機能します。 小さな例。 何百万人ものユーザーがクエリ[VKontakte]を入力して、同じサイトを見つけます。 この場合、彼らの行動は非常に強力なシグナルであるため、検索では人々が結果を見ることはできませんが、リクエストを入力するとすぐに住所が求められます。

しかし、人々はより複雑であり、彼らは検索からより多くを求めています。 現在、すべてのリクエストの最大40%が一意です。つまり、監視期間全体で少なくとも2回は繰り返されません。 つまり、検索にはユーザーの行動に関する十分なデータがなく、Matrixnetは貴重な要素を失います。 Yandexのこのようなクエリは、「 ロングテール 」と呼ばれます。これは、これらのクエリが一緒になって検索への呼び出しのかなりの割合を占めるためです。

人工知能の時代

それから、最新のブレークスルーについてお話します。数年前、コンピューターは十分に高速で、ニューラルネットワークを使用するのに十分なデータがあります。 それらに基づく技術は、マシンインテリジェンスまたは人工知能とも呼ばれます-ニューラルネットワークは脳内のニューロンのイメージに組み込まれ、その一部の機能をエミュレートしようとするためです。

マシンインテリジェンスは、人々が実行できるタスク(たとえば、音声認識や画像内の画像)に対処するための古い方法よりもはるかに優れています。 しかし、これは検索にどのように役立ちますか?

原則として、低頻度で一意のクエリは検索が非常に困難です-適切な答えを見つけることははるかに困難です。 どうやってやるの? ユーザーからのプロンプトはありません(どちらのドキュメントが優れているか、どちらが悪いか)。したがって、検索の問題を解決するには、クエリとドキュメントの2つのテキスト間の意味的対応をよりよく理解する方法を学ぶ必要があります。

言いやすい

厳密に言えば、人工ニューラルネットワークは機械学習の方法の1つです。 ごく最近、 Small ShADの枠組みで講義が行われました 。 ニューラルネットワークは、自然情報(音と画像)の分析で印象的な結果を示します。 これは数年前から起こっています。 しかし、なぜ検索でそれほど積極的に使用されないのですか?

簡単な答えは、意味について話すことは、写真の画像について話すこと、または音を解読された単語に変える方法について話すことよりもはるかに難しいからです。 しかし、意味の検索では、人工知能は実際にそれが長い間王であった地域から来始めました-写真の検索。

これが画像検索でどのように機能するかについてのいくつかの言葉。 画像を取得し、ニューラルネットワークを使用して、N次元空間のベクトルに変換します。 リクエスト(テキスト形式または別の画像形式のいずれか)を取得し、同じことを行います。 そして、これらのベクトルを比較します。 それらが互いに近いほど、要求に一致する写真が多くなります。

わかりました、これが写真で機能する場合、ウェブ検索で同じロジックを適用してみませんか?

技術の悪魔

次のように問題を定式化します。 入力にはユーザーリクエストとページタイトルがあります。 それらが意味で互いにどのように対応するかを理解する必要があります。 これを行うには、クエリテキストと見出しテキストをこのようなベクトルの形式で提示する必要があり、そのスカラー倍が大きいほど、この見出しを持つドキュメントの関連性が高くなります。 言い換えると、意味が近いテキストに対して同様のベクトルを生成し、意味的に関連のないクエリとベクトルヘッダーに対しては異なる必要があるように、ニューラルネットワークをトレーニングする必要があります。

このタスクの複雑さは、正しいアーキテクチャの選択とニューラルネットワークのトレーニング方法にあります。 科学出版物から、問題を解決するためのかなりの数のアプローチがあります。 おそらくここで最も簡単な方法は、 word2vecアルゴリズムを使用してテキストをベクトルの形式で表現することです(残念ながら、実際の経験から、これは検討中の問題に対するかなり失敗した解決策であることが示唆されています)。

さらに-試したこと、成功を収めた方法、起こったことを訓練する方法について。

DSSM

2013年、Microsoft Researchの研究者は、 Deep Structured Semantic Modelと呼ばれるアプローチを説明しました。

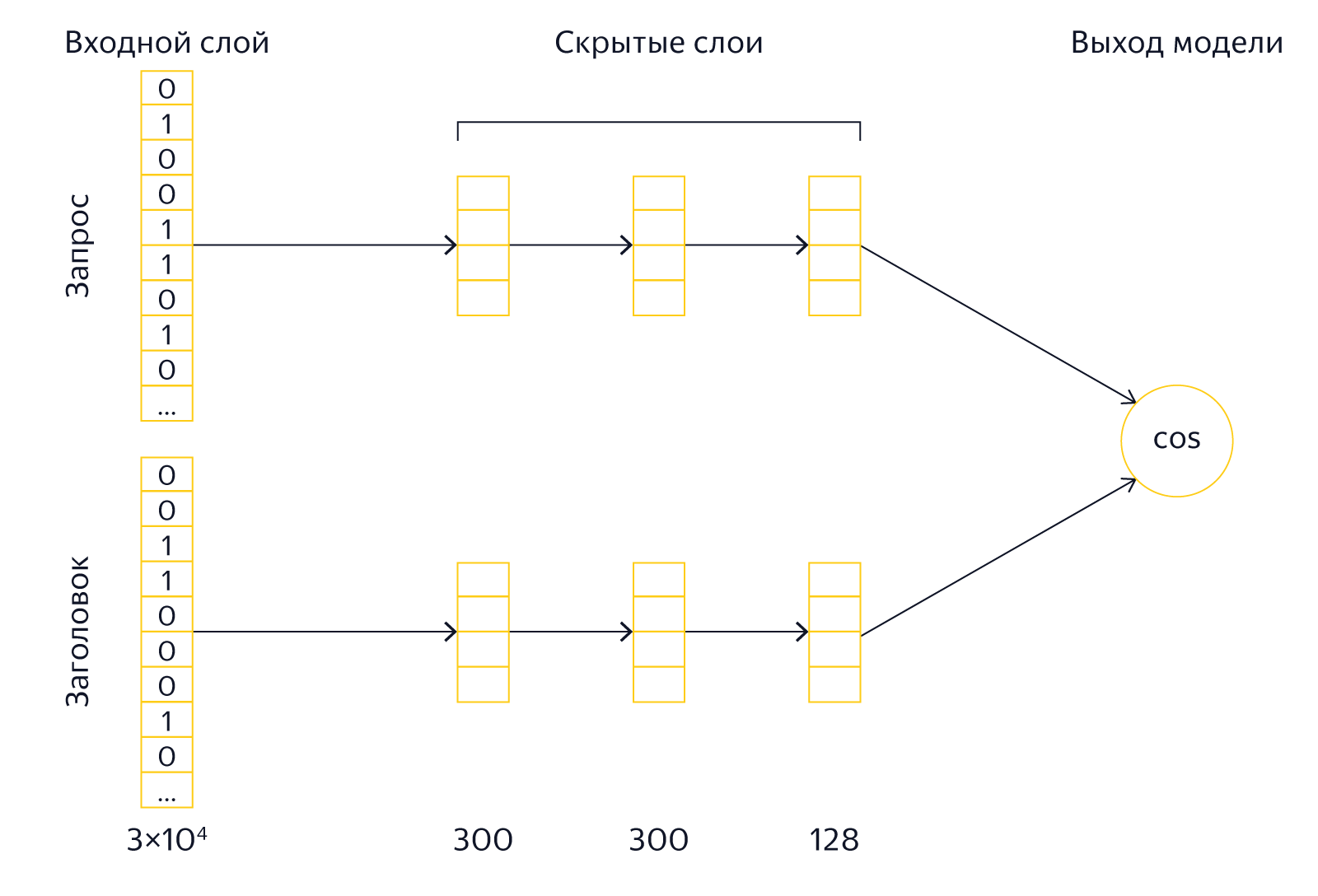

リクエストとヘッダーのテキストはモデル入力に送られます。 モデルのサイズを小さくするために、それらに対して操作が実行され、作成者はこれをワードハッシュと呼びます。 開始と終了のマーカーがテキストに追加され、その後、文字のトライグラムに分割されます。 たとえば、クエリ[palekh]の場合、trigram [pa、ale、lech、ex]を取得します。 異なるトライグラムの数は限られているため、クエリテキストを数万要素のベクトルとして表示できます(アルファベットのサイズは3度です)。 クエリのトライグラムに対応するベクトル要素は1、残り-0になります。実際、このようにして、すべての既知のトリグラムで構成される辞書のテキストからのトライグラムの出現をマークします。 このようなベクトルを比較すると、クエリとヘッダーに同じトライグラムが存在するかどうかのみを確認できますが、これは特に重要ではありません。 したがって、必要なセマンティックプロキシミティのプロパティをすでに持っている他のベクトルに変換する必要があります。

深いアーキテクチャで予想されるように、入力層の後に、要求とヘッダーの両方に対していくつかの隠された層があります。 最後のレイヤーのサイズは128エレメントで、比較に使用されるベクトルとして機能します。 モデルの出力は、ヘッダーとクエリの最後のベクトルのスカラー乗算の結果です(完全に正確にするために、ベクトル間の角度のコサインが計算されます)。 モデルは、正のトレーニング例では出力値が大きく、負の例では小さい値になるようにトレーニングされます。 つまり、最後のレイヤーのベクトルを比較して、予測誤差を計算し、誤差が減少するようにモデルを修正できます。

Yandexでは、人工ニューラルネットワークに基づいたモデルも積極的に検討しているため、DSSMモデルに興味があります。 さらに、この領域での実験について説明します。

理論と実践

科学文献に記載されているアルゴリズムの特性は、それらが常に箱から出して動作するとは限らないことです。 事実、「学術」研究者と業界研究者は著しく異なる状況にあります。 科学出版物の著者が彼の決定を比較する出発点(ベースライン)として、いくつかのよく知られたアルゴリズムが動作するはずです-これは結果の再現性を保証します。 研究者は、以前に公開されたアプローチの結果を取得し、それらがどのように超えられるかを示します。 たとえば、元のDSSMの作成者は、 NDCGメトリックとBM25およびLSAアルゴリズムを使用してモデルを比較します。 実際の検索エンジンで検索品質を扱う応用研究者の場合、開始点は特定のアルゴリズムではなく、全体のランキング全体です。 Yandex開発者の目標は、BM25を追い越すことではなく、以前に導入された多くの要因とモデルを背景に改善を達成することです。 したがって、Yandexの研究者のベースラインは非常に高く、科学的斬新性と「学術」アプローチで良い結果を示す多くのアルゴリズムは、検索の品質を実際に改善できないため、実際には役に立ちません。

DSSMの場合、同じ問題に直面しました。 よくあるように、「戦闘」状態では、記事のモデルの正確な実装はかなり控えめな結果を示しました。 実用的な観点から興味深い結果を得るには、多くの重要な「ファイルの改善」が必要でした。 ここでは、元のモデルをより強力にするための主要な修正について説明します。

大きな入力層

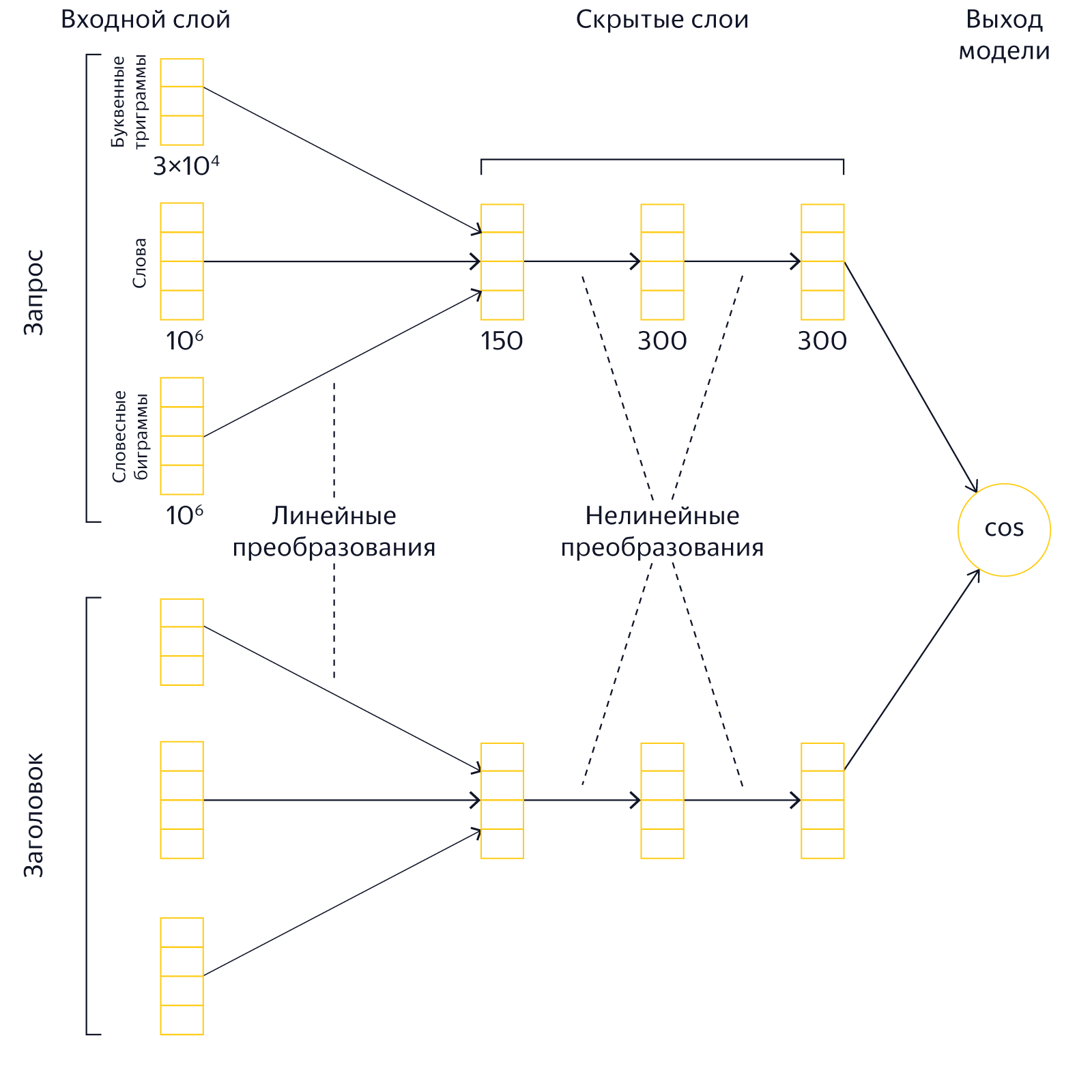

元のDSSMモデルでは、入力レイヤーは文字のトライグラムのセットです。 サイズは30,000です。トライグラムアプローチにはいくつかの利点があります。 第一に、それらは比較的少ないので、それらを操作するのに大きなリソースは必要ありません。 第二に、それらのアプリケーションは、単語のタイプミスやエラーの識別を簡素化します。 しかし、私たちの実験では、トライグラムの「バッグ」の形でテキストを表示すると、ネットワークの表現力が著しく低下することが示されました。 そのため、文字のトライグラムに加えて、約200万の単語と語句を含む入力レイヤーのサイズを大幅に増やしました。 したがって、リクエストのテキストと見出しは、単語、言葉のバイグラム、および文字のトライグラムの「バッグ」の形で提示します。

大きな入力層を使用すると、モデルのサイズが大きくなり、トレーニング期間が長くなり、非常に大きなコンピューティングリソースが必要になります。

学ぶのは難しい:ニューラルネットワークがそれ自体とどのように戦い、その誤りから学んだか

オリジナルのDSSMを学ぶことは、多くの肯定的および否定的な例のネットワークを実証することにあります。 これらの例は、検索結果から取られています(明らかに、Bing検索エンジンがこれに使用されました)。 ポジティブな例は、クリックされた問題のドキュメントの見出しです。ネガティブな例は、クリックされなかったドキュメントの見出しです。 このアプローチにはいくつかの欠点があります。 実際のところ、クリックがないということは、ドキュメントが無関係であることを常に示すとは限りません。 逆もまた真です-クリックの存在はドキュメントの関連性を保証しません。 本質的に、元の記事で説明した方法で学習することにより、ヘッダーがSERPに存在する場合、ヘッダーの魅力を予測しようとします。 もちろん、これも悪いことではありませんが、セマンティックな近接性を理解することを学ぶという私たちの主な目標とは間接的な関係があります。

実験中に、否定的な例を選択するための別の戦略を使用することで、結果を著しく改善できることがわかりました。 目標を達成するための良いネガティブな例は、リクエストとは無関係であることが保証されているが、ニューラルネットワークが単語の意味をよりよく理解するのに役立つドキュメントです。 どこから入手できますか?

最初の試み

まず、否定的な例として、ランダムなドキュメントのタイトルを取得します。 たとえば、リクエスト[Palekh painting]の場合、ランダムな見出しは「Traffic Rules 2016 RF」です。 もちろん、数十億からランダムに選択されたドキュメントがリクエストに関連することを完全に除外することは不可能ですが、この可能性は無視できるほど小さいです。 したがって、非常に簡単に多くの否定的な例を得ることができます。 ユーザーに興味のある良いドキュメントとリクエストに関係のないドキュメントを区別するために、ネットワークに私たちが望むものを正確に教えることができるようになります。 残念ながら、そのような例で訓練されたモデルはかなり弱いことが判明しました。 ニューラルネットワークはスマートなものであり、常に作業を簡素化する方法を見つけます。 この場合、彼女はクエリと見出しで同じ単語を探し始めました:はい-良いペア、いいえ-悪い。 しかし、私たち自身がこれを行うことができます。 私たちにとって重要なのは、ネットワークが非自明なパターンを区別することを学ぶことです。

もう一度試してください

次の実験では、クエリの単語を否定的な例の見出しに追加しました。 たとえば、クエリ[Palekh painting]の場合、ランダムな見出しは[Rules of the road 2016 RF painting]のように見えます。 ニューラルネットワークはもう少し複雑でしたが、それにもかかわらず、自然なペアと手作りのペアを区別する方法をすぐに学びました。 そのような方法では成功しないことが明らかになりました。

成功

多くの明らかな解決策は、発見されて初めて明らかになります。 そのため、今回は起こりました。しばらくして、ネガティブな例を生成する最良の方法は、ネットワークを自分自身に対して「戦う」ことであり、それ自体の間違いから学ぶことでした。 数百のランダムヘッダーの中から、現在のニューラルネットワークが最適と考えるヘッダーを選択しました。 ただし、このヘッダーはまだランダムであるため、高い確率でリクエストと一致しません。 そして、ネガティブな例として使用し始めたのはまさにこれらの見出しでした。 つまり、ネットワークに最高のランダムヘッダーを表示したり、トレーニングしたり、新しい最高のランダムヘッダーを見つけたり、再びネットワークを表示したりすることができます。 この手順を何度も繰り返して、モデルの品質が大幅に向上し、ランダムペアの最高のものが実際のポジティブな例のようになることがわかりました。 問題は解決されました。

科学文献における同様のトレーニングパターンは、通常、ハードネガティブマイニングと呼ばれます。 同様の概念のソリューションは、科学コミュニティで現実的に見える画像を生成するために広く使用されており、同様のクラスのモデルは生成的敵対ネットワークと呼ばれていました。

さまざまな目標

良い例として、Microsoft Researchの研究者はドキュメントクリックを使用しました。 ただし、既に述べたように、これは、ヘッダーと要求のセマンティック対応に関するかなり信頼性の低いシグナルです。 最後に、私たちの仕事は、検索結果で最も訪問されたサイトを上げることではなく、本当に役立つ情報を見つけることです。 そのため、トレーニングの目標として、ユーザーの行動の他の特性を使用しようとしました。 たとえば、モデルの1つは、ユーザーがサイトにとどまるか去るかを予測しました。 もう1つは、彼がサイトに留まる時間です。 判明したように、このようなターゲットメトリックを最適化すると、ユーザーが必要なものを見つけたことを示す場合、結果を大幅に改善できます。

利益

わかりました、これは実際に私たちに何を与えますか? ニューラルモデルの動作と、クエリワードとテキスト-BM25との対応に基づいた単純なテキストファクターを比較してみましょう。 彼はランキングが単純だった時代から私たちのところに来て、今では基本的なレベルでそれを使うのが便利です。

例として、クエリ[Kellsの本]を取り上げて、さまざまな見出しにどのような重要な要因がかかるかを見てみましょう。 制御のために、明らかに無関係な結果をヘッダーのリストに追加しましょう。

| ページタイトル | BM25 | 神経モデル |

|---|---|---|

| ケルズウィキペディアブック | 0.91 | 0.92 |

| 科学者は世界中のケルズの本を研究します | 0.88 | 0.85 |

| ケルズのウィキペディア | 0 | 0.81 |

| アイルランドの図解された福音書vii viii世紀 | 0 | 0.58 |

| ikea ikea home and office hypermarkets

| 0 | 0.09 |

Yandexのすべての因子は、区間[0; 1]に正規化されます。 BM25には、クエリワードを含むヘッダーの値が高いことが予想されます。 また、リクエストに共通の単語がない見出しでは、この要素の値がゼロになることは予測可能です。 次に、ニューラルモデルの動作に注意してください。 リクエストと、関連するウィキペディアのページのロシア語の見出しと英語の記事の見出しの両方との接続を等しく認識しています! さらに、このモデルは、要求と見出しの関係を「見た」ようです。これは、ケル書には言及していませんが、意味が近いフレーズがあります(「アイルランドの福音書」)。 無関係な見出しのモデルの値は大幅に低くなります。

次に、意味を変えずにリクエストを再定式化した場合の要因の動作を見てみましょう:[Kellsからの福音書]。

| ページタイトル | BM25 | 神経モデル |

|---|---|---|

| ケルズウィキペディアブック | 0 | 0.85 |

| 科学者は世界中のケルズの本を研究します | 0 | 0.78 |

| ケルズのウィキペディア | 0 | 0.71 |

| アイルランドの図解された福音書vii viii世紀 | 0.33

| 0.84 |

| ikea ikea home and office hypermarkets | 0 | 0.10 |

BM25の場合、リクエストの再定式化は真の災害に変わりました。関連するヘッダーの係数はゼロになりました。 そして、私たちのモデルは、再定式化に対する優れた回復力を示しています。関連する見出しは依然として高い因子価値を持ち、無関係な見出しは低いです。 これはまさに、テキストのセマンティクスを「理解」できると主張するものに期待する動作であるようです。

別の例。 リクエスト[蝶がつぶされた物語]。

| ページタイトル | BM25 | 神経モデル |

|---|---|---|

| 蝶がつぶされた映画 | 0.79 | 0.82 |

| 雷がウィキペディアを襲った | 0 | 0.43 |

| ブラッドベリーレイウィキペディア | 0 | 0.27 |

| タイムマシンローマンウィキペディア | 0 | 0.24 |

| 自家製ラズベリージャムの冬のレシピ | 0 | 0.06 |

ご覧のとおり、リクエストに一般的な単語が完全に含まれていないにもかかわらず、ニューラルモデルは正解で見出しを評価することができました。 さらに、要求に応答しないが、意味において関連しているヘッダーは、かなり高いファクター値を受け取ることが明らかに見られます。 私たちのモデルはブラッドベリーの物語を「読み」、これが彼が要求で話していることを「知っている」かのようです!

次は?

私たちは偉大で非常に興味深い旅の始まりにいます。 どうやら、ニューラルネットワークはランキングを改善する優れた可能性を秘めています。 積極的な開発が必要な主な方向性はすでに明確になっています。

たとえば、見出しにドキュメントに関する不完全な情報が含まれていることは明らかであり、フルテキストを使用してモデルを構築する方法を学ぶとよいでしょう(判明したように、これは完全に簡単な作業ではありません)。 さらに、DSSMよりもはるかに複雑なアーキテクチャを備えたモデルを想像できます。この方法で、自然言語の構造をより適切に処理できると考える理由があります。 個人のレベルに匹敵するレベルで、要求と文書の意味的対応を「理解」できるモデルを作成するという長期的な目標があります。 この目標への道のりには多くの困難があります-それをもっと面白くすることです。 この分野での仕事について話すことをお約束します。 次の資料に従ってください。