これは、表情による笑顔の定義に関するシリーズの2番目の記事です。

ガレージディープラーニング-フェローシップ

ガレージディープラーニング-2つのネットワーク

ガレージでの深層学習-笑顔の復活

キャリブレーション

そのため、分類器を使用して整理しましたが、検出のための戦闘テスト中に空の99%がどういうわけか非常に印象的にならないことにすでに気付いているでしょう。 だから気づいた。 さらに、最後の2つの例では、ウィンドウの移動に非常に小さなステップがあり、これは実際には機能しないことがわかります。 現在の実際の起動では、このステップは最初のネットワークの写真のように見えることが期待されています。そこで、不快な事実をはっきりと見ることができます:ネットワークがどのように顔を探していても、ウィンドウは顔にうまく整列しません。 そして、ピッチを小さくすることは、明らかにこの生産の問題に対する適切な解決策ではありません。

まあ、私は思った。 私たちは窓を見つけましたが、正確な窓は見つけませんでしたが、シフトしたかのように。 顔が中央にくるように、どのように後ろに動かしますか? 当然、自動的に。 まあ、そして私はネットワークで忙しくなったので、私はネットワークでもウィンドウを「復元」することにしました。 しかし、どのように?

私が最初に考えたのは、ネットワークによって3つの数値を予測することでした。つまり、xとyだけシフトする必要があるピクセルの数と、ウィンドウを拡大する(縮小する)定数です。 結局のところ、退行。 しかし、その後、すぐに何かが間違っていると感じました。3回の回帰を行う必要がありました。 はい、そのうちの2つは個別です。 さらに、ウィンドウを遠くに移動しても意味がないため、元の画像でウィンドウが移動するステップによって制限されます。別のウィンドウがありました。 このアイデアのcoの最後のネイルはいくつかの独立した記事であり、回帰は分類が最新のネットワーク手法によって解決されるよりもはるかに悪く、安定性がはるかに低いと主張しました。

したがって、回帰問題を分類問題に還元することが決定されました。分類問題は、ウィンドウをほとんど引っ張る必要がないことを考えると、可能性を超えていることが判明しました。 これらの目的のために、元のデータセットから選択した個人を取得し、9つの異なる側(なしを含む)にシフトし、5つの異なる係数(1つを含む)を増減するデータセットを組み立てました。 合計45クラス。

賢明な読者はここでぞっとするはずです。クラスは互いに非常に強く結びついていることが判明しました。 このような分類の結果は、一般的に現実とはほとんど関係がない場合があります。

内部数学を落ち着かせるために、私は3つのポイントを挙げました:

- 本質的に、ネットワークトレーニングは、単純に最小損失関数の検索です。 分類として解釈する必要はありません。

- 私たちは何も分類しません。実際、回帰をエミュレートします! これにより、最初のポイントの認識と合わせて、正式な正当性に集中することができなくなります。

- それはうまくいきます!

回帰をエミュレートするのではなく分類するため、最良のクラスを取得してそれが正しいと仮定することはできません。 したがって、私はネットワークが各ウィンドウに与えるクラス分布を取り、非常にありそうもないものを削除します(<2.2%、つまり1/4このような小さな非基底に一種の回帰があります(クラスが独立している場合は基礎がありますが、まったく基礎ではありません:) 。

合計で、システムに2つ目のキャリブレーションネットワークを導入しました。 彼女はクラスの分布を示し、それに基づいてウィンドウを較正し、顔がウィンドウの中央に揃うことを望んでいました。

このネットワークを訓練してみましょう:

def build_net12_cal(input): network = lasagne.layers.InputLayer(shape=(None, 3, 12, 12), input_var=input) network = lasagne.layers.dropout(network, p=.1) network = conv(network, num_filters=16, filter_size=(3, 3), nolin=relu) network = max_pool(network) network = DenseLayer(lasagne.layers.dropout(network, p=.5), num_units=128, nolin=relu) network = DenseLayer(lasagne.layers.dropout(network, p=.5), num_units=45, nolin=linear) return network

そして、変位を計算するためのアルゴリズムは次のとおりです。

def get_calibration(): classes = np.array([(dx1, dy1, ds1), (dx2, d2, ds2), ...], dtype=theano.config.floatX) # ds -- scale min_cal_prob = 1.0 / len(classes) cals = calibration_net(*frames) > min_cal_prob # , (dx, dy, ds) = (classes * cals.T).sum(axis=0) / cals.sum(axis=1) # -- , -- . , return dx, dy, ds

そしてそれは動作します!

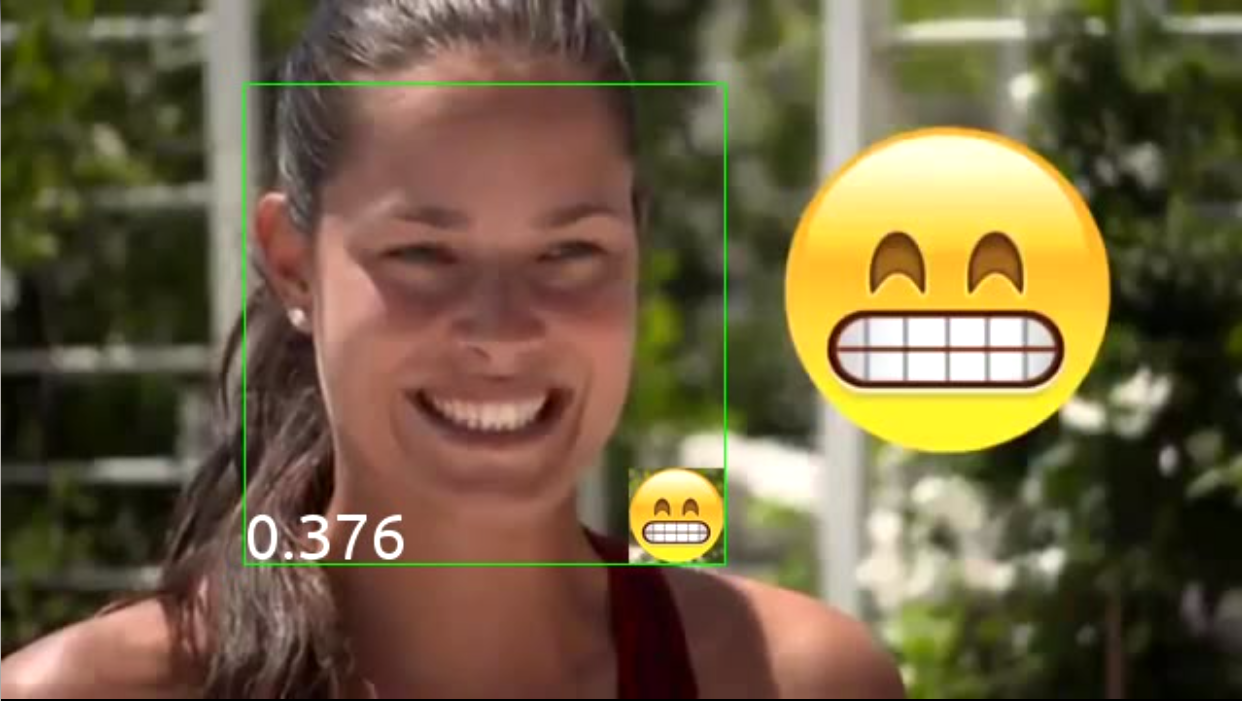

左側には検出ネットワークからの元のウィンドウ(小さい)があり、右側にはキャリブレーションされています。 ウィンドウが明示的なクラスターでグループ化し始めることがわかります。 さらに、同じ面に属するウィンドウはより大きな領域と交差し、そのうちの1つをフィルタリングする必要があることを理解しやすくなるため、これは複製をより効率的にフィルタリングするのに役立ちます。 また、画像上でウィンドウをスライドさせるステップを増やすことにより、実稼働中のウィンドウの数を減らすことができます。

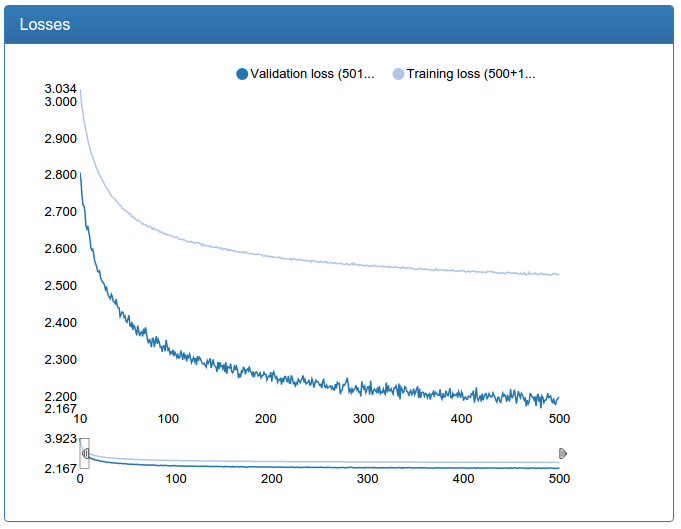

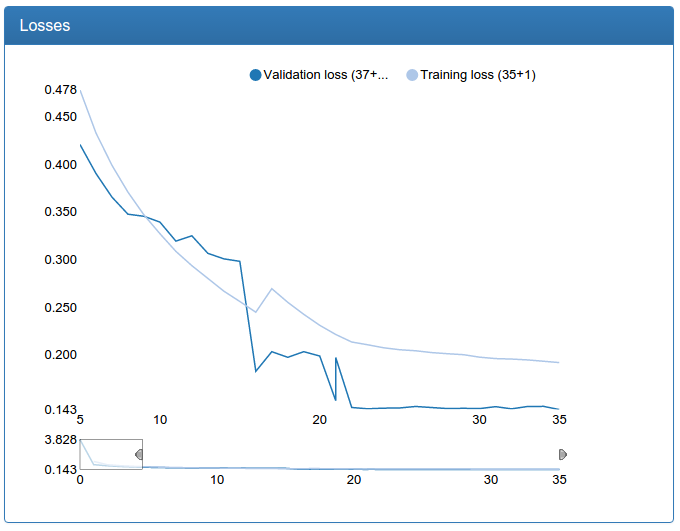

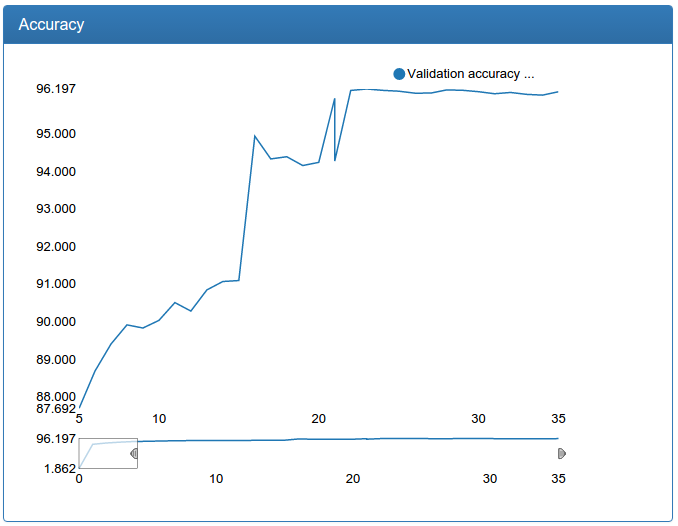

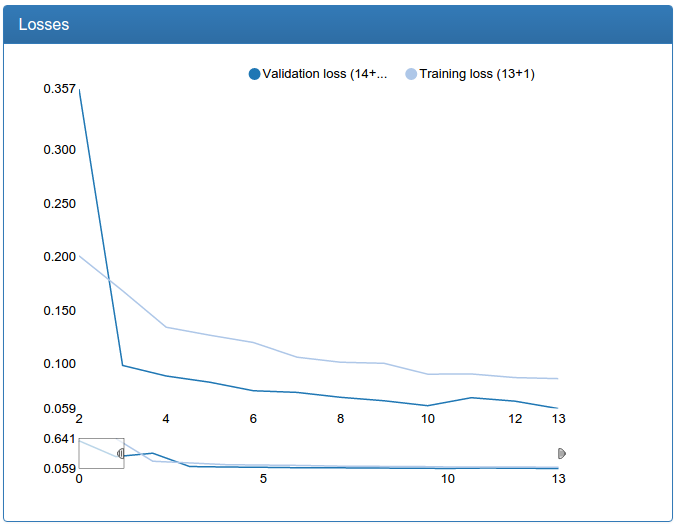

同時に、小口径のトレーニングの結果は次のとおりです。

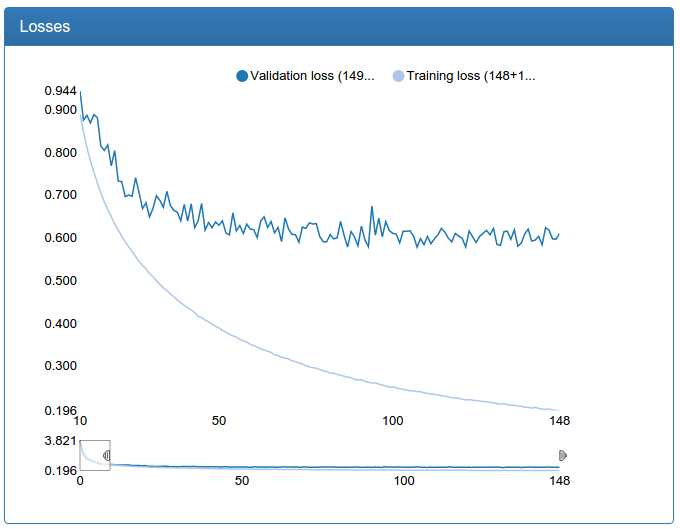

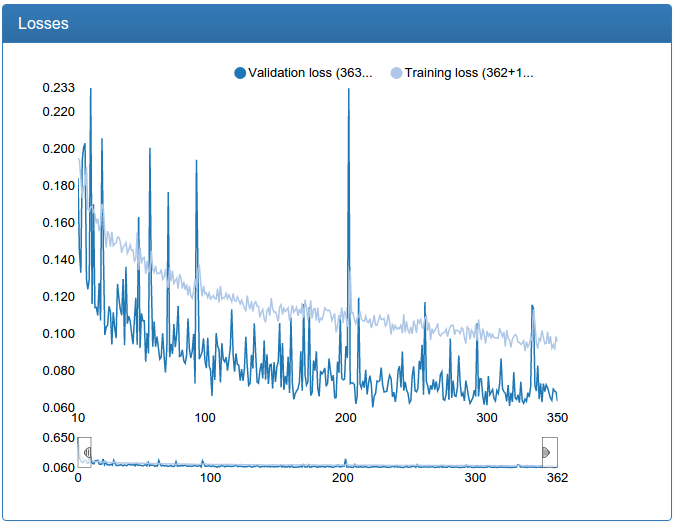

および大規模なキャリブレーション:

これが大規模なキャリブレーションネットワークそのものです。

def build_net48_cal(input): network = lasagne.layers.InputLayer(shape=(None, 3, 48, 48), input_var=input) network = lasagne.layers.dropout(network, p=.1) network = conv(network, num_filters=64, filter_size=(5, 5), nolin=relu) network = max_pool(network) network = conv(network, num_filters=64, filter_size=(5, 5), nolin=relu) network = DenseLayer(lasagne.layers.dropout(network, p=.3), num_units=256, nolin=relu) network = DenseLayer(lasagne.layers.dropout(network, p=.3), num_units=45, nolin=linear) return network

分類する必要はなく、回帰する必要があるため、これらのグラフは懐疑的です。 しかし、一目で実証実験を行うと、この方法でトレーニングされたキャリブレーションが目的を十分に果たしていることがわかります。

また、キャリブレーションの場合、初期データセットは分類の45倍(各人45クラス)ですが、一方で、問題を設定するだけでは上記の方法で補足することはできません。 だから、ソーセージ、特に大規模なネットワークはほとんど。

最適化II

検出に戻ります。 実験では、小さなネットワークでは目的の品質が得られないことがわかっているため、大きなネットワークを学習する必要があります。 しかし、大きな問題は、1枚の写真から取得した何千ものウィンドウを非常に長い時間にわたって強力なGPUで分類することです。 このようなシステムを実装することは不可能です。 現在のバージョンでは、トリッキーなトリックによる最適化の大きな可能性がありますが、十分にスケーラブルではなく、問題を定性的に解決し、フロップを巧妙に最適化しないことを決定しました。 そして、あなたの目の前にある解決策です! 12x12の入力、1つの畳み込み、1つのプーリング、および分類器を備えた小規模ネットワーク! 特に、すべてのウィンドウでGPUで並行して分類を実行できることを考えると、非常に高速に動作します-ほぼ瞬時に判明します。

アンサンブル

それらすべてをもたらし、暗闇の中でそれらを縛るための一つのアンサンブル。

そのため、1つの分類と1つのキャリブレーションではなく、ネットワーク全体を使用することにしました。 最初は弱い分類、次に弱いキャリブレーション、次におそらく1つの顔を示すキャリブレーションされたウィンドウのフィルタリングがあり、これらの残りのウィンドウのみで強い分類を実行し、次に強いキャリブレーションを実行します。

その後、練習により、かなり遅いことがわかったため、アンサンブルを3レベルまで作成しました。2つの中間に「平均」分類を挿入し、次に「平均」キャリブレーションとフィルタリングを行いました。 このような組み合わせでは、システムは十分に高速で動作するため、フロップを減らして並列性を高めるために、エンジニアリングの努力といくつかのトリックを実装する場合、実稼働で使用する本当の機会があります。

アルゴリズムを取得する合計:

- すべてのウィンドウが見つかります。

- 最初の検出ネットワークを確認します。

- 発火した人は、最初のキャリブレーションネットワークをキャリブレーションします。

- 交差するウィンドウをフィルタリングします。

- 2番目の検出ネットワークを確認します。

- 発火したものは、2番目のキャリブレーションネットワークをキャリブレーションします。

- 交差するウィンドウをフィルタリングします。

- 3番目の検出ネットワークを確認します。

- 発火したものは、3番目のキャリブレーションネットワークをキャリブレーションします。

- 交差するウィンドウをフィルタリングします。

バッチウィンドウ

各ウィンドウで手順2〜7を個別に実行すると、CPUからGPUへの絶え間ない切り替え、ビデオカードでの不完全な並列処理の利用、他に何を知っているかなど、非常に長い時間がかかります。 したがって、個々のウィンドウだけでなく、任意のサイズのバッチで動作するパイプラインロジックを作成することが決定されました。 これを行うために、各ステージをジェネレーターに変換し、各ステージ間にコードを配置することが決定されました。これは、ジェネレーターとしても機能しますが、ウィンドウではなく、前のステージの結果をバッチおよびバッファーし、所定の数の結果が蓄積された場合(または終了した場合)、収集されたバッチをさらに提供します

このシステムは不良ではなく(30%)、検出中に処理を加速しました。

モアーデータ!

上記の前の記事で述べたように、大規模な検出ネットワークはきしみで学習します。絶え間ない急激なジャンプと、それについてのチャットです。 そして、学習ネットワークに精通している人なら誰でも最初に考えるので、学習速度の問題ではありません! 実際のところ、データはまだほとんどありません。 問題が示されています-あなたは解決策を見つけることができます! そして、それはすぐに見つかりました:WildデータセットのLabeled Faces。

FDDB、LFW、および個人用リフィルのデータセットを組み合わせたものは、元のほぼ3倍でした。 何から来たの? 言葉を減らし、写真をもっと!

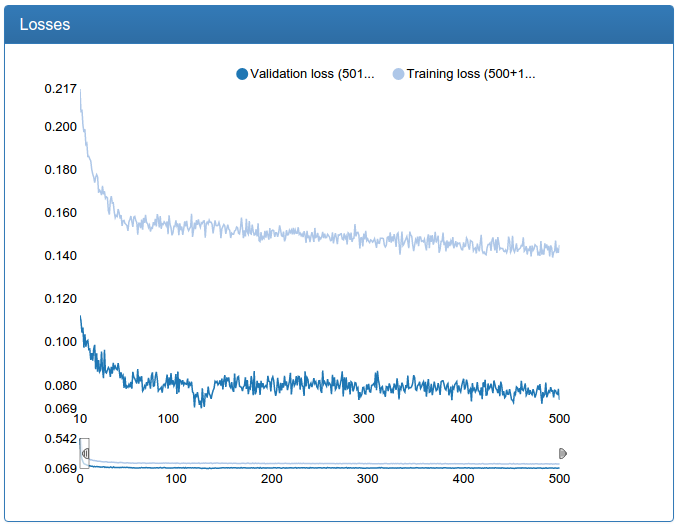

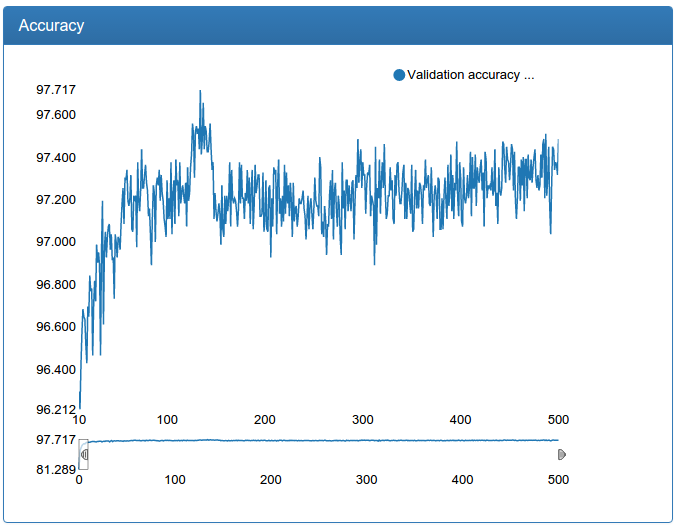

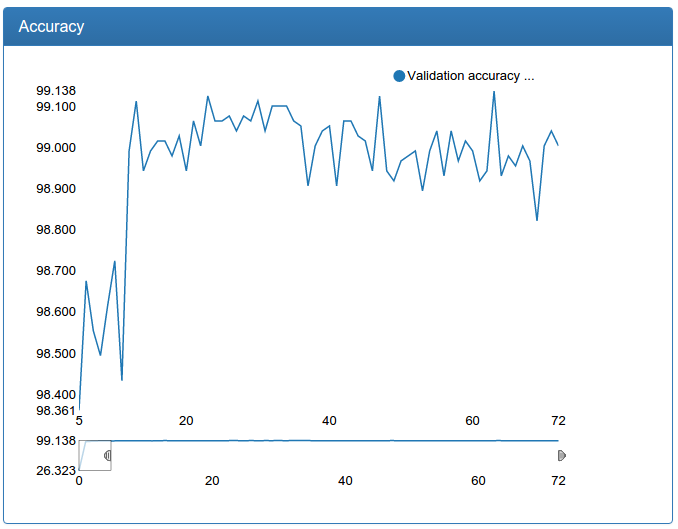

小規模なネットワークは著しく安定しており、収束が速くなり、結果が良くなります。

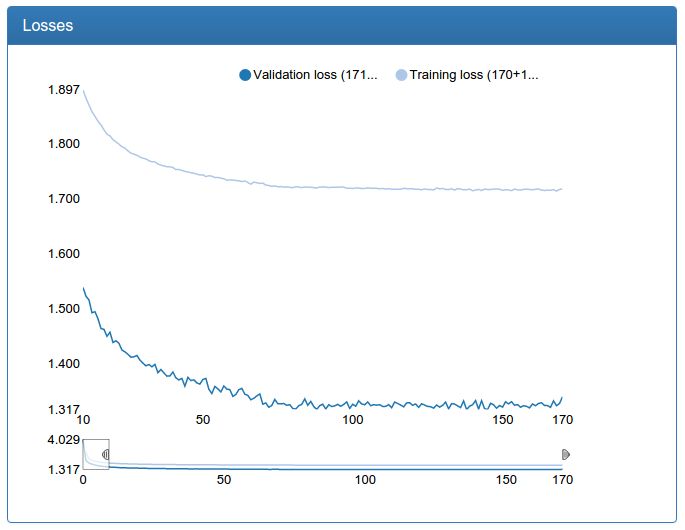

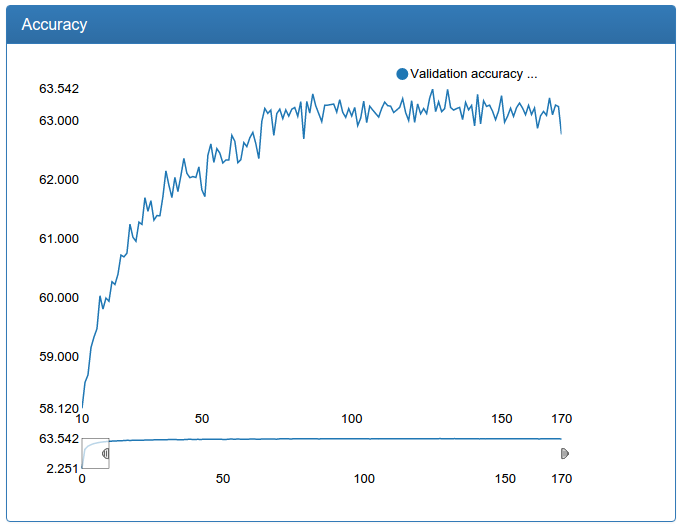

また、大規模なネットワークは著しく安定しており、バーストが消滅し、収束が速くなり、結果は突然わずかに悪化しますが、0.17%は許容できるエラーのようです。

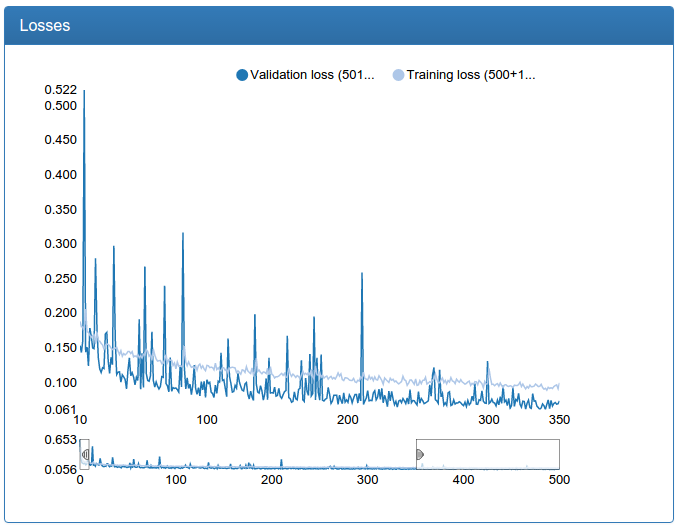

さらに、このデータ量の増加により、検出用の大規模モデルをさらに増やすことができました。

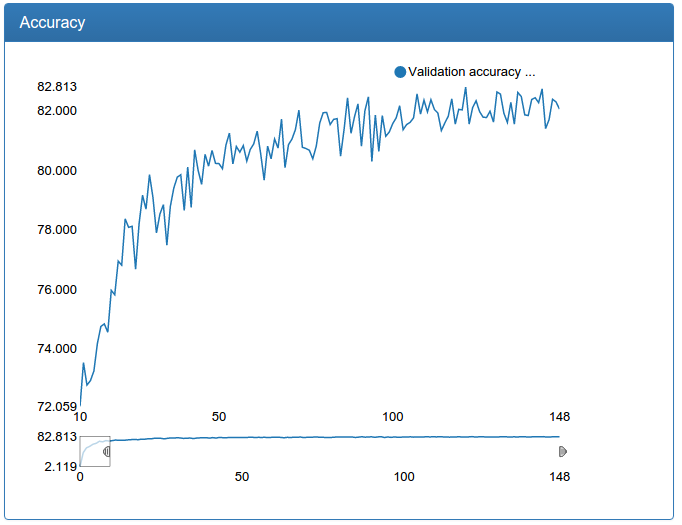

モデルはさらに速く収束し、より良い結果になり、非常に安定していることがわかります。

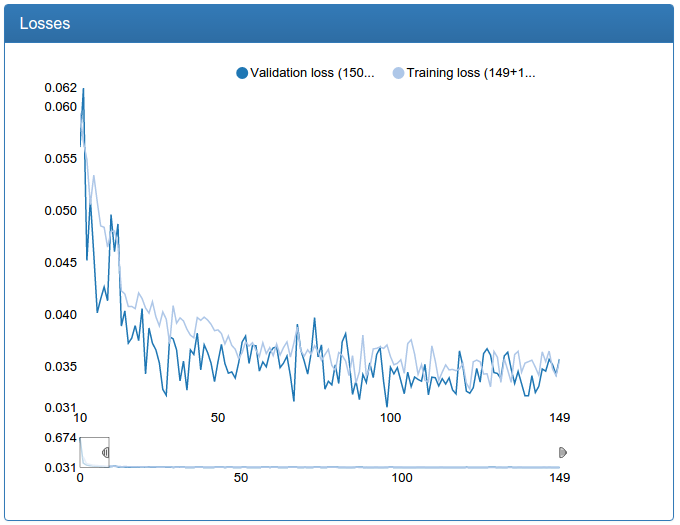

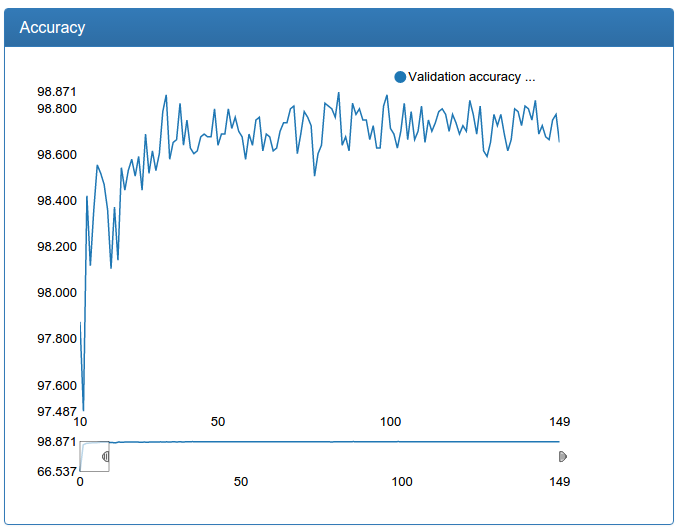

同時に、より多くのデータを使用してネットワークの再トレーニングとキャリブレーションを行いました。

小さな校正:

と大きなキャリブレーション:

検出ネットワークとは対照的に、ここでは劇的な改善が見られます。 これは、元のトレーニングセットが拡張されておらず、元のネットワークがデータ不足に大きく苦しんでいるのは、拡張前の検出用のネットワークが苦しんでいたためです。

検出準備完了

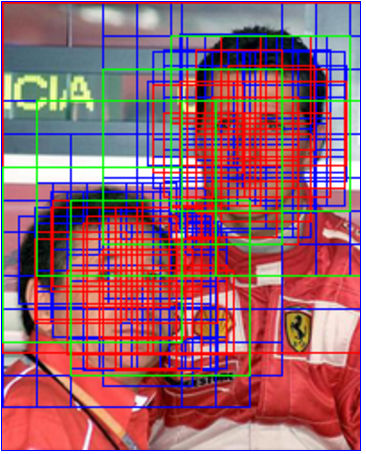

パイプライン全体を示す画像(分類1、キャリブレーション1、フィルタリング、分類2、キャリブレーション2、フィルタリング、分類3、キャリブレーション3、フィルタリング、グローバルフィルタリング、トレーニングセットの顔は白でマークされています):

成功!

多重解像度

この瞬間までに、恐竜が古代(4年前:)のテクニックを使用していると考えている人は、恐らくすでに流行を追いかけているでしょう。 そして、ここにあります!

arxiv.orgのオープンスペースでは、興味深いアイデアが取り上げられました。さまざまな解像度で畳み込み層のフィーチャカードを数えましょう。ネットワークを複数の入力にすることが一般的です:NxN、(N / 2)x(N / 2)、(N / 4)x(N / 4)好きなだけ! そして、同じ方法で、異なる方法でのみ削減します。

次に、最終分類子については、すべてのカードが連結され、実際には異なる解像度を見ることができます。

左側にあり、右側になりました(非常に中央のネットワークで測定)。

私の場合、複数の解像度を持つネットワークがより速く収束し、ハングが少し少ないことがわかります。 それにもかかわらず、中小規模のネットワークはあまり正確ではないため、機能していないという考えを拒否し、複数の許可の代わりに大規模なネットワークを単純に増やしてさらに大きな成功を収めました。

バッチ正規化

バッチ正規化は、ネットワークの正規化手法です。 アイデアは、各入力レイヤーが前のレイヤーの結果を取得するというもので、これにはほとんどすべてのテンソルを含めることができ、その座標は何らかの形で分布しています。 また、すべてのレイヤーに対応する固定分布からの座標を使用して入力テンソルに入力されると、レイヤーにとって非常に便利です。入力データの分布パラメーターに不変な変換を学習する必要はありません。 さて、すべてのレイヤーの間に計算を挿入して、前のレイヤーの出力を最適化して、次のレイヤーへの圧力を軽減し、より良い仕事を行えるようにします。

このテクニックは私を大いに助けてくれました。同じモデルの品質を維持しながら、ドロップアウトの可能性を減らすことができました。 ドロップアウトの可能性を減らすと、ネットワークの収束が速くなります(バッチを正規化せずにこれを行うと、より多くの再トレーニングが行われます)。 実際、文字通りすべてのグラフで結果を確認できます。ネットワークは最終品質の90%にすぐに収束します。 バッチの正規化前は、エラーの低下はずっと穏やかでした(残念ながら、DeepEventがなかったため、結果は保存されませんでした)。

インセプトロン

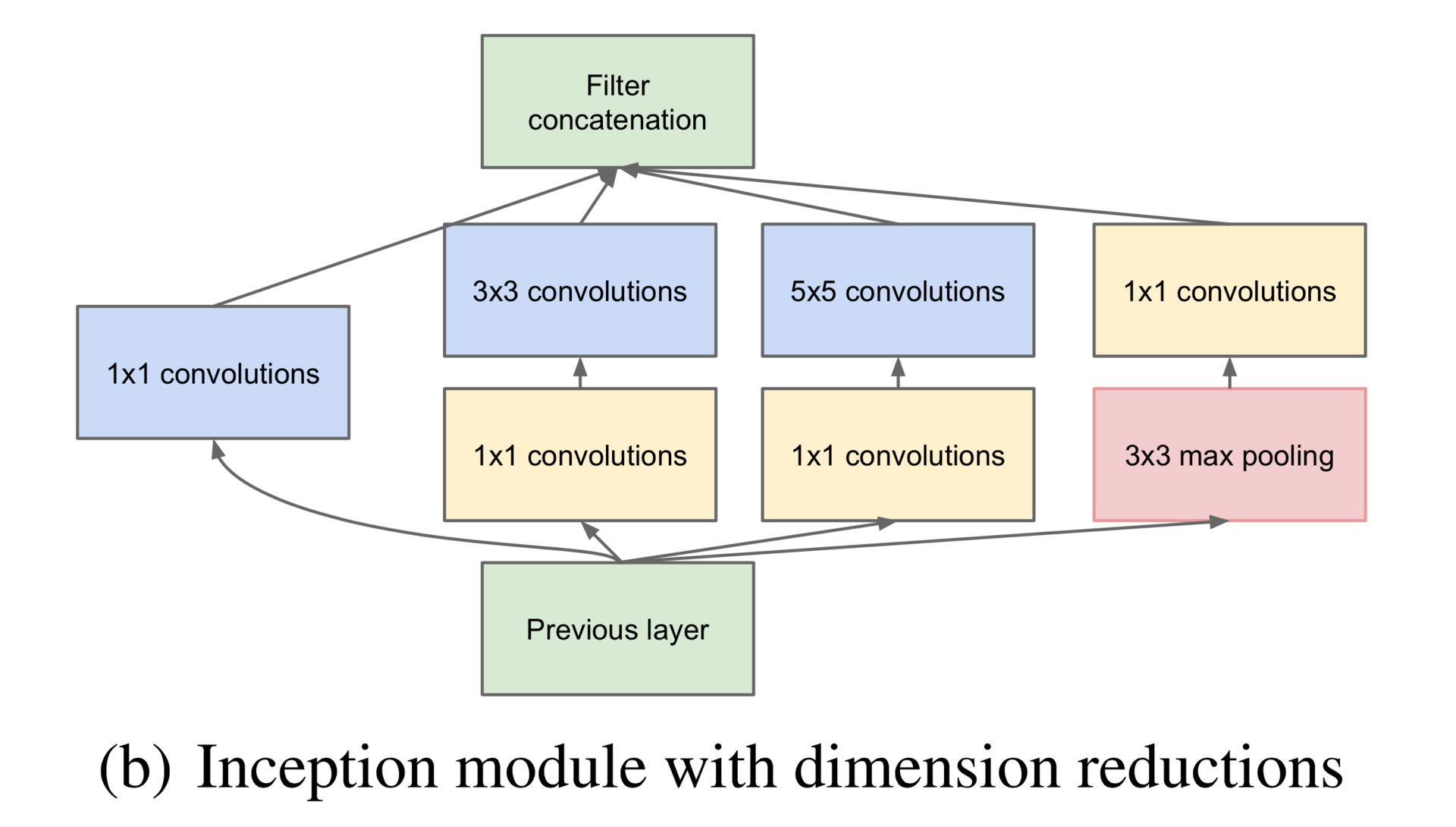

もちろん、現代のアーキテクチャをいじることに抵抗することはできず、Inceptronをトレーニングして顔(GoogLeNetではなく、はるかに小さいネットワーク)を分類しようとしました。 残念ながら、このモデルはTheanoで正しく実行できません。ライブラリは任意のサイズのゼロパディングをサポートしていないため、Inception-moduleのブランチの1つ、つまりこの図の正しいものを削除する必要がありました。

さらに、GoogLeNetのように、7つのモジュールではなく、3つのインセプションモジュールのみが互いの上にありました。最初の出口はなく、最初の通常の畳み込みプルレイヤーはありませんでした。

def build_net64_inceptron(input): network = lasagne.layers.InputLayer(shape=(None, 3, 64, 64), input_var=input) network = lasagne.layers.dropout(network, p=.1) b1 = conv(network, num_filters=32, filter_size=(1, 1), nolin=relu) b2 = conv(network, num_filters=48, filter_size=(1, 1), nolin=relu) b2 = conv(b2, num_filters=64, filter_size=(3, 3), nolin=relu) b3 = conv(network, num_filters=8, filter_size=(1, 1), nolin=relu) b3 = conv(b3, num_filters=16, filter_size=(5, 5), nolin=relu) network = lasagne.layers.ConcatLayer([b1, b2, b3], axis=1) network = max_pool(network, pad=(1, 1)) b1 = conv(network, num_filters=64, filter_size=(1, 1), nolin=relu) b2 = conv(network, num_filters=64, filter_size=(1, 1), nolin=relu) b2 = conv(b2, num_filters=96, filter_size=(3, 3), nolin=relu) b3 = conv(network, num_filters=16, filter_size=(1, 1), nolin=relu) b3 = conv(b3, num_filters=48, filter_size=(5, 5), nolin=relu) network = lasagne.layers.ConcatLayer([b1, b2, b3], axis=1) network = max_pool(network, pad=(1, 1)) b1 = conv(network, num_filters=96, filter_size=(1, 1), nolin=relu) b2 = conv(network, num_filters=48, filter_size=(1, 1), nolin=relu) b2 = conv(b2, num_filters=104, filter_size=(3, 3), nolin=relu) b3 = conv(network, num_filters=8, filter_size=(1, 1), nolin=relu) b3 = conv(b3, num_filters=24, filter_size=(5, 5), nolin=relu) network = lasagne.layers.ConcatLayer([b1, b2, b3], axis=1) network = max_pool(network, pad=(1, 1)) network = DenseLayer(lasagne.layers.dropout(network, p=.5), num_units=256, nolin=relu) network = DenseLayer(lasagne.layers.dropout(network, p=.5), num_units=2, nolin=linear) return network

そして、私もやった!

結果は、以前にトレーニングした通常の畳み込みネットワークよりも1%悪いですが、価値もあります! ただし、4つの開始モジュールのうち、同じネットワークをトレーニングしようとすると、安定して分散しました。 このアーキテクチャ(少なくとも私の変更を加えたもの)は非常に不機嫌だと感じています。 さらに、何らかの理由でバッチの正規化により、このネットワークは着実に完全なスプリットに変わりました。 ここでは、Lasagneのバッチ正規化の準職人的実装を疑っていますが、一般的にこれにより、InceptronをTensorflowでより明るい未来に延期しました。

ところで、Tensorflow!

もちろん、私も試してみました! このファッショナブルなテクノロジーを試してみたのは、救世主であるGoogleに大きな希望と賞賛を抱いた同じ日です! しかし、いや、彼は希望に応えていませんでした。 複数のGPUの自動使用の宣言については言及されていません。操作は、手で異なるカードに配置する必要があります。 サーバーに配置できなかった最後のkudaでのみ機能し、libcのハードコードバージョンがあり、別のサーバーで起動しませんでした。また、dockerコンテナーでは機能しないblazeを使用して手動で組み立てられました。 要するに、彼との仕事のモデルは非常に良いものの、いくつかの失望です!

テンソルボードも失望した。 詳細を知りたくありませんが、すべてが好きではなかったので、DeepEventと呼ばれる監視の開発を始めました。これは、記事で見たスクリーンショットです。

次のシリーズでは:

絵文字、既製のシステム、結果、そして最後に、かわいい女の子!