科学データの量は驚くべき速度で増加しているため、新しい数学的方法と分析方法が必要です。 データセットは、たとえばニューラルネットワーク、天体物理学、または医学に関連する多くの分野でますます複雑になっています。

ノースイースタン大学(米国)の物理学者Alessandro Vespignani(Alessandro Vespignani)は、株式市場の行動のモデリング、選挙結果やその他の統計上の問題の予測に従事しています。 彼はソーシャルネットワークから受信した数テラバイトのデータを自由に使用でき、それらのほとんどすべて[データ]は構造化されていません。

Vespignaniは、収集したデータを処理するために、さまざまな数学的ツールと方法を使用しています。 彼は何百万ものツイートをソートし、キーワードを検索します。 Vespignaniは、ビッグデータ分析に対して効果的に段階的なアプローチを取ります。 しかし、イェール大学の数学者ロナルド・コイフマンは、膨大な量の情報を収集して保存するだけでは不十分であり、適切に編成する必要があり、これには特別な構造が必要であると主張します。

頂点とリブ

13世紀に生まれたケーニヒスベルク市(現在のカリーニングラード)は、プレゴル川の島々と銀行に位置する3つの正式に独立した都市集落で構成され、4つの主要な部分に分かれていました。 これらの4つの土地区画は、7つの橋で相互に接続されていました。 18世紀、数学者のレオンハルトオイラーは当時人気のあった謎に戸惑いました。ケーニヒスベルクの7つの橋すべてを渡り、それぞれの橋を2回踏まずに出発点に戻るにはどうすればよいのでしょうか。

それを解決するために、オイラーは点と線からモデルを構築し、偶数個の橋が各「地球の島」につながる場合にのみ問題が解決することを発見しました。 ケーニヒスベルクには奇数の橋があったため、この旅は不可能でした。

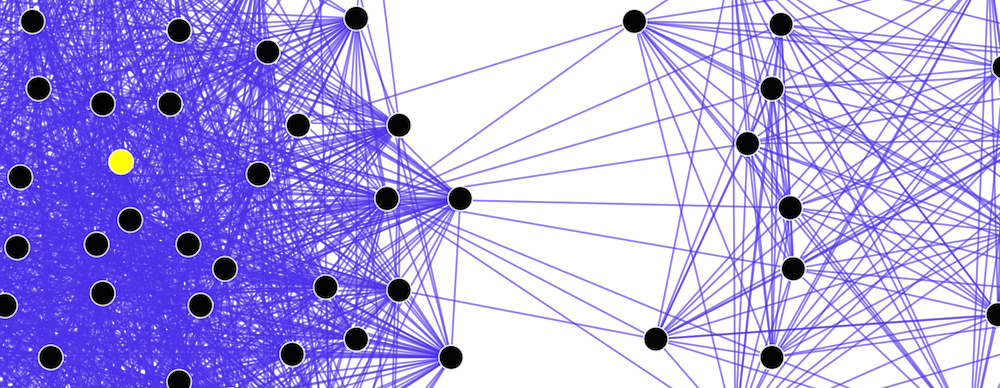

オイラーの考えに基づいて、スタンフォード大学の数学者グンナーカールソンは、面倒なデータセットを頂点とエッジのネットワークとして表すデータマップの構築を開始しました。 このアプローチはトポロジカルデータ分析(TDA)と呼ばれ、Gunnarによれば「非構造化データを構造化して、後で機械学習法を使用して分析できるようにします」。 ビデオで、カールソンはトポロジカル分析が研究者が大きなデータセットを解釈するのにどのように役立つかを説明します。

橋についてのパズルの場合のように、ここではすべてが接続と「接続」されています。 ソーシャルネットワークは、頂点が名前で、エッジが接続である、人々の間の関係のマップです。 カールソンは、このアプローチを他の分野、例えばゲノム配列を扱うために使用できると信じています。 「シーケンスを比較して、違いの数を特定できます。 結果の数値は距離の関数として表すことができ、それらがどれだけ異なるかを示します」とカールソンは説明します。

Carlsson Ayasdiプロジェクトはこのために作成されました。高次元データの表示を単純化します。 多次元データセットに155個の変数がある場合、クエリはどのようになり、すべてを一度に考慮しますか? カールソンは、この作業を暗いガレージでハンマーを見つけることと比較しています。 懐中電灯を持っている場合、ガレージの内容を順番に見て、必要なツールに出くわします。このプロセスは非常に長く、夢中にさせることができます。 ライトを点灯する方がはるかに効率的です。ハンマーと釘の箱の両方がすぐに見つかりますが、それらが必要になるとは思わなかったでしょう。 Ayasdiテクノロジーは電球を照らすだけです。

トポロジカル手法を使用すると、複雑なオブジェクトを平面に投影するようになります。 危険は、シャドウシアターの幻想のようないくつかのパターンが実際には存在しないという事実にあります。 さらに、多くの科学者は、トポロジカル手法は一般に一部のデータセットには適用できないと考えています。 データセットがゆがんでいるか不完全な場合、完全に不正確な結果をもたらす可能性があります。

オッカムのカミソリ

2004年2月、スタンフォード大学の数学者エマニュエルカンデスは、ぼやけた画像を改善する方法を見つけようとしました。 Candesは開発されたアルゴリズムの1つを適用し、わずかな改善が見込まれると予想していましたが、彼は明確なイメージを持っていました。 Candesによると、この確率は、最初の3桁を知っている銀行カード番号の10桁を推測する確率と同じでした。 しかし、それは偶然ではありませんでした。 このメソッドは他の画像でも機能しました。

成功の鍵は、いわば、オッカムのカミソリの数学的バージョンでした。特定のファジー画像を再構築するための数百万の可能なオプションの中で、最も単純なバージョンが最適です。 この発見により、圧縮センシングの手法が生まれました。

今日では、ネットワークを介したビデオ放送で使用されています。 ビデオを送信するときのデータ量は非常に大きいため、圧縮する必要があります。 通常、データを圧縮するには、まずすべてのビットを取得してから、重要でないビットを破棄する必要があります。 圧縮センシング方式を使用すると、事前に保存することなく、重要なビットを判別できます。

「希少疾患の集団をスクリーニングする場合、すべての人の血液検査が必要ですか? 答えはノーです。 望ましい「要因」は非常にまれであるため、つまり、それがまばらであるため、わずかなテストを実行するだけで十分です」とCandesは述べています。 32人のグループに1人が感染しているとします。 分析のためにそれぞれから採血しました。 テストが陰性の場合、感染はありません。 しかし、結果が肯定的な場合、感染者を見つける方法は?

Candesは、サンプルの半分を採取(16)し、再分析できると考えています。 結果が陽性の場合、感染者はこのグループに属し、そうでない場合は別のグループに属します。 その後、グループは再び半分に分割され、テストが繰り返されます。 したがって、それぞれを個別にテストすると、32回ではなく5回のテストで回答が得られます。 これが圧縮センシング方式の本質です。

圧縮センシング方式は、一部のデータが失われたり破損したりしている大規模なデータセットに役立ちます。 良い例は、診療記録の処理であり、その一部は診療所のスタッフによってタイプミスがあります。 別の例としては、顔認識システムがあります。眼鏡をかけたとしても、それでも認識できます。

CandesはCompressed Sensingを称賛しますが、Karlssonはトポロジカルアプローチを採用しています。 ただし、これら2つの方法は互いに補完するだけで、競合することはありません。 「結局のところ、データサイエンスは方法論の総和以上のものです」とVespignaniは主張します。 「いくつかの方法を組み合わせることで、まったく新しいものを作成できます。」

PS最近、私たちは初心者向けの機械学習のソースの選択を公開し、ディープラーニングについて話しました 。 もちろん、私たち自身の経験も共有しています。量子通信システムの開発について、そして普通の学生から高度なプログラマーをどのように準備するかについて少しです。