次の日は私たちに何をもたらすでしょうか? 20〜30年後、私たちはどの世界に住むのでしょうか。 未来はとても刺激的で不確実です。 古代のように、そして今、オラクル、魔術師、先見者に質問をする人々の流れは乾ききっていません。 多くの場合、人々は明日ではなく、はるかに遠い未来に興味を持っています。人間の寿命の長さという点では無限です。 「完全なナンセンス」のように見えますが、それが人間の本質です。 19世紀から、新しい先見者たちが高貴な長老、つまりSF作家の代わりになりました。

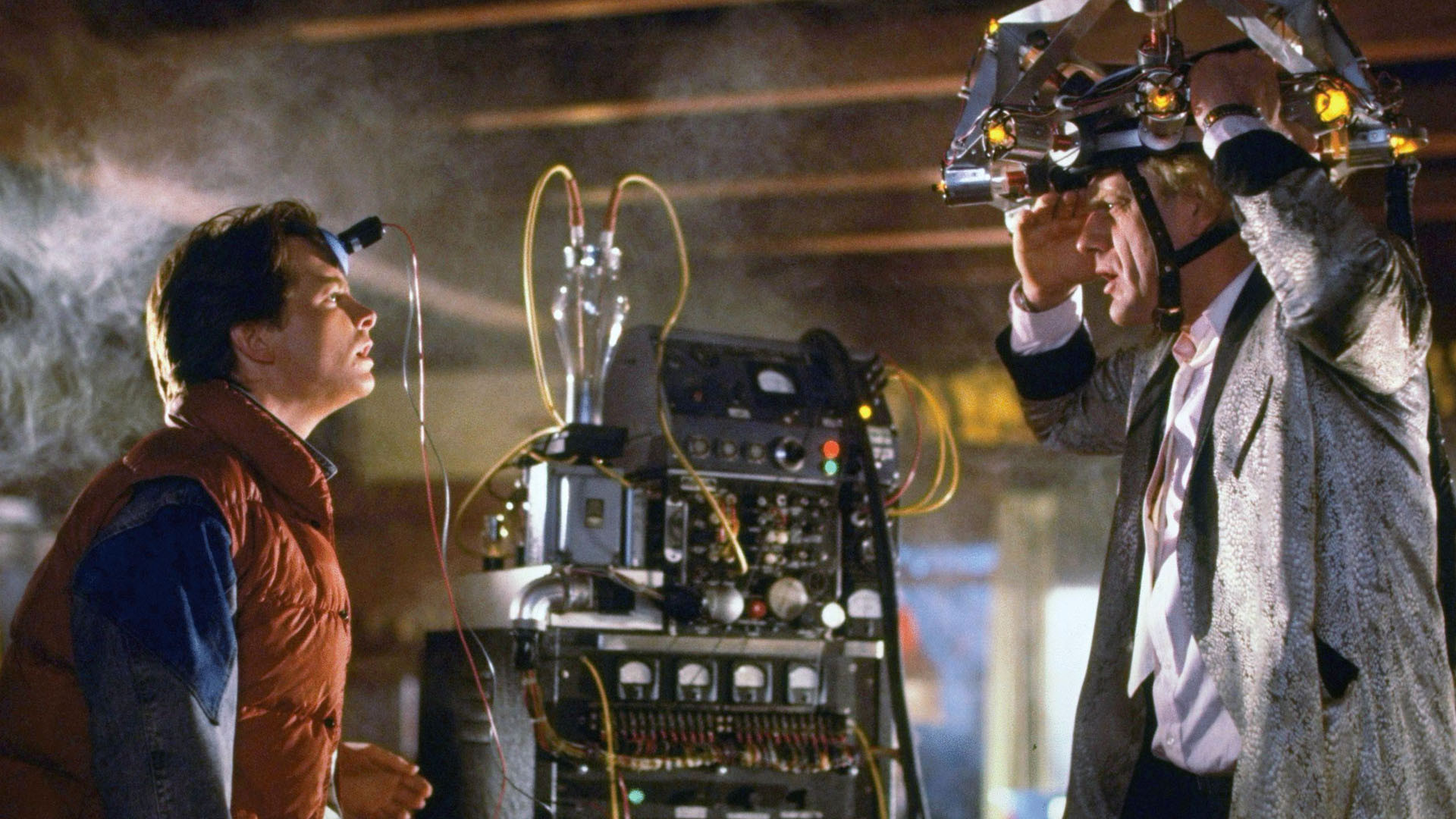

1989年にワイドスクリーンで公開された壮大な3部作「バックトゥザフューチャー」の第2部を最近レビューしたところ、迫り来る2015年には、私たちの都市の通りは空飛ぶ車、家庭用エネルギーリアクター、ゴミを処理できない、ユートピア、ホログラフィック映画館-過去の四半世紀にわたる雑誌のパイプ神話、さらには防塵カバーさえ発明されていません。 同時に、私たちの日常生活の一部の領域では、先見はかなり正確でした。

上記に触発された反省は、データストレージセンターに影響を与えたこれらのイノベーションのより詳細な理解を促しました。 はい、過去数年間、同じIntelがプロセッサラインナップを更新してきましたが、ソフトウェアも静止していませんが、これによりデータセンターの機能の重大な変更について話す権利が与えられますか? 過去10年間でよく耳にするイノベーションを詳しく見てみましょう。 現在、実装のどの段階にありますか?

低エネルギー効率比(PUE)

2007年にグリーングリッドがエネルギー効率測定(PUE)を初めて導入したとき、国立研究所 Lawrence Barclayは、20のデータセンターの調査結果に関するレポートを公開し、平均PUEが2.2であることを示しました。 明らかに、企業はPUEの価値を可能な限り最小にすることに常に関心があるわけではありません。エネルギー効率は、大規模な金融投資と技術的な困難に関連しており、新しいデータセンターの構築に追加の問題を引き起こします しかし、この方向では、GoogleやFacebookなどのITの巨人が良い例を提供します。 データセンターの特徴は1.2〜1.3のPUEであり、エネルギー効率のリーダーになっています。 同時に、世界の研究機関の分析に基づいて2013年に公開された資料は、調査時点で、世界の既存のデータセンターの平均PUEレベルが2.0をわずかに上回っていることを示しました。 データセンターのエネルギー効率の問題に対するソリューションは、ITインフラストラクチャの運用コストを削減するために解決しなければならない主要な目標です。

ダウンタイム

長い間、情報システムエンジニアは、すべてのネットワーク機器が1日24時間、最大の生産性で動作するはずだと考えていました。 現時点では、サーバープラットフォームの広範な可用性により、特定のプログラムまたは一部のネットワークオプションの操作をサポートするためだけに永続的に動作する多数の分離されたクラスターがあり、その結果、膨大な数のサーバーが存在するという事実に直面しています彼らの時間のほとんどは、単に関与していません。 調査会社McKinseyが発行したレポートは、調査が実施されたデータセンターで、無制限にアイドル状態にあるサーバーの割合が30%に達したことを示しました。 過去10年間に、サーバーのダウンタイムの削減に役立った仮想化の方向で多くのことが行われましたが、この課題は依然として非常に深刻です。 大規模なインターネット企業はすでに仮想化を非常に効率的に使用しており、これはビジネスを行うことの収益性を高める要因の1つです。 2014年にマーケティング会社Gartnerが実施した評価によると、x86プラットフォームのワークロードの最大70%が特に仮想化システムに関連しています。 それまでの間、データセンターの所有者は既存の施設を合理的な最小値に引き上げることはせず、サーバーはそのような貴重な電力をアイドル時間に使い続けます。

水冷

もちろん、この種の冷却は今日では発明されていません。 20世紀の60年代に、大量の電力浪費コンピューターの中断のない動作のために、液体ベースの冷却方式が使用されました。 現代のスーパーコンピューターでは、液体冷却も目新しいものではありませんが、データセンターでこのような技術を使用することは一般的ではありません。 多くの場合、これらは実験施設であり、そのようなシステムの使用はかなりまれです。 同時に、理論は、液体が空気よりも何千倍も効率的にサーバーキャビネットの作業機器から過剰な熱を除去できることを示しています。 しかし、残念ながら、データセンターの所有者は、規模の大小を問わず、既存のインフラストラクチャを変更したり、液体環境にある機器を扱う従業員の文化を変えたり、大規模なデータセンターの例が不足したりするため、この技術を広く適用することを依然として恐れていますそのようなシステムが機能している場合。 液体冷却の使用の成功例は、2013年に作成されたデータセンターがスーパーコンピューターを提供する2013年に作成されたNational Renewable Energy Laboratory(Perigrin、米国)であり、PUEが1.06という驚異的なレベルで示されています! また、寒い時期にペリントン市に設置されたシステムは、機器から放出される熱を国立研究所のキャンパスの暖房に向けることができます。 液体冷却技術の普及の推進力となるのは、このような前向きな例です。

ピーク負荷分布

ピーク負荷は、まさにネットワークインフラストラクチャの惨事であり、エンジニアの悪夢です。 そのため、日中の私たちの生活のリズムが、データセンターの容量の不均等な消費を決定づけることになりました。 したがって、現地時間の約19:00から21:00までの時間間隔でお気に入りのソーシャルネットワークのページをロードする際に問題が発生しないように、ネットワークサービス会社は過剰な量のコンピューティングパワーを含めることを余儀なくされます。その後、需要がありません。 はい、もちろん、ネットワークエンジニアはこの問題を解決する方法を見つけます:ここで、キャッシュ、およびサーバークラスター間で負荷を再分散するインテリジェントシステム。 しかし、少なくとも1分間、ネットワークの遅延を排除(最小化)できたらどうなるか想像してみてください。 これにより、地球上の既存の通信インフラストラクチャ全体が根本的に変わります。 それまでの間、私たちには事実があります。地球の赤道の底までの距離をカバーするために、電磁波には64ミリ秒が必要です。 経路の不規則性、ネットワークインフラストラクチャの機能に関連する要求の応答の遅延、およびその他の多くの要因を考えると、現時点では、世界のさまざまな地域間でコンピューティングリソースのかなり効率的な転送を編成することは非常に問題であり、企業は提供するサービスに満足していない多くの猛烈な顧客を獲得するリスクを抱えています。

データセンターインフラストラクチャ管理(DCIM)

現在は「不安定」な状態にあるもう1つの素晴らしい始まりです。 DCIMの哲学には、データセンターの管理と機能のための統一された標準を作成するという原則が含まれています。 ハードウェア、ソフトウェア、および管理アプローチの標準化は、ネットワークインフラストラクチャの製造と保守の両方のコストを削減するために大きな貢献をすることができます。 この方向の動きは、統一係数PUE、CUE、DCeの出現と呼ばれます。 オープンソースソフトウェアにもっと注意を払い、それに基づいて企業間プロジェクトを実装するという、大手IT大手による最近の統合声明は、この目標に向けたもう1つのステップです。 しかし、州と商業の両方のさまざまな種類の利益のために、統一のプロセスは非常に遅いです。 最後に、断片化のコストを支払います。

モジュラーデータセンター

ここでは、明らかな進歩に注目する価値があります。 2003年以来、Googleの最初の特許技術である、1日で世界中のどこにでも配送できるサーバー機器を詰めたコンテナの技術と、そこに実質的に本格的なデータノードをセットアップすることは、本当に驚くべきことです。 もちろん、必要な通信チャネル、およびこれらのコンテナが設置される場所については忘れないでください。メンテナンススタッフが非常に重要な役割を果たします。 それでも、これは明らかな突破口です。 現時点では、新しいデータセンターを作成するためのコンテナアプローチは、IT市場の主な参加者を満足させています。 設備移転の機動性、配備の速度、統一、および親工場の優秀な労働者による高品質の組み立て-これらすべての品質は、民間組織と軍の両方から高く評価されました。 テクノロジーアプリケーションの既存の例の数は数百です。

緯度48以北のデータセンター

北の気候条件でのデータセンターの建設は、意識を刺激する他のいくつかのアイデアと同様に、今日では広く支持されていません。 一部の専門家の推定によると、緯度48のすぐ北にあるデータセンターを構築するのが最も効率的です。これは、サーバールームの低コストの大気冷却に最も適した条件です。 データセンターの配置に関する既存の地理を分析すると、少なくともこの点に関してはヨーロッパのみが注目されます。 スウェーデンとフィンランドのデータセンターがすぐに思い浮かびます。これには、Luleåに1つのGoogleデータセンターしかありません。 しかし、これらは依然としてかなり孤立したケースであり、グローバルプロバイダーは、インフラストラクチャの頭脳を能力の直接の消費者に近づけることに焦点を当てる可能性が高く、ネットワークの可能な限り低い遅延を優先し、潜在的な顧客を失うリスクを避け、運用コストを下げることを望んでいます。

メインライン-リスクなし

既存のデータセンターの主な傾向を見て、新しいデータセンターを設計すると、結論が示唆されます。 このような若くて急速に発展しているIT企業は、その種の革命家であり、かなり保守的な、しかし骨化されていない場合の市場行動モデルをリードしており、新しい有望な開発の広範な導入を妨げています。 既存のネットワークインフラストラクチャの効率を向上させるために、具体的な例ですでに進行方向の肯定的な結果がすでに示されている場合でも、事業者と設計者は、最小限のリスクを受け入れる準備ができていません。 おそらく、すべてのニュアンスを詳細に調べた場合、これには独自のより高いロジックが含まれている可能性があります。 しかし、結論は少し悲観的です。2015年にバックトゥザフューチャー3部作の作成者が予測した空飛ぶ車を待たなかったのと同じように、私たちはそれらをさらに四半世紀待たないでしょう。