最近発表された無害な見出しの記事は、おそらく逆伝播アルゴリズムの発明以来、ニューラルネットワークの世界で最大のニュースです 。 しかし、そこには何が書かれていますか?

Googleディープラーニングプロジェクトの著者を含むチームであるクリスチャンセゲディ、ウォジチェフザレンバ、イリヤサツケバー、ジョアンブルーナ、ドゥミトルエルハン、イアングッドフェロー、ロブファーガスによるニューラルネットワークの興味深い特性の記事では、ニューラルネットワークの動作に関する2つの発見について簡単に説明しています以前考えていたものとは逆です。 そして、率直に言って、そのうちの1つは驚くべきものです。

最初の発見は、ニューラルネットワークがデータを整理していると私たちが長い間信じていたという仮定に疑問を投げかけます。 長い間、各レベルの多層ネットワークでは、ニューロンは次の層の特徴を認識するように訓練されていると考えられていました。 最後のレベルが重要な、通常は重要な機能を認識できるという仮定は、それほど強力ではありませんでした。

これが実際に該当するかどうかを調べる標準的な方法は、特定のニューロンについて、出力値を最大化するような多数の入力データを見つけることです。 このセットが強調表示する機能が何であれ、ニューロンはそれに特別に応答すると想定されます。 たとえば、顔認識タスクでは、ニューロンは画像内の目または鼻の存在に応答できます。 しかし、注意してください-そのような機能が人が作るものと一致する理由はありません。

個々のニューロンの特徴は、ニューロンのランダムなセットの特徴と同じくらい意味があると解釈できることがわかった。 つまり、多数のニューロンをランダムに選択し、出力値を最大化する画像を見つけた場合、これらの画像は1つのニューロンの場合と同じ意味論的に類似しています。

これは、ニューラルネットワークがデータを「デスクランブル」せず、出力層などの個々のニューロンの機能を表示することを意味します。 ニューラルネットワークが抽出する情報は、ニューロンの1つに集中しているため、すべてのニューロンに分散されます。 これは興味深い発見であり、さらに興味深いことにつながります...

各ニューラルネットワークには 、正しく分類されている入力データのセットがあり、正しく認識されないという意味で「ブラインドスポット」があります。

ニューラルネットワークの研究の最初から、ニューラルネットワークは一般化できると想定されていました。 つまり、特定の写真セットを使用して猫の画像を認識するようにネットワークを訓練すると、正しく訓練されていれば、以前に会ったことのない猫を認識することができます。

この仮定には、ニューラルネットワークが猫の写真を「猫」として分類すると、この画像のわずかに変更されたバージョンも分類されるという、さらに「明白な」ものが含まれていました。 このような画像を作成するには、いくつかのピクセルの値をわずかに変更する必要があり、これらの変更が小さくなるまで、人は違いに気付かないでしょう。 おそらく、コンピューターもそれに気付かないでしょう。

そうかもしれないが、これはそうではない。

研究者の仕事は、正しく分類された例から始まり、誤った分類につながる入力値の小さな変化を見つけようとする最適化アルゴリズムの発明でした。 もちろん、そのような変化が存在することは保証されていません-そして、前述のニューラルネットワークのシーケンスに関する仮定が正しい場合、検索は結果をもたらしません。

ただし、結果があります。

ニューラルネットワークとソースデータのさまざまなセットについて、そのような「矛盾する例」が正しく認識されたものから生成される可能性が非常に高いことが証明されました。 記事を引用する:

調査したすべてのネットワークと各データセットについて、常に正しく認識されない、非常に類似した視覚的に区別できない矛盾した例を生成しています。

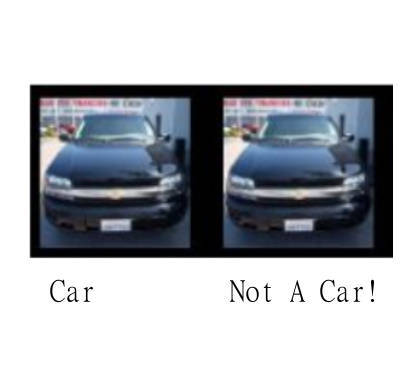

明確にするために、人にとっては、初期画像と矛盾する画像は同じように見えますが、ネットワークはそれらを別々に分類します。 2枚の写真を撮ることができます。2匹の猫だけでなく、同じ猫でも人の視点から見ることができますが、コンピューターは一方を正しく認識し、もう一方を認識しません。

右側の画像は正しく分類され、左側の画像は正しくありません。 中央では、2つの画像の違いに10を掛けて、違いが見えるようにします。

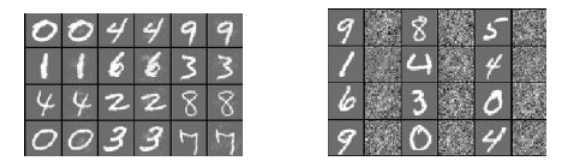

左の図では、奇数列は正しく分類されていますが、偶数列は正しく分類されていません。 右の写真では、すべてが正しく認識されています。元の画像のランダムな歪みも偶数列で表示されています。 これは、変更は非常に具体的でなければならないことを示しています。矛盾の例を見つけるには、厳密に定義された方向に移動する必要があります。

さらに顕著なのは、これらのすべての例を統一しているように見える特定の普遍性です。 例の比較的大きな割合は、共通のデータでトレーニングされたが、異なるパラメーター(レイヤー数、正則化、または初期係数)でトレーニングされたネットワークと、異なるデータセットでトレーニングされた同じパラメーターを使用したネットワークの両方で誤って認識されます。

上記の観察結果は、例の不整合がグローバルなものであり、 再トレーニングの結果だけではないことを示唆しています。

これはおそらく結果の最も顕著な部分です。正しく分類された例ごとに、元の例と区別できない別の例がありますが、どのニューラルネットワークまたはトレーニングセットが使用されたかに関係なく誤って分類されます。

したがって、猫の写真がある場合、ネットワークとそのトレーニングに関係なく、ネットワークに猫を犬として認識させることができるいくつかの小さな変更があります。

これはどういう意味ですか?

研究者は積極的であり、ネットワークのトレーニングに矛盾した例を使用して、適切に機能することを保証します。 彼らは、これらの例を、ネットワークとその一般化能力を改善するために使用できる特に複雑なタイプのトレーニングデータに起因すると考えています。

ただし、この発見は単なる改善されたトレーニングセットではありません。

あなたが最初に考えるかもしれないことは、 「まあ、そして何、猫を犬として分類することができますか?」です。 しかし、状況を少し変えると、 「ディープニューラルネットワークを使用する無人車両がその前の歩行者を認識せず、道路が空いていると思ったらどうなるでしょうか?」

ディープニューラルネットワークの一貫性と安定性は、実際のアプリケーションにとって重要です。

先に述べた盲目の領域に関しても哲学的な疑問が生じます。 生物学的モデルがディープニューラルネットワークの基礎である場合、結果を適用できますか? または、より単純に、人間の脳にはそのような組み込みエラーが含まれていますか? そうでない場合、その作業を再現しようとするニューラルネットワークとはどう違うのでしょうか。 その安定性と一貫性の秘密は何ですか?

1つの説明はこれが次元の呪いの別の現れであるかもしれません。 空間の次元が大きくなると、超球面の体積がその境界に指数関数的に集中することが知られています。 ソリューションの境界が非常に大きなスペースにあることを考えると、最も適切に分類された例が境界の近くに配置されることは論理的に思われます。 この場合、例を誤って分類する機能は、正しく実行する機能に非常に近いです。最も近い境界に向かう方向を判断するだけです。

これがすべてを説明するなら、人間の脳でさえそのような効果を避けることができず、どういうわけかそれに対処しなければならないことは明らかです。 そうでなければ、猫は驚くべき規則性で犬に変わるでしょう。

まとめ

ニューラルネットワークは新しいタイプの不安定性を明らかにしており、順番に決定を下せるとは思えません。 また、トレーニングセットで矛盾する例を含む「穴を修正する」代わりに、科学は問題を調査して修正する必要があります。 これが起こるまで、安全性が重要なニューラルネットワークに頼ることはできません...