これらのテクノロジーはどれも優れていて興味津々ですが、くしゃみの誇大広告はどこにありますか?

過去10年間に3Dシューティングテクノロジーが発明され、開発され、量産に導入されたとしたらどうでしょうか。 さらに、この技術はすでに広く使用されています。 デバッグされ、店舗の一般の人々がアクセスできます。 彼女について聞いたことがありますか? (おそらくロボット工学および関連する科学分野の専門家だけが、私がToFカメラについて話していると推測しているでしょう)。

ToFカメラとは何ですか? ロシア語版ウィキペディア( 英語 )では、それが何であるかについての短い言及すら見つけることができません。 「飛行時間カメラ」は「飛行時間カメラ」に変換されます。 カメラは、光の速度によって範囲を決定し、カメラから発せられ、受信した画像の各ポイントで反射される光信号の飛行時間を測定します。 今日の標準は320 * 240ピクセルのマトリックスです(次世代は640 * 480になります)。 このカメラは、1センチメートルのオーダーの深度測定の精度を提供します。 はい、はい。 76800センサーのマトリックス。1/ 10,000,000,000(10 ^ -10)秒のオーダーの時間精度を提供します。 発売中。 150ドル。 または多分あなたもそれを使用します。

そして今、物理学、仕事の原理、そしてあなたがこの美しさに出会った場所についてもう少し。

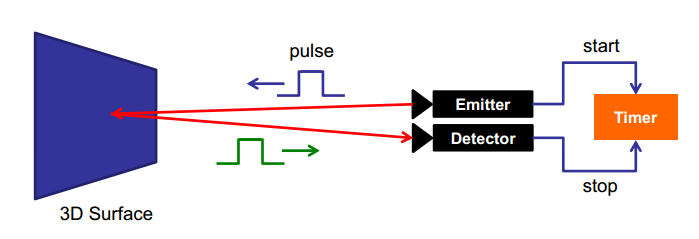

ToFカメラには主に3つのタイプがあります。 各タイプは、ポイントの範囲を測定するために独自の技術を使用します。 最も単純で最も理解しやすいのは、直接変調方式とも呼ばれるパルス変調です。 インパルスが与えられ、その戻りの正確な時間がマトリックスの各ポイントで測定されます:

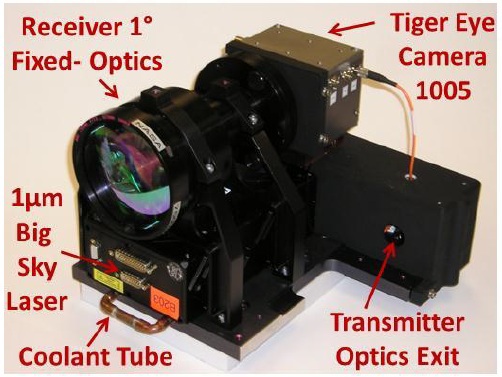

実際、マトリックスは波面に沿って発火するトリガーで構成されています。 同じ方法がフラッシュの光同期で使用されます。 ここだけが桁違いに正確です。 これがこの方法の主な難点です。 応答時間の非常に正確な検出が必要であり、これには特定の技術的ソリューションが必要です(これは見つかりませんでした)。 現在、そのようなセンサーは、その船の着陸モジュールについてNASAによってテストされています。

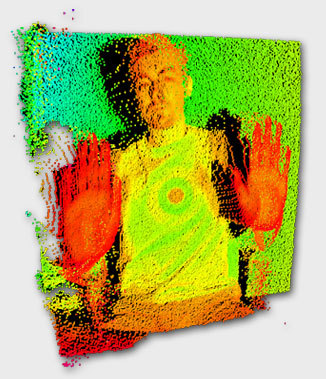

そして、ここに彼女が配った写真があります:

約1キロメートルの距離から反射された光学ストリームによってトリガーがトリガーされるように、十分なバックライトがあります。 グラフは、1 kmの距離で90%の距離に応じて、マトリックス内のトリガーされたピクセルの数を示します。

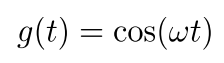

2番目の方法は、信号の一定の変調です。 エミッターは変調波を送信します。 受信機は、この波で見たものの最大相関を見つけます。 これは、信号が受信機に反射して到着するのに費やした時間を決定します。

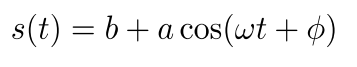

信号を放出させます。

ここで、wは変調周波数です。 次に、受信信号は次のようになります。

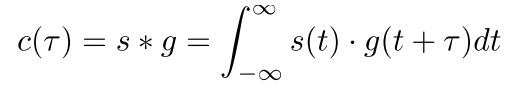

ここで、bは特定のシフト、aは振幅です。 着信信号と発信信号の相関:

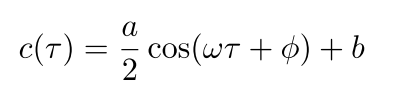

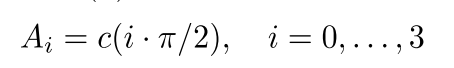

ただし、すべての可能な時間シフトとの完全な相関関係を各ピクセルでリアルタイムに生成することは非常に困難です。 したがって、耳のあるトリッキーなフェイントが使用されます。 受信信号は、位相が90°シフトした4つの隣接ピクセルで受信され、それ自体と相関します。

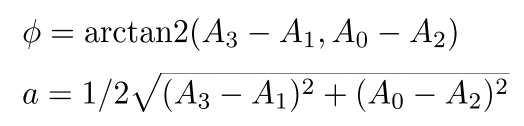

次に、位相シフトは次のように定義されます。

得られた位相シフトと光の速度を知って、オブジェクトまでの距離を取得します。

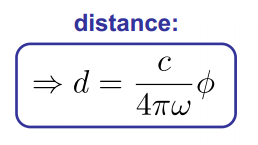

これらのカメラは、最初のテクノロジーで構築されたカメラよりも少しシンプルですが、それでも複雑で高価です。 この会社はそれらを作ります。 そして、彼らは約4キロバックスかかります。 しかし、キュートで未来的な:

3番目の技術は、レンジゲートイメージャーです。 基本的にシャッターカメラ。 ここでの考え方は非常に単純で、高精度の受信機や複雑な相関関係は必要ありません。 マトリックスがシャッターになる前。 完璧ですぐに動作するとします。 時間0で、シーンの照明がオンになります。 シャッターは時間tで閉じます。 その場合、t /(2∙c)(cは光の速度)よりも遠くにあるオブジェクトは表示されません。 光には彼らに到達して戻る時間がない。 カメラの近くにあるポイントは、露出時間tを通して照明され、明るさIを持ちます。したがって、露出ポイントは0〜Iの明るさを持ち、この明るさはポイントまでの距離を表します。 明るい-近い。

このイベントでシャッターを閉じる時間とマトリックスの動作、非理想的な光源(点光源の場合、範囲と明るさは線形ではありません)、材料の異なる反射率を導入します。 これらは、デバイスの作成者が解決した非常に大規模で複雑なタスクです。

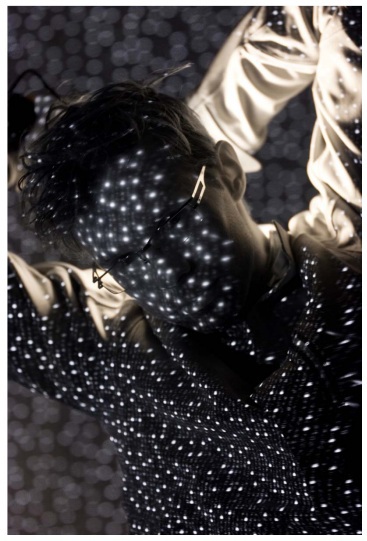

このようなカメラは最も不正確ですが、最もシンプルで安価です。カメラの複雑さはアルゴリズムです。 そのようなカメラがどのように見えるかの例が必要ですか? ここにあります:

はい、はい、2番目のKinectにはまさにそのようなカメラがあります。 2番目のKinectと1番目のKinectを混同しないでください(昔はハブ上に、まだよく混ざっていた詳細な記事がありました)。 最初のKinectは、 構造化された強調表示を使用します 。 これは、はるかに古く、信頼性が低く、遅いテクノロジーです。

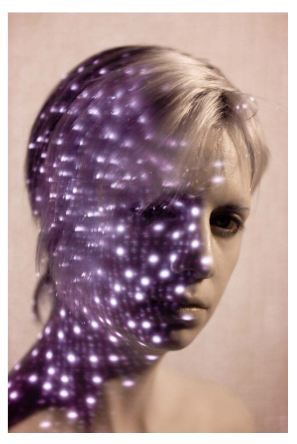

投影されたパターンを見る従来の赤外線カメラを使用します。 その歪みが範囲を決定します(方法の比較はこちらにあります )。

しかし、Kinectは市場で唯一の代表者ではありません。 たとえば、Intelは150ドルでカメラをリリースし、3D画像カードを提供します。 近いゾーンに焦点を当てていますが、フレーム内のジェスチャーを分析するためのSDKがあります。 SoftKineticの別のオプションを次に示します(これらにはSDKもあり、さらにテキサスインストゥルメントに関連付けられています)。

しかし、私自身は、これらのカメラのいずれにもまだ遭遇していないため、哀れで迷惑です。 しかし、5年後にはそれらが使用され、私の番が来ると思います。 私の知る限り、ロボットの向き付けに積極的に使用されており、顔認識システムに導入されています。 タスクとアプリケーションの範囲は非常に広いです。