アレキサンドリンスキー劇場の新しいステージの一部として作成された、技術的なメディアパフォーマンスについて話している。 パフォーマンスの主役は、パフォーマーの感情的な状態と思考です。 まず、ソーシャルの公式説明。 ネットワーク:

メディアパフォーマンス「Neurointegrum」は、現代の国内シーンにおける現代技術の成果を使用および理解する、科学芸術または科学芸術の希少な領域を代表する実験プロジェクトです。 サンクトペテルブルクの有名なメディアアーティストユーリディディヴィッチの指導の下で作成されたパフォーマンスは、世紀の変わり目の文化の重要なプロットの1つ-人間と機械の相互作用:それらの間の文化的な対話を確立する試み-ニューロインテグラムのスーパープロット。 パフォーマンスは、パフォーマーの脳(EEG)の生体電位を使用して、視聴覚ステージングアルゴリズムを制御します。

Neurointegrumは、Alexandrinsky TheaterのNew Stage Media Centerに基づいて実装された最初の劇場プロジェクトです。

興味がある人のために、私は猫の下で尋ねます。 Habrausers専用のワークフローの写真がいくつかあります。

エッセンス

メディアパフォーマンス「Neurointegrum」は、人間、コンピューター、インターフェイスの相互作用のオプション、それぞれの役割範囲の問題を提起します。

ステージ上の音と画像は、パフォーマンス用に特別に作成されたソフトウェアによってリアルタイムで生成されます。 それらは、イベント、偶然、ダイナミクス、ドラマツルギーが考慮される動的座標系を定義します。 パフォーマンスの制御要素はパフォーマーの感情状態であり、コンピューターとの情報およびエネルギー交換を通じて、音と視覚のメディアを制御します。 自身のソースである視聴覚イベントに対するパフォーマーの応答の結果として、生物学的フィードバックが発生します。

Neurointegrumは何を表していますか?

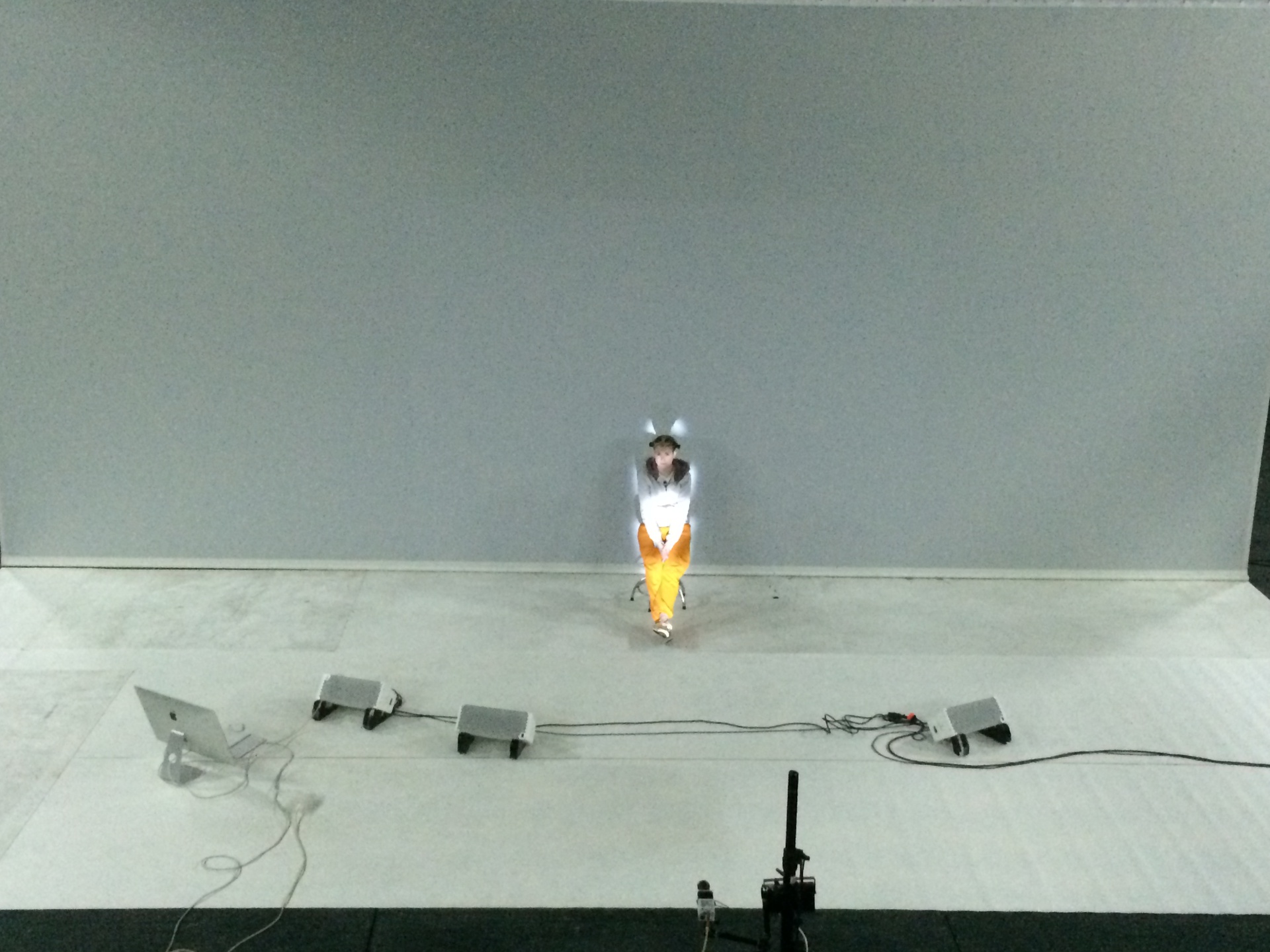

パフォーマーの感情状態を読み取るには、ニューラルインターフェイスEmotiv Epoc Research Editionが使用されます。 そのSDKを使用すると、感情的な興奮や欲求不満などの感情的な状態パラメーターを受け取り、システムパラメーターを制御するために割り当てることができるいくつかのメンタルコマンドを学習できます。 ネットワークでは、たとえば、障害者が思考の力で椅子を制御する方法をグーグルで検索できます。 下の写真では、パフォーマーのSasha Rumyantsevaがトレーニング中に3Dキューブを動かしています。 また、画面には、リアルタイムで撮影された脳の電位の測定値を含むグラフが表示されます。

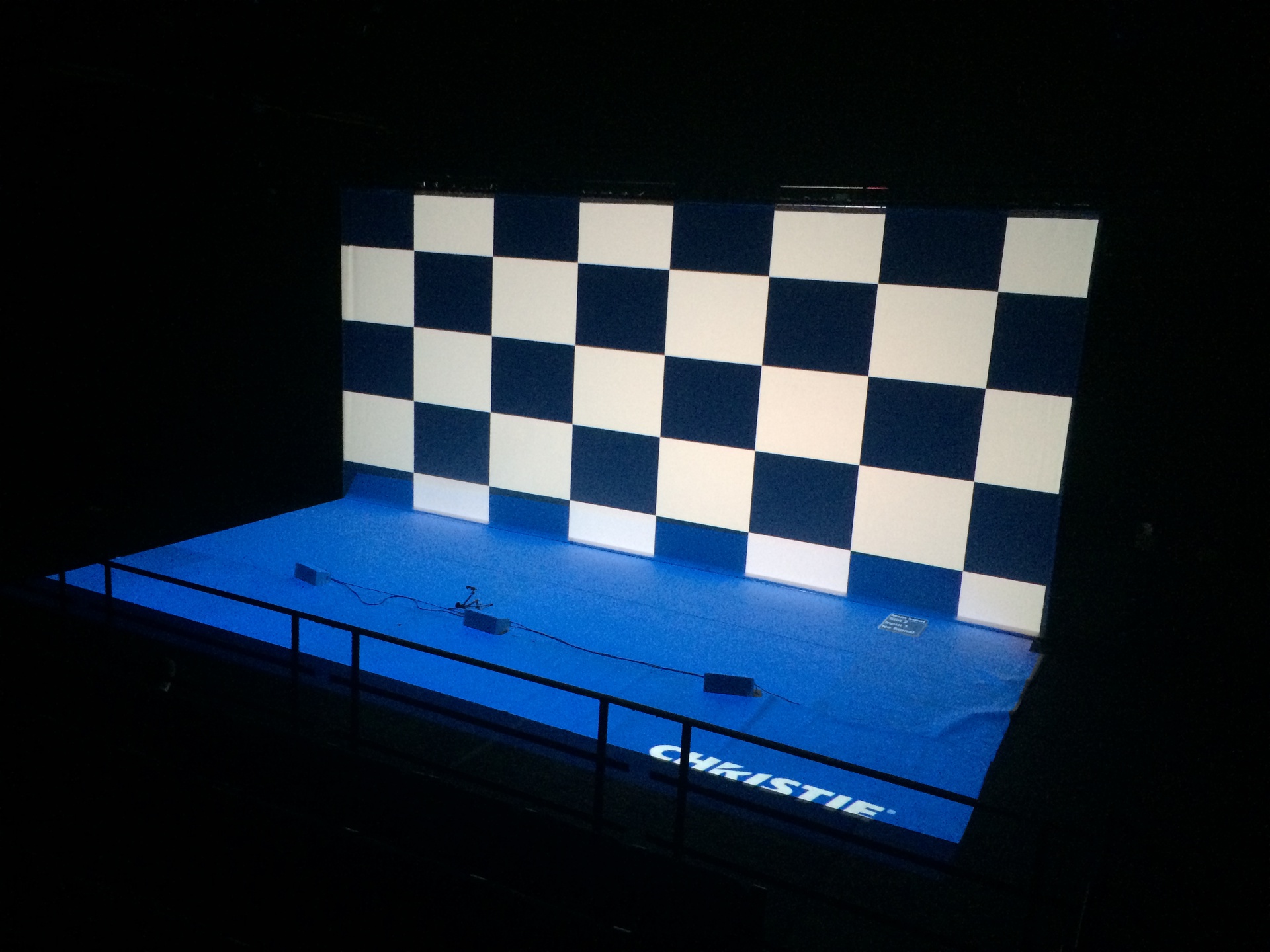

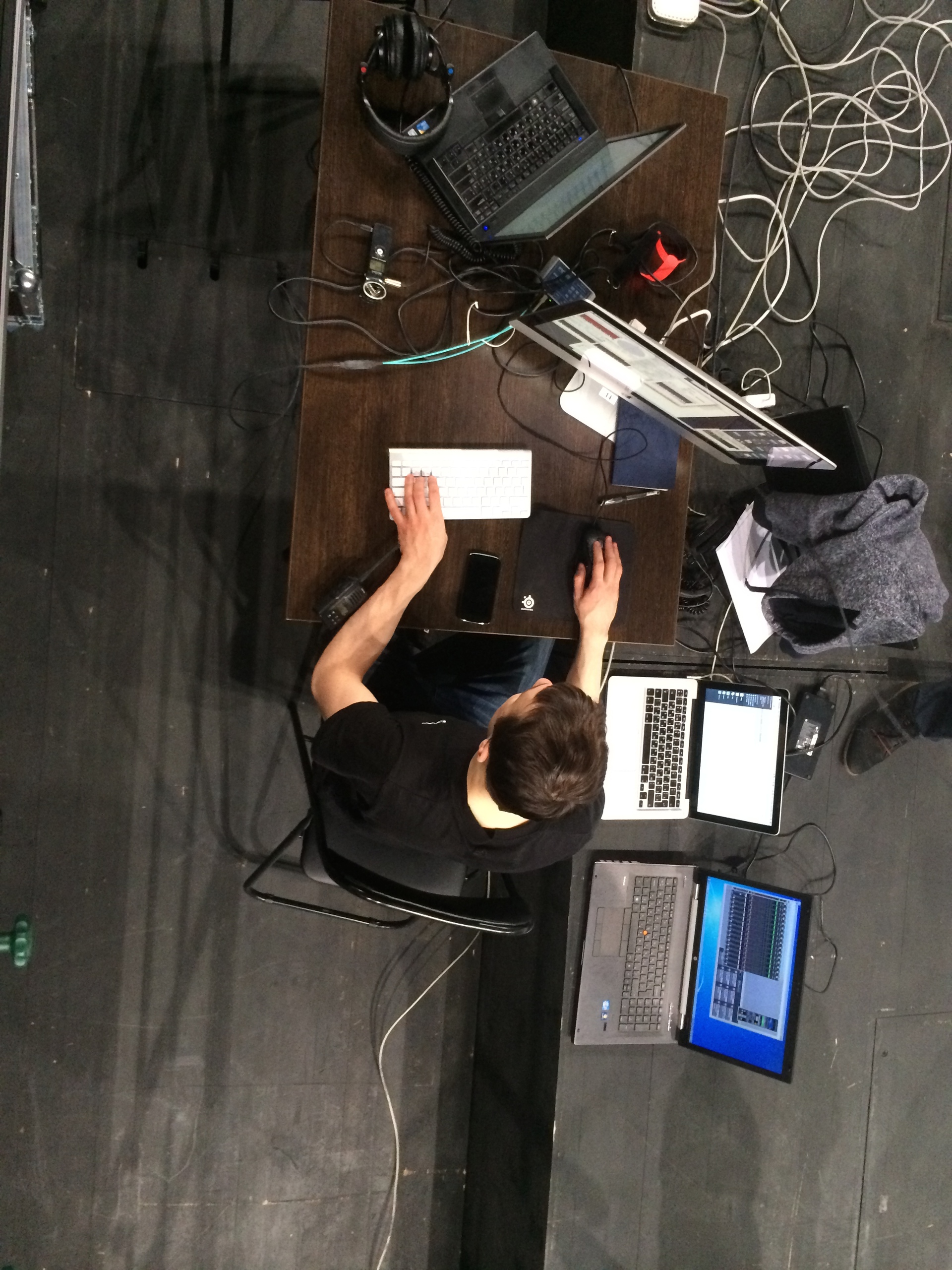

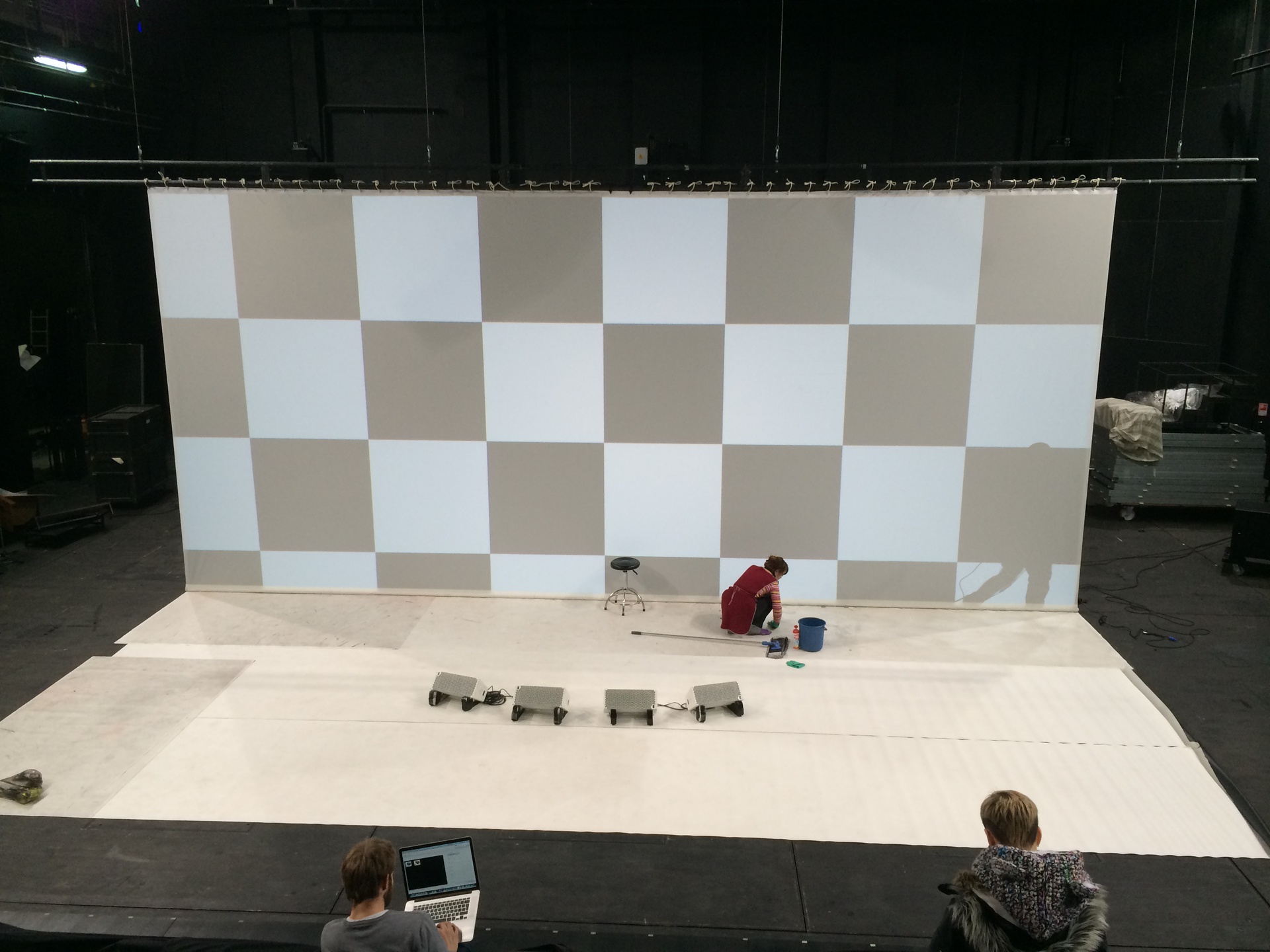

シーン自体は、グラフィック投影用の10x4.5メートルのサイズの2つのスクリーンで構成されています(事前に記録されたビデオを使用せず、リアルタイムでグラフィックを生成することは既に述べましたか?)、パフォーマーのシルエットに個別に投影され、14のサウンドチャンネル、2つのサブウーファー、IR -Kinetのkameraには、照明装置Clay Paky A.leda Wash K20もあります。これは、シーンの1つでサーシャの頭によってインタラクティブに制御されます。 これらはすべて4台のコンピューターから制御されます。投影生成用の2台のPC(床、背面投影画面、およびSashaのシルエット)、1台のPC(またはWindowsがインストールされたiMac)、ニューラルインターフェイスとkinectの操作用、および1台のMac音を生成します。 はい、サラウンドも含めて、サウンドもリアルタイムで生成されます。

ツール

技術面についてもう少し説明します。 グラフィックソフトウェアは、OpenFrameworksフレームワークを使用してC ++で記述されています。 パフォーマーのシルエットの強調表示に関連するタスクでは、OpenCVが使用され、IRカメラからの画像が処理されます。 以下は、アナログカメラとIRイルミネータを見ることができる写真です。

以下に、シルエットライトの仕組みを示します。 バックライトの不均一性(体の上部は強調表示されていません)は、サーシャの「家」の衣服が赤外線をほとんど反射しないためです。 もちろん、パフォーマンスのために、私たちが承認した、つまりプログラマーの生地で特別な衣装が作られました。

Kinectは、いくつかのジェスチャーを認識するために使用されます。

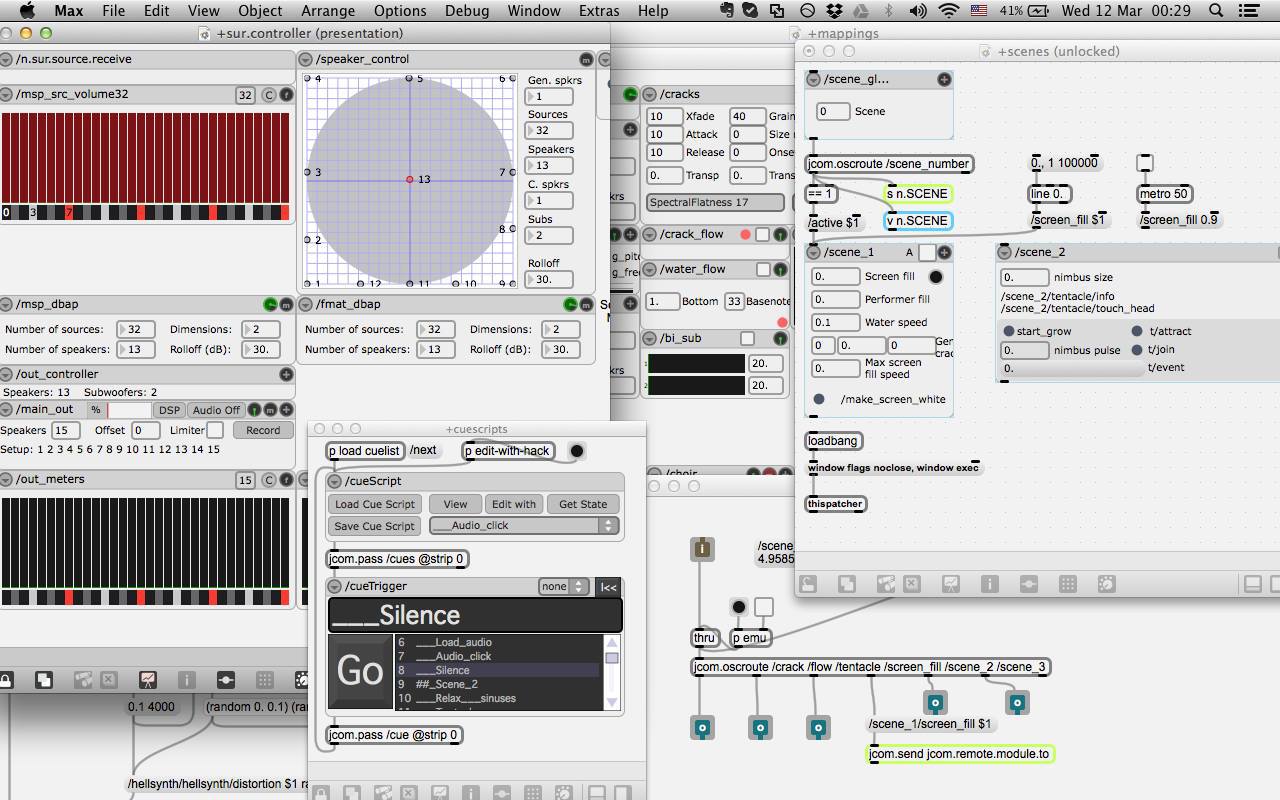

音に移りましょう。 Max / MSPで作成されたサウンドソフトウェア。 インタラクティブなオーディオビジュアルアプリケーションを作成するためのビジュアルプログラミング環境です。 Max / MSPの歴史は、有名なパリの調整と音響研究所IRCAMで80年代後半に始まります(このメディアのレビューを書いたことがあります)。 Neurointegrumのサウンドパッチは次のようになります。

このパッチから、光の音はRME MADIfaceを介してYamaha M7CLにルーティングされます。 次の写真では、私と非常に賢明なサウンドエンジニアであるアレクサンドリンカのマーシャ:

前の写真のいずれかに気付いた場合、スピーカーもシーンの中央に配置されています。 この「トリック」のルーツは、70年代にパリGRMセンターでピエールシェーファーの学生によって開発された「Acousmonium」システムにあります(ちなみに、ワークショップはオーストリアのAkusmonium Thomas Gorbachの作者によって6月下旬にAlexandrinkaメディアスタジオで開催されます)。 これにより、音がシーンの中央に行くような感覚を作り出すことができます。

劇中の音は基本的に空間的であるという事実に加えて、インタラクティブでもあります。 スティックやオーディオプレーヤーはありません。 これを実現するために、現在描画されているものに関する情報がグラフィックプログラムから絶えず送信され、これに基づいて、グラフィック要素が既に表明されています。 たとえば、秘密を教えてください。最初のシーンでは、同様のグラフィックオブジェクトが多数描かれています。 そして、そのようなオブジェクトごとに、その位置と成長率に関する情報がネットワークを介して送信されます。これはすべて、そのような要素ごとに別々に鳴らし、音の空間画像の対応するポイントに向けるために使用されます サウンドはパフォーマーの状態にも影響しますが、これはすでにグラフィックに影響を与えています。

いつどこで

このイベントは19:30に開始され、3つの部分で構成されます。1)劇の制作に関する映画を上映する、2)劇自体、3)公開討論。著者に質問をすることができます。

さらに、新しいステージのロビーでの18:00の各イベントの前に、技術芸術をテーマにした新しい講義が行われます。 無料の講義が好きです。

次のショーは4月3、4、5日にサンクトペテルブルクの住所で開催されます。 r フォンタンカ、49a。

11月 3日にLove Bugaevaによる講演「 Neurokino and Neuro-Literature 」があることは既に知られています。 提供されているリンクを使用して、イベントに登録できます。

パフォーマンスに大きな音とストロボ効果があるため、てんかんがイベントに参加することはお勧めできません。

ソーシャルのパフォーマンスグループ。 ネットワーク: vk 、 facebook 。

プロセス写真

Habrの場合、プロセスの写真をいくつか投稿します。

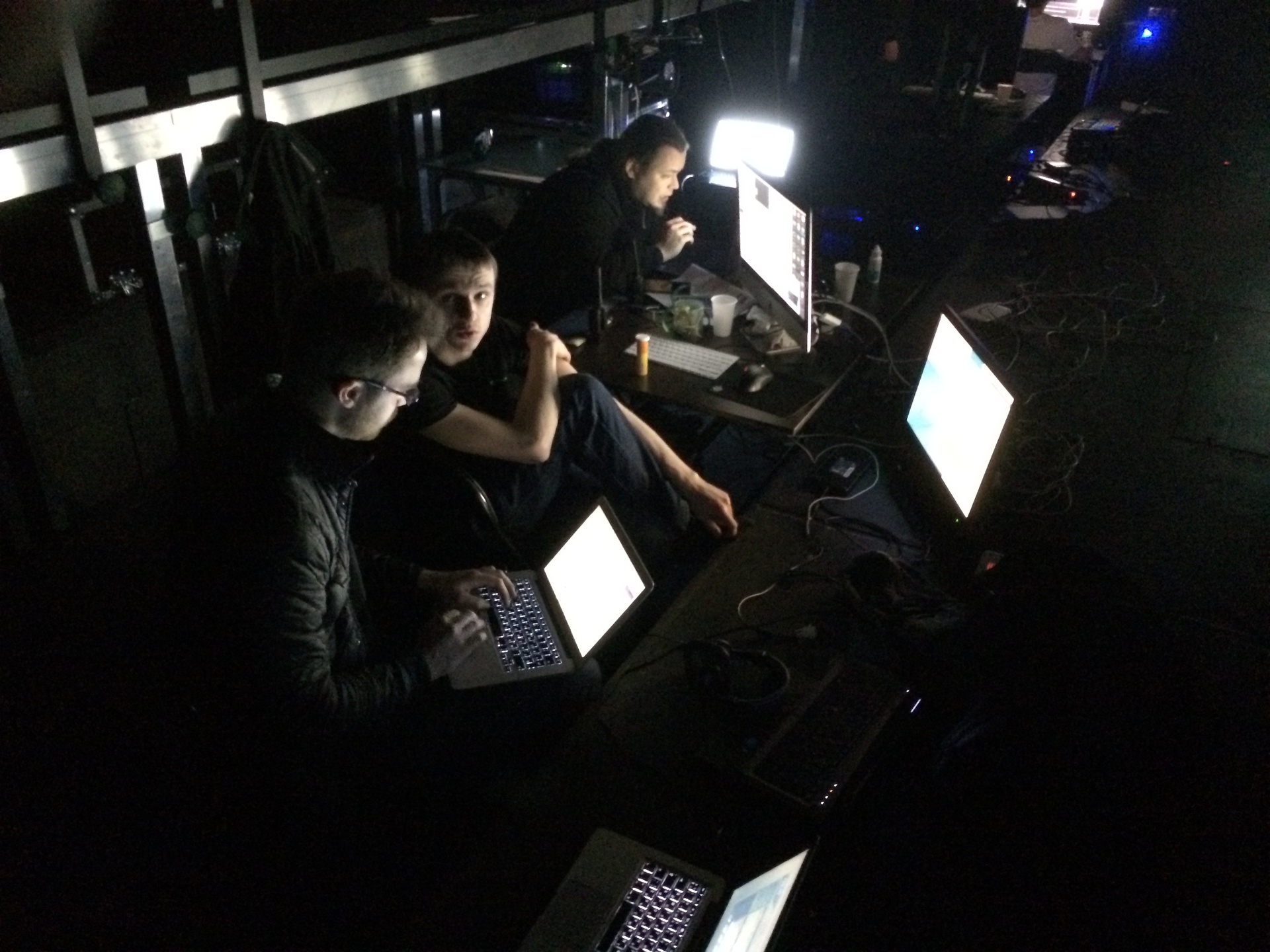

左側には、コンピューターネットワークの専門家である友人が座っており、ArtNetプロトコルを使用してプログラムで照明器具を制御するためのネットワークをセットアップします。

私とレシャ・オリニコフの下。 私たちは座って、スリッパを脱いで、バッテリーで足を温めます。