今日は、私のプロジェクトについてお話ししたいと思います。プロジェクトの開始は2008年に行われました。 それ以来、データストレージのアーキテクチャと情報処理アルゴリズムの両方で多くの変化がありました。

SEOスペシャリストおよび/または通常のウェブマスター向けのサービスです。 BotHunterは、サイト上のユーザーエージェントを(リアルタイムで)受動的に監視するシステムです。 以下のインターフェースの例を参照するか、システムのウェブサイトのデモアカウントでご覧ください (デモモードでは機能が制限されています)。 続きを読む

背景

私の食欲と分析されたデータの量を考えると、私は自分でこのサービスを書きました。 私にとって、すべての質問に対する「図解」はより理解しやすいものです。 BotHunterが回答するよくある質問:

- 検索エンジンはいつ、どのくらいの頻度で私のサイトを訪れましたか?

- 誰が私のサイトを解析し、いつ、検索ボットのように見えますか?

- 私のサイトの何ページが検索ロボットによってロードされましたか?

- 検索にクローラーがアクセスしたページは何ページですか?

- 検索に関係するページがトラフィックを促進しますか?

- 検索ボットがアクセスしたランディングページの割合はどのくらいですか?ただし、(検索エンジンからの)エントリポイントではありませんでしたか?

- Sitemap.XMLからインデックス付けされたページはいくつですか?

- 検索ボットは私のサイトに常にアクセスしますが、それで十分ですか?

- 1つのシステムでYandex、Google、Search.Mail.ru、Bing、Yahoo!との連携に関するデータを表示することは可能ですか? (私のサイトの大きなリストにあります)?

- サイト上に検索エンジンのプロモーションに「有害」なページがありますか?

- など など

完成した自転車があります

「なぜ?」という質問をする準備ができている人たちをすぐに止めたいです。 Yandex.webmasterとgoogle webmastersは何ですか?”

はい、これらのサービスは便利でよく知られていますが、次の質問には答えません。

1.ボットが知っているがSitemap.XMLにないページが私のサイトにありますか?

2.ボットがアクセスしたサイトにページがありますが、トラフィックは一度もありません(リストが必要です)。

3.クローラーは常にどの割合のURLにアクセスしますが、検索されていませんか?

4.サイトに同じウェイト(バイト単位)のページ(重複トピックもあります)はありますか?

5.特定の番号の検索ベースを更新(またはアルゴリズムを変更)した後。 ボットがアクセスしなくなったサイトのページ数 そして、それらのうちどれだけがオーガニック発行からのトラフィックのエントリポイントではなくなっていますか?

6.など

興味深い質問のリストを続けることができ、私たちはそれぞれこのリストを持っています...

サービスの利点は何ですか

- イベント通知システムがあります(基準のリストによる)

- 1つのアカウントのサイト数に制限はありません

- ログバンドルで「針」を探すのは意味がありません。システム自体がイベントについて通知します

- 1つのインターフェースで複数の検索エンジンのデータを分析して表示する

- サイト全体だけでなく、そのスライス、セグメントなどのみを分析することが可能です。 (URLによる正規表現に基づく)

- すべてのデータはクラウドに保存され、システム内のサイトの登録の瞬間から履歴が利用可能です

- レポートはファジー重複の防止に役立ちます

- サイトが定期的に解析されている場合は、それが誰であるかをお知らせします。 常にログを記録する必要はありません

- サービスは無料です

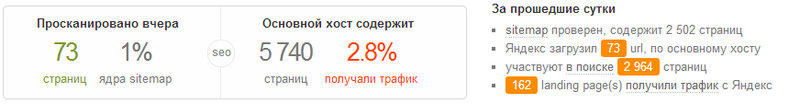

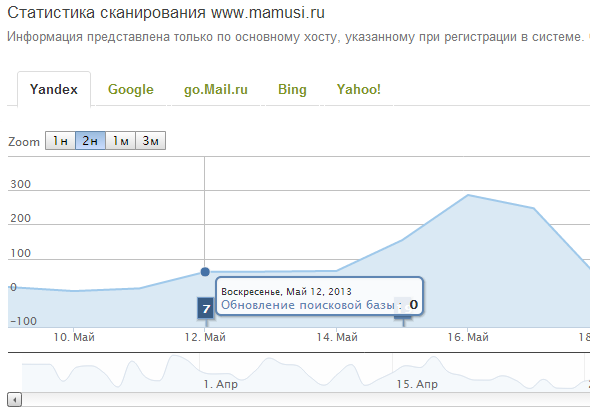

簡単でわかりやすいレポートに加えて、BotHunterは各サイトのrobots.txtおよびsitemap.xmlファイルの整合性を毎日チェックします。 別の歌であるsitemap.xmlに関して、ファイルはサイトマッププロトコルの有効性とコンプライアンスについてテストされます。 システムは、レポートを毎日生成するすべてのチェックと事実に関するジャーナルを書き込みます。

元気?

- (あなたのサイトの)統計的インデックス付けインデックスからの逸脱の識別

- 一般的なエラー検出

- インデックス設定に関する推奨事項(各サイトの機能を考慮)

- [コレクション]トラフィックをサイトにもたらしたキーフレーズのコレクション

- [コレクション拡張]サイトに推奨されるキーフレーズのリストを取得する

- Google Analyticsとの統合により、トラフィック損失を予測します(サイトセグメントごと)

- スペシャリストに役立つもの(推奨事項とアイデア)

TTXについての簡単な説明:

- DC Filancoの独自のサーバーグループが使用されます

- すべてのデータをNoSQLに保存して分析します。具体的には、MongoDBを使用します

- ログファイルは保存せず、処理結果のみを保存します

- 承認するには、facebook、Yandex、またはGoogleでプロファイルを使用します

この投稿の主な目標はあなたのアドバイスを得ることです。

他にどのようなデータをどのような形式で受け取りたいですか?

どのようなアイデアを提案しますか?

建設的な批判を事前にありがとう...