親愛なる行商人、

親愛なる行商人、

革新的なサーバーI / O仮想化技術に特化した一連の出版物を公開しています。FCoEおよびiSCSI技術と簡単に比較し、この技術を使用したI / O仮想化デバイスとデータセンターアーキテクチャを詳しく見て、接続と操作の主な特徴と機能を視聴者に紹介します仮想化I / O、および比較テストの結果も示します。

サイクルの最初の記事をご紹介します。

データセンターに現在および将来の問題を解決するのに十分なリソースがありますか?

リソースの静的な分離という従来の方法論を使用するデータセンターでは、通常、機器のかなりの部分の負荷が弱く、一部の重要な場所では過負荷が常に観察されます。 マーフィーの有名な法律に従って1つのボトルネックを排除すると、すぐに他のボトルネックが特定されます。 現在、ほとんどのデータセンターでは、ストレージシステムとサーバーが統合されており、サーバー仮想化管理システムが使用されています。その使用により、リソースを動的に割り当て、追加のサーバー容量、スイッチングノード、ストレージシステムリソースの必要な瞬間を予測できます。 自信を持って、どの日付RAMまたはサーバーが必要か、特定の数のハードドライブ、またはディスクシェルフを計算できます。 そして、これは既存の機器を拡張する可能性に適合しますが、コストは比較的小さいです。 ただし、新しいサーバーラックを導入する場合、特にパフォーマンスが大幅に向上したサーバーの場合、この変更はより多くのデータセンターサブシステムに影響を及ぼします。まず、以前は多額の投資があったため節約したいデータセンターサブシステムです。

データセンター機器への投資を節約するために使用できるアーキテクチャとテクノロジーは何ですか?

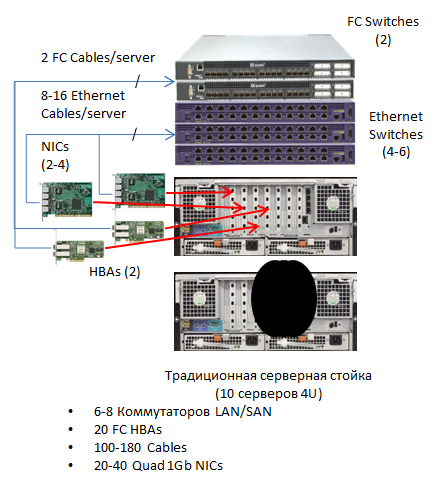

クラシックアーキテクチャ(イーサネット+ FC)

従来の一般的に受け入れられているアプローチでは、データセンターには、LANとSANの2つの完全に独立したネットワークがあり、独自のコアスイッチとアクセススイッチがあります。 同時に、両方のタイプのネットワークアダプターがサーバーにインストールされ、バックアップが必要な場合は複製されます。 物理的には、LANおよびSANコアスイッチは通常、データセンターの専用セクターに配置されます。

従来の一般的に受け入れられているアプローチでは、データセンターには、LANとSANの2つの完全に独立したネットワークがあり、独自のコアスイッチとアクセススイッチがあります。 同時に、両方のタイプのネットワークアダプターがサーバーにインストールされ、バックアップが必要な場合は複製されます。 物理的には、LANおよびSANコアスイッチは通常、データセンターの専用セクターに配置されます。

アクセスラック、いわゆるTORスイッチ(Top Of Rack)は、サーバーキャビネットに設置されます。 原則として、各タイプのスイッチ1つと、フォールトトレランスと冗長性を高めるために2つのスイッチを使用します。 アクセススイッチとコアは、トランク回線を介して接続されます。 サーバーを備えた新しいキャビネットまたはラックを追加する必要がある場合、このようなシステムは簡単に拡張できます。サーバーとTORスイッチを備えたラックが追加され、必要なインターフェイスモジュールがカーネルスイッチに追加され、新しいトランクラインが敷設されます。

このアプローチは、コアの冗長性が以前に提供されていた場合に最も正当化されます(トランクデバイスに空きスロットがあります)。

イーサネットコンバージドアーキテクチャ

当初、従来の方式にはかなりの冗長性が必要だったため、最近ではLANネットワークとSANネットワークの収束を確保するために重大な試みが行われました。一方では10 Gbit iSCSIテクノロジー、もう一方ではFCoEテクノロジーです。 最初のテクノロジーを適用すると、組織に存在するLANコアスイッチを使用できますが、SANのストレージシステムを完全に置き換える必要があります(10G iSCSI接続インターフェイスが必要です)。 2番目のテクノロジーを適用すると、FC SANへの投資を節約できますが、コアスイッチとアクセスを完全に交換する必要があります。 どちらのテクノロジーも、スイッチとアダプターの収束と節約を実現しますが、データセンターサブシステムの1つを完全に置き換える場合、それらの使用は経済的に正当化されます。

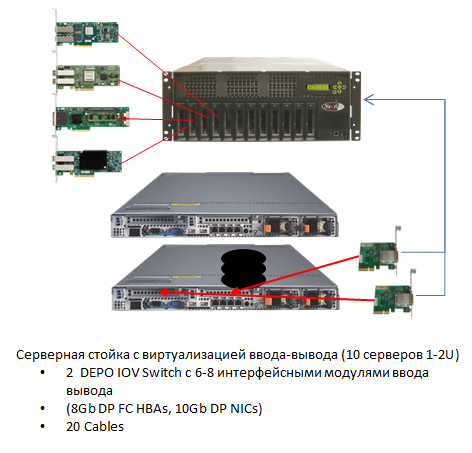

革新的なサーバーI / O仮想化テクノロジーを使用したアーキテクチャ

以前にデータセンター(SANとLANの両方)に多額の投資が行われたが、サーバーリソースを増やす必要がある場合、PCI-Eバスレベルでの切り替えを使用する新しいI / O仮想化テクノロジーを使用できます。 これは、Intel Xeon E5プロセッサーを搭載した最新のサーバーでは、PCI-Eコントローラーがプロセッサーに直接組み込まれているため、サーバーを切り替える最も自然な方法です。 このようなプロセッサは、RAMにアクセスすることなく、独自のキャッシュメモリでI / O要求を直接処理できるため、I / O操作のパフォーマンスが最大80%向上します。 I / O仮想化スイッチ(以降、IOV-入力出力仮想化)には、PCI-Eバスを介してサーバーに接続するための入力と、LANおよびSANに接続するためのインターフェイスモジュールがあります。 このようなインターフェイスモジュールは、仮想マシン(ハイパーバイザー)およびオペレーティングシステムのモニタードライバーによって標準LANおよびSANアダプターとして認識され(実際、サーバーファームの集合体になります)、LANおよびSANの帯域幅が動的に割り当てられます。 帯域幅の割り当て、優先順位付け、およびトラフィックの集約も可能です。 トランク通信の帯域幅を動的に分離することにより、たとえば、インターフェイスの数を減らし、それに応じてカーネルスイッチのポートの数を減らすことにより、節約することができます。 これにより、投資が保護され、所有コストが削減されます。 さらに、TORでの切り替えの除外により、LANコアおよびストレージシステムへのアクセス遅延が大幅に削減されます。

以前にデータセンター(SANとLANの両方)に多額の投資が行われたが、サーバーリソースを増やす必要がある場合、PCI-Eバスレベルでの切り替えを使用する新しいI / O仮想化テクノロジーを使用できます。 これは、Intel Xeon E5プロセッサーを搭載した最新のサーバーでは、PCI-Eコントローラーがプロセッサーに直接組み込まれているため、サーバーを切り替える最も自然な方法です。 このようなプロセッサは、RAMにアクセスすることなく、独自のキャッシュメモリでI / O要求を直接処理できるため、I / O操作のパフォーマンスが最大80%向上します。 I / O仮想化スイッチ(以降、IOV-入力出力仮想化)には、PCI-Eバスを介してサーバーに接続するための入力と、LANおよびSANに接続するためのインターフェイスモジュールがあります。 このようなインターフェイスモジュールは、仮想マシン(ハイパーバイザー)およびオペレーティングシステムのモニタードライバーによって標準LANおよびSANアダプターとして認識され(実際、サーバーファームの集合体になります)、LANおよびSANの帯域幅が動的に割り当てられます。 帯域幅の割り当て、優先順位付け、およびトラフィックの集約も可能です。 トランク通信の帯域幅を動的に分離することにより、たとえば、インターフェイスの数を減らし、それに応じてカーネルスイッチのポートの数を減らすことにより、節約することができます。 これにより、投資が保護され、所有コストが削減されます。 さらに、TORでの切り替えの除外により、LANコアおよびストレージシステムへのアクセス遅延が大幅に削減されます。

DEPOスイッチIOVデバイスの説明は、 ここにあります 。

完全なDEPOスイッチIOV仕様

シャシー

サーバーを接続するためのポート:15ノンブロッキングPCIe x8ポート。

ポートあたりのパフォーマンス:20 Gbps。

サーバーに接続するためのケーブル:PCIe x8(1、2、または3 m)。

I / Oモジュールをインストールするためのスロット:FC、イーサネット10GE I / Oモジュールの任意の組み合わせをサポートする8つのスロット

(計画にはSAS2およびGPU I / Oモジュールのサポートが含まれます)

10ギガビットイーサネットI / Oモジュール

I / Oモジュールインターフェイス:2つの10Gイーサネットポート(SFP +コネクタ、10 GBase-SRモジュールおよびDAケーブルをサポート)。

MACアドレスの割り当て:各仮想ネットワークアダプター(vNIC)は一意のMACアドレスを受け取ります。 物理サーバー間を移動する際のMACアドレスの動的な移行が提供されます。

チェックサムTx / Rx IP、SCTP、TCPおよびUDPチェックサムオフロード機能、Tx TCPセグメンテーションオフロード、IPSecオフロード、およびMacSec(IEEE 802.1ae)の計算。

VLANサポート:IEEE 802.1Q VLANおよびトランクをサポートします。

IPv6サポート。

プロセス間通信(IPC)のサポート。

サービス品質(QoS):はい。

8ギガビットファイバーチャネルI / Oモジュール

I / Oモジュールインターフェイス:2つの8Gbファイバーチャネルポート(SFP +、LC、MMコネクター)。

サポートされるプロトコルFC-PI-4、FC-FS-2、FC FS-2 / AM1、FC-LS、FC-AL-2、FC-GS-6、FC FLA、FC-PLDA、FC-TAPE、FC- DA、FCPからFCP-4、SBC-3、FC-SP、FC-HBAおよびSMI-S v1.1。

World Wide Nameのサポート:各仮想HBA(vHBA)は一意のWWNを受け取ります。 WWNは、物理サーバー間を動的に移動できます。

SANから起動する機能がサポートされており、vHBAはSANから起動するように構成できます。

サポートされているオペレーティングシステムとハイパーバイザー

Windows 2008(32ビットおよび64ビット)、Windows 2008 R2。

Linux RHEL 5.3、5.4、5.5、および6.0、CentOS、SEL11.x。

VMware ESXi 4.1アップデート1。

管理コンソール

専用10/100/1000 Mbpsイーサネットポートを介した管理。

制御インターフェース:

-WebベースのGUI管理(Firefox 3.5、Firefox 4、IE8、IE9、Chrome 11以降)。

-他の管理システムと統合するためのTelnet / SSHおよびOpen APIを介したCLI。

Lights Out Management-2つのユーザーアカウントと3つのトラップ送信先をサポートするSNMPv3トラップ構成。

環境モニタリング-環境モニタリングとシャーシアラート。

高可用性

電源、ファンモジュール、FRUの冗長性と「ホット」交換。

10GbpsイーサネットNICチーミングとフェイルオーバーをサポートします。

ファイバーチャネルマルチパス(MPIO)のサポート。

電源オプション

110-240 V、47-63 Hz

最大消費電力:600ワット。

全体の寸法と重量

172.7 x 482.6 x 508(高さx幅x奥行き、mm)

31.8キロ

運転条件

動作温度:+ 10°C〜35°C

許容湿度:8〜80%(結露しないこと)。

高度:0から2000 m。

サーバーを接続するためのポート:15ノンブロッキングPCIe x8ポート。

ポートあたりのパフォーマンス:20 Gbps。

サーバーに接続するためのケーブル:PCIe x8(1、2、または3 m)。

I / Oモジュールをインストールするためのスロット:FC、イーサネット10GE I / Oモジュールの任意の組み合わせをサポートする8つのスロット

(計画にはSAS2およびGPU I / Oモジュールのサポートが含まれます)

10ギガビットイーサネットI / Oモジュール

I / Oモジュールインターフェイス:2つの10Gイーサネットポート(SFP +コネクタ、10 GBase-SRモジュールおよびDAケーブルをサポート)。

MACアドレスの割り当て:各仮想ネットワークアダプター(vNIC)は一意のMACアドレスを受け取ります。 物理サーバー間を移動する際のMACアドレスの動的な移行が提供されます。

チェックサムTx / Rx IP、SCTP、TCPおよびUDPチェックサムオフロード機能、Tx TCPセグメンテーションオフロード、IPSecオフロード、およびMacSec(IEEE 802.1ae)の計算。

VLANサポート:IEEE 802.1Q VLANおよびトランクをサポートします。

IPv6サポート。

プロセス間通信(IPC)のサポート。

サービス品質(QoS):はい。

8ギガビットファイバーチャネルI / Oモジュール

I / Oモジュールインターフェイス:2つの8Gbファイバーチャネルポート(SFP +、LC、MMコネクター)。

サポートされるプロトコルFC-PI-4、FC-FS-2、FC FS-2 / AM1、FC-LS、FC-AL-2、FC-GS-6、FC FLA、FC-PLDA、FC-TAPE、FC- DA、FCPからFCP-4、SBC-3、FC-SP、FC-HBAおよびSMI-S v1.1。

World Wide Nameのサポート:各仮想HBA(vHBA)は一意のWWNを受け取ります。 WWNは、物理サーバー間を動的に移動できます。

SANから起動する機能がサポートされており、vHBAはSANから起動するように構成できます。

サポートされているオペレーティングシステムとハイパーバイザー

Windows 2008(32ビットおよび64ビット)、Windows 2008 R2。

Linux RHEL 5.3、5.4、5.5、および6.0、CentOS、SEL11.x。

VMware ESXi 4.1アップデート1。

管理コンソール

専用10/100/1000 Mbpsイーサネットポートを介した管理。

制御インターフェース:

-WebベースのGUI管理(Firefox 3.5、Firefox 4、IE8、IE9、Chrome 11以降)。

-他の管理システムと統合するためのTelnet / SSHおよびOpen APIを介したCLI。

Lights Out Management-2つのユーザーアカウントと3つのトラップ送信先をサポートするSNMPv3トラップ構成。

環境モニタリング-環境モニタリングとシャーシアラート。

高可用性

電源、ファンモジュール、FRUの冗長性と「ホット」交換。

10GbpsイーサネットNICチーミングとフェイルオーバーをサポートします。

ファイバーチャネルマルチパス(MPIO)のサポート。

電源オプション

110-240 V、47-63 Hz

最大消費電力:600ワット。

全体の寸法と重量

172.7 x 482.6 x 508(高さx幅x奥行き、mm)

31.8キロ

運転条件

動作温度:+ 10°C〜35°C

許容湿度:8〜80%(結露しないこと)。

高度:0から2000 m。

サーバーファームは、既存のデータセンターインフラストラクチャのI / O仮想化とどのように統合されますか?

I / O仮想化を使用してサーバーファームを追加する手順は、物理アダプターを使用してサーバーを追加する手順とほとんど変わりません。 唯一の違いは、IOVおよびTORスイッチの構成です。 IOVには一定の利点があります。IOVデバイスに接続されたサーバーファーム内で仮想サーバーを移動(ライブマイグレーション)する場合、追加の設定は不要です。 IOVを使用すると、サーバーファームとネットワークコアの管理プロセスを管理者の異なるグループ間で分割できます。 新しいサーバーファームの導入時に、カーネルスイッチに空きポートがないが、パフォーマンスマージンがある場合、カーネルスイッチの高価なアップグレードを回避できます。 既存のラックでTORスイッチをIOVに置き換え、カーネルスイッチ上の既存のポートをそれらの間で分離するだけで十分です。 既存のサーバーをIOVに接続するための要件は1つだけです。それは、x8コネクタを備えた1-2の空きPCI-E 1.0または2.0スロットの可用性です。

現在、新しいI / O仮想化テクノロジーをより詳細に知る方法は何ですか?

テストファームの展開、LAN、SAN、VMWare vCenterへの接続、ファームサーバー間の仮想マシンの転送、2番目のI / Oスイッチへの設定の転送、それらのバックアップと復元、新しい物理サーバーの追加などに関するトレーニングを提供します。 トレーニング後、テスト用の機器を転送できます。これには、事前に構成され、顧客のデータセンターへの接続に備えた新しいサーバーが含まれます(2つのデモセットがあります)。

他のソリューションに対するI / O仮想化デバイスの利点は何ですか?

最初の利点は、10GbEアダプターを使用する場合と比較して、単一の物理サーバーで実行できる仮想マシンの最大可能数を増やすためのおそらく最も効果的なソリューションであることです(PCI帯域幅が広く、インターフェイスを集約できるため) -2.5回)。

I / O仮想化テクノロジーの2番目の重要な利点は、ネットワークI / O操作のレイテンシを半分以上にすることです。これは、金融システムが展開されているデータセンターサブシステムでIOVを使用するための重要な利点になることがあります(トランザクション処理時間の短縮とネットワークトラフィックの送信による) (高速PCI-Eバスを介したサーバー間)、および必要なサービス品質を確保するためのテレコミュニケーションシステム内。

その他の利点と利点

- 管理を簡素化します。 このデバイスを使用すると、システム管理者はワンクリックで任意のI / Oインターフェイスを任意のサーバーに割り当てることができます。 動的なリソース割り当てにより、変化する負荷条件に合わせて構成を最適化できます。

- 中間スイッチ、ネットワークアダプター、ケーブルの数を全体的に削減することで、資本コストと運用コストを削減できます(CAPEXが最大40%、OPEXが最大60%)。

さらに、新しいサーバーファームを追加するときに既存のLANおよびSAN機器への投資が保護され、他のI / Oモジュールを使用できるようになります。 近い将来、SAS2ネットワークに接続し、GPUリソースを共有するためのインターフェースモジュールをリリースする予定です。

仮想化プラットフォームVMWareとMicrosoftの制御下で「ゼロから」プライベートクラウドを構築する場合、I / O仮想化テクノロジーの使用が最も適切な選択肢です。このテクノロジーにより、最新の仮想化およびクラウドコンピューティングプラットフォームが提供するすべての機能を完全に使用できるためです。

特にDEPO Switch IOVは 、2,000を超えるジョブのプライベートクラウドを構築するために、典型的なDEPO Cloud 4000ソリューションで使用されます。

センコ 、

リードプロダクトマネージャーDEPO Computers