IBM Deep Thunderがいわゆるいわゆる ハイパーローカル予報では、観客は内部からの外観と、新しいシステムが単純な天気予報とどのように異なるか、どのように高い精度の予報を達成できるかについて多くの質問をしました。

Deep Thunderのすべての予測アクティビティのベースとなる予測モデルについて、さらに詳しく話し合うことにしました。 もちろん、地理的な地域ではなく、たとえばニューヨークやリオデジャネイロなどの都市の中心部の高度にローカライズされた予測は、対処できないタスクであると言う価値があります。ほとんどの天気予報モデル。 Deep Thunderの開発を最初から主導したLloyd Treinish(最初の投稿で言及しました)は次のように述べています。 「天気」などのこのような広義の用語は、大気中および表面との接触の場所で直接行われるプロセスを表します。 都市の領土では、まず、たとえば高温の廃棄物が大気中に放出される場所で、都市環境が天候にどのように影響するかを監視する必要があります。

このようなイベントの正確なモデリングには、モデル自体(気象センターやその他の「気象」機関の古典的な理解において)が現在提供できるよりもはるかに高いモデルの精度が必要です。 そして、新しい、ある意味で、Deep Thunderモデルは、数平方キロメートルのオブジェクトのモデリングに関して非常に正確ですが、たとえば洪水などの予測について話す場合、数百または数十メートルのスケールでの超局所的な条件を考慮する必要があります。また、予報の裏側もあります。これは、高高度の風(航空、宇宙、工学、高層ビルの設計時など、一部の地域でも非常に重要です) より多くの「垂直」モデルリリースが必要です。ここでrmalnogo表示が、実際には、それはモデル自体の規模と予測の透明度を組み合わせることがどれだけ難しいと難しいでしょう。

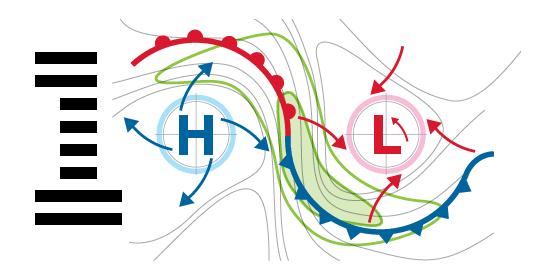

一般に、天気で何が起こっているのかをある程度適切に説明する場合、立方メートル規模で予測モデルを組み立てることは不可能であり、これにはいくつかの理由があります。 第一に、Deep Thunderのような「獣」を養うためにそのような正確なデータを収集することは不可能です-その量は膨大になります。 第二に、このような大量のデータをリアルタイムで処理し、少なくとも消化可能な形式で分析して提示する可能性はありません。 センサーで都市をカバーすることは多かれ少なかれ解決されたタスクですが、そこから非常に多くの不十分な解決結果が現れます。たとえば、世界にはセンサーからハブにそのようなデータを消化して正常に転送できるような開発されたネットワークインフラストラクチャを備えた都市は12を超えません。その後、このデータを処理するマシンに。 しかし、実際には、そのような解決策に基づいた「予測」が出ないという事実と比較して、これらは花でもあります-ほとんどの場合、都市部の天気はその外側に形成され、風や大気の他の気流とこのプロセスによって運ばれます市内にあるセンサーには一切反映されません。 要約-効果的でもっともらしい予測を行うには、最初の気象条件が形成される場所で、それを行うのに意味のあるデータを取得する必要があります。 サイクロンと高気圧の動きについて話す必要はないと思います。サイクロンと高気圧は現在かなり予測可能であり、それらの助けを借りて、明日の雨または日光に関するデータの90%を取得します。

ここで、お気に入りの話-膨大な量のデータの分析と、Deep Thunderがこれらすべてのデータを「飲み込む」方法について説明します。高品質の天気予報、詳細、申し訳ありませんが完全に表示します。

そのため、1メートル3から1キロメートル3に移動してモデルのスケールと解像度を上げるたびに、1メートル3の解像度で予測を正常に生成するためのデータを取得できたとしても、計算を指数関数的に増加させる必要があります三次元モデルの形成力。 これについて、Trainish氏は次のように述べています。「エリアの解像度を2倍にするだけでよい場合( 2メートルと考えられています)、システム全体の計算能力を8倍にする必要があります。 しかし、はるかに複雑なのは、「高」モデルを取得したい場合、つまり、垂直解像度を上げたい場合、システムは状況に応じて10〜20倍強力になるはずです。」

このスケーリングの問題をどうにかして回避するために(システムがスーパーコンピュータークラスターで既に動作しているため、パフォーマンスを指数関数的に向上させることは非常に費用のかかるタスクであると理解することが重要です)、IBMの開発者は、特にDeep Thunderの「結合モデル」のパラダイムを作成しました。 このようなモデルは次のように形成されます-1つの結果(1つの気象観測所からのデータである可能性があります)は次のモデルの入力として使用され(たとえば、1平方キロメートル)、モデルの処理結果は次のモデルの入力として使用されます、など 過去の気象データ(つまり、ファクト)は、各モデルの結果を検証するために使用されます。つまり、予測は1つまたは別の予測の確率に従って相関され、その結果、ユーザーは記録されたデータ(事実)の観点から最も可能性の高い予測を正確に見ることができます。

「リオには、異なる解像度の4つのモデルが同時にあり、それらの間の切り替えはテレスコピック地理グリッドを使用して行われます。 すべてはNOAAによって形成されたグローバルモデルから始まり、その後、別の都市にズームインします。水平解像度27 km、9、3、最終的に1 kmが使用可能です。 これは、ビジネス上の問題を解決するために必要な物理データを考慮に入れた地理的バランスの一種です(結局、Deep Thunderは、いくつかのかなり具体的なタスクの解決に役立つように設計されています)。」1 km 2の分析で得られたデータは、メータースケールでメーターに供給され、洪水やその他の同様の気象災害の可能性を判断するために使用される非常に正確な地理的および水文学的モデルを予測するためにすでに使用されています。

IBM Researchチームは、このアプローチをさまざまなサイズのレイヤーで使用して、作業モデルのスケーリングの問題を解決しました。 現在、Deep Thunderはリオとニューヨークで働いています。IBMが適切な結果を得るために単にコンピューティング能力を高めるという道を選んだ場合、おそらくすべてのスーパーコンピューターの能力を使用して複数のモデルを並行して処理する必要があります。 ロイドトレインは次のように述べています。「アーキテクチャは非常にシンプルであると同時に非常にエレガントですが、最も重要なのは、機能することです。 NOAA自体と米国空軍気象センターはこのモデルを使用し、「単純な」顧客に提供するよりも大規模な高精細予報を達成しています。

実際、リオデジャネイロモデルは、Infinibandスイッチで相互接続された少数の「POWER7」サーバーのみを使用しています。 モデルの規模を拡大する必要がある場合、この構成では、Deep Thunderが動作し続けるためにサーバーをいくつか追加するだけで十分です。 別の例があります- ブルネイ大学 (世界で最も裕福なスルタンのような小さな州)では、モデルはIBM Blue Geneによって処理され、小規模な州規模での天気予報を可能にします。

ただし、優れた信頼性の高いモデルを構築するには、気象観測所、センサー、温度計、気圧計からの大量の初期入力が必要であり、神は他に何を知っているのか、これがロイドトレイニッシュが言っていることです。天気予報を作成するのにどの方法が役立ちますか」 これには、衛星画像、NOAA、NASA、地質ミッション、欧州宇宙機関など、あらゆる種類の公開データと公開データが含まれます。 リオとブルネイは、シミュレートされた表面全体に配置されたリモートスマートセンサーを使用します。

もちろん、パブリック(NASAデータは通常の意味で完全に公開されているデータではありませんが)データに加えて、IBMは利用可能なすべてのタイプのデータを使用してDeep Thunderモデルを構築し、少なくとも予測を検証します。 したがって、ニューヨークの特定の例を使用すると、データがEarth Networksが所有するWeatherBugセンサーネットワークからのものであることは明らかです。 WeatherBugは、都市およびその境界の外側にあるさまざまなセンサーの広いインフラストラクチャであり、米国中に分散され、そのデータは5分ごとにDeep Thunderに到着します(通常、5分が「ティック」モデルの標準時間です)。モデルの明瞭さを効果的に制御できます。 、履歴データへの対応、そして最後に、もっともらしい予測を提供します。