新しいデータセンター

より強く、より高く、より速く、より安く

最初の問題は、結果と価格の相関関係でした。 モスクワに既存のデータセンターの近くにデータセンターを建設したいが、建設とエネルギー供給に本当に多額を費やすほどではないことは明らかです。 最初は、モスクワとその地域にある約30のオブジェクトを調べましたが、首都地域に直接ではなく、首都地域の近くに建設する方が経済的に実行可能であるという結論に達しました。 まだ複雑です:モスクワのデータセンターと新しいデータセンターの間には、200キロメートルを超える光ファイバがあってはなりません。そうしないと、光の速度がすでに同期複製中の遅延に大きく影響します。 並行して、ディスクアレイの新しいモデルを購入し、非同期複製をテストする機会を得ました。 そのため、センターを地理的に分散できることが明らかになりました。

場所を選ぶ

データセンターの主な指標は、消費する電力量です。 過去10年間の成長率を計算し、この成長を概算し、2008年の危機後に調整し、近い将来に問題を解決するには10 MWが必要であることがわかりました。 電源をばらばらに接続することは有益ではないことを考えると、ただそのような線をすぐに中心に引く必要がありました。

次の選択要素は、地域の温度と湿度です。 平均して場所が寒いほど、強制冷却に必要なエネルギーが少なくなり、データセンターの運用が環境に優しく経済的になります。 湿度の場合、状況は次のとおりです。空気が乾燥していると、静電気放電がボードに蓄積し始め、湿度が高すぎると「露」が落ちます。 評価の結果によると、最適な場所は技術的に提供されたモスクワに近いヤロスラブリでした。ヤロスラブリは、多くの電力を得ることができ、安価な土地があり、温度体制が適切です(アクティブ冷却を使用しない時間の90-95%、つまり、外気で作業します) 。

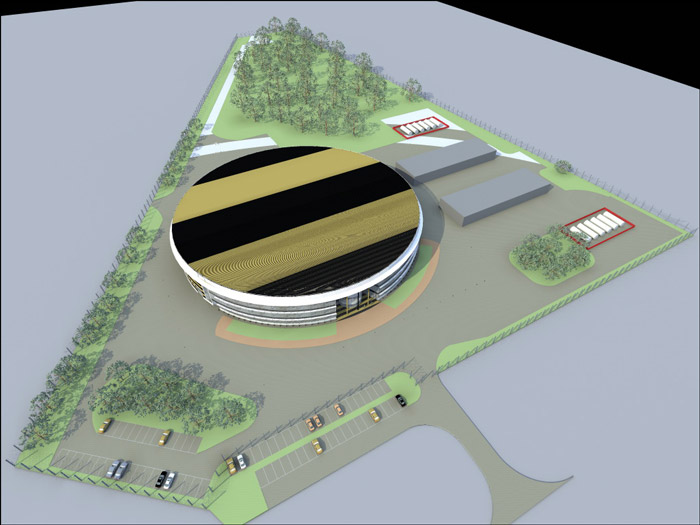

データセンターの建物、トップビュー

建設費を見積もる

彼らはすぐにデータセンターをモジュール化することにしました。 競争の後、AST(Smart Shelter)に基づくソリューションが15の大企業から選ばれました。 主な構造要素は、耐火性の自立型パネルであり、アリ溝で接続され、温度の影響と不正侵入の両方から保護するプロファイルで閉じられています。 モジュラーデータセンターの設計は、各500平方メートルの有用な領域を持つ6つの自律モジュールです。

モジュール 外では、実際には大きな灰色の箱のように見えます。

データセンター自体は、あらゆる災害に耐えるさまざまなシステムを使用しています:水と火による損傷からの保護、温度保護、物理的保護、最も厳しい天候からの保護、内部火災、侵入、愚か者、EMフィールドなど。 各モジュールには、独自の分散エンジニアリングインフラストラクチャがあります。 必要に応じて、個々のモジュールを解体し、新しい場所にすばやく輸送できます。 met石がモジュールの1つに当たっても、他のモジュールの動作には影響しません。

モジュールは内部にあり、新しいデータセンターで撮影されたものではありません。

詰め物を選択します

センター自体にソリューションを使用することが可能であることを考慮して、制限がないため、リソースの最小消費を保証するもの、つまり、収益性が高く環境に優しいものに焦点を当てました。 一般に、現代のデータセンターに環境に優しいことは有益です。これは、電力消費とリソースの最適な支出を削減するという主なパラダイムと一致します。 コンサルティング会社のレポートによると、冷却システムを構築し、無停電電源を維持するための約40の異なるソリューションが判明しました。 サーバーの水冷、電源管理、およびソフトウェアまたはBIOSレベルでのサーバーの冷却に関連するデータセンターのエンジニアリングシステムに関係のないテクノロジーは、テクノロジーの選択に関する決定と並行して実行できるため、すぐに却下しました。 冷却ビーム、深海冷却などのエキゾチックな冷却システム、および一次または二次電源システムのエキゾチックなシステム-ウルトラキャパシター、地熱源、ソーラーパネル、潮力発電システム、風車も急速に落ちました。 直接分析の残りのシステムは拒否を引き起こさず、追加調査の対象となりました。

一次選択

最初は、京都の車輪について考えました。 ただし、Tier-3の要件を考えると、同じ冗長ノードをさらに2つ作成する必要があり、多くのスペースが必要になります。 サーバーに統合されたUPSに興味を持ちました。このテクノロジーは、集中化されたUPSを必要としないため、有望に見えました。 一方、さまざまなハードウェア(ディスクアレイ、テープライブラリ、ハイエンドサーバー)が多数あり、迅速に統合することはできないため、拒否しなければなりませんでした。 このテクノロジーは、サーバーの観点から同種の環境でのみ使用でき、データセンター全体のアーキテクチャに大きな制限を課します。 私たちの仕事は、10年前に生産された多様な機器が現在共存し、現在生産され、今後10年以内に使用されるユニバーサルデータセンターを構築することでした。 それから、蓄熱に目を向け始めました-しかし、ここでは大量が必要でした。10MWの場合、それは単に天文学的でした。 吸着システムまたは吸収システムを使用したタービンまたは燃料電池でのトリジェネレーションは、トリジェネレーションおよびDDIBPシステムの所有コストとデータセンターおよびフリーコールモジュールを比較してケースを計算するまでは良好に見えました。 30年の使用でビジネスケースがポジティブになることが判明しました。 高性能の静的UPS-すでにそのようなシステムを使用しています。そのようなソリューションを実装するのにどれだけの費用がかかるかを考えています。つまり、新しいソリューションと比較することができます。

栄養

経済的な実現可能性の観点から最も興味深い技術は、DDIBP(ディーゼル動的無停電電源装置)であることが判明しました。 その基本原理は、従来のバッテリー駆動UPSシステムのように、化学エネルギーではなく運動エネルギーを蓄積することです。

電源スキーム

古典的な無停電電源システムと同じ原理で動作します-短期的な停電や低品質の電源(交流電圧、周波数変動、振幅などの不適切な正弦波)の場合、蓄積された運動エネルギーが使用され、ディーゼル発電機は長期間の停電のためにオンになります。 「トップ」のおかげで、電力スイッチングは非常に高速で、消費者には感知されません。つまり、たとえば電力サージがありません。

UPSデバイス

冷却

冷却には、自然の自由冷却システム「Natural Free Cooling」が選択されました。これは、空気の純度と湿度を制御しながら、屋外空気とMCOD内を循環する空気との間の熱交換の原理に基づくMCODの内部空間の空調です。 システムは、2つの開いた個別の回路で構成されています。 データセンターの空気は内部回路を循環し、外部空気は外部回路に供給されます。 システムの主な要素は、熱交換器であり、外部の周囲の空気とセンターの部屋の空気との間で熱交換が行われます。 加熱された空気は排気ダクトによってホットゾーンから除去され、冷却された空気は冷たい廊下に供給されます。 断熱冷却(外部回路の空気流への注水)を使用すると、コンプレッサーの冷凍回路を+19から+24℃に接続することなく、冷却システムの温度範囲を広げることができます。

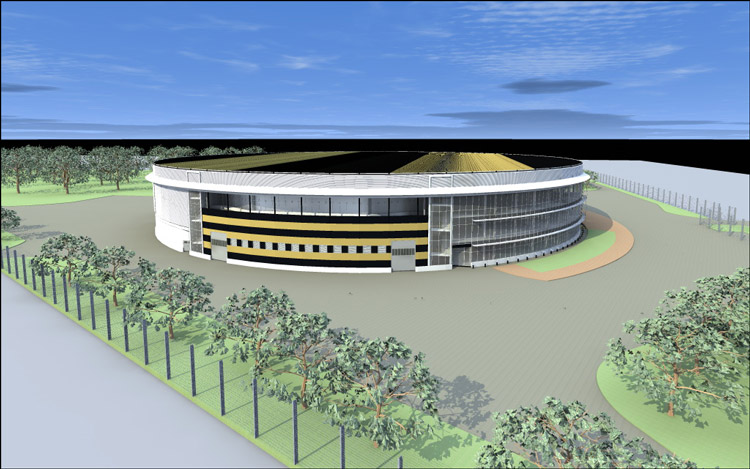

テリトリー 木は、風や保護を妨げないように植えられています。

使用されるテクノロジーを計算すると、最先端のテクノロジーソリューションの総所有コストが、実装時間が短いほど低いことがわかりました。

この点でデータセンターの効率を評価するための主なパラメーターは電力使用効率であり、その物理的意味は、ペイロードで消費されるエネルギー量に対するデータセンターで消費されるすべてのエネルギーの比率です。 計算によると、平均年間PUEは1.3を超えません。

トピックが興味深い場合は、データセンターの冷却システムと無停電電源装置について個別のトピックを作成し、データを同期し、さまざまな障害から身を守る方法について個別に話し合うことができます。 コメントでは、一般的なトピックについて質問できます。すぐに回答するか、別のトピックを約束します。