「ばかじゃない」

前と同様に、よく知られている法律の解釈を参照しようとします。 私は自分の態度を表明しません。私の意見は、本文に掲載されているものと一致しないかもしれません。

前と同様に、よく知られている法律の解釈を参照しようとします。 私は自分の態度を表明しません。私の意見は、本文に掲載されているものと一致しないかもしれません。

これは、コンピューターサイエンスとその法則、および日常生活におけるその痕跡について語ろうとする試みの続きです。 この刻印、影、または錯覚さえも、誰もが決定するものです。 しかし、私たち自身が世界を知るためにすべての科学を思いついた場合、物理学で自然を見ないこと、犯罪を知ること、建築を賞賛すること、小説のようなプログラムを書くこと、またはその逆で、すべての構造を見て、特定の重要性を理解し、生きて感じる存在の法則。 問題は、 ある人が他の人とは違って考え、理解したらどうなるかということです。 誰が正しいのか、誰が愚か者、誰が賢いのか? おそらく、より多くを知っており、より多くの情報を持っている人...おそらくこれはそうです。 しかし、今日、世界で最も重要な経済的価値になり、産業技術の主な生産資源としての機械技術が知識と知性に置き換わったことを示す情報は何ですか? おそらく、この質問に答えることで、誰が愚かで、誰が賢く、なぜかを理解できるでしょう。

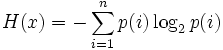

1949年ごろ、クロードエルウッドシャノンは、情報エントロピーを通じて情報を定義しました。これは、プライマリアルファベットのシンボルの出現の不確実性です。 独立したランダムイベントの場合、n個の可能な状態(1〜n)を持つxは次の式で計算されます。

シャノンは次のように書いています。「Hの価値は、情報量、選択、不確実性の尺度として情報理論の中心的な役割を果たします。」

情報エントロピーは予測不可能性の尺度です。 メッセージのエントロピーと冗長性の概念は、情報の尺度に関する直感的なアイデアに自然に対応しています。 メッセージが予測不能であるほど(そして、その可能性が低いため、エントロピーが大きくなるほど)、より多くの情報が伝達されます。 感覚は、その予測可能性が非常に小さいまれなイベントであるため、その情報価値は大きいです。 多くの場合、情報はニュースと呼ばれ、発生したばかりのイベントに関するメッセージですが、それについてはまだ知りません。 しかし、2回目と3回目のインシデントについて説明すると、メッセージの冗長性が非常に大きくなり、予測不能性がゼロになります。

メッセージソースに実際の言語の文を送信させます。 どのキャラクターが次に来るかは、すでに送信されたキャラクターによって異なります。 たとえば、ロシア語では、記号「b」の後に子音の記号を続けることはできません。 2つの連続した母音「E」の後、3番目の母音「E」は非常にまれに続きます(たとえば、「長い首」という言葉で)。 したがって、後続の各シンボルはある程度事前に決定されているため、シンボルの条件付きエントロピーについて話すことができます。

Erokhin(「情報理論。パート1」)によると、ロシア語の冗長性は73%、フランス語の冗長性は71%、ドイツ語は66%です。 「特別な言語」には最大の冗長性があります。たとえば、「空港のディスパッチャ」の言語や法律文書の言語、文学言語の冗長性は低く、ライブスピーチの冗長性はさらに低くなります。 たとえば、ロシア語の場合:ライブスピーチ:72%。 文学テキスト:76%; 法的テキスト:83%。 これらのデータは、ロシア語とフランス語を比較することで補足できます。

|

| ロシア語

| フランス語

|

| 一般的な言語

| 72.6%

| 70.6%

|

| 会話

| 72.0% | 68.4% |

| 文学テキスト

| 76.2% | 71.0% |

| ビジネステキスト

| 83.4%

| 74.4% |

原則として、完全に冗長な言語、いわゆる最適なコードを構築することが可能です。 その中で、文字のランダムな組み合わせはすべて意味のある単語を意味します。 しかし、それを使用することは不可能です。 ここにアレキサンダー・カラバイキンが書いているもの(「非電磁サイバネティックスの問題」):「情報を増やすことはエントロピーを減らすことと同等です。 これは宇宙の基本法則の一つです! エントロピーを増加させることで情報の転送に対して支払う必要がありますが、情報を受け取ったシステムは自動的に「独自の」エントロピーを減らします。

情報の尺度とは何ですか? シャノンによれば、実験に含まれる情報量に等しい情報量を測定する基本単位であり、2つの同様に可能性のある結果があります。 これは、「はい」または「いいえ」の回答を許可する質問に対する回答の情報量と同じです(つまり、質問に明確に回答できる情報量)。 1946年、アメリカの統計学者ジョン・テューキーは、20世紀の主要な概念の1つであるBIT(BIT-BInary digiTの略)という名前を提案しました。 Tukeyは、値0または1を受け入れることができる単一のビットを示すためにビットを選択しました。シャノンはそのビットを情報の単位として使用しました。

「はい」または「いいえ」の2つの答えのみがあり、3番目の答えは与えられません。 この事実は、パリティの法則の現れと考えることができます。 イゴール・ミハイロヴィチ・ドミトリエフスキーは次のように述べています。「パリティの保存の法則は、左右の対称性です。 単一の自然なプロセスでは指をつついて、それが残っている、または正しいと言うことはできません。 自然は無関心であり、答えを与えません。 対称的です。 彼女は左と右の違いを知っていますが、どちらが左か右かは私たちが同意することです。」 彼の講義で、ドミトリエフスキーはこの考えを続けました:「...誰が愚か者で、誰が賢いのか? 自然には価値がないことがわかります。」

「愚か者は反対者または反対者です。」

アルカディとボリス・ストルガツキー

「車への情熱」